AI服务治理新范式:下一代智能网关设计与实践

AI服务治理新范式:下一代智能网关设计与实践

菜鸟小白的学习分享

发布于 2025-11-21 17:39:20

发布于 2025-11-21 17:39:20

概述

为什么需要AI网关?

因为随着企业内部AI服务数量爆炸增长,AI调用管理正成为新的技术瓶颈。

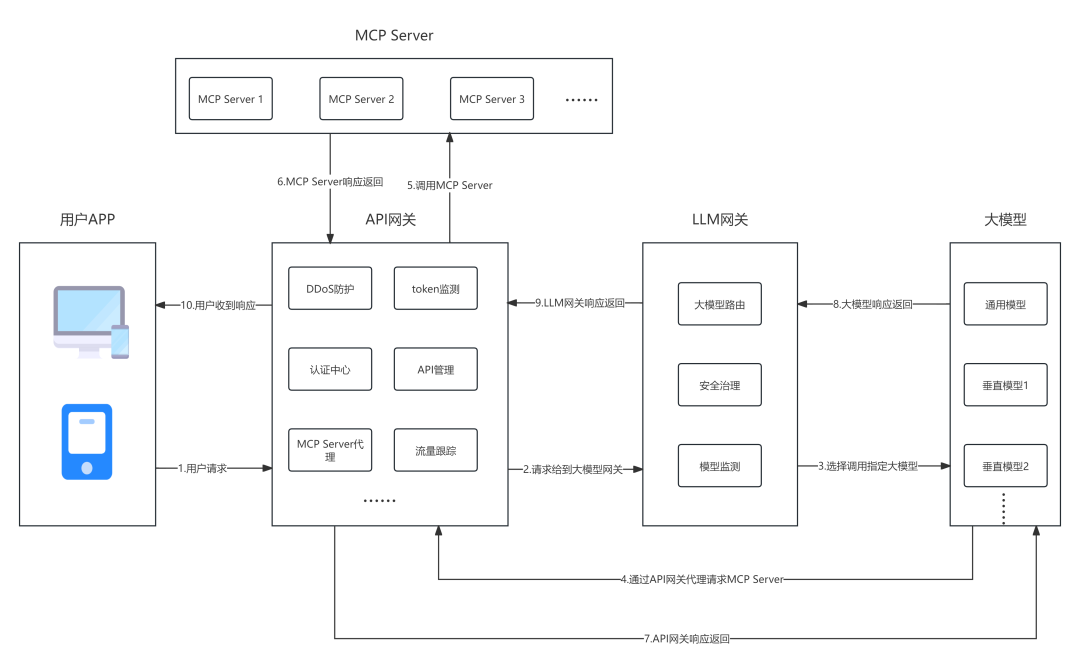

AI Gateway,本质上可以理解成是由一个传统API网关的变种(API网关功能之上叠加了AI的场景) + LLM网关 ,这两部分组成。在整体架构图上如下图所示:

相比于传统的API网关,AI场景下多采用SSE/WebSocket协议来保持长连接;网关除了需要处理传统的文本数据之外,多模态场景下还需处理图片、音视频等数据;不同的业务场景下,调用模型会是通用大模型+垂类模型的混合模式;并且AI场景下的数据流量将会更大,以流式传输为主,需要更大的带宽,响应时间更长(尤其推理场景下),也会更容易遭受Prompt等攻击,所以安全防护层面尤为重要......

话不多说,下面针对一些网关的核心功能进行说明。

API Gateway

API网关除了传统的能力外,还需要处理以token为核心的流量,采用流式输出的方式。

MCP Server代理

传统API接口主要是restful和gRPC两种协议,MCP则需要将SSE转换为Streamable HTTP,这就要求API网关新增支持这种协议卸载能力,在MCP Server前端做一层代理。

RESTful和gRPC协议补充说明: 「设计理念」 RESTful:基于HTTP协议,使用标准的HTTP方法(如GET、POST、PUT、DELETE)对资源进行操作,强调资源的统一接口和状态转移。 gRPC:由Google开发的高性能开源RPC框架,基于HTTP/2协议,使用Protocol Buffers作为序列化协议,支持流式传输和强类型语言。 「性能」 RESTful:使用文本格式的JSON进行数据交换,可读性强但性能相对较低,存在数据冗余和解析耗时的问题。 gRPC:采用二进制格式的Protocol Buffers,数据体积小、传输效率高,适合高性能和低延迟的场景。 「使用场景」 RESTful:适用于面向互联网的公开API,具有广泛的兼容性和简单易用性,支持多种数据格式和浏览器。 gRPC:适用于内部系统通信、实时数据传输、微服务架构等高性能场景,支持多种编程语言和流式传输。 「开发与维护」 RESTful:开发工具和文档丰富,易于上手和维护,生态系统强大。 gRPC:需要学习Protocol Buffers和HTTP/2,学习成本较高,但提供代码自动生成和强类型检查,减少运行时错误。 「安全性」 RESTful:通过HTTPS实现安全通信,支持常见的安全机制如OAuth、JWT等。 gRPC:支持双向TLS认证,提供更细粒度的安全控制,安全性更高。 综上所述,RESTful和gRPC各有优势,选择哪种协议取决于具体的应用场景和需求。如果需要广泛的兼容性和简单易用性,RESTful是合适的选择;如果对性能和实时性有较高要求,gRPC可能更为适合。

❞

Token监测

大模型按照token作为计量单位,身为AI 网关就需要支持基于token角度进行流量监控、管控。

「监控」:基于用户维度,对每个用户使用的token进行监控,建立用户token流量基线模型。

「管控」:基于用户维度,支持对某个用户在某个时间段进行token限流,支持异常流量下的阻断。

LLM Gateway

大模型路由

大模型路由主要根据用户的需求和服务器状态,动态的选择最优模型。所以这里要注意,不单单只是依据用户Prompt自动选择模型,还需要考虑整体GPU负载等因素。核心功能应包含以下几点:

- 将用户的意图进行解析,识别出请求类型,选择匹配一个模型或几个模型的组合。

- 需结合延迟、负载、成本等多维度进行考量。

- 在多个节点和多GPU实例间进行实时流量调度。

- 做好容灾切替,例如在主模型故障时可自动切换至备用模型,保障高可用。

安全治理

LLM Gateway的主要能力,基于《网络安全技术 生成式人工智能服务安全基本要求》的5大类31小类风险类型对大模型的输入输出进行安全防护,确保对外服务安全、合规和可追溯。核心功能如下:

- 「内容合规检测」:对输入和输出内容进行多维度合规审查,覆盖涉政敏感、色情暴力、偏见歧视、不良价值观等风险内容,支持价值观过滤和底线风险识别。

- 「敏感内容检测」:自动识别并分类分级个人/企业敏感信息(如身份证、电话、地址、护照、驾照等),支持脱敏处理,防止隐私数据泄露。

- 「提示词攻击检测」:识别大模型生成内容中,通过提示词操纵(如诱导性、对抗性 prompt 构造)、技术手段绕过(如编码混淆、多轮对话伪装)等方式突破安全策略,刻意生成的违规内容。

- 「恶意文件/链接检测」:实时检测文件上传和URL内容,防范恶意程序、病毒文件及违规网站链接的传播风险。

- 「数字水印标识」:对生成内容嵌入可识别标识,用于版权保护和虚假信息溯源,避免纠纷。

- 「访问与行为管控」:精准控制对话长度、文件上传权限,避免权限滥用,支持黑白名单和自定义阈值配置。

- 「溯源与审计分析」:建立身份识别机制,支持风险数据逐条分析、日志审计和攻击源定位,实现行为可追溯。

- 「多模态与多语言支持」:覆盖文本、图片、文件、音频、视频等多模态内容交叉检测,支持英语、印尼语等多国语言,封堵绕过审核漏洞。

模型监测

- 对模型调用进行实时观测与反馈分析,例如实时采集请求成功率、延迟、Token使用量、模型负载等;

- 对模型生成内容进行自动评分,可实现对模型调用过程的全面可见与可控,也为大模型路由提供实时决策信号,为企业提供成本与性能优化依据。

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2025-11-13,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读

目录