机器人学中的现实鸿沟:挑战、解决方案与最佳实践

机器人学中的现实鸿沟:挑战、解决方案与最佳实践

一点人工一点智能

发布于 2025-11-26 16:25:54

发布于 2025-11-26 16:25:54

编辑:陈萍萍的公主@一点人工一点智能

导读:全文围绕机器人学中仿真与现实之间的差异(即“现实鸿沟”)展开,系统性地分析了其成因、评估方法与应对策略,并展望了未来研究方向。

论文地址:https://arxiv.org/pdf/2510.20808

引言

仿真技术在机器人学习中具有显著优势,包括可扩展性、安全性和效率。通过仿真,机器人可以在部署到现实世界之前进行安全训练,算法可以在多种模拟场景中进行比较,同时可以以较低成本大规模收集数据。然而,仿真与现实世界之间存在显著的“现实鸿沟”,这限制了仿真技术在机器人学习中的广泛应用。现实鸿沟源于仿真中对物理世界的抽象与近似,导致在仿真中训练的策略在现实环境中表现不佳,甚至可能因利用仿真中的不准确模型而产生危险行为。

尽管存在这些挑战,近年来仿真到现实的迁移学习已取得显著进展。特别是在机器人运动、导航和操作等领域,通过域随机化、状态与动作抽象、仿真-现实协同训练等技术,研究者们成功地将仿真中学习到的策略迁移到现实环境中。然而,现实鸿沟仍然是一个未完全解决的问题,需要对其根源、影响及解决方案进行更深入的理解。本综述旨在系统梳理仿真到现实迁移的研究现状,分析现实鸿沟的成因,总结现有解决方案,并提出未来研究方向。

预备知识

为了形式化地描述现实鸿沟与仿真到现实迁移问题,论文引入了部分可观测马尔可夫决策过程(POMDP)作为建模框架。POMDP 定义为元组M=(S,A,T,R,Z,O,γ),其中S是状态空间,A是动作空间,T是状态转移动态,R是奖励函数,Z是观测空间,O是观测模型,γ是折扣因子。在仿真中,我们使用近似的动态模型Ts和观测模型Os来模拟真实世界中的Tr和Or。

现实鸿沟被定义为仿真POMDP Ms真实POMDP Mr之间的差异,主要包括动态差距Gdyn和感知差距Gperc,分别衡量了动态模型和观测模型之间的差异。此外,性能差距Gperf衡量同一策略在仿真与现实环境中期望回报的差异。仿真到现实迁移的目标是找到最小化性能差距的策略,即:

这一目标强调,即使无法完全消除现实鸿沟,只要策略对仿真与现实的差异具有鲁棒性,仍可实现成功迁移。

现实鸿沟的来源

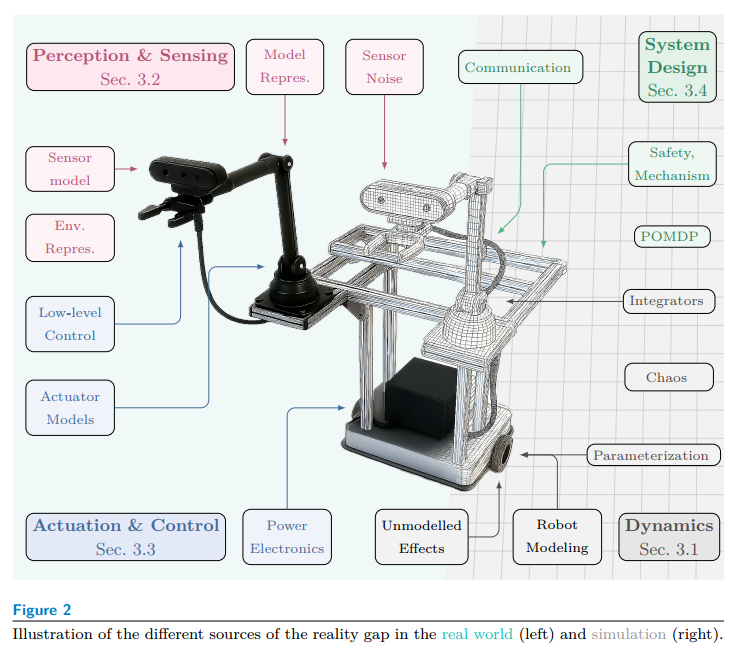

现实鸿沟的来源可分为四大类:动态、感知、执行与控制系统设计。

3.1 动态差距

动态差距源于仿真中对物理动态的不完全建模。具体包括:

· 刚体动力学假设:仿真通常假设物体为理想刚体,忽略变形、柔性关节、阻尼等真实物理特性。

· 混沌与随机性:真实世界中的混沌现象(如湍流)和随机扰动(如地面摩擦变化)难以在仿真中准确再现。

· 电池与能源模型:电池电压随负载变化导致扭矩输出不稳定,这一非线性过程在仿真中常被忽略。

· 接触动力学:真实接触涉及材料变形、摩擦变化等复杂行为,而仿真中常使用简化的点接触或弹簧-阻尼模型。

· 数值积分误差:仿真中使用离散数值积分方法(如欧拉法、龙格-库塔法)会引入累积误差。

· 人机交互建模:人类行为的复杂性与不可预测性难以在仿真中准确模拟。

3.2 感知差距

感知差距主要来自传感器模型的不准确性:

· RGB相机:尽管现代仿真器支持光线追踪和物理渲染,但仍难以模拟镜头畸变、滚动快门等真实效应。

· 深度传感器与LiDAR:仿真中常忽略量化噪声、深度阴影、材料反射特性等。

· 其他传感器:如IMU的漂移、GPS的多路径效应等,在仿真中常被理想化。

· 环境表示:低分辨率资产、简化材质和光照模型导致仿真图像缺乏真实感。

· 碰撞检测:仿真中使用简化几何体(如包围盒)进行碰撞检测,无法精确模拟复杂接触。

3.3 执行与控制差距

执行器与底层控制器是机器人动作的最终执行者,其建模误差会直接影响策略迁移:

· 执行器模型:真实电机具有高阶动态、死区、回差等非线性特性,而仿真中常简化为理想一阶系统。

· 底层控制回路:真实机器人通常包含多层控制器和滤波器(如抗混叠、共振抑制),这些在仿真中常被忽略。

· 功率电子设备:电机驱动器引入的延迟、PWM量化效应和保护逻辑在仿真中未建模。

3.4 系统设计差距

系统层面的差异也会影响现实鸿沟:

· 通信延迟与丢包:真实系统中的网络问题在仿真中常被忽略。

· 安全机制:如虚拟墙、急停逻辑等在仿真中未激活,影响策略行为。

· POMDP建模差异:仿真中可能使用特权信息(如精确碰撞检测)作为奖励信号,这在现实中不可用。

· 实现细节:如控制频率、数值方法等差异会导致仿真与现实行为不一致。

现有解决方案

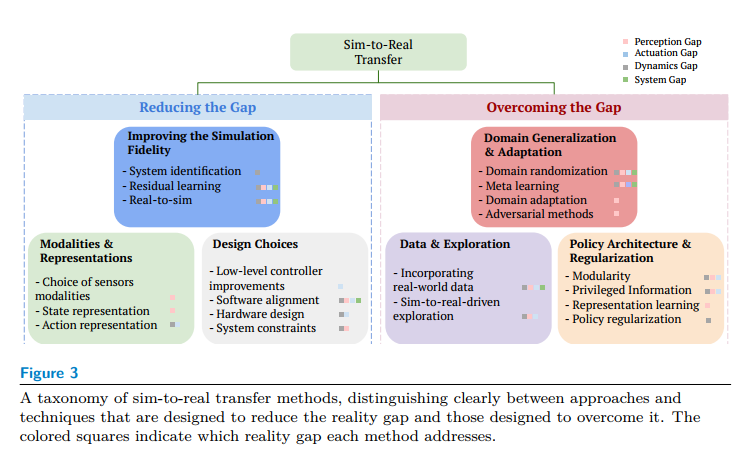

针对现实鸿沟,现有方法可分为两类:一是通过改进仿真来“缩小”鸿沟,二是通过策略设计来“克服”鸿沟。

4.1 缩小现实鸿沟

4.1.1 改进仿真

系统辨识:通过真实数据校准仿真参数,如质量、摩擦、延迟等,已在运动、导航和操作任务中广泛应用。

· 学习残差模型:当参数化模型无法准确描述真实动态时,可训练神经网络对仿真输出或输入进行修正。例如,Gao 等人使用神经网络对气动软体臂的有限元模型施加修正力。

· 真实到仿真建模:利用真实数据构建仿真环境,包括几何重建、运动学辨识和神经渲染(如NeRF、3D Gaussian Splatting)。

4.1.2 选择模态与表示

· 传感器选择:使用深度图像或点云作为观测可减少视觉渲染带来的鸿沟。

· 状态表示:关键点检测、视觉特征跟踪或基础模型嵌入等抽象表示有助于提升策略的泛化能力。

· 动作表示:在操作任务中,使用关节速度控制比位置或扭矩控制更易于迁移。

4.1.3 系统设计选择

提升底层控制频率:高频控制器可更好地应对延迟和扰动。

· 软件栈对齐:确保仿真与真实系统在控制频率、滤波器等方面一致。

· 硬件设计:选择易于建模的执行器和传感器,或采用被动稳定结构。

· 约束系统动态:在初期部署中限制机器人的运动速度与复杂度,降低对模型精度的依赖。

4.2 克服现实鸿沟

4.2.1 域泛化与适应

· 域随机化(DR):在训练中随机化仿真参数(如纹理、光照、物理属性),使策略对参数变化具有鲁棒性。自动域随机化方法可根据策略表现动态调整参数范围。

· 对抗训练:引入对抗智能体施加扰动,提升策略的鲁棒性。

· 元学习:通过元强化学习使策略能够快速适应新环境。

· 域适应:利用真实数据调整策略的观测编码器,减小域间差异。

4.2.2 数据选择与探索

· 融合真实数据:在仿真训练中引入少量真实数据,或使用真实数据指导仿真策略训练。

· 仿真到现实驱动的探索:设计探索策略以识别关键系统参数,或在真实环境中进行策略微调。

4.2.3 策略架构与正则化

· 模块化设计:将视觉、控制等模块分离训练,提升系统可迁移性。

· 特权信息利用:在训练中使用特权信息(如真实状态)提升学习效率,再通过蒸馏将其迁移至仅使用观测的策略。

· 表示学习:通过对比学习、对抗训练等方法学习对域变化不敏感的表示。

· 策略正则化:通过奖励设计或损失函数约束策略的平滑性、动作幅度等,提升稳定性。

评估指标

评估仿真到现实迁移的方法可分为两类:一是评估现实鸿沟本身,二是评估迁移性能。

5.1 评估现实鸿沟

· 仿真到现实相关系数(SRCC):衡量仿真与现实性能之间的相关性,高SRCC表明仿真性能可有效预测现实表现。

· 离线回放误差:通过在仿真中回放真实动作序列,比较状态轨迹差异:

· 视觉保真度分析:使用FID、KID、SSIM等图像质量指标评估仿真图像的逼真度。

5.2 评估仿真到现实迁移性能

· 成功率:最直接的性能指标,适用于各类任务。

· 累积奖励:适用于强化学习策略,能反映策略的长期表现。

· 任务特定指标:如导航任务中的路径效率、操作任务中的目标距离等,提供更细粒度的性能分析。

讨论与开放问题

尽管仿真到现实迁移已取得显著进展,但仍存在多个开放问题与未来方向:

6.1 错误模型与更好控制器

研究表明,即使仿真模型不准确,只要策略或控制器对模型误差具有鲁棒性,仍可实现良好性能。未来研究可探索如何在参数不准确的仿真中高效学习鲁棒策略或世界模型。

6.2 可微分仿真器

可微分仿真器能够提供解析梯度,支持基于梯度的优化。如何将其与基于学习的动态模型结合,是未来的重要方向。

6.3 视频与世界模型

视频模型专注于视觉序列生成,而世界模型旨在学习环境的因果结构以支持规划。两者在机器人仿真中具有潜力,但面临时序一致性、物理合理性与泛化能力等挑战。

6.4 基于仿真的推断

通过贝叶斯方法推断仿真参数的后验分布,可用于指导域随机化。神经后验估计等方法已显示出潜力,未来可进一步推广至复杂物理系统。

6.5 仿真与大机器人模型

仿真可用于生成大规模合成数据以训练机器人基础模型,也可用于系统性地评估现实策略。如何在校准现实鸿沟的同时保持仿真的可扩展性,是一个关键问题。

结论

本综述系统性地分析了机器人学中的现实鸿沟问题,从其成因、影响、解决方案到评估方法,提供了全面的视角。尽管现实鸿沟仍是一个复杂且未完全解决的问题,但通过改进仿真建模、优化策略设计与探索新型学习方法,我们有望在未来进一步缩小仿真与现实之间的差距,推动机器人技术向更广泛的实际应用迈进。

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2025-10-27,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读