DeepSeek,你终于又杀回来了!

两个月前,当DeepSeek-V3.2-Exp(实验版)发布时,我写下了一篇分析,说我看到了开源世界向闭源巨头发起了有力冲击。如果说实验版是一份让人眼前一亮的“模拟考”答卷,那么这份正式版,就是一份直接写着排名、得分和对标竞品的正式成绩单,每一行数据都极具分量,每一个对比都直指要害。

毕竟DeepSeek承载了太多国人的期待,这次,DeepSeek-V3.2正式版,没有让我们失望。

这次发布的,不是一个模型,而是两个。

- DeepSeek-V3.2(标准版)定位是“全能型选手”。目标是在推理能力和使用成本之间取得极致平衡,适合我们日常的问答、编程、和通用的Agent任务。

- DeepSeek-V3.2-Speciale(特别版)定位是“奥赛金牌得主”。不计成本,只为将推理能力推向人类已知的极限,专攻最复杂的科学、数学和逻辑问题。

DeepSeek似乎在告诉市场:我们既有能与顶级闭源模型(如GPT-5)在日常应用中一较高下的“主力部队”,也有能在智力巅峰对决中战胜一切对手的“特种部队”。

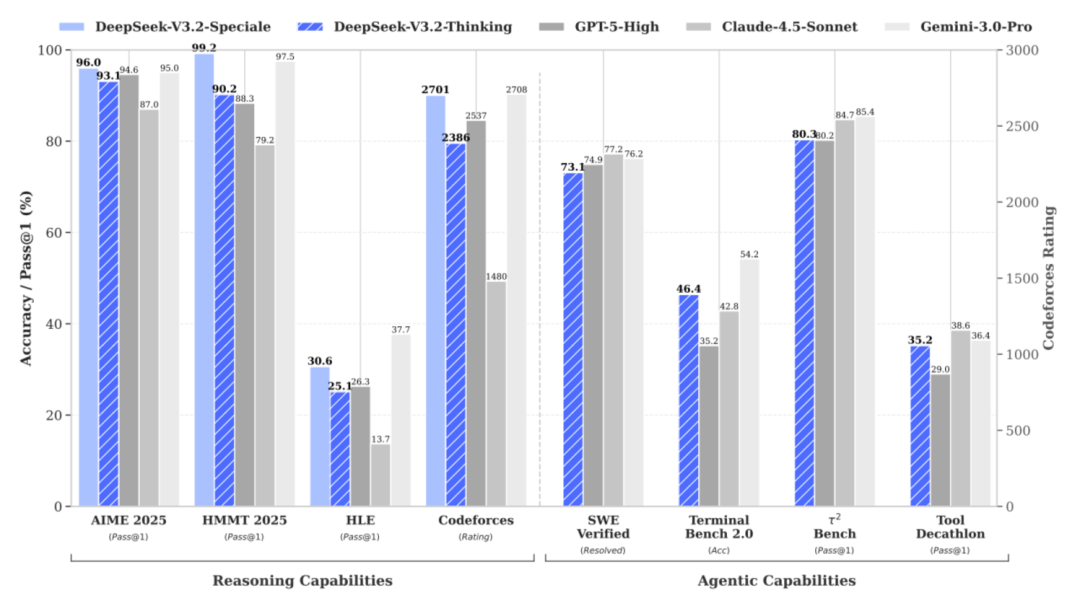

我们先看看“特种部队”DeepSeek-V3.2-Speciale的成绩单:

- IMO 2025 (国际数学奥林匹克): 金牌

- CMO 2025 (中国数学奥林匹克): 金牌

- IOI 2025 (国际信息学奥林匹克): 金牌 (相当于人类选手第10名)

- ICPC World Finals 2025 (国际大学生程序设计竞赛全球总决赛): 金牌 (相当于人类选手第2名)

这份成绩单确实亮眼,这已经不是“模型能力强”可以形容的了。这是通用大模型在人类智力最顶尖、最纯粹的赛场上,实现了降维打击。

再看具体的评测分数对比:

看明白了吗?在AIME和HMMT这两项顶级数学竞赛评测上,Speciale版本的分数全面超越了目前已知最强的闭源模型Gemini-3.0-Pro,并对GPT-5-High形成碾压之势。Codeforces编程能力也与Gemini-3.0-Pro平起平坐。代价是消耗更多的tokens进行“长思考”,但结果证明,这种投入是值得的。它向世界证明了,在推理能力的上限上,开源模型完全可以做到世界第一。

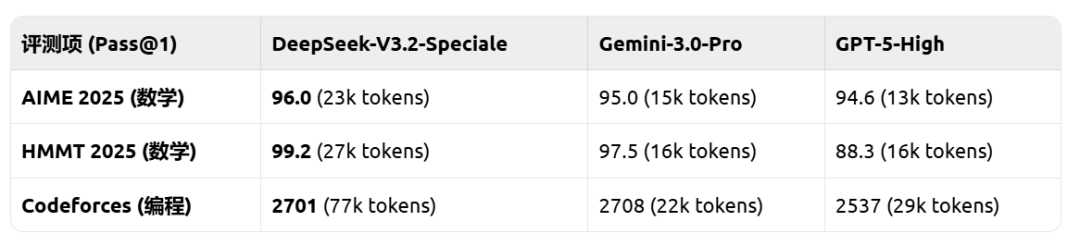

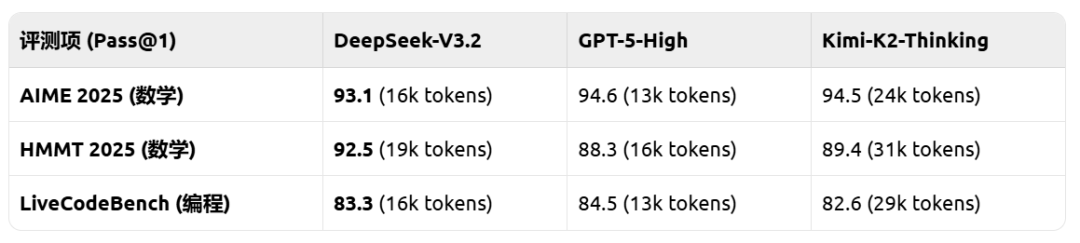

再看“主力部队”DeepSeek-V3.2的表现:

官方公告里有一句极具分量的话:“在公开的推理类Benchmark测试中,DeepSeek-V3.2达到了GPT-5的水平,仅略低于Gemini-3.0-Pro。”

以下是对比数据:

从数据中我们可以清晰地读出三点:

- 能力对标V3.2的推理能力确实已经和GPT-5-High在同一梯队,互有胜负。

- 效率优势相比国内同样以推理见长的Kimi-K2-Thinking,V3.2在取得相似甚至更高分数的同时,消耗的tokens(括号内数字)减少了近40%-50%。这意味着更快的响应速度和更低的使用成本。

- 技术基石这一切都建立在实验版已经验证成功的DSA稀疏注意力机制之上,它从底层架构保证了模型在处理长文本时的高效率和低成本,让这种“既要又要”(高性能+低成本)的平衡成为了可能。

这第一张王牌,打出了开源模型的信心和底气。它告诉我们,开源不仅能追,还能赶超。

让Agent学会“思考”,而不只是“执行”

如果说推理能力的登顶是“深度”上的突破,那么Agent(智能体)能力的进化,则是“广度”和“实用性”上的再升级。

不同于过往版本在思考模式下无法调用工具的局限,DeepSeek-V3.2 是首个将思考融入工具使用的模型,并且同时支持思考模式与非思考模式的工具调用。DeepSeek还提出了一种大规模 Agent 训练数据合成方法,构造了大量「难解答,易验证」的强化学习任务(1800+ 环境,85,000+ 复杂指令),大幅提高了模型的泛化能力。

这些任务都有一个共同特点:“难解答,易验证”。比如要做个“杭州三日游”的规划,规划过程千头万绪,但验证一个方案是否符合所有约束条件却相对简单。通过在这种海量、高质量的“逆向工程”任务中进行强化学习,V3.2学会了真正的“运筹帷幄”。

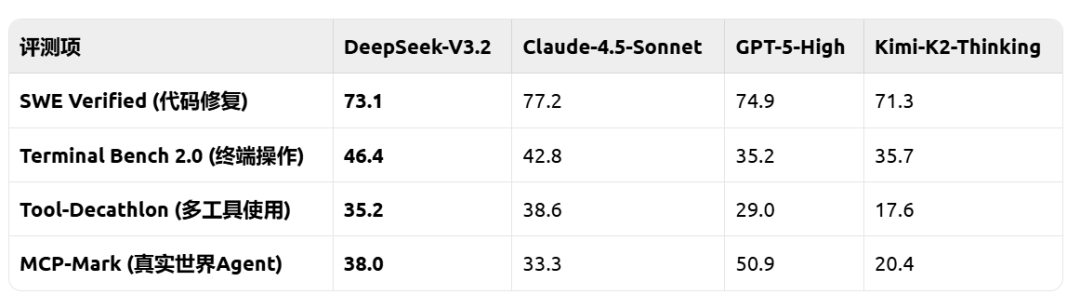

我们再来看它在Agent评测上的“成绩单”,这次的对比对象,是所有主流的开源和闭源模型:

这份成绩单传递的信息同样清晰:

- 开源领军在所有智能体相关的评测中,DeepSeek-V3.2的得分全面、大幅度地超越了目前所有的其他开源模型。尤其是在Tool-Decathlon和MCP-Mark这类复杂任务上,优势几乎是碾压性的。

- 缩小鸿沟它极大地缩小了与Claude、GPT-5等顶级闭源模型在Agent能力上的差距,甚至在某些项目(如Terminal Bench)上实现了反超。

- 泛化潜力官方特别强调,V3.2并没有针对这些评测集进行特殊训练。这意味着它在训练中学会的是通用的、可泛化的Agent能力,这在真实应用场景中的价值,远高于在某个榜单上刷分。

这意味着我们手中的AI,正在从一个“问答机”,进化为一个真正可以协同工作的“数字员工”。结合MCP server它能在你给出复杂指令后,自主思考、规划步骤、调用工具、解决问题,最终交付结果。

下面是我用DeepSeek-V3.2在执行出行规划任务,调用搜索工具情况下的测试结果,DeepSeek-V3.2在调用三次工具不成功的情况下果断停止,基于自己的知识输出方案,避免了循环调用工具导致token消耗巨大的问题。其实调用失败是常见现象,之前我用过很多模型,看起来能力很强,但其实是以消耗token为代价的。

最后总结一下:

DeepSeek-V3.2正式版的发布,远不止是一次简单的模型迭代。

尽管DeepSeek-V3.2与那些闭源巨头相比仍存在差距,但它正在迎头赶上,它也在向整个行业宣告:

- 开源模型,可以在核心能力上问鼎全球。

- 开源模型,可以在应用落地上比肩巨头。

- 开源模型,可以走出一条不依赖模仿、自我进化的创新之路。

本公众号聚焦实战,拆解最新的AI工具与商业案例。不讲空话,直接讲透如何解决实际业务问题、驱动公司业务成长。我们的目标:让您读到的每一次思考、每一个案例,都能带来启发,拿来就能用。若您有意进一步探讨相关内容,欢迎扫描下方二维码添加好友,以便我们更充分地沟通学习,一起提升!

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2025-12-02,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读