Kafka Consumer原理分析及特性总结

Kafka Consumer原理分析及特性总结

SmileNicky

发布于 2025-12-17 18:03:42

发布于 2025-12-17 18:03:42

1. 一段话总结

本文围绕Kafka Consumer展开,详细解析了Offset维护原理(含存储于特殊Topic __consumer_offsets、未找到Offset时的auto.offset.reset策略及手动/自动提交机制)、消费者与分区的关系(默认RangeAssignor等分配策略、触发ReBalance的场景及Coordinator的管理作用),同时介绍了Kafka高性能的核心原因(顺序读写、索引、批量操作与压缩、零拷贝机制),并给出了保障消息不丢失的关键配置(如Producer端acks=all、Broker端replication.factor≥3等)。

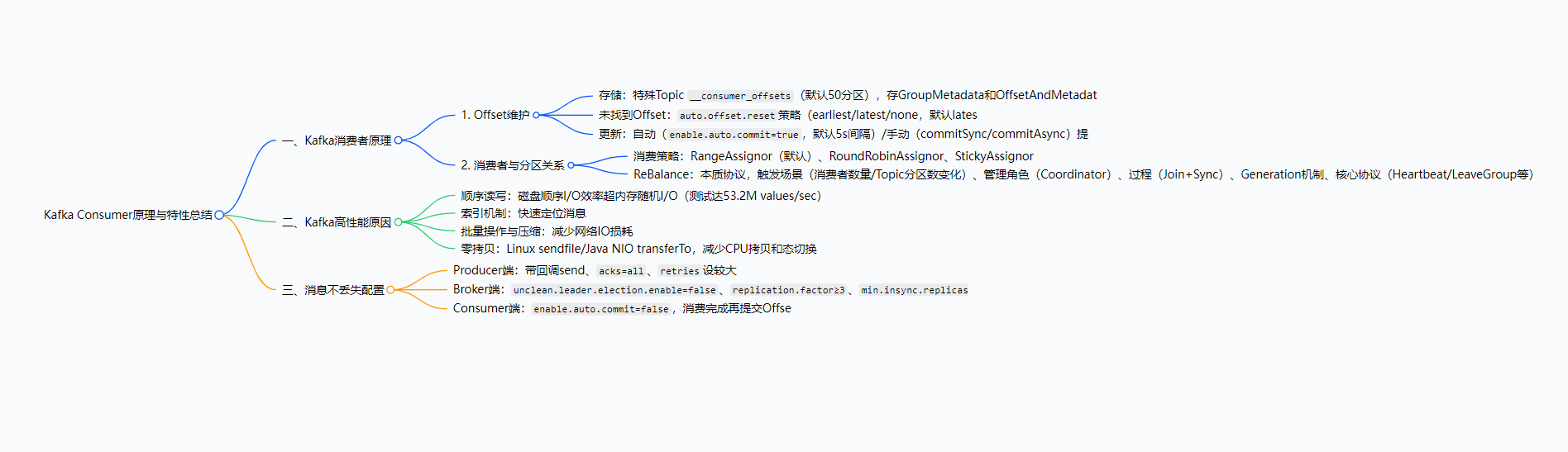

2. 思维导图(mindmap)

在这里插入图片描述

3. 详细总结

一、Kafka消费者原理

1. Offset维护原理

Offset是消费者消费消息的位置标识,其维护直接影响消费连续性,核心包括存储、未找到时的策略及更新机制三部分:

Offset存储

存储位置:早期存ZK,现存Broker端特殊Topic __consumer_offsets(默认offsets.topic.num.partitions=50个分区,每个分区默认1个副本)。

存储内容:该Topic存储两类序列化对象

GroupMetadata:消费者组内各消费者信息(含编号)OffsetAndMetadata:消费者组与各分区的Offset元数据(含Offset值、提交时间等)

分区映射:通过哈希计算确定消费者组Offset对应的__consumer_offsets分区,公式为Math.abs(consumer_group_id.hashCode()) % 50(如组gp-assign-group-1计算后对应某一分区)。

查看方式:

查看消费者组与分区的Offset关系:

./kafka-consumer-groups.sh --bootstrap-server 192.168.8.144:9092,192.168.8.145:9092,192.168.8.146:9092 --describe --group gp-assign-group-1结果字段含义如下表:

字段 | 含义说明 |

|---|---|

PARTITION | 分区编号 |

CURRENT-OFFSET | 下一个未使用的Offset |

LOG-END-OFFSET(LEO) | 下一条待写入消息的Offset(最新Offset+1) |

LAG | 消费延迟量(LEO - CURRENT-OFFSET) |

CONSUMER-ID | 消费该分区的消费者ID |

查看__consumer_offsets内容:

./kafka-console-consumer.sh --topic __consumer_offsets --bootstrap-server 192.168.8.144:9092,192.168.8.145:9092,192.168.8.146:9092 --formatter "kafka.coordinator.group.GroupMetadataManager\$OffsetsMessageFormatter" --from-beginning未找到Offset的处理策略

当新消费者组消费已有分区(无历史Offset记录)时,由auto.offset.reset参数控制消费起始位置,参数取值及含义如下表:

参数值 | 含义说明 |

|---|---|

earliest | 从最早的消息(序号最小)开始消费,可获取历史消息 |

latest | 从最新的消息(最后发送)开始消费,默认值,无法获取历史消息 |

none | 若未找到消费者组的历史Offset,直接抛出异常 |

其他值 | 抛出异常 |

Offset更新机制 Offset由消费者主动提交给Broker更新,分为自动提交和手动提交两种方式:

- 自动提交:

enable.auto.commit=true(默认),消费者消费消息后自动提交,提交频率由auto.commit.interval.ms控制(默认5秒)。 - 手动提交:

enable.auto.commit=false,需调用方法触发提交consumer.commitSync():同步提交,提交成功前阻塞consumer.commitAsync():异步提交,不阻塞但需处理回调

- 注意:若不提交或提交失败,Broker端Offset不更新,下次消费会重复获取消息。

2. 消费者与分区的关系

消费者组(Consumer Group)对Topic分区的消费分配及动态调整是核心,包括消费策略、ReBalance机制两部分:

- 消费策略(分区分配策略)

消费者组内的消费者与Topic分区遵循“一个消费者可消费多个分区,但一个分区仅能被组内一个消费者消费”的规则,分配策略由

partition.assignment.strategy参数控制,支持三种策略: 策略名称分配逻辑示例(5分区,2消费者)RangeAssignor(默认)按分区序号连续分配,“按坨分配”消费者1:分区0、1、2;消费者2:分区3、4RoundRobinAssignor轮询分配,按消费者顺序依次分配分区消费者1:分区0、2、4;消费者2:分区1、3StickyAssignor优先保证分区分配均匀,其次尽量与上次分配保持一致(结果不固定)可能为消费者1:分区0、3、4;消费者2:分区1、2- 特殊场景:若消费者数量>分区数量,多余消费者无分区可消费(“站着上课”)。

- 手动指定分区:使用

consumer.assign(Arrays.asList(tp))(tp为TopicPartition对象),此时消费者组ID失效,不参与自动分配。

- ReBalance(分区再均衡)

ReBalance是消费者组动态调整分区分配的协议,确保分区在消费者变化时仍均匀分配:

- 触发场景:

- 消费者组内消费者数量变化(新增/下线消费者)

- 订阅的Topic分区数变化(新增/减少分区)

- 管理角色:Coordinator(GroupCoordinator),每个消费者组对应一个Coordinator,由

__consumer_offsets分区的Leader所在Broker担任。 - 核心机制:

- ReBalance Generation:“届”,每次ReBalance后Generation号+1,上一届消费者无法向新一届提交Offset(隔离无效提交)。

- 核心协议:共5种,ReBalance主要用到前4种 协议名称作用说明Heartbeat消费者定期向Coordinator发送心跳,证明存活LeaveGroup消费者主动告知Coordinator退出组SyncGroup组内Leader将分配方案同步给所有成员JoinGroup消费者请求加入组,Coordinator收集成员信息DescribeGroup查看组信息(成员、分配方案等),供管理员使用

- 执行流程:分为Join和Sync两步

- Step 1(Join):所有消费者发送

JoinGroup请求给Coordinator,Coordinator选1个消费者作为Leader,并将成员/订阅信息发给Leader。 - Step 2(Sync):Leader制定分配方案,通过

SyncGroup请求上报Coordinator;其他消费者发送空SyncGroup请求,Coordinator将方案通过响应返回给所有消费者。

- Step 1(Join):所有消费者发送

- 触发场景:

二、Kafka高性能核心原因

Kafka基于磁盘存储却能实现百万级TPS(普通服务器测试数据),核心依赖四大机制:

- 顺序读写

- 原理:Kafka消息仅追加到磁盘文件末尾(顺序写),消费时按顺序读取,避免磁盘随机寻址的耗时(随机I/O需反复定位扇区,顺序I/O无需重复寻址)。

- 性能对比:测试显示磁盘顺序读写速度达53.2M values/sec,超内存随机读写(36.7M values/sec)。

- 索引机制

- 作用:通过索引文件快速定位消息在数据文件中的位置,减少磁盘I/O次数,提升消费效率。

- 批量操作与文件压缩

- 批量操作:将多条消息打包成

RecordBatch批量传输和存储,减少网络请求和磁盘操作次数。 - 文件压缩:对批量消息进行压缩(如Gzip、Snappy),降低网络传输带宽和磁盘存储占用。

- 批量操作:将多条消息打包成

- 零拷贝机制

- 传统I/O问题:消费消息需4次拷贝(磁盘→内核缓冲区→用户缓冲区→Socket缓冲区→网卡)、4次态切换(用户态↔内核态),CPU参与2次拷贝,效率低。

- 零拷贝实现:依赖Linux

sendfile系统调用(Java中对应FileChannel.transferTo方法),直接从内核缓冲区将数据传输到网卡(仅2次DMA拷贝,无CPU拷贝),减少态切换和拷贝次数,性能提升至少1倍。

三、Kafka消息不丢失配置

需从Producer、Broker、Consumer三端协同配置,保障消息全链路不丢失:

端类型 | 配置项 | 配置值/建议 | 作用说明 |

|---|---|---|---|

Producer | 消息发送方法 | 使用producer.send(msg, callback) | 通过回调感知发送失败,针对性处理(如重试) |

acks | all | 消息需被所有副本(含Leader和Follower)接收,才视为“已提交” | |

retries | 较大值(如10) | 网络抖动时自动重试发送,避免临时失败导致消息丢失 | |

Broker | unclean.leader.election.enable | false | 禁止落后过多的Follower竞选Leader,避免消息丢失 |

replication.factor | ≥3 | 每个分区至少3个副本,提升数据冗余度 | |

min.insync.replicas | >1(如2) | 消息需写入至少2个副本才视为“已提交”,推荐replication.factor = min.insync.replicas + 1 | |

Consumer | enable.auto.commit | false | 关闭自动提交,确保业务逻辑处理完成后再手动提交Offset,避免消费未完成却提交导致消息丢失 |

4. 关键问题

问题1:Kafka消费者组的Offset为何从ZK迁移到__consumer_offsets Topic?两种存储方式的核心差异是什么?

- 答案:早期Offset存储于ZK,因ZK的设计定位是分布式协调(而非高频读写存储),当消费者组数量多、Offset更新频繁时,会导致ZK读写性能损耗大,无法支撑高并发场景;迁移到

__consumer_offsetsTopic后,利用Kafka本身的高吞吐、高可用特性(分区副本机制),能高效承载Offset的存储与更新。 核心差异如下表: 对比维度ZK存储Offset__consumer_offsetsTopic存储Offset性能高频读写损耗大,性能低依托Kafka高吞吐,性能高可用性依赖ZK集群,无Kafka自身副本保障支持分区副本(默认1副本,可配置更多),可用性高存储内容仅Offset值含Offset值、提交时间、消费者组元数据等完整信息

问题2:Kafka的ReBalance机制可能导致“消费停顿”,如何从配置和策略上减少ReBalance的频率和影响?

- 答案:减少ReBalance需从“避免触发场景”和“优化机制”两方面入手:

- 避免不必要的触发场景:

- 控制消费者数量:确保消费者数量≤Topic分区数,避免多余消费者(减少消费者下线触发ReBalance的概率)。

- 稳定Topic分区:提前规划好Topic分区数,避免频繁新增/减少分区。

- 优化消费者存活检测:合理设置

session.timeout.ms(默认10秒,消费者断连后Coordinator等待的超时时间)和heartbeat.interval.ms(默认3秒,心跳发送间隔),避免因网络波动误判消费者下线(建议heartbeat.interval.ms设为session.timeout.ms的1/3)。

- 优化ReBalance影响:

- 使用StickyAssignor策略:该策略尽量保持分区分配与上次一致,减少ReBalance后分区迁移的范围,降低消费停顿时间。

- 批量提交Offset:手动提交时避免频繁提交,减少ReBalance时Offset提交冲突的概率。

- 避免不必要的触发场景:

问题3:在保障Kafka消息不丢失的配置中,为何要求replication.factor > min.insync.replicas?若两者相等会导致什么问题?

- 答案:

replication.factor是分区的副本总数,min.insync.replicas是消息“已提交”所需写入的最小副本数,要求replication.factor > min.insync.replicas的核心目的是“保留冗余副本,应对部分副本下线场景”,确保分区仍能正常写入消息。 若两者相等(如replication.factor=2且min.insync.replicas=2),当任意一个副本(如Follower)下线时,剩余副本数(1个)<min.insync.replicas(2个),此时Broker会拒绝Producer的消息写入请求,导致整个分区无法正常工作,影响业务可用性。 推荐配置示例:replication.factor=3、min.insync.replicas=2,即使1个副本下线,剩余2个副本仍满足min.insync.replicas要求,分区可正常写入,同时保留1个冗余副本应对极端情况。

本文参与 腾讯云自媒体同步曝光计划,分享自作者个人站点/博客。

原始发表:2025-12-17,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读

目录