在地球卷AI太费电?谷歌密谋“太空显卡”,把AI数据中心射上天!

在地球卷AI太费电?谷歌密谋“太空显卡”,把AI数据中心射上天!

AgenticAI

发布于 2025-12-18 21:02:31

发布于 2025-12-18 21:02:31

轨道上最值钱的,不是燃料,是算力。

“太空能源”这个词,早就不是科幻专供了。从阿西莫夫的短篇到NASA的白皮书,人类想上天薅太阳羊毛的心思,就没断过。但把能量转化成百Gbps的光束打回地球,还要克服大气层这个天然“信号屏蔽器”,这事儿光想想就让人想挠头。

Google的一群研究员最近在arXiv上挂出了一篇编号2511.19468v1的论文,标题挺唬人,叫《面向未来的、基于太空的高可扩展AI基础设施系统设计》。既然电传下来这么难,那我们干脆把数据中心也一起搬上去,直接在太空里炼AI模型。 这个逻辑像极了“既然外卖送过来凉了,那我直接到你家厨房做饭”。简单、粗暴,但又隐约觉得……好像还真有点道理?

1 轨道显卡农场:三体人看了都说绝

这群人的算盘是怎么打的呢?他们绕过了“能量无线传输”这个超级难题,转而去解决另一个听起来更实际的方案:在近地轨道上,用一群“扎堆飞行”的卫星,直接构建一个分布式超级计算集群。

每颗卫星,就是一个会飞的“AI计算节点”:

- 能源:超大面积的太阳能帆板。在晨昏轨道上,几乎能获得连续日照,年接收能量是地面同面积板的8倍。

- 算力:塞进Google自家的Trillium TPU加速芯片。这是谷歌云里跑大模型的“心脏”。

- 散热:真空中散热是难题,方案是用热管把芯片热量导向专门的散热板,直接朝宇宙深空辐射掉。

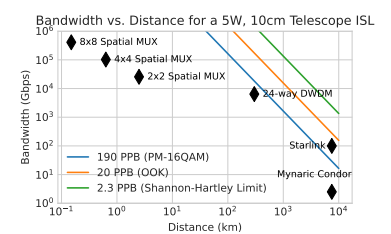

- 联网:这是最科幻的部分——卫星之间用激光通信。不是那种几千公里才一发的老式激光,而是让卫星“贴贴”飞行,距离缩短到几百甚至几公里内。距离近了,激光的能量衰减就小了,能实现单链路10 Tbps的恐怖带宽,比现有星间激光通信快两个数量级。

为什么要贴贴飞?论文里这个图很直观:激光信号强度跟传输距离的平方成反比。想把商业数据中心里用的那种高速光模块(比如400G DWDM)搬到太空用,接收端需要“数百微瓦”的功率。而传统长距离星间激光,通常只能收到1微瓦左右。

怎么办?把卫星间距从几千公里缩小到几百公里,能量就够用了。再近到10公里级别,甚至能玩“空间多路复用”——在一个口径里塞进多束独立激光,带宽还能再翻倍。

你可以把这个集群想象成一块飘在太空里的巨型分布式显卡,81颗卫星(论文中的示例)组成一个半径1公里的球,在轨道上保持着精妙的队形,边飞边并行计算。

2 真正的考验:宇宙射线来“改答案”

把精密的地面芯片扔进太空,最大的敌人不是真空,不是低温,而是无孔不入的高能粒子。宇宙射线和太阳风里的质子,打到芯片上,可能引发两种后果:

- 累计电离效应:像慢性中毒,电荷在绝缘层里慢慢累积,久了芯片就“衰老”、性能下降。

- 单粒子效应:像突如其来的“爆头”。一个高能粒子打中关键电路,可能直接让内存里的一个0变成1,或者1变成0。这就是比特翻转。

对于在太空里训练AI模型来说,比特翻转是致命的。它不会导致程序崩溃,而是静默数据损坏——模型权重被悄咪咪改错了,训练出的结果看似正常,实则全错,你都不知道错在哪一步。

谷歌干了件挺硬核的事:他们把最新的Trillium TPU连同上游的AMD主机,一起送到了加州大学戴维斯分校的核实验室,用67 MeV的质子束持续轰击,模拟太阳同步轨道上5年寿命期的辐射环境。

测试结果有点意思:

- 高带宽内存最脆弱:累计辐射到2 krad(Si)时(目标要求是750 rad),内存测试开始出现异常。但对核心计算单元和端到端的AI负载测试来说,撑到15 krad都没出现硬性故障。

- 比特翻转率可以接受:对于推理任务,在轨每年150 rad的辐射量下,HBM内存出现不可纠正错误的概率,大概是一千万次推理里发生一次。但训练任务的容错性,还需要进一步研究。

结论是:经过适当筛选和加固,现有的高性能AI芯片,确实有可能在近地轨道生存数年。这为“太空算力”扫除了一个根本性的技术障碍。

3 算经济账:发射费降到“白菜价”是关键

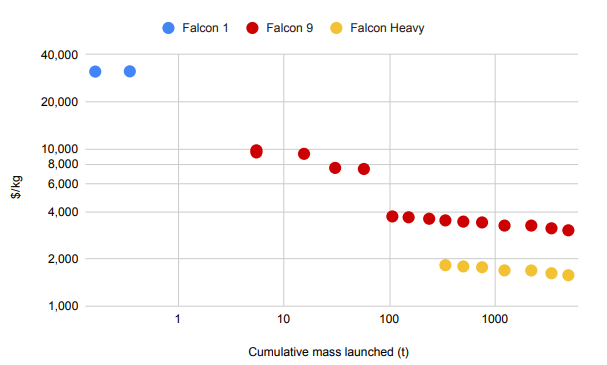

历史上,任何太空基建的梦想,都会被一个现实问题击碎:发射太TM贵了。论文也承认,整个方案的经济可行性,完全押注在发射成本持续且大幅下降这个前提上。

他们翻出了SpaceX的“学习曲线”:从猎鹰1号到猎鹰9号再到猎鹰重型,每次累积发射质量翻倍,每公斤的发射成本就下降约20%。如果这个趋势能保持(这需要像星舰这样的大运力可回收火箭成功,并保持每年约180次的高频发射),那么到2035年左右,近地轨道的发射成本有望降到200美元/公斤以下。

这个数字是个重要的心理关口。因为对地太阳能电站等类似太空基建的分析认为,地球同步转移轨道发射成本降到500美元/公斤(换算到近地轨道约200美元/公斤)是盈亏平衡点。

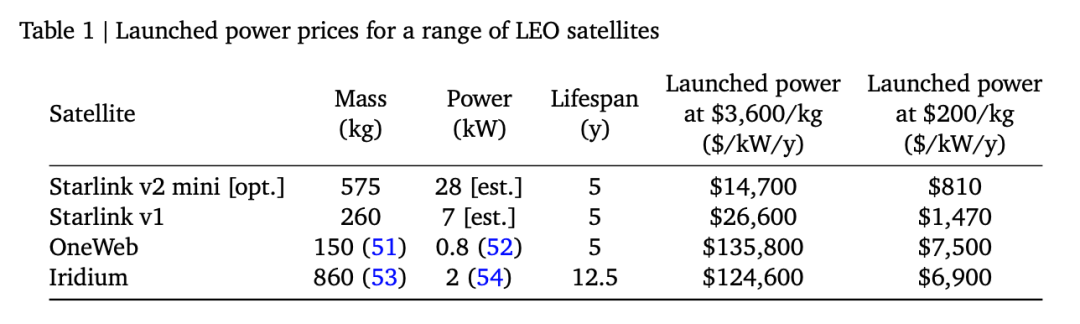

论文算了笔账:如果发射成本降到200美元/公斤,那么像星链V2迷你版这样的卫星(重575公斤,功率约28千瓦),其平摊到每年的“发射能量成本”约为810美元/千瓦/年。

做个对比:目前美国地面数据中心,算上电费和基础设施损耗,每年的电力成本大约在 570 - 3000美元/千瓦/年。

也就是说,在最理想的情况下,未来在太空“发电+计算”的平摊成本,可能跟在地面买电差不多。

4 太空AI的未来:从“显卡”到“细胞自动机”

当然,论文描绘的还只是一个远景的第一步。除了发射成本,还有一大堆难题:

- 散热:TPU是电老虎,也是发热大户。在真空中把巨量废热高效排出去,是个顶级工程挑战。

- 地面高速通信:训练好的模型、推理的结果,总要传回地球。未来需要建立星地高速激光链路,对抗大气湍流。

- 在轨维护:地面坏了换块卡,天上坏了怎么办?目前思路很简单:冗余,冗余,还是冗余。

更有趣的是文章最后提到的一个前瞻概念:现在设想的还是“卫星是卫星,计算机是计算机”的拼接模式。但真正大规模、超集成化的太空计算,可能需要全新的架构。

比如,未来或许会出现一种集计算、散热、能源于一体的“神经细胞自动机”计算基底,它本身就是一个可以生长、自修复的有机计算单元。这篇文章里基于TPU的卫星集群,只是开启那个潜在未来的第一声敲门砖。

5 最后

看完这篇论文,我的感觉是:它把科幻级别的构想,用极度工程化和量化的方式拆解了一遍。

它没有空谈“星辰大海”,而是告诉你:

- 带宽差多少?(需要10 Tbps)

- 辐射有多猛?(测试了15 krad)

- 成本怎么算?(瞄准200美元/公斤)

- 队形怎么飞?(81颗卫星半径1公里)

每一个挑战都有对应的技术路径和初步数据支撑。这是一种非常谷歌范儿的“登月项目”写法:先定义那个遥不可及的最终目标,然后倒推回来,找出第一个必须攻克的、可验证的里程碑。

这未必是未来AI算力的唯一解,甚至未必是最优解。但它提供了一种跳出大气层思考的疯狂样本:当算力需求指数级增长,当能源和散热成为地面数据中心的紧箍咒时,我们或许真的需要仰望星空,把整个信息产业的基础设施,向上推一个维度。

毕竟,太阳就在那里,每秒输出着人类总能耗的100万亿倍。与其在地面上争夺电网配额,不如去轨道上,把数据中心建在离电源最近的地方。

至于这个“太空显卡农场”到底能不能建成?谁知道呢。但至少,有人开始认真地计算,把科幻变成现实的第一个公式了。

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2025-12-02,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读