LiveKit Agents 深度技术架构剖析

原创摘要:本文档以资深系统架构师的视角,深入剖析 LiveKit Agents 框架的设计哲学与实现细节。不同于常规的功能说明,本文将聚焦于并发模型选择、自定义 IPC 协议设计、低延迟音频流处理关键路径以及进程级故障隔离机制。

0. LiveKit Agents是什么

LiveKit Agents 框架是一个基于 Python 的系统,旨在构建、部署和管理与 LiveKit WebRTC 基础设施交互的实时对话式 AI Agent。它提供了一个强大的 Worker 模型来管理进程、连接和作业分配,同时提供通过插件架构集成各种 AI 服务(STT、LLM、TTS、VAD)的能力。

简单说,就是提供基于LiveKit房间的智能对话能力。

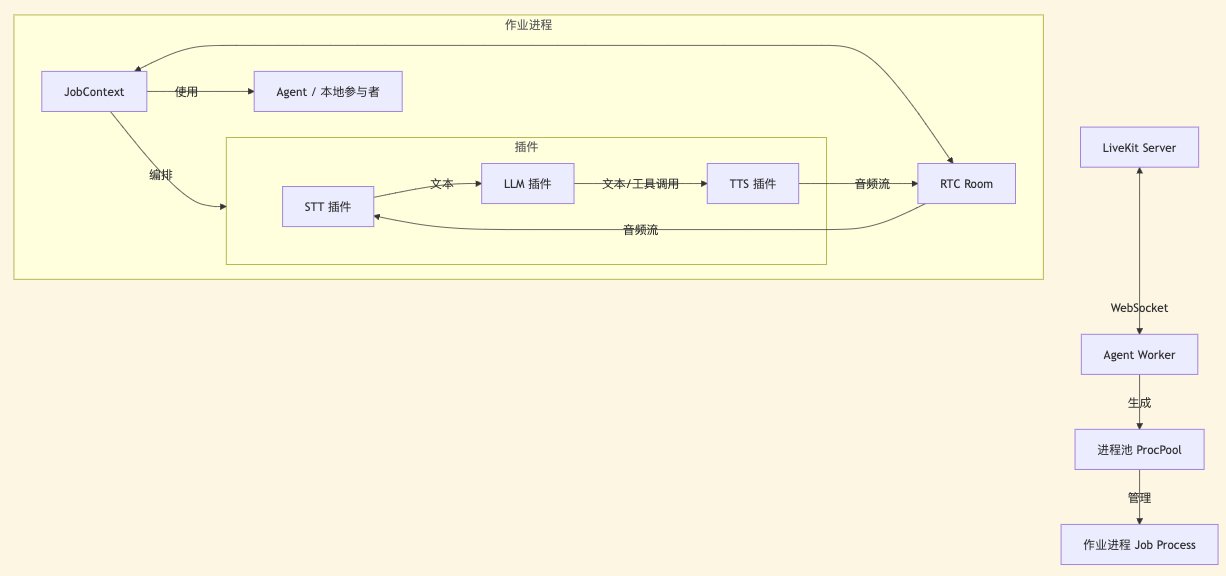

高层架构图

1. 架构设计哲学:稳定性与隔离性

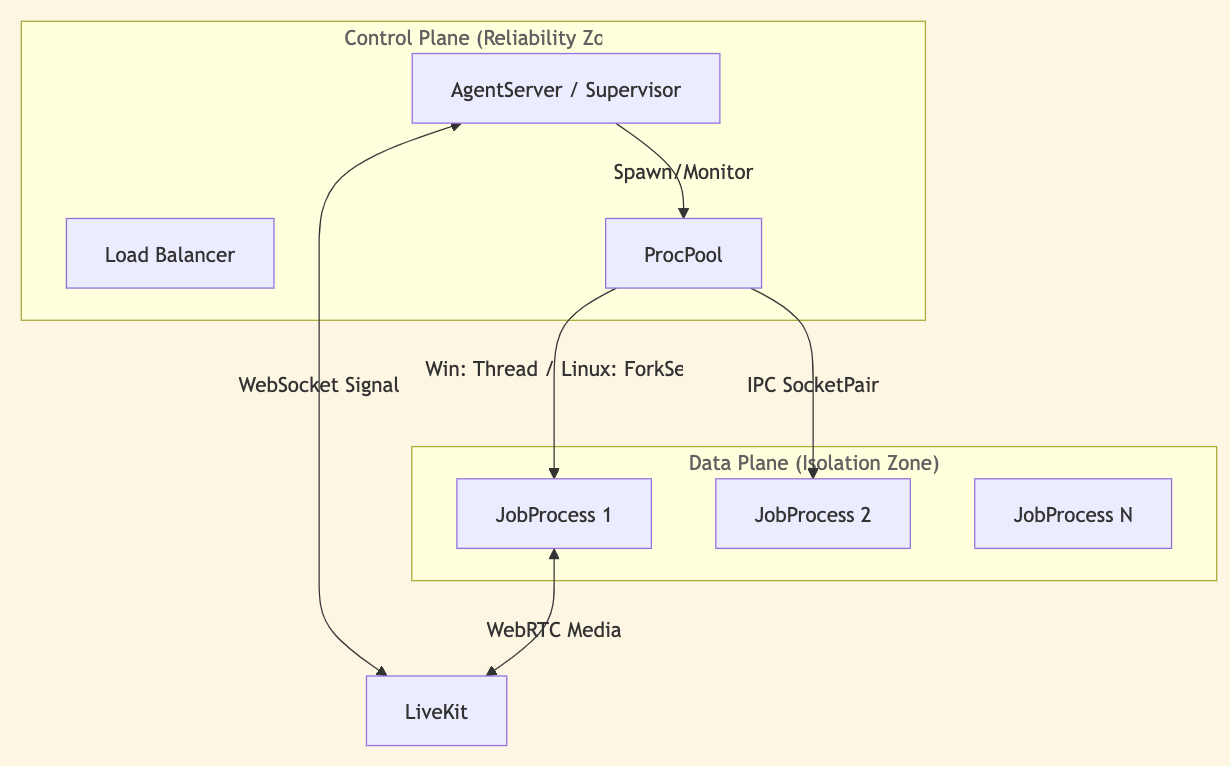

LiveKit Agents 的核心设计目标是在不稳定的 AI 模型(可能产生 hallucinations 或 crash)与高实时性的 WebRTC 通信之间建立一道防火墙。为此,框架采用了 "Supervisor-Worker" 的多进程架构模式。

1.1 进程隔离模型

- Supervisor (AgentServer):作为控制平面,负责维持与 LiveKit Server 的 WebSocket 长连接,处理信令调度、负载均衡(CPU/Memory 监控)及进程池管理。该进程设计为极轻量级,确保即使在高负载下也能保持心跳响应。

- Worker (JobProcess):作为数据平面,承载具体的业务逻辑与 AI 模型推理。每个 Room 的会话通常运行在一个独立的进程中(

JobExecutorType.PROCESS),确保单点故障(如 Python GIL 锁死、C++ 扩展崩溃)仅影响当前会话,而不会波及整个节点。

2. 深度并发与 IPC 机制

框架并没有简单使用 Python 标准库的 multiprocessing.Queue,而是设计了一套基于 Unix Domain Sockets (UDS) / Pipe 的高性能自定义二进制协议。

2.1 协议设计 (ipc/proto.py & ipc/channel.py)

- 二进制传输:为了避免 Pickle 序列化的性能开销及安全风险,IPC 通信采用了自定义 TLV (Type-Length-Value) 格式的二进制协议。

- 双通道分离:

- 控制通道 (Control Channel):传输 StartJobRequest, ShutdownRequest,

Ping/Pong等低频高敏控制指令。 - 数据通道 (Data Channel):(如有) 传输推理数据。注:媒体流 (Audio/Video) 直接通过 WebRTC 传输,不经过 IPC,这是降低延迟的关键设计。

- 控制通道 (Control Channel):传输 StartJobRequest, ShutdownRequest,

2.2 跨边界异步桥接

每个 JobProcess 内部运行一个独立的 asyncio 事件循环。父进程(Supervisor)通过 aio.Chan 和 duplex_unix 模块将阻塞的 Socket I/O 桥接到 asyncio 协程中,实现了跨进程的“全异步链路”。

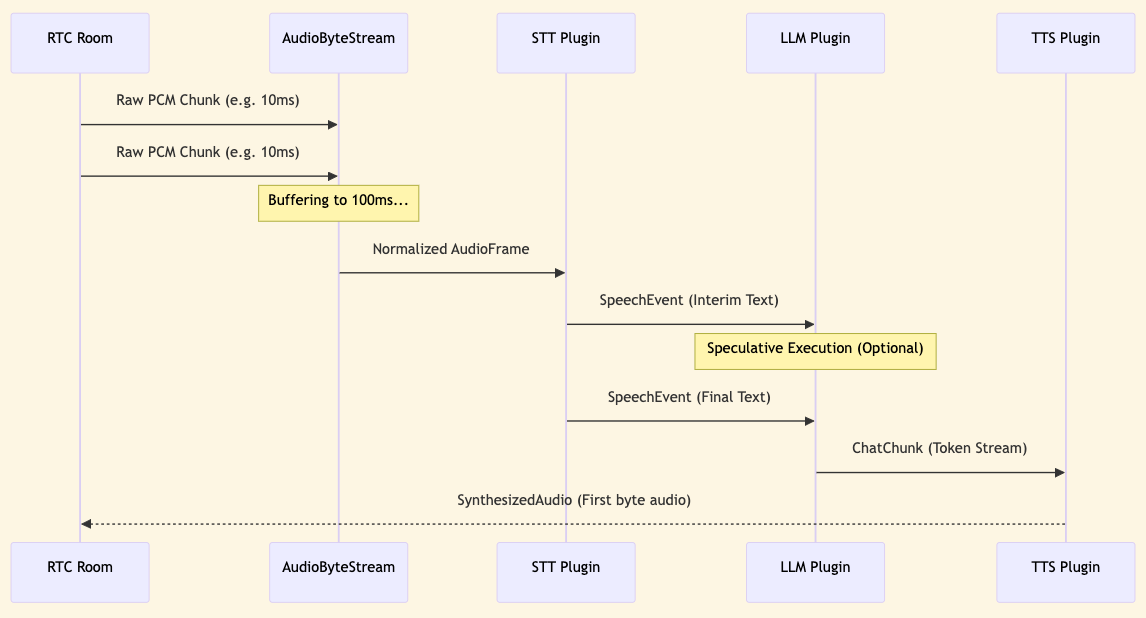

3. 低延迟音频关键路径 (Critical Path Analysis)

在实时 AI 对话中,端到端延迟(E2E Latency)是核心指标。LiveKit Agents 在架构上对此做了极致优化。

3.1 音频流处理流水线

- Ingestion (C++ -> Python):

rtc.Room接收 WebRTC 音频包,底层 (C++ SDK) 解码为 PCM,通过ffi零拷贝或高效内存视图传递给 Python 层。 - Buffering (**

utils.audio.AudioByteStream**):- 框架内置 AudioByteStream 进行微缓冲。它不是简单地有数据就发,而是尝试构建固定时长(如 100ms)的帧。

- 架构权衡:这是一种 Latency vs. Efficiency 的 Trade-off。过小的包会导致 STT/LLM 调用频繁,开销巨大;过大的包会引入明显的缓冲延迟。LiveKit 选择在 Worker 侧进行归一化,确保下游插件收到稳定的数据流。

- Streaming Inference:

- 所有插件接口 (STT, LLM, TTS) 均被强制设计为 Stream-first。

- 这里的关键是

AsyncIterator的广泛使用(如SpeechStream, LLMStream)。数据在各级 Pipeline 之间是“流动”的,而非“等待完整响应”。

4. 弹性与高可用保障 (Resilience Patterns)

4.1 监督树模式 (Supervision Tree)

SupervisedProc 类实现了一个类似于 Erlang OTP 的监督者模式:

- 心跳保活:主进程每

ping_interval(默认 2.5s) 发送 Ping 包。若子进程在high_ping_threshold内未响应,视为“假死”(可能 GIL 锁死),触发警告;若超时,直接 Kill。 - 资源熔断:主进程独立监控子进程的内存使用 (

psutil)。一旦只有 AI 模型发生内存泄漏(OOM),父进程会主动介入杀死子进程并进行清理,防止服务器雪崩。

4.2 优雅退出与状态保留

- SigTerm 拦截:在 supervised_proc.py 中,框架巧妙地利用 _mask_ctrl_c 上下文管理器,在进程启动的关键临界区(Critical Section)屏蔽信号,防止出现僵尸进程。

- Stack Trace Dump:在强制 Kill 之前,框架会尝试发送 DumpStackTraceRequest,要求子进程将当前的调用栈打印到日志中。这对于调试死锁或“卡住”的推理请求具有极高的工程价值。

5. 推理加速与共享架构

虽然默认模式是每个 Job 独占资源,但在 inference_runner.py 中,我们看到了 Shared Inference 的设计蓝图。

- 设计初衷:LLM/STT 模型显存占用极大,无法为每个用户启动一个进程。

- 实现方案:通过独立的

InferenceProcExecutor,多个 Job 进程可以通过 IPC 将推理请求转发给一个共享的、常驻显存的推理进程。 - 架构收益:这种分离计算与控制的模式,使得 Agents 框架不仅能做轻量级编排,也能承载高密度的本地模型部署。

总结:LiveKit Agents 不仅仅是一个简单的 SDK 包装,它是一个为长连接、多模态、高并发场景量身定制的工程化容器。它在 Python 的灵活性和生产环境的稳定性之间找到了极佳的平衡点。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

评论

登录后参与评论

推荐阅读

目录