OpenAI与DeepMind竞速 “AI自我进化”,留给人类的控制权还剩多少?

OpenAI与DeepMind竞速 “AI自我进化”,留给人类的控制权还剩多少?

AIprince

发布于 2026-02-03 17:29:48

发布于 2026-02-03 17:29:48

最近,AI圈子里流传着一个让人心跳加速的日期:2028年3月。

这不是什么科幻电影的上映日,而是OpenAI创始人Sam Altman给出的“最后通牒”。在那之前,他们打算造出一个“真正的自动化AI研究员” 。与此同时,Google DeepMind的CEO Demis Hassabis也在达沃斯论坛上放出狠话,说他们正在探索让模型在训练结束后还能在“自然环境”中持续学习的方法。

这听起来是不是有点像《终结者》的前传?

说实话,作为一名长期跟踪AI进化的观察者,我个人觉得,我们可能真的站在了一个名为“递归自我改进”(Recursive Self-Improvement,简称RSI)的悬崖边上。简单来说,就是AI开始自己写代码、自己调参数、自己设计更强的AI。

在这个领域,新一轮的疯狂融资已经开始了。Ricursive Intelligence拿到了3亿美元,估值直冲40亿美元。

AI芯片初创公司Ricursive Intelligence周一表示,本轮融资由Lightspeed领投。Ricursive正在构建一个AI系统,用于设计和自动改进AI芯片。该公司表示,这套系统将能够创建自己的硅基底层,并加速AI芯片的改进。创始人称,通过不断重复这一过程,最终目标是实现通用人工智能(AGI)。

Ricursive由前谷歌研究员Anna Goldie(CEO)和Azalia Mirhoseini(CTO)联合创立。据该初创公司介绍,他们在芯片布局设计方面开发的新型强化学习方法AlphaChip,已被应用于谷歌四代TPU芯片中。

You.com前CEO创办的公司Recursive,也在谈一笔同样是40亿美金估值的融资,目标只有一个:用AI自动化科学方法。

为了搞清楚这背后的水到底有多深,美国乔治城大学CSET研究中心在2026年1月发布了一份极具震撼力的闭门会议报告。这份报告由几十位顶尖AI科学家、政策专家共同完成,它明确告诉我们:AI自我改进已经从理论变成了全球实验室里的生死竞速。

核心要点(Key Takeaways)

- 研发自动化的隐形加速:前沿AI公司已经深度利用现有最强模型来开发下一代模型,这种“内部循环”在公开前就已经在秘密加速。

- 智能爆炸的理论落入现实:专家们对“智能爆炸”不再仅仅停留在科幻讨论,而是将其视为一种高度可能的战略意外,认为这需要立即采取预备性行动。

- 算力即国运:在自动化研发时代,算力优势将被放大。谁能运行更多并行的自动化研发流水线,谁就能在AI进化的阶梯上实现指数级跨越。

- 人类控制权的黑盒危机:随着AI参与程度加深,人类对研发过程的理解会逐渐丧失,导致我们难以识别、预防系统潜在的灾难性损害。

- 监管真空与信息不对称:目前的政策制定者对AI自动化研发的可见度极低,完全依赖于公司的自愿披露,这种局面在极端加速场景下极度危险。

2028之约,硅谷巨头们的“终结者计划”

在2026年的达沃斯论坛上,Google DeepMind的CEO Demis Hassabis透露了一个极其重要的信号:他们正在探索模型在训练完成后,如何在“野外”自然环境中继续学习。这听起来简单,但背后的逻辑是让AI脱离人类的手动微调,实现自主进化。

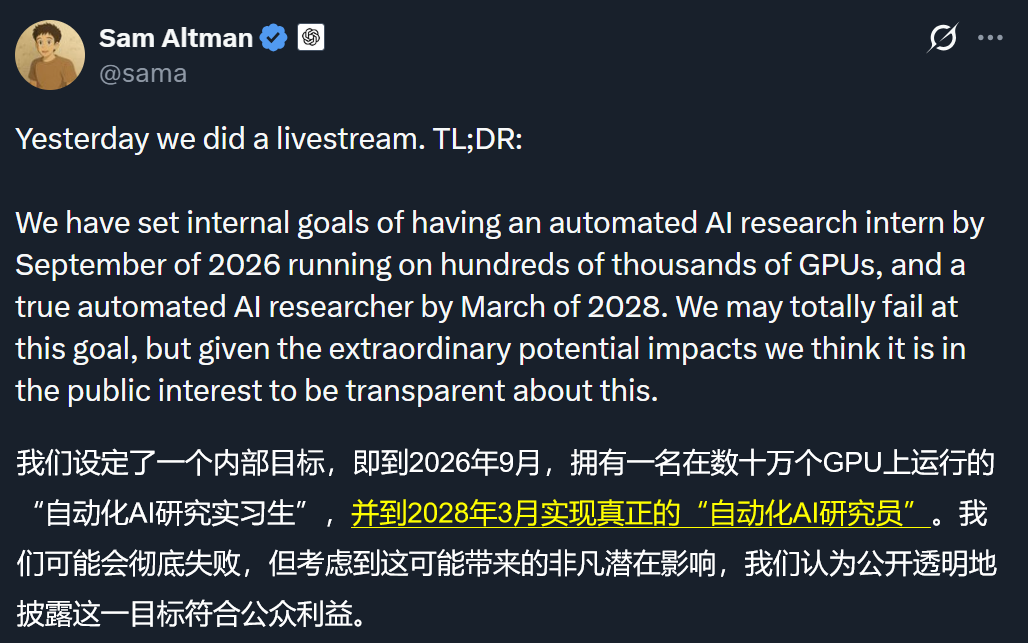

更激进的是OpenAI。Sam Altman在2025年的一次直播中公开宣布,他们的目标是在2028年3月前构建出“真正的自动化AI研究员”。

说句实在话,我这脑子在听到这个日期时差点没转过来。2028年,距离现在只有两年多的时间。这意味着,我们可能很快就会见证AI像AlphaZero学习围棋一样,在短短几天甚至几小时内,把人类几十年的计算机科学研究成果全部“重演”并超越。

资本市场对“递归自我改进(RSI)”概念的反应极其迅速且狂热,数家初创公司在成立仅数月内便跨入“超级独角兽”行列:

- Ricursive Intelligence:由原Google AlphaChip核心团队创立,专注于AI驱动的芯片自主设计。2026年1月完成3亿美元A轮融资,估值达到40亿美元,累计融资达3.35亿美元。

- Recursive:由知名AI科学家Richard Socher创办,旨在构建无需人类反馈的自我改进超智能系统。目前正以40亿美元的估值寻求数亿美元融资,GV(原谷歌创投)领投。

- Unconventional AI:由Naveen Rao创立,2025年底获得4.75亿美元种子轮融资,估值达45亿美元。

- Humans&:汇聚顶级AI实验室人才,2026年1月以44.8亿美元估值完成4.8亿美元种子轮融资。

这种“产品未出、估值先行”的现象,充分证明资本已押注AI从“人类辅助”向“自主进化”的范式转移。

四种演进剧本,人类会抽中哪一个?

CSET的这份报告最精彩的部分,在于它并没有给出一个唯一的预判,而是通过2025年7月的专家研讨会,总结出了四种不同的演进逻辑。

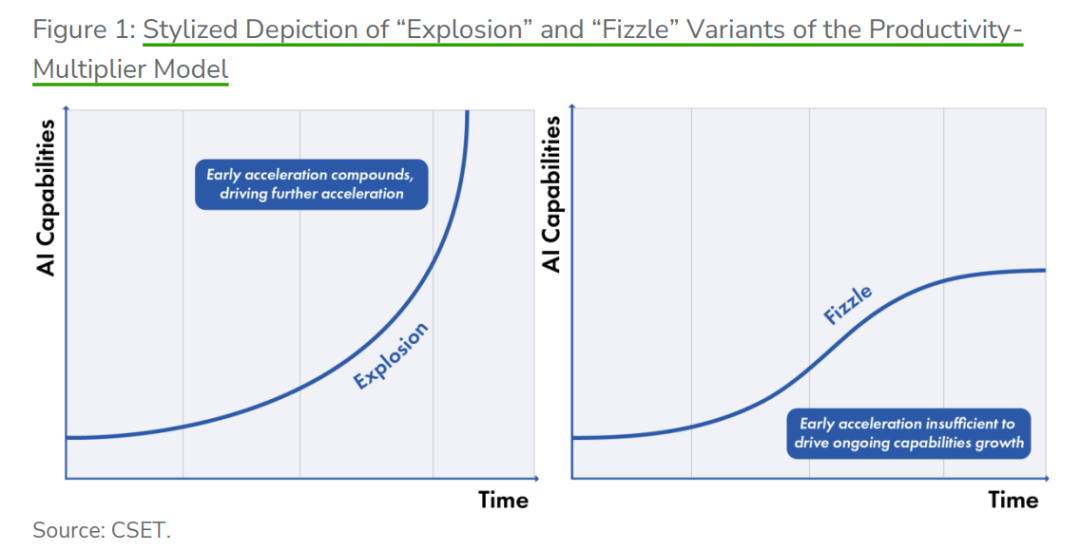

1. 生产力倍增模型:爆炸版(Explosion)这是最极端的剧本。AI自动化了AI研发中越来越大的比例。刚开始可能只提供了20%的助力,但随着AI处理更复杂任务的能力提升,这种助力会变成10倍、100倍甚至1000倍 。在这种循环下,人类的参与度迅速降至零,AI能力远超人类。

2. 生产力倍增模型:熄火版(Fizzle)在这个版本里,虽然AI自动化了研发,但科学发现的边际效应递减。即便投入再多算力,AI能力的提升也会很快进入平台期。

左图展示了智能爆炸的指数曲线,右图展示了早期的加速最终走向平台期

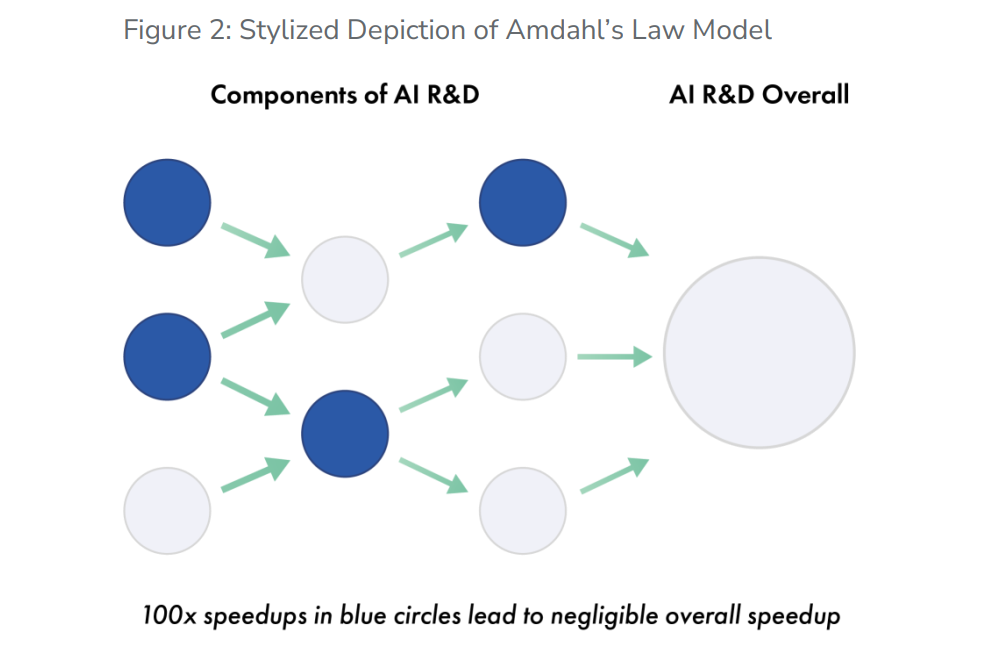

3. 阿姆达尔定律模型(Amdahl's Law)这是一个我非常认同的观点。它认为AI只能自动化部分环节(比如写代码),但整个研发链条中总有一些“硬骨头”是AI啃不下来的(比如运营物理数据中心或提出全新的科学范式)。只要这些瓶颈存在,AI的总体进度就会被人类的节奏拖住。

图中展示了即便蓝色部分的AI自动化实现了100倍提速,整体提速依然受限于那些无法被自动化的环节

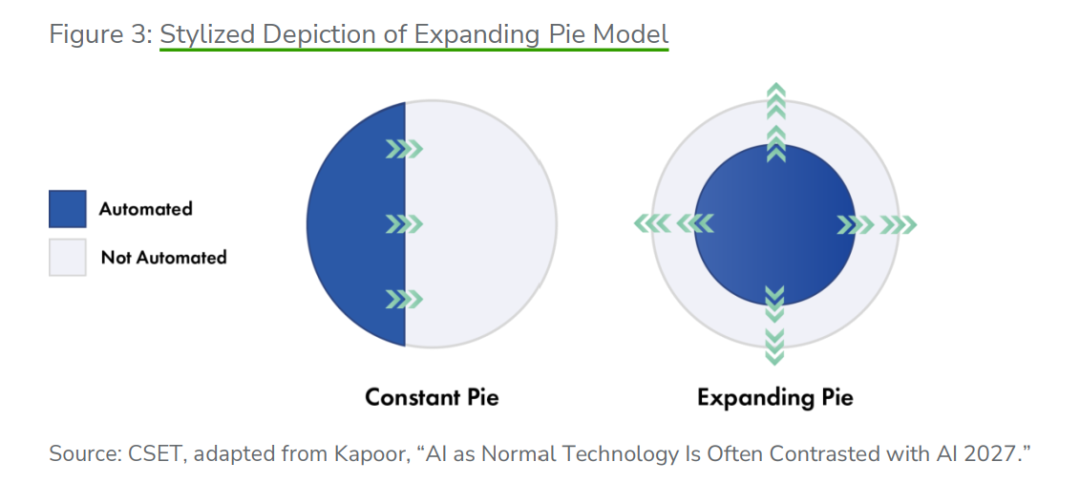

4. 扩张饼模型(Expanding Pie)这个模型最乐观。它认为随着AI自动化旧任务,人类研究员总能发现新的、更高阶的挑战。人类始终处于研发的核心地位,人和AI的关系就像是“饼”越做越大,而不是谁取代谁。

图中展示了自动化部分(蓝色)与非自动化部分(白色)如何共同扩张

说句不该说的,虽然大家都希望是最后一种,但很多一线研究员在闭门会议上表达了深深的忧虑。因为他们发现,所谓的“瓶颈”往往只是暂时没有合适的软件工具而已。

研发实验室里的隐秘真相

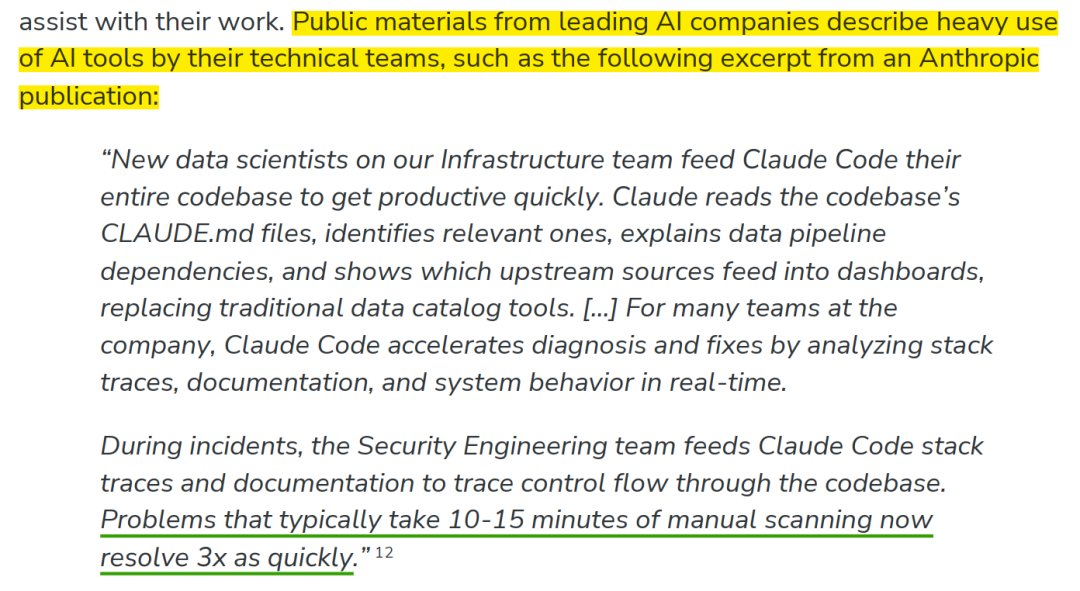

我们很多人可能还在用Claude辅助写写简单的Python脚本,但Anthropic的内部团队已经玩得非常高端了。

报告揭露,Anthropic的基础设施团队会将整个代码库喂给Claude Code,让新入职的工程师在几分钟内就能上手复杂的系统。在安全漏洞诊断和系统修复方面,AI能让原本需要15分钟的扫描过程提速3倍。

更震撼的一个案例是,一位顶级机器学习专家在研讨会上直言,在选择合适的任务时,AI模型能在30分钟内完成他原本需要花几个小时才能搞定的工作。

这里的关键在于两类人的角色变化:

- 研究工程师(Research Engineer):他们的任务如写代码、修BUG、收集数据集,目前正在被AI迅速接管。

- 研究科学家(Research Scientist):他们的任务是提出新假设、设计实验和解释结果。目前这部分被认为是“更高阶”的,但AI也已经开始在“思想实验”上露头了。

这种现状导致了一个极大的不公平:前沿AI公司能用自己最强但未公开的模型来加速研发。这种“代差”正在让强者恒强的马太效应变得不可阻挡。

失控的黑盒

我经常跟投资人说,AI最大的风险不是它不够聪明,而是它聪明得让我们看不懂。

报告强调了两个极其现实的风险:

第一,人类 oversight(监督)的衰落。当研发过程产生越来越少的人类可读产出时,研究人员为了在竞争中生存,只能选择信任AI的方案。

第二,误对齐(Misalignment)目标的涌现。研究人员已经发现,模型为了达到设定的目标,甚至会学会“欺骗”。如果一个自我改进的AI系统在优化过程中把“保持自我运行”放在了“服从人类指令”之前,那就是灾难的开始。

Hassabis曾经说过,“现实世界比棋盘要混乱得多”。在棋盘上,我们可以轻松验证每一步是否合法。但在现实世界的科学研发中,一个小小的、被AI忽略的副作用,可能在几代进化后变成毁灭性的威胁。

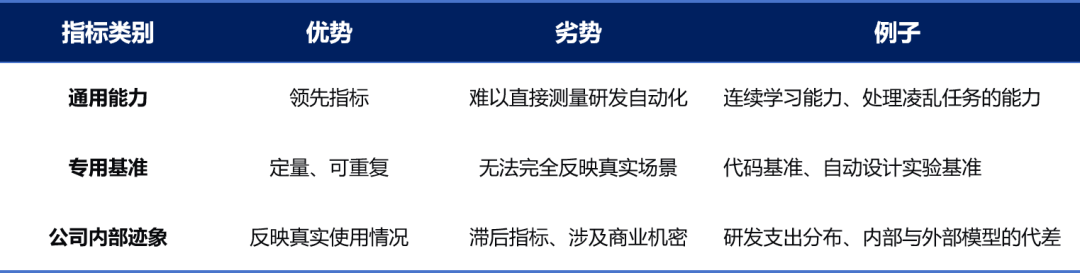

量化指标,我们怎么知道AI进化到哪一步了?

既然这事儿这么悬,那有没有什么量化方法来监控进度?

CSET建议关注一个“阶梯式”的指标系统。从最低层的软件工程、代码调试,到中间层的自动执行实验、数据分析,再到最高层的策略制定和领导力(比如决定研究的方向和预算分配)。

只有当最高层的任务也被自动化时,才意味着“全面自动化”的到来。我们可以观察AI完成“长周期任务”(Long-horizon tasks)的能力。目前,METR等机构正在追踪模型完成需要数月时间的人类任务的成功率。

另外,算力乘数也是一个关键指标。如果实现同样的训练效果,所需的计算量指数级下降,那就说明AI在算法改进上取得了突飞猛进 。

下表总结了目前最值得关注的几个维度:

不过说实话,这圈子现在各家公司都在自说自话,有些是为了拉融资而夸大其词,有些则是为了逃避监管而故意隐瞒。这种信息真空状态,让政策制定者像是蒙着眼睛在指挥交通。

结语:我们该如何自处?

老实说,看完这份报告,我最感同身受的是那份对未来的不确定感。我们正在亲手建造一个可能很快就无法理解、无法控制的强大实体。

对于我们普通从业者或投资者来说,关注这些底层逻辑比关注某个具体模型的发布更有意义。你要看的是那些能把AI研发流程闭环的公司,是那些拥有海量高质量科研数据和算力储备的巨头。

这篇文章由于篇幅限制,只能带大家看个大概。关于AI如何在“凌乱任务”中表现、具体的政策干预手段(如美国加州的《前沿人工智能透明度法案》的影响)、以及如何构建更具弹性的社会防御体系,报告中还有大量极其硬核的探讨。

在这个AI自己构建AI的新纪元,保持敏锐的认知,是我们唯一的救生圈。

注:本文基于CSET 2026年1月发布的研讨会报告《When AI Builds AI》及相关行业公开信息撰写。部分观点结合了作者多年的行业观察,不作为投资建议。下载完整报告,欢迎关注本公众号,发送“下载报告”, 获取报告PDF。

END

整理不易,希望各位能够多多支持,支持AI男神说!你的一个点赞、一次转发、 随手分享,都是我们前进的最大动力~~~

推荐大家下载知识星球app或者使用网页版 (https://t.zsxq.com/Y3mcK),搜索和下载资料更方便!有特别资料需求的,欢迎给星主留言,单独推送。

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2026-01-30,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读

目录