引入无代码LLM FineTuning与Monster API

引入无代码LLM FineTuning与Monster API

地址:https://blog.monsterapi.ai/no-code-fine-tuning-llm/

计算机视觉研究院专栏

Column of Computer Vision Institute

微调预训练模型是自然语言处理(NLP)领域的一项重要实践,可以优化它们在特定任务中的性能。在Monster API,我们了解开发人员在微调模型时面临的挑战,特别是当涉及复杂设置、内存限制、高GPU成本以及缺乏标准化实践时。

01

概要简介

微调预训练模型是自然语言处理(NLP)领域的一项重要实践,可以优化它们在特定任务中的性能。在Monster API,我们了解开发人员在微调模型时面临的挑战,特别是当涉及复杂设置、内存限制、高GPU成本以及缺乏标准化实践时。

这就是为什么我们很高兴推出无代码LLM微调产品,该产品旨在简化和加快微调过程,同时为您提供所需的所有功能和可能性。

02

背景介绍

什么是微调LLM?为什么它如此重要?

虽然像GPT-J、LLaMA、Falcon、StableLM和OPT这样经过预训练的模型具有广泛的语言知识,但微调使开发人员能够提高他们在特定任务中的性能。微调使模型更加准确、上下文感知,并与目标应用程序保持一致。

微调不是从头开始训练语言模型,这需要大量的数据和计算资源,而是利用预先训练的模型的现有知识,并将其调整为专门的任务。

03

详细介绍

与微调LLM相关的挑战:

微调LLaMA和其他大型语言模型带来了一些挑战。复杂的设置、内存要求、GPU成本以及缺乏标准化实践可能会阻碍微调过程,并使开发人员获得适合其需求的模型变得复杂。

然而,通过Monster API的LLM FineTuner,这些挑战得到了有效解决:

- 复杂设置:Monster API简化了为FineTuning机器学习模型设置GPU环境的复杂过程,将其封装在用户友好、直观的界面中。这种创新方法消除了手动硬件规范管理、软件依赖性安装、CUDA工具包设置和其他低级配置的需要。通过抽象这些复杂性,Monster API LLM Finetuner允许用户轻松选择所需的模型、数据集和超参数,并专注于优化机器学习模型的实际任务。

- 内存限制:微调大型语言模型(如LLaMA)可能需要大量的GPU内存,这对许多开发人员来说可能是一个限制。Monster API通过优化FineTuning过程中的内存利用率来解决这一挑战。它确保在可用的GPU内存内有效地执行该过程,从而使大型语言模型FineToning更易于访问和管理,即使存在资源限制。

- GPU成本:当微调机器学习模型时,GPU成本可能会迅速上升,这使其成为并非所有开发人员都能负担得起的奢侈品。然而,Monster API利用其分散的GPU网络实现了对超低成本GPU实例的按需访问。因此,显著降低了与访问LLM的强大计算资源相关联的成本和复杂性。

- 标准化实践:行业中缺乏标准化实践可能会使微调过程令人沮丧且耗时。Monster API通过提供直观的界面和预定义的任务,以及创建自定义任务的灵活性,简化了这一过程。我们的平台引导您了解最佳实践,无需在错综复杂的文档和论坛中导航。

可以依赖Monster API来简化和流线化复杂的微调过程,使其快速而容易地被处理。通过使用Monster API,您可以轻松地使用LoRA将大型语言模型(如LLaMA 7B)与DataBricks Dolly 15k进行3个阶段的微调。

你猜怎么着?它不会让你倾家荡产,只需花费不到20美元。

有关用于演示的LLM和数据集的上下文:

LLaMA(Large Language Model Meta AI)是Facebook AI Research(FAIR)为机器翻译任务开发的一个令人印象深刻的语言模型。LLaMA基于Transformer架构,在大量多语言数据的语料库上进行训练,使其能够在许多语言对之间进行翻译。LLaMA 7B具有70亿个参数,是该模型的最小变体。

为了展示像ChatGPT这样的交互式和引人入胜的对话能力,我们使用了Databricks Dolly V2数据集。该数据集,特别是“data bricks-doolly-15k”语料库,由Databricks员工创建的15000多条记录组成,提供了丰富多样的会话数据来源。

只需五个简单的步骤,您就可以设置微调任务并体验显著的效果。

所以,让我们一起开始探索这个过程吧!

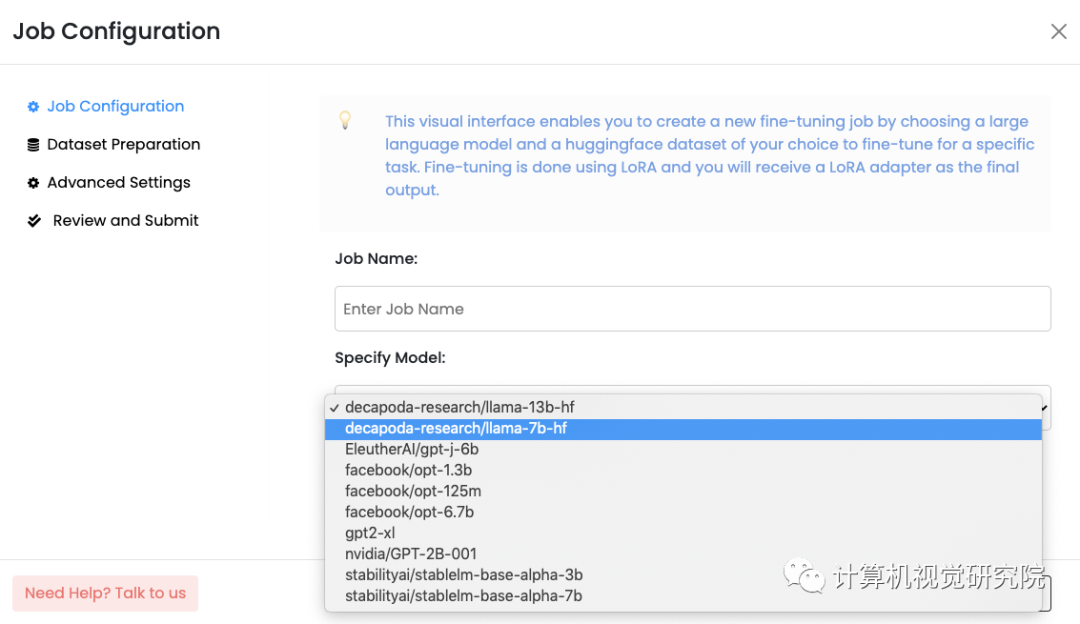

选择一个语言模型进行微调

- 选择适合您需求的LLM。您有多种流行的开源语言模型可供选择,例如Llama 7B、GPT-J 6B或StableLM 7B

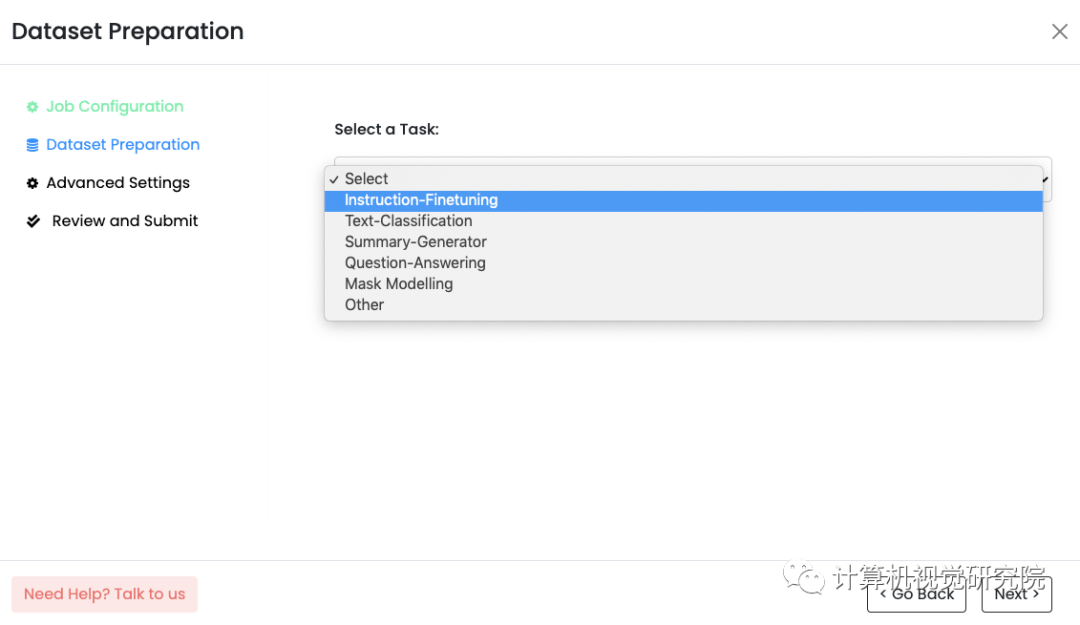

- 第二部选择或创建任务:接下来,定义用于微调LLM的任务。使用Monster API,您可以灵活地从预定义任务中选择,如“指令精细调整”或“文本分类”。如果您的任务是唯一的,您甚至可以选择“其他”选项来创建自定义任务。我们重视您的具体要求,并提供相应的选择

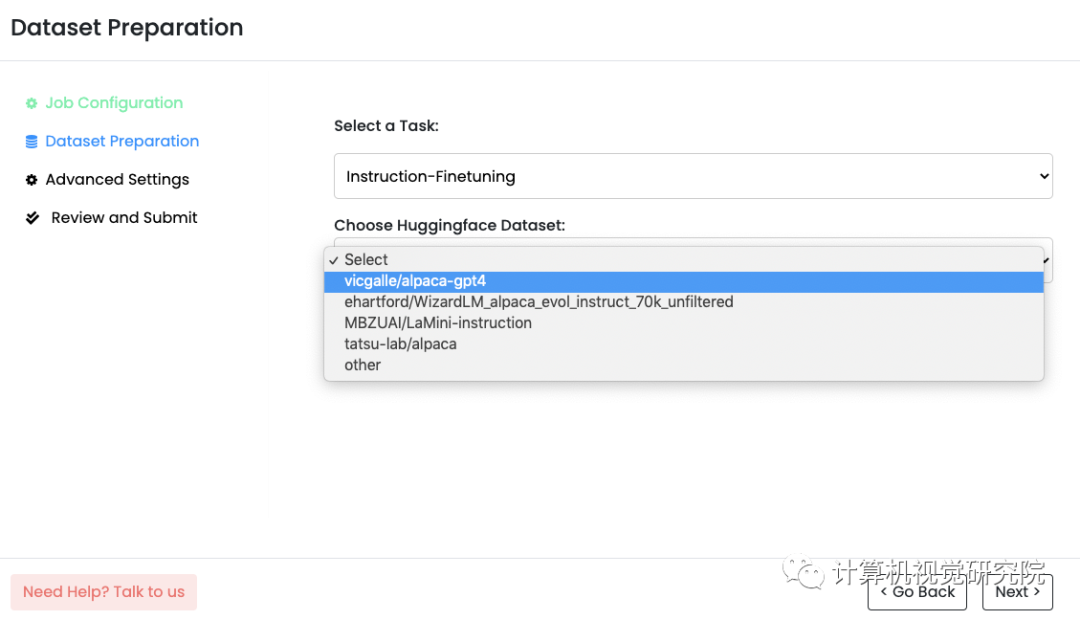

- 选择一个HuggingFace数据集:为了有效地训练你的LLM,你需要一个高质量的数据集。Monster API与HuggingFace数据集无缝集成,提供了广泛的选择。我们甚至根据您选择的任务建议相关的数据集。只需点击几下,您选择的数据集就会自动格式化并准备好使用。我们希望让您能够方便地访问所需的数据

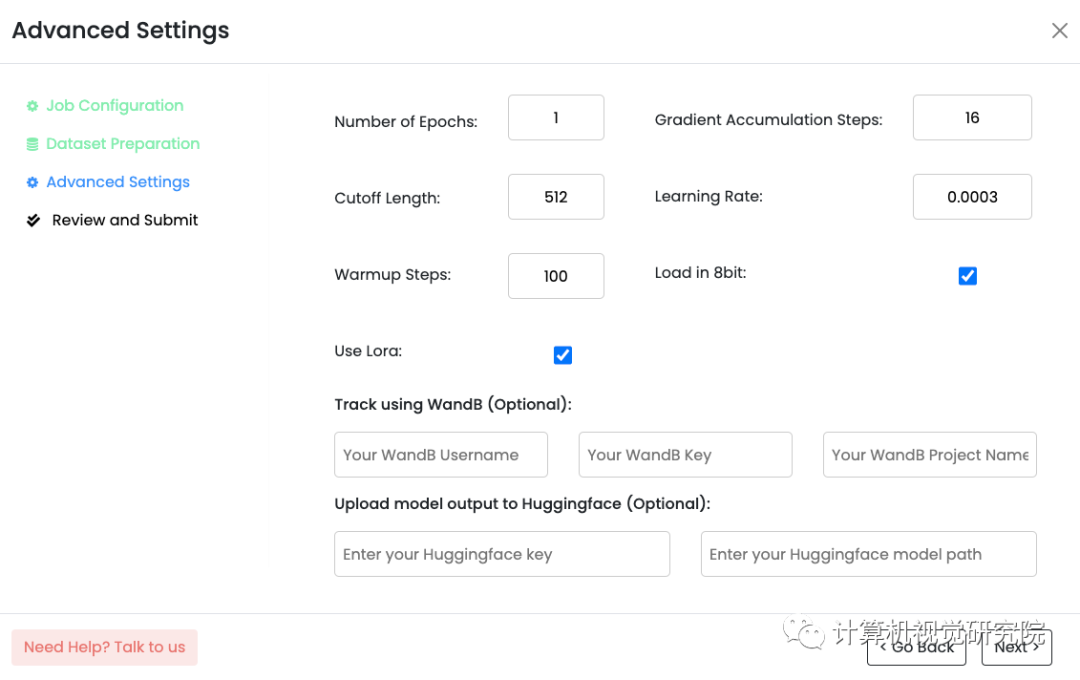

- 指定超参数:Monster API根据您选择的LLM预先填充大多数超参数,从而简化了过程。但是,我们知道您可能有特定的偏好。您可以自由定制时间、学习率、截止长度、热身步骤等参数,确保您的LLM能够根据您的确切要求进行微调

- 审查并提交微调工作:设置完所有参数后,您可以在摘要页面上查看所有内容。我们知道准确性的重要性,因此我们提供此步骤以确保您能够完全控制。一旦你对细节有信心,只需提交工作即可。从那里开始,我们负责剩下的事情

就是这样!只需五个简单的步骤,您的作业就可以提交给您选择的LLM进行微调。我们致力于简化流程,这样您就可以专注于您的任务,而不会被复杂的配置所淹没。

使用Monster API成功设置微调作业后,可以通过WandB上的详细日志监控性能。我们相信为您提供所需的见解,以便您做出明智的决策并取得最佳结果。

Monster API的优点

Monster API的FineTuning LLM产品的价值在于它能够简化大型语言模型(LLM)的使用并使其民主化。通过消除技术复杂性、内存限制、高GPU成本和缺乏统一实践等常见障碍,该平台使人工智能模型微调变得容易和高效。通过这样做,它使开发人员能够充分利用LLM,促进更复杂的人工智能应用程序的开发。

转载请联系本公众号获得授权

往期推荐

🔗

- 中国提出的分割天花板 | 精度相当,速度提升50倍!

- All Things ViTs:在视觉中理解和解释注意力

- 基于LangChain+GLM搭建知识本地库

- OVO:在线蒸馏一次视觉Transformer搜索

- 最近几篇较好论文实现代码(附源代码下载)

- AI大模型落地不远了!首个全量化Vision Transformer的方法FQ-ViT(附源代码)

- CVPR 2023|EfficientViT:让ViT更高效部署实现实时推理(附源码)

- VS Code支持配置远程同步了

- 基于文本驱动用于创建和编辑图像(附源代码)

- 基于分层自监督学习将视觉Transformer扩展到千兆像素图像

- 霸榜第一框架:工业检测,基于差异和共性的半监督方法用于图像表面缺陷检测