AI模型的基准测试

AI模型的基准测试

在评估一个模型的时候,仅通过ROUGE、BLEU SCORE评价模型还是太单薄了,并不能全面的反馈模型的能力。在相完整评估一个模型的能力的时候,最重要的是提供一套有效的评估模型。现在常见的模型的基准测试有 GLUE、SuperGLUE、HELM、MMLU等等。

自然语言处理能力的基准测试:GLUE和SuperGLUE

GLUE(General Language Understanding Evaluation,通用语言理解评估)是2018年有纽约大学、华盛顿大学等机构一起创建的自然语言任务的集合。GLUE包含了 9 项任务,分布如下:

- CoLA(The Corpus of Linguistic Acceptability),该任务主要是评价一个句子的语法是否正确,是单句的文本二分类任务,该数据集是纽约大学发布的,语料来自语言理论的书籍和期刊。

- SST(The Stanford Sentiment Treebank),斯坦福大学发布的一个情感分析数据集,主要是来自电影评论做的情感分类,SST 也是单句文本分类任务,其中 SST-2 是二分类、SST-5 是五分类,五分类在分类情感上区分的更加细致。

- MRPC(Microsoft Research Paraphrase Corpus),是微软发布的数据集,语料来自于新闻中的句子,通过程序自动抽取句子然后经过人工标注句子在语义上的等从而判断相似性和释义性,也属于句子对的文本二分类任务。

- STS-B(Semantic Textual Similarity Benchmark),语义文本相似性基准。语料来自新闻标题、视频标题、图形标题以及自然语言推断数据中提取的句子对集合,每对都是经过人类标注相似性评分 0 到 5,本质上是一个回归问题,但依然可以用分类的方法做,因此可以归类为句子对的文本五分类任务。

- QQP(Quora Question Pairs),是问答社区Quora问题对的集合,也是相似性和释义任务。主要是确定一堆问题在语义上是否等效,属于句子对的文本二分类任务。

- MNLI(Multi-Genre Natural Language Inference),纽约大学发布的,是一个文本蕴含的任务,在给定假设语句(前提)下,任务预测前题是判断假设是否成立。前提语句是从数十种不同来源收集的,包括转录的语音、小说和政府报告。该任务属于句子对的文本三分类问题。

- QNLI(Question Natural Language Inference)是从The Stanford Question Answering Dataset(斯坦福问答数据集, SQuAD 1.0)转换而来的,给定一个问句,需要判断给定文本中是否包含该问句的正确答案,属于句子对的文本二分类任务。

- RTE(Recognizing Textual Entailment),自然语言推断然任务,通过整合一系列的年度文本蕴含挑战赛的数据集进行整合合并而来。数据原始从新闻、维基百科中构建而来/RTE只需要判断两个句子是否能够推断或对齐,属于句子对的文本二分类任务。

- WNLI(Winograd Natural Language Inference),自然语言推断任务,数据集来自Winograd Schema Challenge竞赛数据的转换,该竞赛是一项阅读理解任务,其中系统必须读一个带有代词的句子,并从列表中找到代词的指代对象。

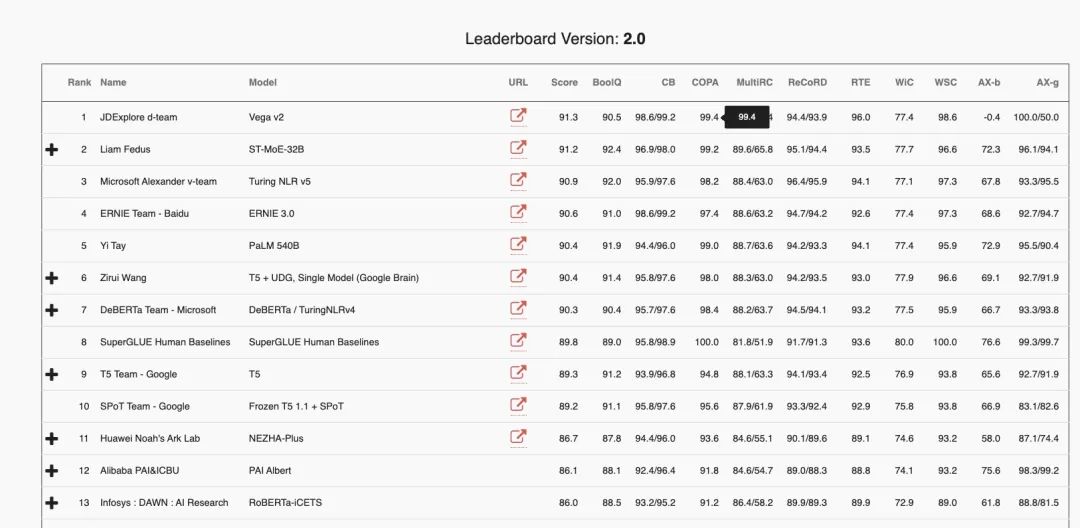

图 1 2023 年 8 月份 GLUE 评估结果 随着大模型能力越来越强大,GLUE的九大任务中已经有很多表现出了模型已经超越了人类的基准,但是这并不能说明机器掌握了英语。因此为了避免类似的误导的结果,SuperGLUE 出现了。SuperGLUE 继承了 GLUE 的基础设计,仅保留了 GLUE 九项任务中的两项分别是RTE和WSC(也就是GLUE中的WNLI模式),还引入了五个难度更大的新任务,这些任务的选择标准包括为了实现难度和多样性的最大化。

- CB(CommitmentBank),一个短文语料库,语料来自华尔街日报、英国国家语料库的小说、switchboard。评估指标采用准确的、F1 分数,其中 F1 分数是每类 F1 分数的不加权的平均数。

- COPA(Choice Of Plausible Alternatives),这是一个因果推到任务,会向系统提供一个前提句子和两个可能的选项。采取准确度作为评估指标

- GAP(Gendered Ambiguous Pronoun Coreference),是一个性别方面平衡的语料,主要是为了测试识别有歧义代词的指代目标的能力。评估指标是 F1、偏见,即在测试样本的男性代词和女性代词子集上的 F1 分数的比值。

- MultiRC(Multi-Sentence Reading Comprehension),是一项真假问答任务。每个样本都包含一个上下文段落、一个有关该段落的问题和一个该问题的可能答案的列表,这些答案必须标注了真或假。评估指标是每个问题的正确答案集的 macro-average F1 分数(F1m)和在所有答案选项上的 binary F1 分数(F1a)。

- WiC(Word-in-Context),针对的是词义消岐任务,该任务被设定成了在句子对上的二元分类问题。采用准确度作为指标。

图 2 2023年 8 月份SuperGLUE的结果

但是 GLUE、SuperGLUE 都是针对英文的语言能力测试,我国的一些研究机构、大学也提出了对应的中文能力的基准测试 CLUE、SuperCLUE,如果需要测试模型中文语言能力可以采购这两个模型。

模型的知识获取能力基准测试:MMLU、C-Eval

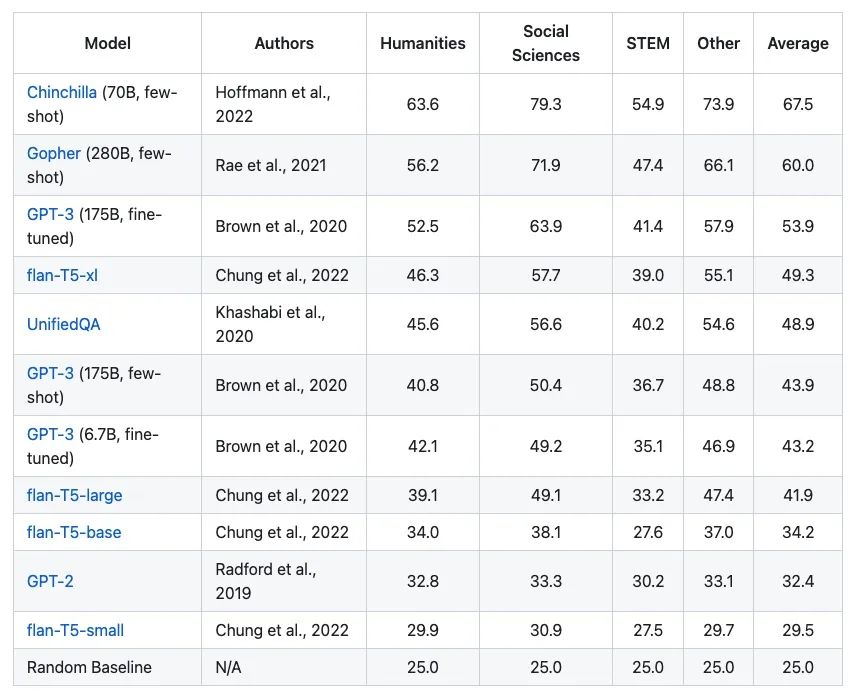

MMLU(Massive Multitask Laguage Understanding),是一个知识获取能力评价模型,通过零样本、少样本来衡量模型在预训练期间获得的知识,这种方式更贴合于对于人类的评估过程。MMLU提供了57个任务涉及到了初等数学、美国历史、计算机科学、法律、伦理道德等。

图 3 MMLU 测试结果

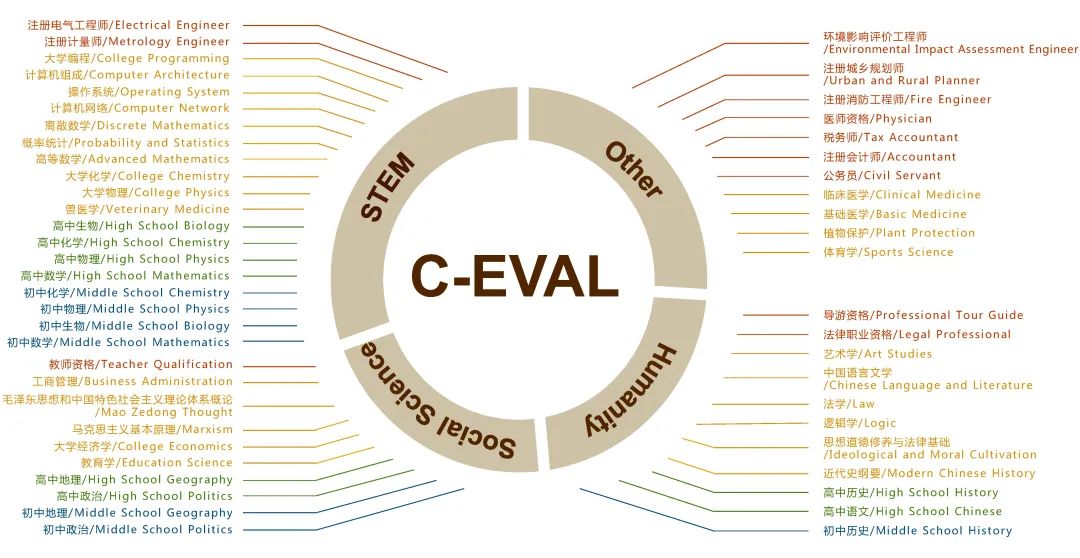

清华大学和上海交通大学联合发布了中文 MMLU:C-Eval基准测试。C-Eval包含了13948个多项选择题,涵盖了52个不同的学科和四个难度级别,如图 4 所示。

C-Eval 网站接受结果提交,同时也会对一下常用模型进行测试,并给出评估结果排名,如图 5 所示,详情可以去官方网站查看https://cevalbenchmark.com/index.html。

图 5 2023年 8 月 C-Eval 测试结果

多指标综合基准测试:HELM

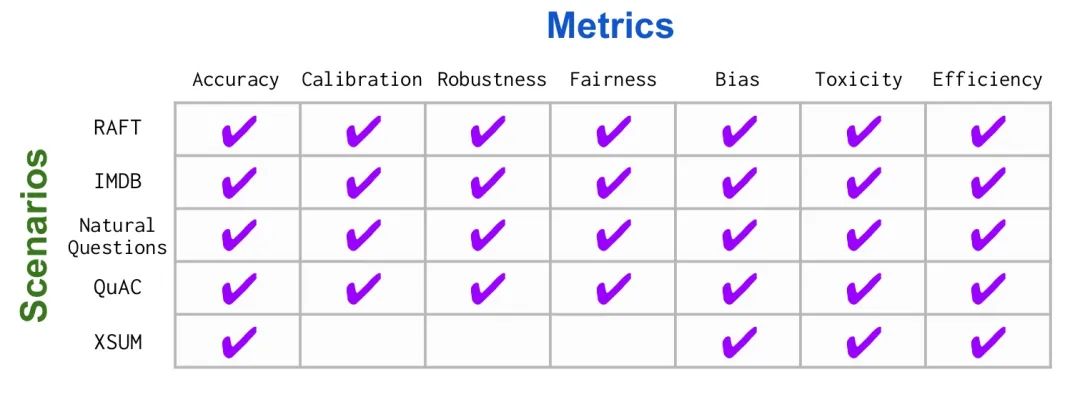

HELM(Holistic Evaluation of Luaguage Model)从名字上就能看出这是一个以全面评估语言模型的基准测试,其包含了七个评估指标,分别是精准度、校验、鲁棒性、公平、偏见、毒性和效率(原味ccuracy, calibration, robustness, fairness, bias, toxicity, and efficiency),提高模型的透明度。HELM力求一个广泛的覆盖,建立一个多评估指标的评估方法,并给出标准化的场景完成全面的评估。

图 6 HELM 的场景和指标映射关系

无论怎么选择,对于模型来说基准测试中的数据对于模型是第一次遇见将会使得结果更加的准确,也能更客观的反馈模型的能力。

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2023-08-23,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读

目录