PNAS | ChatGPT在文本标注任务中表现优于众包工作者

今天为大家介绍的是来自Fabrizio Gilardi的一篇讨论chatgpt能力的论文。许多自然语言处理(NLP)应用需要进行手动文本标注,用于训练分类器或评估无监督模型的性能,这是一个常见的任务。根据任务的规模和复杂程度,这些任务可能由众包工作者在MTurk等平台上进行,也可能由经过培训的标注员,比如研究助理,来完成。作者使用包含六千一百八十三个样本的四个推文和新闻文章数据集,展示了ChatGPT在多个标注任务中的表现优于众包工作者。在这四个数据集上,ChatGPT的零样本准确率平均超过众包工作者约25个百分点,同时ChatGPT的标注员间一致性在所有任务上均超过众包工作者和经过培训的标注员。此外,ChatGPT每个标注的成本不到0.003美元,比MTurk便宜约30倍。这些结果表明大型语言模型的潜力,能够大幅提高文本分类的效率。

文章探讨了大型语言模型(LLMs)在文本注释任务中的潜力,重点关注ChatGPT,该模型于2022年11月发布。研究表明,ChatGPT的零样本分类在成本的一小部分下优于MTurk的标注。LLMs已被证明在各种用途上表现非常出色,包括意识形态尺度、立法提案的分类、认知心理学任务的解决以及用于调查研究的人类样本的模拟。虽然一些研究表明ChatGPT可执行描述的文本注释任务,但作者的工作提供了系统性的评估。

实验部分

图 1

作者使用了四个数据集(n = 6,183),包括作者在以前的关于内容审查话语的研究中手动收集和注释的推文和新闻文章,以及2023年发布的新样本,以解决ChatGPT可能依赖于在模型的训练数据集中潜在包含的文本的记忆问题。作者依赖于经过训练的标注员(研究助理)来建立六个概念类别的标准:推文与内容审查问题的相关性(相关/不相关);推文与政治问题的相关性(相关/不相关);对美国互联网法规Section 230的立场(保留/废除/中立);主题识别(六个类别);第一组框架(内容审查作为问题、解决方案或中立);第二组框架(十四个类别)。然后作者使用ChatGPT和在MTurk上招募的众包工作者进行了完全相同的分类,使用了为研究助理开发的相同编码手册。对于ChatGPT,作者进行了四组注释。为了探索ChatGPT温度参数的影响,该参数控制输出的随机程度,作者使用默认值1和值0.2进行了注释,其中值0.2表示更少的随机性。对于每个温度值,作者进行了两组注释来计算ChatGPT的编码者一致性。对于MTurk,作者旨在选择高质量的众包工作者,尤其是筛选那些被亚马逊评为“MTurk大师”的工作者,他们的批准率超过90%,并且位于美国。

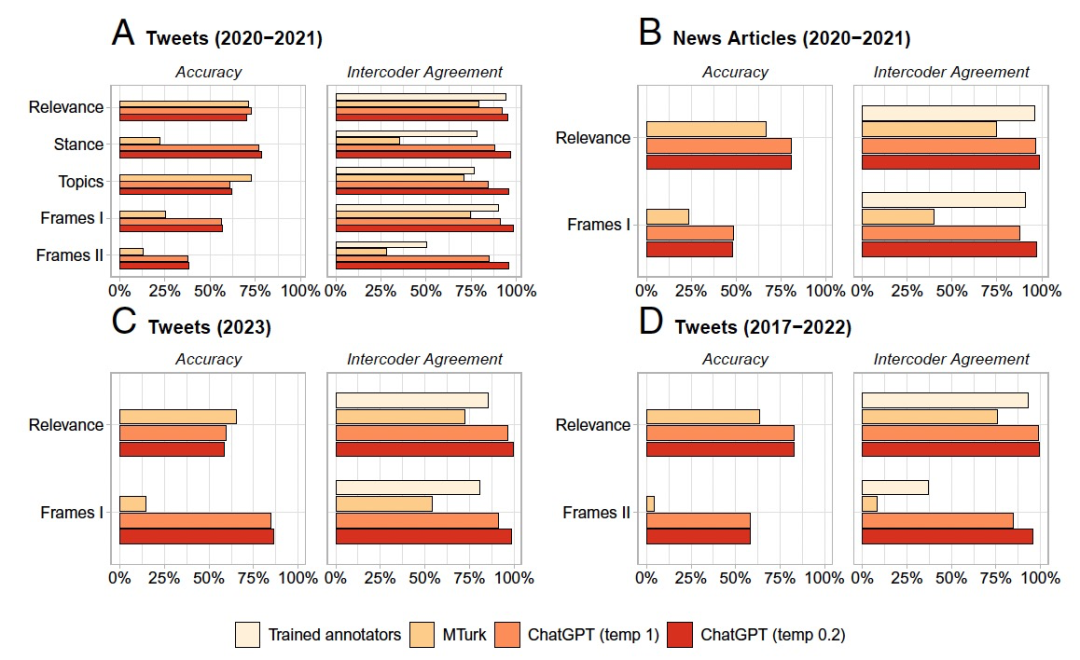

在这四个数据集中,作者报告了ChatGPT的zero-shot性能的两个不同指标:准确率和编码者一致性(图1)。准确率是以正确标注的百分比来衡量的,而编码者一致性是根据两个不同标注者对同一推文所分配相同标签的百分比来计算的。关于准确率,图1显示在这四个数据集中,ChatGPT在大多数任务上表现优于MTurk。平均而言,ChatGPT的准确率比MTurk高出约25个百分点。此外,考虑到任务的挑战性、类别数量和zero-shot注释,ChatGPT整体上表现出足够的准确率。针对只有两个类别(相关/不相关)的相关性任务,ChatGPT在内容审查推文中的准确率为70%,在内容审查新闻文章中为81%,在美国国会推文中为83%,在2023年内容审查推文中为59%。

关于编码者一致性,图1显示ChatGPT的性能非常高。平均而言,MTurk的编码者一致性约为56%,经过训练的标注员为79%,温度为1的ChatGPT为91%,温度为0.2的ChatGPT为97%。编码者一致性与准确性之间的相关性是正相关的。这表明对于注释任务,较低的温度值可能更可取,因为它似乎可以在增加一致性的同时保持准确性。作者强调,对ChatGPT进行的测试是困难的。作者的任务最初是在以前的研究的背景下进行的,并需要相当多的资源。作者为特定的研究目的开发了大多数概念类别。此外,一些任务涉及大量的类别,并表现出较低的编码者一致性水平,这表明注释难度较高。ChatGPT的准确性与经过训练的标注员的编码者一致性呈正相关,这表明在更容易的任务中表现更好。相反,ChatGPT相对于MTurk的优势与经过训练的标注员的编码者一致性呈负相关,这可能表示对于更复杂的任务表现更为优越。作者得出结论,考虑到其注释是zero-shot的,ChatGPT的性能令人印象深刻。

结论

本文展示了大型语言模型(LLMs)在改变许多研究项目常见的多种文本注释任务的潜力。证据在不同类型的文本和时间段上保持一致,表示ChatGPT可能已经是与MTurk等平台上的众包注释相比更优越的方法。至少,这些发现表明有必要更深入地研究LLMs的文本注释性能和能力。以下问题似乎特别有前景:i)在多种语言上的性能;ii)实现少样本学习;iii)构建半自动化数据标注系统,模型从人类标注中学习,然后推荐标注程序;iv)使用思维链提示和其他策略来提高零样本推理的性能;v)比较不同类型的LLMs。

参考资料

Gilardi, F., Alizadeh, M., & Kubli, M. (2023). Chatgpt outperforms crowd-workers for text-annotation tasks. arXiv preprint arXiv:2303.15056.