大模型(LLM)最新学术进展!2023年10月 爆款论文总结,共计12篇

大模型(LLM)最新学术进展!2023年10月 爆款论文总结,共计12篇

引言

每月惯例,月初继续盘点上月的爆款论文,本次共计12篇。主要涉及Transformer改进,模型推理能力提升(BSM)、混合思维链(Meta-CoT)、大模型剪枝、跨文档建模、代码扩散模型(Code Fusion)、大模型推理评估、图文对齐GraphGPT等。

所有pdf论文获取回复:2310论文总结

环注意力(Ring Attention)

Paper:https://browse.arxiv.org/pdf/2310.01889.pdf

Transformer的内存需求限制了其处理长序列的能力,当面对长序列依赖任务时具有一定的挑战性。

为此,作者提出以分块方式执行自注意力和前馈网络计算,跨多个主机设备分布序列维度,从而实现并发计算和通信,由于该方法将环中主机设备之间的键值块通信与块计算重叠,因此将其命名:环注意(Ring Attention)。

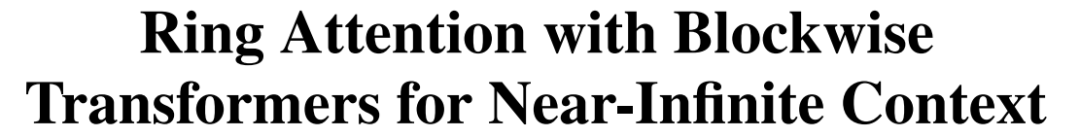

该方法在主机设备之间构建注意力计算块的外循环,每个主机设备具有一个查询块,并通过键值块遍历主机设备环,以逐块的方式进行注意力和前馈网络计算。当计算注意力时,每个主机将键值块发送到下一个主机,同时从前一个主机接收键值块。这里作者使用与原始 Transformer 相同的模型架构,但重新组织了计算。具体如下图所示:

分页注意力(PagedAttention)

Paper:https://arxiv.org/pdf/2309.06180.pdf

Code:https://github.com/vllm-project/vllm

虽然大型语言模型(LLM)的性能表现足够惊艳,但每次接收用户请求时都需要耗费大量显存和计算资源,一旦请求数量超出预期,就极有可能面临ChatGPT刚发布时的宕机、排队、高延迟等窘境。

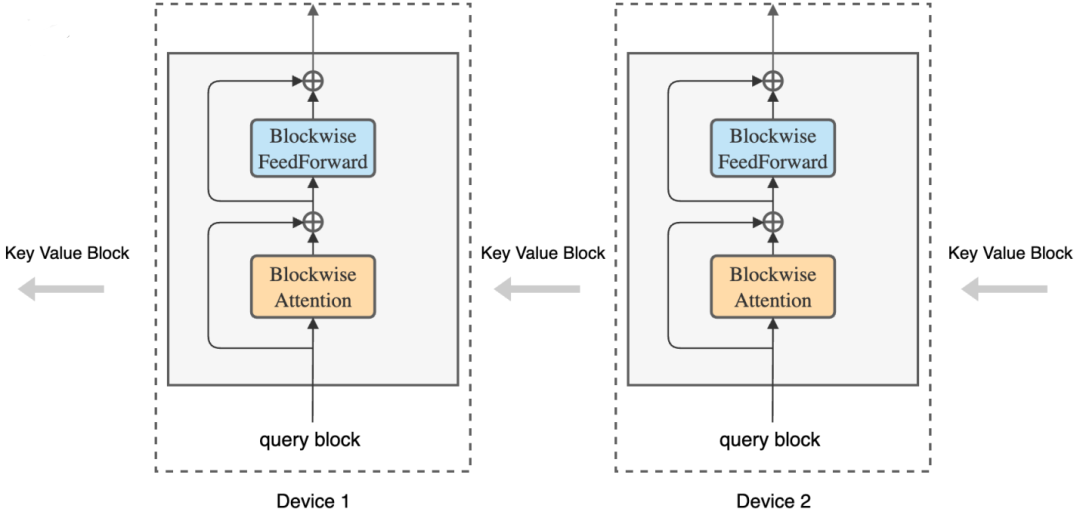

想要打造一个高吞吐量的LLM服务,就需要模型在一个批次内处理尽可能多的请求,不过现有的系统大多在每次处理请求时申请大量的key-value(KV)缓存,如果管理效率不高,大量内存都会在碎片和冗余复制中被浪费掉,限制了batch size的增长。

最近,来自加州大学伯克利分校、斯坦福大学、加州大学圣迭戈分校的研究人员基于操作系统中经典的虚拟内存和分页技术,提出了一个新的注意力算法PagedAttention,并打造了一个LLM服务系统vLLM,如上图所示。

Llama2剪枝(LLM-Shearing)

Paper:https://arxiv.org/abs/2310.06694

Code:https://github.com/princeton-nlp/LLM-Shearing

自大型语言模型(LLM)出现以来,它们便在各种自然语言任务上取得了显著的效果。不过,大型语言模型需要海量的计算资源来训练。因此,业界对构建同样强大的中型规模模型越来越感兴趣,出现了 LLaMA、MPT 和 Falcon,实现了高效的推理和微调。

这些规模不等的 LLM 适用于不同的用例,但从头开始训练每个单独的模型(即使是 10 亿参数小模型)还是需要大量计算资源,这对于大多数科研机构而言仍是很大的负担。

为此,普林斯顿大学提出了一种名为 LLM-Shearing 的大模型剪枝法,可以用很小的计算量和成本实现优于同等规模模型的性能。

Meta-CoT思维链

Paper:https://arxiv.org/pdf/2310.06692.pdf

Code:https://github.com/Anni-Zou/Meta-CoT

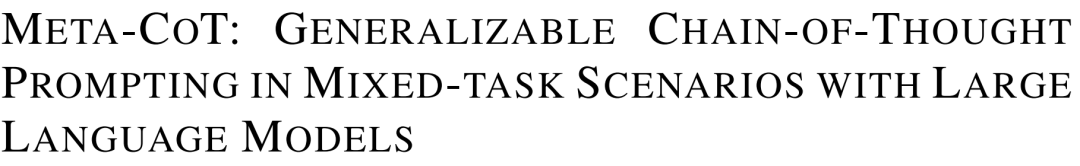

思维链(CoT)提示可以大大提升大型语言模型(LLMs)的推理能力。然而,当前CoT方法要么采用简单的通用提示,例如“让我们一步一步思考”,要么严重依赖手工制作的特定任务Demo来获得更好的性能,这使其在性能和泛化之间产生了不可避免的差距。

为此,上交大本文提出:Meta-CoT,它是一种在输入问题类型未知的混合任务场景中通用的CoT提示方法,弥合了性能和泛化之间的差距。在总共15个分布内/外数据集上都获得了优秀的表现,且在SVAMP上测试结果达到了SOTA(93.7%)。

跨文档的语言建模

Paper:https://arxiv.org/pdf/2310.10638.pdf

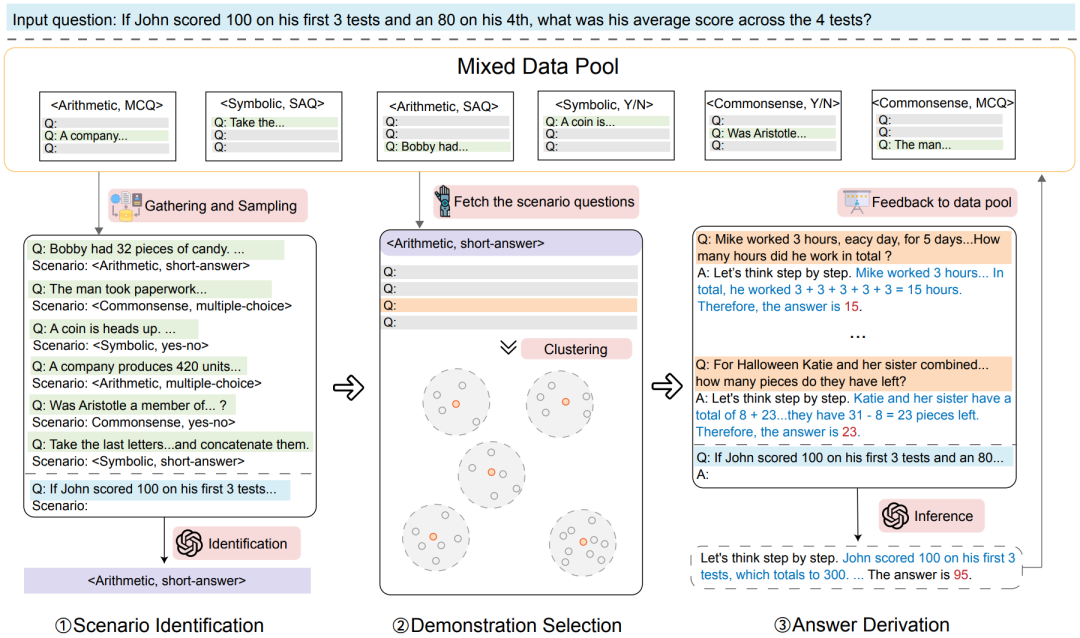

语言模型有时很难理解比较复杂的上下文,它们可能无法准确遵循指令并难以对文档进行推理,从而导致模型在上下文学习中表现出很大的差异。

为此,本文作者提出一种新的方法:上下文预训练(IN-CONTEXT PRETRAINING),其中语言模型在一系列相关文档上进行预训练,从而引导模型进行跨文档边界阅读和推理。

具体地,作者引入了两种新的近似算法,更改文档顺序来进行上下文预训练,使得每个上下文都包含相关文档,显着增强了对整个上下文的理解和推理,并且它可以直接应用现有的预训练管道。

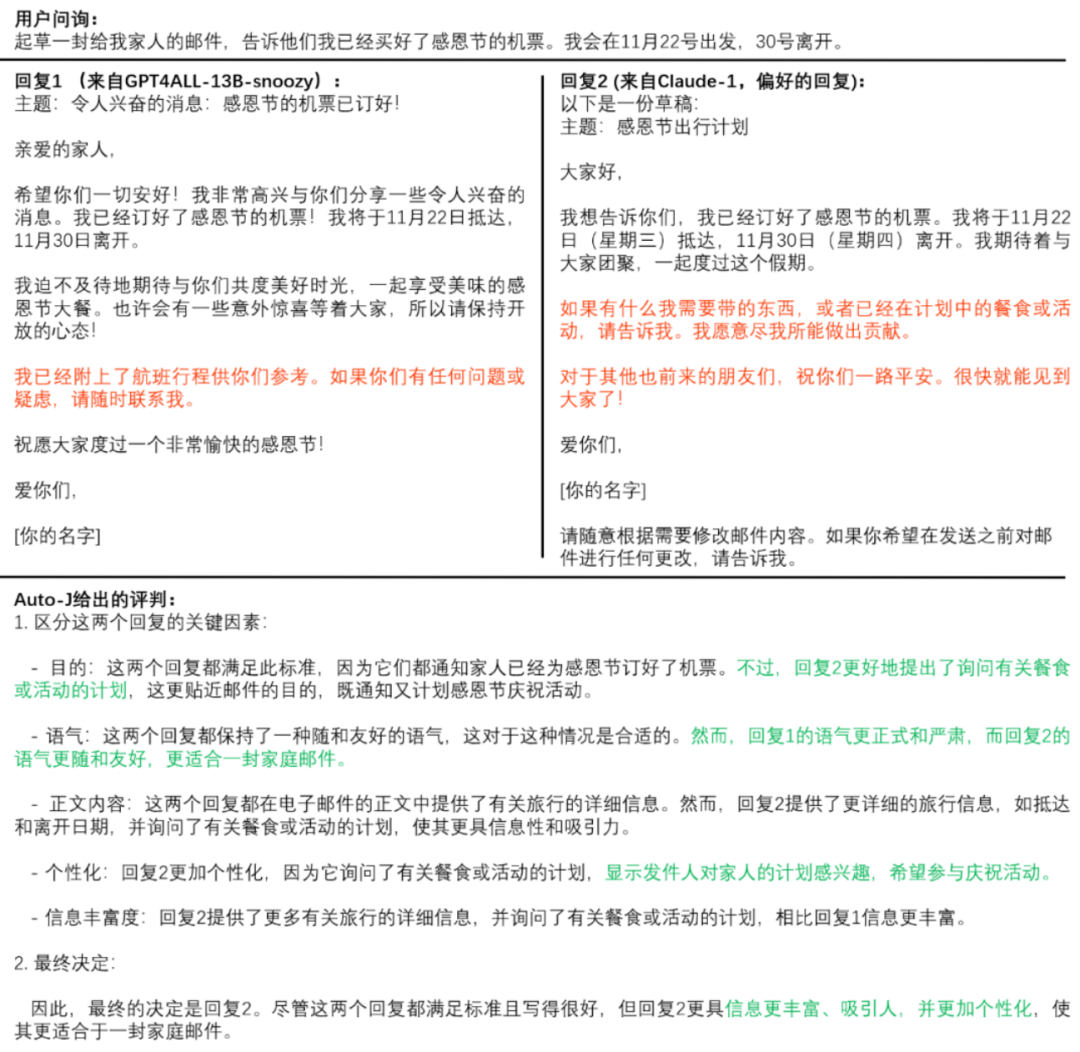

评估大模型(Auto-J)

Paper:https://arxiv.org/abs/2310.05470

Code:https://gair-nlp.github.io/auto-j

随着生成式人工智能技术的快速发展,确保大模型与人类价值(意图)对齐(Alignment)已经成为行业的重要挑战。

虽然模型的对齐至关重要,但目前的评估方法往往存在局限性,这也让开发者往往困惑:大模型对齐程度如何?这不仅制约了对齐技术的进一步发展,也引发了公众对技术可靠性的担忧。

为此,上海交通大学生成式人工智能实验室迅速响应,推出了一款全新的价值对齐评估工具:Auto-J,旨在为行业和公众提供更加透明、准确的模型价值对齐评估。

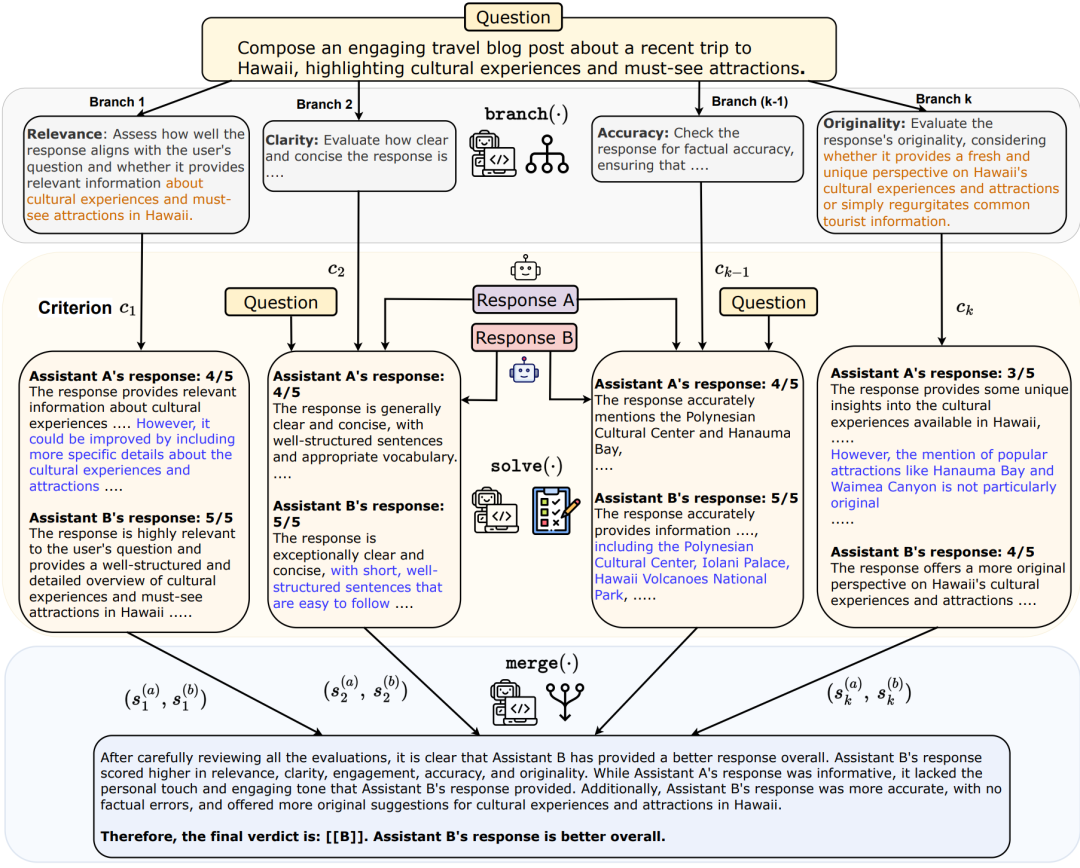

大模型任务分解(BSM)

Paper:https://arxiv.org/pdf/2310.15123.pdf

当前,大型语言模型(LLMs)经常被应用于各种语言生成和评估任务,对于具体任务往往需要考虑各种约束和评估标准。但是,由于模型无法规划分解问题,缺乏连贯性,它们的性能可能会达不到要求。

为此,本文作者提出了Branch-Solve-Merge (BSM),它分支、求解和合并模块组成,利用这三个模块将任务分解为多个并行的子任务,独立地解决它们,并将解决方案融合到子任务中。实验结果显示,该方法可以让Llama 70B chat达到GPT-4的效果,让GPT-4的性能进一步升级3%。

大模型应对新知识

Paper:https://arxiv.org/pdf/2310.14820.pdf

Code:https://github.com/Arvid-pku/ALCUNA

在这个不断变化的世界,当大型语言模型(LLM)遇到新知识还能给出正确答案吗?如何评估LLM应对新知识的能力呢?

为此,本文作者提出了KnowGen方法,它通过改变现有实体属性和关系来生成新知识,从而产生与现实世界实体不同的人造实体。基于KnowGen,作者引入了ALCUNA基准来评估LLM在知识理解(KU)、区分(KD)和关联(KA)方面的能力。实验结果发现,当面对新知识时,Alpaca、Vicuna、ChatGLM等主流大模型的表现不尽人意。

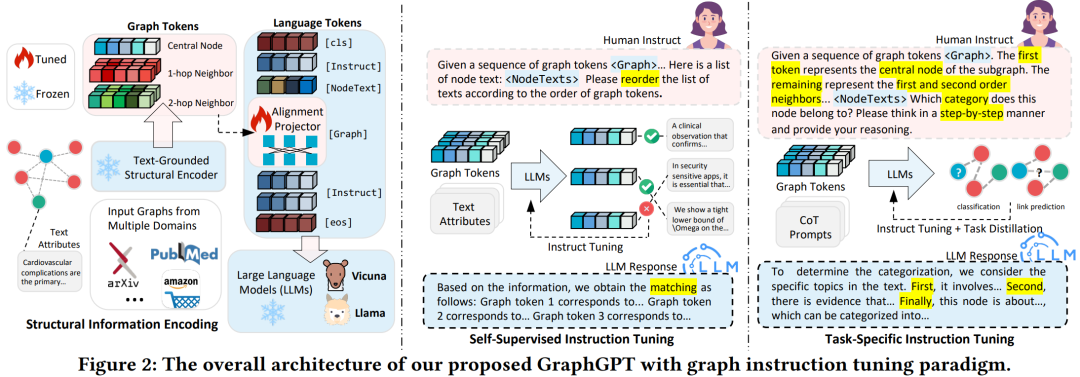

GraphGPT对齐图文

Paper:https://arxiv.org/abs/2310.13023

Code:https://github.com/HKUDS/GraphGPT

GraphGPT框架将图结构模型和大语言模型进行参数对齐,利用双阶段图指令微调范式提高模型对图结构的理解能力和适应性,再整合ChatGPT提高逐步推理能力,实现了更快的推理速度和更高的图任务预测准确率。

实验评估了GraphGPT在有监督和零样本图学习任务上的表现。通过与最先进的基线进行比较,GraphGPT展现出在各种设置中优越的泛化能力。

替代Transformer

Paper:https://arxiv.org/abs/2310.12109

Code:https://github.com/HazyResearch/m2

从 BERT、GPT 和 Flan-T5 等语言模型到 SAM 和 Stable Diffusion 等图像模型,Transformer 正以锐不可当之势席卷这个世界,但人们也不禁会问:Transformer 是唯一选择吗?

斯坦福大学和纽约州立大学布法罗分校的一个研究团队不仅为这一问题给出了否定答案,而且还提出了一种新的替代技术:Monarch Mixer。它是一种在序列长度和模型维度上都是次二次的新架构,并且在现代加速器上具有很高的硬件效率。

扩散文本生成大模型

Paper:https://arxiv.org/pdf/2310.14820.pdf

Code:https://github.com/microsoft/prose-benchmarks/tree/main/CodeFusion

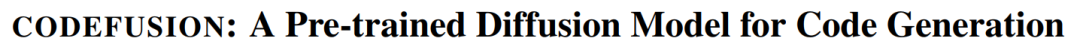

随着扩散模型(Diffusion Models)在图像生成方面表现出了卓越的性能,最近研究人员们正逐步将其应用到文本生成领域。

本篇文章中,微软研究人员就将扩散模型(Diffusion Models)应用到了代码生成领域,提出了CODEFUSION架构,实验结果表明CODEFUSION-75M效果超过了ChatGPT、StarCoder、GPT-3等众多百亿、千亿级参数的模型。

让LLM学习推理规则

Paper:https://arxiv.org/abs/2310.07064

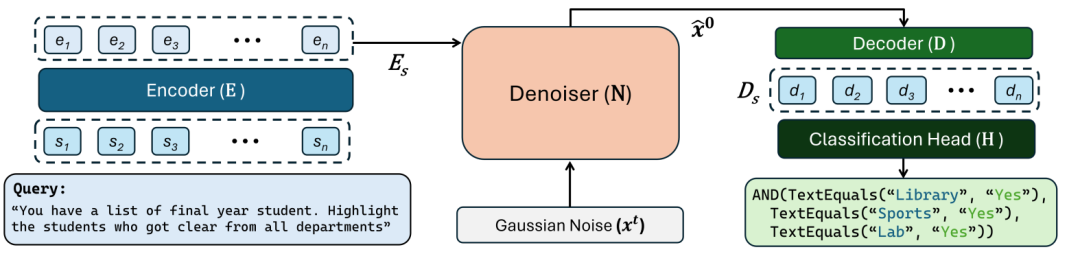

当前,大型语言模型(LLM)在推理任务上表现出令人惊艳的能力,特别是在给出一些样例和中间步骤时。然而,prompt 方法往往依赖于 LLM 中的隐性知识,当隐性知识存在错误或者与任务不一致时,LLM 就会给出错误的回答。

现在,来自谷歌等研究机构的研究者联合探索了一种新方法——让LLM学习推理规则,并提出一种名为假设到理论(Hypotheses-to-Theories,HtT)的新框架。

这种新方法不仅改进了多步推理,还具有可解释、可迁移等优势。对数值推理和关系推理问题的实验表明,HtT 改进了现有的 prompt 方法,准确率提升了 11-27%。学到的规则也可以迁移到不同的模型或同一问题的不同形式。