大模型能成为你的私人医生么?中文医疗大模型评估基准CMB现已加入OpenCompass

大模型能成为你的私人医生么?中文医疗大模型评估基准CMB现已加入OpenCompass

OpenMMLab 官方账号

发布于 2023-11-03 15:29:09

发布于 2023-11-03 15:29:09

近期,中国的医疗大模型研发正蓬勃进行,涌现了诸多具有影响力的工作,例如 BenTsao[7]、MedicalGPT[4]、Med-ChatGLM[5]、HuatuoGPT[1] 等。然而,由于缺乏标准化的基准,我们难以对这些模型的提升进行量化。为此,基于临床医学领域的行业特性,香港中文大学(深圳)的研究人员构造了中文医疗大模型评估基准 CMB,该基准通过选择题和复杂病历问诊任务对各模型的医学知识与诊断能力进行了全面评估。CMB 旨在为中文医学大模型的开发者们提供详细且精准的反馈,以加速模型的迭代过程,并推动中文医学领域语言模型的进一步发展与应用。

目前该评测基准已加入 OpenCompass 平台,用户可直接在 OpenCompass 完成大模型在医疗能力上的全面评测。

https://github.com/open-compass/opencompass

(欢迎使用,文末点击阅读原文可直达)

研究背景

医疗技术的进步极大地延长了人类的寿命。医学依赖于知识和经验,而语言模型依赖于数据,这种一致性给予了医学大模型帮助缓解医疗资源短缺的可能性。

虽然医学 LLM 应用前景广阔,但是模型的评估仍存在许多挑战,在医院中部署 LLM 会带来重大的伦理问题,使得从实际场景中获取反馈较为困难。现有的模型评价通常使用自动评估(GPT-4),考虑到医疗的准确性和专业性要求,这种没有参考答案的评估欠缺说服力。而专业的人工评判往往需要高昂的人力成本,且不易扩大规模。

BioLAMA 拥有参考答案,但它是为了评估掩码语言模型而不是自回归模型。MultiMedBench 包括问题解答、报告总结、视觉问题回答、报告生成和医疗图像分类,但 MultiMedBench 只有英文版本,直接翻译一方面需要对中英文医学和文化有深入了解,另一方面难以覆盖中医医学知识。

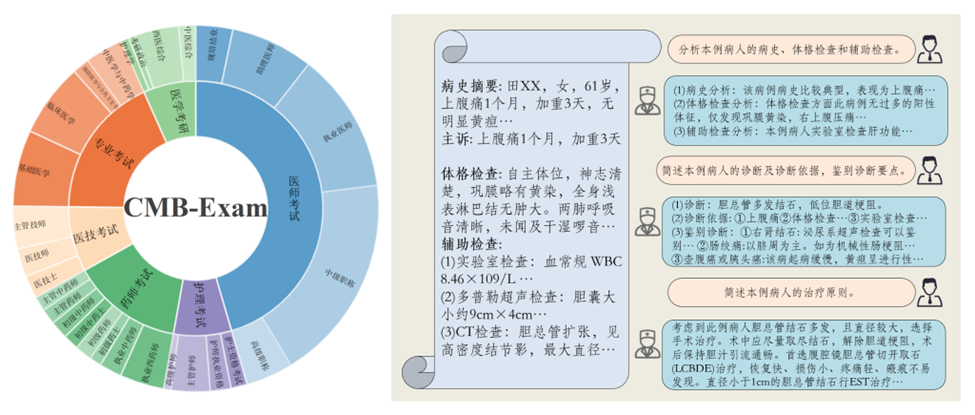

为此,CMB 提出了中文医疗模型评估基准,其中包括了适用于不同临床职业、不同职业阶段的多项选择题(CMB-Exam)和基于真实病例的复杂临床诊断问题(CMB-Clin)。

通过其进行的测评实验发现:

- GPT-4 在医学领域的表现显著优于其他模型,同时中文通用大模型也表现出色;

- 尽管如此,专门的医疗大模型在性能上仍落后于通用模型,表明其有很大的发展空间;

- CMB 还发现,具有参考答案和评分标准的问诊自动评估与专家评估高度一致,这为医学领域提供了超级对齐的初步实践。

数据集:基础知识和临床问诊能力并重

为了分别评测模型在医疗知识掌握程度和临床问诊能力方面的表现,CMB 构建了两个不同的数据集,分别是 CMB-Exam 和 CMB-Clin 集。

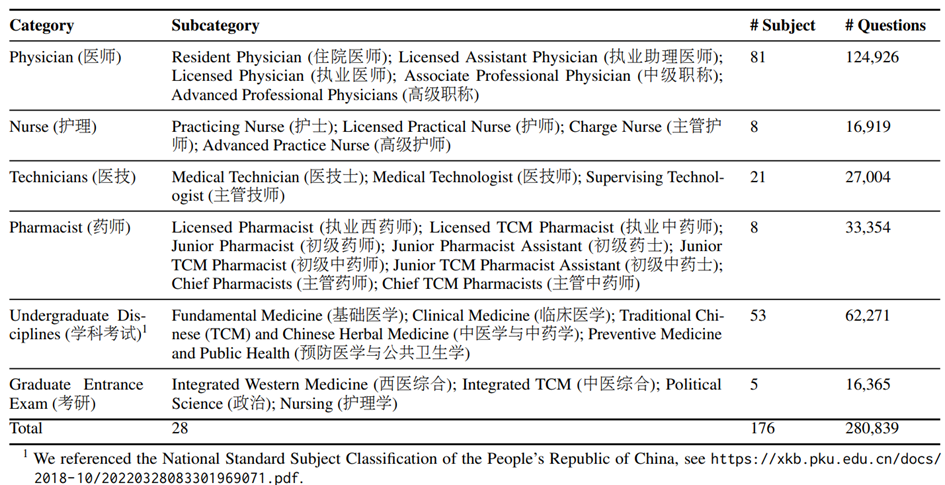

CMB-Exam 的构建理念是反映真实医疗领域的考核体系,覆盖了医生、药剂师、医技科室、护士岗位,对于一致的大学学科知识考试和研究生入学考试进行了合并,归纳出了六个类别。类别中依据职业阶段进行子目录的划定,子目录中又针对不同科室提供了细粒度更小的标签。

其数据的来源主要为历年真题、模拟题、课程练习题和章节测试题。其中一部分来自于医学题库网(https://www.medtiku.com/),获得了维护者的支持。为了确保数据质量,CMB 采用了一套规范的数据预处理流程,包括数据去重、清洗,针对原数据无法确认问题质量的地方,CMB 还进行了人工校验,纠正文法错误。同时,利用中国医疗试题库提供的评论系统,实行了严格的选题和删题过程,保证了问题中蕴含知识的准确度。

CMB-Clin 基于 74 个复杂真实案例,考察模型在真实诊断和治疗情境中的知识应用水平,评测其是否可以利用知识真正帮助解决临床复杂问题。其中,每个案例包含病历详情和 1~3 个问题,共 208 个问题。模型需要理解病人信息,包括主诉、病史概要、体格检查。根据这些信息来解答与诊断和治疗相关的问题,有些问题可能彼此关联。模型也需要能提供问题的解决方案。在与考官进行的对话模拟中,模型需要展现出其诊断和治疗能力。

实验:医疗大模型和通用大模型分别能力几何?

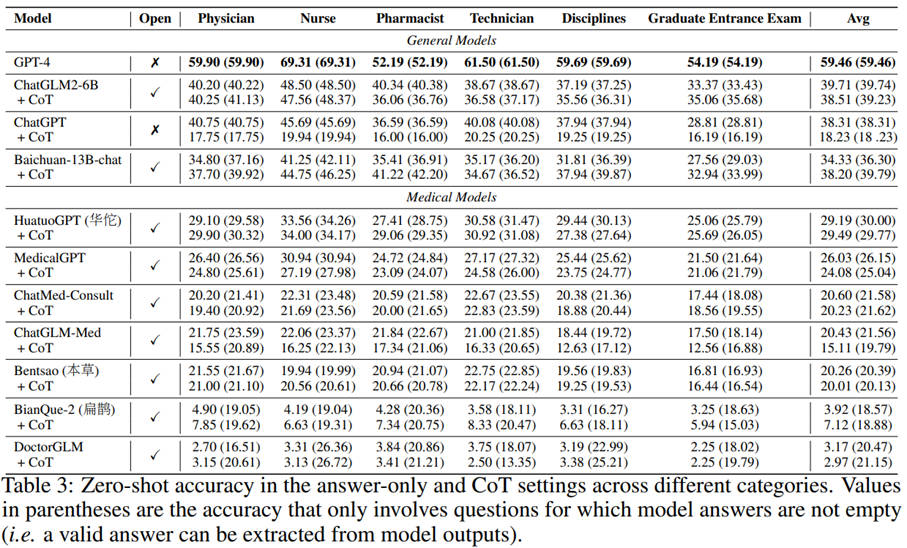

CMB 选用了 7 个中文开源医疗模型(HuatuoGPT[1],BianQue-2[2],ChatMed-Consult[3],MedicalGPT[4] , ChatGLM-Med[5],Bentsao[7],DoctorGLM[6]),2 个中文通用模型(ChatGLM-2[8],Baichuan-13B-Chat[9])以及 ChatGPT 和 GPT-4,在对齐超参的条件下,在 CMB-Exam 和 CMB-Clin 上对比表现。

CMB-Exam 实验

CMB 对比了 Zero-shot 条件下各模型的表现,在通用语言模型中,GPT-4 在医学领域的表现远超过其他模型,但仍然有很多问题回答错误。中文通用模型 ChatGLM2-6B 和 Baichuan-13B-chat 紧随 GPT-4 之后。值得一提的是,参数量仅为 6B 的 ChatGLM2 模型甚至超过了 ChatGPT,显示了国产大模型的在医疗领域的卓越能力。

在医疗领域的模型中,中文医疗模型的发展似乎落后于通用大型模型。其中,BianQue-2[2] 和 DoctorGLM 由于输入长度的限制和指令跟随能力的不足,使得无法在模型回答中抽取到答案,因而分数较低。

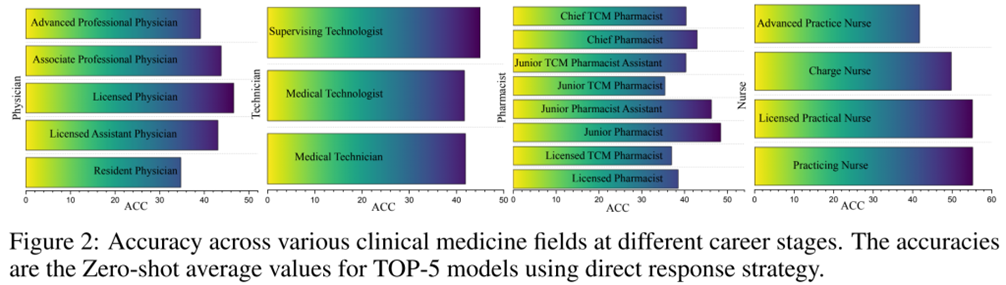

在不同临床职业的评分中,LLM 在各个临床专业领域表现不一,如药剂师相关问题得分较低,而护士相关得分较高。这可能是因为护士需要的基础知识相对直接,而药剂师需要处理的药名和药效差别较大。尽管在专业领域中的表现存在差异,但模型表现出一致的趋势,不特别偏向特定职业。

另外,研究还检验了 AI 模型和人类对考试难度感知上的一致性(Figure 2)。结果显示,医师和护士模型的准确率随着职业等级的提升而降低,但医学技术人员则呈现出相反的趋势,其主管技师考试的准确率最高。这可能是因为此类考试更侧重于人员管理和交流,而这并非医学专业的内容,而是可以从大量的通用语料库中学习的。而对于药师,CMB 发现涉及到传统医学的问题难度较大,这也说明了为中文医学领域开发大模型的必要性。

此外,CMB 还探索了 Few-shot 和 CoT 策略的效果,发现 CoT 并不总能提高模型的精度,可能其反而会给模型带来不相关的背景信息,妨碍了模型的推理能力。而 Few-shot prompting 策略在模型已经展现出较高准确性的情况下效果最明显。在表现欠佳的模型中,使用这种策略可能反而会损害模型的结果。后者的原因可能有两个:一是模型在处理大段输入时遇到困难,二是模型可能需要进一步的优化,以更好地利用上下文中的示例。

CMB-Clin 实验

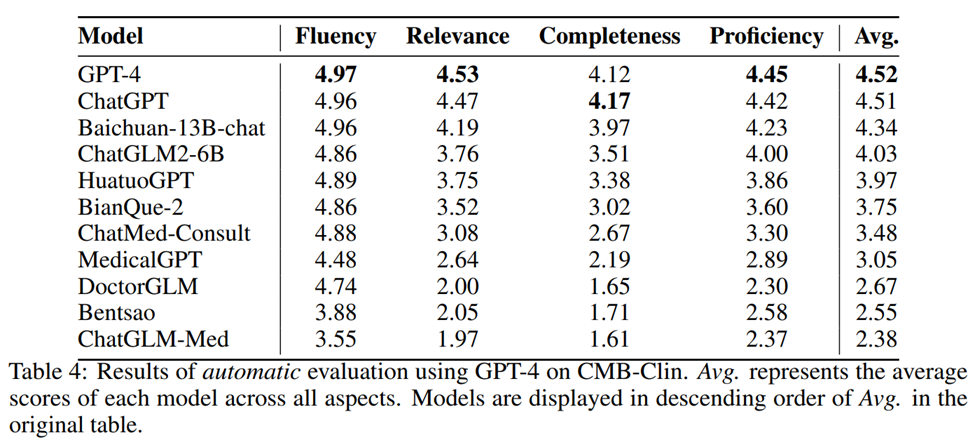

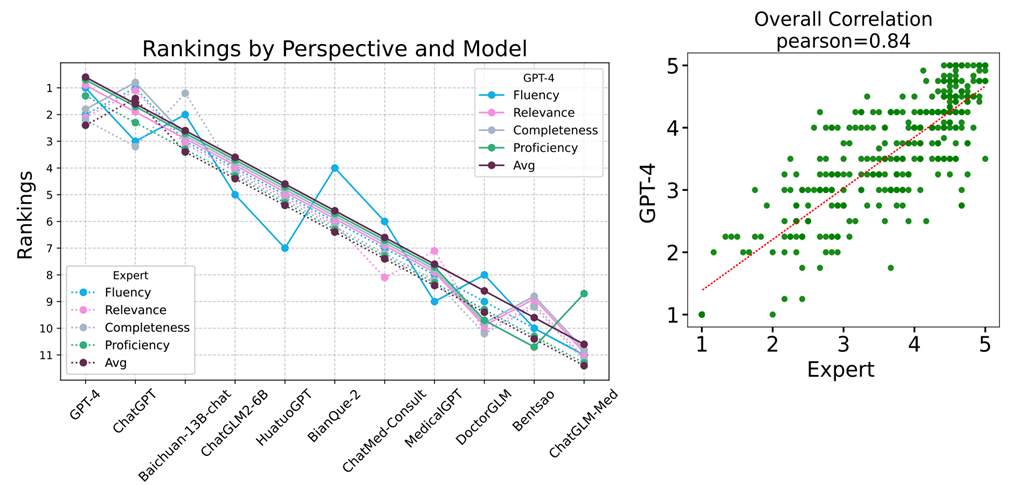

CMB 从四个维度(流畅性、相关性、完整性、医学知识专业性),用人工评估和自动评估的方式对语言模型在 CMB-Clin 评测数据集上的输出进行打分。上表是 GPT-4 基于参考答案和评分标准得出的模型分数。同时 CMB 对自动评估和专家评估的一致性进行了量化统计,发现自动评估和专家评估之间的结果存在高度的一致性,两者的结果排名 Spearman 系数为 0.93 ,分数的 Pearson 系数为 0.84 。

其次,CMB-Exam 和 CMB-Clin 两组数据的排名结果也非常一致,Spearman 系数达 0.89。研究者希望模型在 CMB-Exam 的训练集上进行微调后,仍然能在 CMB-Clin 上获得不错的分数,与社区的期望进行对齐:既有足够的医学知识,又能和患者进行有效交流,帮助解决实际问题。

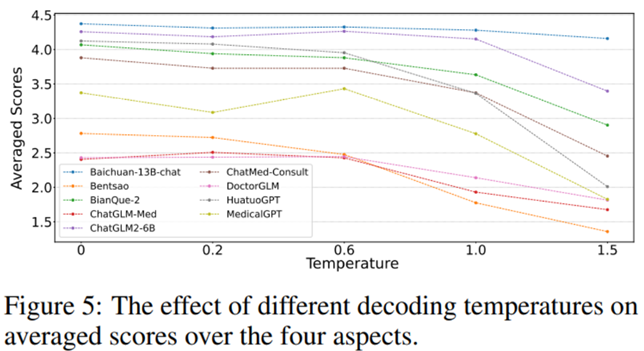

CMB 还探索了不同解码温度下的结果之间的差异。研究发现,当解码温度从 0 增加到 1.5 时,模型的整体表现有所下滑,这可能是因为较高的温度会导致输出的随机性(多样性)增加,而在医学领域,社区更偏好准确的内容。同时,CMB 也发现在不同的解码温度下,模型的排名结果的稳定性都非常高。

总结

CMB 从现实医学考核和临床应用出发,结合选择题和复杂病历问诊来全面检验模型在医学知识与诊断能力上的表现。研究者真诚地希望,CMB 可以为医学大模型的研发者们提供有力的反馈,帮助更快地完善模型,促进中文医学领域语言模型的持续创新和应用。CMB 将在近期加入更多中文模型测评,论文也将在近期更新。

相信在共同努力下,未来医疗大模型的社会接受度和应用场景将不断扩大,为人口老龄化,医疗资源分配不均,医生超负荷工作和成长空间受限等问题,提供 AI 社区的缓解方案。

OpenCompass 开源项目链接:

https://github.com/open-compass/opencompass

论文题目:

CMB: A Comprehensive Medical Benchmark in Chinese

论文链接:

https://arxiv.org/abs/2308.08833

代码链接:

https://github.com/FreedomIntelligence/CMB

官网链接:

https://cmedbenchmark.llmzoo.com/

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2023-11-02,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读