每日学术速递4.12(全新改版)

标题:查找视觉任务向量

作者:lberto Hojel ; Yutong Bai ; Trevor Darrell ; Amir Globerson ; Amir Bar

文章链接:https://arxiv.org/abs/2404.05729

项目代码:https://github.com/alhojel/visual_task_vectors

摘要:

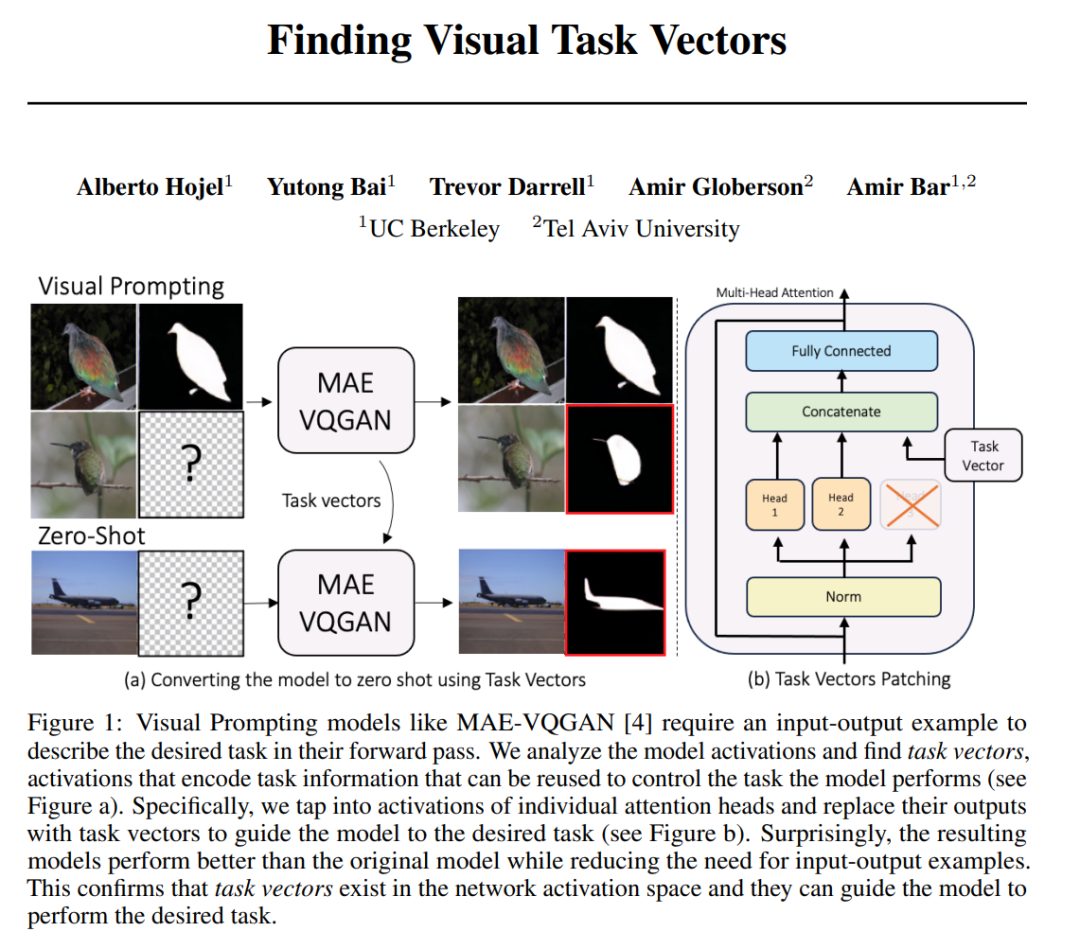

视觉提示是一种通过上下文示例教模型执行视觉任务的技术,无需任何额外的训练。在这项工作中,我们分析了MAE-VQGAN(一种最新的视觉提示模型)的激活,并找到了任务向量,即编码特定于任务的信息的激活。有了这种洞察力,我们证明了可以识别任务向量并使用它们来指导网络执行不同的任务,而无需提供任何输入输出示例。为了找到任务向量,我们计算每个任务的平均中间激活次数,并使用 REINFORCE 算法搜索任务向量的子集。生成的任务向量引导模型执行比原始模型更好的任务,而无需输入输出示例。

论文的主要内容:

- 问题定义:论文探讨了在计算机视觉中,如何通过模型激活来找到任务向量,这些向量能够编码特定任务的信息,并在模型的前向传播中指导模型执行任务。

- 方法提出:研究者提出了一种方法,通过分析MAE-VQGAN模型的激活,找到可以代表任务信息的中间激活(任务向量),并用这些任务向量来替换输入-输出示例,以指导模型执行不同的视觉任务。

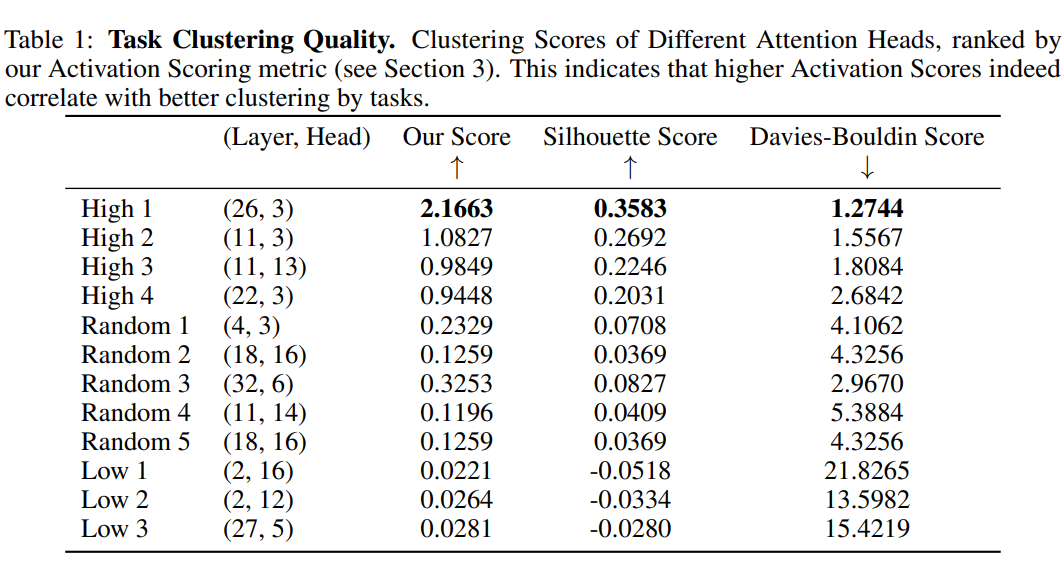

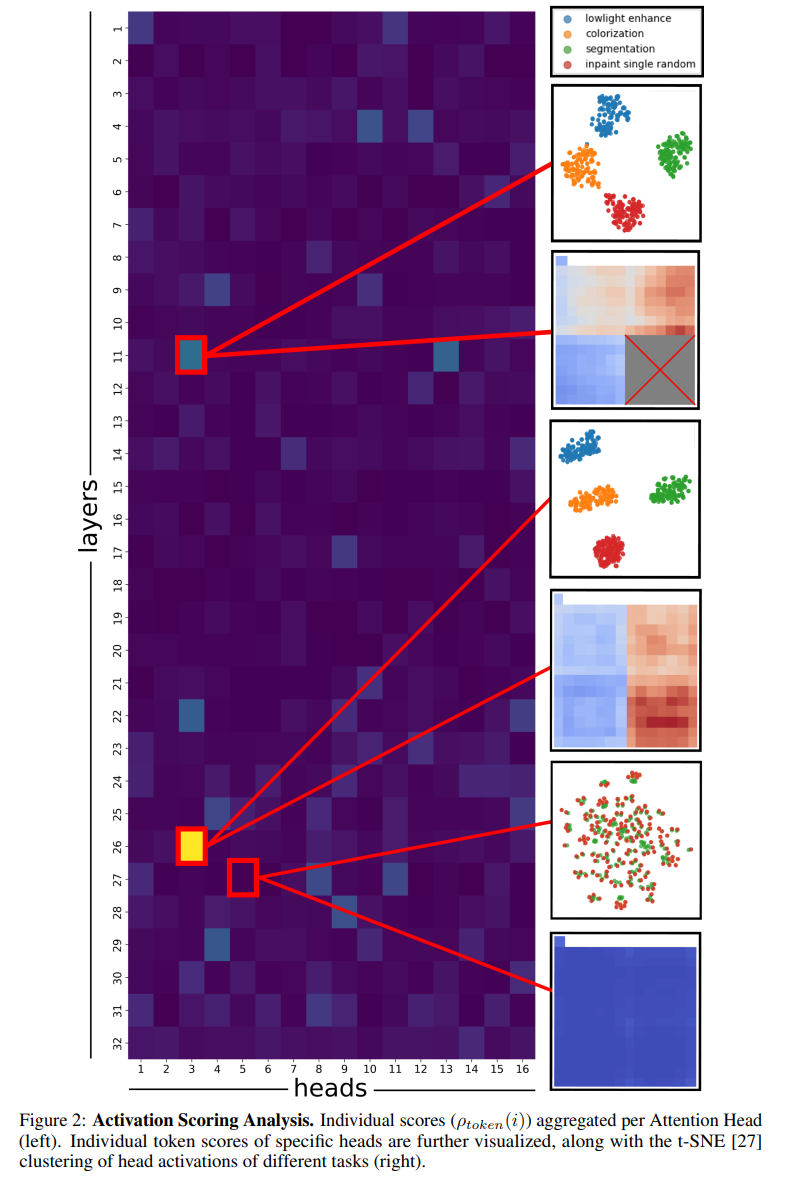

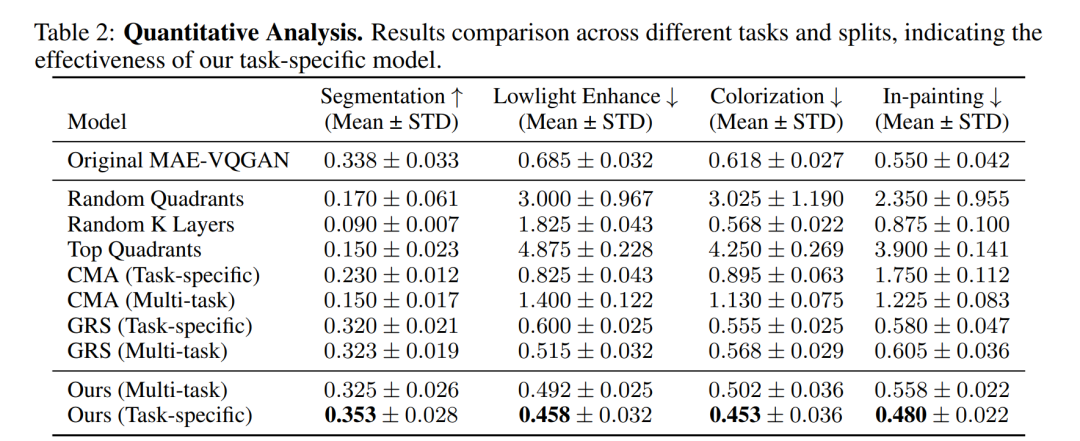

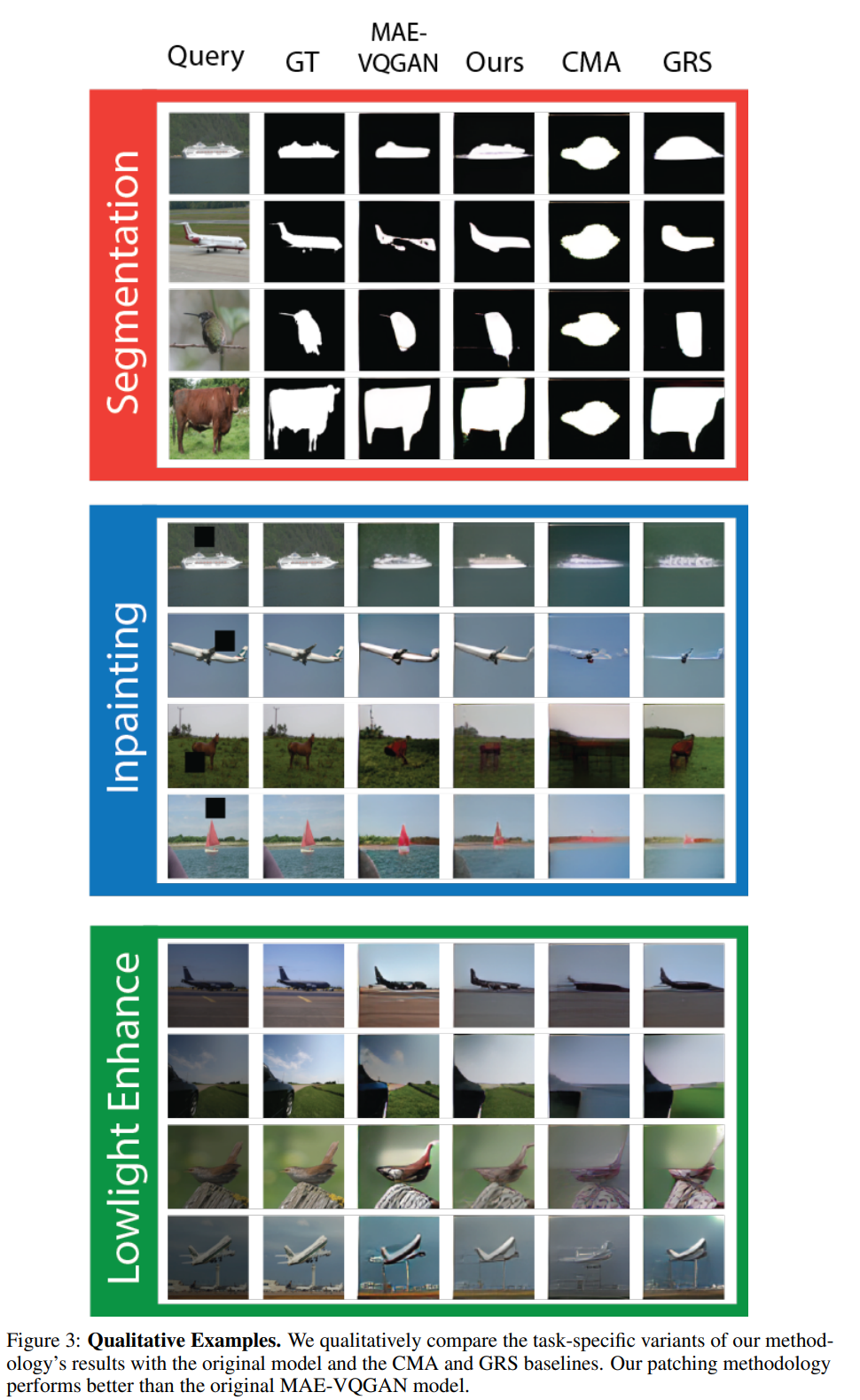

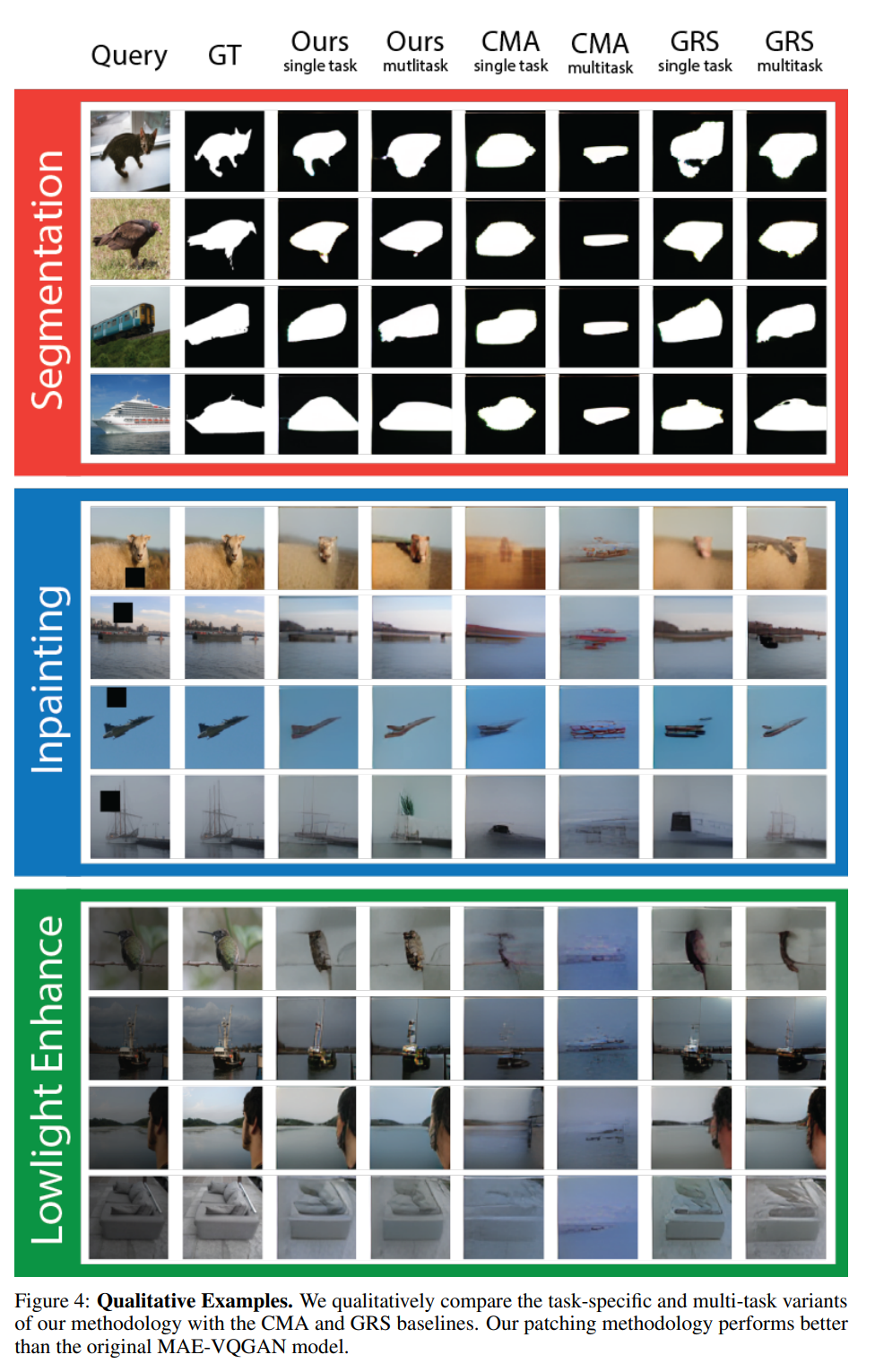

- 实验设计:论文中进行了一系列实验,包括激活评分分析、下游任务性能评估、零样本任务向量补丁、消融实验等,来验证任务向量的有效性和性能。

- 结果分析:实验结果表明,使用任务向量的方法能够在不需要额外输入-输出示例的情况下,达到与原始模型相当的或更好的性能。此外,消融实验揭示了任务向量在网络中的位置和补丁策略的重要性。

- 未来方向:论文指出了一些可以进一步探索的方向,包括探索其他类型的向量、改进评分机制、多任务学习、模型和数据集的泛化、更高效的搜索算法、任务向量的解释性以及实际应用场景。

- 结论:论文得出结论,任务向量在视觉上下文学习中确实存在,并且可以通过特定的方法被有效地识别和利用,以提高模型执行特定视觉任务的性能和灵活性。

这篇论文试图解决什么问题?

探讨了在计算机视觉领域中,如何通过激活任务向量(task vectors)来实现上下文学习(in-context learning)。具体来说,研究者们试图解决以下问题:

- 任务向量在计算机视觉模型中的存在性:研究者们试图验证在计算机视觉模型中是否存在类似于自然语言处理中的任务向量,这些向量能够编码特定任务的信息,并在模型的前向传播中起到指导作用。

- 无需额外训练的任务执行:通过分析MAE-VQGAN模型的激活,研究者们尝试找到一种方法,使得模型能够在没有额外训练的情况下,通过上下文示例执行视觉任务。

- 减少对输入-输出示例的依赖:论文中提出的方法旨在减少模型执行任务时对输入-输出示例的需求,从而提高模型的灵活性和效率。

- 模型性能的提升:研究者们通过实验验证,使用任务向量指导模型执行任务,能否在不依赖输入-输出示例的情况下,实现与原始模型相当的或更好的性能。

- 任务向量的定位和搜索:论文提出了一种基于REINFORCE算法的方法来搜索和定位任务向量,这种方法能够在模型的激活空间中有效地找到能够指导模型执行特定任务的激活。

- 多任务学习:研究者们还探讨了如何通过任务向量实现多任务学习,即在多个任务之间共享任务向量,以提高模型在不同任务上的性能。

总的来说,这篇论文的目标是深入理解视觉上下文学习的工作机制,并提出一种实用的方法来识别和利用任务向量,以指导视觉模型执行特定的视觉任务。

论文如何解决这个问题?

论文通过以下步骤解决视觉任务向量的问题:

- 分析模型激活:研究者们首先分析了MAE-VQGAN模型的激活,这是一个视觉提示模型,通过寻找在不同任务间变化但在单个任务内部保持不变的中间激活来建立任务向量的概念。

- 计算平均激活:通过计算每个任务的平均中间激活,研究者们使用REINFORCE算法来搜索能够指导模型执行特定任务的任务向量子集。

- 定位任务向量:研究者们提出通过定位单个注意力头的激活并用任务向量替换它们的输出,以此来引导模型执行所需的任务。

- 优化任务向量:使用REINFORCE算法来优化任务向量的位置,通过迭代优化和采样,找到最佳的激活集合来指导模型执行任务。

- 减少对输入-输出示例的需求:通过将任务向量插入模型的自注意力头中,研究者们展示了可以在不需要额外的输入-输出示例的情况下引导模型执行任务。

- 性能评估:通过在一系列视觉任务上评估模型的性能,研究者们证明了使用任务向量的方法能够在减少计算量的同时,达到与原始模型相当的性能。

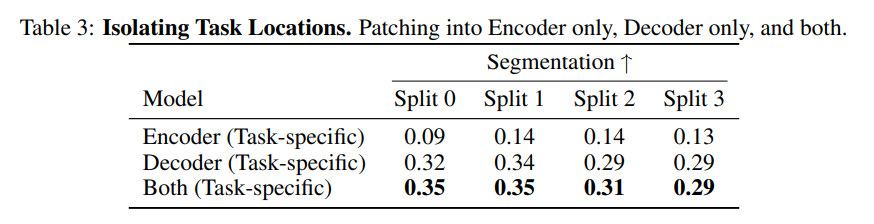

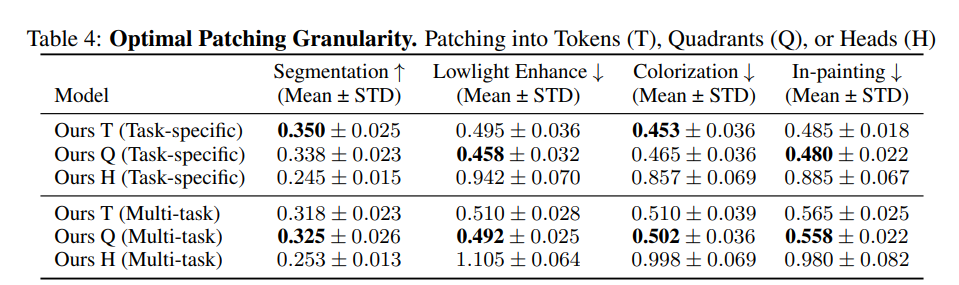

- 消融实验:为了验证方法的有效性,研究者们进行了一系列消融实验,包括检查任务向量在编码器和解码器中的位置,以及不同的补丁粒度(如按象限、注意力头或单独的标记分组)。

通过这些步骤,论文成功地展示了在计算机视觉模型中存在任务向量,并且可以通过这些任务向量来有效地引导模型执行特定的视觉任务,而不需要依赖于输入-输出示例。这一发现为提高视觉模型的灵活性和效率提供了新的可能性。

2.MA-LMM: Memory-Augmented Large Multimodal Model for Long-Term Video Understanding

标题:MA-LMM:用于长期视频理解的内存增强大型多模态模型

作者:Bo He, Hengduo Li, Young Kyun Jang, Menglin Jia, Xuefei Cao, Ashish Shah, Abhinav Shrivastava, Ser-Nam Lim

文章链接:https://arxiv.org/abs/2404.05726

项目代码:https://boheumd.github.io/MA-LMM/

摘要:

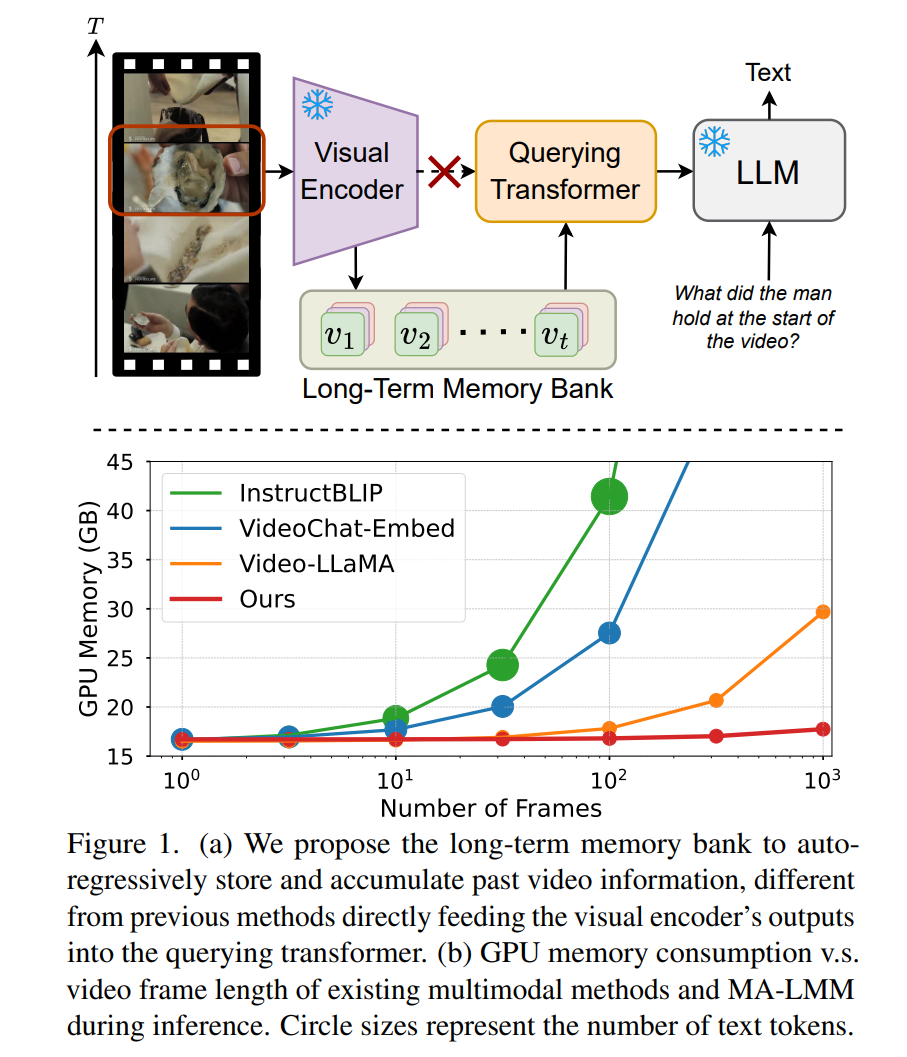

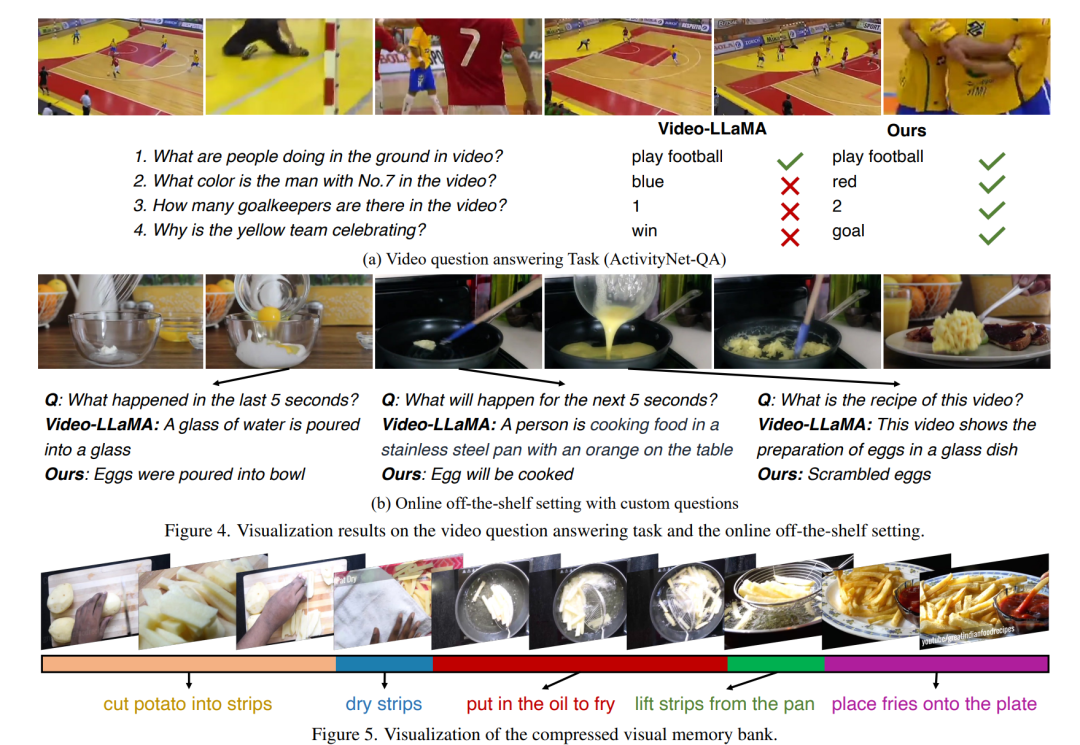

随着大型语言模型的成功(LLMs),将视觉模型集成到LLMs构建视觉语言基础模型中,最近引起了人们的更多兴趣。然而,现有的LLM基于大型多模态模型(例如,Video-LLaMA、VideoChat)只能接受有限数量的帧来理解短视频。在这项研究中,我们主要关注设计一个高效且有效的长期视频理解模型。我们建议不要像大多数现有工作那样尝试同时处理更多帧,而是以在线方式处理视频并将过去的视频信息存储在存储库中。这允许我们的模型参考历史视频内容进行长期分析,而不会超出LLMs上下文长度限制或 GPU 内存限制。我们的记忆库LLMs可以以现成的方式无缝集成到当前的多模态中。我们对各种视频理解任务进行了广泛的实验,例如长视频理解、视频问答和视频字幕,我们的模型可以在多个数据集上实现最先进的性能。此 https URL 中提供的代码。

论文的主要内容:

这篇论文的主要内容可以总结如下:

- 问题定义:论文针对现有大型多模态模型(LLMs)在处理长期视频内容时存在的上下文长度限制和GPU内存限制问题,提出了一个新的模型MA-LMM(Memory-Augmented Large Multimodal Model)。

- 方法提出:为了解决这些问题,论文提出了一个在线处理视频帧并使用长期记忆库来存储过去视频信息的方法。这种方法允许模型在不超出LLMs的上下文长度和GPU内存限制的情况下,进行长期视频分析。

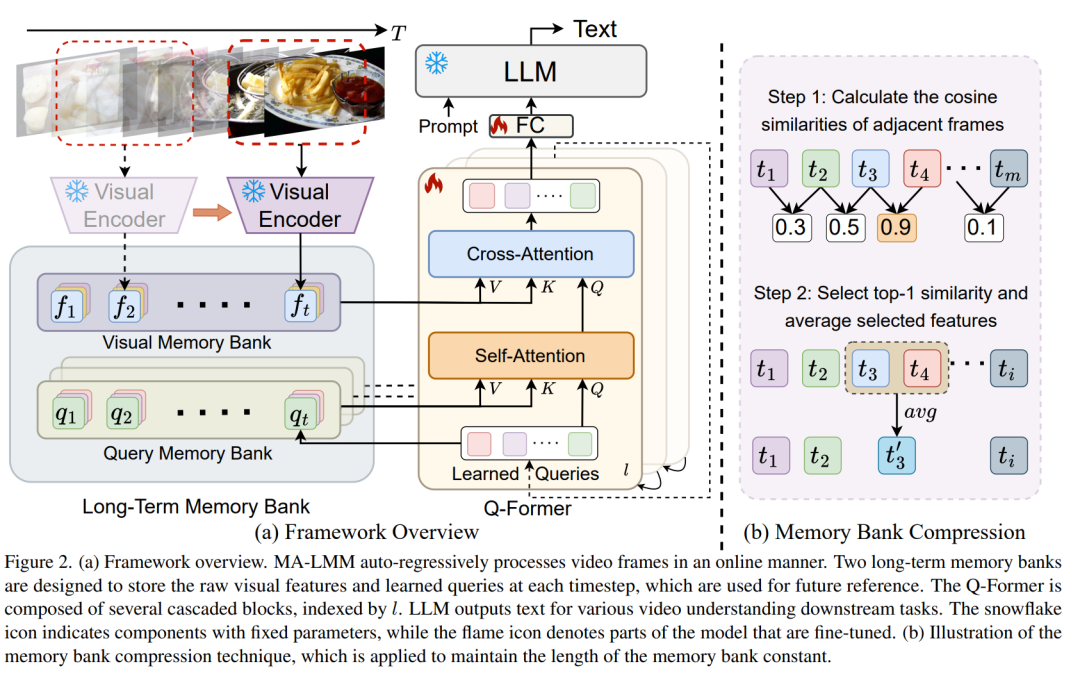

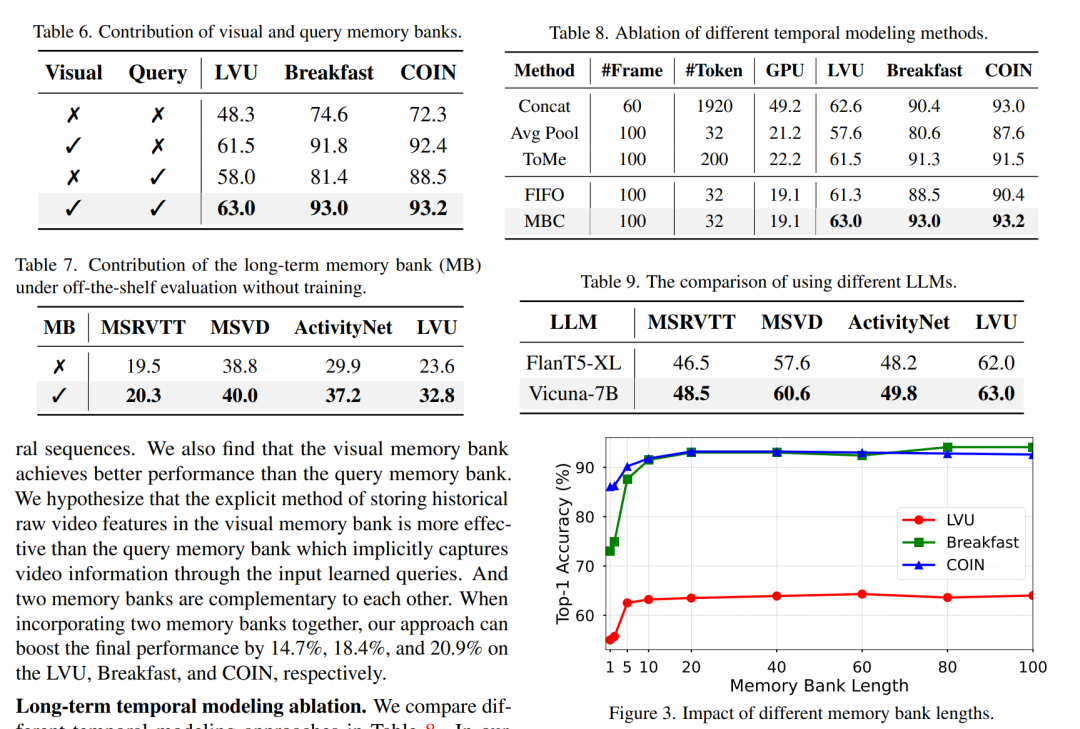

- 关键组件:

- 视觉记忆库:存储来自视觉编码器的原始视频特征。

- 查询记忆库:累积输入查询,捕获视频的时间信息。

- 记忆库压缩:通过计算相邻帧的相似性并进行特征平均来减少记忆库的长度,同时保留关键信息。

- 模型架构:MA-LMM模型结合了视觉编码器、查询转换器(Q-Former)和大型语言模型(LLM),通过自回归方式处理视频帧并生成文本输出。

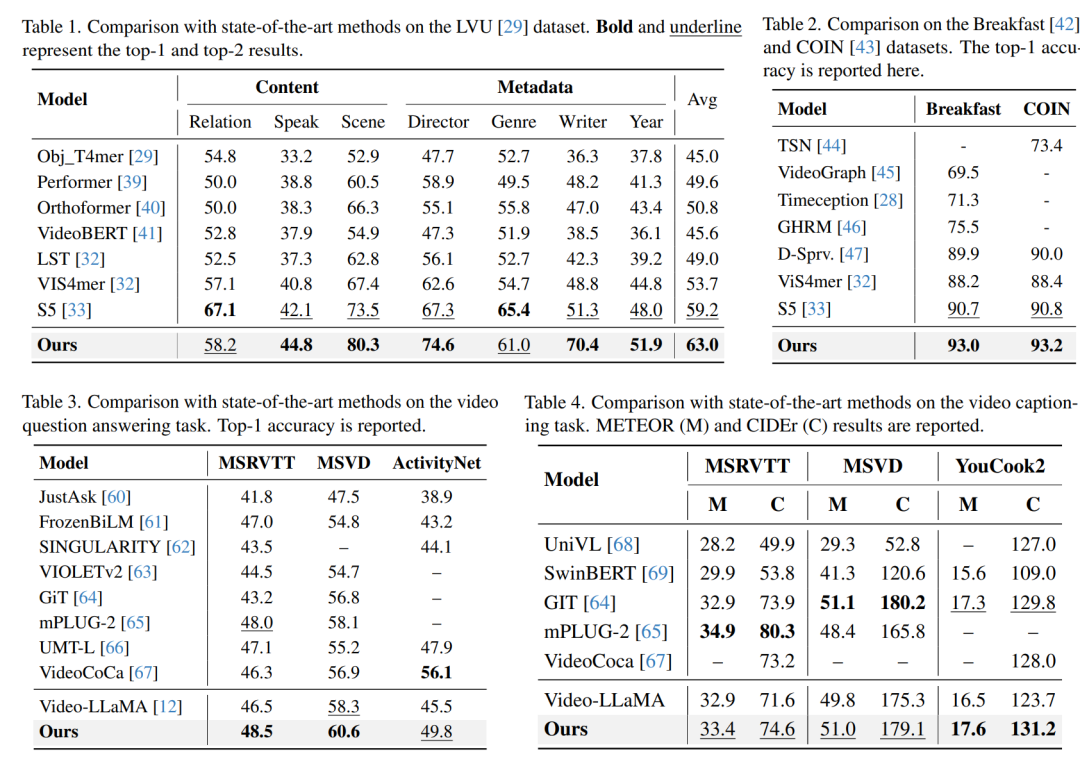

- 实验验证:论文在多个视频理解任务上进行了广泛的实验,包括长期视频理解、视频问题回答和视频字幕生成,证明了MA-LMM在多个数据集上取得了最先进的性能。

- 消融研究:通过消融研究,论文展示了视觉和查询记忆库对模型性能的贡献,以及不同时间建模方法的效果。

- 未来方向:论文讨论了未来可能的研究方向,包括处理极长视频的分层方法、使用视频编码器、在大规模数据集上预训练、集成更先进的LLM等。

总体而言,这篇论文提出了一个创新的模型,通过在线处理和记忆库机制有效解决了长期视频理解中的一些关键挑战,并在多个任务上展示了其优越的性能。

这篇论文试图解决什么问题:

这篇论文试图解决的主要问题是如何在大型多模态模型(Large Multimodal Models, LLMs)中有效地理解和处理长期视频内容。具体来说,它关注以下几个方面的挑战和问题:

- 长期视频理解:现有的基于大型语言模型(LLMs)的多模态模型在处理视频时,通常只能处理有限数量的帧,这对于理解长期视频内容(如电影和电视节目)是不足够的。

- 上下文长度限制:大型语言模型在处理输入时存在上下文长度限制,这限制了它们处理长视频序列的能力。

- GPU内存限制:同时处理大量视频帧会导致显著的GPU内存消耗,这对于资源有限的环境是不可行的。

为了解决这些问题,论文提出了一个名为MA-LMM(Memory-Augmented Large Multimodal Model)的模型,它通过以下方式优化了长期视频理解:

- 在线处理视频帧:与尝试同时处理更多帧的方法不同,MA-LMM提出按顺序在线处理视频帧,并将过去的视频信息存储在记忆库(Memory Bank)中,这样模型就可以在不超过LLMs的上下文长度约束或GPU内存限制的情况下引用历史视频内容进行长期分析。

- 记忆库的引入:通过自回归的方式聚合过去的视频特征,这些特征可以在后续的视频序列处理中被引用。此外,记忆库被设计为与查询转换器(Q-Former)兼容,作为注意力操作中的键(key)和值(value),用于长期时间建模。

- 记忆库压缩方法:为了提高效率,提出了一种记忆库压缩方法,通过选择和平均最相似的相邻帧特征来保持记忆库的长度与输入视频长度成比例,同时显著减少长期视频中的时间冗余。

通过这些方法,MA-LMM能够在多个数据集上实现最先进的性能,包括长期视频理解、视频问题回答和视频字幕生成等任务。

论文如何解决这个问题?

论文通过提出一个名为MA-LMM(Memory-Augmented Large Multimodal Model)的新型模型来解决长期视频理解的问题。具体的解决方案包括以下几个关键组件和步骤:

- 在线处理视频帧:

- 与同时处理整个视频的方法不同,MA-LMM采用在线方式顺序处理视频帧,这类似于人类处理视觉信息的认知过程。

- 长期记忆库:

- 引入两个长期记忆库:视觉记忆库(Visual Memory Bank)和查询记忆库(Query Memory Bank)。

- 视觉记忆库存储来自冻结视觉编码器的原始视频特征。

- 查询记忆库累积每个时间步的输入查询,这些查询通过Q-Former捕获视频的时间信息。

- 记忆库压缩:

- 为了解决长期视频中的时间冗余问题,提出了一种记忆库压缩方法,通过计算相邻帧之间的余弦相似性并选择最相似的特征进行平均,从而减少记忆库的长度。

- 查询转换器(Q-Former):

- 使用与BLIP-2中相同的查询转换器架构来对齐视觉和文本嵌入空间。

- Q-Former由跨注意力和自注意力子模块组成,可以与长期记忆库交互,以捕获视频的时间动态。

- 文本解码:

- MA-LMM以自回归方式处理视频帧,最终时间步的Q-Former输出包含所有历史信息,这些信息随后被送入大型语言模型(LLM)进行文本解码。

- 实验验证:

- 在多个视频理解任务上进行广泛的实验,包括长期视频理解、视频问题回答和视频字幕生成,证明了MA-LMM在多个数据集上实现了最先进的性能。

通过这些设计,MA-LMM能够有效地处理长期视频内容,同时解决了大型语言模型在处理长视频时遇到的上下文长度限制和GPU内存限制的问题。论文的实验结果表明,该模型在多个视频理解任务上都取得了显著的性能提升。

3.Evaluating the Efficacy of Cut-and-Paste Data Augmentation in Semantic Segmentation for Satellite Imagery

标题:评估剪切粘贴数据增强在卫星影像语义分割中的功效

作者:Ionut M. Motoi, Leonardo Saraceni, Daniele Nardi, Thomas A. Ciarfuglia

文章链接:https://arxiv.org/abs/2404.05693

摘要:

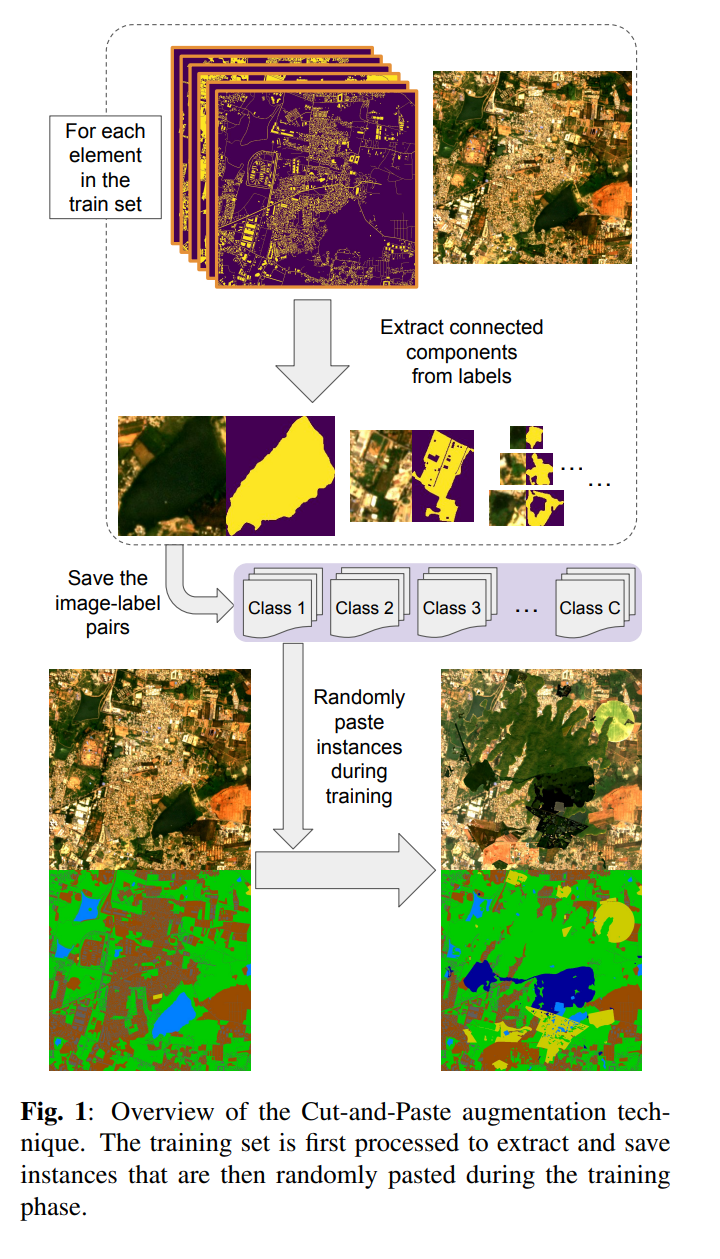

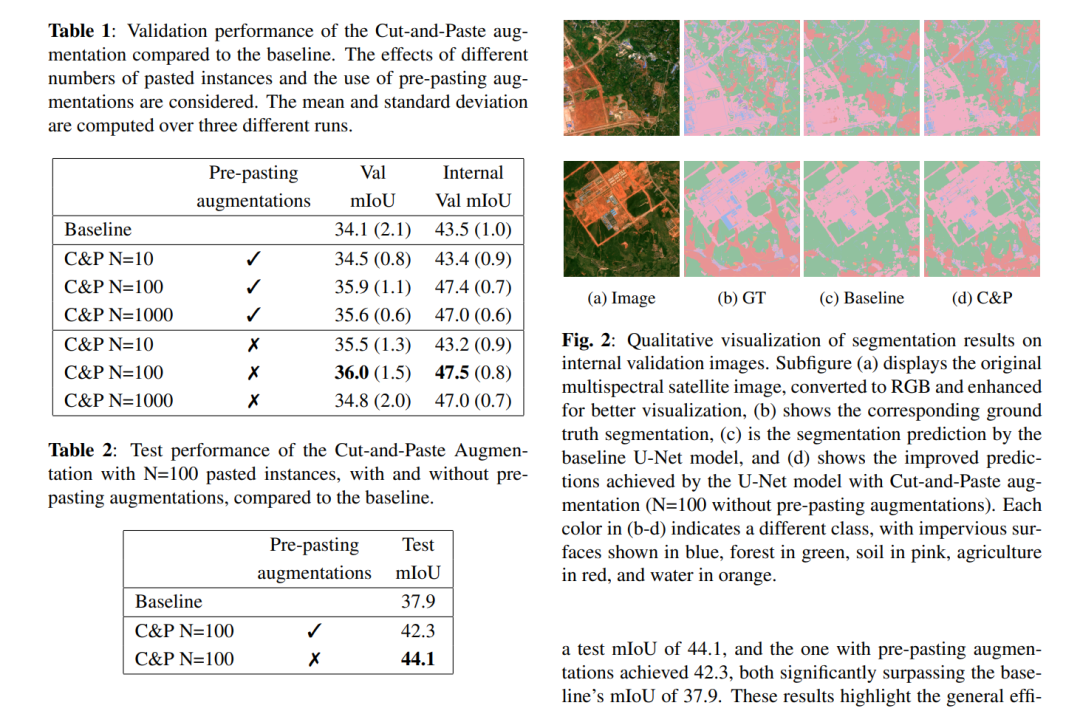

卫星图像对于环境监测和城市规划等任务至关重要。通常,它依赖于语义分割或土地利用土地覆被 (LULC) 分类来对每个像素进行分类。尽管深度神经网络 (DNN) 带来了进步,但它们在分割任务中的性能受到诸如标记数据可用性有限、类别不平衡以及卫星图像固有的可变性和复杂性等挑战的阻碍。为了缓解这些问题,我们的研究探讨了剪切和粘贴增强技术在卫星图像中语义分割的有效性。我们将这种通常需要标记实例的增强调整为语义分割的情况。通过利用语义分割标签中的连接组件,我们提取实例,然后在训练期间随机粘贴这些实例。使用 DynamicEarthNet 数据集和 U-Net 模型进行评估,我们发现这种增强显着提高了测试集的 mIoU 分数,从 37.9 提高到 44.1。这一发现凸显了剪切和粘贴增强在提高卫星图像中语义分割模型的泛化能力方面的潜力。

论文的主要内容:

这篇论文的主要内容可以总结如下:

- 问题陈述:论文旨在解决卫星图像语义分割任务中的挑战,特别是标记数据有限、类别不平衡和图像复杂性等问题。

- 方法介绍:提出了一种剪切和粘贴(Cut-and-Paste)数据增强技术,以提高深度神经网络(DNNs)在卫星图像语义分割中的性能和泛化能力。

- 技术实施:

- 实例提取:使用连通组件分析从语义分割标签中提取独立的实例掩码。

- 实例粘贴:在训练过程中随机选择并粘贴提取的实例,允许实例重叠以创建多样化的训练样本。

- 实验设置:

- 使用DynamicEarthNet数据集和U-Net模型作为实验平台。

- 采用平均交并比(mIoU)作为主要性能评价指标。

- 实验结果:

- 展示了不同配置下剪切和粘贴增强技术的性能,包括粘贴实例的数量和是否使用预粘贴增强。

- 结果表明,该增强技术能显著提高模型在测试集上的mIoU分数,从而验证了其有效性。

- 结论:

- 论文证实了剪切和粘贴数据增强技术在提高卫星图像语义分割模型性能方面的潜力。

- 提供了一种无需额外手动标注即可生成新卫星图像语义分割数据的简单有效方法。

- 未来工作:

- 论文提出了进一步改进增强技术、探索其在其他遥感任务和领域中的应用,以及开发自动化标注和增强方法等未来研究方向。

这篇论文试图解决什么问题?

这篇论文试图解决的问题是如何提高卫星图像语义分割的性能,特别是在面临标记数据有限、类别不平衡以及卫星图像本身的复杂性和变化性等挑战时。为了解决这些问题,论文探索了一种称为“剪切和粘贴”(Cut-and-Paste)数据增强技术在卫星图像语义分割任务中的有效性。通过这种技术,作者旨在增加训练数据的多样性和变化性,从而提高深度学习模型的泛化能力。

论文如何解决这个问题?

论文通过以下步骤解决了卫星图像语义分割中的挑战问题:

- 实例提取(Instance Extraction):

- 利用连通组件(connected components)的概念,将语义分割标签中的每个类别的像素级信息分离成独立的实例掩码。

- 对于每个图像,首先将其对应的标签分割成多个二值掩码,每个掩码代表一个类别中的一个连通区域。

- 通过这种方式,可以将每个连通区域作为一个实例进行提取和保存。

- 实例粘贴(Instance Pasting):

- 在训练阶段,从第一步生成的实例集中随机选择实例,并将其粘贴到当前的训练样本上。

- 允许实例之间发生重叠,以创建不典型但合理的场景,这有助于模型泛化到罕见的实际情况。

- 对于每个训练图像,重复粘贴过程多次,其中粘贴的实例数量是一个可调的参数。

- 数据增强和模型训练:

- 使用DynamicEarthNet数据集和一个U-Net模型进行评估。

- 在训练过程中,结合标准的图像增强技术(如翻转和旋转)和剪切粘贴增强技术。

- 通过改变粘贴实例的数量和是否在粘贴前对实例进行额外的增强(例如翻转和旋转),来评估不同配置下的性能。

- 性能评估:

- 使用平均交并比(mean Intersection over Union, mIoU)作为主要的性能评估指标。

- 通过与未使用剪切粘贴增强技术的基线模型进行比较,来评估所提出方法的有效性。

通过这些步骤,论文展示了剪切粘贴数据增强技术能够显著提高模型在测试集上的mIoU分数,从而证明了这种方法在提高卫星图像语义分割模型泛化能力方面的潜力。