微软深夜再掀AI生产力革命,奥特曼登台「自曝」新模型!定制Copilot十亿打工人狂欢

微软深夜再掀AI生产力革命,奥特曼登台「自曝」新模型!定制Copilot十亿打工人狂欢

新智元报道

编辑:编辑部

【新智元导读】微软昨夜刚上演了一波AI PC革命,今天又全是Copilot。而最让人意外的,竟是奥特曼本人登台预告了下一代模型将会带来新的模态和整体智能。

AI生产力的革命,微软怎会缺席?

在今天的开发者大会上,曾经誓要「颠覆」10亿打工人的Copilot,依然是全程的主角。

没想到70年后,还是要靠微软重新定义软件

不仅有Copilot加持的全新AI PC,日常生活助手Copilot,还有为全世界开发者提供的AI工具堆栈。

更惊喜的是,Sam Altman竟然在发布会的最后,被CTO Kevin Scott请上了台!

两人开场先是一波寒暄,然后共同感慨,这简直是疯狂的一周,疯狂的一年!

针对前段时间的OpenAI离职潮,奥特曼似乎用了一些隐晦的话语来暗戳戳回应:「为了让GPT变得稳健、安全,我们做了很多工作。OpenAI 创建了众多团队来确保LLM按预期工作。」

三大杀器

过去的一年半里,世界发生了诸多变化,其中最令Altman本人震惊的事是什么?

Altman表示,数百万开发者是推动过去一年里世界巨变的核心。

从GPT-4 ,再到GPT-4o的发布,尽管模型API推出时间不久,但我从未见过一项技术能如此迅速地得到有意义的应用。

人们正在构建我们从未想过的创新应用,完全展现了开放API的价值所在。

而Kevin Scott也调侃道:看得出来,你们很好地利用了手里的超强超算。

2020年交付的「鲨鱼」级超算训出了GPT-3,接下来的「虎鲸」级超算训出GPT-4,而现在「鲸鱼」级超算微软正交付给OpenAI

奥特曼还表示,新的模态和整体智能将是OpenAI下一个模型的关键。

他预计模型将会变得更智能、更强大,更安全,而且GPT-4o将会速度更快,成本更低。

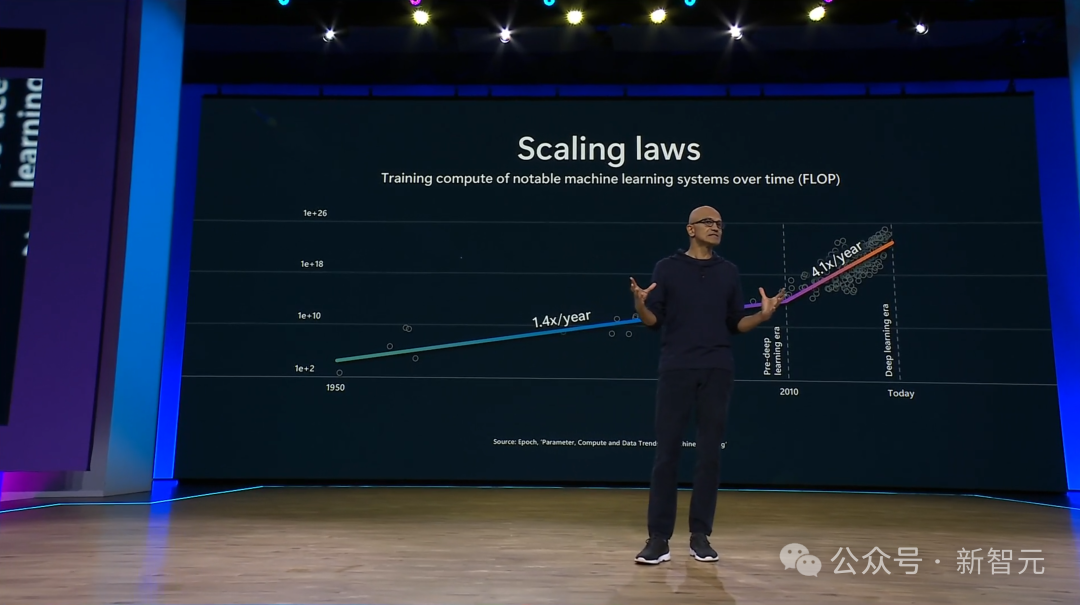

是的,就像摩尔定律推动信息革命一样,Scaling Law和模型架构一起,改变了我们使用数据、生成数据的方式。

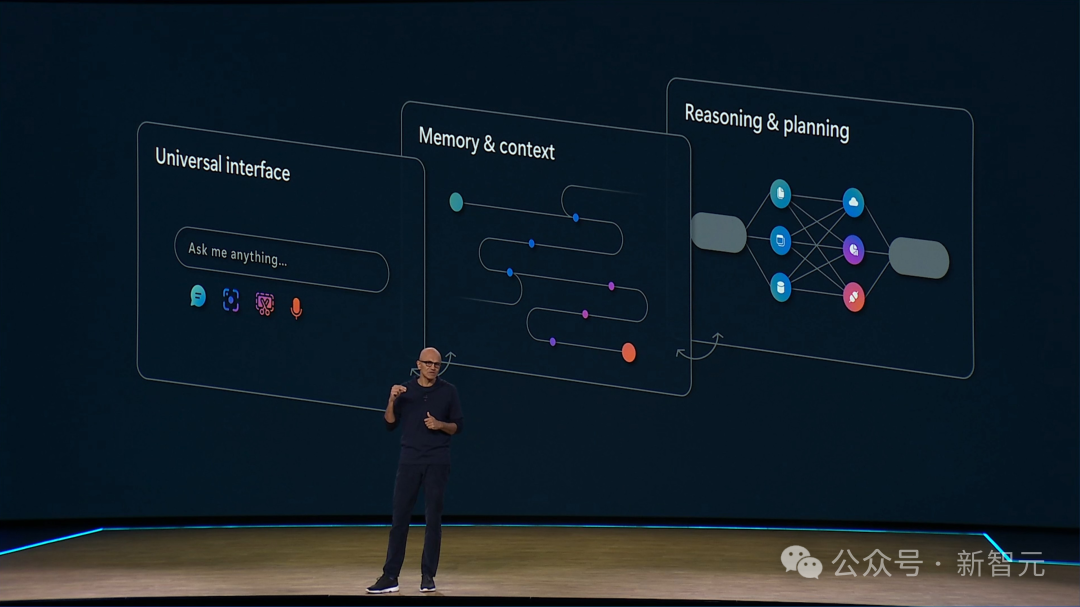

在这些缩放定律的影响下,我们拥有一个新的自然用户界面,这是一个模型,这意味着支持文本、语音、图像、视频作为输入和输出。

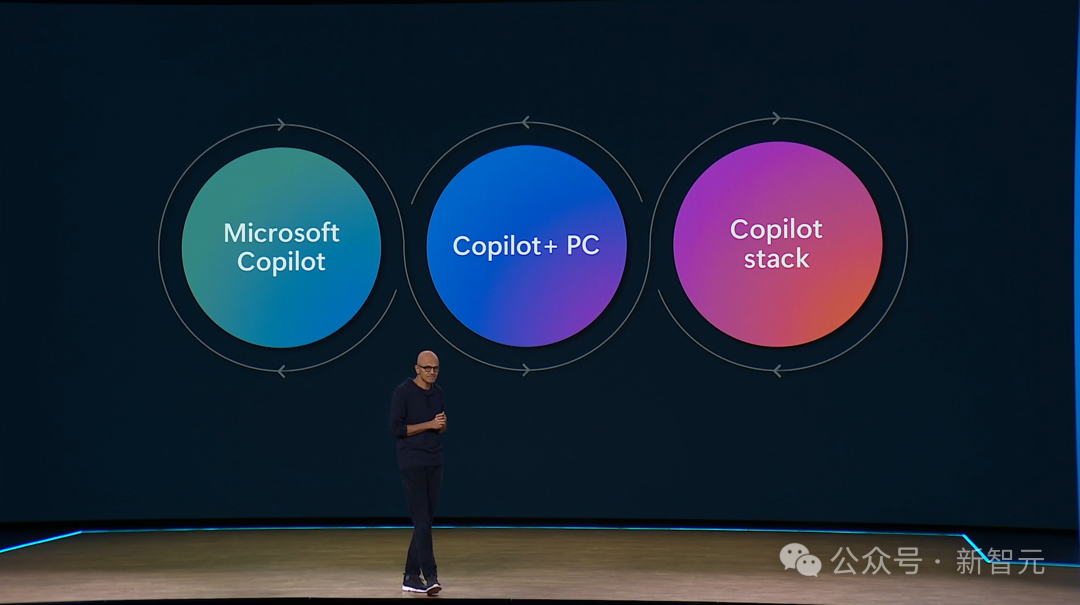

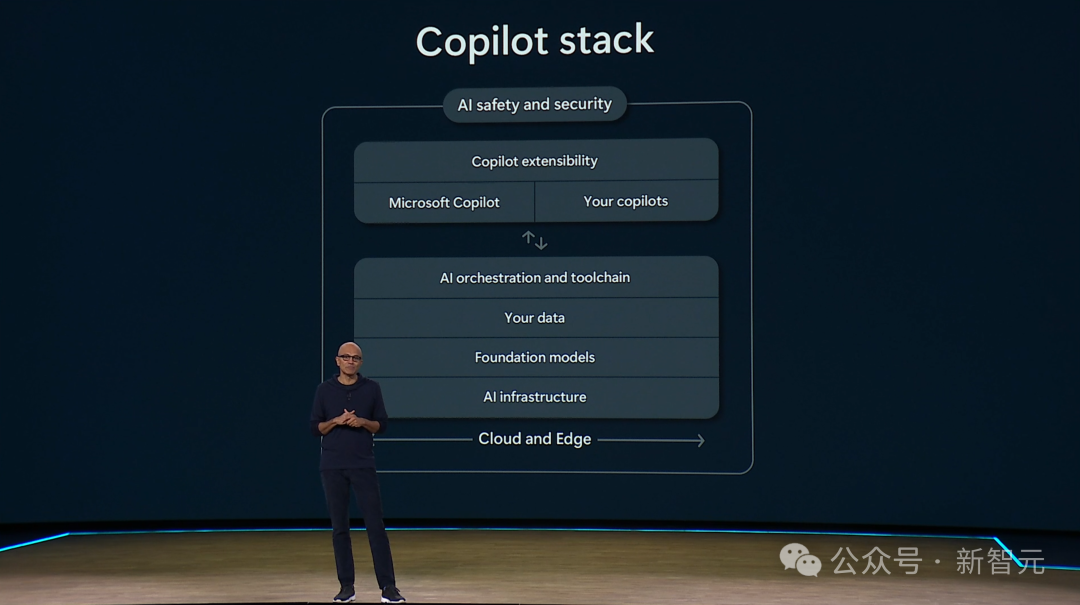

Microsoft Copilot,是日常生活中的助手;Copilot stack,则可以让我们构建AI程序、解决方案等。

还有一个重头戏,当然就是昨天发布的全新Copilot+ PC,它直接打破了纪录,成为有史以来最快的AI电脑!

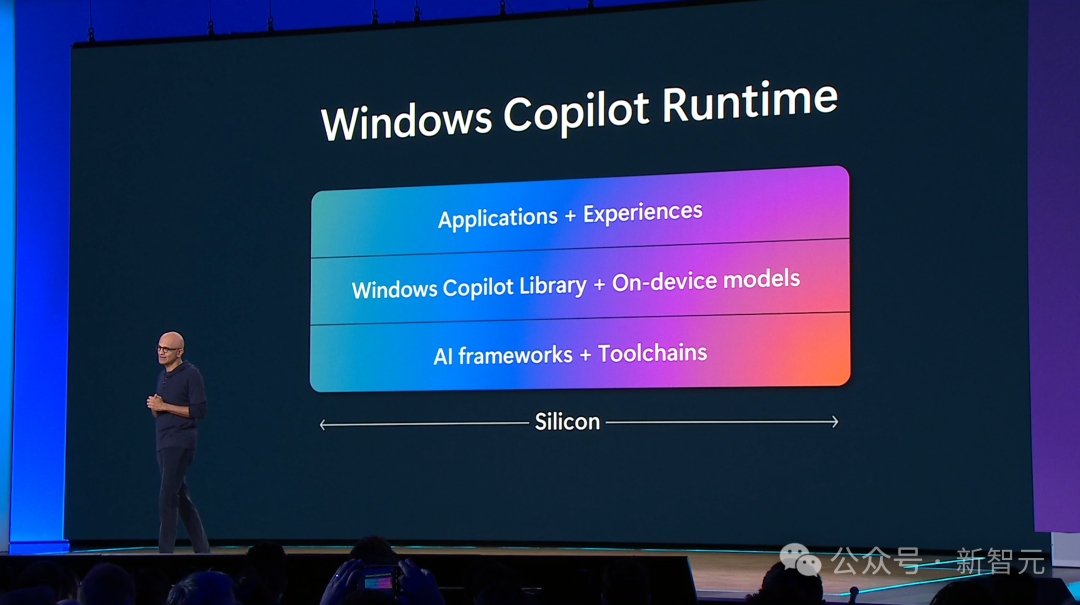

如今,Windows成为了构建AI应用的最佳平台。而这种影响,不啻于Win 32对图形用户界面的意义。

GitHub Copilot「插件商店」首发

继Copilot成为最流行的代码补全工具和「个人助理」之后,微软本次又更新了这个效率提升神器。

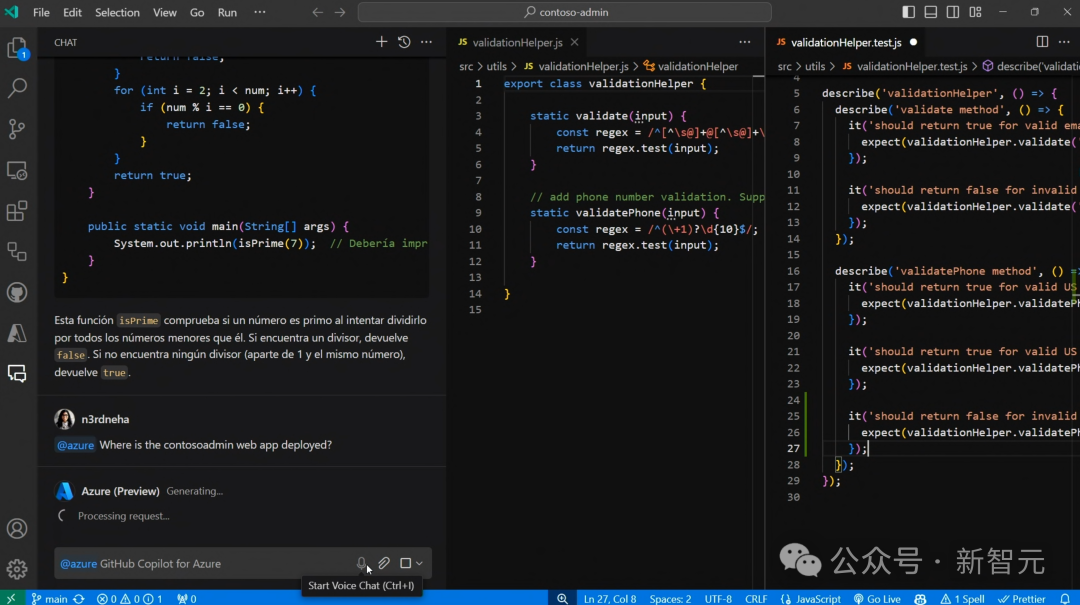

微软表示,很多开发者在代码之外花费了75%的时间,比如追踪工作流、以及撰写需求文档和规格说明等。

不仅如此,定位和修复bug的工作往往需要频繁进行上下文切换,开发者在数据库、IDE、代码仓库、监控工具、云平台之间疲于奔命,无法专注于代码本身。

这正是全新GitHub Copilot可以发挥作用的地方。

它可以通过对话的方式将所有流程整合在一起,帮你调用所有工具和平台,开发者只需要专注于IDE界面的核心代码内容,最大限度减少上下文切换。

不仅如此,基于强大的网络搜索和推理决策能力,Copilot还能回答关于开发过程的问题。

比如在下面这个demo中,用西班牙语描述需求,Copilot就可以自动编写出代码,并为Azure上的部署提供建议。

GitHub产品副总裁表示:「使用自然语言编程将继续降低软件开发的门槛。未来,10亿人可以利用GitHub Copilot,以自然语言的方式与开发技术栈中的任何工具集成,在GitHub上构建代码。」

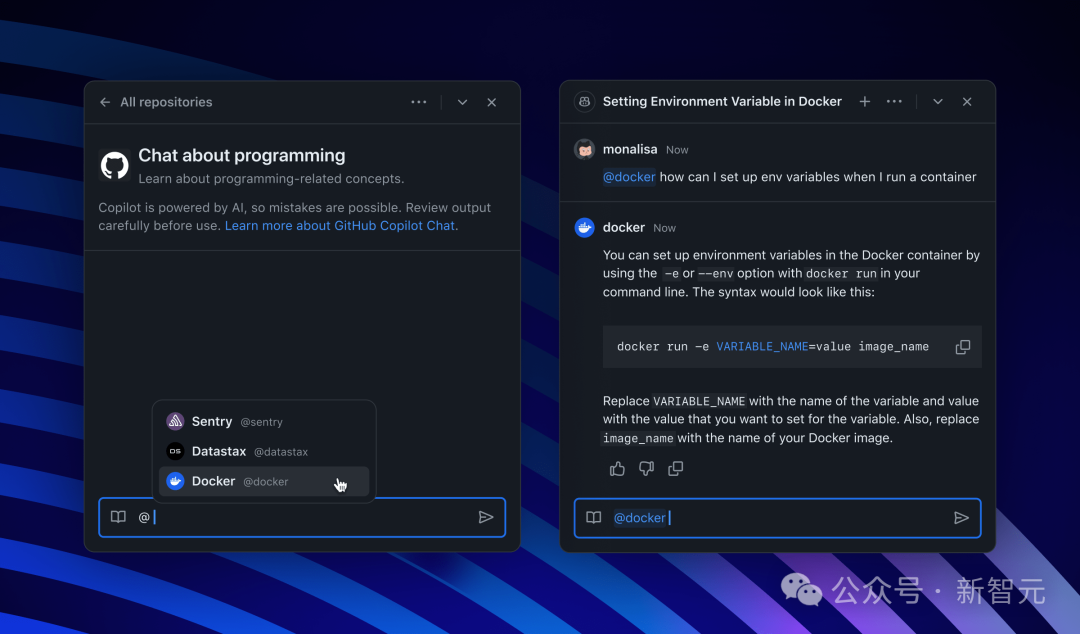

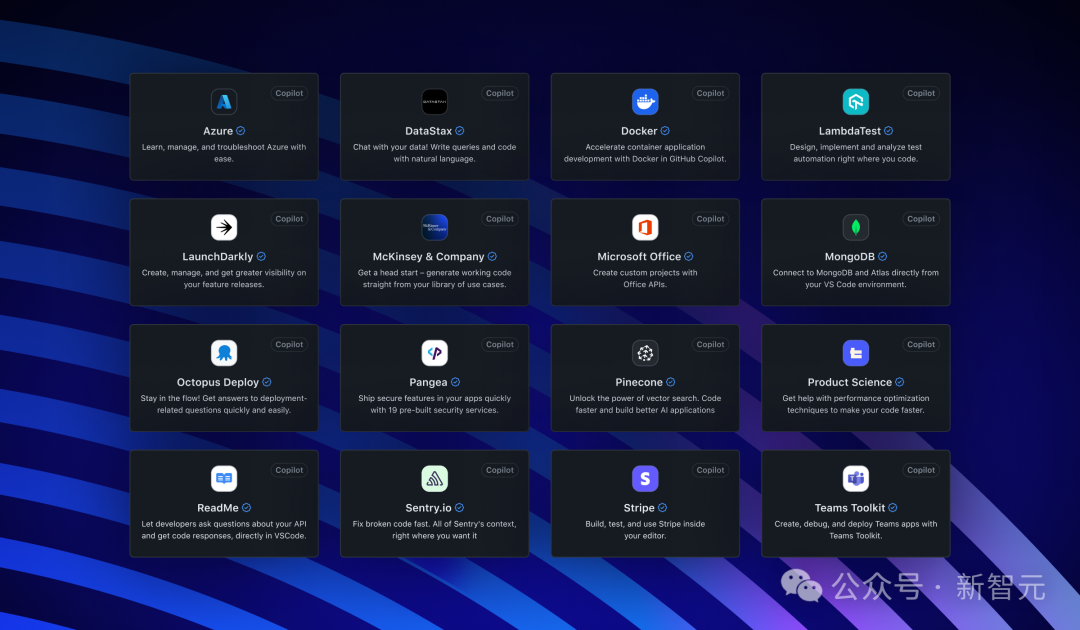

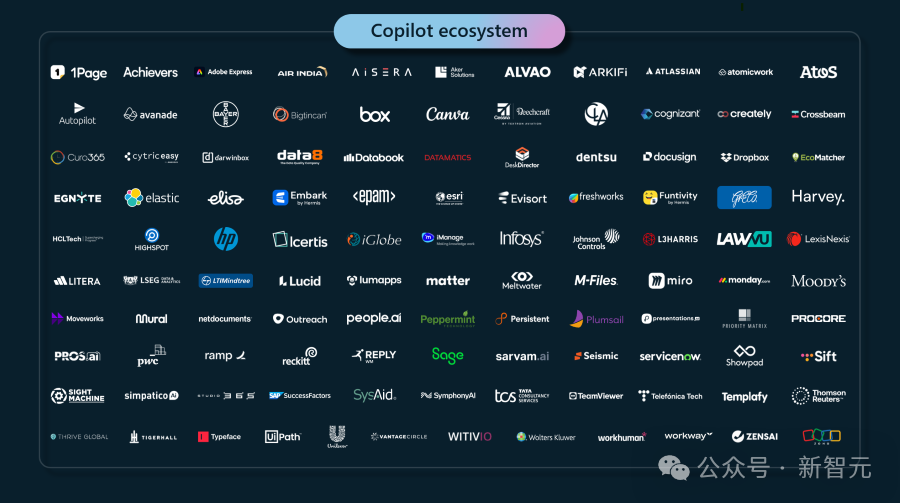

GitHub Copilot支持各种各样的开发工具和平台,包括DataStax, Docker, MongoDB, Octopus Deploy, Pangea, Pinecone, Product Science, ReadMe, Sentry, Stripe以及微软自家的Office全家桶、Azure和Teams。

GitHub产品高级副总裁Mario Rodriguez表示:「我们的目标是使GitHub Copilot成为最集成、最强大、最智能的AI平台。」

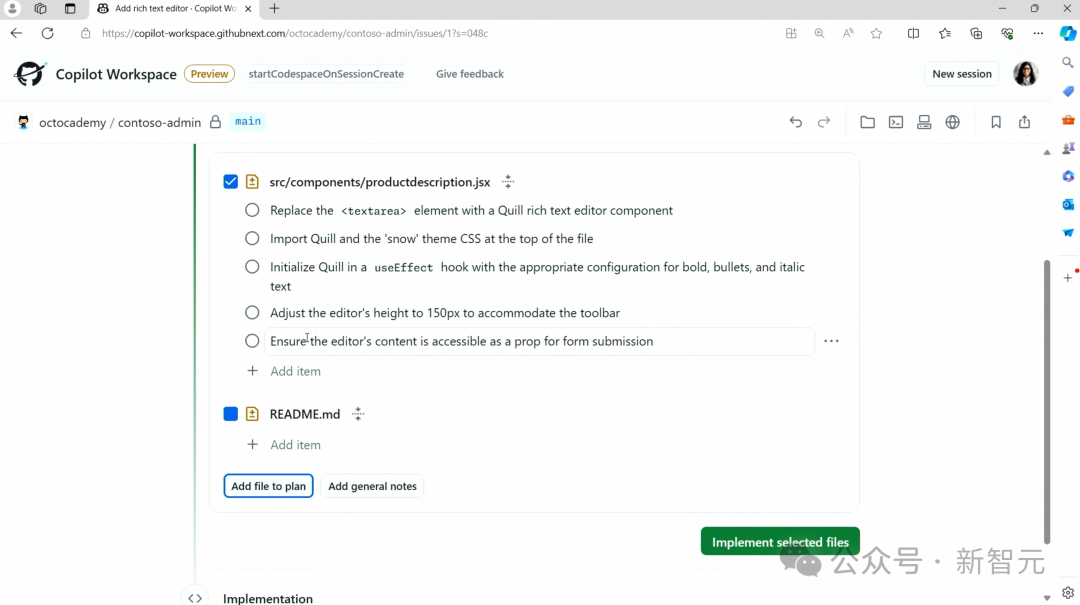

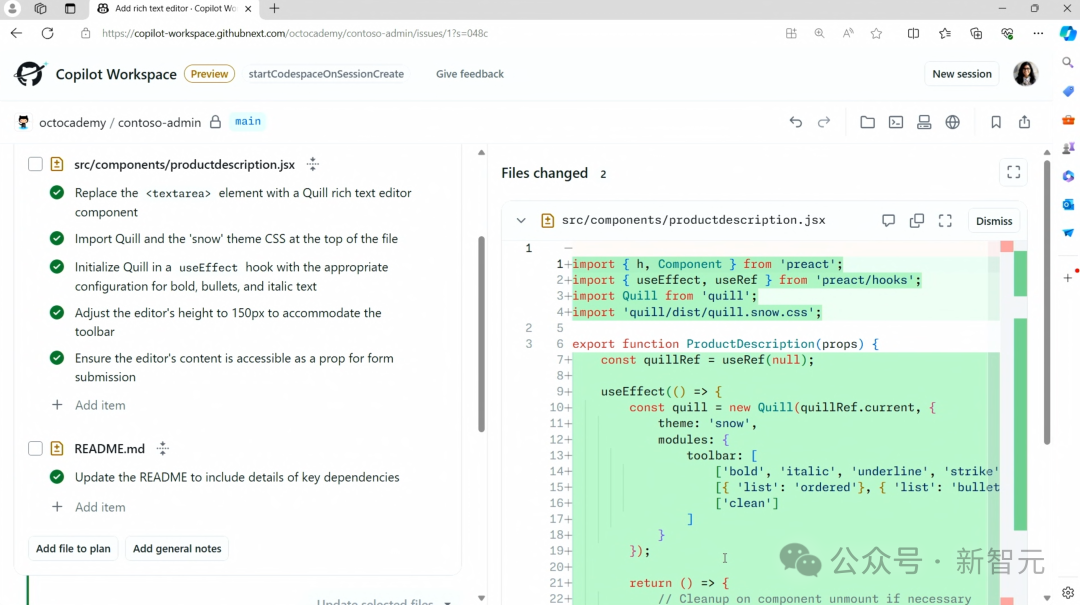

在此基础上延伸出的Copilot Workspace更是提高了开发团队使用GitHub管理项目代码的效率。

之前,用户只能通过Git Bash命令行上传项目文件,图形化界面能进行的操作非常有限。

有了Copilot Workspace,各种时间线和代码分支一目了然,上传文件也容易很多。

而且还提供了非常清晰的代码变动可视化界面,让你自始至终都对项目有满满的掌控感。

截止目前,GitHub Copilot仍处于内测阶段,之后将在GitHub插件市场中发布。

不仅如此,对开发者来说,更酷的是——你可以定制自己的Copilot插件!

3种方式,定义自己的Copilot插件

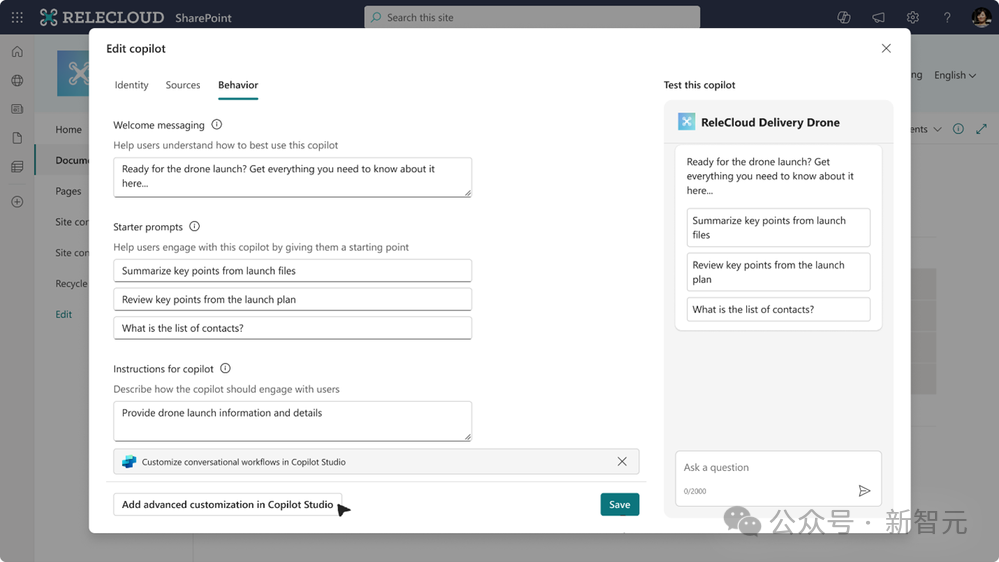

SharePoint

SharePoint是微软开发的用于组织内部存储、管理和共享内容的平台,每天上传数量超过20亿条。

为了减少工作中搜索和筛选内容的时间,微软开发了从SharePoint创建Copilot的功能。

任何拥有SharePoint网站编辑权限的人,只需点击几下就可以自定义Copilot功能,还可以通过Teams聊天框、电子邮件等方式将创建好的Copilot分享给团队中其他成员。

点选好SharePoint中允许访问的内容范围,以及Copilot的身份和行为等信息,它就可以立刻投入工作了。

比如内容回答问题、总结信息或者查找文件,基于你之前授权给它的内容,Copilot可以提供最新、最准确的响应。

想要在SharePoint之外创建自己的Copilot?

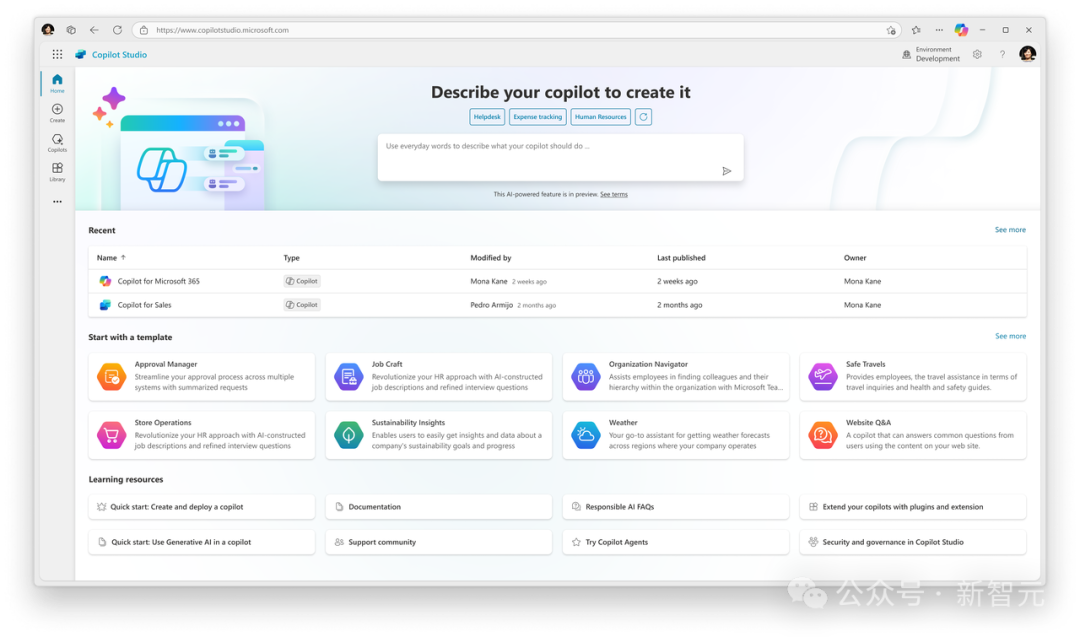

没问题!微软还发布了Copilot Studio,提供更灵活的自定义功能。

Copilot Studio

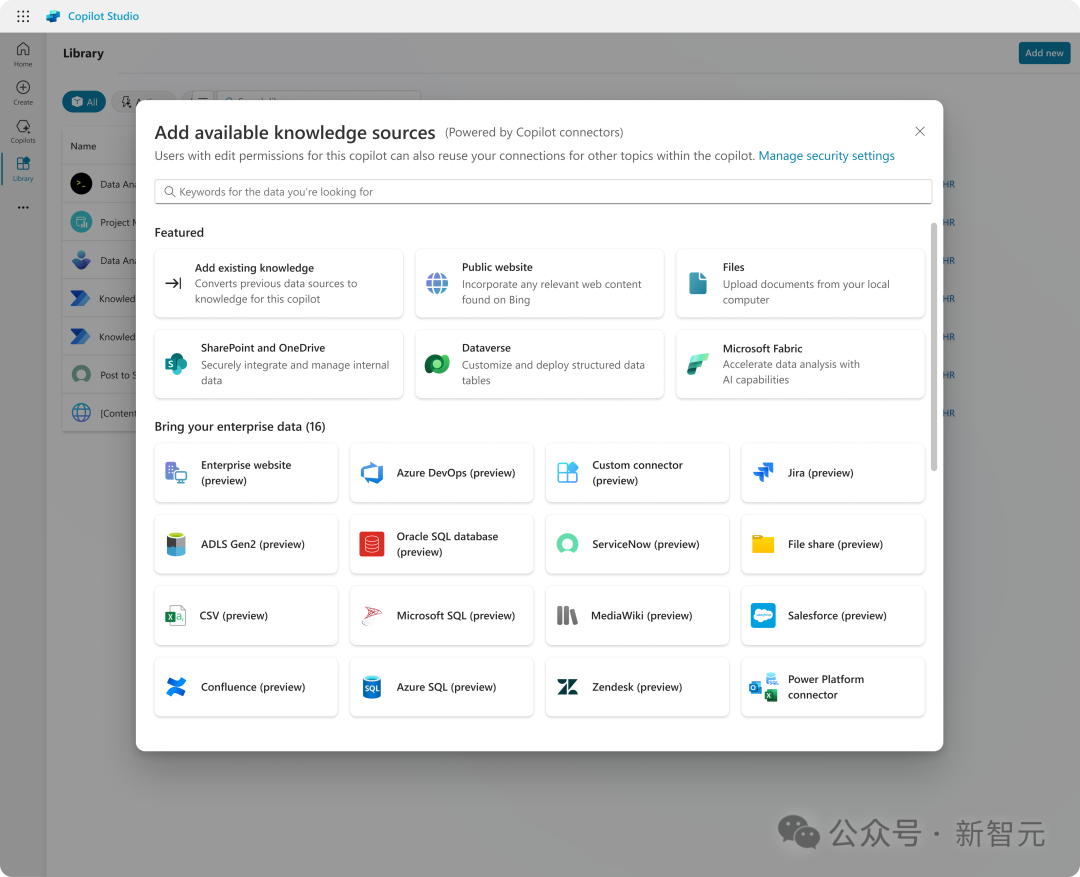

在SharePoint之外,Copilot Studio支持超过1000个数据连接器,方便你将各种数据源导入Copilot。

Copilot Studio依旧采用类似SharePoint中「对话驱动」的界面,你可以像聊天一样描述——想要Copilot有什么样的知识和功能,Copilot Studio就可以立即创建,并支持实时的测试、修改和发布。

为了用户更容易上手使用,Studio中还内置了各种Copilot模板,比如用于组织清晰度的Organizatiion Navigator、用于员工健康管理的Wellness等,未来几个月还会有更多Copilot模板发布。

使用Copilot Studio,你会有一种一切尽在掌握的感觉。

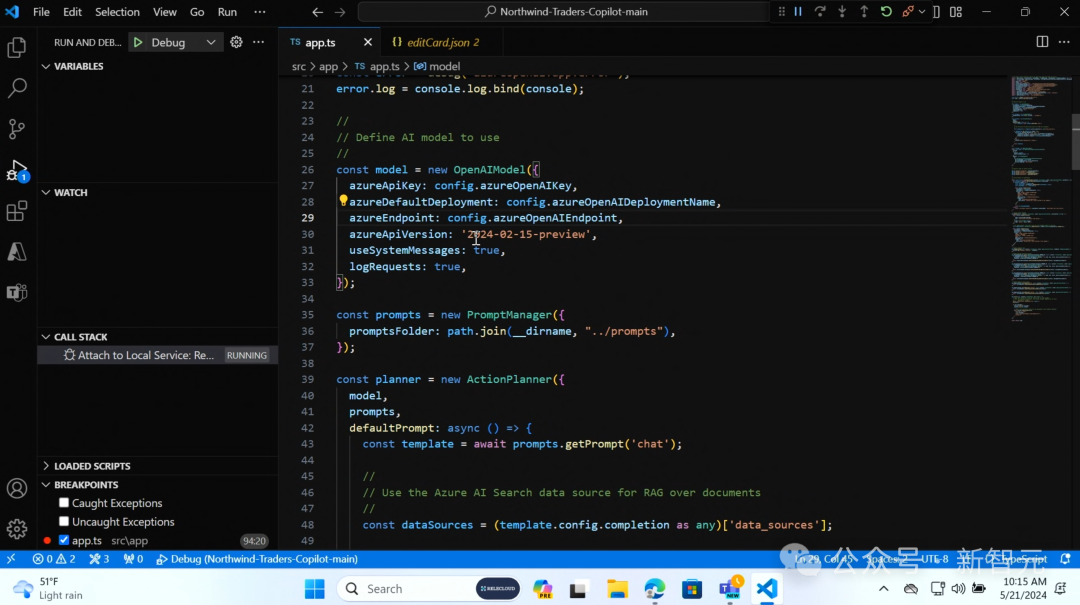

VSCode

如果你是一个高端玩家,更喜欢用代码优先的方式构建插件,也可以使用Visual Studio Code和Teams Toolkit,编写函数来精准定义Copilot的工作流。

Copilot新能力解锁

Copilot早就不止步于代码补全功能,而是已经演变「个人助理」,成为打工人们的效率提升神器,而且与多种工具和平台合作,构建起一套完整的「Copilot生态」。

本次Build大会上,微软又为Copilot解锁了一系列新功能。

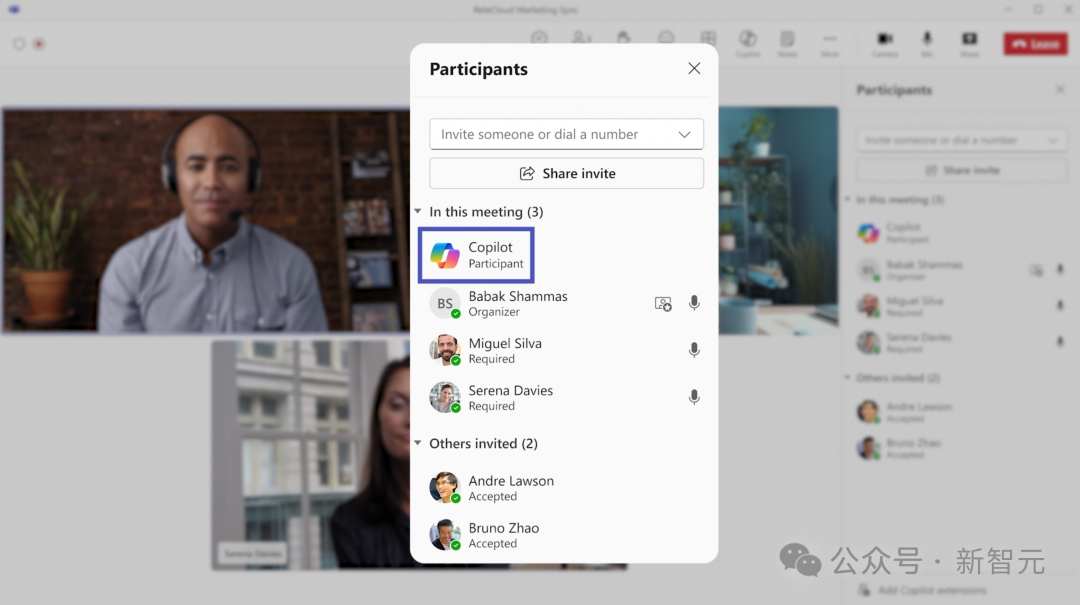

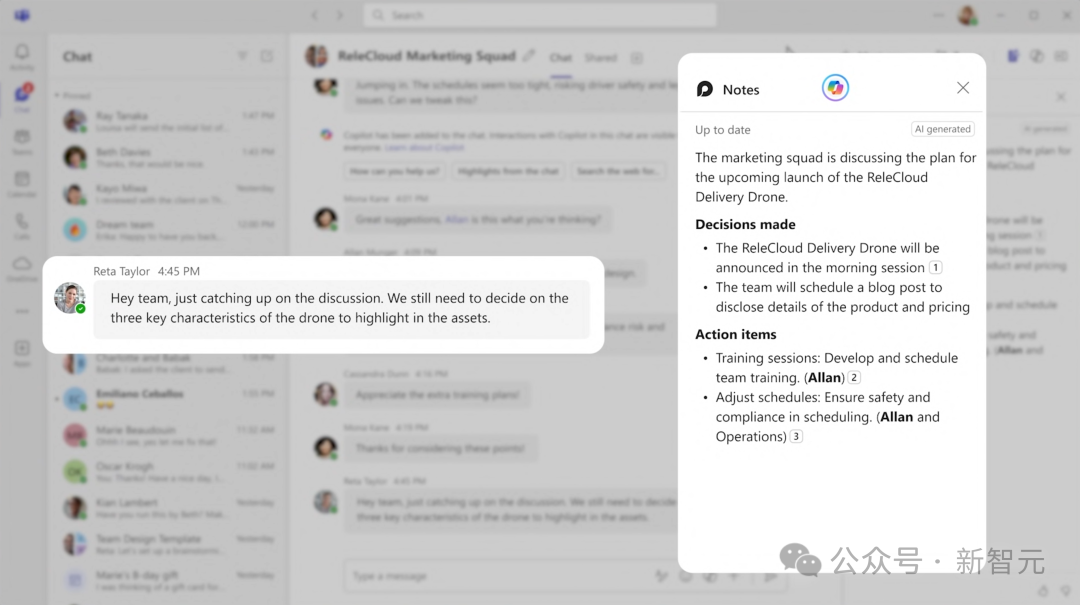

Team Copilot

Team Copilot将功能延伸到「个人助理」之外,开始成为团队的一员。

它能承担单独的职责,提升整个团队的工作效率,比如组织并记录会议、跟踪讨论内容等,甚至可以充当项目经理,为成员分配任务并及时跟进ddl。

对于聊天界面中团队成员们的讨论进展,Copilot还能实时更新自己的记录内容。

可以在Microsoft自家开发的Teams、Loop或者Planner等协作办公软件中使用Team Copilot。

这项功能将在今年晚些时候以预览版形式向有Copilot许可证的用户发布。

Agents Copilot

如果Copilot仅仅进化到团队助手,你可能还是小看了微软。

就像用户可以自定义Copilot插件一样,你也可以使用Copilot Studio自定义一个Copilot Agent。

它不再像原来一样被动地等着你问问题或者分配任务,而是变成「事件触发」的智能体,像虚拟员工一样工作并自动执行任务。

这意味着,Copilot Agent不仅需要记忆、上下文推理以及根据反馈学习的能力,而且需要更加主动,能够在后台自发执行任务。

这样的Copilot岂不是会让一大批白领失业?

微软业务应用程序和平台公司副总裁Charles Lamanna在采访中表示,它可以消除一些重复、琐碎的工作,例如数据输入等,也许都是没有人真正想做的事情。

GPT-4o上新,多款基础模型可用

除了Copilot华丽的演示之外,在开篇提到的三个平台中,最核心的是构建最完整的端到端堆栈——Copilot stack。

其中,最底层是基础设施,然后是基础模型层。

基础设施

为了AI工作负载,微软特意构建了全新的数据中心。

因此,微软可以用每一兆瓦的功率,来降低AI的成本和功耗。

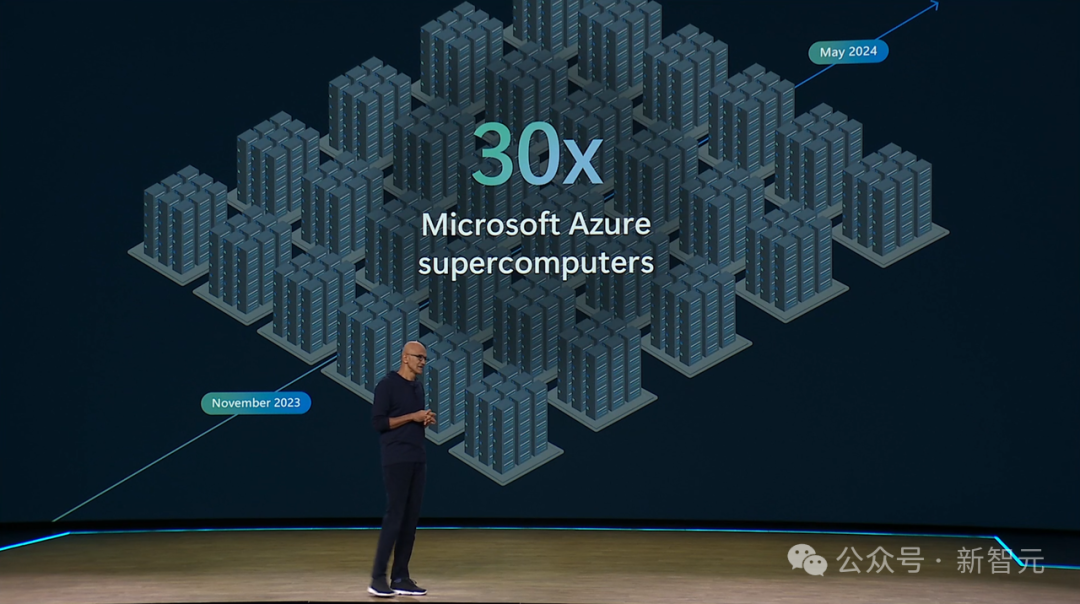

截止2024年5月,Azure超算能力已经实现了30倍的增长!

可以说,他们提供了世界上最先进的AI加速器,开发者可以拥有最完整的AI加速器选择。

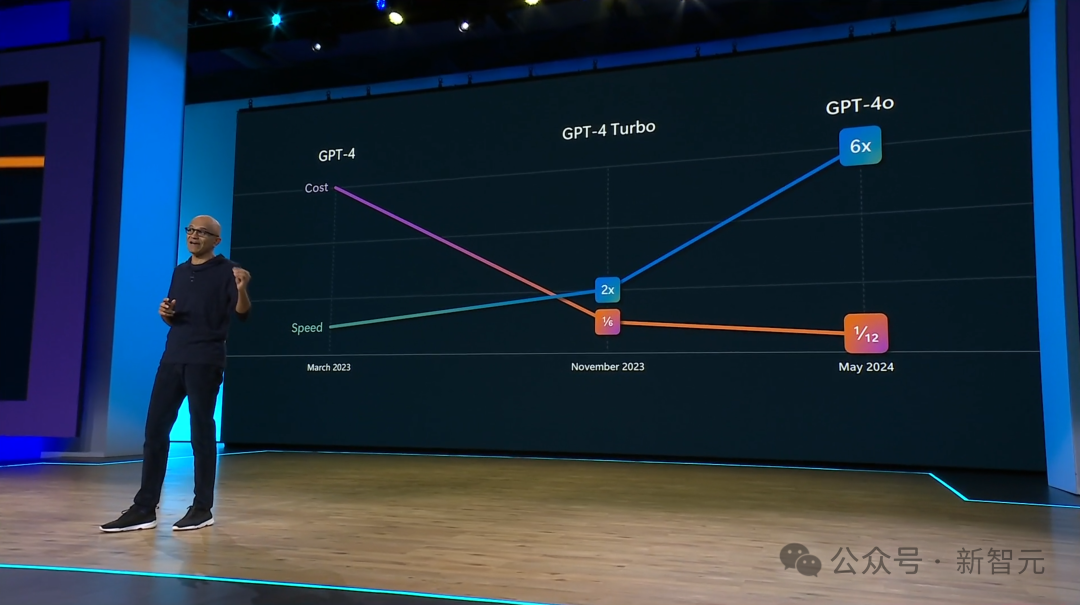

从GPT-4到GPT-4o,不仅模型的速度提高了6倍,成本更是便宜了12倍。

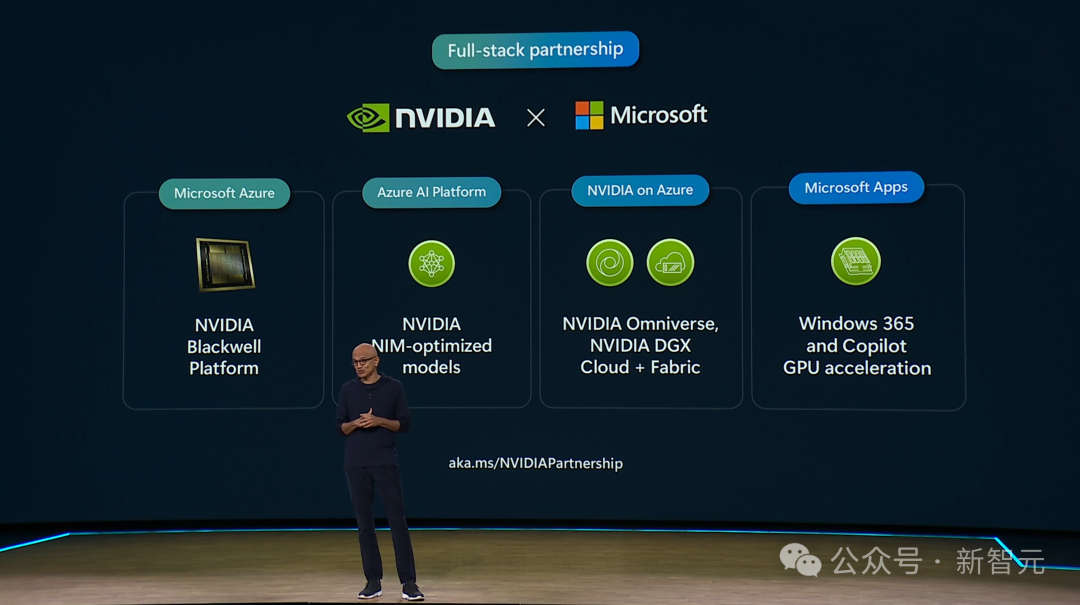

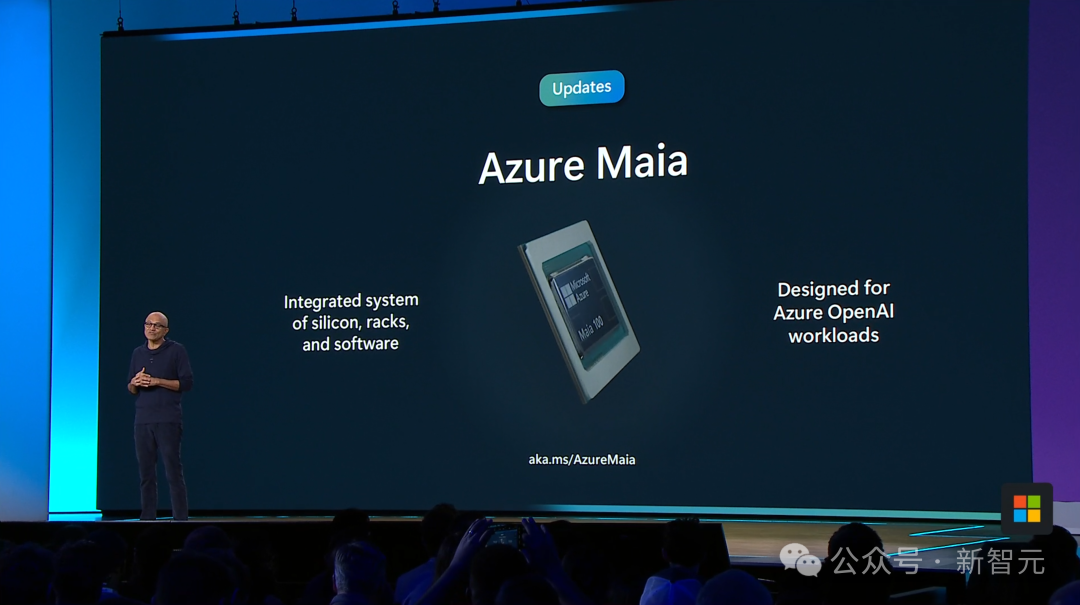

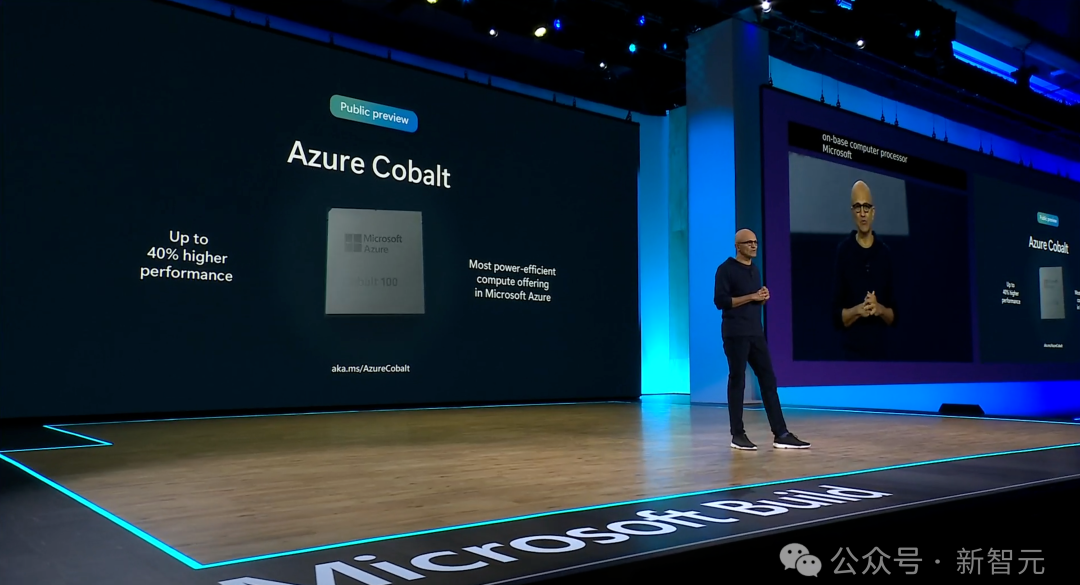

而这背后,是微软与英伟达、AMD的深度合作,以及自研芯片的大力推进。

英伟达关键平台产品,都会引入微软的云中。

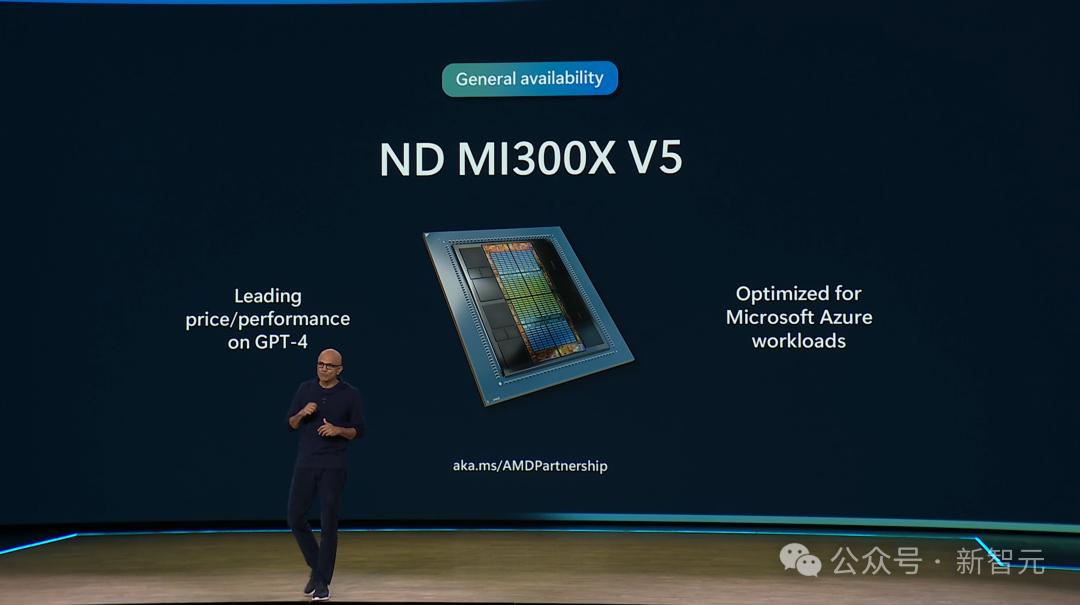

而说到和AMD的合作,微软是第一个提供最新ND MI300X v5虚拟机的云服务供应商。

无论对于AMD,还是对于微软,这都是一个意义重大的里程碑。

自研Azure Maia 100,只要你用过微软的服务,或多或少都会接触到。

而最新Azure Cobalt也开始进行公开预览了,目前已经为Microsoft Teams等服务提供了数十亿次对话的支持。

基础模型

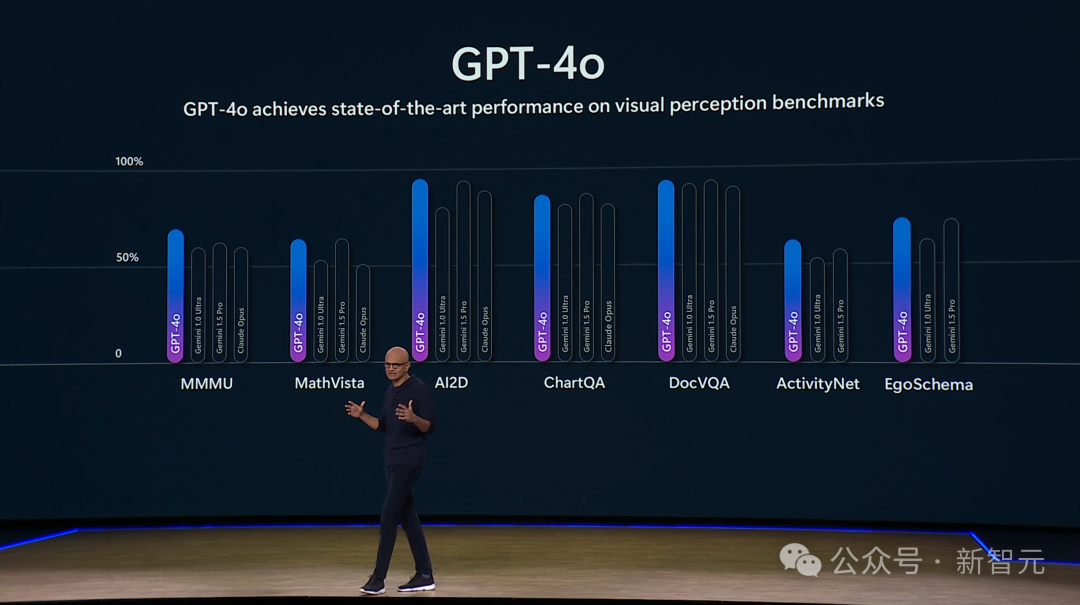

在基础模型方面,微软与OpenAI展开了深度合作,而现在GPT-4o可以在Azure上进行训练。

一张图,展示了GPT-4o依旧是最强的模型。

而在如此强大的模型的加持下,Copilot甚至已经「进化」到指导我们怎么玩游戏了!

举个例子,你想弄清如何在《我的世界》中制作一把剑,却毫无头绪。

Copilot会从头教你:为了造一把剑,你需要先收集材料。按E键,就能打开自己的材料库了。

Copilot发现,我们缺少制作剑刃的材料,为此,需要收集木材、石头、铁、金或者钻石。

忽然出现的小人,让玩家吓了一跳。

Copilot提示道:这是一场僵尸赛跑,我们需要尽快摆脱它们。要么快速建一座方块塔,或者快速找到一个避难场所,还可以挖到山的另一侧。

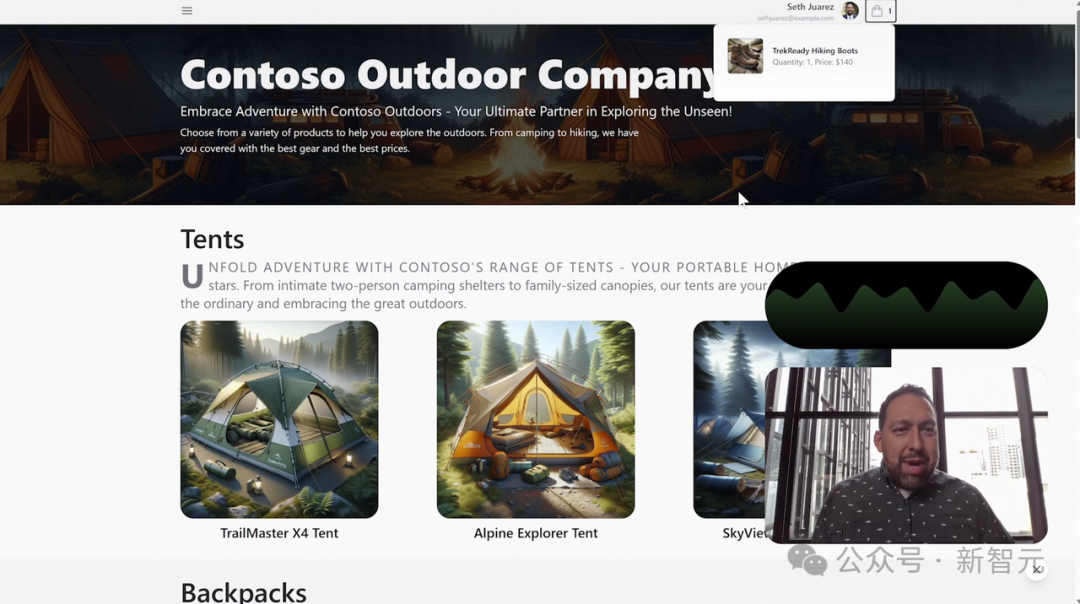

此外,微软首次介绍了十分强大的Agent能力。

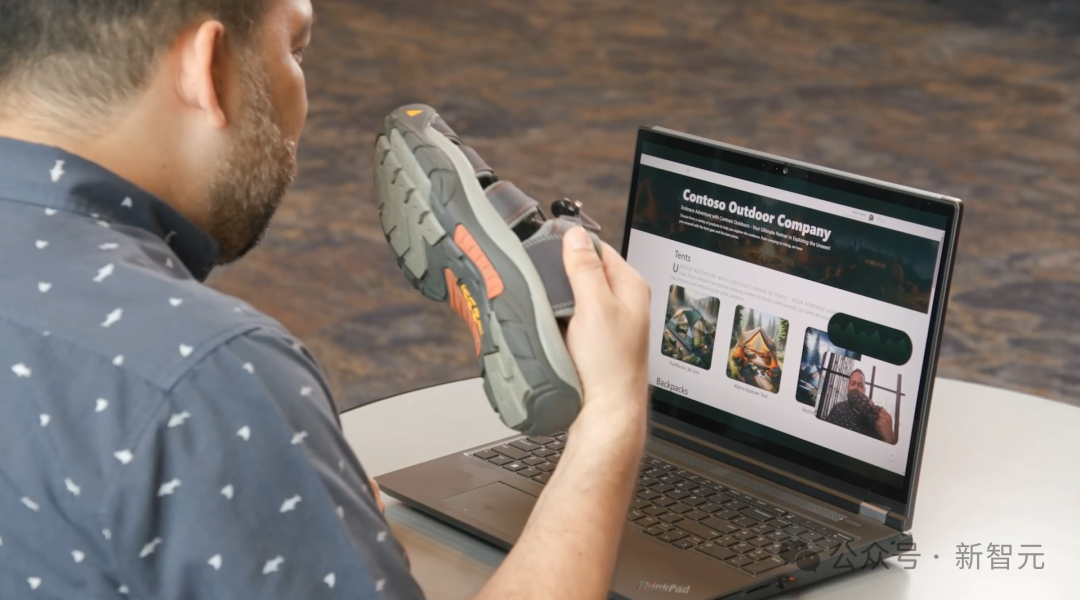

想露营但找不到合适的鞋怎么办?给它看一眼你的鞋,就能让它给你提意见了。

Agent分析道,这款非常适合夏季远足、让双脚保持凉爽,然而却不是这次的最佳选择。

既然如此,我们就让Agent直接挑一款最合适的。

Agent发现,这次最合适的产品是TrekReady Hawking,它为脚踝提供了支撑,还能在寒冷的山区为脚部提供保暖。然后,它还帮我们把这双鞋添加到购物车中。

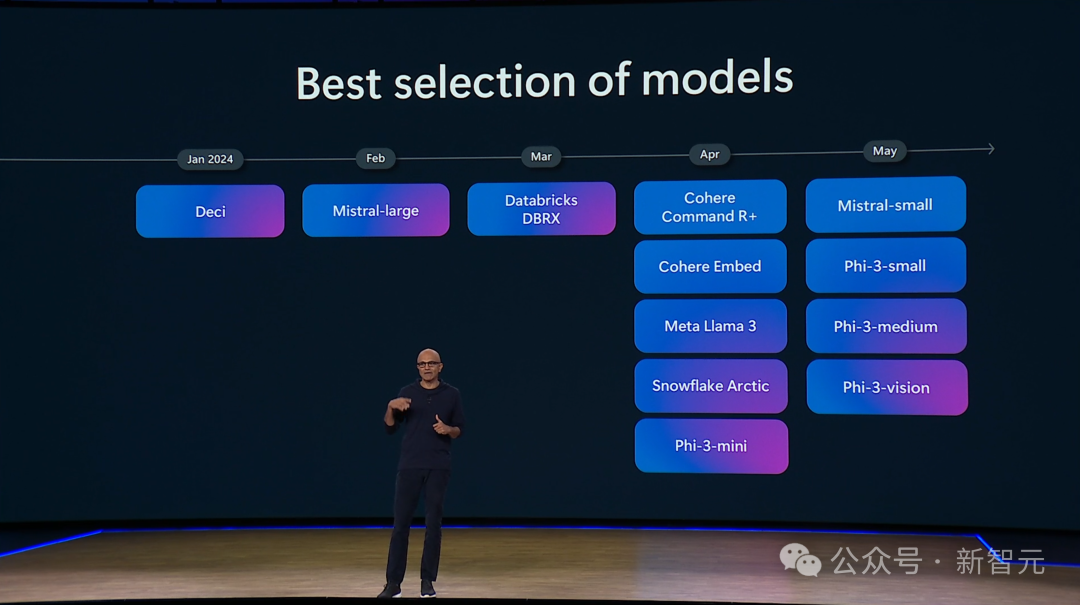

当然,除了OpenAI的模型之外,微软Azure平台还将提供多款可用的模型。

并且,微软依旧拥抱开源社区,与Hugging Face合作。

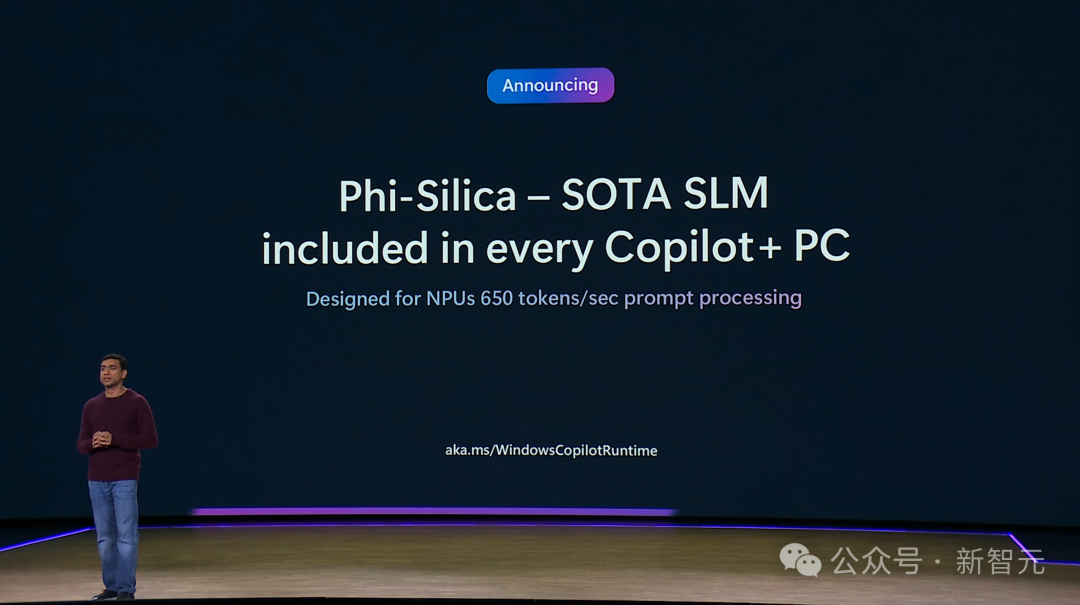

最强小语言模型:Phi-3

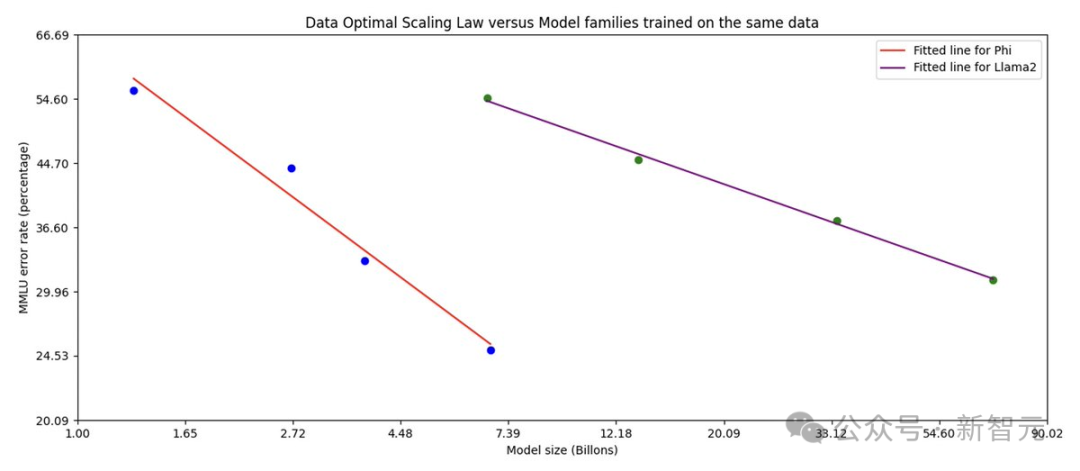

除了引入外部模型之外,微软一直以来都在押注小模型,并引领了一场SLM革命。

从去年6月Phi-1面世,到Phi-1.5、Phi-2,再到如今Phi-3,微软小模型已经完成四次迭代升级。

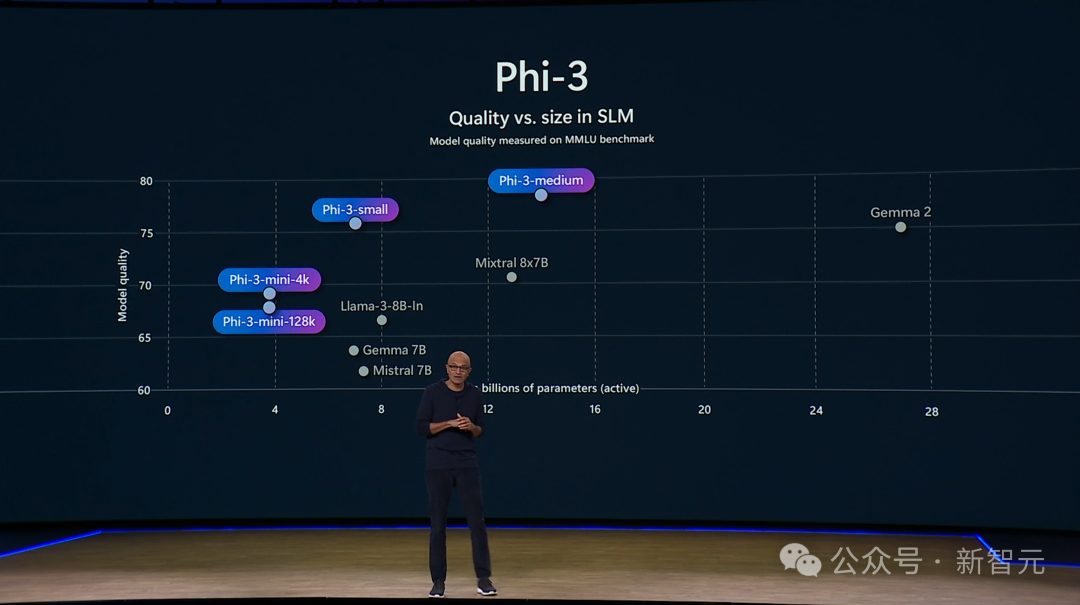

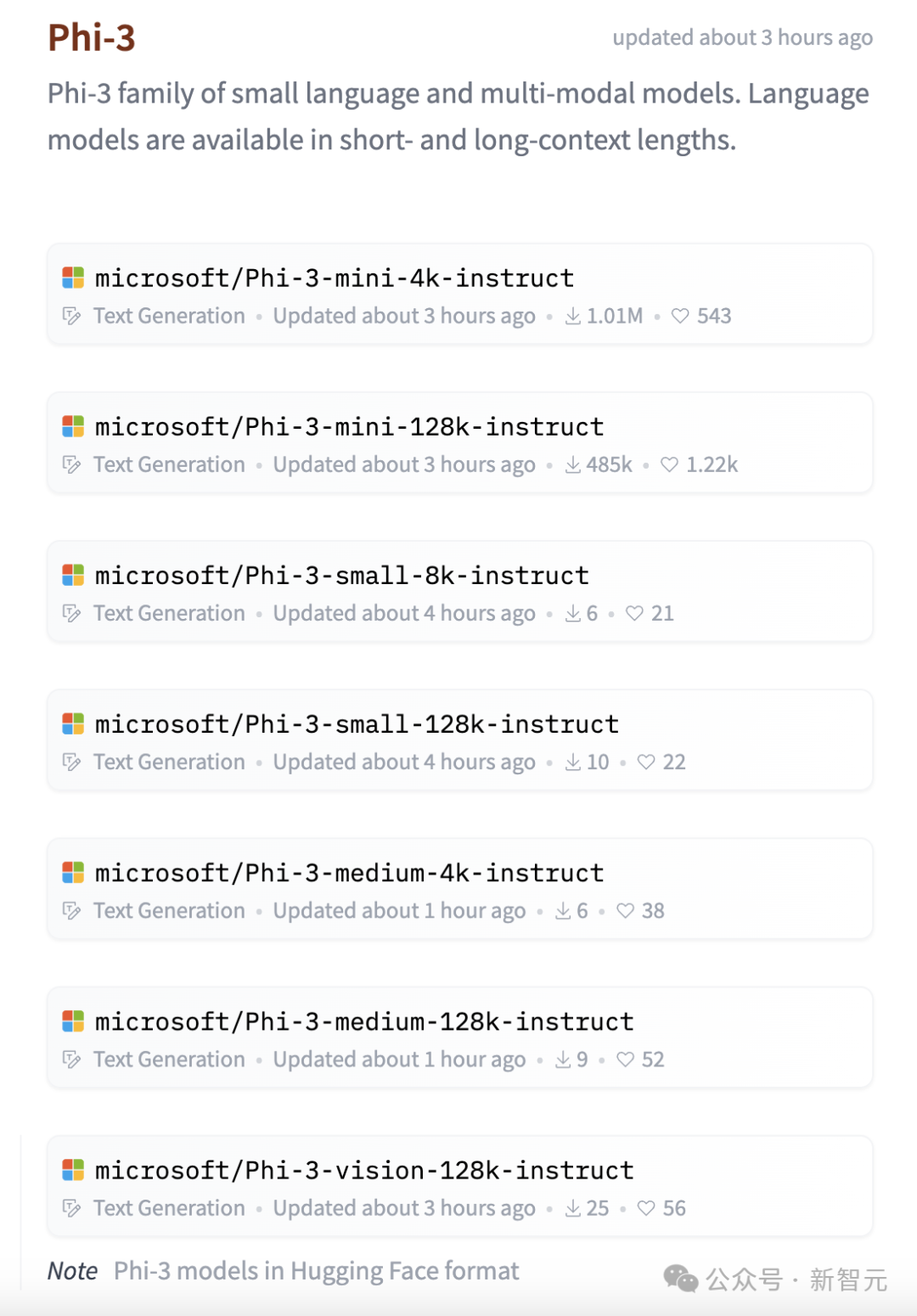

今天,Phi-3家族正式官宣新成员:

Phi-3-vision、Phi-3-small,Phi-3-medium。

其实,Phi-3-small,Phi-3-medium对于每个人来说,或许并不陌生了。

上个月,微软首次亮相Phi-3-mini,经过3.3万亿token训练仅有38亿参数,而且还可以部署在手机上,性能与Mixtral 8x7B和GPT-3.5相媲美。

论文地址:https://arxiv.org/pdf/2404.14219

另外,技术报告中,还首次展示了经过4.8T token训练的7B模型Phi-3-small,以及14B模型Phi-3-medium。

具体来说,Phi-3-small提供了8k和128k上下文,实力与Llama-3-8B-In、Gemma 7B,以及Mistral 7B相当。

而提供了4k和128k上下文的Phi-3-medium,性能可以超越Mistral 8x7B。

而现在,这些模型已经在Hugging Face上发布,开发者们可以下载权重并使用。

多模态Phi-3

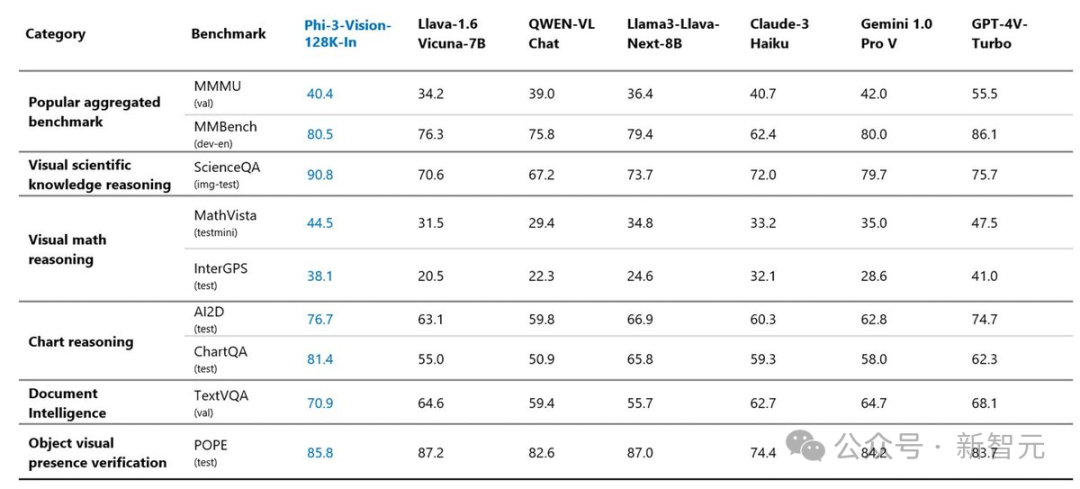

真正引人关注的是,Phi-3在今天正式推出了多模态模型Phi-3-vision,有42亿参数,128k上下文。

它可以完成一般的视觉推理任务,比如现场演示中,询问图表中的信息。

甚至,人们还可以使用Phi-3-vision进行OCR、表格理解、一般图像理解等。

值得一提的是,这款轻量模型仅用了一天半的时间,在512块H100上完成了训练。

它使用了500B视觉和文本token,其中「教科书数据集」一直以来是Phi系列模型的训练核心。

这次,Phi-3-vision的训练的图像数据来自,精选高质量图文搭配的内容,还有新创建的「教科书」式的综合数据。

其中包括,图表、表格、示意图、幻灯片等教授的数学、编码、常识推理等。

尽管参数量级非常小,在多模态基准测试中,Phi-3-vision的性能超越了Claude 3 haiku、LlaVa和Gemini 1.0 Pro。

甚至,各项性能非常接近GPT-4V。

一些开发者已经上手体验了,并称令人印象极为深刻。

还有一些开发者们也决定尝试一番。

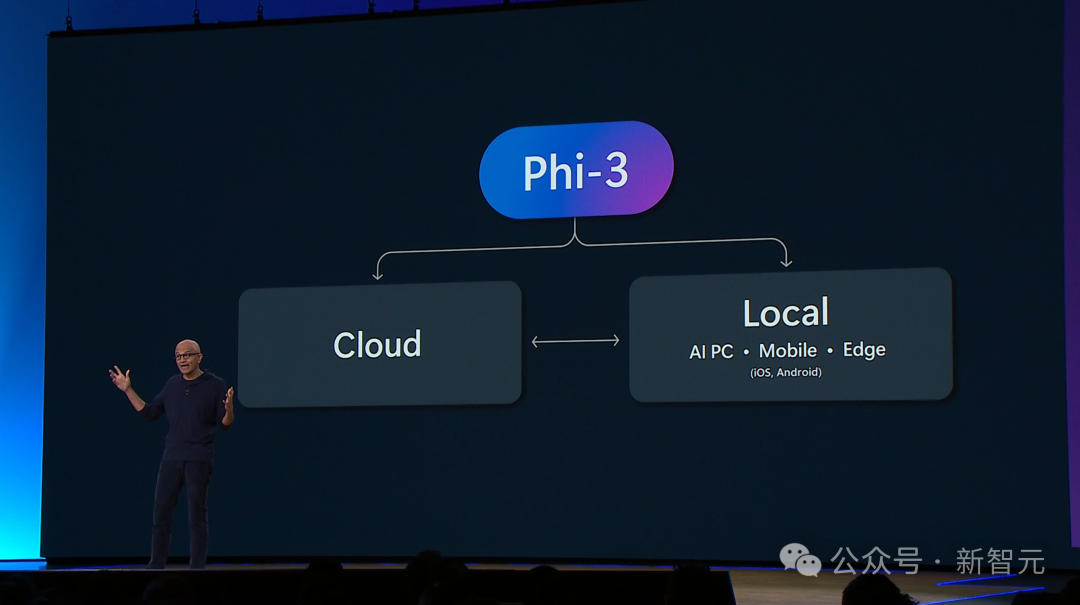

以上Phi-3模型,不仅可以在云端运行,甚至可以在本地运行。

SOTA小模型Phi-Silica

此外,纳德拉还在今天发布了Phi系列的SOTA模型——Phi-Silica。

微软称,这是一款专为Copilot+ PC设计的33亿参数模型,每秒可以处理650 token的,功率消耗约为1.5瓦。

这就意味着,Phi-Silica不会占用大量算力,并可以释放PC的CPU和GPU来处理其他计算。

另外,它的token生成会重用NPU的KV缓存,并在CPU上运行,大约每秒可输出27个token。

微软表示,「Phi-Silica的不同之处在于,它是Windows首个本地部署的语言模型」。

它针对Copilot+PC NPU进行了优化,可在本地设备上实现超快的推理响应速度。 这是Windows将先进的AI技术直接带给第三方开发者的一个里程碑时,为他们开发出色的Windows原生体验和第三方体验铺平了道路。

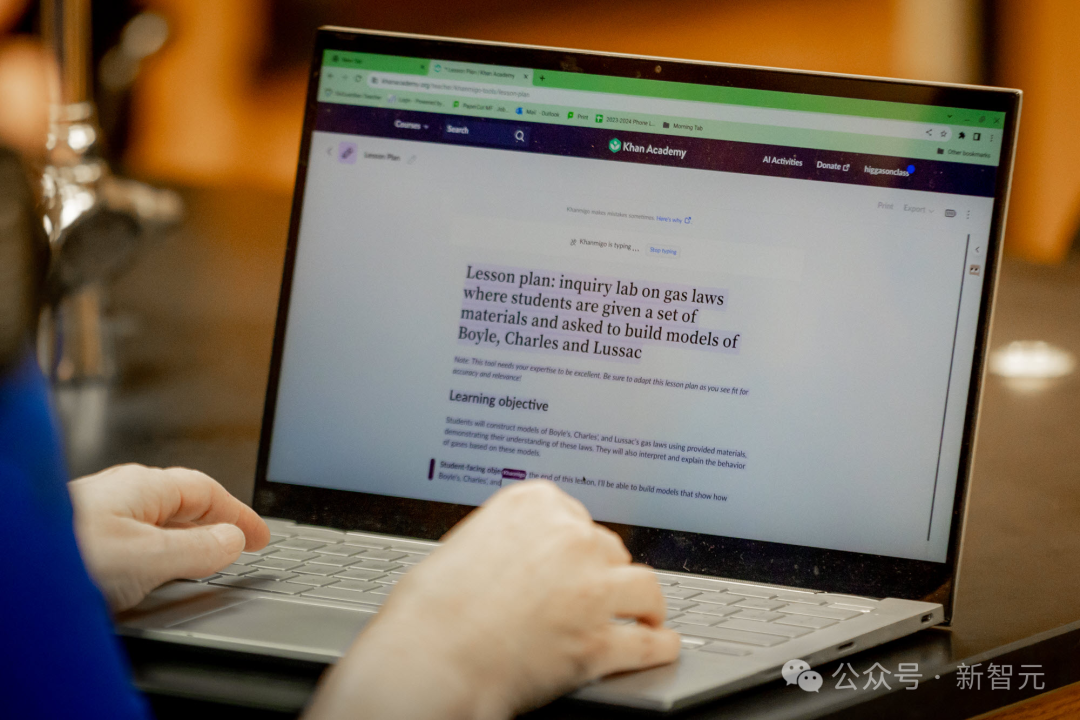

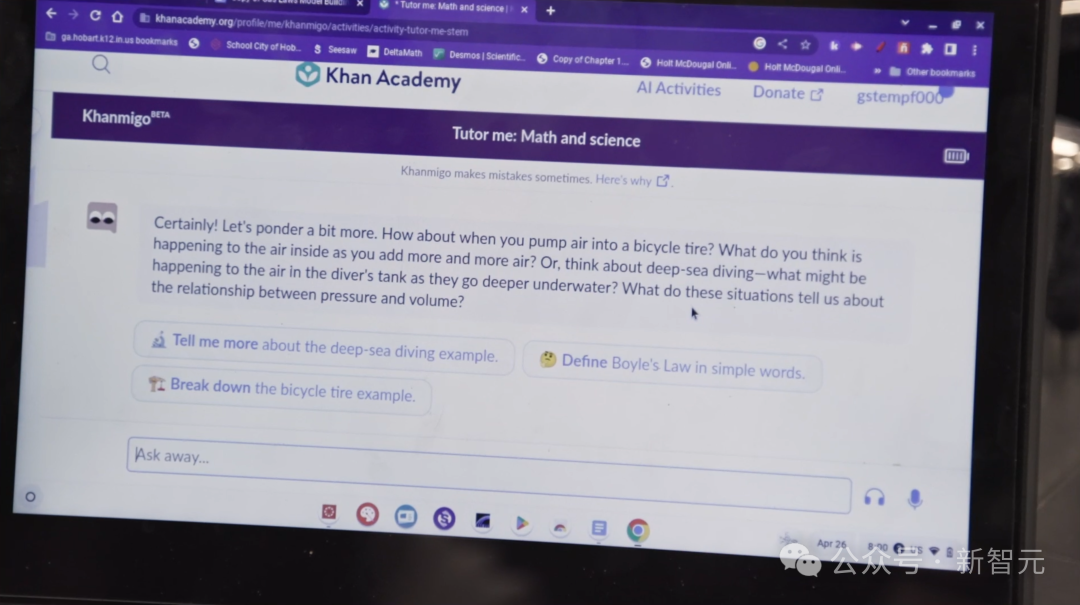

Phi-3模型最新的应用,便是微软还和可汗学院联合打造教育模型。

在模型的帮助下,学生们不仅得到了个性化的AI指导,老师们也感受到了自己的价值。

更重要的是,在Phi-3的加持下,能够免费提供给教育工作者的Khanmigo,必将极大地改变美国的教育界。

Windows

Copilot+ PC将重新定义任何一个人在PC所做的一切。

Pavan Davuluri展示了Copilot加持下的玩家,不用谷歌搜索,询问即可通过被卡住的关卡。

通过将Copilot集成到XBox中,可以大幅提升游戏体验。

此外,微软还与Quest联手,将Copilot带进VR世界,并为Quest带来可扩展到3D空间的Windows应用程序。

参考资料:

https://build.microsoft.com/en-US/home#live-stream