BDetCLIP | 对抗预训练CLIP中的后门,增强多模态模型对抗后门攻击的可靠性和安全性

BDetCLIP | 对抗预训练CLIP中的后门,增强多模态模型对抗后门攻击的可靠性和安全性

集智书童公众号

发布于 2024-05-31 14:20:39

发布于 2024-05-31 14:20:39

多模态对比学习方法(例如CLIP)因其能够为视觉和文本模态联合表示学习而展现出令人印象深刻的零样本分类性能。然而,近期研究显示,在含有小比例恶意后门数据的污染预训练数据上进行多模态对比学习,可以诱导出可能被下游任务中插入触发器以高成功率攻击的后门CLIP。 为了防御对CLIP的后门攻击,现有的防御方法关注于预训练阶段或微调阶段,不幸的是,这会导致由于大量参数更新而带来高昂的计算成本。 在本文中,作者首次尝试提出一种计算效率高的后门检测方法,以在推理阶段防御后门CLIP。 作者通过实验发现,后门图像的视觉表示对类描述文本中的良性变化和恶性变化均不敏感。 基于这一观察,作者提出了BDetCLIP,一种基于对比提示的新型测试时后门检测方法。具体而言,作者首先通过特别设计的指令提示语言模型(例如GPT-4[1])生成与类相关的描述文本(良性)和类扰动的随机文本(恶性)。 然后,图像与这两种类型类描述文本之间余弦相似度的分布差异可以作为检测后门样本的标准。大量实验验证了作者的BDetCLIP在有效性和效率方面均优于现有最先进的后门检测方法。

1 Introduction

多模态对比学习方法(如CLIP [39])在各类下游任务中展现出了令人印象深刻的零样本分类性能,由于它们能有效对不同模态的表示进行对齐,因此在开放词汇目标检测[51]、文本到图像生成[51]和视频理解[53]等多个视觉语言领域中作为基础模型。然而,近期的研究发现,预训练数据中一小部分被毒化的后门样本,可以在多模态对比预训练过程后导致CLIP被后门攻击[5; 4; 2]。

在推理阶段,被后门的CLIP会对带有触发器的图像产生被篡改的图像表示,这些表示在零样本分类中接近目标攻击类的文本表示。这在CLIP在现实世界应用中的部署暴露了严重威胁。

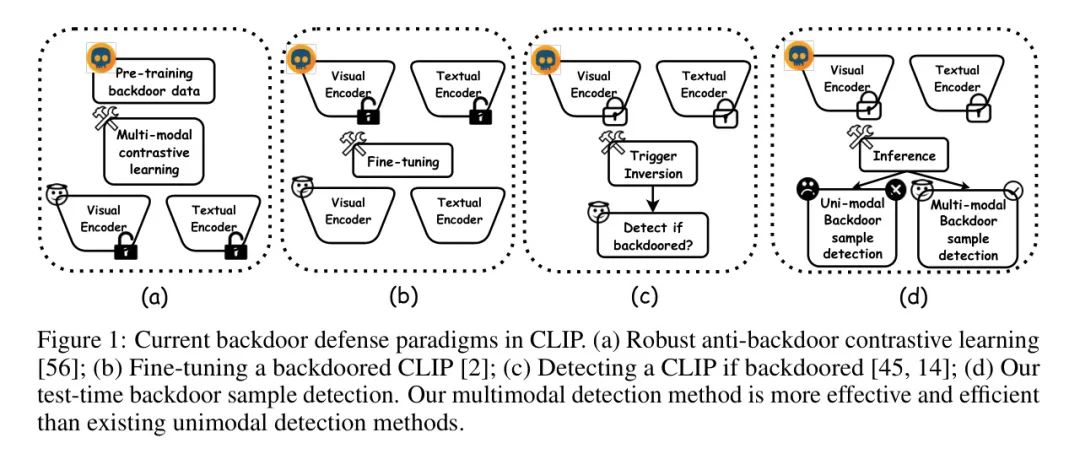

为了克服这个问题,最近提出了有效的防御方法,这些方法可以分为三种防御范式,如图1所示:

- 在预训练阶段的健壮反后门对比学习;

- 在微调阶段对抗预训练CLIP中的后门;

- 利用触发器反转技术判断预训练的CLIP是否被后门攻击;

总的来说,这些防御方法由于需要额外的学习或优化过程,计算成本很高。

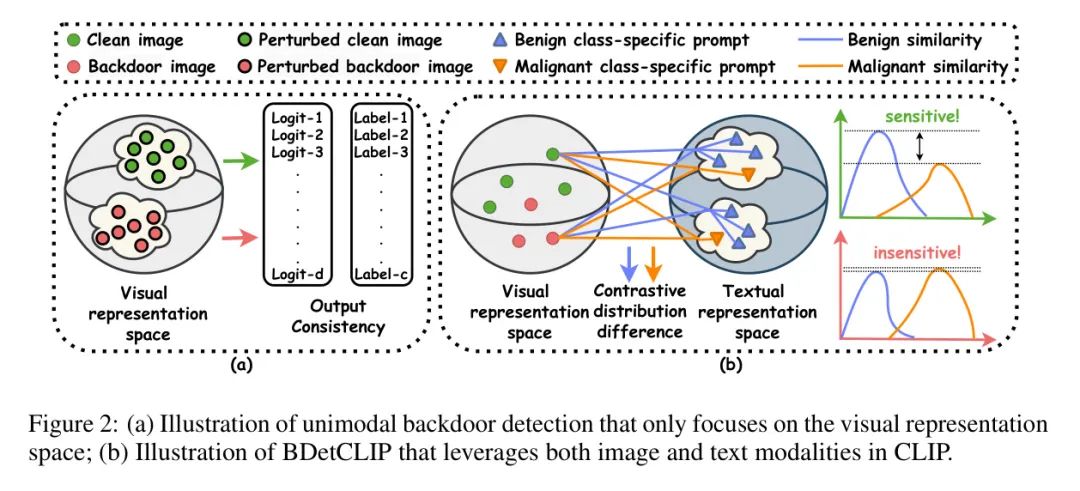

相比之下,作者提倡在推理阶段的测试时后门样本检测(图1(d)),这是一种针对被后门的CLIP的计算效率更高的防御方法,因为在推理阶段没有参数更新。直观上,可以尝试直接将现有的单模态测试时检测方法适用于CLIP中的后门图像检测,因为它们通常基于通过特定的图像修改(例如,损坏[30],放大[20],混合[16])在视觉表示空间中的输出一致性来区分后门和干净图像。然而,这些单模态检测方法的性能是次优的,因为它们没有利用CLIP中的文本模态来辅助后门样本检测。因此,作者可以预期,如果同时利用图像和文本模态,可以获得更好的性能。

在本文中,作者首次尝试在推理阶段提出一种计算效率高的后门检测方法,以防御被后门的CLIP。作者实证发现,被后门图像的视觉表示对类别描述文本的良性变化和恶性变化都表现出不敏感。受到这一观察的启发,作者提出了BDetCLIP,一种基于对比提示的新型测试时多模态后门检测方法。具体来说,作者首先通过专门设计的指令提示GPT-4模型[1]生成与类别相关的(或类别扰动的随机)描述文本,并将其作为良性(恶性)类别提示。然后,作者计算图像与这两种类型类别提示之间的余弦相似性分布差异,这可以作为检测后门样本的一个良好标准。作者可以看到,被后门图像在良性与恶性类别提示变化之间的分布差异小于干净图像。被后门图像不敏感的潜在原因是它们的视觉表示与类别描述文本对齐的语义信息较少。通过这种方式,作者可以在CLIP的推理阶段有效地检测后门图像。广泛的实验验证了作者的BDetCLIP在有效性和效率方面都优于现有的后门检测方法。

作者的主要贡献可以总结如下:

- 针对CLIP的新后门检测范式。作者开创了针对CLIP的测试时后门检测,其计算效率高于现有的防御范式。

- 一种新型的后门检测方法。作者提出了一种基于对比提示的新型测试时多模态后门检测方法,该方法基于图像关于良性与恶性类别提示变化的分布差异来检测后门样本。

- 强大的实验结果。与现有的检测方法相比,作者提出的方法在各种类型的被后门的CLIP上取得了优越的实验结果。

2 Background & Preliminaries

Multimodal Contrastive Learning

多模态对比学习已成为一种强大的方法,用于从多种数据模态(如文本和图像)中学习共享表示。具体而言,本文作者关注的是对比语言图像预训练(CLIP)[39]。具体来说,CLIP包括一个视觉编码器,用表示(例如,ResNet[21]和ViT[11])和一个文本编码器,用表示(例如,Transformer[49])。

CLIP中使用的训练样本是从互联网上收集的大量图像-文本对,表示为,其中是图像的标题,。在训练阶段,给定一个批次图像-文本对,匹配(不匹配)对的余弦相似度表示为()。值得注意的是,图像和文本嵌入使用范数进行归一化,以具有单位范数。基于这些符号,CLIP损失可以通过以下方式形式化[39]:

CLIP的损失函数

其中 是一个可训练的温度参数。

CLIP在零样本分类中的应用。为了在下游的零样本图像分类数据集 上利用CLIP,其中 ,一种简单而有效的方法是使用一个类模板函数 ,它生成一个特定于类的文本,如 "一张[CLS]的照片",其中[CLS]可以被替换为数据集上的第 个类别名称。在推理阶段,可以直接计算图像 对于第 个类别的后验概率,如下所示:

通过这种方式,CLIP可以取得令人印象深刻的零样本性能,即使与通过(自)监督学习方法训练的单模态视觉模型相比也是如此。

此外,由于CLIP仅在方程(1)中考虑了图像和文本之间简单和粗略的对应关系,许多后续研究专注于更细粒度和一致的对应策略,如SLIP [34],Uniclip [25],Cyclip [18],PROMU [22]和RA-CLIP [52]。另一方面,在零样本图像分类中使用方程(2)中由生成的简单类别提示可能无法充分利用CLIP在文本模态上的强大表示学习能力。这意味着更详细描述的类别特定提示可能对图像分类更有利。

为此,最近的研究深入探讨了工程细粒度的类别特定属性,或提示大型语言模型(例如,GPT-4 [1])生成可区分的属性相关文本。

Backdoor Attacks and Defenses

后门攻击是对机器学习系统的一个严重安全威胁。整个后门攻击过程可以阐述如下:

在机器学习系统的数据收集阶段,一个恶意的对手可能会在训练数据集中植入带有不可察觉触发器的后门样本。在模型训练阶段之后,隐藏的触发器可能会被植入到受害者模型中,而对受害者模型的表现影响甚微。

在推理阶段,对手可以通过在干净输入中添加触发器来操纵受害者模型,产生特定的输出。

早期关于后门攻击的研究主要集中在设计满足实际场景的多种触发器,这些场景主要涉及图像和文本分类任务,包括不可见的隐蔽触发器[7; 47; 28; 10; 35; 17; 44]和物理触发器[7; 50]。为了防御这些攻击,提出了许多后门防御方法,主要可以分为四类:预处理阶段的数据清洗[46],健壮的反后门训练[6; 60],后训练阶段的缓解、检测和反转[33],以及推理阶段的测试时检测[43]。

此外,最近的研究还调查了其他学习范式以及其他视觉或语言任务(包括目标跟踪[23],通过扩散模型生成文本到图像[9],以及通过大型语言模型生成文本[55])的后门攻击。

针对CLIP的后门攻击。本文特别关注多模态对比学习中的后门安全问题。最近的研究揭示了CLIP严重的后门漏洞。具体来说,一个恶意的对手可以制造一定比例的后门图像-文本对 ,其中 是带有触发模式 [19; 7]和 Mask 的后门图像,而是目标攻击类的标题。然后,原始的预训练数据集可能会被毒化为。针对CLIP的后门攻击可以形式化为:

其中是被感染的视觉编码器的参数,是文本编码器的参数。值得注意的是,在等式(2)中,后门CLIP的零样本性能预计不会受到影响,而对于带有触发器的图像,图像属于第个目标类的后验概率可能会以高概率很大:

针对后门CLIP的防御。最近提出了有效的防御方法,可以分为三种防御范式:包括等式(3)中的反后门学习[56],对后门CLIP进行微调[2],以及使用触发器反转技术[45; 14]来检测CLIP的视觉编码器是否被感染。然而,这些防御方法由于需要额外的学习或优化过程,计算成本很高。

3 The Proposed Approach

在本节中,作者首次尝试对CLIP进行测试时后门检测,并提出BDetCLIP,它有效地基于文本模态检测测试时的后门图像。

A Defense Paradigm: Test-Time Backdoor Sample Detection

与在预训练或微调阶段使用的现有防御方法相比,直接在推理阶段检测(并拒绝)后门图像是一种更轻量级、更直接的防御后门CLIP的解决方案。为此,人们可以直接调整仅基于CLIP的视觉编码器(即 )的现有单模态检测方法[16; 59; 48; 20; 30; 37; 29],并进行适当的修改。然而,这种策略是次优的,因为它没有利用CLIP中的文本编码器来辅助检测(如图2(a)所示)。相比之下,作者提出在CLIP中整合视觉和文本编码器,用于测试时后门样本检测(TT-BSD)。对于CLIP的TT-BSD的目标是设计一个好的检测器:

其中 是一个指示函数, 返回1或0,表示检测器将 视为后门图像或干净图像。

防御者的目标。防御者旨在从有效性和效率两个方面设计一个好的检测器 。有效性直接与 的性能相关,可以通过准确度、召回率和精确度等多个指标进行评估。效率表示检测所花费的时间,这在实际应用中期望是短暂的。

防御者的能力。在本文中,作者考虑的是黑盒设置。具体来说,防御者只能访问CLIP的编码器接口,并获得图像和文本的特征嵌入,完全缺乏关于CLIP架构和后门攻击的任何先验信息。这是TT-BSD[20]中现实且具有挑战性的设置。

Our Proposed BDetCLIP

已经表明,CLIP通过利用大型语言模型生成的视觉描述文本,实现了令人印象深刻的零样本分类性能。对于被后门攻击污染的CLIP(即后门CLIP),最近的研究[2]揭示了CLIP中植入的视觉触发器与目标类别之间的强烈共存关系。然而,CLIP中的这类视觉触发器通常是非语义的简单像素模式,它们无法很好地与丰富的文本概念对齐。因此,带有视觉触发器的后门图像无法适当地捕捉类别描述文本的语义变化。这激励作者考虑当类别描述文本存在显著变化时,后门图像的视觉表示与类别描述文本之间的对齐是否会显著改变。有趣的是,作者通过经验发现,即使给定了文本描述文本的显著变化,后门样本的对齐也不会显著改变。这一观察可以帮助作者从干净样本中区分出后门样本,因为干净样本的对齐会受到文本描述文本变化的影响。

基于上述动机,作者提出了BDetCLIP,一种基于对比提示的新型测试时后门检测方法。

具体来说,作者提示GPT-4[1]生成两种对比性类别描述文本。首先,基于GPT-4强大的上下文学习能力,作者使用特别设计的指令,并附上附录A中的“示范”。特别是,对于“金鱼”这一类别的示范,与各种物体属性相关联,例如形状、颜色、结构和行为。这样,作者期望GPT-4输出多个基于细粒度属性的句子,分配给第类,表示为,其中是句子的数量。另一方面,作者还通过指令“请随机生成不超过10个单词且与{类名}无关的句子”提示GPT-4,以生成一个与指定的第类无关的随机句子。作者将类别模板提示与获得的随机句子连接起来,生成最终的类别扰动提示,表示为,例如“A photo of a goldfish. The bright sun cast shadows on the bustling city street.”(一张金鱼的照片。明亮的阳光在繁忙的城市街道上投下阴影)。

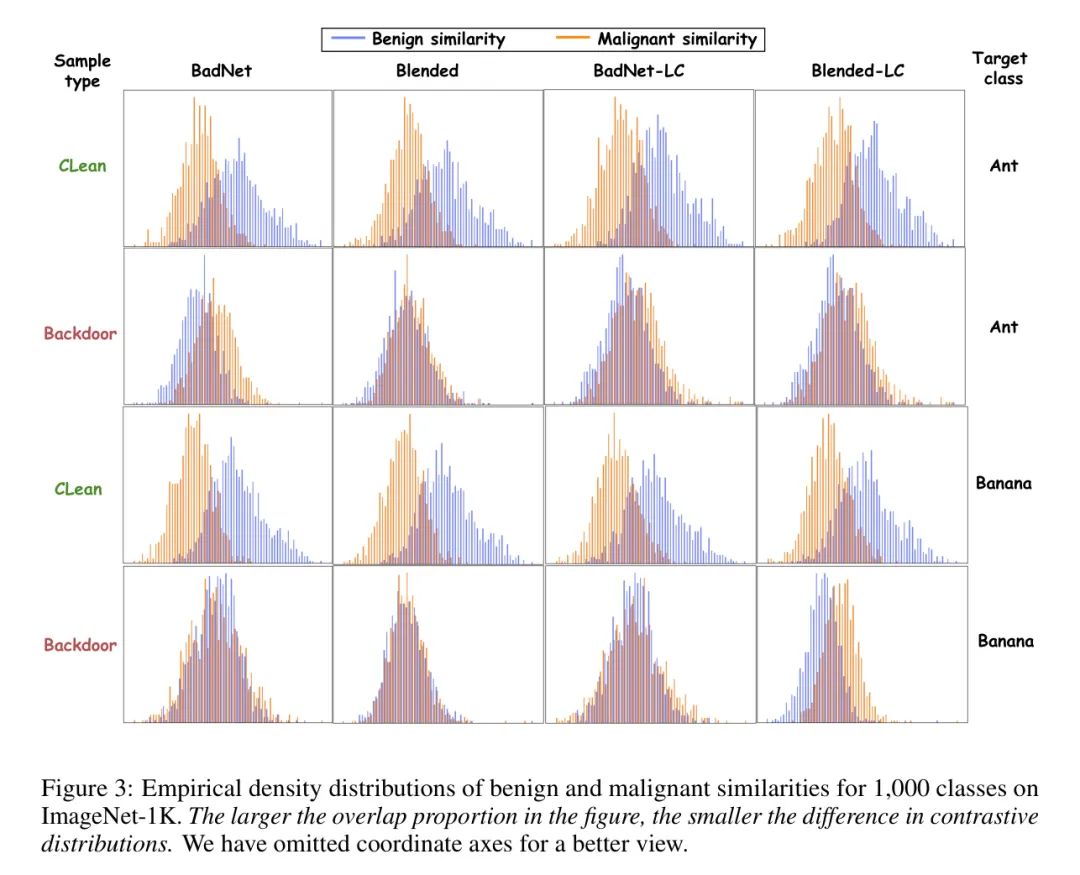

对比分布差异。基于GPT-4生成的两种文本,作者可以计算测试时图像与良性(恶性)类别特定提示之间的良性(恶性)相似度。特别是,由于作者没有关于每个测试时图像标签的先验信息,作者考虑对标签空间中的所有类别进行这种计算。通过这种方式,作者可以通过累积每类良性与恶性的对比差异,获得所有类别的整体分布差异。正式地,对于每个类别 ,每个测试时图像 的良性相似度和恶性相似度分别表示为 和 。值得注意的是,作者考虑了所有 个类别相关描述文本的平均文本嵌入。然后,测试图像 的对比分布差异可以形式化为:

这个统计量揭示了每个测试时图像对类别特定提示良性与恶性变化的敏感性。作者在图3中展示了在ImageNet-1K上良性与恶性相似度的经验密度分布。在作者的考虑中,一个测试时被植入后门的图像 对类别特定提示的语义变化不敏感,从而导致 的值相对较小。因此,作者提出了以下TT-BSD的检测器:

4 Experiments

在本节中,作者介绍了实验设置,并提供了实验结果、进一步分析以及消融研究。

Experimental setup

在实验中,作者评估了BDetCLIP在各种下游分类数据集上的表现,包括ImageNet-1K [40],Food-101 [3]和Caltech-101 [13]。特别是,作者在细粒度图像分类数据集Food-101和Caltech-101上首次进行了针对CLIP的后门攻击和防御,这些任务更具挑战性。此外,作者从CC3M [42]中选择了目标后门样本,这是一个流行的多模态预训练数据集,包括大约300万图像-文本对。在推理阶段,作者认为的测试时间样本是后门的,这是一个更实际的设置。数据集的详细信息显示在附录D中。

攻击CLIP。按照CleanCLIP [2],作者在实验中采用了BadNet [19],Blended [7]和Label-consistent [47]作为作者的攻击方法。特别是,作者使用BadNet和Blended的触发器来实现标记一致的攻击,分别表示为BadNet-LC和Blended-LC。对于针对CLIP的后门攻击,作者考虑从被毒化的CC3M数据集开始从头预训练CLIP,或者通过一部分被毒化的对精调预训练的干净CLIP。攻击细节显示在附录D中。对于目标攻击类别,作者从ImageNet-1K中选择了三种类型的类别,包括“香蕉”,“蚂蚁”和“篮球”,从Food-101中选择了一个细粒度类别“果仁蜜饼”,从Caltech-101中选择了一个细粒度类别“达尔马提犬”。

比较方法。据作者所知,目前尚无针对多模态模型的后门样本检测方法。因此,作者将作者提出的方法与在传统分类模型中使用的三种常见触发样本检测方法进行了比较,分别是STRIP[16],SCALE-UP[20]和TeCo[30]。实施细节在附录D中提供。

评估指标。遵循对后门样本检测的传统研究,作者通过使用接收者操作特征曲线下的面积(AUROC)[12]来评估防御效果。此外,作者还采用推理时间作为评估检测方法效率的指标。通常,AUROC的值越高,表示检测方法越有效;推理时间越短,表示检测方法越高效。

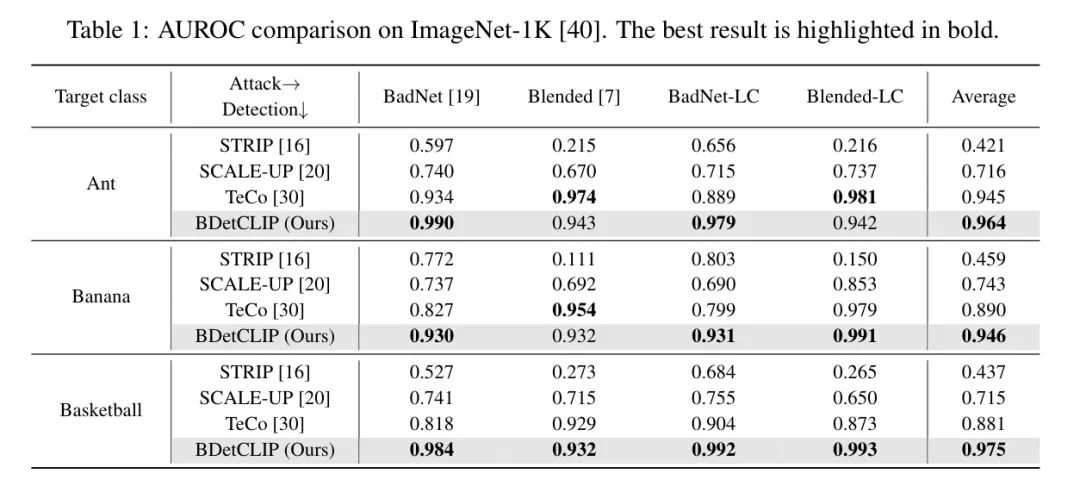

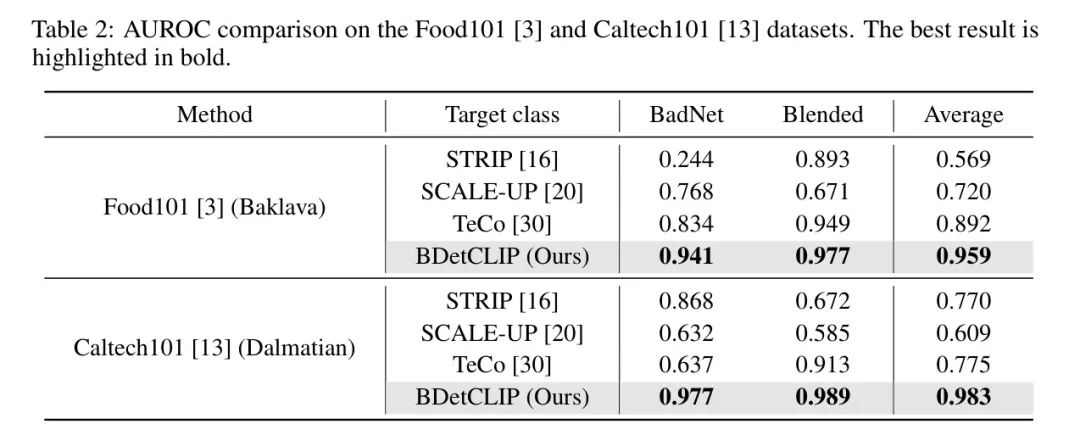

总体比较。如表1和表2所示,作者可以看到BDetCLIP几乎在所有攻击设置和目标类别中一致优于比较方法。具体来说,BDetCLIP在所有设置中的平均AUROC [12]超过0.946,这验证了其效果上的优势。相反,单模态检测方法通常表现不佳。例如,STRIP经常在AUROC小于0.55的11个19个案例中表现不合格。尽管SCALE-UP [20]比STRIP取得了相对较好的性能,但其实际应用中的表现也不令人满意。特别是,TeCo [30]在特定情况下与BDetCLIP取得了相当的性能。然而,其在细粒度数据集上的性能不稳定且更差。总的来说,这些单模态检测方法在CLIP的测试时后门检测中是无效的,而BDetCLIP在效果上优于它们。至于效率,BDetCLIP在推理时间上也取得了最佳性能。

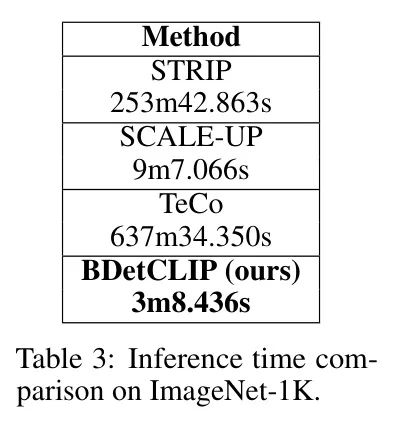

如表3所示,TeCo [30]是最慢的检测方法,其速度甚至比BDetCLIP慢160倍以上。这是因为TeCo在图像上使用了许多耗时的破坏性操作符,这对于CLIP来说过于繁重。这种操作也用于单模态方法STRIP和SCALE-UP。相比之下,BDetCLIP仅在文本模态的语义变化中进行两次后门检测,即良性类和恶性类特定的提示。因此,BDetCLIP在实际应用中可以快速进行测试时后门检测。总之,与现有的单模态方法相比,BDetCLIP在效果和效率方面都取得了卓越的性能。

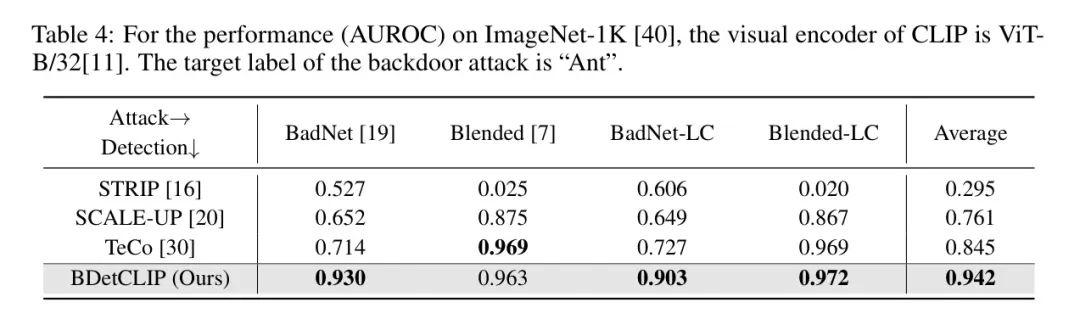

使用ViT-B/32进行CLIP的后门检测。作者还评估了将ViT-B/32 [11]作为后门CLIP的视觉编码器的情况。

如表4所示,作者提出的BDetCLIP在所有类型的后门攻击中也取得了卓越的性能。具体来说,与其他方法相比,表1中的性能显著下降,而BDetCLIP也保持了高水平的AUROC(例如,平均AUROC为0.942)。这一观察结果验证了BDetCLIP在不同CLIP视觉模型架构中的通用性。

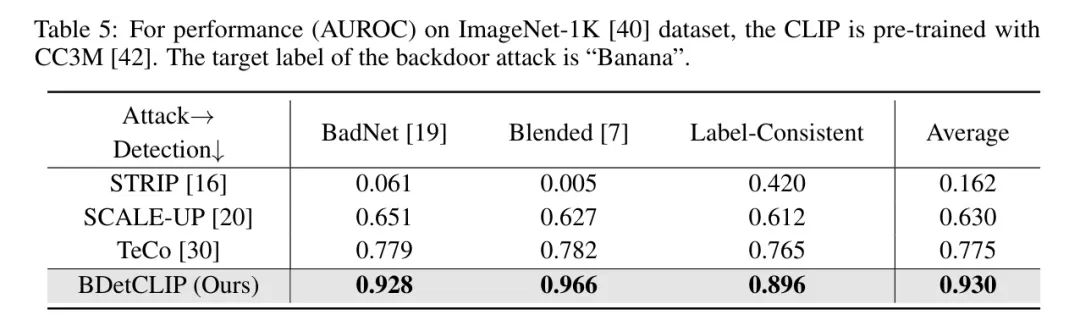

针对在CC3M数据集上预训练的带有后门的CLIP的后门检测。遵循CleanCLIP [2]的方法,作者也考虑了从零开始在有毒的CC3M数据集上预训练CLIP。正如表5所示,与表1的结果相比,STRIP在几乎所有情况下都未能实现检测,SCALE-UP和TeCo的表现变差,而BDetCLIP在所有攻击设置中也展现了卓越的性能。这一观察结果确实验证了BDetCLIP在不同CLIP模型能力中的通用性。

Further Analysis of Class-specific Prompts

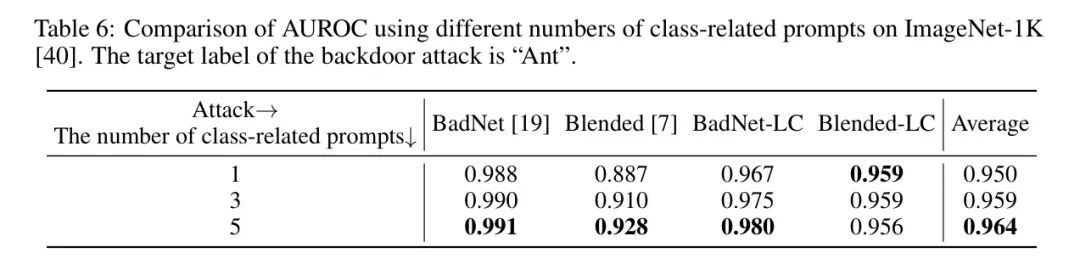

类相关提示数量对性能的影响。如表6所示,作者可以看到,增加类相关提示的数量可以在各种后门攻击下提高检测性能。这是因为更多样化的细粒度描述文本扩大了对立分布的差异,这对于BDetCLIP区分被后门和干净图像更有利。因此,在BDetCLIP中利用更多样化的描述文本至关重要。类扰动提示的文本长度对性能的影响。

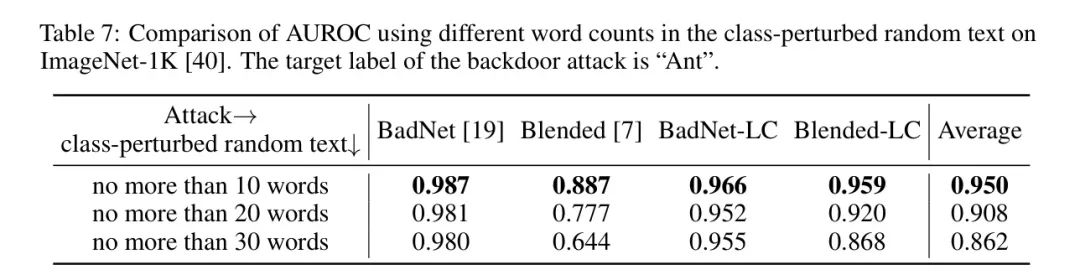

如表7所示,随着类扰动提示中单词数量的增加,性能急剧下降。这是因为类扰动提示中生成的更多随机文本会极大地破坏类扰动提示的语义,从而增加被后门图像的对立分布差异(接近干净图像的分布)。这将显著降低检测性能。此外,对于Blended和Blended-LC攻击,性能对类扰动提示的文本长度表现出高度敏感性。

Ablation Studies

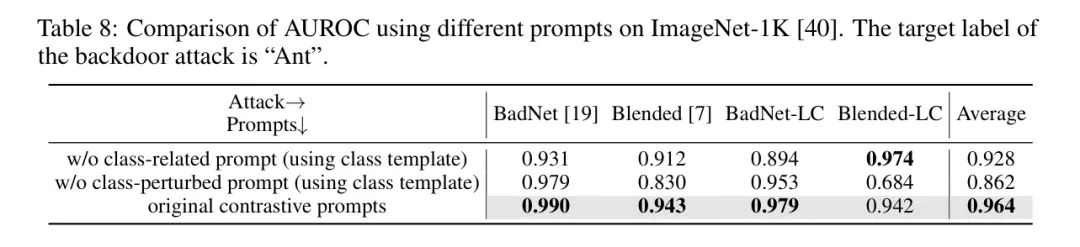

如表8所示,如果不使用两种类特定提示,检测性能都会下降。这一观察结果证明了在BDetCLIP中实现语义变化时使用这两种提示的重要性。特别是,在不使用类扭曲提示的情况下,性能有显著下降。这是因为在这种情况下,干净图像的对比分布差异会较小(接近被植入后门图像的分布)。因此,检测性能显著下降。

其他实验。在附录E中,作者提供了在使用类相关提示、类扭曲提示和提示模板的情况下,CLIP在遭受后门攻击时的零样本性能细节,以及使用这些提示对CLIP攻击成功率的影响。作者还提供了不同后门比例对检测方法有效性影响的数据,见附录E。

5 Conclusion

在本文中,作者首次尝试提出一种计算效率高的后门检测方法,以在推理阶段防御后门CLIP。作者通过实证观察到,后门图像的视觉表示对类别描述文本的重大变化不敏感。基于这一观察,作者提出了一种基于对比提示的新颖测试时后门检测方法,称为BDetCLIP。对于作者提出的BDetCLIP,作者首先通过特别设计的指令提示语言模型(例如,GPT-4)生成类相关的描述文本(良性)和类扰动随机文本(恶性)。然后,作者计算图像与这两种类别描述文本之间的余弦相似度分布差异,并利用这种分布差异作为检测后门样本的标准。综合实验结果验证了作者的BDetCLIP比现有最先进的后门检测方法更有效、更高效。

附录A 提示设计

已经证明,像GPT-4这样的生成性预训练大型语言模型在生成视觉描述以辅助CLIP进行分类任务方面是有效的,原因如下:

(1) 这些模型在包含大量人类知识的网页规模文本数据上进行训练,因此无需特定领域的标注。

(2) 它们可以轻松地被操纵以产生任何形式或结构的信息,使得它们相对简单地与CLIP提示集成。

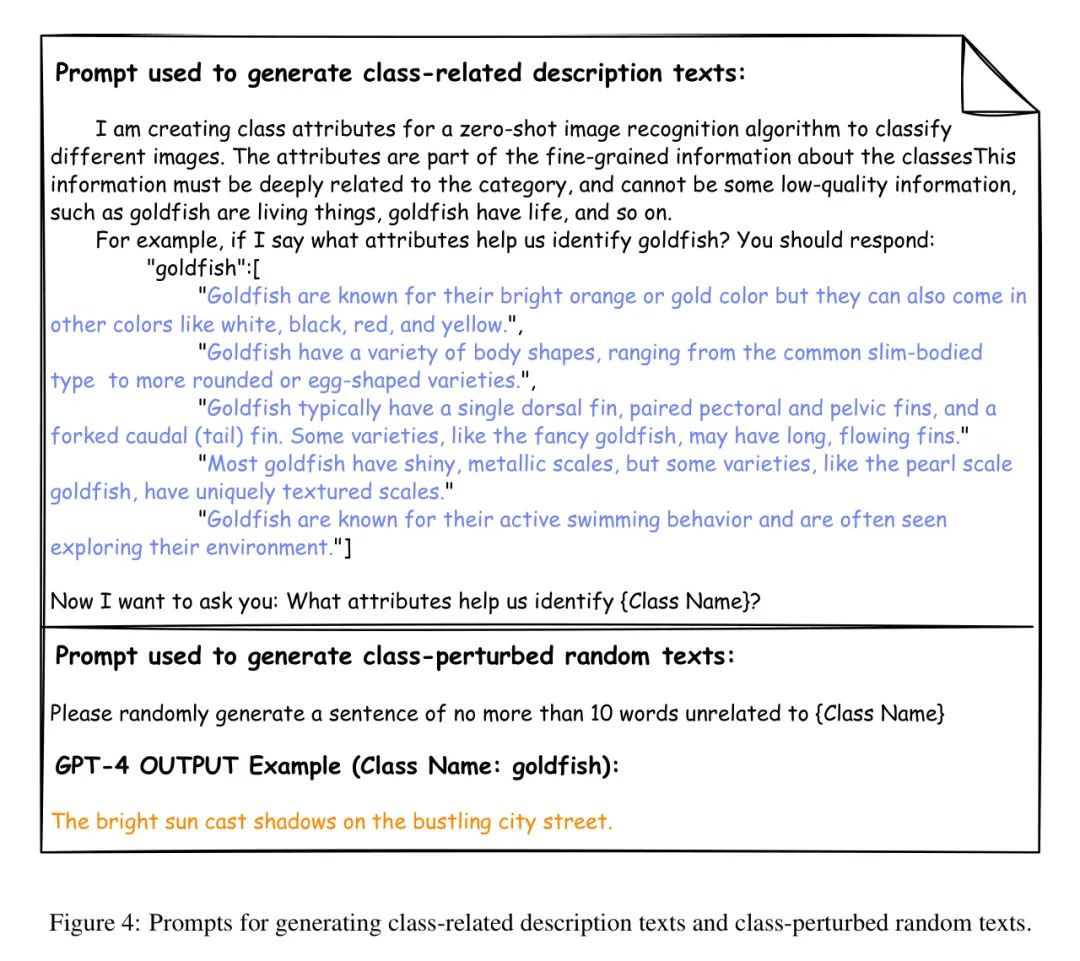

在作者的研究中,作者利用了GPT-4的上下文学习能力生成两种文本——相关描述文本和类扰动描述文本。用于生成文本的提示在图4中说明。

Appendix B Threshold Selection

作者提出的BDetCLIP可以高效且有效地将输入图像映射到一个线性可分离的空间。防御者需要设置一个阈值来区分干净图像和后门图像。在确定这个阈值时,作者使用了之前工作中经常使用的一个假设[20],[30]:防御者可以根据一小部分干净样本来估计阈值。这个估计的阈值是通过以下方式计算的:

其中是用来估计阈值的干净图像的数量。其他符号与正文保持一致。

Appendix D More Details about the Experimental Setup

攻击CLIP的细节。作者考虑了两种针对CLIP的攻击手段,包括在CC3M的部分后门图像-文本对上对预训练的干净CLIP进行微调,以及通过中毒的CC3M数据集预训练后门CLIP。在第一种情况下,作者从CC3M中随机选择了500,000个图像-文本对作为微调数据集,其中作者也随机选择了1,500个作为目标后门样本,并对它们应用触发器,同时将它们对应的标题替换为目标类的模板。然后,作者可以用后门数据集微调CLIP。在第二种情况下,遵循CleanCLIP [2]中的攻击设置,作者从CC3M中随机选择了1,500个图像-文本对作为目标后门样本。然后,作者从零开始在后门的CC3M数据集上预训练CLIP。所有实验都是在8个NVIDIA 3090 GPU上进行的。

比较方法的细节。

- STRIP[16]是第一种黑盒TTSD方法,它叠加各种图像模式,并通过观察被扰动的输入预测类别的随机性来识别中毒样本。STRIP [16]的官方开源代码可以在https://github.com/garrisongys/STRIP找到。在作者的实验中,对于每个输入图像,作者使用测试数据中的64个干净图像进行叠加。

- SCALE-UP[20]也是一种黑盒输入级后门检测方法,通过在放大条件下测量标签的缩放预测一致性(SPC)来评估输入的恶意性,在没有数据或攻击先验信息的情况下提供有效的防御。SCALE-UP [20]的官方开源代码可以在https://github.com/JunfengGo/SCALE-UP找到。

- TeCo[30]通过常见的图像损坏修改输入图像,并通过硬标签输出评估其鲁棒性,最终基于结果偏差测量确定后门触发器的存在。TeCo [30]的官方开源代码可以在https://github.com/CGCL-codes/TeCo找到。在作者的实验中,考虑到运行时的问题,作者选择了“弹性变换”、“高斯噪声”、“散粒噪声”、“脉冲噪声”、“运动模糊”、“雪”、“霜”、“雾”、“亮度”、“对比度”、“像素化”和“JPEG压缩”作为损坏图像的方法。最大的损坏严重程度设置为6。

数据集的细节。 ImageNet-1K [40]包含1,000个类别和超过一百万张图片,对于大规模图像分类任务来说是一个具有挑战性的数据集。Food-101 [3]包含101个食物类别的菜肴,每类有1,000张图片,以及Caltech101 [13],一个包含101个目标类别和1个背景类别的图像数据集,每个类别有40到800张图片,这两种数据集常用于测试模型在细粒度分类和图像识别任务上的性能。在作者的实验中,作者使用了ImageNet-1K [40]的验证集,以及Food-101 [3]和Caltech101 [13]的测试集。在测试时后门样本的比例上,作者的方法(BDetCLIP)一致优于 Baseline 方法SCALE-UP。无论是在0.5或0.7的后门样本比例下,BDetCLIP在所有目标类别和攻击检测场景中都比SCALE-UP获得更高的AUROC分数。这表明BDetCLIP在检测后门样本方面表现出更高的鲁棒性和准确性,从而提高了多模态模型对抗后门攻击的可靠性和安全性。

参考

[1].BDetCLIP: Multimodal Prompting Contrastive Test-Time Backdoor Detection.

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2024-05-30,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读

目录