机器学习:更多关于元学习

目录

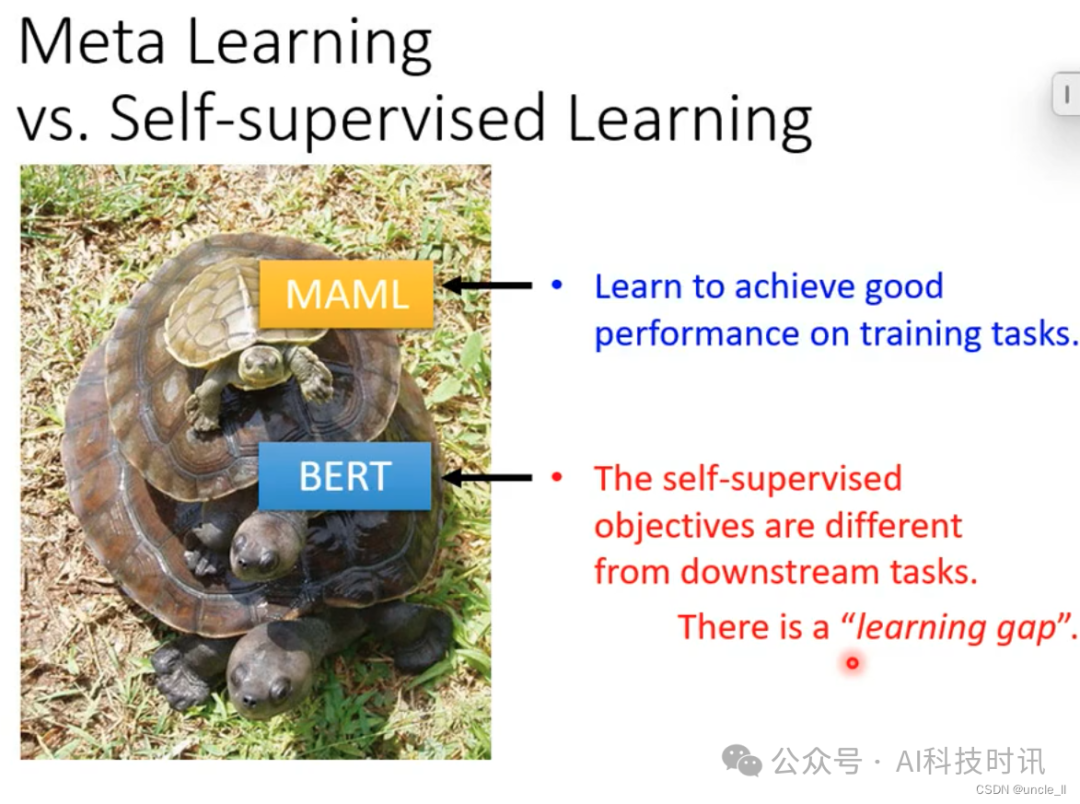

Meta Learning vs Self-supervised Learning

- 自监督学习——找初始化的参数

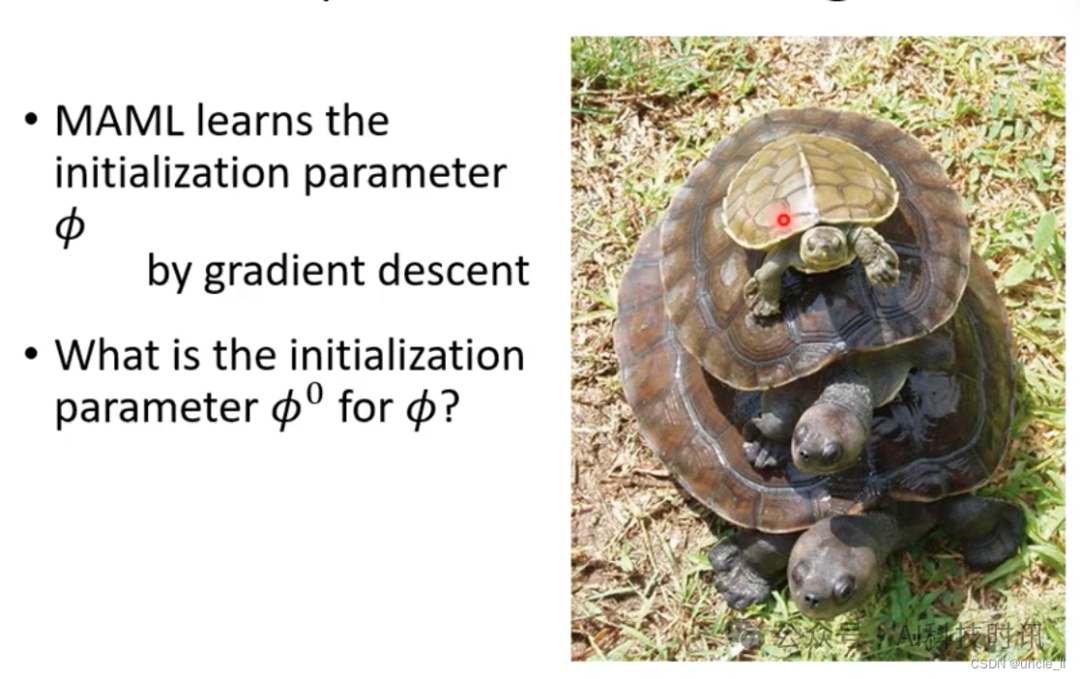

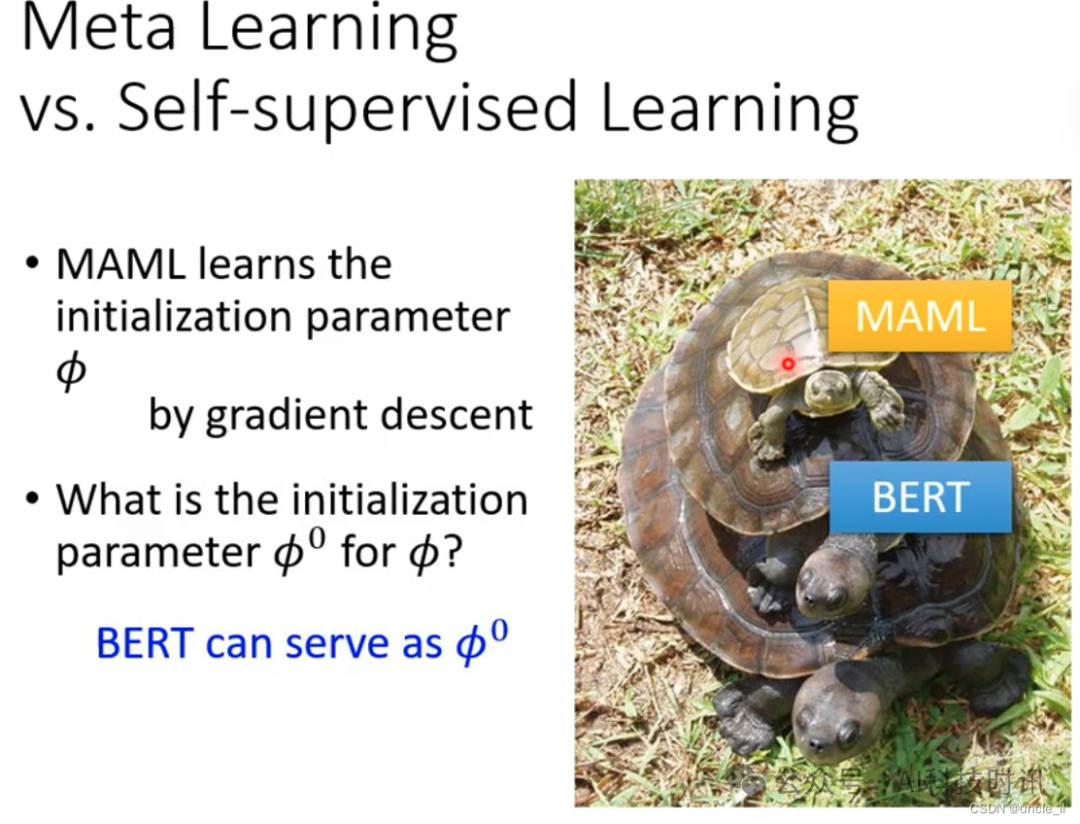

- MAML 自动学出合适的参数

- MAML:不断的学初始化参数

- MAML的初始化参数来自BERT

- MAML:找出来的初始化参数能在训练任务上表现的很好

- BERT:自监督目标是不同的下游任务,使用了大量未标注的数据

- 二者结合可能会有更好的效果

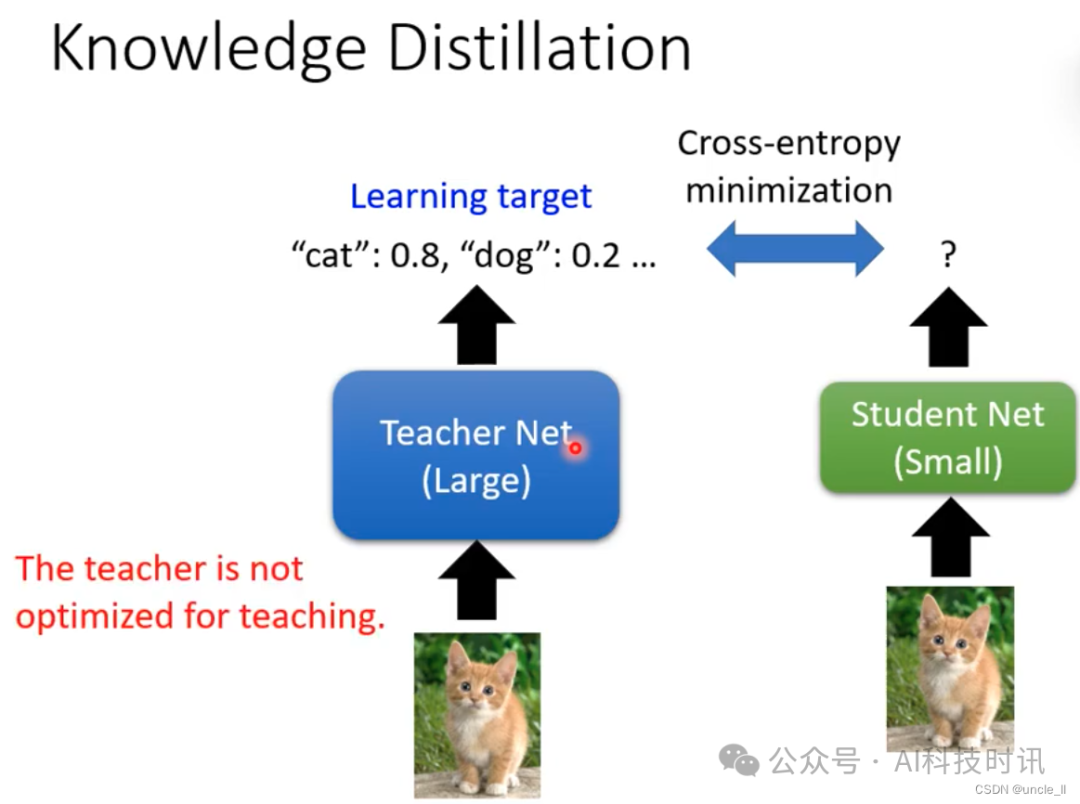

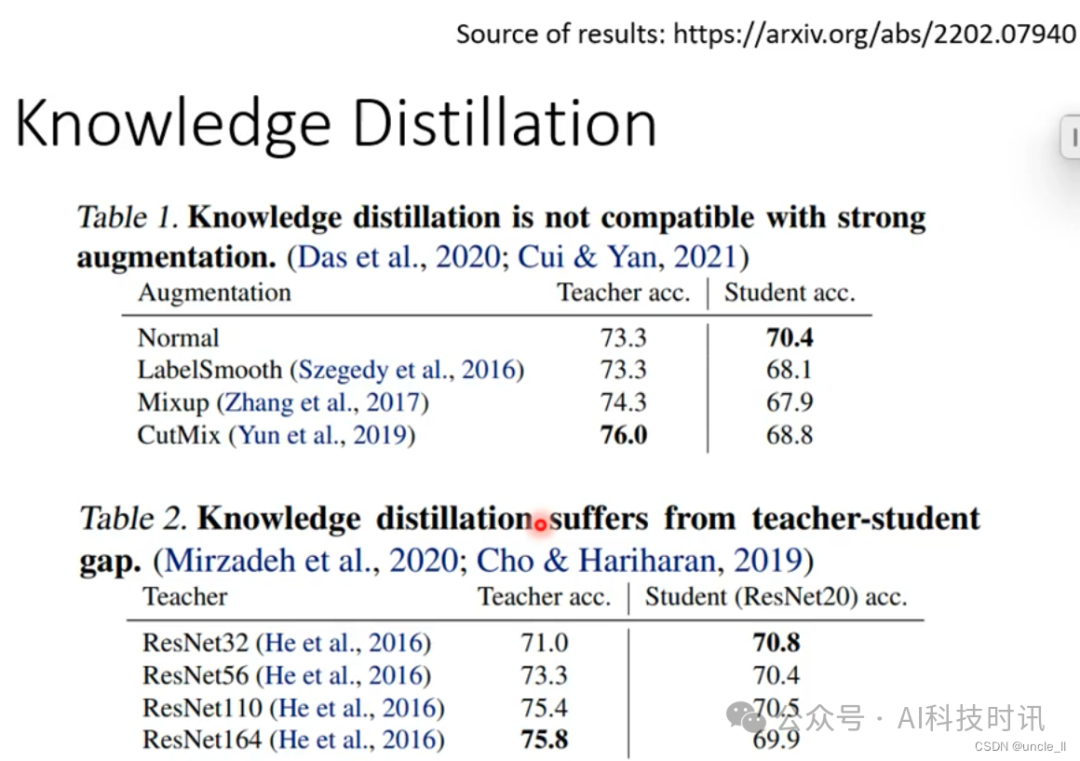

Meta Learning vs Knowledge Distillation

- 老师模型不是最擅长教育学生模型的

- 老师模型和学生模型之间有gap

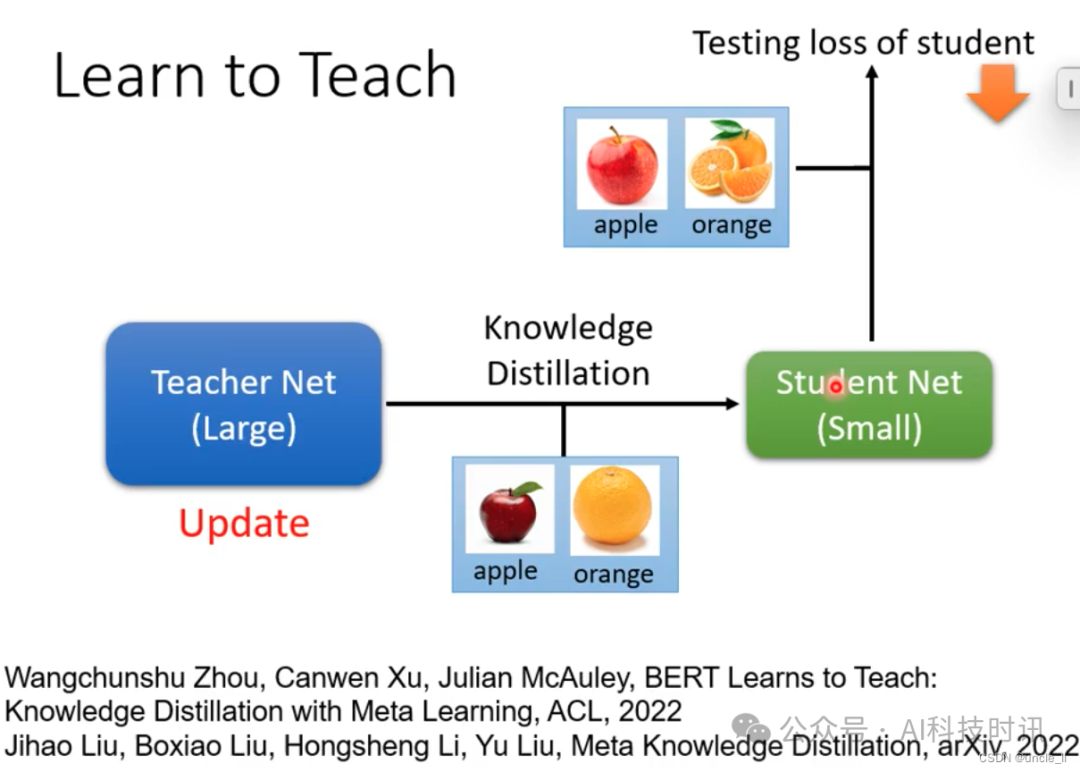

- 能让老师模型学习如何去教吗?可以通过meta learning实现这点

- 基于学生模型的损失,更新老师模型

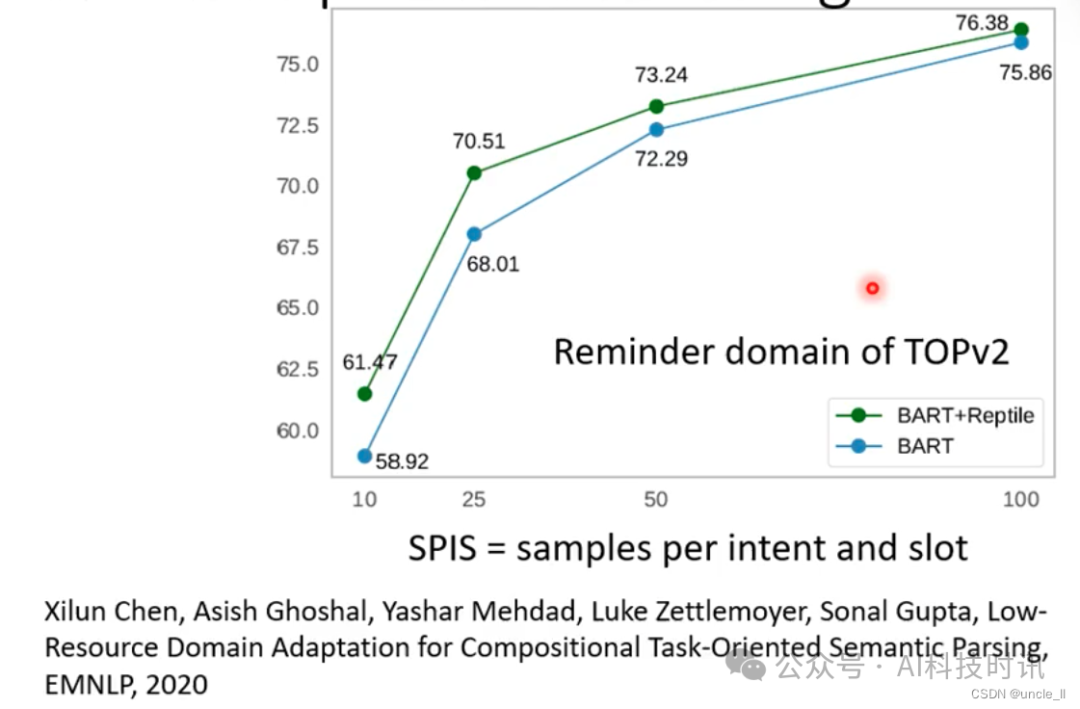

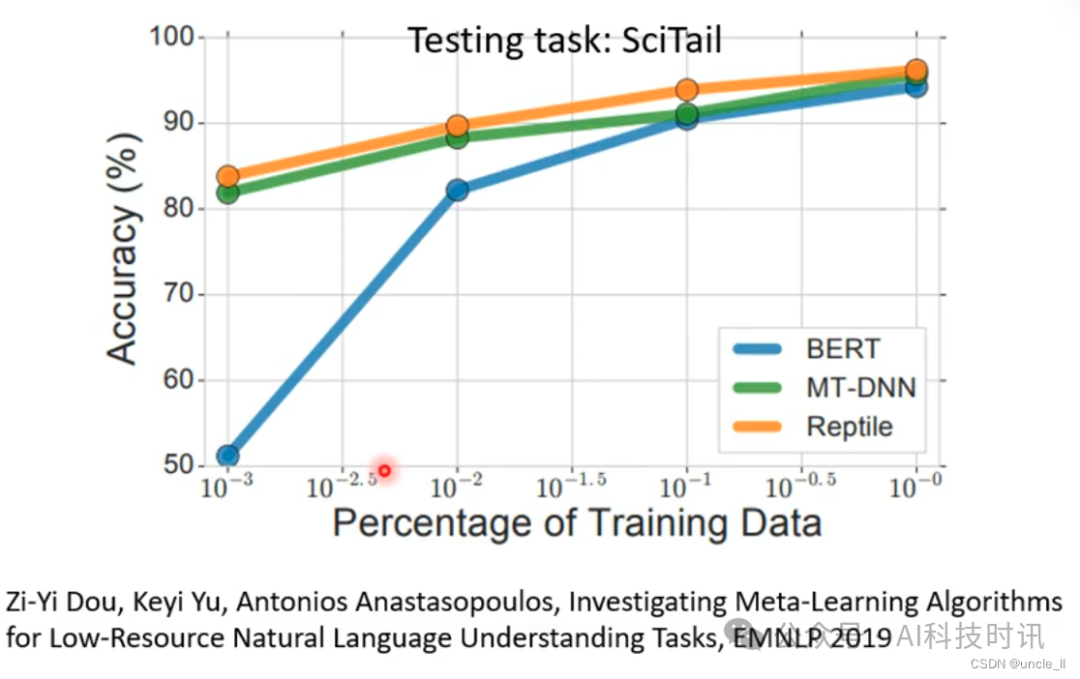

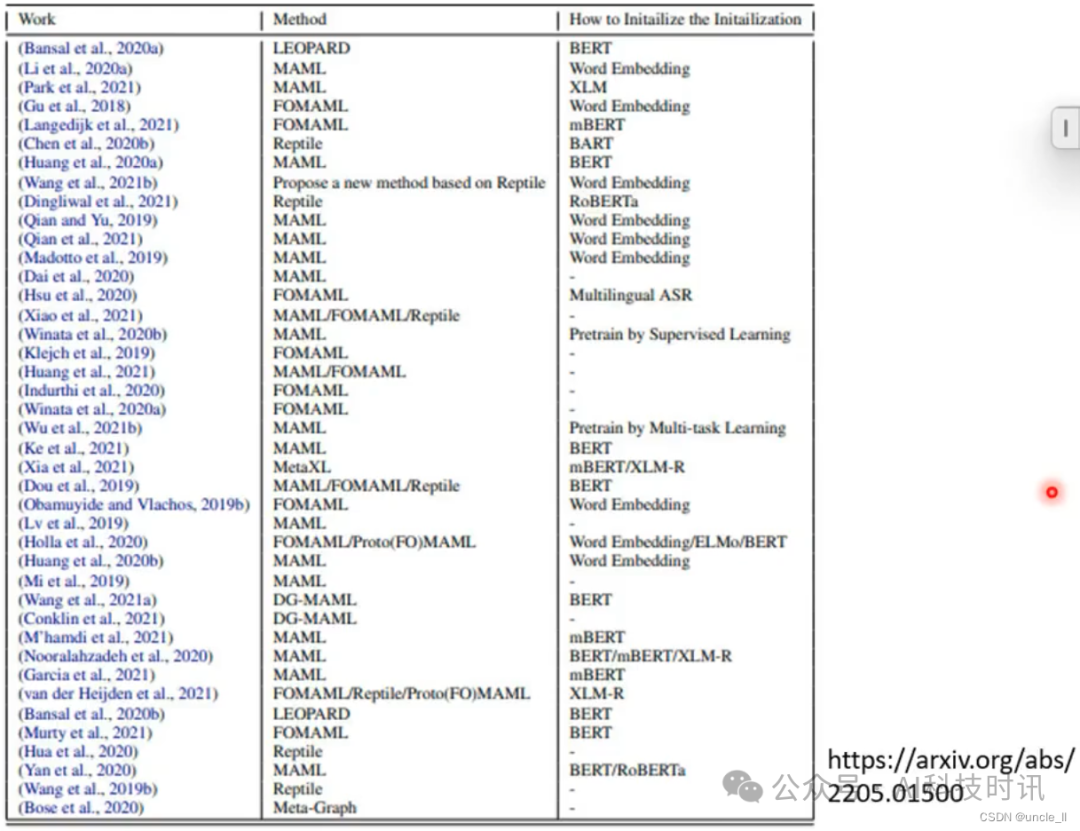

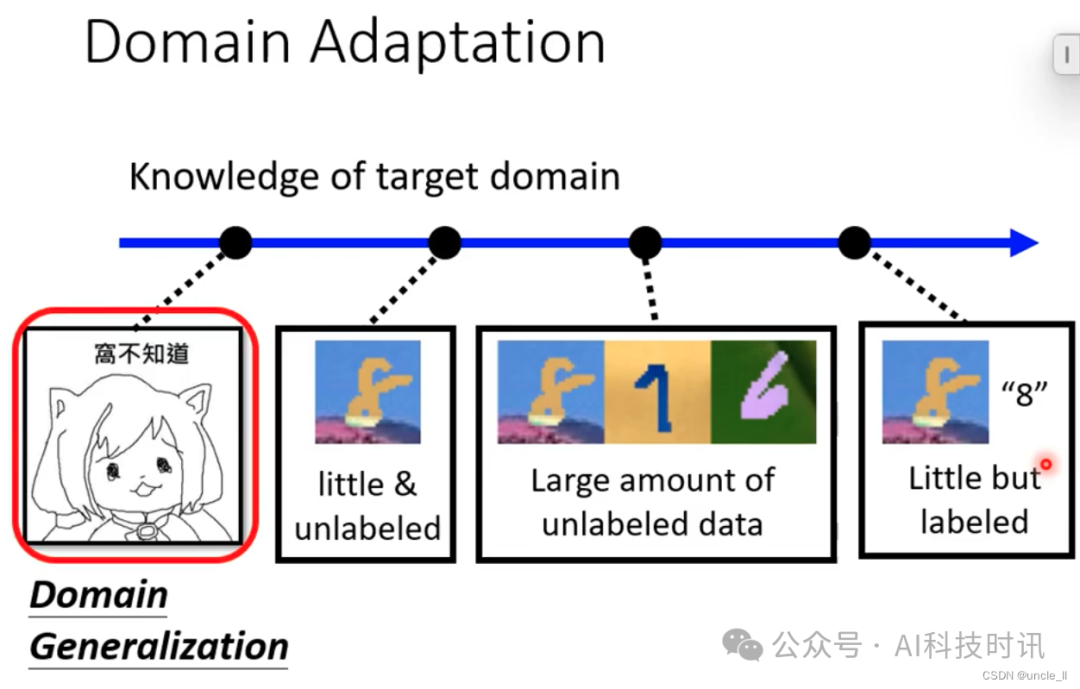

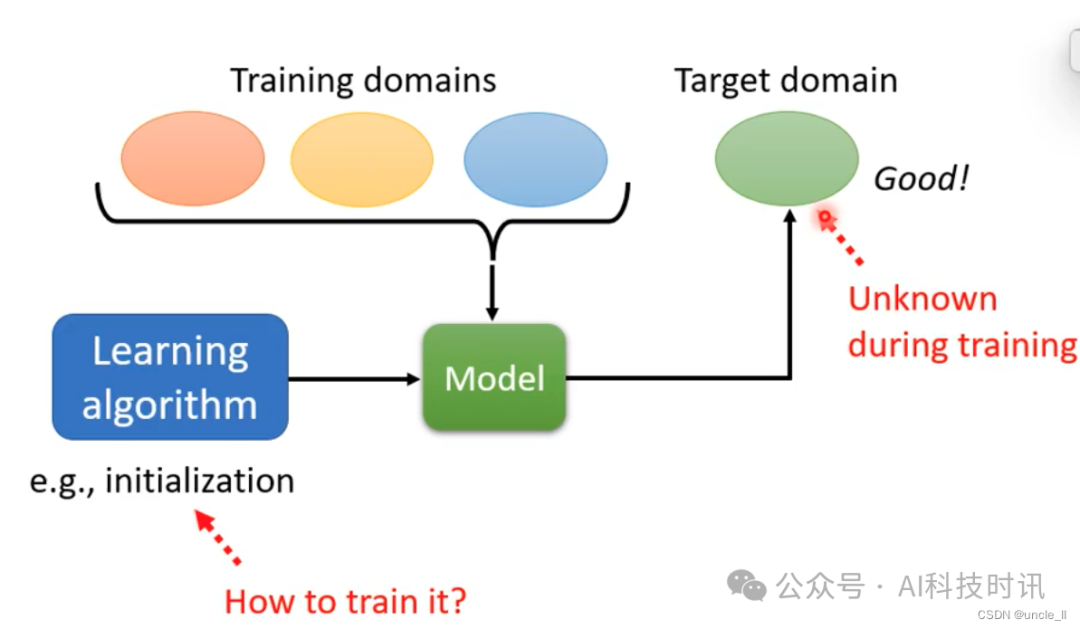

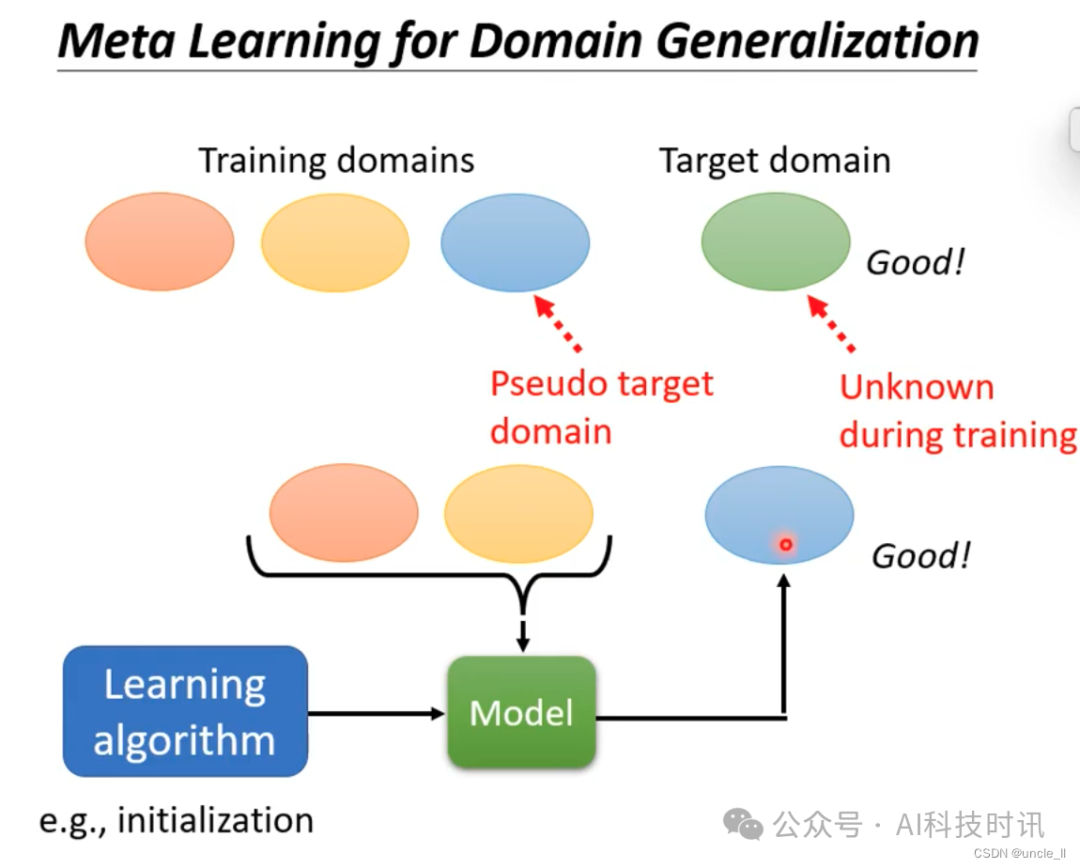

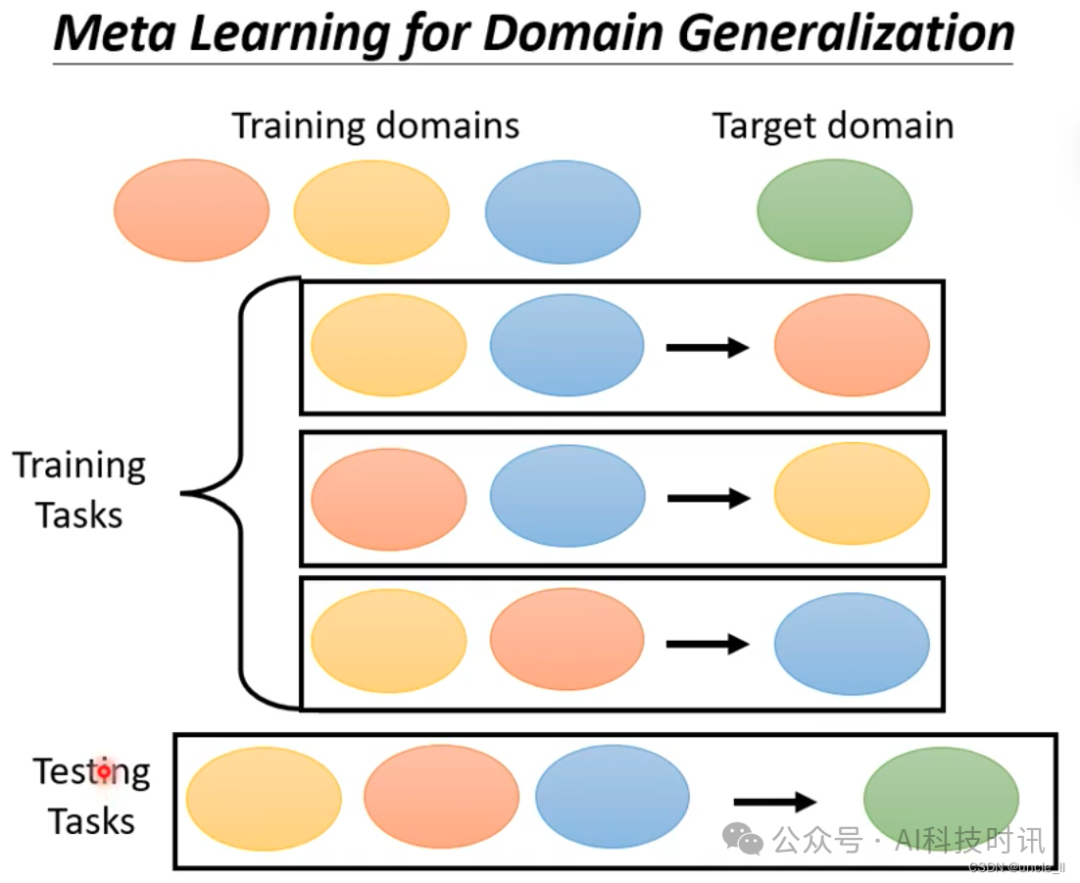

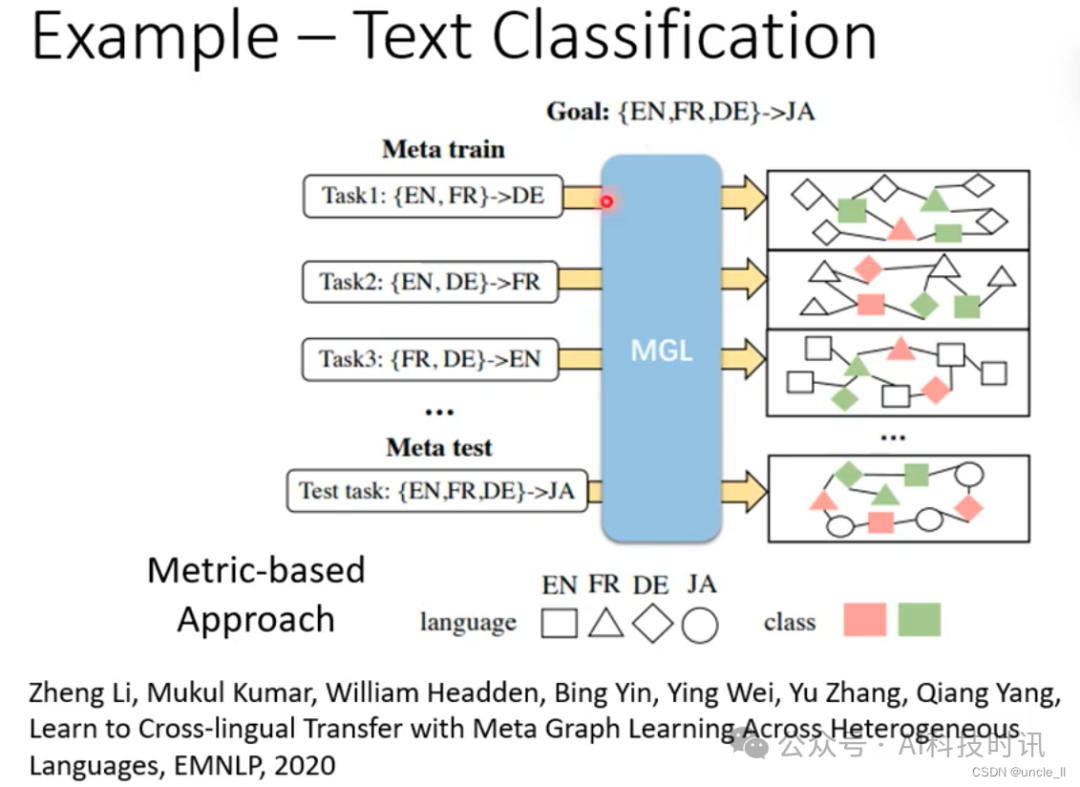

Meta Learning vs Domain Adaptation

- 擅长解few-shot的题目

- target domain拿不到,就用之前的某个domain知识假设是target domain,然后进行训练。

- 所有的domain都来一遍,然后期望在新的domain上有好的表现

- Meta Learning可以用来进行不同任务的领域学习

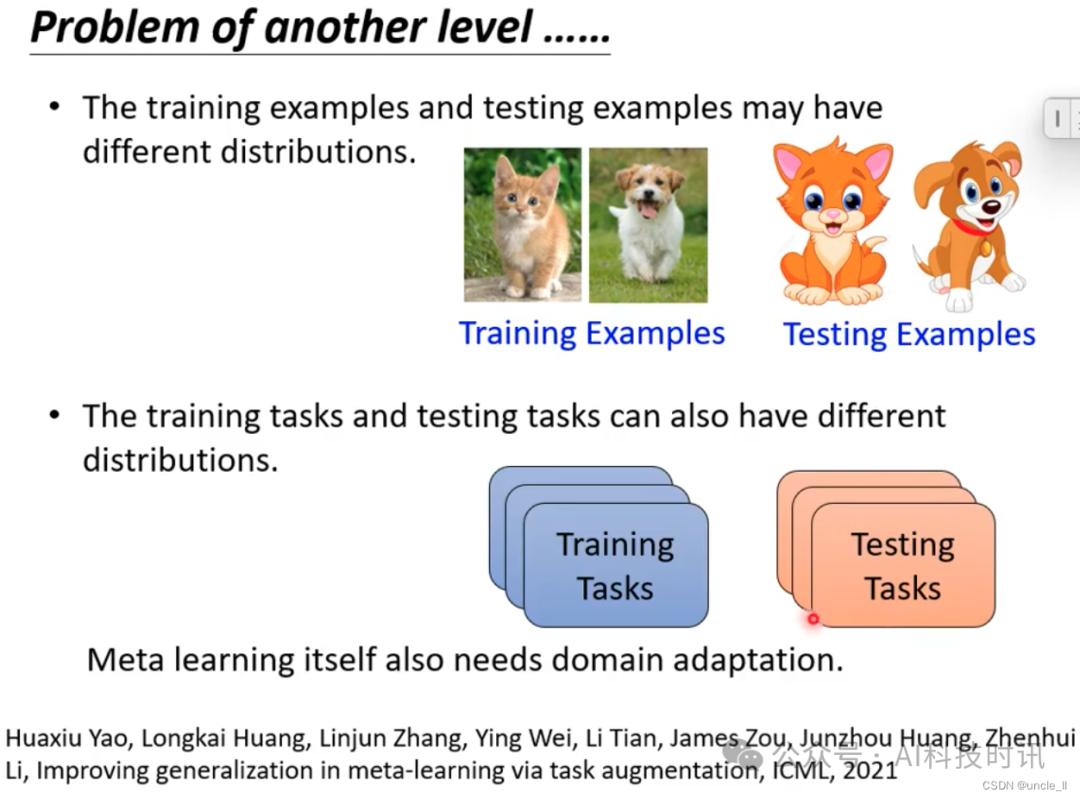

- Meta Learning可能自身也需要领域适应

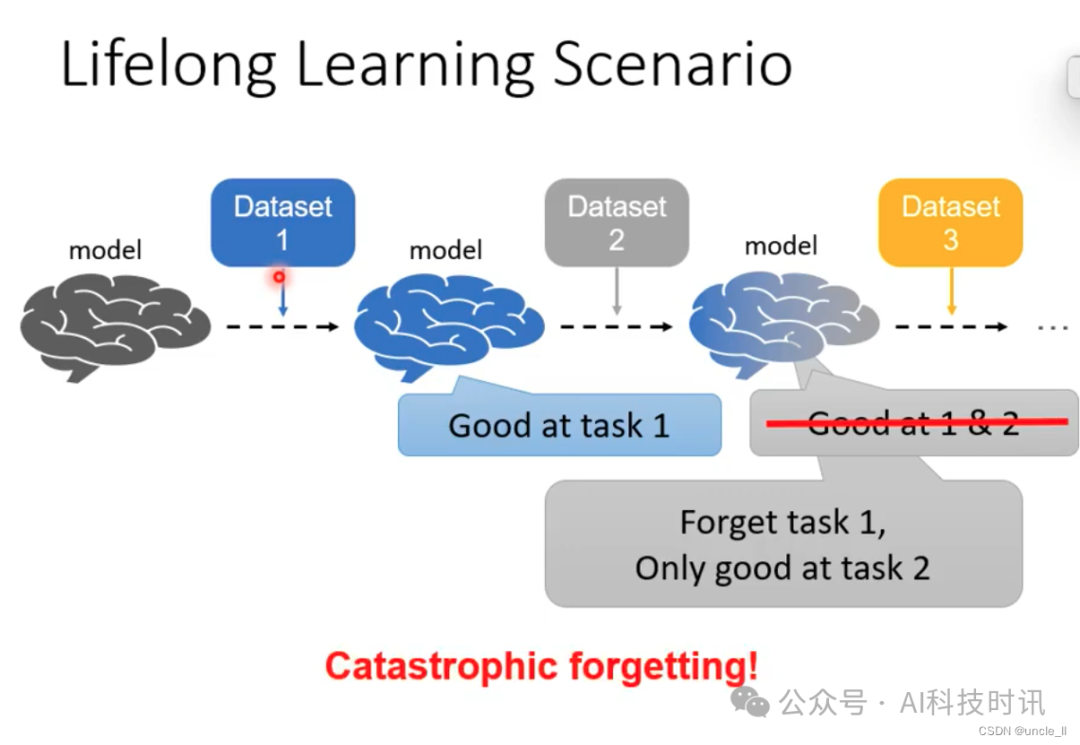

Meta Learning vs Life-long Learning

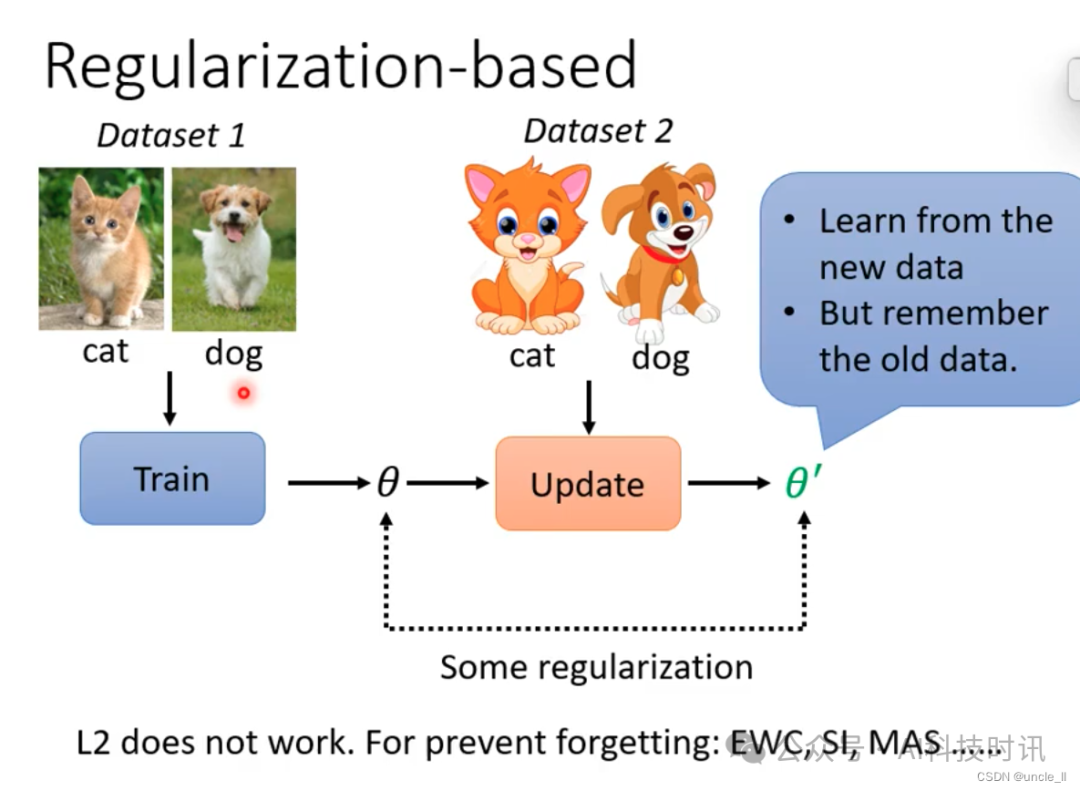

- 随着不断的进行,容易遗忘之前学到的知识

- 期待新的参数能在之前的数据集上表现也好

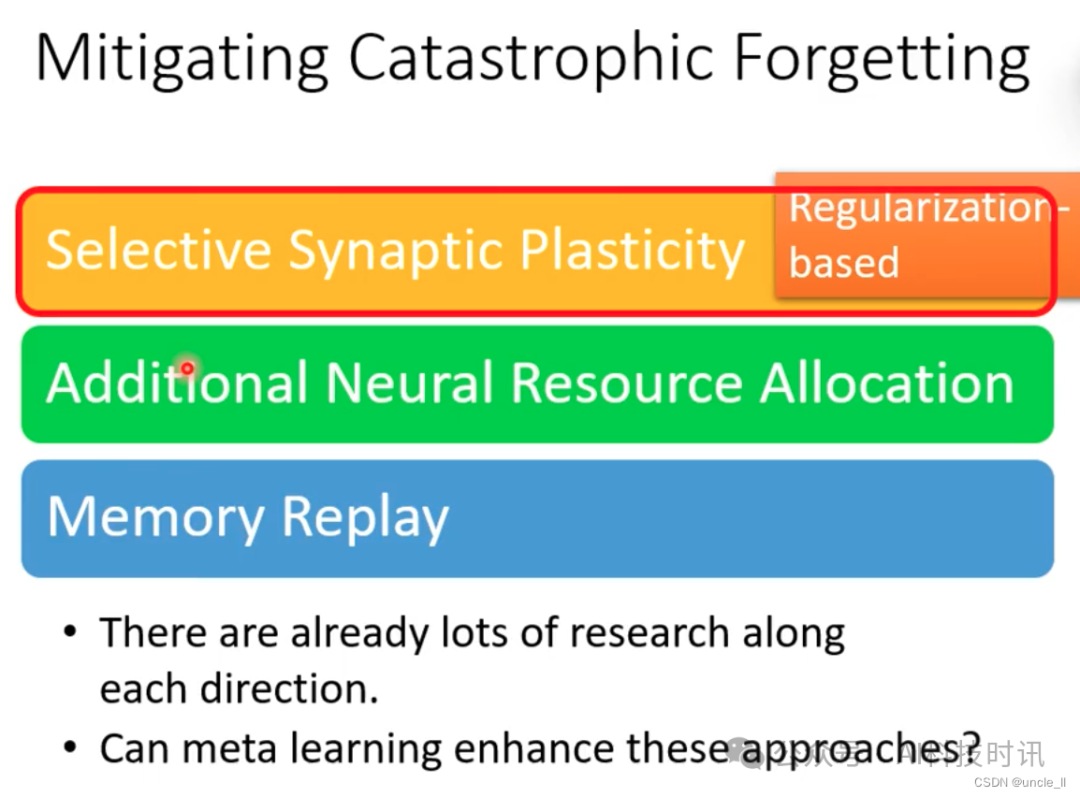

- 采用regularization来保持算法对两个数据集都表现较好

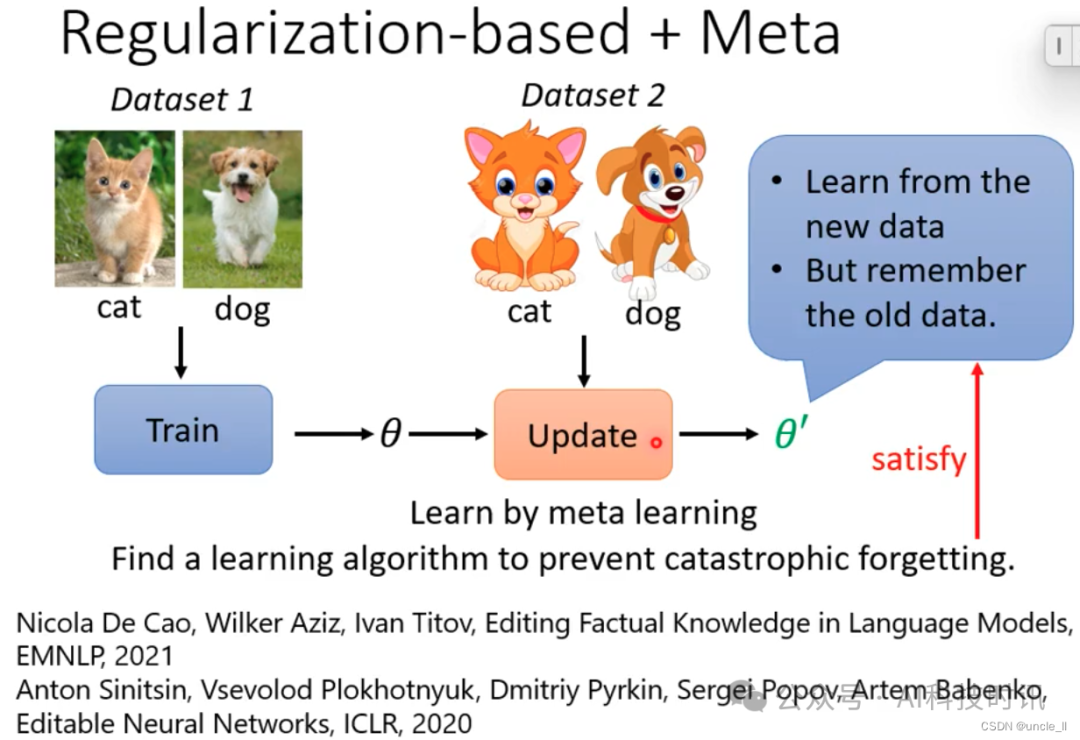

- 使用Meta Learning来避免产生灾难性遗忘

- 学会新的东西,也不会忘记旧的东西

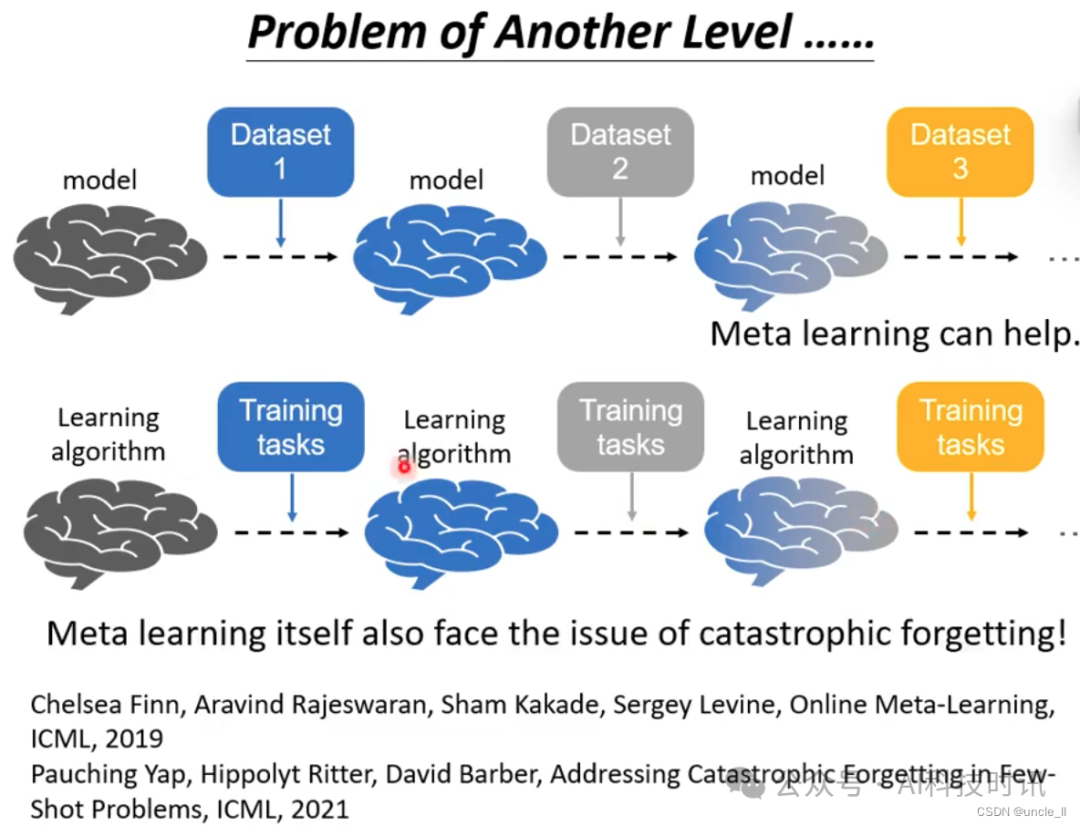

- Meta Learning 也有可能遇到灾难性遗忘的问题

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2024-06-12,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读

目录