启示AGI之路:神经科学和认知心理学大回顾 全译上

启示AGI之路:神经科学和认知心理学大回顾 全译上

CreateAMind

发布于 2024-07-05 11:19:05

发布于 2024-07-05 11:19:05

A Review of Findings from Neuroscience and Cognitive Psychology as Possible Inspiration for the Path to Artificial General Intelligence

神经科学和认知心理学的发现回顾:作为通往人工通用智能之路的可能启示

https://arxiv.org/abs/2401.10904

摘要(上篇5万字,下篇4.6万字)

这篇综述旨在通过研究神经科学和认知心理学方法,为人工通用智能的发展提供潜在的启示。尽管深度学习模型在各个领域取得了令人印象深刻的进展,但它们在抽象推理和因果理解方面仍然存在不足。为了超越数据驱动的局限性并以更接近人类智能的方式支持决策制定,这些能力最终应该被整合到人工智能系统中。这项工作是一项纵向综述,试图对大脑功能进行广泛的探索,从较低层次的生物神经元、尖峰神经网络和神经元集合,到较高级别的概念,如大脑解剖学、向量符号架构、认知和分类模型以及认知架构。希望这些概念可以为人工通用智能的解决方案提供见解。

关键词:尖峰神经元、细胞集合、神经科学、分类、认知架构、人工通用智能

1. 引言

人工智能(AI)近年来取得了显著进展,主要得益于深度学习模型的出现。这些模型在解决以往难以解决的复杂问题方面表现出了高效性,特别是在处理图像、声音和语言等主要处理领域。此外,深度学习通过发展生成模型,在内容生成方面取得了重大突破,使得文本生成、问答和图像合成成为可能。

深度学习模型的成功在各种应用中都有所体现。在图像处理中,这些模型在物体检测、图像识别和语义分割等任务中取得了显著成果,往往在特定场景中超过了人类水平的表现。类似地,在声音处理领域,深度学习算法展示了在语音识别和音频合成方面的能力,推动了虚拟助手的发展。此外,在自然语言处理领域,深度学习技术使得机器能够处理和生成人类语言,推动了机器翻译、情感分析和文本摘要等方面的进步。

生成模型代表了AI的重大进步,能够跨越不同形式生成新颖且逼真的内容。例如,基于文本的对话代理展示了生成一致且与上下文相关的回应的能力。另一方面,图像生成模型展示了根据文本描述生成高质量图像的能力。这些进步标志着AI系统表达能力的显著提升,以及它们在与人类进行创造性互动方面的潜力。

尽管取得了显著成就,深度学习模型存在固有限制,这些限制阻碍了它们朝向人工通用智能(AGI)的进展。当面对抽象推理和因果关系识别任务时,它们的缺陷变得明显。虽然深度学习方法在模式识别和数据驱动任务方面表现突出,但在理解导致观察到的模式的基础因果机制时往往困难重重。这种限制在要求高级抽象推理的任务中尤为明显,人类智能在这方面明显优于AI。

深度学习模型的另一个重大缺点是它们需要大量的训练数据才能实现良好的性能,这使得它们在数据稀缺、获取成本高或根本无法获取数据的情况下不太实用。相比之下,人类具备通过抽象推理、理解因果关系和利用简洁规则有效推广知识的能力。

实现人工通用智能(AGI)的道路在于解决这些限制。将推理和因果关系集成到AI系统中将是关键,使它们能够超越数据驱动的任务,做出类似人类推理能力的明智决策和推断。

此外,知识的积累在追求AGI过程中至关重要。除了从大量标记数据中学习外,AI系统还应具备类似人类常识的知识积累能力。这涉及到融入关于世界的背景知识、情境理解能力,以及基于先前经验和推理做出决策的能力。通过这种方式,这些系统可以更接近人类的能力,弥补不完整事实或在意外情况下行动的能力。

在本文综述中,我们将概述一些有潜力推动AGI发展的研究方向。尽管深度学习目前主导了AI研究领域,但重要的是要认识到一些可能未受到足够关注的领域。尽管这些领域似乎不在AI社区的关注焦点之内,但它们仍在积极进行研究。

此外,我们应强调将AI研究与神经科学和认知心理学领域相连接的重要性。从这些学科中汲取灵感可以提供新的见解和机会,使我们更接近实现AGI的目标。

然而,即使在神经科学和认知心理学的领域中,也存在明显的鸿沟,即微观神经功能细节与人类认知中观察到的宏观现象之间的差距。在一个极端,我们对单个神经元的内部运作和不同脑区功能有相当深入的了解。另一方面,认知心理学已经识别和描述了支持记忆、注意力和决策等复杂心理过程的高级机制。然而,一个重要问题仍然存在:神经元活动与高阶认知功能出现之间的联系仍然知之甚少。

我们的重点是描述大脑和心智功能的特征,涵盖了从低层基本原理到高级认知操作的范围。我们主要关注描述理论原理,而不是探索实际应用和计算优化,因为这些常常会掩盖基础研究的重要性。

需要注意的是,我们的目标不是提供每个概念的详尽描述,因为这个领域广阔而多样化。鼓励感兴趣的读者进一步深入探索这些方面。许多调查报告往往局限于特定领域或子领域。我们的意图是通过涉及更广泛的问题谱系,并尝试提供更全面的视角,来更全面地了解人类大脑及可能实现AGI的复杂旅程。

2. 生物神经元

我们将从描述单个生物神经元的行为开始,这是传递和处理信息的神经系统的基本构建模块。在第3节中,我们将介绍在这方面开发的一些计算模型。

2.1. 神经元的结构

神经元的主要组成部分包括细胞体、树突和轴突(图2.1)。细胞体,也称为胞体,是神经元的中心部分。细胞体内含有细胞核,其中包含必要的遗传物质,支持神经元的功能,以及各种细胞器,支持其代谢过程。

树突类似于树枝,从细胞体延伸出来,作为神经元的输入接收器。这些树突延伸接收来自其他神经元的电脉冲信号。

神经元内的关键决策点是轴突初段,位于轴突从细胞体发出的位置。在这里,来自树突的电输入被集成。如果这些输入的累积强度超过了某个阈值,将触发电冲动的启动,通常称为动作电位或尖峰。动作电位是一种“全有或全无”的事件,意味着它要么以完全强度发生,要么根本不发生。一旦在轴突初段生成了动作电位,它就变得不可逆,并沿着轴突单向传播。

轴突是一种长而像电缆的结构,负责将动作电位信号传递给其他神经元,通常跨越相当大的距离。这个过程确保了神经系统内部信息的传播。在轴突的末端,有专门的结构称为轴突末端按钮(或小结),它们将轴突信号传递给相邻神经元的树突。这种传输通常通过化学突触实现,轴突末端释放神经递质,进而在接收神经元的树突中引发电信号,继续神经通讯链。

重要的是要提到,这是关于神经信号传递的典型描述,但在大脑中存在神经元结构和连接类型的变化。例如,作为例外,有些神经元具有多个轴突或完全缺乏轴突,而有些突触是电性而非化学性的。

一般来说,可以将神经元视为一种探测器,通过评估其被连接检测的特定条件来对特定刺激做出反应。就像电子系统中的探测器一样,神经元识别并响应特定的输入模式。数学建模中的神经元激活(“全有或全无”响应)与二进制探测器的功能紧密相似,需要达到一定的输入阈值才能触发响应。

神经元是单个细胞,产生并传递电信号,而神经是由结缔组织围绕着的许多轴突束,作为在身体各部分和中枢神经系统之间传递这些信号的通道。

将神经元与其他类型的细胞进行比较,我们可以提到神经元是体内寿命最长的细胞之一。许多神经元在人的一生中存在并且通常不会被替换。相比之下,体内大多数其他细胞的寿命有限,通过细胞分裂不断被替换。此外,神经元不通过细胞分裂进行再生。因此,它们的再生能力有限;如果它们受损或死亡,通常不会通过细胞分裂而被替换,而是通过神经可塑性(调整神经元之间连接的结构)或其他神经元承担部分失去功能的过程。虽然存在新神经元的产生(神经发生),但其程度有限。

此外,神经元具有高代谢和能量需求,这是由于它们持续的信号活动以及维持跨其细胞膜的离子梯度所致,如下文所述。平均而言,大脑消耗了人体总能量的约20%,尽管它仅占总体重的约2%。

2.2. 化学突触的结构

接下来我们将描述化学突触的基本结构和运作方式(图2.2)。突触是神经元之间通信发生的微观连接点。它充当了从一个神经元传递冲动到另一个神经元的桥梁。

传递神经元被称为前突触神经元,接收神经元被称为后突触神经元,它们之间由称为突触间隙的小间隙分隔开来。当动作电位到达前突触神经元轴突的末梢按钮时,它会触发从特殊结构称为突触小泡中释放神经递质。释放的神经递质会扩散过突触间隙。在后突触神经元膜上,存在专门设计用于与神经递质结合的受体位点。这些受体位点类似于锁,而神经递质则起到钥匙的作用。

当神经递质与其受体结合时,它们会触发后突触神经元膜电位的变化。这种变化可以是兴奋性的,使后突触神经元更有可能产生动作电位,或者是抑制性的,使其 less可能。后突触神经元接收到的这些兴奋性和抑制性信号的综合效应决定了它是否会产生自己的动作电位,并继续沿神经途径传递神经冲动。

神经递质释放到突触间隙后,已经完成了从一个神经元到另一个神经元的信号传递,它们会被清除以终止信号并防止持续刺激。神经递质再摄取泵专门用于重新吸收它们回到释放它们的前突触神经元中。

2.3. 动作电位的形成

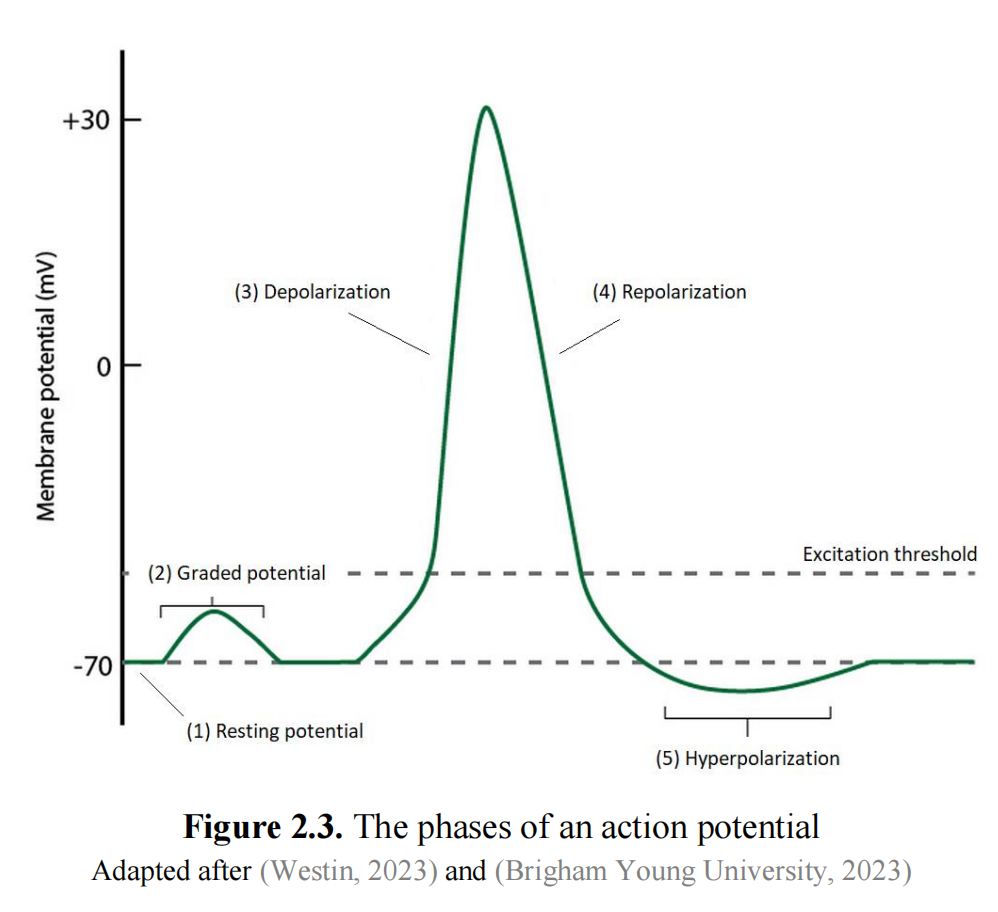

最后,我们将简要描述神经元中动作电位(AP)的形成过程(图2.3)。

在神经元的静息和放电过程中,电力和化学力之间的相互作用起着关键作用,涉及多种类型的离子,本文将仅关注钠(Na+)和钾(K+)离子的作用。

在神经元的静息状态下,大部分Na+离子位于细胞外,而大部分K+离子则位于细胞内。细胞外的Na+浓度约为细胞内的10倍,而细胞内的K+浓度约为细胞外的25倍(Henley, 2021)。这种浓度不平衡(或梯度)产生了强烈的扩散力,使离子倾向于形成更均匀的分布。然而,扩散力受到电力的抵消。当神经元处于静息状态时,电力和化学(扩散)力彼此抵消达到平衡(O’Reilly et al., 2012)。这就是为什么神经元的静息膜电位约为-70 mV(图2.3中的状态1),而不是零。

当神经元接收到传入信号时,Na+离子通过配体门控Na+通道进入细胞。这些通道在特定神经递质结合后打开。正离子的流入导致膜电位正向变化。如果膜电位保持在激活阈值以下,称为分级电位(图2.3中的阶段2),神经元不会产生动作电位。随后,神经元膜电位主要由正离子(如K+)的扩散离开细胞直到达到平衡,返回其静息状态。

然而,如果膜电位超过激活阈值,大约为-55 mV,这将触发电压门控Na+通道的打开。这些通道仅在细胞膜电位(电压)发生变化时才会打开。因此,Na+离子迅速流入细胞,使细胞膜的电荷反转。这个过程称为去极化(图2.3中的阶段3),并且它引发了动作电位的生成。去极化沿着细胞膜传播,促使电信号在轴突上传输。因此,膜电位达到了正值,大约为30-40 mV。

此时,电压门控K+通道也会打开。由于K+离子在神经元内部浓度更高,它们沿着电化学梯度流出细胞。这些正电荷离子的向外运动使神经元膜重新极化,这个过程称为复极化(图2.3中的阶段4)。

离子的运动取决于它们通过神经元细胞膜上的离子通道的电导率(电导率是电阻的倒数:G = 1 / R)。虽然Na+的电导率在图2.3中的动作电位形状中变化非常类似,但K+的电导率开始在稍后的动作电位峰值附近增加,经过复极化阶段的中点后达到最大水平,然后逐渐减少,但在细胞膜达到静息电位时并不达到最小值。

电压门控K+通道会保持打开稍长一段时间,导致超极化阶段(图2.3中的阶段5),这是由于K+离子的过度流出造成的。此外,神经元还具有K+泄漏通道,允许K+离子持续 passively 从细胞中流出,从而加剧了正电离子的流出。此时神经元进入不应期,这使得再次生成动作电位变得更加困难,因为需要更大的刺激来达到阈值。超极化允许神经元在响应另一个信号之前恢复。动作电位过多可能会有害,导致癫痫发作或心律失常等病症,而动作电位过少可能会导致肌无力、瘫痪或感觉和认知障碍等病理状态。因此,超极化在帮助细胞维持稳态(即确保稳定和相对恒定的内部环境)方面起着至关重要的作用。

随后,神经元膜电位再次回到静息状态,主要是由于正电离子(如Na+)通过膜内向外扩散,直到达到电化学平衡。

虽然所述的机制依赖于Na+的流入和K+的流出,单个动作电位的流动足够小,不会显著改变细胞内离子的浓度,因此也不会显著改变平衡电位。然而,长期来看,多个动作电位可能会逐渐影响离子浓度。维持静息状态的主要手段是钠-钾泵。Na+/K+泵是存在于所有动物细胞膜上的一种酶,其作用是将Na+从细胞内排出并吸收K+离子。在一个功能周期内,它交换3个Na+离子以获得2个K+离子(Byrne, 2023)。这是一个需要能量的主动过程。

因此,动作电位后K+和Na+浓度的小量耗竭是由Na+/K+泵恢复的。然而,这种补充并不需要立即启动下一个动作电位。在一个神经元内部,离子梯度足以生成大约10,000个动作电位,而无需依赖Na+/K+泵。

完整的动作电位周期持续时间很短,大约在1-5毫秒之间,具体取决于神经元类型和动物物种的不同。在大脑皮层中发挥重要认知功能的锥体神经元可以以每秒几个脉冲到超过100个脉冲的速率发放动作电位,这取决于任务和环境。

上述过程涉及兴奋性突触,增加了后突触神经元发放动作电位的可能性。在大脑中,还存在具有相反作用的抑制性突触。这类突触通过不同的机制运作。例如,兴奋性突触中主要使用的神经递质是谷氨酸,而抑制性突触中主要使用的是γ-氨基丁酸(GABA)。这两种神经递质在大脑中非常普遍,超过一半的大脑突触使用谷氨酸,大约三分之一使用GABA(Genetic Science Learning Center, 2013)。

抑制性突触的关键机制涉及氯离子(Cl–)的运动进入细胞。这些带负电的离子流入使神经元内部更加负电(超极化),远离触发动作电位所需的阈值。因此,神经元达到发放阈值的可能性降低。

2.4. 兴奋与抑制

虽然在多层感知器(MLP)中连接权重(对应生物神经元中的突触效能)可以是正或负的,但在大脑中神经元遵循戴尔原则(Eccles, 1986),即一个神经元不能同时具有兴奋性和抑制性突触。因此,我们可以认为生物神经元可以是兴奋性的或抑制性的。

兴奋性负责跨神经元之间的信号传输,支持信息的传播。兴奋性神经元在不同的皮层区域之间建立长距离连接,学习主要发生在它们之间的突触上。

另一方面,抑制性通过防止过度发放神经冲动和维持网络活动的平衡水平来控制神经活动。它对于时间精确性至关重要,同步神经发放,增强信号之间的对比度,调节网络振荡,并调整神经元对输入的敏感性。

在人类大脑皮层中,兴奋性神经元的百分比约为80-85%(Bratenberg, 1989; O’Reilly & Munakata, 2000; Nowak, Sanchez-Vives & McCormick, 2007),因此兴奋性神经元和抑制性神经元的数量比大约是4:1。

2.5. 大脑的复杂性

人类大脑是一个非常复杂的器官,具有广泛的神经机制。在这种复杂性的核心是大量的神经元和突触。成年人的大脑估计包含86 ± 8亿个神经元(Azevedo et al., 2019)。神经元之间通过大约100万亿个突触连接。平均而言,每个神经元大约有1万个树突接收来自其他神经元的输入,而轴突连接到大约1万个神经元以传递其输出(White, 1989; Abeles, 1991; Braitenberg & Schüz, 1998)。

此外,大脑由多种类型的神经元组成,每种神经元具有独特的特征和功能。在皮层神经元中,轴突可以长达数毫米,但人体中最长的神经元位于坐骨神经,其轴突长度可达60厘米。

神经通讯中涉及到100多种神经递质(Eliasmith, 2015),起着重要作用。除了前文提到的谷氨酸和GABA外,一些最为人熟知的神经递质包括多巴胺、5-羟色胺、乙酰胆碱和肾上腺素,每种都具有独特的功能和对行为及认知的影响。

神经元模型

今天最常见的人工神经元类型是感知器,它在各种形式的MLP神经网络中充当基本构建块。这也被称为点神经元模型。其输出表达为:

3.1. 霍奇金-赫胥黎模型

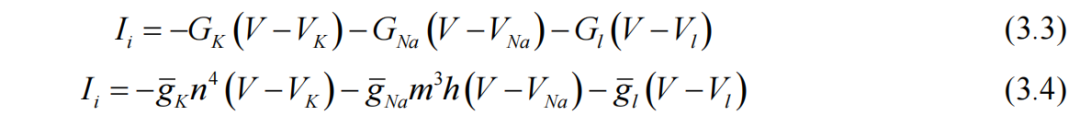

霍奇金-赫胥黎(Hodgkin-Huxley)模型是一个基础的数学框架,用于描述生物神经元的电生理特性。1952年,霍奇金和赫胥黎在巨型鱿鱼神经轴突上进行了一系列实验,该轴突直径约为0.5毫米,因此是研究的理想对象。相比之下,大多数鱿鱼和其他物种神经系统中的轴突要细得多,例如人类典型神经元的直径为1-2微米。

他们将神经元的电特性表示为等效的电路。一个电容器代表细胞膜,两个可变电阻代表电压门控的钠离子通道和钾离子通道,一个固定电阻代表由于Cl-离子而产生的小漏电流,三个电池代表由细胞内外离子浓度差产生的电化学电位。

该模型的基本方程为:

其中,Is代表刺激电流,Ii代表离子电流,表示为三种电流的总和 - 钠离子电流(Na+)、钾离子电流(K+)和漏电流:

门控变量n、m和h也由附加方程建模:

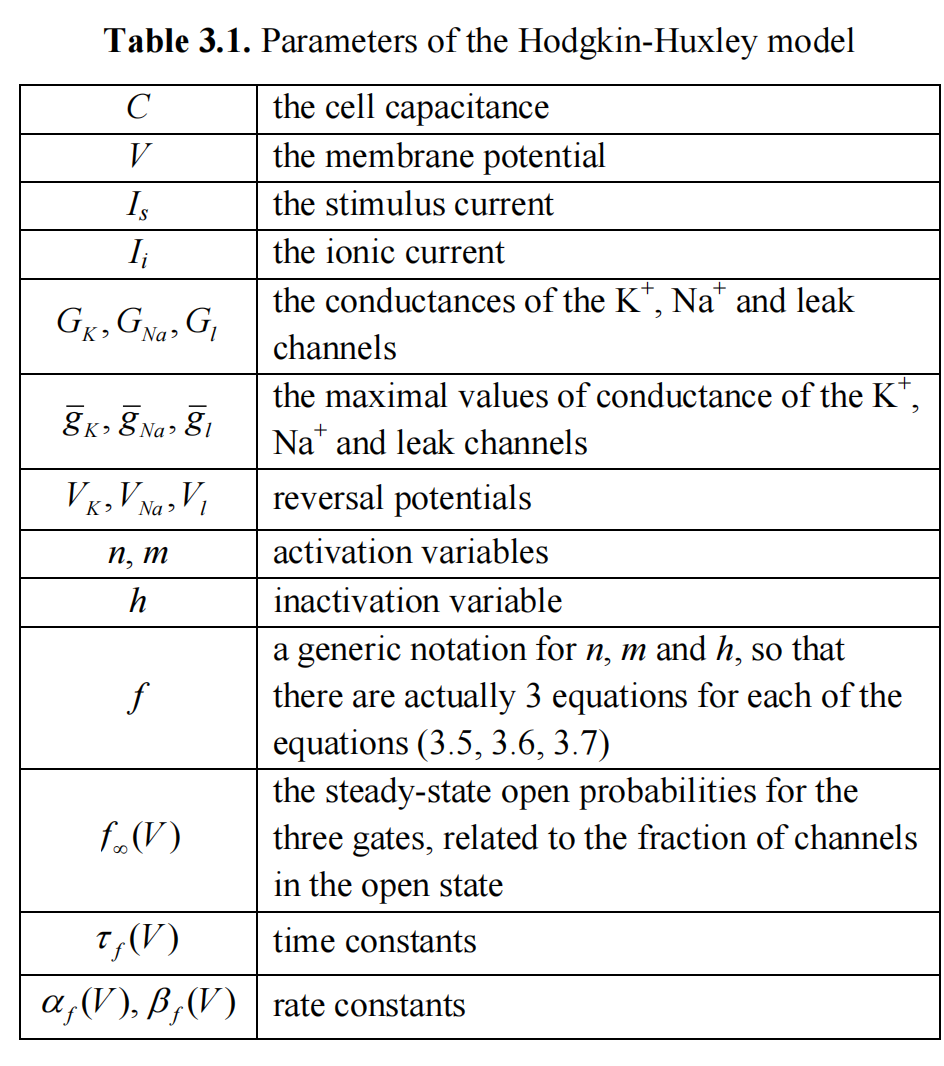

我们包含这些方程式是为了强调这一被广泛认可的神经元行为的数学模型的复杂性。然而,我们不打算深入讨论涉及的参数的含义和具体数值。这些参数在表3.1中简要列出(Nelson, 2004; Coombes, 2010; Wells, 2010)。

这些参数的值是近似的,以使方程式与实验数据吻合。我们应该提到,方程式(3.5、3.6、3.7)与原始论文(Hodgkin & Huxley, 1952)中的方程式略有不同,因为当前使用数值技术如欧拉方法来解决微分方程,而在1950年代,作者们不得不使用更为原始的方法进行手工计算(Wells, 2010)。此外,他们研究中使用的乌贼的动作电位数值与人类神经元中测量到的数值有些许不同(见图2.3)。

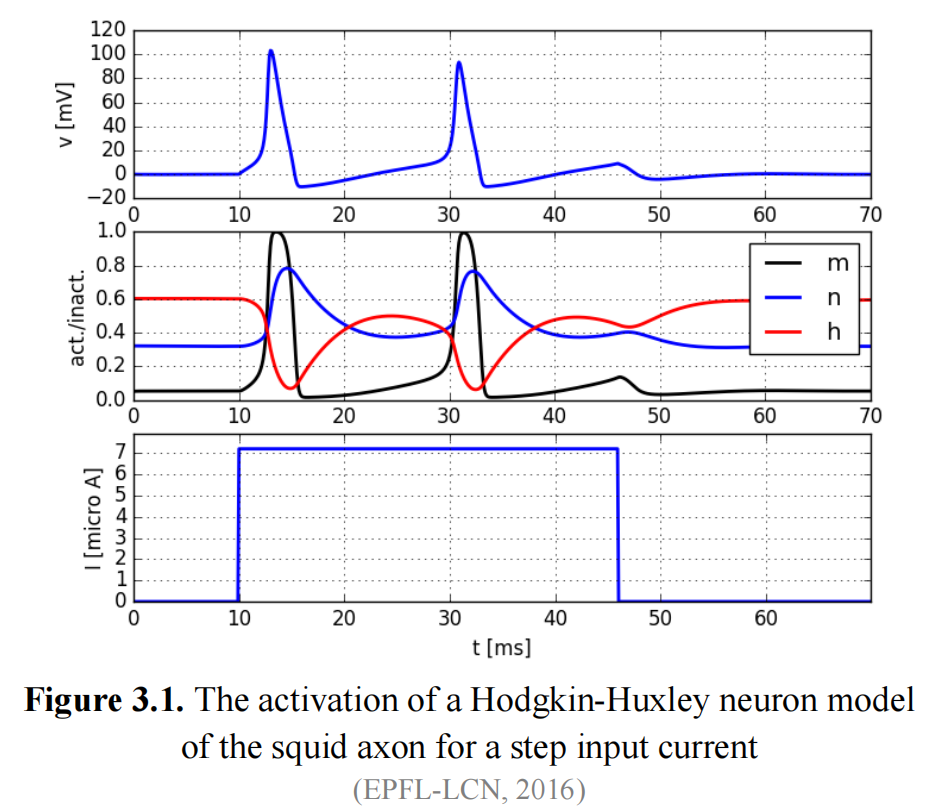

当没有外部刺激时,Hodgkin-Huxley模型的动态会达到稳定状态,即静息电位。因此,为了产生一个动作电流,必须添加一个刺激电流 Is。图3.1展示了在加入阶跃输入电流的情况下,Hodgkin-Huxley神经元的表现示例。

3.2. 伊热凯维奇模型

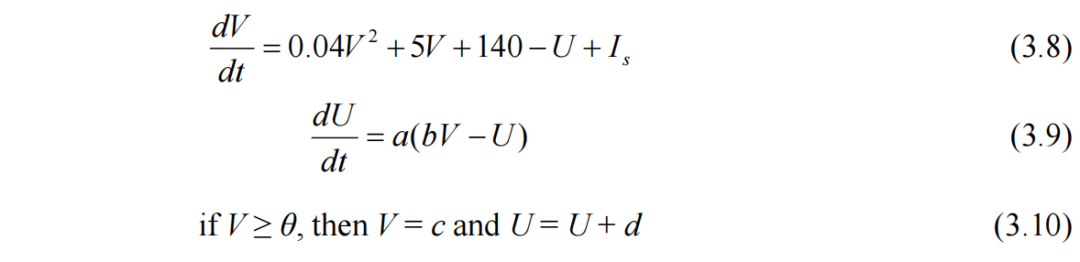

正如我们所看到的,Hodgkin-Huxley模型非常复杂。Eugene Izhikevich(2003年)设计了一个简单得多的模型,但却能够复现生物神经元中的大量行为。它仅由两个微分方程和一个非线性测试条件组成:

V和U被构想为无量纲变量;然而,通过将第一个方程中的系数与皮层神经元的动态拟合实验数据,可以将V解释为神经元的膜电位,而将U解释为考虑离子电流效应并对V施加负反馈的变量。该模型还为参数a、b、c和d提供了适当的值。通常阈值θ = 30。除了其用于模拟多种行为的潜力外,该模型的主要优势在于其计算效率。作者报告称,在1 GHz计算机上,可以以1毫秒的分辨率实时模拟数万个尖峰神经元(Izhikevich,2003)。

3.3. 积分-火和漏积分-火神经元模型

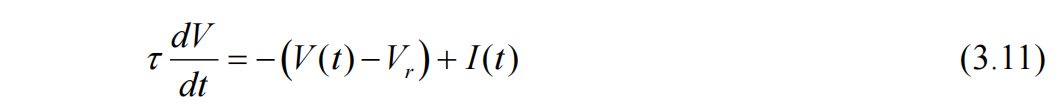

更简单的模型是漏积分-火(LIF)模型(Koch & Segev, 1998)。神经元的行为类似于一个积分器:当它接收到外部刺激或输入信号I时,其膜电位增加。膜电位随时间衰减,因此当没有刺激时,电压会缓慢返回到静息电位Vr。当电压V达到阈值时,神经元产生一个尖峰(动作电位),然后V被重置为Vr。类比于第3.1节中考虑的电路,LIF模型基于以下形式的微分方程(其中τ是膜时间常数,类似于学习率的倒数):

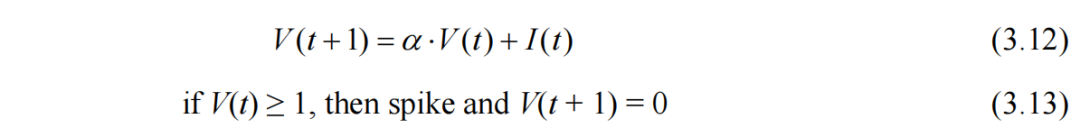

然而,软件模拟通常采用离散时间动态。因此,漏积分-火(LIF)模型的等效表述是(Jin et al., 2022):

在这个方程中,V代表膜电位或电压,I代表输入电流或刺激,α是泄漏或衰减因子,决定了膜电位随时间趋于零的速度。可以注意到方程(3.12, 3.13)模拟了一种标准化的活动,其中静息电位为0,产生尖峰的阈值为1。

可选地,在发生尖峰后,可以保持V = 0多n个时间步,模拟神经元无法产生另一个尖峰的不应期。在方程(3.12)中,α通常属于(0, 1)范围内,通常接近1(例如,0.9),而刺激I通常接近[0, 1]范围内的0,以允许多个时间步直到发生尖峰(例如,0.1或0.2)。

虽然比其他模型缺乏生物学细节,LIF提供了一种计算高效的方式来模拟尖峰神经网络。

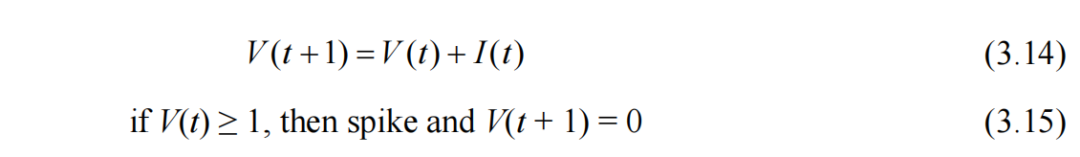

更简单的模型是积分-火(IF)模型,它与LIF类似,但不包括衰减因子:

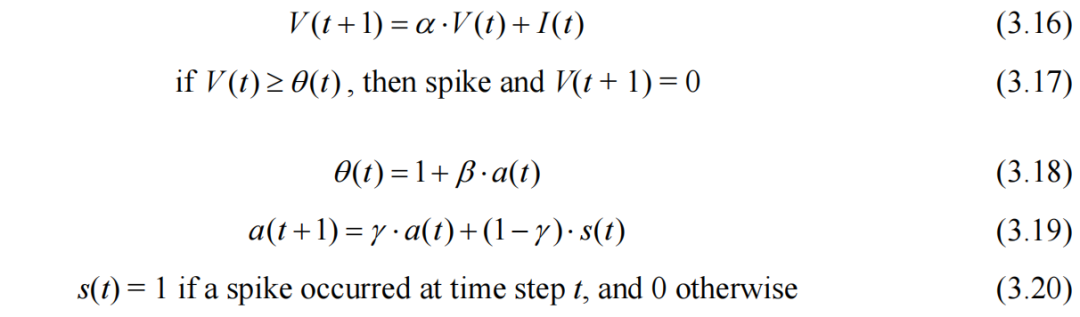

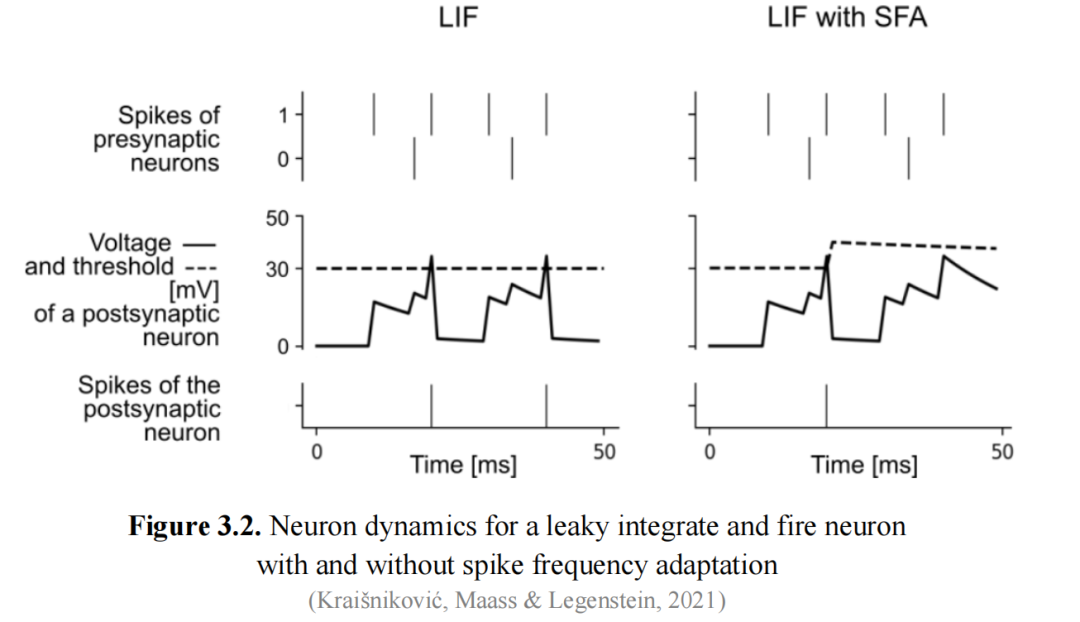

3.4. 尖峰频率适应

尖峰频率适应(SFA)是神经元中观察到的一种生理现象,即神经元在持续输入刺激下的射频率有逐渐减少的趋势。换句话说,当神经元接收连续输入时,其射频率逐渐降低,随着时间的推移生成的动作电位(APs)变少。这种现象也称为适应性,即神经元对输入的快速变化变得不太敏感,而对长时间尺度内发生的变化更为敏感。

当与LIF神经元结合使用时,SFA的思想转化为在神经元产生尖峰后增加其阈值,在没有尖峰发生时将阈值降低到其正常值(例如1)。以下方程描述了这一过程。使用θ(t)作为动态阈值,而不是1。β和γ是控制阈值增加和减少的参数。

Figure 3.2 展示了LIF神经元和带有SFA的LIF神经元之间的比较。从计算的角度来看,SFA可以具有各种功能上的影响,例如,它可以有助于调节在尖峰神经网络中兴奋性和抑制性信号之间的平衡(见第4节)。

3.5. 分区神经元

在许多模型中,包括多层感知器,突触被统一对待,没有考虑到特定的树突类型或树突处理。然而,与这种传统方法相反,分区神经元模型认识到区分不同类型的树突(即近端(基底)和远端(顶端))的重要性。在第10.1节中,我们将看到这种区分是如何应用于受到神经科学启发的分层时间记忆模型中。

近端(附近)树突靠近神经元细胞体,作为接收来自邻近神经元的传入信号的主要部位。远端(远程)树突从细胞体延伸得更远,通常进入神经元感受场的更远区域。

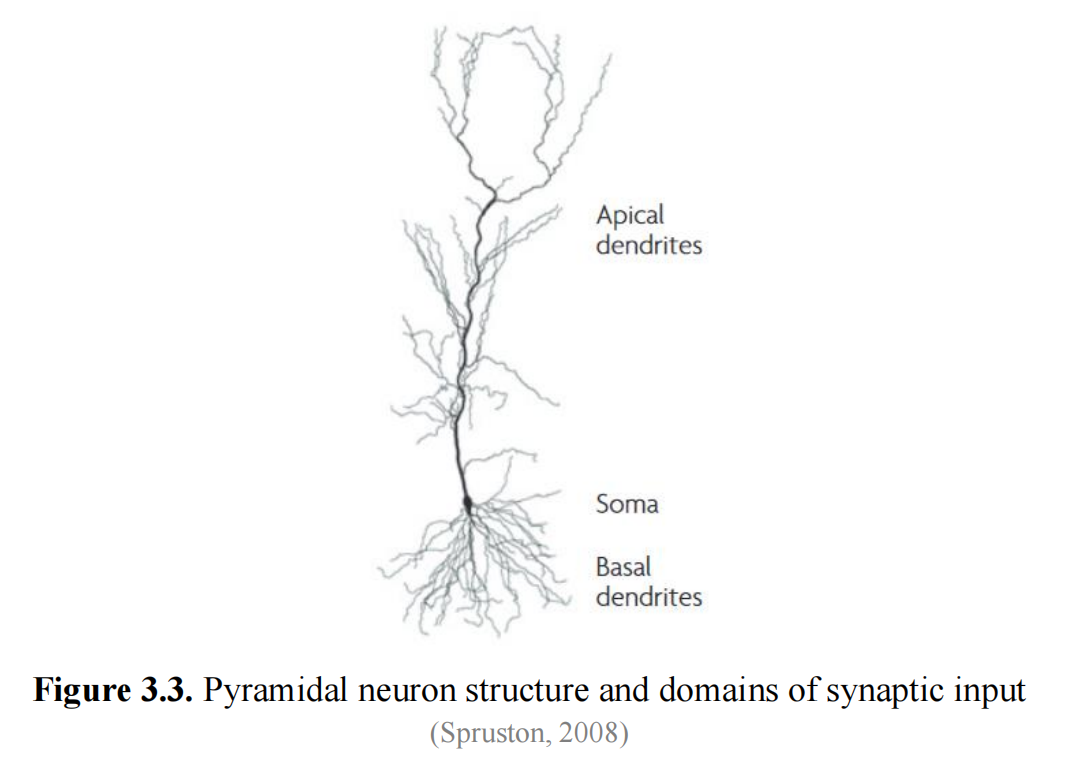

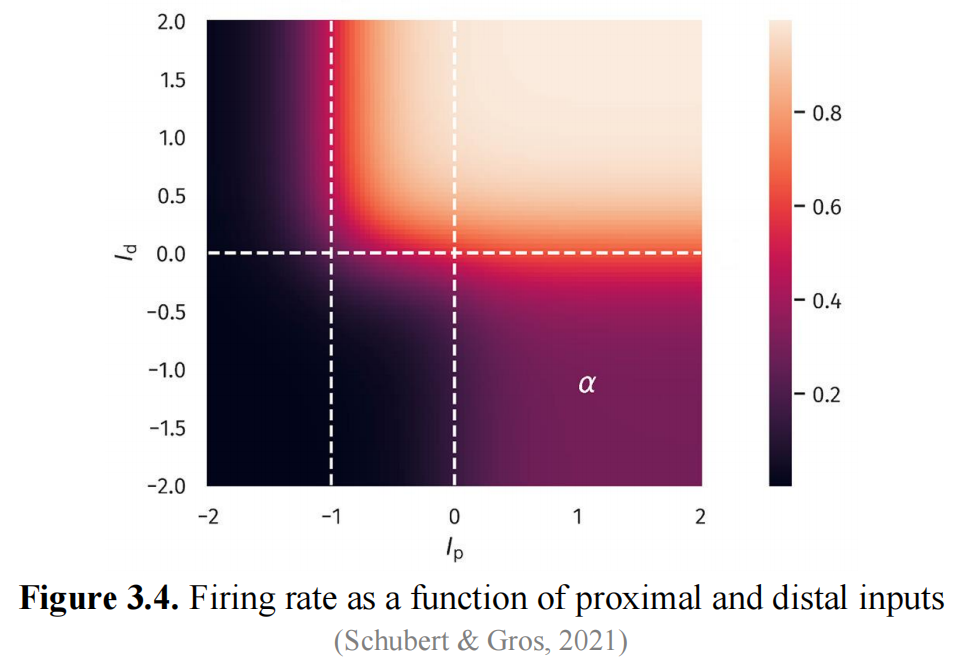

在(Schubert & Gros,2021)中,提出了一个两隔室模型,该模型解释了近端和远端输入之间的非线性相互作用。这项研究的主要动机是,皮质中生物锥体神经元细胞的一些动态特性无法使用简单的点神经元模型来重现(Spruston等人,1995;Häusser等人,2000)。当来自近端和远端来源的突触输入同时发生时,神经元表现出高尖峰活动,这比仅通过近端突触输入可能的最大放电率要大。这表明了一种远端和近端刺激之间的时间巧合检测形式。

这里提出的神经元模型是一个离散时间速率编码模型,即其输出表示神经元在某个时间步长的尖峰频率。实际上,这意味着它的输出是一个实数值,就像经典MLP神经元的输出一样。该模型假设两个不同的输入变量Ip(总近端输入)和Id(总远端输入)。它们可以是正数或负数,再次类似于MLP神经元的情况。隔室神经元的输出为:

该论文还在方程(3.21)中使用了某些阈值,但由于它们的值也被提供(例如,一些阈值被设置为0,另一个设置为-1),这些值被直接包含在内,以简化表达式。这个方程本身就是(Shai等人,2015)中描述的现象学模型的简化版本。

根据这个方程,在(Ip,Id)平面上有两个不同的神经激活区域,如图3.4所示。当输入电流Ip和Id都很大时,第二项占主导地位,导致y≈1。当Ip为正且Id为负时,会出现中等活动平台。因此,隔室模型区分了低活动水平的神经元(例如,在α=0.3时)和强烈爆发的神经元,其中最大放电率为1。在中等活动平台中,神经元在没有远端刺激的情况下处理近端输入。远端电流作为一个调制器。在图中,最大值为1的区域出现在右上角象限,两种类型的输入都处于活动状态,而值为α=0.3的区域出现在右下角象限。这意味着当只有近端输入处于活动状态时,只能达到最大放电率的30%。

4. 尖峰神经网络尖峰神经网络(SNN)旨在紧密模仿真实神经元的行为,强调神经信号的时间方面。与传统的多层感知器等人工神经网络不同,SNN使用离散事件(尖峰)来表示神经元激活。这些尖峰的时间和速率允许SNN捕获数据中精确的时间动态。

SNN的基本组成部分是尖峰神经元,它随时间累积输入信号,并在达到某个阈值时发出尖峰。神经元之间的突触连接由权重表征,这些权重决定了神经元活动对另一个神经元的影响。当一个突触前神经元发出尖峰时,这个脉冲(例如,归一化为1)乘以将其连接到突触后神经元的突触权重。然后,突触后神经元随时间整合加权输入。当其膜电位达到某个阈值(例如,也为1)时,它会依次发出尖峰,并重置其膜电位(例如,到0)。然后,这个尖峰通过相应的突触权重传输到其他神经元,影响它们的膜电位,依此类推。

4.1. 神经编码

SNN从生物神经元中获得比MLP更深入的灵感。神经元通信的一个重要方面是使用尖峰。生物神经元的另一个关键特征是稀疏性。神经元大部分时间都处于静止状态;在任何给定时刻,只有一小部分神经元处于活动状态。一个相关的概念是“静态抑制”(或“事件驱动处理”)。例如,在感觉系统中,神经元对输入的变化比对静态、不变的信号更敏感。这种对动态信息的响应性使大脑能够优先关注相关刺激,同时过滤掉恒定的背景输入(Eshraghian等人,2023)。这些原则导致了SNN中信号的编码和处理方式。

4.1.1. 速率编码

一种编码机制是速率编码,其中输入刺激x被转换为发射率或尖峰计数。输入的强度越高,产生的尖峰就越多。在这种方法中,感觉输入的强度对应于神经元的发射率。例如,更亮的光线导致更高的发射率,而更暗的输入导致更低的发射率。神经元在一定时间间隔内产生的一组尖峰被称为尖峰序列。在速率编码中,由于神经元的发射率是已知的(与x成正比)且恒定,因此产生的尖峰序列遵循泊松分布,用于描述在固定时间间隔内发生的事件数量。

设k为时间间隔内的总尖峰数,T为时间间隔的长度。那么平均发射率r = k / T。有两种常用的方法来生成泊松尖峰序列(Heeger,2000)。第一种是基于这样的想法:在一个短子区间Δt内发生尖峰的概率近似等于rt Δ。因此,总时间间隔被划分为一组短时间间隔(bin),并为每个bin生成一个均匀随机数ui ∈[0,1]。如果ui ≤ rt Δ,我们认为在第i个bin中发生了尖峰。

然而,这种方法的一个缺点是时间离散化。另一种方法是使用泊松过程的指数分布特性来计算尖峰之间的间隔,其概率密度函数为:

在实践中,可以生成均匀随机数ui ∈[0,1],并使用以下公式将它们转换为所需的指数分布:

与SNNs的特征离散尖峰不同,发射率是一个实数值,可以与MLP神经元的激活函数的输出进行比较。对于单个神经元,两者并不等同,因为SNNs中的尖峰序列包含MLP神经元的瞬时激活中不存在的时间信息。然而,在统计背景下,例如,通过分析SNN神经元群体,MLP神经元的激活可以被视为代表一组尖峰神经元的平均发射率。

4.1.2. 时间编码

另一种神经编码方法是时间编码。在这里,输入刺激的强度决定了尖峰何时发生。例如,首次尖峰时间机制将较大的刺激编码为较早的尖峰。

感觉系统中的神经元表现出对广泛动态范围内的刺激做出反应的巨大能力。因此,尖峰时间和输入特征强度之间经常使用对数关系。我们将在第11.1节中遇到这种对数关系,该节专门讨论大脑中数量(与数字相关的量)的表示。

时间编码作为一种神经策略,可以缓解速率编码的一些缺点。它使大脑能够快速准确地解码复杂的感官输入,这在需要快速反应时间的场景中是至关重要的。在感觉处理中,有一些情况,例如,速率编码太慢,无法提供人类受试者观察到的必要速度。这些情况包括:声音定位,短暂刺激需要快速响应,视觉编码,特别是在高对比度情况下的边缘检测,以及味觉和嗅觉系统中相似刺激的辨别。此外,大脑的能耗估计低于仅使用速率编码所需的情况。

虽然时间编码方案比速率编码更复杂,但我们可以提到,例如,在一种简化的形式中,(Park等人,2020)在名为T2FSNN(深度SNN的首次尖峰时间编码)的模型中提出的想法,具有编码和解码阶段。

编码阶段将动态输入(或膜电位)Vi转换为尖峰时间si:

其中i是神经元的索引,τ是时间常数,r是定义为后续解码(或发射)阶段开始时间的参考时间,δ是时间延迟。该模型假设一定数量的层,信号在层之间传播。τ和δ是每个层的可训练参数,但为了简单起见,它们可以对所有层具有相同的值。

在解码阶段,突触后神经元整合在前一阶段编码为单个尖峰的信息:

其中w是突触权重。神经元是IF神经元,因此它们在相应的时间连续整合每个尖峰,除了权重之外,由于指数变换,较早的尖峰具有更大的影响。

时间编码可以用于分类任务(Comșa等人,2020),基于其对应的输出神经元首先尖峰的类别。在生物学背景下,获胜神经元可以通过侧向抑制来抑制邻近神经元。在机器学习中,受抑制神经元的尖峰时间可以按后续尖峰的顺序建议替代预测。

相关文献还包括反向编码方法(Zhang等人,2019),其中输入刺激越强,相应的神经元就越晚发出尖峰。

4.1.3. 突发编码

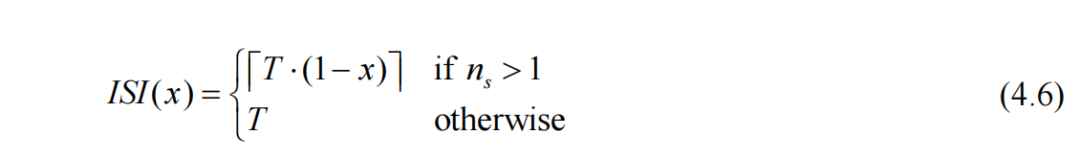

速率编码和时间编码是神经编码过程的两个极端。然而,还有其他类型的编码。例如,在突发编码(Park等人,2019)中,考虑一个归一化的刺激x ∈[0,1],神经元在时间间隔T内产生的尖峰数为:

其中nmax是尖峰的最大数量,通常不超过5(Buzsáki,2012)。

这些尖峰然后在指定的间隔内均匀分布,尖峰间间隔(Guo等人,2021)为:

因此,x刺激越大,尖峰的数量就越多,但与速率编码不同,它们是均匀分布的。突发也会导致不遵循泊松分布的尖峰序列。突发编码的优点是,在噪声存在的情况下,它比单尖峰时间编码更可靠。

4.1.4. 比较

速率编码和时间编码提供了不同的优势。速率编码通过随时间出现多个尖峰提供了容错性。这种冗余减少了错过事件的影响。此外,速率编码产生更多的尖峰,在使用基于梯度的算法时,这增强了学习的梯度信号。另一方面,时间编码通过产生更少的尖峰来实现更好的功率效率。这减少了专用硬件中的动态功耗,并由于稀疏性而最小化了内存访问频率。时间编码在需要快速响应的场景中特别有效,因为单个尖峰有效地表示信息,使其成为具有时间限制的任务的理想选择。这与生物学中的观察结果一致,大脑通过神经元中的低平均发射率来优化效率。

4.2. SNNs的计算能力

Maass(1997)表明,就某些任务所需的神经元数量而言,SNNs在计算上比使用sigmoid激活函数的MLPs更强大。他还证明了SNNs和MLPs作为通用函数逼近器是等价的。

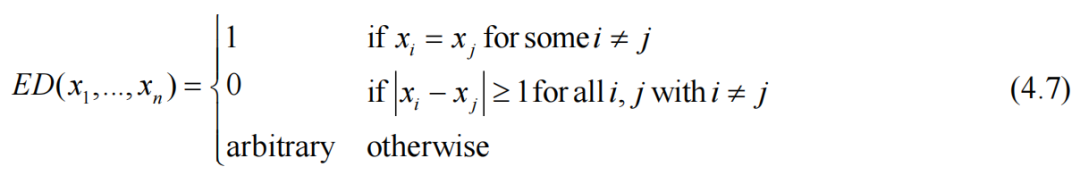

为了展示SNNs的(理论)优越性,他考虑了一个“元素不同性”函数ED:(ℝ+)n → {0, 1},定义为:

然后,他提出了一个不太直观的ED变体,定义为:

如果存在k ≥ 1,使得x1, x2, x3, x3k+1, x3k+2, x3k+3具有相同的值,则为1; 如果ℝ+中长度为1的每个区间最多包含3个输入xi的值,则为0; 否则为任意值。

作者证明了这个函数可以由单个尖峰神经元使用时间编码来计算,因为它只需要在两个相邻的三个突触块接收到同步兴奋性电位时才发射。他还发现了sigmoid MLP所需的隐藏单元数量的下限,对于n = 10000,这可能超过1000。

这绝对是一个巨大的差异,有趣的是,它是针对检测输入之间相似性的通用问题的版本发现的。从同一类别中,我们有xor问题,它不能由单层感知器学习。

进一步推广SNNs的通用性,在(Vineyard等人,2018)中描述了使用时间编码实现几种基本算法,例如计算最小值、最大值和中位数,排序,最近邻分类,甚至更复杂的神经模型,自适应共振理论,将在后面的第15.1节中描述。

4.3. 讨论

SNNs和MLPs在结构、行为和应用方面表现出差异和相似之处。

一个关键的区别是,SNNs显式地模拟神经元尖峰的时序,模仿真实神经元的时间动态,而MLPs将输入数据作为静态快照处理,没有显式的时间表示。SNNs可以使用更符合生物学的学习规则进行训练(在第5节中介绍),这些规则可以根据尖峰的精确时序调整突触权重,而MLPs主要使用梯度下降算法,如反向传播及其现代变体进行权重更新。此外,由于SNNs的事件驱动处理特性,它们往往具有更高的能源效率,仅在必要时激活神经元,而MLPs通常需要连续计算,因此消耗更多资源。

然而,它们也有相似之处。SNNs和MLPs都由相互连接的神经元层组成,适用于分类、回归和模式识别等任务。在SNNs中,神经元基于膜电位的积累和发射阈值产生输出尖峰,反映了MLPs,其中神经元使用输入的加权和后跟一个激活函数来计算激活。这两种模型都依赖于输入累积的思想,并且它们都包括对这个净输入进行非线性转换的思想。

SNNs具有各种优点和缺点,这些优点和缺点会影响它们在不同任务中的适用性和性能。

讨论它们的优点,与传统神经网络(如MLPs)相比,它们表现出更高水平的生物学合理性。SNNs擅长处理时间信息和序列,使它们适用于涉及语音识别、事件预测和时间序列分析的任务。它们通过尖峰模式编码时序的内在能力在事件顺序和时序至关重要的场景中提供了显著的优势。SNNs还表现出对输入噪声的鲁棒性,依赖于随时间推移的尖峰模式,而不是确切的连续值。

然而,SNNs也存在一些值得注意的缺点,需要加以考虑。首先,它们的复杂性是一个突出的挑战。与传统的NNs相比,开发和训练SNNs本质上更加复杂。在大规模网络中,由于硬件限制,可扩展性可能是一个问题。SNNs的学习和训练过程,特别是当使用生物学上合理的学习规则时,可能比MLPs中使用的反向传播变体更慢、更困难。此外,SNNs通常依赖于稀疏表示,这可能导致在某些应用中过度拟合或未充分利用可用资源。最后,SNNs的可解释性和表达能力带来了挑战。尖峰模式和网络行为之间的复杂关系可能使解释和理解SNNs的内部表示和决策变得更加困难。

尽管尖峰神经元是现实大脑建模的基础,但如果目标是解决认知能力,直接使用它们可能过于底层。这可能就像用汇编语言编写智能算法一样。这就是为什么,在第7节中,我们将描述在神经元组级别上运行的模型,称为“细胞集合”。

5. 学习规则

在本节中,我们将介绍几种神经网络的学习规则,这些规则比经典的反向传播算法及其最近的扩展更具生物学合理性。

反向传播被认为不具有生物学合理性,因为错误传播是通过与神经元激活不同的机制发生的。在等效的生物环境中,需要一个全局错误信号,提供关于网络实际性能与期望输出相比的信息,该信号需要从突触后神经元的树突传播到突触前神经元的轴突。实际上,这种通过网络向后传播以调整权重的明确的全局错误反馈并不存在,尽管确实存在错误后发生变化的想法。此外,梯度编码的实际数量没有生物学对应物。

总的来说,大脑中的学习依赖于更局部的学习规则,神经元根据邻居的活动模式调整它们的连接。

单层感知器中使用的简单delta规则可以被视为生物学上合理的,因为权重的变化取决于局部错误。正是通过MLP的隐藏层的梯度传播不太合理。

生物突触也表现出各种形式的可塑性,包括神经元尖峰的时间,这些可塑性更复杂,通常涉及超出简单基于梯度的调整的多个因素。

5.1. Hebbian学习

Hebbian学习描述了一种基于突触可塑性的基本学习原则,即神经元之间连接(突触)的强度能够响应神经活动而改变。它以唐纳德·赫布的名字命名,经常被总结为著名的短语:“一起激发的细胞(神经元),一起连接”。

Hebb的规则实际上是这样表述的:“当细胞A的轴突足够接近以激发细胞B,并反复或持续地参与激发它时,一个或两个细胞中会发生某种生长过程或代谢变化,使得A的效率,作为一个激发B的细胞之一,得到提高”(Hebb,1949)。简单来说,如果两个神经元经常同时活跃,它们之间的突触就会加强。如果神经元A总是在神经元B之前激发,那么从A到B的突触就会变得更强,使得A的活动在未来更有可能触发B的活动。

这一原则基于这样一种观点,即大脑中的学习和记忆形成是频繁一起激活的神经元之间连接加强的结果。

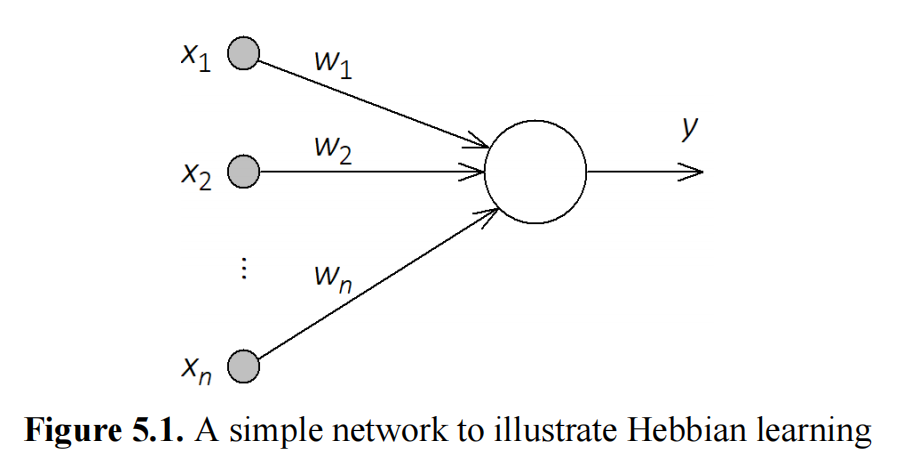

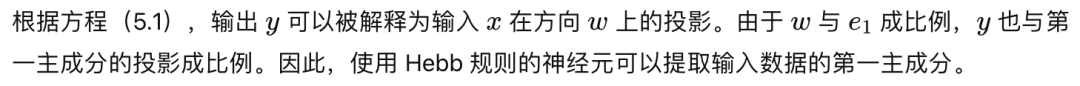

从计算的角度来看,这种学习规则通常是无监督的,涉及具有图5.1所示结构的网络。我们在这里介绍它对具有静态行为的神经元的应用,例如MLPs中的神经元,而不是尖峰神经元。这些神经元通常是简单的,具有线性激活函数。

这样一个简单的模型能够识别输入数据中最相关的变化方向非常有趣。然而,输入数据应当具有零均值,这可以通过从实际数据中减去平均值来轻松实现。

这种方法的主要缺点是权重向量会呈指数增长。这个问题通过接下来介绍的扩展来解决。

5.2. Hebb 规则的扩展

5.2.1. Oja 规则

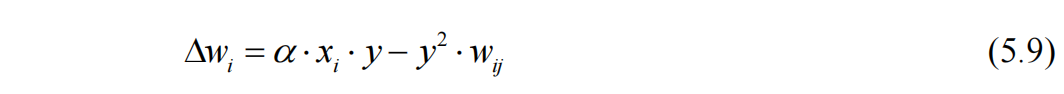

为了避免权重变得无限大,Erkki Oja 提出了一种称为减法归一化(Oja, 1982)的解决方案。它包含了一个竞争性或稳态项,限制了突触权重的增长。这个项有助于确保突触权重随时间收敛到一个稳定的范围。相应的权重更新方程是:

这个规则是一种权重归一化的形式,即当权重向量的一个元素增加时,其他元素会自动减少。在这种情况下,网络可能会忘记旧的关联:如果一个训练实例不经常被呈现,它可能会被遗忘。

由于它使用与Hebb规则相同的相关项,Oja规则也计算输入数据的第一主成分(Hertz, Krogh & Palmer, 1991)。

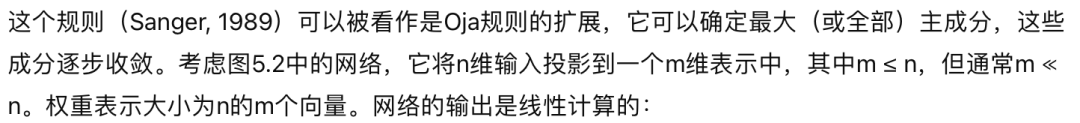

5.2.2. Sanger规则

第一个输出神经元相当于Oja模型,它学习了第一个主成分。由于涉及到对1到j的求和的减法,第二个神经元被迫寻找另一个主成分,依此类推。其结果是,权重收敛到一组有序的m个主成分(即相关矩阵C的特征向量)。

这突显了这类简单模型仅通过Hebbian关联就能提取输入数据分布中重要信息的能力。

5.2.3. ABCD规则

这是Hebb规则的一个广义版本,它不仅考虑了输入和输出之间的乘积,还单独考虑了输入和输出值,以及一个偏置项:

在这个方程中,A(相关项)、B(突触前项)、C(突触后项)和D(偏置或常数)是可以找到最优值的参数,例如,使用进化算法。这个规则被用于强化学习任务,其中进化的Hebbian规则足以让一个代理学会在一个2D环境中导航,并学会在一个3D环境中行走(Niv等人,2001;Niv等人,2002)。

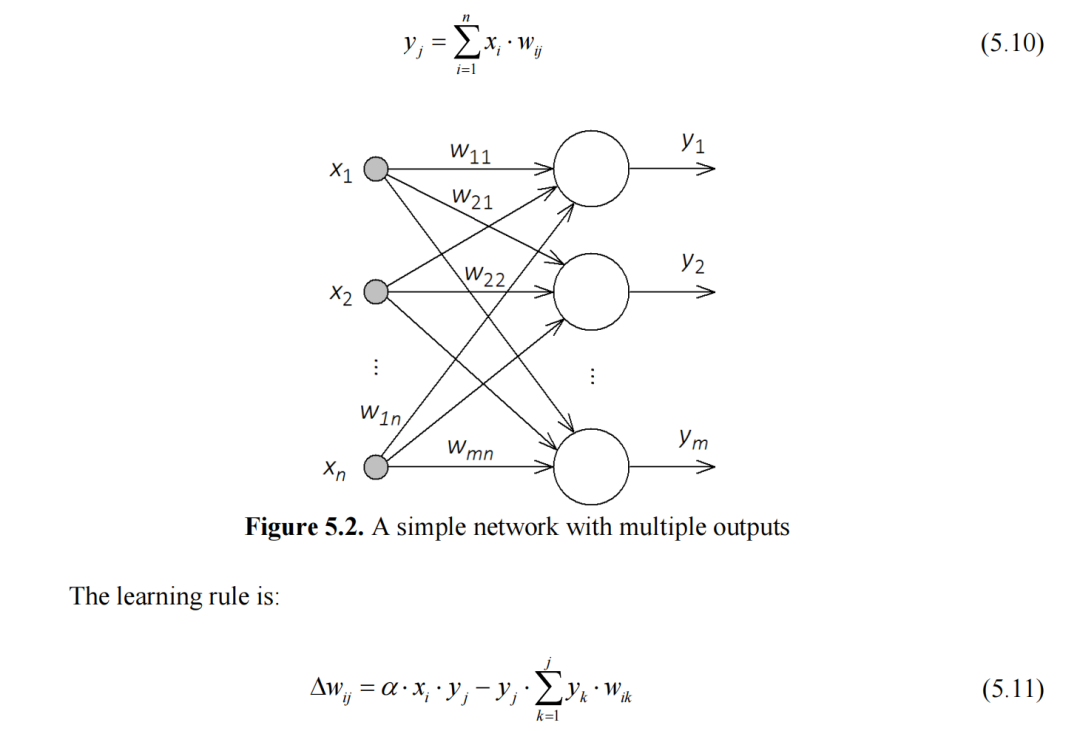

5.2.4. BCM规则

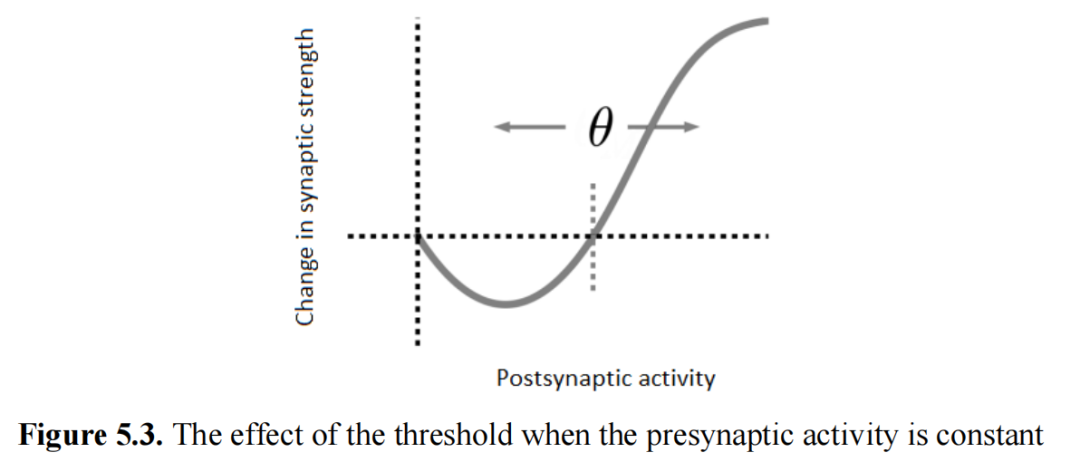

BCM规则(Bienenstock,Cooper & Munro,1982)建议使用另一种解决Hebb规则不稳定性的方法,该方法使用滑动阈值:

图中函数的形状与观察到的突触变化相似,例如,在视觉皮层中(Intrator & Gold,1993)。

5.3. 尖峰时间依赖性可塑性

在这一部分,我们将考虑突触前和突触后神经元尖峰的相对时间。在生物系统中,神经元不太可能完全在同一时间发射。

此外,只有当突触前神经元的激活导致突触后神经元的激活时,即两次激活之间存在因果关系时,突触才会增强。

尖峰时间依赖性可塑性(STDP)规则(Markram等人,1997;Bi & Poo,1998)认为,突触前和突触后尖峰之间的时间差决定了突触是增强还是减弱。当一个突触前神经元刚好在一个突触后神经元之前发射时,突触会增强,并进一步增强信号传输。相反,如果是突触后神经元在突触前神经元之前发射,突触会减弱,从而减少信号传输。

这些行为对应于与突触可塑性相关的两个重要过程:长期增强(LTP),意味着突触的持续增强,和长期抑制(LTD),意味着突触的持续减弱。根据STDP,突触前尖峰在突触后尖峰前几毫秒到达会导致突触的LTP,而突触前尖峰在突触后尖峰之后到达会导致突触的LTD。

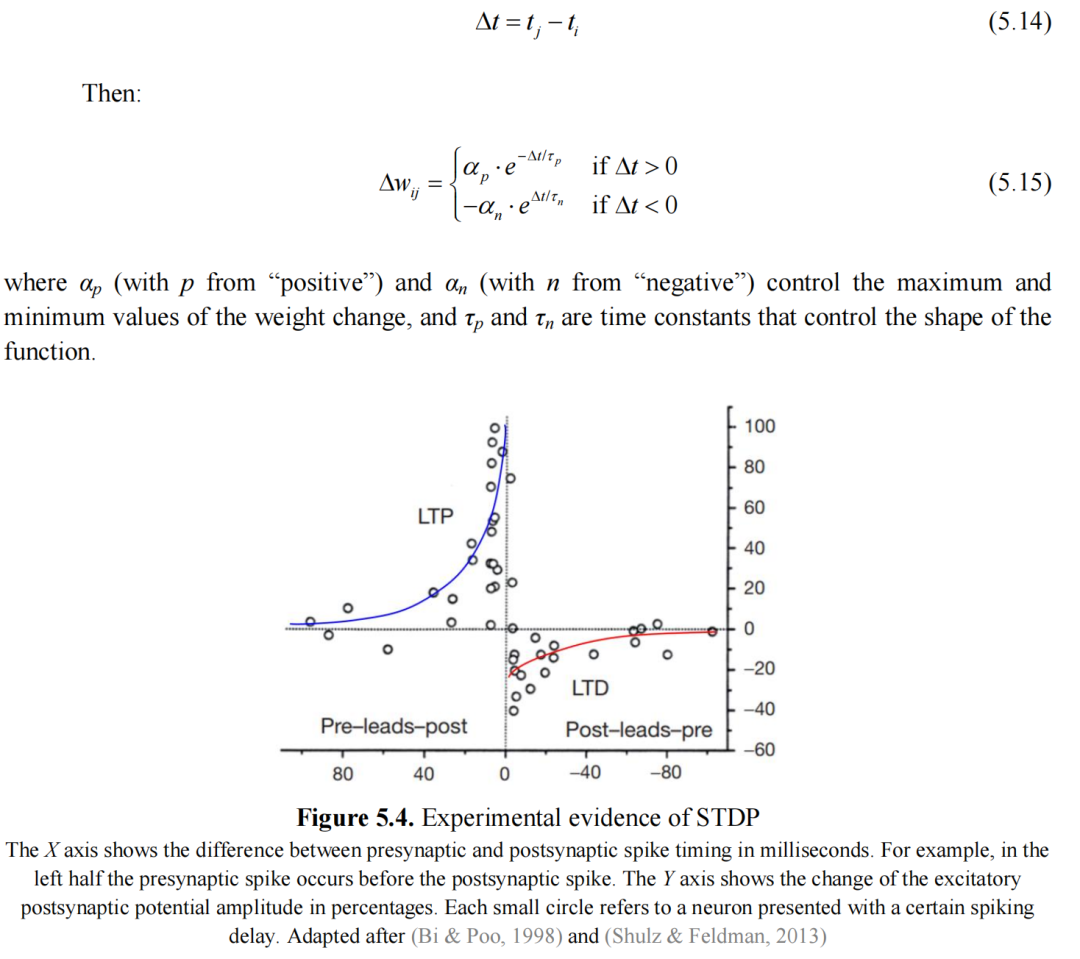

为了将这些想法形式化,设Δt为突触后神经元j的尖峰时间与突触前神经元I的尖峰时间之差:

图5.4展示了不同尖峰时间差对 postsynaptic potential 幅度变化的影响,这是根据 Bi 和 Poo (1998) 使用海马细胞培养中的神经元获得的实验数据。在大脑中,实际观察到了几种STDP的变体(例如Hebbian或反Hebbian),这取决于通过突触进行通信的神经元类型(例如兴奋性或抑制性)(Shulz & Feldman, 2013)。

可以看到,当两个神经元在短时间间隔内被激活时,可以获得最大的长时增强(LTP)和长时抑制(LTD)效应。如果前突触神经元在后突触神经元之前发放,突触强化效果最大。

从某种意义上说,Hebb规则可以看作是STDP的一种近似,考虑到神经元同时激活,并且前突触神经元对后突触神经元的激活有直接影响。针对基于速率的(非尖峰)神经元,提出了几种反Hebbian方程的变体,以解释LTD现象。例如,当前突触神经元活跃而后突触神经元不活跃时,突触会被削弱。

从生物学角度来看,前突触神经活动涉及到兴奋性神经递质谷氨酸的释放。相应的后突触活动与去极化的膜电位相关。这两个条件打开了N-甲基-D-天门冬氨酸(NMDA)通道,允许钙离子(Ca2+)进入突触。这种机制发生在树突水平。经过数个复杂的化学反应后,突触的效能发生改变。高浓度的钙导致LTP,而较低浓度导致LTD(O’Reilly & Munakata, 2000)。我们将在第10节重新审视与NMDA相关的过程。

然而,突触的强化也受到神经递质多巴胺的影响。当人们期待获得奖励时,多巴胺产生神经元被激活。影响情感反应和记忆最强烈的是奖励的期待,而不是奖励本身。当个体遇到意外的结果时,奖励学习过程发生。如果奖励超出他们的预期,多巴胺信号增加。相反,如果奖励低于预期,多巴胺信号减少。但是,正确预测奖励不会显著改变多巴胺信号,因为这不涉及新的学习(Halber, 2018)。

5.4. 其他学习算法

一般来说,针对训练脉冲神经网络(SNNs),提出了许多算法。有些算法使用STDP的变体,而其他算法则从反向传播中汲取灵感,设计了适用于尖峰神经元的算法,例如使用替代梯度,其中不连续的脉冲函数被可微函数近似。关于这类方法的综述可以参考(Han & Lee, 2021)。

一个尝试以生物学可信度方式实现反向传播思想的算法是GeneRec(Generalized Recirculation)(O’Reilly, 1998),也被应用在LEABRA(本地误差驱动和联想,生物真实算法)认知架构中,该架构最初由(O’Reilly, 1996)引入。GeneRec受到了重新循环算法(Hinton & McClelland, 1987)和递归反向传播算法(Almeida, 1987; Pineda, 1987)的启发。

GeneRec假设双向连接:从输入到输出以及反之(这也可以视为自下而上和自上而下)。学习分为两个阶段。在加法阶段,期望值被“固定”在输出层上。因此,输入值和期望值都被呈现给网络。由于网络是递归的,隐藏层神经元的激活取决于两者。在减法阶段,只呈现输入。根据几个假设和近似,建议的学习率是:

正如可以注意到的那样,方程(5.16)具有δ规则的形式。激活状态两个阶段的差异表明了一个单元对整体误差信号的贡献。双向连接将这个信号的两部分传播到整个网络中,因此学习可以基于这种差异进行。此外,激活状态局限于权重改变必须发生的突触位置。

6. 神经元集合(细胞组装)

唐纳德·赫布引入了细胞组装(CA)的概念,也称为神经元集合,用于描述对相关刺激响应中活跃的稀疏分布的小组神经元。它们代表了一组相互连接的神经元,共同执行大脑内特定功能,从简单的感觉处理到复杂的认知任务。

这些集合作为处理信息的功能单元,可以被视为大脑神经信息处理的基本组成部分。细胞组装假设(赫布,1949)认为,神经元集合作为概念的神经表示。随着时间的推移,这一假设得到了生物学、理论和模拟数据的支持。神经元集合可以对感觉刺激进行分类,使个体能够识别物体,但它们也可以在没有直接感觉输入的情况下被激活,例如在思考一个概念时。

由于它们由一组神经元组成,比单个神经元大但比整个大脑小,因此它们可以为研究心理学和神经生物学提供一个组织原则,并可能弥合心理学与神经生物学之间的差距。

神经元集合使用高发射率的神经元集合来表示概念(群体编码)。它们由一组相对较少的神经元组成,每个概念编码,估计的大小范围从

个神经元每个细胞组装。虽然大脑通常由以低频率(例如1赫兹)持续发放的神经元组成,但细胞组装神经元以高频率(例如100赫兹)发放。

细胞组装内的神经元在初始刺激后表现出自持续活动,即所谓的回响。它们之间有强烈的互相突触连接,当足够的子集被激活时,例如通过提及特定概念,它们会启动一个神经级联,这个级联会在初始刺激呈现结束后持续存在。这种持续的激活特征化为短期记忆(STM),可以持续几秒钟。

细胞组装内的神经元集合通过突触权重变化、神经生长、神经细胞死亡和突触增长等过程形成。高度的互相突触强度是赫布学习的结果。这些神经元之前曾一起对早期刺激作出响应,导致它们之间的突触连接强化。因此,细胞组装通常是通过重复呈现类似刺激形成的,因此它们也可以被认为代表长期记忆(LTM)。

相关的神经元放电,或称同步,在响应相同刺激或引发相同动作的神经元同时放电时被观察到。同步被认为是细胞组装协同工作的标志。研究表明,同步神经放电可以是将感知元素绑定在一起并协调大脑区域活动的机制。

细胞组装可以重叠,个别神经元可以参与多个细胞组装。一些神经元可能比其他神经元更加核心或关键于某个细胞组装。此外,细胞组装是活跃的实体,通过兴奋或抑制影响其他组装。它们可以招募新的神经元,失去神经元,或分裂成不同的细胞组装。此外,细胞组装是动态和灵活的,能够根据经验重新配置自己。这种可塑性使大脑能够适应或在不断变化的环境中学习。

个别细胞组装之间的关联可以支持符号基础化(在第17.4节中讨论),即符号获取意义的过程。学习得到的细胞组装可以直接来源于环境刺激。

尽管有大量证据显示细胞组装的持久性,将这些证据与预测记忆强度和持续时间的模拟和心理学理论联系起来仍然是一个挑战。现有的细胞组装模型要么无限期地持续下去,要么在相对短的时间内停止,缺乏记忆强度与神经放电之间的稳健联系。快速形成细胞组装也是一个问题,特别是在区分语义和情节记忆时,语义记忆可能需要重复呈现以形成细胞组装。细胞组装形成的动态可能非常复杂,可能涉及遵循神经连接中的幂律动力学的神经雪崩等现象。

每个神经元集合都专门用于特定的功能或任务。例如,在视觉皮层中,有专门用于识别面部的神经元集合,而其他集合则负责检测运动。在海马体中,神经元集合负责编码和检索记忆。在回忆过去事件或学习新信息时,特定的集合会变得活跃并同步它们的活动模式。神经元集合还参与感觉处理,例如在视觉皮层中,不同的集合对特定的视觉特征如边缘、颜色或运动作出响应。这些集合中神经元的集体放电模式允许对复杂视觉场景进行感知和解释。

传统的记忆研究集中在确定记忆存储的位置,即哪些细胞或大脑区域代表记忆痕迹。这些记忆的物理表现称为“记忆印记”(memory engrams)。最近的实验表明,特定神经元群体的相互作用和重新激活,而不是记忆在特定区域的局部化,可能是大脑记住过去经历和想象未来行动的主要机制。神经元集合之间的相互作用对将序列活动模式转化为记忆以及通过记忆的重新激活组合复杂行为至关重要。

当经典的人工神经网络在学习完一个初始任务后,再学习新任务时,它们在第一个任务上的表现通常会显著下降。这个问题被称为灾难性遗忘,是神经网络领域的一个持续性挑战。持续学习指的是神经网络在学习多个任务时能够顺序地学习,而不会忘记从前面任务中获得的知识。与人工神经网络不同,人类大脑能够顺序学习和记住多个任务,而不会经历灾难性遗忘。负责这种能力的机制尚未完全理解,但在神经科学领域得到了积极研究。

一个假设是,一旦形成了记忆,大脑会限制对记忆重要的突触连接的可塑性。对于新任务会建立新的连接,而与之前任务相关联的连接会降低可塑性,以保留已获得的知识。

另一个提出的机制是,大脑在不同的神经元集合中编码记忆,在不同的上下文中使用不同的神经元集合来编码记忆。这种方法减少了记忆之间的干扰,并防止灾难性遗忘的发生。

7. 神经元集合模型

在本节中,我们将介绍几篇利用神经元集合概念进行计算任务或神经科学研究的论文的贡献。

Papadimitriou等人(2020年)提出了一个名为“组装微积分”的计算模型,旨在弥合神经元尖峰活动水平与整个大脑水平之间的差距。他们确定了一组神经元集合上的操作,通过分析方法和模拟展示了它们的可行性。

该模型侧重于兴奋性神经元的集合,这些神经元可能构成人类更高级的认知功能,如推理和规划,以及与实验结果一致的句法语言处理。它定义了几个高级过程,可以转换为神经元操作,类似于高级编程语言被编译成机器代码。

组装微积分采用了简化但现实的神经元和突触表示。使用了几个区域,象征着大脑皮层的不同部分。每个区域都有一群通过随机突触连接的兴奋性神经元,形成循环回路。不同区域之间也有随机连接。

这篇文章采用了赫布学习,并结合了较慢时间尺度上的突触权重重新调整。这种调整旨在保持每个神经元的前突触权重总和相对稳定,类似于一个稳态过程(或遗忘过程)。为了避免对抑制的明确建模需求,在任何给定区域内,固定数量的神经元在任何给定时间点都会激活,即那些具有最高激活水平的神经元。这是一种k最大值选择(k winners take all, kWTA)功能。尽管kWTA由于其对激活状态和排序机制的全局信息要求在生物学上不太可能,但它提供了抑制动态的计算有效近似。在本文中,这个概念被称为capping,并且在LEABRA认知架构(O’Reilly, 1996)等地方也有应用。

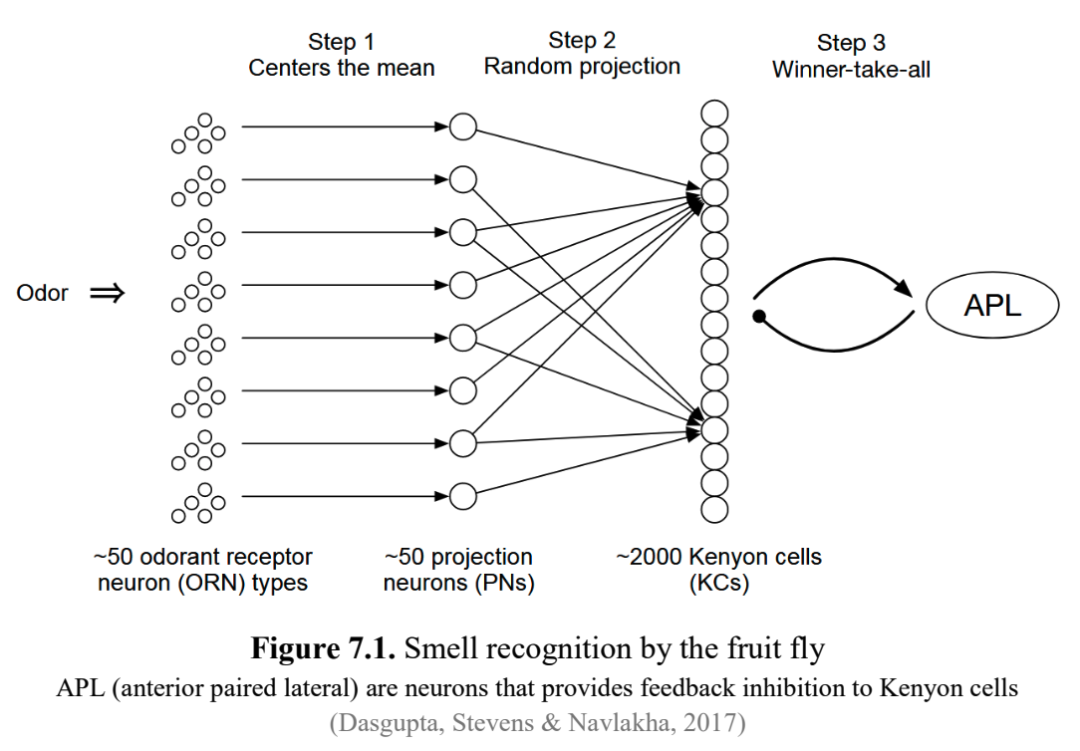

一个kWTA的例子是果蝇(Drosophila melanogaster)如何识别气味,如图7.1所示。果蝇大约有50种气味受体(气味分子)。感觉神经元与其他50个神经元一对一连接,这些神经元又随机连接到2000个神经元(Kenyon细胞)。在这个阶段,由于抑制作用,大约只有100个Kenyon细胞被激活并表达出对气味的识别。这个过程可以建模为有100个胜者的kWTA。

在组装微积分中,随机投影和capping操作的有趣之处在于,投影可以看作是源神经元集合的低维表示。例如,如果两个不同的输入在区域A中创建重叠表示,那么在区域B中对应的投影也会重叠。这可以导致在区域B中进行低维空间中的近似最近邻搜索,而不是在区域A中的原始空间中。

组装微积分计算模型是通用的,不依赖于为特定任务设计的预先存在的神经回路。功能性,包括集合操作,是由网络内部的随机性和高输入值神经元的选择产生的。这种功能性是简单事件的结果,如一个集合的重复激活。主要操作如下所示。

在关联皮层中,假设神经元群通过从一个区域到另一个区域的投影形成集合。例如,考虑两个区域A和B。A区中激活度最高的k个神经元在B区激活。B区中激活度最高的k个神经元则向B区的其他神经元激活。从A到B的重复激活结合B自身的递归激活,增加了连续回合中B区中激活神经元的重叠。因此,投影在下游区域复制了一个集合,确保新形成的集合在原始集合激活时也会激活。集合内部连接密集,意味着同一集合内的神经元相比于位于不同集合内的神经元更有可能连接。尽管在稀疏图中寻找密集子图的计算复杂性很高,但集合的存在可以通过投影创建集合来解释,从而增加突触连接性。

互相投影代表了投影的一种精细化形式。就像标准投影的情况一样,当区域A中的集合x激活时,它会触发区域B中一组神经元(标记为y1)变得活跃。主要区别在于,除了从A到B的连接外,还存在从区域B回到区域A的突触连接。在下一步中,集合x略微偏移,变为x1,而y1变为y2。这个过程迭代继续,直到收敛为止。最终形成的集合y展示了在集合x内部和集合x之间都有强大的突触连接。这与常规投影形成对比,常规投影中突触连接是单向的,只从x到y。

模式完成发生在集合内部的一小部分细胞激活时,整个集合以高概率激活的情况下。由于递归连接的存在,集合内的少数神经元部分能够触发该集合中绝大多数神经元的激活。

通过关联,两个现有的CA由于反复的同时激活而收敛。这种共同发射加强了它们神经元之间的联系,增强了重叠并提高了相应组装体的相互连接性。这个操作表达了使用连接到人类受试者海马体的电极的实验的想法(Ison,Quian-Quiroga & Fried,2015)。他们展示了熟悉的地方图像,并观察到每个地方都有独特的神经元激活。同样,名人的图像引发了独特的神经元放电模式。当他们同时显示一对人-地方图像时,特定的神经元做出反应,一些与地方有关,一些与个人有关。在反复暴露于这些组合刺激后,先前不同的神经元组装开始重叠。最初只对一个刺激(一个人)有反应的神经元开始与其他刺激(一个地方的形象)相关的神经元一起发射,突出了不同刺激之间的关联关系如何随着时间的推移改变神经组装配置。

合并操作是最复杂和最精细的操作。它可以被视为双重互惠投影。当组装体x和y分别在区域B和C中反复发射时,最终会在区域A中形成一个新的组装体z,这也会改变原来的组装体x和y。在生成的组装体中,x和z之间以及y和z之间出现了强烈的双向突触连接。合并操作在创建层次结构方面具有重要作用,并被认为是语言句法处理和层次思维过程的贡献者。这被应用于设计一个强调语言处理中句法方面的皮质架构。

(Dabagia,Vempala & Papadimitriou,2022)证明了组装演算框架可以用于分类。该论文证明了新的组装体可以可靠地形成以响应来自不同类别的输入并保持可区分,特别是当这些类别合理地分开时。

(D'Amore等人,2022)实证表明,复杂的规划策略,如解决积木世界任务的启发式方法,可以在组装演算中有效地实现,并提出了一种解决此类问题的近似策略。然而,它也强调了规划所需表示的限制,这些规划涉及长链的强连接组装体;具体来说,对长链的可靠实现存在限制。这个想法是,一个积木堆被建模成或多或少像一个链表,连接到一个头节点。当顶部积木被移除时,它与头节点的关联通过权重归一化(稳态)慢慢被遗忘,并且学习积木与其新相邻节点之间的新关联。

(Xie,Li & Rangamani,2023)讨论了两种组装演算操作的使用,即从刺激创建组装体的投影和实现变量绑定的互惠投影,这是一个具体对象(变量)被绑定到由其关系确定的抽象结构的过程,或者换句话说,由不同CA编码的项目如何可以被组合在各种设置中使用。它类似于谓词逻辑中用一个事实替换一个变量(我们将在第13节后面关注的一个重要概念)。研究表明,互惠投影的容量低于投影,但提出了一种跳过连接方法,增加了容量,并为使用神经元组装探索层次模型提供了机会。

(Huyck,2007)表明,高度循环的神经网络可以学习以CA形式的回响电路。它们有能力对其输入进行分类,该论文探讨了它们学习层次类别的潜力。基于尖峰疲劳泄漏积分器的模拟器用于建模,学习是通过一种Hebbian学习形式实现的。重叠的CA允许神经元参与多个CA,增强了网络的分类能力。包含CA的NN可以根据感官信息学习和适应,CA通过无监督学习形成、增长、修改和分裂。这样的网络充当分类器,CA代表类别,当一个实例属于一个类别时被激活。在论文中的例子中,网络被划分为识别10种动物特征的神经元,包括那些特定于动物类别的特征(例如,狗、猫和老鼠的特征0到2),以及所有哺乳动物的共享特征(特征3和4)。其他特征与尾巴和饮食习惯有关。与这些特征相关的神经元根据动物实例中特定特征的存在而被激活。模拟显示了层次分类的出现:神经网络识别四个类别:狗、猫、老鼠和哺乳动物(超类)。这是通过形成重叠的CA实现的。例如,狗和老鼠与猫共享特征,而哺乳动物包含其大多数子类共有的特征。

这种层次结构的一个优点是能够执行默认推理。经过训练的网络可以根据其超类的特征推断出新类的属性。给出了一个例子,当网络面对熊的一个实例时,它使用默认推理根据哺乳动物超类的特征推断出熊是杂食动物。

SHRUTI(Ajjanagadde & Shastri,1991;Shastri,1999)是一个反射推理的生物合理神经模型。它表明,对于一个庞大的通用和特定知识的体系进行系统推理可以是神经系统自发和自然的结果。人类具有快速高效地进行各种推理的先天能力,类似于反射反应。认知科学和计算神经科学面临的挑战是解释一个类神经元元素的网络如何表示广泛的知识并进行快速推理。SHRUTI模型展示了神经网络如何编码语义和情景事实、规则和知识,实现广泛的快速推理。

关系结构由细胞群表示,推理涉及这些细胞群上的节奏活动传播,以及适当细胞的同步发射。涉及关系知识的推理对应于这些焦点群集上节奏活动的瞬态传播。

SHRUTI提供了一个详细的计算账户,说明如何使用同步活动来表示和处理高级概念知识和推理。

在SHRUTI中,“理解”对应于沿着神经回路闭合环路的连贯活动。该模型通过适当细胞的同步发射来表示在给定情况下概念角色和满足这些角色的实体之间的绑定。LTM中的事实被编码为时间模式匹配电路,检测正在进行的节奏活动流中的巧合和巧合失败。例如,基于包含断言give(John, Mary, a-Book)的知识库,对问题“玛丽是否拥有一本书?”的回答导致了图7.2中所示的那种激活模式。绑定通过角色和实体节点的同步激活来表达。每个尖峰表示适当节点集合中细胞的同步发射。 SHRUTI模型的一个局限性是,尽管概念以神经方式编码,但它们并没有基础,而是任意的,就像在经典符号表示中一样。

(Tetzlaff等人,2015)提出,Hebbian意义上的突触可塑性和较慢的突触缩放过程的结合实现了两个关键目标:CA的形成和神经动力学多样性的增强。突触缩放是一个调整神经元之间连接强度的过程,以保持活动水平的平衡。当活动高时,它会削弱突触,当活动低时,它会加强突触,确保稳定的神经功能。该研究引入了一种基于不同时间尺度上神经和突触过程相互作用的机制。它的目标是在长期内实现CA的自组织形成,同时在短期内执行非线性计算。主要的动机是大脑中CA的形成需要适应性地学习和适应新信息,但它也应该是稳定的,不会迅速改变。这表明,使学习成为可能的突触可塑性必须由作用于更长的时间尺度的过程(如突触缩放)来稳定。分析结果表明,突触可塑性和缩放的结合非常适合实现多个CA的共存,因为这很难通过其他突触可塑性规则或机制(如抑制或短期可塑性)来实现。

(Buzsáki,2010)建议,理解大脑中的CA应该关注它们如何影响下游的“阅读器-执行器”机制。换句话说,一组活跃神经元或假定的CA的重要性只能通过考虑它们产生的明确输出来确定。为了识别有意义的组装体,检查这些神经元之间的同步性是很重要的,而这种同步性从一个能够随时间整合事件的阅读器机制的角度来看变得有意义。这种方法不同于仅基于神经元连接性而不考虑其功能影响的CA的替代观点。

该论文介绍了CA及其激活序列可以被理解为具有层次神经语法的观点,类似于语言。这种句法组织定义了组装体之间的关系,促进了大脑中的通信和计算。离散组装体的时间排序产生了“神经词汇”和“句子”,并使复杂的认知功能(如回忆、思考、推理和计划)成为可能。

突触权重的动态变化被称为“突触体”,它们被认为在连接不同的尖峰CA中起着重要作用。突触体有两个重要的功能。首先,它们将神经组装体的寿命限制在短时间范围内,通常持续从亚秒到秒。这种时间约束有助于组装体活动的组织和终止。其次,突触体通过改变神经元之间突触连接的强度,即使在没有任何正在进行的尖峰活动的情况下,也能弥合不同CA之间的差距,从而连接被不活动期隔开的神经元词汇。突触体的这种双重作用被认为是理解大脑功能连通性如何随时间演变的关键。

(Huyck,2020)概述了一个神经认知架构的建议,该架构旨在紧密接近人脑的神经和认知功能。它使用尖峰神经元作为其基本单元,强调它们有效地近似生物发射行为和突触修改的能力。所提出的架构可以帮助阐明神经网络如何产生认知功能,促进各种系统(如基于规则的系统和联想记忆系统)的整合,并使在认知任务背景下探索神经行为成为可能。

(Valiant,2005)提出了神经模型,这是一种关于神经系统及其计算能力的原创观点。主要的贡献围绕着两个主要计算功能的开发:记忆形成(一个“连接”功能)和在神经系统中已经表示的项目之间的关联(一个“链接”功能)。这些功能被设计为与生物系统中观察到的神经参数一致。

文章强调了在实施这些功能时不产生有害干扰或副作用的必要性,确保它们不会破坏先前建立的神经回路或导致意外后果。此外,它探索了使用随机图作为在神经系统内实现记忆和关联任务的计算框架的概念。它表明,即使突触强度相对较弱,随机图也可以用于创建记忆形成和关联路径。识别它们意想不到的计算能力是一项重大贡献。该论文还引入了用于神经网络内部通信的节点链的概念,扩展了之前的提议,如“同步链”。它强调这些通信链必须在网络中无处不在,而不是局限于特定区域。

8. 动态模型

神经动力学研究神经元发射状态的持续变化、同步模式的出现以及神经群体的集体行为。这些研究为感知、认知和其他各种神经现象的潜在机制提供了很好的见解。这些动态过程对于理解大脑如何管理信息、编码记忆和产生复杂行为至关重要。

在本节中,我们将从三个角度介绍大脑的动态模型。第一个与一组描述大量神经元网络活动的方程有关。第二个指的是一类被称为“储层计算”的计算动态模型。第三个展示了一些表现出可以用混沌理论方法分析的复杂行为的模型,例如,强调神经群体行为中吸引子的存在。

8.1. Wilson-Cowan模型2

在1970年代,Wilson和Cowan发表了两篇革命性的理论神经科学经典论文。在他们的第一篇论文(Wilson & Cowan,1972)中,他们引入了一组耦合方程,提供了由兴奋性和抑制性神经元群体组成的网络动力学的粗粒度描述。粗粒化涉及以较低的分辨率(从更高的角度)表示系统;在我们的案例中,它是关于描述神经元群体的行为,而不是单个神经元。第二篇论文(Wilson & Cowan,1973)将他们的工作扩展到包括空间依赖性。这些结果标志着计算神经科学领域的转折点。

在1960年代,许多与Wilson-Cowan方程有关的核心概念已经被提出,但它们还没有被整合到一个统一的模型中。Wilson和Cowan的目标是开发一个全面的神经元活动描述,明确考虑兴奋性和抑制性细胞之间的区别。他们的灵感来自于生理学证据,表明存在对外部刺激有类似反应的特定神经元群体。

以前的研究和模拟探索了空间局部化的神经群体。这些研究使用了各种方法,包括离散和连续时间模型。然而,它们都使用单一变量(如每单位时间变得活跃的细胞比例)来描述某一时刻的群体状态。

鉴于大脑的复杂性和对微观细节的有限访问,人们认为有必要采取统计方法,涉及平均场理论等概念。挑战在于确保丢失的信息对于理解感兴趣的现象并不关键。 平均场理论最初是为磁性开发的,作为一种粗粒化方法,用于通过简化系统中单个粒子或组件之间的相互作用来描述和分析复杂系统的行为,从而使研究更容易处理。平均场理论背后的关键思想是通过将组件之间的相互作用视为受到其他组件产生的平均或“平均”场的影响来近似它们的效果。换句话说,系统中的每个组件都与所有其他粒子创建的有效、平均场相互作用,而不是考虑与每个单独实体的特定相互作用。这种简化允许人们获得分析解决方案,这些解决方案提供了对系统集体行为的洞察,即使当个体相互作用非常复杂且难以精确建模时也是如此。这种方法类似于使用统计热力学将粒子的低级布朗运动与温度、压力或扩散等高级特性联系起来。

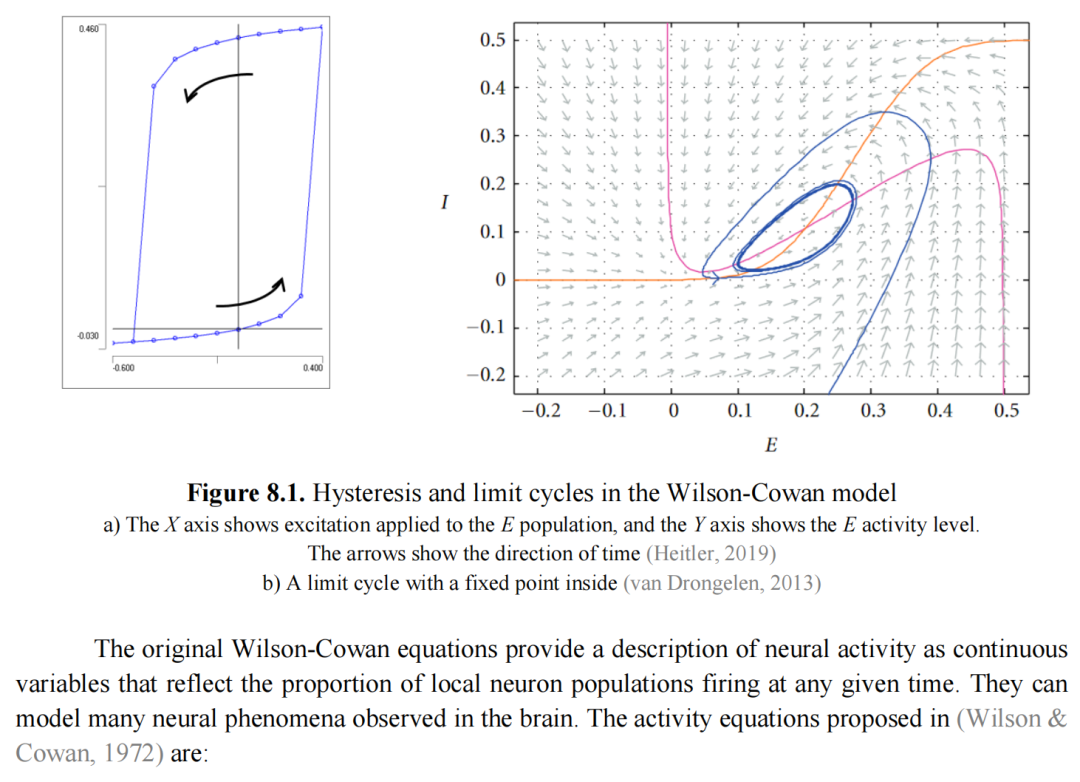

Wilson和Cowan根据Dale原理明确考虑了兴奋性和抑制性神经元两个不同亚群之间的相互作用。作者表明,他们的方程描述的动力学表现出多稳定性和滞后性,这可以为记忆提供基础,以及由刺激强度调制的振荡频率的极限周期。(Wilson & Cowan,1972)中引入的一个定理指出,对于一类刺激表现出极限周期行为的神经群体对于另一类刺激表现出简单的滞后性。

滞后性(图8.1a)是指神经群体响应表现出关于变化的输入条件的延迟或非线性关系的现象,因为其状态不仅取决于当前输入,还取决于其过去的历史,即以前的输入条件继续影响其当前状态。极限周期(图8.1b)代表了神经群体对某些刺激的响应中稳定的、重复的振荡模式。这种周期性行为通常对应于大脑中观察到的节律活动,如各种认知过程中的振荡模式。

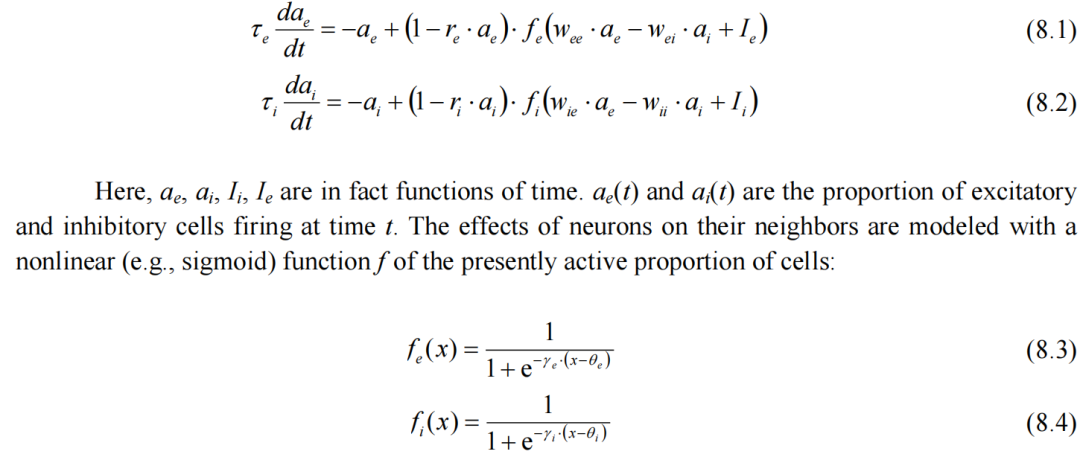

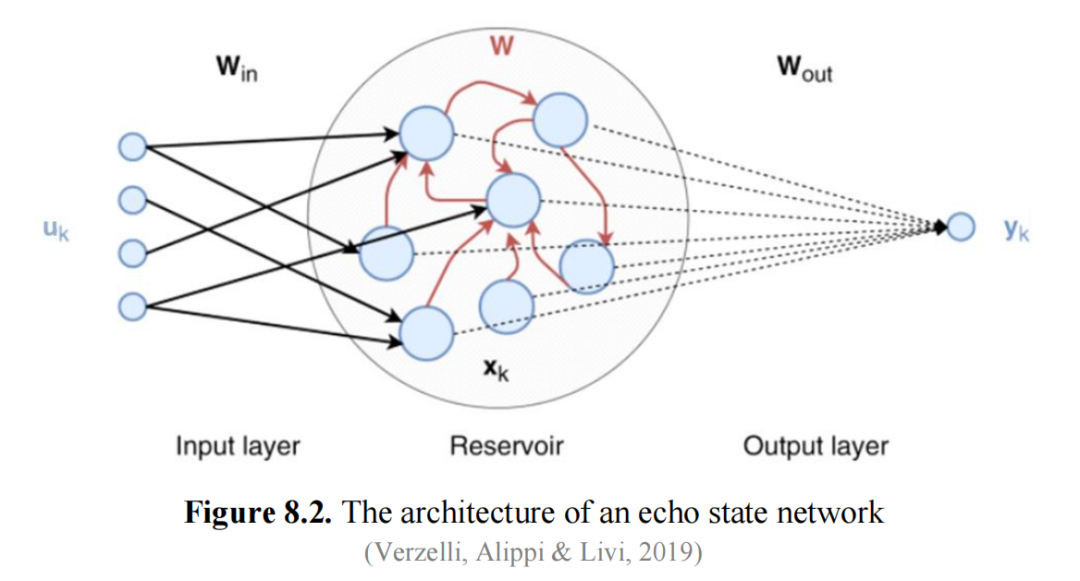

原始的Wilson-Cowan方程提供了神经活动的描述,作为反映在任何给定时间局部神经元群体发射比例的连续变量。它们可以模拟在大脑中观察到的许多神经现象。在(Wilson & Cowan,1972)中提出的活动方程是:

当兴奋性神经元之间的突触权重达到足够高的水平时,这导致出现多个稳定的固定点,其特征是高和低兴奋状态。相反,如果抑制性群体之间的相互连接充分减弱,系统显示出极限周期解,这涉及到少数活跃的兴奋性细胞导致其他细胞的激活,随后触发抑制性细胞去激活整个集合,从而重新开始循环。这个过程代表了在发射率活动中振荡的一个简单机制,这在生物神经网络中通常发生。

这些方程还考虑了两个群体的不应期(当细胞在激活后无法响应刺激时)通过(1 – r · a)因子。I代表一个群体接收到的外部电流的累积输入,例如,来自其他大脑区域。引入尖峰率适应可以导致神经活动行波的出现(Hansel & Sompolinsky,1998)。此外,包括动态调节突触权重函数w的短期可塑性效应可以导致类似现象(Kilpatrick & Bressloff,2010)。

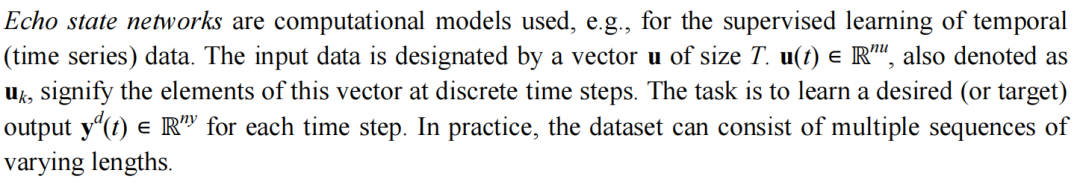

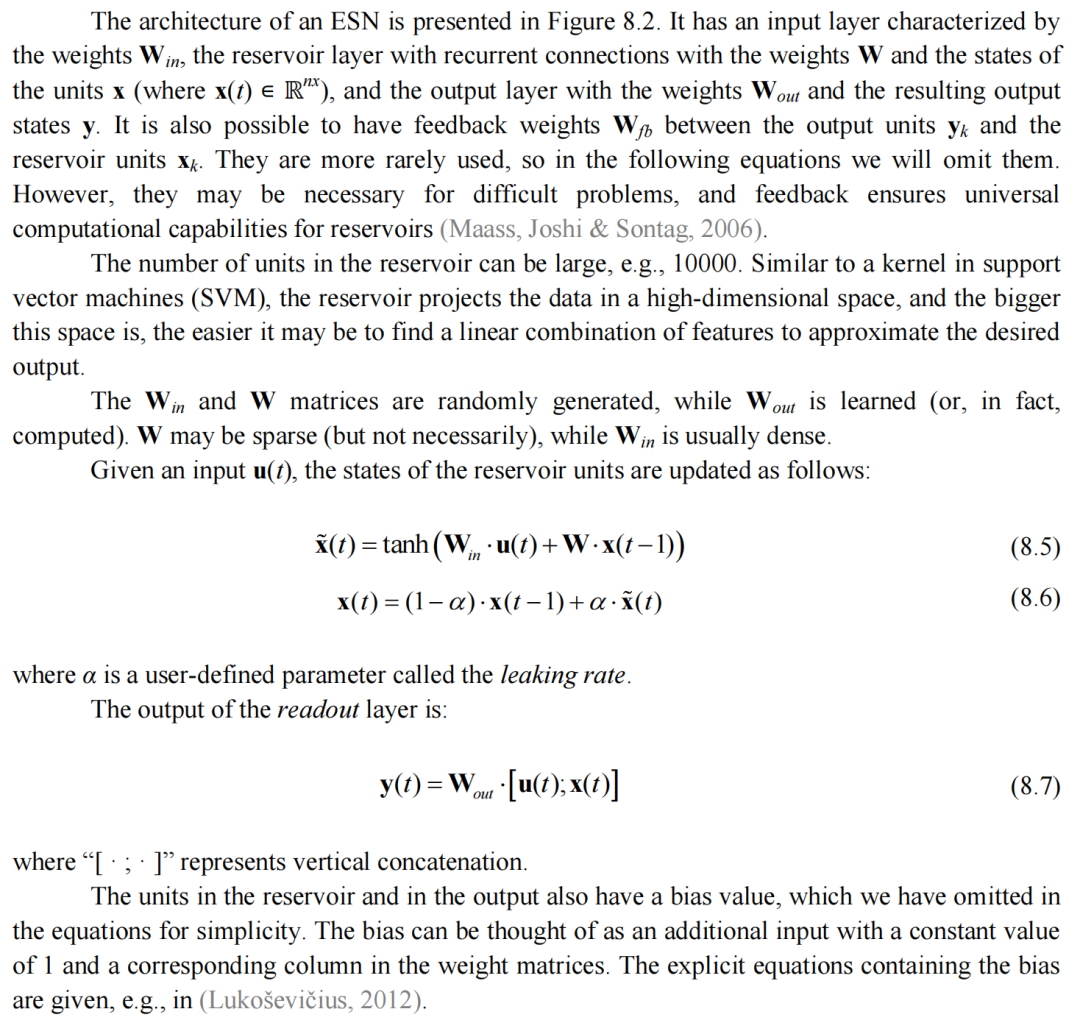

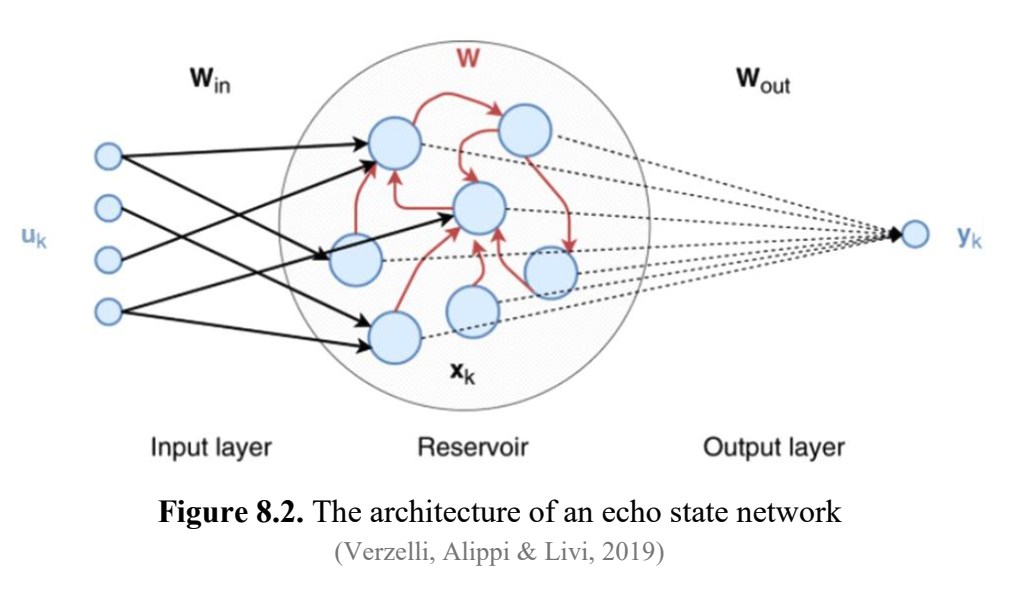

8.2. 储层计算

储层计算(RC)是从循环神经网络衍生出的一类架构。它的主要思想是使用一个固定的、非线性的系统,称为储层,就像一个黑盒。这一层由表现出动态行为的相互连接的神经元组成。这些神经元随时间处理输入数据,它们的相互作用创造出复杂的时间模式。储层层作为一个非线性变换,将输入数据转换到高维空间。与需要对整个网络进行大量训练的传统NN不同,储层计算只训练一个线性读出层,将储层的状态转换为所需的输出。

储层计算被独立发明了三次:Peter Dominey在研究灵长类前额叶皮层的序列学习生理学时(Dominey,1995),Herbert Jaeger作为回声状态网络(ESN)(Jaeger,2001;Jaeger & Haas,2004),以及Wolfgang Maass作为液态机(LSM)(Maass,Natschläger & Markram,2002)。最后两者的主要区别在于,LSM是受生物启发的尖峰神经网络,具有整合和发射神经元,而ESN使用基于速率的模型,其中神经元具有sigmoid激活函数。储层计算这个术语后来被引入(Verstraeten等人,2007)作为一个更通用的名称来描述这种架构。

1995年,Dominey试图模拟灵长类动物的眼动电路,包括条件行为的能力,即基于学习从几个可能性中选择正确的扫视目标。他研究了不同的视觉线索如何与不同的目标相关联,以及空间序列如何与输出扫视序列相关联。前额叶皮层电路被建模为一个具有循环连接的神经元储层,随后是一个计算输出的系统,该系统使用奖励进行训练(纹状体的一个模型,基底神经节的一个组成部分)。循环连接(兴奋性和抑制性)是固定的,但产生了丰富的时空动力学。神经可塑性被用来将循环网络的状态与输出层的期望响应进行映射。

8.2.1. 回声状态网络

回声状态属性(Echo State Property, ESP)是与回声状态网络(Echo State Networks, ESNs)相关的一个重要概念,它是在输入存在的情况下,储层状态渐近收敛的条件。通常,如果W的元素较小,输入信号会被衰减;而当它们较大时,由于储层中的递归连接,会逐渐发展出不规则的行为。随着这些权重的增加,可能会首先出现振荡,然后是混沌行为。因此,可以根据需要对储层权重进行缩放,以便储层能够正确学习。为了定义ESP,需要生成u和x的函数定义在紧致集上。我们可以简单地认为这个条件是满足的,因为x是由有界双曲正切函数生成的,而且通常在训练前会将输入数据u标准化。

回声状态属性指出,当一个储层网络给出无限序列的输入,并且由于其权重矩阵W的随机性质,从不同的初始条件开始,导致不同的状态x1和x2,储层状态最终会变得相等:x1 = x2。因此,储层的状态x可以被理解为其输入历史的“回声”,这也是模型名称的由来。换句话说,对于足够长的输入序列,储层的状态由输入历史唯一确定,并且这个状态可以随后被映射到所需的输出。

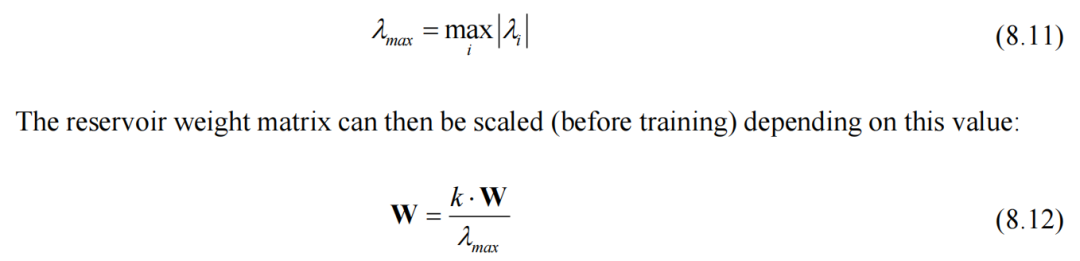

确保ESN表现出ESP的最常见的技术是通过谱半径来实现的,谱半径定义为矩阵W的最大绝对特征值。

当k=1时,W的谱半径变得小于1,这种情况也被记为ρ(W)<1。虽然许多研究人员认为这是ESP的充分条件,但这只在储层在没有输入的情况下运行时才成立,即u(t)=0。对于典型的输入驱动系统,实际上ρ(W)<1保证ESP是一个神话。这个条件对于回声状态属性既不是充分的也不是必要的。虽然这个标准可以作为初步尝试,但一般来说,大于1的谱半径可能会产生更好的结果。

8.2.2. 液态机

液态机与ESN相似,具有相同的架构,但它们在设计时更注重生物合理性。如前所述,LSM使用IF神经元,它们的动力学基于它们产生的尖峰列。 “液体”部分对应于储层。这个词来源于一个类比,观察石头随机扔进水中形成的波浪图案。在一定数量的时间步长后,会出现不同的波浪图案。这些独特的波浪图案包含了关于被扔石头的特征的重要信息。通过分析它们,可以得出关于各种石头属性的结论。同样,储层动力学和结果状态封装了关于输入数据的基本信息,这使得基于这些状态进行有意义的计算成为可能。这是ESN和LSM中读出层背后的原理。

8.2.3. 其他问题和模型

(Carroll,2020)讨论了储层计算机在“稳定边缘”的行为方面的计算能力。以前,发现元胞自动机在“混沌边缘”表现出最高的计算能力,这标志着从有序到混沌的转变。储层计算机被期望在“混沌边缘”表现最佳,但该论文质疑了这一假设,认为“稳定边缘”一词可能更准确,因为并非所有储层计算机都表现出混沌行为。尽管如此,储层计算机的计算能力并不总是在“稳定边缘”达到峰值。相反,各种因素,如与输入系统的广义同步以及储层信号与手头任务之间的匹配,在决定其性能方面发挥着重要作用。

(Gauthier et al., 2021)指出,标准的RC方法依赖于随机生成的参数矩阵,并涉及大量需要优化的元参数,对于这些元参数的选择指南很少。文中提到,非线性向量自回归(NVAR)可以达到与储层计算类似的性能,但具有一些关键优势,可以引导到“下一代储层计算机”。NVAR不使用储层,不依赖于随机矩阵,需要更少的元参数,并且产生更可解释的结果。它在设计用于储层计算的基准任务上表现优异,甚至需要更少的训练数据和时间。

在RC中,线性激活节点结合由储层节点的加权非线性函数组成的特征向量,可以像动态系统的通用逼近器一样强大。这种方法在数学上等效于NVAR方法,比传统的RC更高效、更直接,同时达到类似的结果。

经典的RC方法在处理分层建模时存在基本限制。因此,它们无法全面捕捉某些数据的多尺度组成性质。这是由于高级模块与其对应的低级模块之间缺乏双向交互所导致的(Jaeger, 2021)。因此,提出了深度储层计算模型。例如,(Gallicchio & Micheli, 2021)介绍了深度回声状态网络(DeepESN),这是ESN模型的扩展。与只有单个储层的传统ESN不同,DeepESN具有堆叠递归层的分层结构。输入层仅连接到第一个储层,然后第(n-1)层仅连接到第n层。网络的全局状态是所有层状态的联合。DeepESN的一个显著特征是其稳定性和记忆能力。深层架构往往展示出更长的记忆跨度和更丰富的动态,即使没有训练递归连接。它还具有捕捉多个时间尺度和在序列数据中表示多个频率的能力。这种分层表示使其能够有效地处理和编码各种类型时间序列数据中固有的复杂时间结构。此外,它对回声状态属性的遵循确保了在处理时间信息时的稳定性和效率。

总体而言,储层计算方法的优势在于其非常简单的训练过程,因为大多数权重仅随机分配一次。然而,它们能够捕捉随时间变化的复杂动态,并能够建模动态系统的特性。

8.3.基于吸引子的模型和大脑的其他动态模型

Hopfield网络(Hopfield, 1982)在人工智能社区中可能非常知名。因此,我们将简要介绍它们的特征以及一些扩展。这种类型的递归网络通常用于关联记忆任务和模式识别。Hopfield网络的结构包括一个单层的互连神经元,每个神经元都与网络中的每个其他神经元完全连接,但不包括与自身的直接连接。神经元的激活是二进制的,可以看作是对真实神经元开关状态的近似。学习机制是Hebb学习。

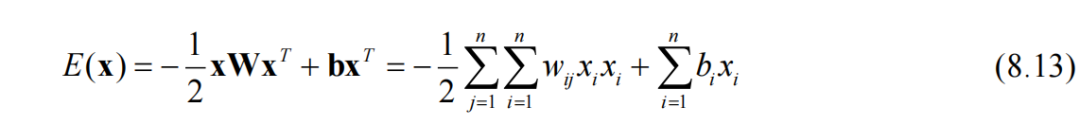

训练后,由于其递归特性,测试实例使网络收敛到一个吸引子,理想情况下应表示实例的正确版本,可能是去噪的版本,即先前学习过的版本。收敛过程相当于最小化一种称为能量的量。

方程式(8.13)定义了网络的权重w和偏置b的能量。需要指出的是,这个方程式的形式与物理学中铁磁体或自旋玻璃的伊辛模型中的能量形式相同。类似地,在Hopfield网络中,当每个神经元的激活与其邻居的加权激活“场”对齐时,能量达到最低。当网络运行输入模式时,其神经元可能会“翻转”,以达到更好的对齐,直到达到最小能量。

其中一个限制是网络可能会收敛到不正确的模式(错误记忆),特别是当网络需要存储大量模式或存储的模式高度相关时。使用统计力学方法,研究人员能够评估Hopfield网络的平均存储容量。因此,如果尝试存储的实例数量大于网络大小的14%,这将导致不可控的检索错误(Amit, Gutfreund & Sompolinsky, 1987)。这种存储限制也适用于架构的其他变体,例如在稀疏连接网络中,这个比率更大,约为64%(Derrida, Gardner & Zippelius, 1987)。

Hopfield网络还可以用于优化。用户需要设置权重w和偏置b的适当值,然后从随机网络状态开始运行网络。在能量最小化配置中,网络状态x表示优化问题的解决方案。这个过程类似于D-Wave量子计算机使用的绝热量子优化技术(Boixo et al., 2014)。

Boltzmann机(Sherrington & Kirkpatrick, 1975; Ackley, Hinton & Sejnowski, 1985)是Hopfield网络的概率扩展。Hopfield网络使用二进制激活,而Boltzmann机则采用使用sigmoid函数计算的概率激活。限制性Boltzmann机(RBM)(Smolensky, 1986)是Boltzmann机的一种变体,专为高效训练和推断而设计。RBM在可见单元和隐藏单元之间的连接上引入约束,形成一个二部图,完全连接。这种约束导致了简化的训练过程,可以通过对比散度等技术完成。

RBM在深度信念网络(DBN)(Hinton, 2009)中充当基础构建块,通过堆叠多层RBM构建。引入DBN标志着深度学习领域的一个转折点,为当前的进展奠定了基础。DBN结合了无监督学习的能力和深度神经架构的表达能力,因此它们可以通过在多个层次捕捉复杂特征来学习分层数据表示。

DBN的典型训练过程包括两个主要阶段:预训练阶段,其中网络的每一层以逐层无监督的方式进行训练;微调阶段,采用反向传播等监督方法。

(Khona & Fiete, 2022)是一篇综述文章,讨论了动态神经电路背景下吸引子的概念。吸引子表示系统随时间演变到特定状态的趋势,该文章涵盖了其定义、性质和机制的各个方面。

如前所述,吸引子是动态系统状态空间中的一组状态,附近所有状态都趋向于收敛。这些状态可以是稳定的、周期性的或混沌的,这取决于系统的行为。由于神经回路的状态难以定义,考虑到由互连的子回路和外部输入的影响所带来的复杂性,作者建议通过使用神经元的时间变化的尖峰率作为建模神经回路的状态来简化这个定义。吸引子具有多种形式,例如离散吸引子是稳定的固定点,连续吸引子通过神经活动模式形成。当网络权重具有连续对称性(如平移或旋转不变性)时,将形成连续吸引子。由局部兴奋和抑制驱动的模式形成在创建稳定的连续吸引子中起着关键作用。具有强烈非对称权重的大型网络可以展现出混沌动态:低维但高度结构化的吸引子。具有抑制性突触占优势的网络可能在零活动时具有单一吸引子,在对扰动的响应中暂时偏离这一状态。

在主要应用方面,吸引子网络提供稳定的内部状态,可用于再现输入的表示。通过前向学习过程可以实现这些表示,其中外部状态与内部吸引子状态相关联。吸引子网络还表现出两种形式的记忆,一种是在权重结构中,另一种是在维持稳定吸引子状态中保持持久活动的能力。吸引子状态作为强大的表示方式,因为它们具有去噪功能:当存在嘈杂或损坏的输入时,吸引子动力学驱使系统进入最近的吸引子状态,消除大部分噪声,这对于记忆维护尤为重要。吸引子网络还可以用于决策过程,集成正面和负面证据以基于证据累积做出决策(我们将在第11.2节讨论)。胜者通吃模型实现了混合模拟-离散计算,允许在多个选项之间进行快速和准确的决策。此外,吸引子动力学对于稳定长期行为,如序列生成,至关重要。序列可以生成为低维极限环吸引子,通过高维扰动进行校正,并沿着吸引子的系统、周期性或准周期性状态流动。然而,在极限环吸引子中的小组件噪声可能导致时序变异性。

(Zhang, Sun & Saggar, 2022)介绍了一个新的建模框架,探讨了大脑功能连接与结构连接之间的关系,试图解释大脑固有动态如何与认知功能相关联。具体而言,该论文试图将持续变化的动态与大脑静态解剖联系起来。作者建议,跨吸引子之间的协调在预测人类功能连接方面优于由噪声驱动的单一吸引子动态。跨吸引子表示不同吸引子之间的一种互动形式。当不同的吸引子表现出一定程度的同步时,就会发生跨吸引子。在这种情况下,系统可以以精确的方式在吸引子之间切换,允许它们之间的动态互动。跨吸引子协调描述了不同的大脑区域或神经状态如何相互作用,可能导致神经活动的协调模式,这对于理解大脑不同部分如何协同工作是相关的。论文还讨论了吸引子之间的转换施加能量成本的观点,以及建模框架如何帮助预测与认知功能和精神疾病相关的这些成本。

(Spalla, Cornacchia & Treves, 2021)提出了一个连续吸引子网络模型,旨在捕捉情节记忆检索的动态特性。这个模型的独特之处在于引入了记忆依赖的不对称元件在突触连接中。它考虑到神经元之间的连接并非对称,这与传统的吸引子网络有所不同。不对称连接对于创建动态记忆检索至关重要,因为它可以在网络活动中产生强大的活动偏移。当网络接收到初始提示时,不对称连接导致神经活动沿着记忆吸引子移动,有效地以动态和时间依赖的方式召回记忆。

记忆依赖的不对称连接被认为是通过涉及STDP的学习阶段形成的。该模型强调了两个组成部分之间的平衡:一个是对称的和轨迹平均的,而另一个是不对称的和轨迹依赖的。这种平衡对模型的运作至关重要。一个有趣的特征是,检索速度可以根据网络活动的稀疏性而变化。这个特性与对海马体重放的观察一致,其中记忆召回以不同的速度发生。

该论文的另一个结果是量化动态连续吸引子的存储容量,发现其容量相当大,有时比特定网络配置中的静态吸引子更高。

(Pereira & Brunel, 2018)描述了一种受吸引子神经网络场景启发的递归神经网络模型的发展和分析,用于在联合皮层中存储记忆。作者通过推断学习规则和从视觉响应记录数据中存储模式的分布,填补了理论模型和实验数据之间的现有差距。与传统的吸引子神经网络模型不同,检索状态表现出分级活动,其发放率分布与对数正态分布密切相关。推断的学习规则被证明优化了存储大量吸引子状态,接近无监督Hebb学习规则家族中的最大存储容量。此外,论文还强调了在模型中识别到的两种不同类型的检索状态:一种特征是随时间保持恒定的发放率,另一种是发放率在强耦合时波动混沌。发现在强耦合时转向混沌动态导致了高度不规则的神经活动,同时保持稳定的记忆存储,揭示了在不同参数条件下网络行为的一个令人惊讶的方面。

(Ursino, Magosso & Cuppini, 2009)报告了一种利用Wilson-Cowan振荡器的神经网络模型,用于模拟抽象对象的识别过程,并阐明了伽马波段同步在高级认知功能中的作用。伽马波段的同步指的是大脑中神经元群体展示出在30到80赫兹频率范围内协调和节律性发放模式的现象。每个对象由四个特征的集合表示,这些特征排列在振荡器的拓扑图中,通过兴奋性侧突触连接,实现了一种相似性机制。该网络考虑了存储在长距离突触中的对象的先前经验,使用时间依赖的Hebb学习。采用了类似大脑皮层结构的二维振荡器格子。模型包括一个位于振荡器网络下游的决策网络,当所有特征振荡器同步时指示对象检测是否正确。在过程的第一阶段,刺激与存储内容进行匹配,其中区域间突触代表记忆。在第二步中,诱导的活动负责通过下游决策网络利用获得的匹配信息。这类似于“匹配和利用模型”(Herrmann, Munk & Engel, 2004)中的操作。作者发现,灵敏度和特异性之间的平衡取决于Hebb学习的强度,但也取决于振荡频率。该模型似乎能够在涉及信息退化、噪声和中等特征相关性的条件下重建和分割对象。

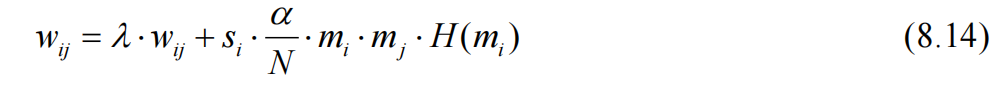

(Siri et al., 2007)专注于研究希伯来学习在具有生物启发连接的随机递归神经网络中的影响。该网络架构设计旨在模仿真实神经网络的特征,包括稀疏连接和兴奋性与抑制性神经元的分离群体。作者考虑到具有S形激活函数的发放率神经元和离散时间动态,其中学习发生在比神经元动态更慢的时间尺度上,即,突触权重在连续T ≥ 1步中保持不变,这定义了一个学习时期,权重仅在一个这样的时期之后更新。使用了希伯来学习规则的一种变体:

其中,i对应于突触前神经元,j对应于突触后神经元,λ是遗忘率,si为+1表示i为兴奋性神经元,为-1表示i为抑制性神经元,α是学习率,N是神经元的总数,在该研究中设定为500,而H是Heaviside函数,即,H(x) = 0如果x < 0,否则为1。

代表活动历史,定义为发放率的时间平均值:

其中,ai(t)是时间步骤t的激活(发放率),θi是一个阈值,在文中设为0.1,这意味着在学习时段内,如果一个神经元的平均发放率至少是最大值的10%,则认为该神经元是活跃的。

Hebbian学习的应用导致神经网络的动态和结构特性发生显著变化。一个显著的效果是权重矩阵范数的收缩。这意味着随着神经元之间逐渐发展的相关性,Hebbian学习导致网络的重连。在由Hebbian学习驱动的新兴突触结构中,最强的突触倾向于组织成小世界网络,即大多数相邻节点可以在少数步骤内相互到达,这可以增强信息传输的效率。Hebbian学习还导致雅可比矩阵的谱半径收缩,将神经网络推向“混沌边缘”状态,这是网络对输入模式表现出最大灵敏度的状态。在模拟中观察到的效应主要由学习规则中的被动遗忘项所介导。

另一个有趣的结果在(Trapp, Echeveste & Gros, 2018)中提出,使用一种称为“flux规则”的Hebbian可塑性规则导致了一种异步混沌状态,其中兴奋性和抑制性激活是平衡的,同时突触的兴奋性和抑制性权重也是平衡的。该研究探讨了神经网络以完全无监督的方式实现突触权重和活动的平衡的可能性。研究表明,这样的平衡网络是自组织的,类似于皮质动态的临界状态。

该论文比较了不同Hebbian学习规则的效果,并发现当学习规则偏好较小的平均膜电位时,Hebbian学习会导致突触权重的平衡分布。具体而言,flux规则导致了兴奋性和抑制性的平衡,而例如Oja规则则没有这种效果。多数自限制Hebbian(或flux)规则的定义如下:

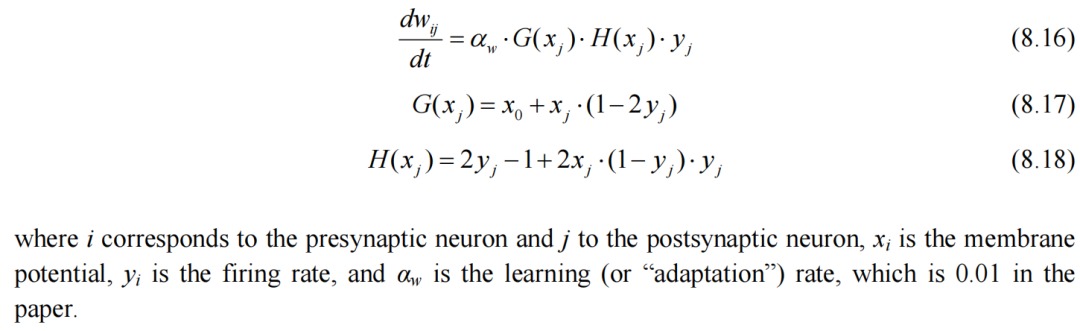

其中,i对应于前突触神经元,j对应于后突触神经元,xi是膜电位,yi是发放率,αw是学习(或“适应”)率,在文中设为0.01。

该研究使用速率编码神经元,并观察到E-I平衡特征是大兴奋性和抑制性输入的几乎抵消。这种状态对小的不平衡非常敏感,导致神经活动出现尖峰样突发,表明活动仍然是异步的。兴奋性和抑制性输入的几乎抵消稳定了异步神经活动,作者发现这种活动是非常不规则的。尽管不规则性,网络仍然保持稳定和平衡,反映了实际神经系统中观察到的动态特性。

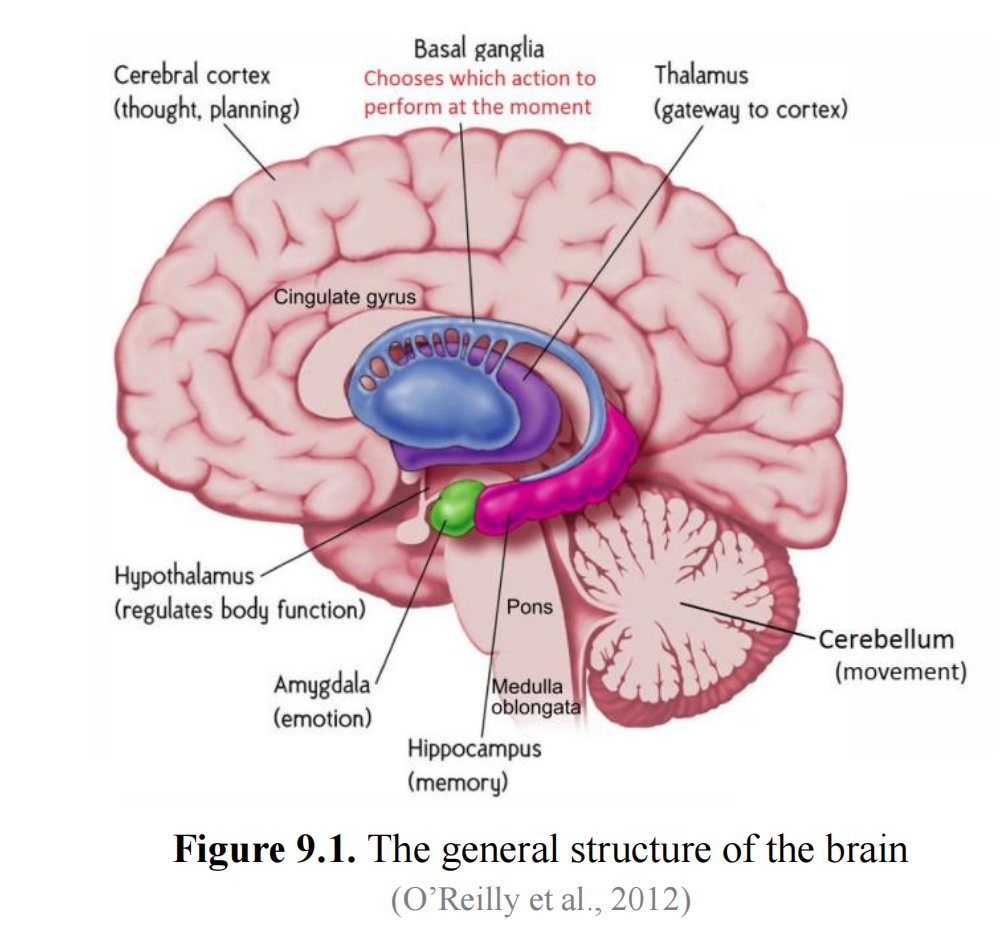

9. 大脑解剖4 9.1. 大脑的一般结构

图9.1提供了人类大脑一般解剖结构的插图。最外层是新皮质,一个高度褶皱的薄片,负责复杂的认知功能,这是我们讨论的主要焦点。

大脑皮层是大脑最外层的一部分。它负责处理感觉信息,如触觉、视觉和听觉,同时控制自主肌肉运动。它还参与更高级的功能,如问题解决、决策制定、语言处理和情绪调节。术语“大脑皮层”和“新皮层”通常可以互换使用,但它们指的是大脑结构的稍有不同方面。大脑皮层是一个更广泛的术语,包括新皮层和其他区域(例如分配皮层)。大脑皮层是大脑半球表面的外覆层。在人类大脑中,它大约有150亿个神经元,厚度约为2-4毫米,占据了大脑质量的40%。

另一方面,新皮层是大脑皮层的一个特定部分,参与意识思维、感觉知觉、空间推理和语言处理等高级认知功能。它被称为“新皮层”,因为被认为是大脑中最近进化的部分,在哺乳动物中特别发达,尤其是在人类中。新皮层占据了大脑皮层约90%的比例。它以其六层结构为特征,负责许多与智力和高级感知处理相关的复杂认知过程。

在新皮层下面,有几个被统称为皮层下脑区的脑区域。

海马体在形成情景记忆中起着至关重要的作用,包括日常事件和事实的记忆。它是一个参与记忆形成和空间导航的脑结构,并且在将短期记忆转化为长期记忆的过程中起着核心作用,这个过程被称为记忆巩固。海马体还通过创建认知地图来帮助环境中的导航。

杏仁核对于识别具有情感重要性的刺激并向其他大脑区域传递它们的存在至关重要。

小脑主要协调运动功能。它采用误差驱动的学习机制,使动作得以精细调节。小脑包含大脑神经元的显著比例(80%),但仅占大脑总质量的10%。

丘脑作为主要的中继站,作为通往新皮层的感觉信息的门户。它接收来自身体各个部分的感觉输入,加工这些信息,然后将其传递到大脑皮层的适当区域,这些区域是感知和意识的发生地。此外,丘脑在调节意识、警觉和睡眠-清醒周期方面也发挥作用。它可能有助于注意力、唤醒和其他调节过程(增强或抑制其他过程的活动)。它过滤和优先处理感觉刺激,帮助集中注意力于相关信息,同时过滤掉干扰。

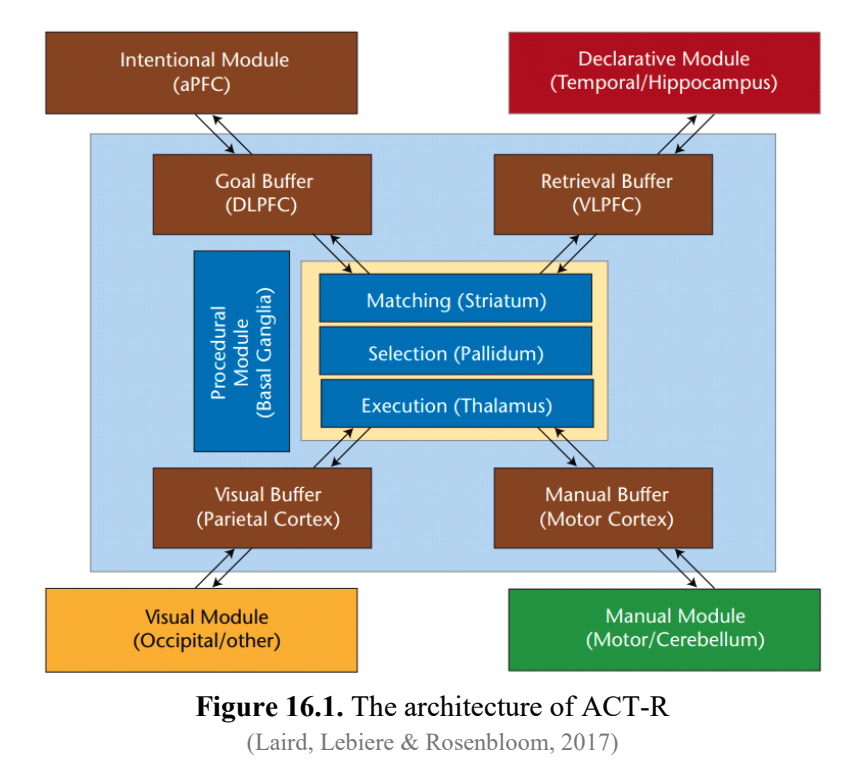

基底节(BG)是一个由皮层下区域组成的网络,在决策制定中发挥重要作用。它基于奖励和惩罚的先前经验来决定是否执行或抑制皮层提出的动作。它具有启动解抑制性的“前进”信号的能力,促进从潜在选择中选择最佳动作。这种动作选择过程在很大程度上受到强化学习的影响,受多巴胺的存在指导,多巴胺是一种神经递质,调节学习和动作选择速度本身。因此,基底节充当仲裁者,支持可能获得奖励的动作,同时尽量减少受到惩罚的可能性。

9.2. 皮质叶

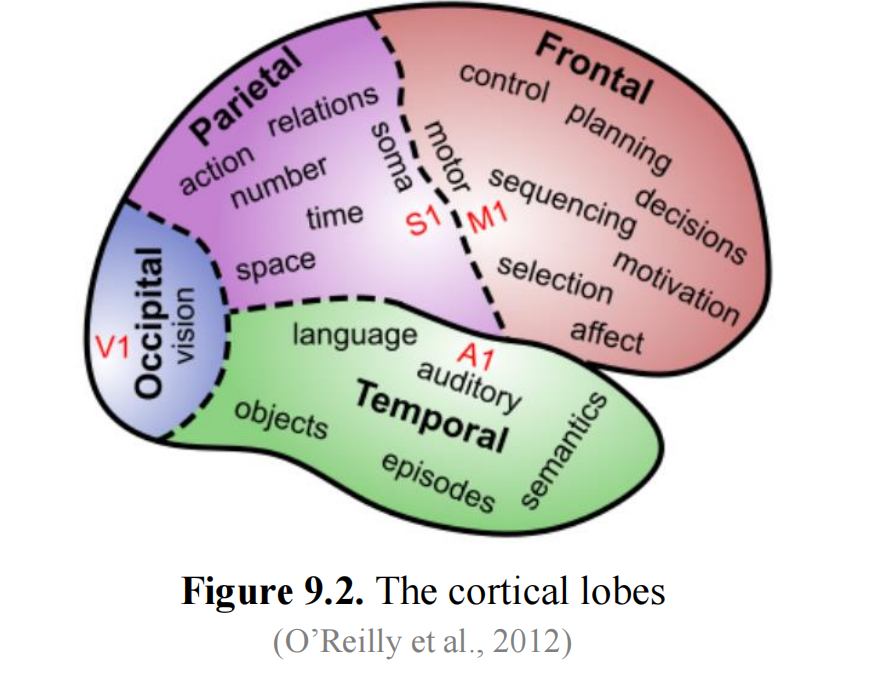

大脑皮层被一个纵向裂缝分成两个半球,每个半球包含几个叶,如图9.2所示。

额叶是大脑叶中最大、最复杂的一个,包括一个按照等级组织的运动控制区域。在其后端是主要运动皮层(M1),负责基本的运动控制。位于叶前端的前额叶皮层(PFC)通常被视为大脑的执行中心。它主管决策制定、长期规划、目标设定和推理等高级认知功能。此外,中部和前部区域调节情绪和动机。

顶叶执行多个通常在潜意识水平操作的功能。它处理空间信息,形成了理解环境中物体位置和移动的“何处”通路。它还在数值处理、数学和抽象概念化中发挥作用。它帮助整合视觉信息以指导运动动作,形成了“如何”通路。负责处理触觉感觉的主要体感皮层(S1)位于这里。一些区域促进不同参照系之间信息的转换,例如将身体上的空间位置映射到视觉坐标上。

颞叶包含主要听觉皮层(A1)和参与听觉以及语言处理的区域。它在识别和分类视觉对象方面起重要作用。它还促进了视觉信息与语言标签之间的转换,有助于命名物体和理解它们的含义。此外,颞叶内侧颞叶(MTL),邻近海马体,对于存储和检索情景记忆至关重要。

枕叶是视觉处理的中心。它包含主要视觉皮层(V1),负责最初的视觉知觉和检测基本的视觉特征,如边缘、形状和方向。

9.3. 视觉皮层

视觉皮层负责处理视觉信息,其结构分为六层。

第一层是最表层,由水平连接组成,用于对传入视觉输入进行初步整合。

第二/三层是处理的初始阶段。它接收来自丘脑的输入并处理基本的视觉特征,如边缘、方向和基本纹理。这一层的神经元还参与复杂的侧向相互作用,有助于特征检测和整合。第二层更专注于检测基本的视觉元素,而第三层则负责整合这些特征,并形成更复杂的视觉刺激表示。

第四层专门传递来自丘脑的信息。它作为视觉刺激的主要输入层。在这一层中,神经元表现出高度的特异性,对不同的特征如方向和空间频率作出反应。

第五层充当中间层,将处理过的视觉信息传递给更高级的皮层区域。它还在将运动命令发送回亚皮层结构方面发挥作用,因此参与协调对视觉刺激的运动响应。

第六层有两个亚层,有助于视觉皮层与亚皮层结构(包括调节感觉处理的丘脑和控制视觉追踪和定位所需的脑干)之间的反馈回路。

视觉皮层的分层结构为卷积神经网络(CNNs)提供了基本灵感来源,CNNs在图像处理和计算机视觉任务中表现出色。人类大脑中视觉皮层在处理视觉信息方面的作用类似于CNNs在计算机视觉中的功能。在视觉皮层中,神经元分成不同的层,每一层负责从视觉刺激中提取不同的特征。早期层捕捉基本特征,如边缘和简单形状,而更深层次则处理更复杂的图案、纹理和物体层次结构。这种分层和逐级处理的方法使大脑能够高效地分析视觉信息。CNNs通过使用卷积层来模仿这种架构,这些层应用滤波器来提取低级特征,然后堆叠多个这样的层来逐步捕捉更高级的特征。层次化的特征提取与视觉皮层的操作密切对应。

9.4. 皮层层次的功能

新皮层表现出一致的六层结构,这种结构在所有皮层区域中都是一致的。然而,这些层的相对厚度在不同的皮层区域中有所变化。

输入区域,如初级视觉皮层,通过丘脑通常接收感觉信息。这些区域具有显著的第四层,丘脑轴突在此终止。一种称为星形细胞的特化兴奋性神经元,具有密集和局部化的树突,在这一层中起到收集输入的作用。这些区域既不直接接收感觉输入,也不直接控制运动输出。它们的特征是较厚的表层 2/3,其中包含许多适合分类功能的金字塔形神经元。

隐藏区域被认为从感觉输入中创建抽象类,并基于这些高级类促进适当的行为反应。

输出区域直接连接到肌肉控制区域,并可以通过电刺激诱发物理运动。这些区域具有较厚的深层 5/6,其将轴突投射到各种亚皮层区域。

皮层的层次结构及不同皮层区域的具体功能共同表明,皮层的主要作用是以多种方式处理感觉输入,以提取行为相关的类别,随后驱动适当的运动反应。

在同一皮层区域内,神经元之间存在广泛的横向连接。此外,不同区域内的隐藏层可以直接相互通信。跨区域的这种互动在形成一致的表征和实现认知功能方面起着重要作用。皮层连接通常是双向的。发送前馈投射到其他区域的区域通常会从同一区域接收到相互反馈投射。反馈流有助于自顶向下的认知控制,指导注意力并解决感觉输入的歧义。

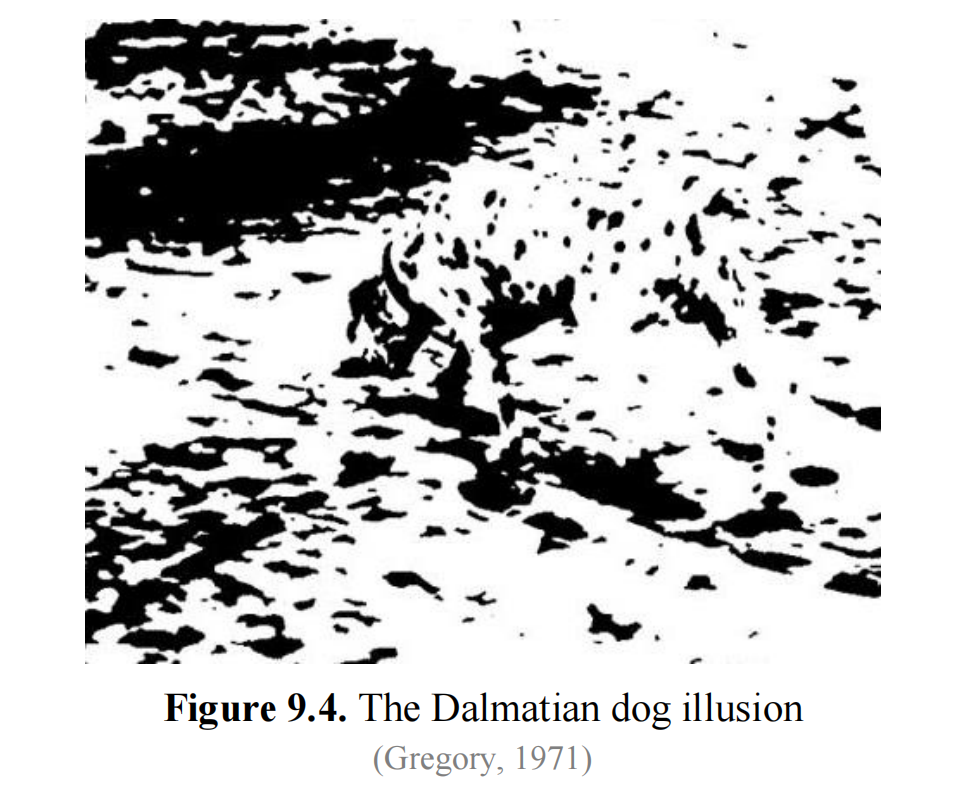

许多刺激在缺乏额外自顶向下约束时是模棱两可的。语义知识和上下文可以帮助大脑以一致的解释来解决模糊性。例如,在看到一个关于达尔马提亚犬的模棱两可图像(见图 9.4)之后,自顶向下的知识有助于识别出狗。

双向兴奋动力学对于模式完成至关重要。当大脑接收到部分输入线索(例如,“上周末你去了哪里?”),适当的记忆表征可以在大脑中部分激活。双向兴奋连接使得这种部分激活能够通过记忆电路传播,填补记忆痕迹中的缺失部分。这个过程就像一个系统围绕正确的记忆痕迹轨道运转,直到收敛。

偶尔,系统可能无法完全收敛到吸引子状态,导致记忆无法达到。这些“舌尖上”的状态可能令人沮丧,人们可能会尝试各种策略来达到最终的吸引子状态以检索记忆。

抑制性竞争至关重要,因为它使个体能够一次集中注意力于少数几件事情,避免认知过载。它确保被激活的探测器是那些特定输入最激发的,类似于进化中“适者生存”的概念。

如果没有抑制作用,皮层中的双向兴奋连接将导致所有神经元的快速且无法控制的兴奋。这就像把麦克风放置在播放自身声音的扬声器旁边产生高频反馈声一样。抑制作用就像空调器中的恒温器一样的控制机制,保持活动在期望的设定点并防止它变得过高。通常情况下,由于抑制作用,给定区域中只有约15-25%的神经元在任何给定时间内是活跃的,形成了稀疏分布的表示。

选择性注意力是抑制性竞争作用的一个典型例子。在拥挤的场景中寻找特定刺激,例如在人群中找朋友时,人们一次只能专注于有限数量的物品。与被关注物品对应的神经元被充分激发以超过抑制阈值,从而使它们突出。抑制作用有助于忽略或抑制其余的物品。底层驱动(感官驱动)和自顶向下(认知驱动)因素共同影响哪些神经元能够超过阈值。如果没有抑制作用,就没有机制可以选择和集中注意力于物品的子集。

患有巴林氏综合征的个体,其由于对负责空间注意力的顶叶皮层损伤,表现出注意力效应减少。他们通常无法同时处理视觉显示中的多个物品,这种情况被称为“同时性失认症”,当场景中存在多个物品时,他们无法识别对象。这与我们将在第13节讨论的可变绑定概念相关。

抑制性竞争还在学习过程中起到选择压力的作用。只有最激发的探测器被激活并通过学习过程加强。这种正反馈循环增强了这些探测器对当前输入的调整,使它们更有可能对将来的类似输入做出响应。抑制性竞争导致探测器针对环境中的特定类别进行专门化。如果没有抑制性竞争,大多数神经元将针对每个输入进行训练,导致对所有事物的检测能力减弱。

9.5. 语言区域

Wernicke区位于左侧颞叶,主要与语言理解和处理相关。它在理解口语和书面语言以及构思连贯和有意义的句子中发挥重要作用。对该区域的损伤可能导致Wernicke失语症,患者在语言理解方面有困难,通常产生流利但无意义的句子。

Broca区位于大脑左侧额叶,参与语言和言语表达的产生。它协调参与言语产生的肌肉,并促使形成语法正确和连贯的句子。对该区域的损伤可能导致Broca失语症,其特点是形成句子和流利表达语言的困难,尽管理解能力相对保持完好。

9.6. 记忆区域

如上所述,海马体在记忆中起着基础性作用。它支持快速学习新信息,而不会对先前学习到的内容造成过多干扰。这种快速学习能力在记住刚认识的人名时尤为重要。

海马体使用稀疏表示,这有助于一种称为模式分离的现象。这一过程确保与一个记忆相关的神经活动模式与其他类似记忆的模式是不同的。通过最小化重叠,模式分离减少了对先前学习的干扰。

除了模式分离外,模式完成是记忆检索过程中的另一个关键过程。模式完成允许从部分信息中恢复记忆,即使只有片段或提示,也能回忆起完整的记忆。

学习率在学习过程中发挥着重要作用。较高的学习率能够快速获取新信息。相反,较低的学习率有助于在各种经验中整合知识,促进语义知识的发展。与海马体相比,新皮层通常表现出较低的学习率。

即使学习率较低,新皮层在一次学习试验后也能显示出可测量的效果。这些效果包括启动和熟悉信号,有助于认知记忆,即在没有显式情节记忆的情况下,识别某物作为熟悉的东西。中颞叶区域参与了这种形式的认知记忆。

9.7. 网格细胞和场所细胞

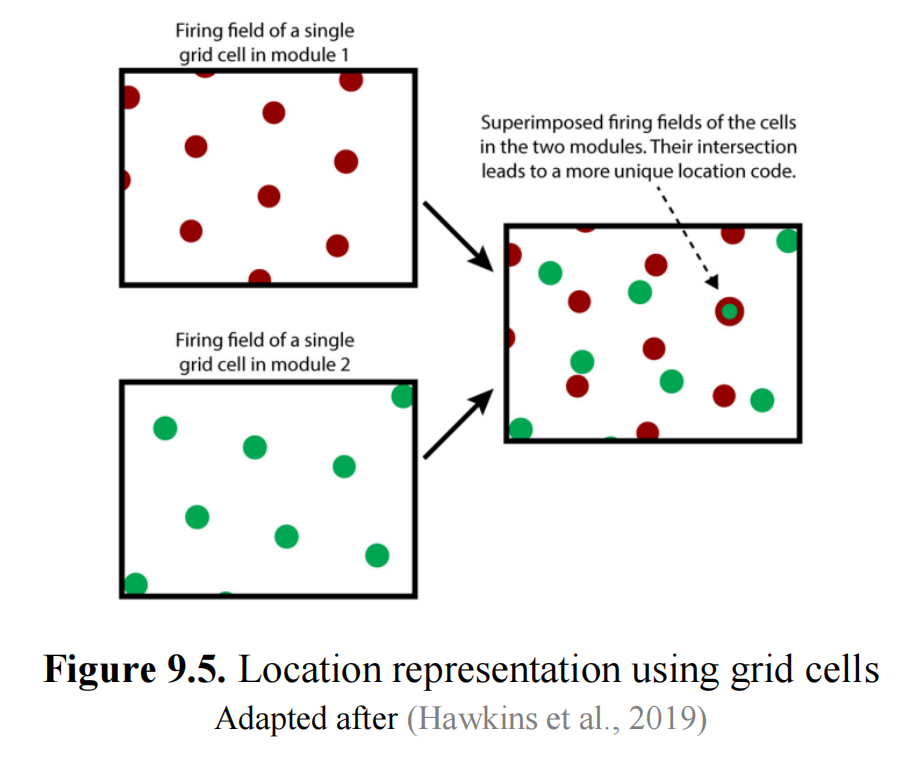

网格细胞是一种存在于环状沟皮层的神经元类型,这个区域与海马体相连。它们在空间中显示出特征性的六边形活动模式,如图9.5所示。环状沟皮层包含表示身体位置相对环境的网格细胞。网格细胞以类似网格的规律模式发射,具有多个网格细胞在不同尺度和方向上的活动。网格细胞的发射模式在环境上叠加出空间网格,提供了大脑用于估计距离和准确导航的系统。

网格细胞在环境中的多个位置激活,形成类似网格的模式。随着个体移动,网格细胞活动的变化反映了其更新的位置。

实验证据表明,影响网格细胞的环状沟皮层损伤会影响导航任务的表现,并破坏海马体中顺序激活的时间排序。这意味着网格细胞在空间规划中的作用,并提出了网格细胞在层次规划中可能的更普遍作用。

单个网格细胞模块无法独立表示唯一的位置。为了做到这一点,需要考虑多个网格细胞模块中的活跃细胞,每个模块相对于环境具有不同的瓦片间距和/或方向。使用多个网格细胞模块表示位置的方法具有很大的表示能力。可以表示的位置数量随模块数量的增加呈指数增长。

路径积分允许人们在移动过程中跟踪其位置,从网络中的任何起始位置开始工作。这提供了一种泛化形式,因为每个网格细胞模块学到的路径积分属性适用于所有位置,即使个体以前从未访问过这些位置。

Grid细胞模块在人们进入熟悉的环境(例如一个房间)时会以不同的方式“锚定”。这种锚定过程确保了当前位置及该环境内所有可能的位置具有独特的特定于该环境的表示。这些位置表示通过路径积分相互关联。每个位置表示是特定于特定环境的唯一表示,不会出现在任何其他环境中。一个环境包含了人们可以移动的所有位置,包括他/她尚未访问但可能访问的位置。其中一些位置可能与可观察的地标相关联。

大脑中的网格细胞以六边形对称编码来组织空间表示,如图9.5所示。当人们在环境中移动时,单个网格细胞在多个位置激活,例如图中的红色圆圈。因此,单个网格细胞无法确定特定的位置。不同的网格细胞模块以不同的间距和方向激活,例如图中的绿色圆圈。当来自不同模块的多个网格细胞同时激活时,它们可以精确识别特定的位置。

这种六边形对称性在功能性磁共振成像(fMRI)信号中反映出来,可能是大脑从一个环境泛化到另一个环境的能力的原因。

(Rodríguez-Domínguez & Caplan, 2019) 提出了一个描述性的网格细胞模型,与二维傅立叶基础相关,设置在六边形坐标系中。该模型建议,网格细胞可能执行环境的反傅立叶变换,从而实现空间表示和对环境信息的有损压缩。在六边形傅立叶模型中,网格细胞表现为专门的滤波器,以压缩形式保留有意义的信息。

场所细胞是位于海马体中的特化神经元,当个体占据特定位置时,它们会变得活跃。每个场所细胞都有一个首选的“场所场”,即在环境中它最活跃的特定区域。当个体在空间中移动时,不同的场所细胞会激活,形成个体当前位置的表示。场所细胞的这种动态激活形成了环境的神经地图,使大脑能够跟踪自身位置(Hawkins et al., 2019)。

认知地图是环境空间布局的心理表示。这些地图使个体能够在头脑中导航空间,即使他们不在那里亲身存在。认知地图提供了规划路线、进行导航决策以及回忆不同位置之间空间关系的方式。它们整合了场所细胞和网格细胞提供的信息,使人们能够在头脑中导航和规划路线(Hawkins et al., 2019)。

有一种假设认为,人脑也会将概念组织成认知地图,以类似于空间导航的方式来导航概念关系。海马体在以认知地图形式组织知识方面起着关键作用。海马体不仅参与空间推理,还参与非空间功能,如关系记忆,涉及理解物体和事件之间的关系和联想。这些地图对基于稀疏观察进行复杂推理至关重要。

一些研究者提出空间和非空间功能之间存在连接,暗示它们可能共享一个共同的基础机制。然而,这种连接仍不清楚,并且现有的模型尚未完全解释海马体中观察到的各种类型的空间表示。

9.8. 决策区域

前额叶皮质在后部皮质处理中提供自上而下的认知控制。它可以影响基底神经节-运动回路中的行动选择,并且还可以影响对感觉皮层任务相关特征的注意力。另一个自上而下控制的例子是斯特鲁普任务,即一种心理测试,受试者被呈现一列以有色墨水书写的颜色词(例如,“红色”,“蓝色”,“绿色”)。任务要求参与者说出每个单词的墨水颜色,而忽略实际的单词含义。它展示了自上而下控制,因为它要求个体施加认知控制,并选择性地注意到刺激的一个方面(墨水颜色),同时抑制或忽视另一个方面(单词的含义)。

前额叶皮质与基底神经节之间的相互作用有助于发展一个工作记忆系统,使大脑能够持有多个信息片段,并在保持现有信息的同时分别更新其中的一些。

9.9. 同质皮层柱

“旧脑”包含明显的结构,每个结构都有特定的功能,形状和大小明显不同。相比之下,负责各种认知功能的新皮层没有明显的分割,看起来像是一张连续的细胞片。新皮层神经元和连接非常密集。在1平方毫米内可能有约100,000个神经元,5亿个突触,以及数公里的轴突和树突。尽管其外观统一,新皮层包含负责视觉、听觉、触觉、语言和规划等各种功能的区域。

令人惊讶的是,即使负责这些功能的详细神经回路彼此之间看起来并没有显著不同。

新皮层内部的区域通过神经纤维束相互连接,形成复杂的网络。科学家们试图理解这种连接性,以确定新皮层的组织方式。关于新皮层组织的一个常见解释是分层的流程图结构,其中感觉输入被逐步处理,逐渐提取复杂特征,直到完整的物体被感知。虽然一些证据支持这种分层观点,但实际的新皮层组织并不完全符合这一模型。每个层次上存在多个区域,并且许多连接不符合分层方案。此外,并非每个区域的所有细胞都起到特征检测器的作用。

考虑到第9.1节提到的六层结构,大多数神经元之间的连接发生在垂直方向,即这些层之间。大多数轴突在层间穿越,表明信息主要在上下传递后再传递到其他地方。

虽然一些区域在神经元类型和数量上有所变化,但与整体的一致性相比,这些差异相对较小。这种相似性表明,使区域不同的不是它们固有的功能,而是它们的连接方式。将一个区域连接到不同的感觉输入,例如眼睛或耳朵,会导致不同的功能,如视觉或听觉。更高阶的功能,如语言,也可能源于区域之间的连接。

Vernon Mountcastle(1957年)提出,新皮层的基本单位是皮层柱。这些柱子占据表面约1平方毫米,并延伸穿过新皮层的2.5毫米厚度,在整个新皮层中重复出现。每个皮层柱处理特定的感觉信息,它们的分组由它们响应的感觉输入部分定义。此外,它们的功能是灵活的,例如,在盲人中,视觉区域可以适应处理其他感觉输入,如听觉或触觉。这些结构也用于更高级的认知功能或学习任务。

因此,新皮层以柱的方式的同质组织可能意味着各种认知过程的共同脑算法。

10. 神经科学模型

10.1. 层次时间记忆

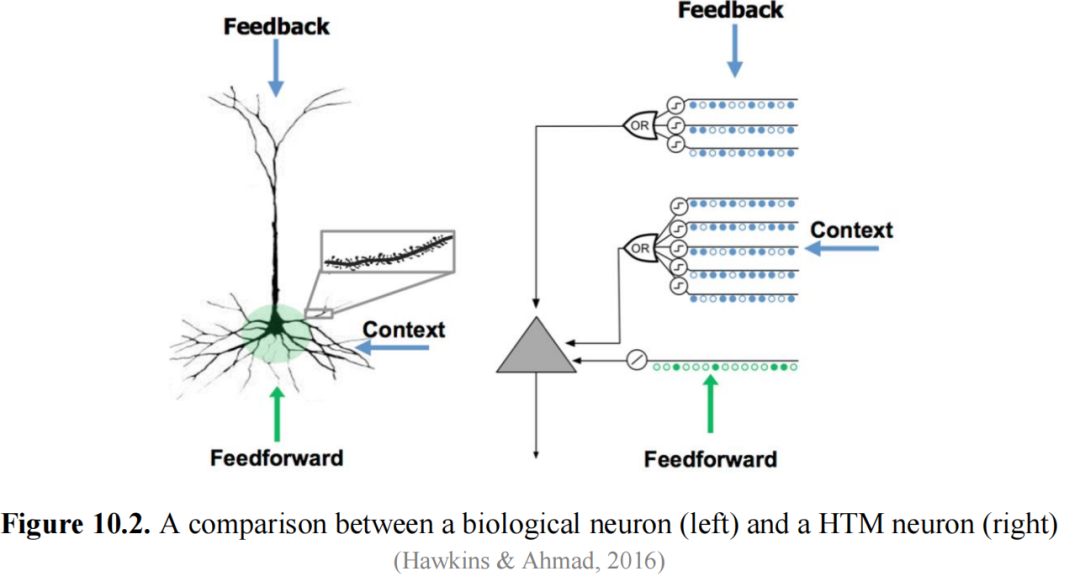

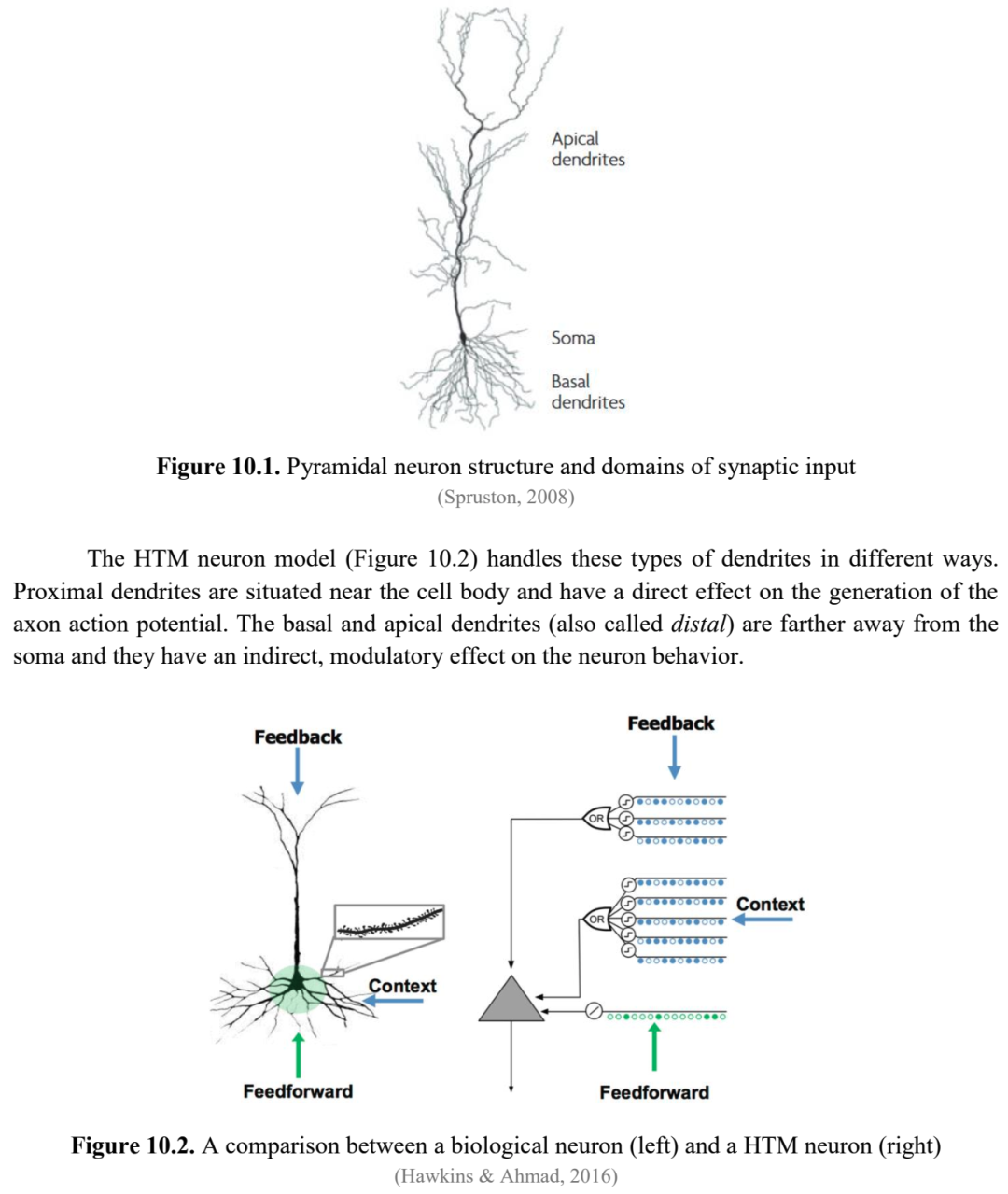

层次时间记忆(HTM)提出了一种受新皮层功能启发的神经结构和学习理论。它依赖于金字塔神经元的模型,并包括专门适用于从连续流数据中无监督地学习序列和检测这些流中异常的算法。

10.1.1. HTM神经元模型

在“点神经元”模型(方程3.1)中,树突是被动的组件,只是将接收到的信号传递给神经元体进行求和。然而,在生物神经元中,树突分支似乎是活跃的处理元素,可以产生非线性响应,例如在新皮质中发现的主要类型的兴奋性神经元——锥体神经元中。

每个神经元都有数千个突触,它们充当独立的模式检测器。当任何这些模式被树突段检测到时,它会触发一个n-甲基-d-天冬氨酸(NMDA)尖峰。这些不是通过轴突传输的尖峰,如第2.3节所述,而是树突尖峰,高度局部化的事件,发生在小的树突段内,通常长度为10-40微米。当一小部分突触在特定的树突段上同步激活时,会产生NMDA尖峰(8-20个,平均约15个),相比于数千个突触的总数(Brandalise等人,2016)。

准确的识别依赖于模式的稀疏性,只有少数神经元处于活跃状态。在这种情况下,当一个树突的所有突触同时接收激活时,它可以检测到一个特定的模式。因此,单个神经元可以识别数百种模式。任何模式的识别都会导致神经元去极化。通过建立比触发NMDA尖峰所需的更多的突触,识别变得对噪声和变化具有弹性。即使一些细胞发生变化或变得不活跃,树突仍然可以成功识别目标模式。

遵循Hebbian可塑性,当突触前输入成功诱导突触后活动时,突触会加强。NMDA受体的激活和随后的钙(Ca2+)水平升高触发了负责长期增强的生化机制,这是一个与学习和记忆相关的突触加强过程。

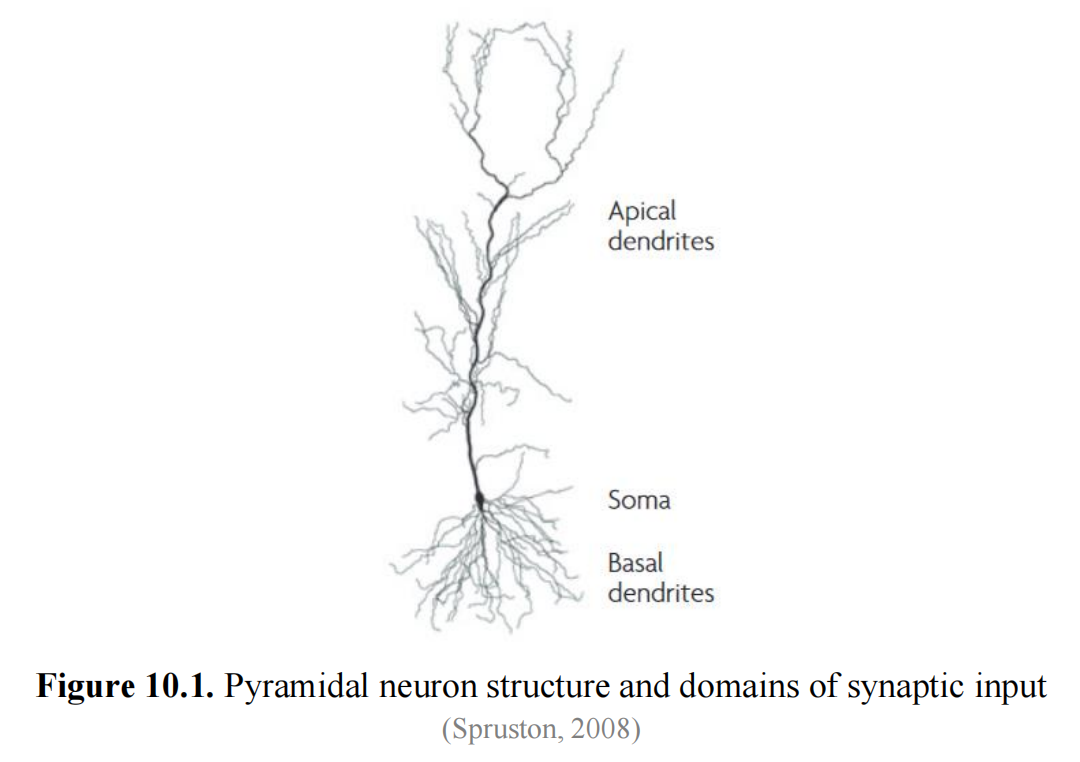

树突分为基底、近端和顶端整合区(图10.1),每个区都有不同的特性。这些区域被认为在信息处理中扮演不同的角色。

HTM神经元模型(图10.2)以不同的方式处理这些类型的树突。 近端树突位于细胞体附近,对轴突动作电位的产生有直接影响。基底和顶端树突(也称为远端)远离细胞体,它们对神经元行为有间接的调节作用。

近端突触,通常有几百个,位于近端树突上,在细胞体上有相对较大的影响。它们的主要作用是定义神经元的经典感受野。如果一部分近端突触同时被激活,它们可以产生一个体AP。这些突触非常适合在输入稀疏活动时识别多个独特的正向模式。因此,神经元的正向感受野可以看作是正向模式的联合。

基底树突负责识别神经元发射前的细胞活动模式。当基底树突识别到一个模式时,它会生成一个NMDA尖峰。由此产生的去极化,虽然不足以触发体AP,但代表了一个预测,即细胞可能很快变得活跃。这种亚阈值去极化可能导致细胞比没有它时更早地发射。

顶端树突在识别模式时也会产生NMDA尖峰。它们引起的去极化被认为会产生一个自顶向下的预期,这可以被认为是另一种形式的预测。

因此,近端突触直接触发AP,而基底和顶端树突识别的模式使细胞去极化,可以被认为是预测信号。基底突触检测预测下一个正向输入的上下文模式,而顶端突触识别预测整个序列的反馈模式。

之前去极化的神经元比那些没有经历去极化的神经元更快地产生尖峰。与快速局部抑制机制一起,这个过程使网络的激活状态偏向于其预测。这种激活、预测和激活的循环形成了序列记忆的基础。HTM旨在模拟大脑处理和识别复杂模式的能力,特别是在时间序列数据中。

现在我们将描述HTM的两个典型的学习算法。然而,它们以一种简化的形式呈现,省略了一些细节。

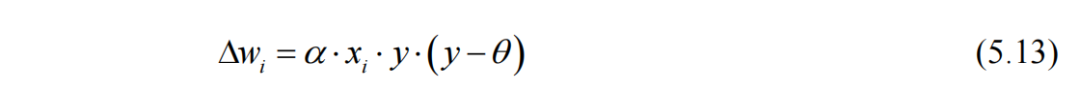

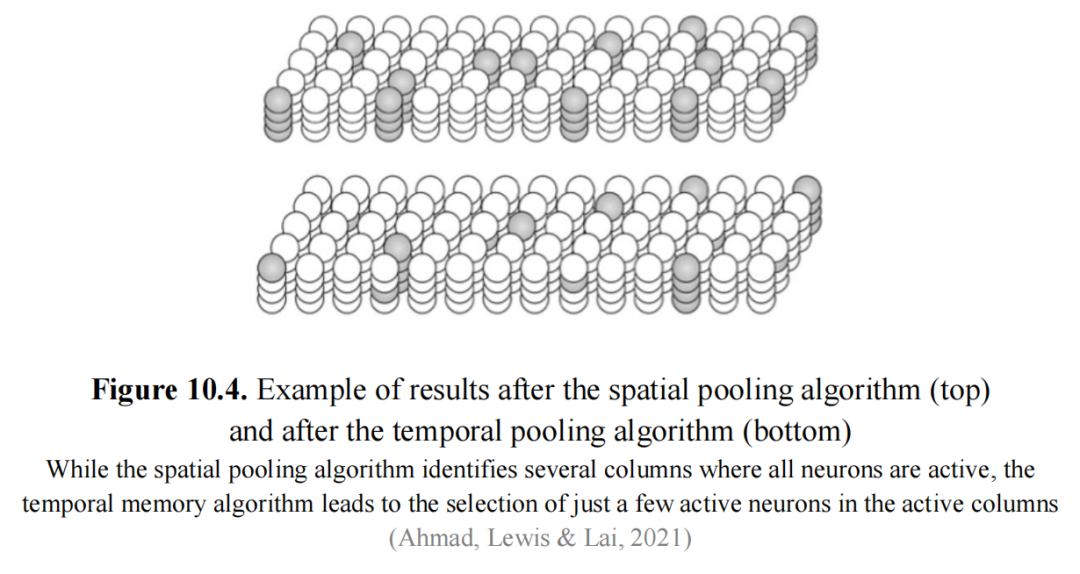

10.1.2. 空间池化算法

在空间池化算法中,输入被认为由固定数量的比特组成。然后初始化一个HTM区域,分配预定数量的列来接收这个输入。例如,一个区域可能被配置为一个4096列的数组。空间池化在这些列的层面上操作,每一列作为一个单独的计算单元(图10.3)。这些列中的每一个都配备了一个相关的树突段,作为连接它到输入空间的桥梁,如图10.2中的HTM神经元所示。

这些树突段包含一组潜在的突触,代表输入比特的随机子集。这些突触与输入空间内的特定比特建立连接。每个突触都有一个持久性值,概念上类似于其强度。突触可以存在于三种状态之一:连接(当持久性值超过某个阈值时)、潜在(当持久性值低于阈值时)和未连接(无法建立连接)。

突触的效果是二元的,意味着它可以是活跃的或不活跃的。持久性值最初被赋予围绕持久性阈值的随机值。因此,如果它们的持久性值超过阈值,一些突触可能已经连接。

一旦初始化完成,算法开始运行。对于给定的输入,它评估每个列中有多少连接的突触与活跃的输入比特相关联,将这些指定为活跃的突触。然后,在一个抑制半径内的一小部分列,具有最高激活的列变得活跃,抑制该半径内的其他列。这个阶段决定了哪些列成为赢家,并在抑制步骤后继续保持活跃。

在这个阶段,一组稀疏的活跃列仍然存在。随后,该区域开始使用Hebbian式学习规则进行学习阶段,以调整活跃列的突触的持久性值。对于获胜的列,与活跃输入比特对齐的突触的持久性值增加,而与不活跃输入比特对齐的突触的持久性值减少。非获胜列的突触的持久性值保持不变。

这些持久性值的变化可能会使一些突触的状态从连接变为潜在,反之亦然。然后整个过程重复。

10.1.3. 时间记忆算法

时间记忆算法在空间池化算法之后继续,初始状态由一组代表前馈输入的活跃列组成。更正式地说,我们可以说它在稀疏分布式表示(SDR)的序列上操作。时间记忆算法的主要功能是学习序列并进行预测。

在这个算法中,突触与树突段建立连接,树突段有两种类型:近端和远端。近端树突段与前馈输入形成突触,它们的活跃突触被线性求和以确定列的前馈激活。相比之下,远端树突段与层内的细胞形成突触。每个细胞有多个远端树突段,当一个远端段上的活跃突触之和超过预定义的阈值时,相关的细胞进入预测状态。通过跨多个阈值检测器的逻辑或操作来确定细胞的预测状态,考虑到每个细胞有多个远端树突段。

在空间池化阶段之后,时间记忆算法将列输入表示转换为一个新的表示,该表示结合了历史上下文。这个新的表示是通过激活每个列内的一部分细胞来创建的,通常每列只选择一个细胞。

在这里,HTM(Hierarchical Temporal Memory,分层时序记忆)单元可以存在于三种状态之一:活跃状态(当受到前馈输入的影响时)、预测状态(由于与邻近细胞的侧向连接部分去极化时)和中性状态。

如上所述,时间记忆算法在空间池化算法停止的地方开始,活跃的列代表前馈输入。算法的每个时间步骤包括几个计算:

- 系统接收一组活跃的列;

- 对于每个活跃的列,它识别出列中具有活跃远端树突段的单元(即,从上一个时间步骤就已经处于预测状态的单元),并激活它们。如果不存在这样的单元,则激活列中的所有单元。这样的列被称为“爆发”状态。活跃单元的集合代表了在先前输入的背景下的当前输入。这种机制允许系统在输入模式与预测一致时确认其期望。否则,当输入模式是意外的时,激活列中的所有单元;

- 在没有先前状态的情况下,因此没有背景或预测,当列活跃时,列中的所有单元都变得活跃。这种情况类似于在一首歌中听到第一个音符,没有背景,很难预测接下来会发生什么,因此所有可能性都保持开放。当有先前状态,但输入与预期模式不匹配时,活跃列中的所有单元都变得活跃;

- 对于每个活跃的列,算法至少在一个远端段上进行学习。在列爆发的情况下,它选择一个在任何永久性水平上都有一些活跃突触的段,或者在具有最少段的单元上生长一个新的段。它增加活跃突触的永久性,减少不活跃突触的永久性,并为之前活跃的单元创建新的突触;

- 树突段通过计算每一层中每个树突段上当前活跃单元对应的突触数量来激活。如果计数超过阈值,树突段被标记为活跃。这些具有活跃远端树突段的单元将在下一个时间步骤中成为预测单元。

HTM学习算法可以根据不同上下文为相同的实例创建不同的表示。以(Hawkins & Ahmad, 2016)中的例子为例,让我们考虑两个输入序列:ABCD和XBCY。这里,每个字母表示一组神经元中的稀疏激活模式。学习这些序列后,网络预期在ABC之后预测D,在XBC之后预测Y。因此,BC在两种情况下的内部表示必须是不同的。否则,网络无法在C之后正确预测下一个项目。

图10.5显示了两种情况下表示的不同。尽管在空间池化之后B和C的表示是相同的,但在时间阶段之后选择的神经元子集根据之前呈现的序列区分了表示。这些状态被表示为B′、B″、C′、C″等。因为C′和C″是不同的,它们可以正确预测D或Y。

HTM(分层时序记忆)非常强调数据的时间方面。它擅长对时间序列建模和识别模式,使其非常适合涉及时间序列的任务。它能够识别时间依赖性、事件顺序和异常(或离群值)。使用稀疏分布式表示,只有一小部分神经元变得活跃以表示特定模式,这增强了记忆效率和鲁棒性,使HTM能够有效处理嘈杂或不完整的数据。

HTM还能够进行在线学习,这意味着它可以随着新数据的可用性不断更新其对模式的理解。这种动态学习过程使HTM适合实时应用。

虽然“分层时序记忆”这个名字暗示了一种分层结构,但重要的是要注意,这样的层次结构实际上并没有实现。HTM的典型描述主要集中在上述的两种算法上:空间和时间池化。它们通常被单独讨论,没有强调HTM可能创造的更广泛的分层框架。可能的分层实现将使用类似树的结构,具有多个层次的区域。每个层次将容纳多个区域,而更高层次将具有较少的区域。这种分层结构将允许更高层次的区域利用在较低层次学到的模式,将它们结合起来编码和回忆更复杂和抽象的模式。然而,这样的实现不太可能,因为HTM模型已经被“千脑”模型所取代,这将在下一节中介绍。

10.2. “千脑”理论

在“千脑”理论中,新皮层被描绘为生成有关它将从外部世界接收到的感官输入的预测。这些预测是基于大脑通过以往经验发展出的对世界的模型构建的。新皮层内的每一列神经元作为一个迷你大脑,自主生成预测。这些列预测随后通过大脑的相互连接网络结合,形成对世界的集体感知。“千脑”一词暗示了新皮层由许多神经元列组成,每一列都作为一个独立的预测生成器。每一列都包含对特定模式或特征具有选择性的细胞。例如,在视觉皮层中,一些列可能专门识别边缘,而其他列可能识别形状。这些专门的预测随后被整合,以获得对视觉场景的全面理解。

杰夫·霍金斯(Jeff Hawkins,2021年)想象了一个关于五个具有不同感官能力和各种城镇地图的人的类比,他们被放入这些城镇中的一个未知位置。他们可以在地图上识别地标,但无法独立确定自己的确切位置。他们每人都拥有一张被切成正方形的地图,上面有关于城镇的感官信息:声音、质地或图像。他们首先根据他们所感知到的个别确定可能的城镇。通过一个投票过程分享他们潜在城镇的列表,他们共同缩小了他们的选择范围。如果一个城镇出现在每个人的列表上,他们就得出结论,他们就在那个特定的城镇。投票机制无论感官能力或地图的细节如何都能工作。他们只需要就他们都假定的城镇达成一致。然而,他们可能会遇到多个城镇与他们集体的感官信息匹配的情况。为了进一步细化他们的位置,他们分享他们的相对位置,以排除不匹配已识别地标空间排列的城镇。这种感官输入之间的投票过程反映了大脑皮层列如何将各种感官输入合并为一个连贯的表示。此外,皮层列还可能分享有关相对位置的信息,帮助根据熟悉特征的排列确定确切位置。

作者假设新皮层也包含网格细胞,但它们代表相对于对象的各种特征的位置。他建议,用于学习环境结构的内嗅皮层和海马体的机制也被新皮层用来学习对象的结构。因此,不同皮层列中的网格细胞跟踪感知特征相对于正在交互的对象的位置。每个皮层列中的位置表示导致了关于新皮层如何表示对象的组合性和行为的思考。作者提出,新皮层的每一部分学习对象的完整模型,并且同一对象的多个模型分布在整个新皮层中。

位移细胞的概念也被引入,同样作为一个假设。与网格细胞类似,位移细胞本身不能表示一个独特的位移。相反,它们以类似于网格细胞模块表示唯一位置的方式表示相对位移。多个位移细胞模块的活动被用来表示一个独特的位移。例如,一个单一的位移向量可以表示对象的相对位置,如咖啡杯上特定位置的徽标。

位移向量不仅表示相对位置,而且对所考虑的特定对象也是独特的。这意味着复杂对象可以通过一组位移向量来表示,定义对象的组成部分及其相互之间的排列。使用位移向量表示对象的方法还允许层次化组合。例如,杯子上的徽标可以由字母和图形等子对象组成。表示徽标的位移向量隐含地携带了其中子对象的信息。位移向量的概念还允许递归结构。例如,一个徽标可能包含一个带有自己徽标的咖啡杯的图像。这种递归组合是表示物理对象、语言、数学和其他形式智能思维的一个基本方面。

新皮层的感觉处理发生在两组平行的区域中,称为“什么”和“哪里”路径。在视觉中,“什么”路径与识别对象有关,而“哪里”路径与空间信息有关,例如伸手去拿一个对象。在其他感官方式中也观察到了类似的“什么”和“哪里”路径,这表明了皮层组织的一个普遍原则。

霍金斯提出,基于位置的皮层功能框架适用于“什么”和“哪里”的处理。这些区域之间的主要区别在于,“什么”区域以一种分配中心的方式(在对象的空间位置中)表示位置,而“哪里”区域以自我中心的方式(在身体的地点空间中)表示位置。在“什么”和“哪里”区域,一个共同的操作涉及关注两个不同的地点。位移细胞确定从第一个位置移动到第二个位置所需的移动向量。在“什么”区域,这可能涉及将手指从一个对象的一个位置移动到同一对象上的另一个位置。相比之下,“哪里”区域计算如何在身体内从一个自我中心的位置移动到另一个位置,而不考虑这些位置是否有对象存在。

思维被概念化为通过这些地点空间的移动。

作者指出,有许多皮层-皮层投射不符合传统的层次处理模型。这些非层次连接包括左右半球区域之间的长程投射以及不同感官方式区域之间的连接。他建议,这些连接与传感器融合和对象识别有关。不是单一统一的对象模型,而是每个对象有数百个模型,每个模型基于来自不同感官方式的独特感官输入子集,例如视觉或触觉。长程非层次连接允许这些模型快速就感知对象的身份达成共识。

在认知过程中,层级概念表示似乎是基础性的观点,可能是非层级神经表示的涌现效应,这是一个有趣的问题,也将在下一节中讨论。

下面内容在第二部分继续

10.3. 其他模型

(Pischedda等人,2017年)研究了人脑如何在各种认知任务中表示和组织使用的规则。一些理论认为大脑在前额叶皮层的不同层级编码规则,这项研究旨在澄清不同层级的规则是否真的在不同的大脑区域中表示。该研究依赖功能性磁共振成像(fMRI)来检查低层级和高层级规则在大脑中的编码是否不同。参与者的任务是应用包含低层级刺激-反应规则和高层级选择规则的规则集。

研究结果揭示了在编码不同层级规则的大脑区域之间没有显著差异。与一些理论预期相反,这些规则似乎以类似的方式被表示。包含低层级和高层级规则的层级规则,在空间上没有根据它们在层级中的位置显著区分。这意味着无论规则是基本的低层级规则(处理基本感官刺激和反应)还是高层级规则(涉及更抽象的认知过程,如决策制定和任务选择),这两种类型的规则都由相同的大脑区域网络处理。

虽然网格细胞可以有效表示二维变量,但它们能否表示更高维度变量的问题随之而来。(Klukas, Lewis & Fiete, 2020年)提出的模型展示了它们如何有效编码大于二维的变量,同时保持低维结构。它通过低维随机投影和传统的六边形网格细胞响应的结合来实现这一点。

网格细胞以其在表示空间信息方面的作用而闻名,但最近的研究表明,它们也可以表示超出空间位置的各种认知变量。在飞行的蝙蝠或攀爬的老鼠等动物中观察到的放电场可以由结合多个网格模块活动的神经元生成。在三维环境中的网格细胞响应可能不会显示出规则的三维网格模式,但它们确实似乎允许在所有三个维度上进行定位。这种定位可能受到空间地标的影响,或由编码更高维空间的网格细胞的组合形成。

这表明网格细胞可以实现一种通用电路,能够为高维变量生成编码和记忆状态。作者提出了一种针对高维变量的编码方案,考虑到网格细胞响应的结构和动态约束。他们假设每个网格模块的活动保持在神经状态空间中的二维环形吸引子内。模块化编码,即将神经元划分为不同的组以编码变量的不同方面,为表示高维变量提供了一种有效手段。网格细胞的多模块表示提供了一个高效的高维向量空间,既可以用于表示,也可以用于记忆任意更高维度的向量。网格细胞的更新机制允许存储向量之间的向量代数运算,这对于抽象高维空间中的向量整合至关重要。该网络可以在不需要重新配置网格细胞网络的情况下,表示、存储并对不同维度的抽象向量执行代数运算。

(Constantinescu, O'Reilly & Behrens, 2016)解释说,在与空间和概念任务相关的大脑区域中发现的类似网格的活动,提出了存储空间和概念表征的共同神经编码机制的可能性。它引用了海马体细胞在人类中编码个体概念的证据,并指出啮齿动物的网格细胞可能代表超出空间的维度,例如时间。该研究使用功能性磁共振成像(fMRI)来调查人类在导航抽象概念表征时是否采用六边形对称编码。为实验设计的任务类似于空间导航,但涉及抽象维度。

实验的参与者学习了鸟类刺激与圣诞节相关符号之间的关联。鸟类刺激是独特的,并在两个连续维度(颈部和腿部长度)上有所变化,但在一维(垂直)视觉空间中呈现。这要求参与者从一维视觉呈现中提取二维概念信息。

参与者观看了根据特定颈部到腿部比例变形的鸟类视频,并被指示想象如果鸟类继续以相同的方式变形,将出现哪个符号。为确保鸟类空间中的运动轨迹方向与视觉属性分离,轨迹设计为避免与视觉特征共享方差。在某些试验中,参与者必须从三个符号中选择一个(图10.6)。

参与者在基于鸟类变形预测符号方面达到了高准确率(约73%),然而,没有人报告说他们将鸟类和符号之间的关系想象成空间地图,即参与者并没有意识到这些关联可以组织在一个连续的“鸟类空间”中。

研究发现了神经活动中的六角调制效应;这种效应在整个大脑中被识别出来,并且在特定区域最为强烈。因此,大脑可能使用具有六角网格模式的全局代码来组织非空间的概念表征。

(Mok & Love, 2019)对内侧颞叶(MTL)中的概念知识依赖于空间处理和导航回路的观点提出了挑战,提出了一个通用学习算法作为解释空间和概念领域中发现的现象。尽管MTL支持的记忆类型在表面上存在差异,但本文提出MTL采用通用算法来学习和组织与上下文相关的信息,使其以有用的格式呈现,而不是依赖于特定于导航的神经回路。

将啮齿动物置于不同几何环境中的实证研究支持了模型预测。在这种情况下,网格细胞的激活在非均匀环境中变得不那么网格化,特别是在更狭窄的区域中,这种下降尤为明显。

(第15.7节中介绍的)一个认知聚类模型在一个正方形环境中被训练,然后转移到一个梯形环境中。因此,模型的“网格得分”(六角对称性的度量)在梯形环境中下降,与梯形的宽侧相比,狭窄侧的下降更为显著。聚类模型表明,由于空间导航任务中可能的输入分布相对均匀,网格状表征在空间导航任务中出现。相比之下,在概念任务中,输入采样更稀疏,整体空间更高维,表征更符合人类的概念知识。环境几何形状的变化,包括非均匀性,预计会影响聚类并使网格模式不那么明显。

该研究强调,最初提出用于理解记忆和概念学习的模型,也解释了空间导航现象,包括地点细胞和类似网格细胞的表征。它表明,空间发现自然地作为更一般的概念学习机制的特例出现。因此,在编码抽象空间时,类似网格的响应应该是例外,而不是规则。表征空间可以是高维的,并非所有维度都同样相关,导致在复杂环境中出现非网格状的响应。

在(Stachenfeld, Botvinick & Gershman, 2017)中,对海马体中地点细胞作为编码纯空间认知地图的传统观点提出了挑战。相反,作者提出海马体主要编码一个预测地图,它代表对个体未来状态的预期。这意味着地点细胞的激活不仅仅与当前位置有关,还取决于个体预期接下来要去哪里。

海马体的预测功能在强化学习(RL)框架内被形式化,强调编码期望和预测。后继者表征(SR)方法被提出作为无模型和基于模型学习方法之间的中介。它允许灵活的价值计算以响应奖励的变化,而没有纯粹基于模型的方法所伴随的计算效率低下。该论文建议,SR可以通过扩展优先更新的前向扫描范围来补充基于模型的规划。与传统的认知地图或基于模型的RL不同,这一理论认为,使用无模型学习方法构建预测地图,在动态环境中更具适应性。

作者提出海马体将SR编码为神经元群体的速率码。每个神经元代表一个可能的未来状态(例如,未来空间位置)。编码特定状态的神经元的放电率与在当前策略和当前位置下,该状态在访问次数上的折现期望值成比例。论文引入了“SR地点场”或“SR感受野”的概念,这些是环境中特定编码未来状态的神经元具有高放电率的区域。在二维环境中,这些SR地点场类似于地点细胞的传统圆形放电场。当人们从场地的峰值移开时,放电率逐渐降低。

最初,网格细胞被认为是表示欧几里得空间度量,有助于路径整合(或航位推算),即通过使用先前确定的位置和速度、航向和经过时间的估计来近似当前位置。提出的预测地图理论表明,网格场倾向于不是全局规则的网格,而是受全局边界和多室结构影响的任务结构的预测地图。

在多室环境中,与单一室矩形围栏相比,网格场的规律性变得不那么明显,因为分隔室之间的障碍物扰乱了从不间断的二维网格的任务拓扑。

在(Stoewer等人,2023年)中,认知地图被讨论为记忆和经验及其关系的表示。这些地图是通过地点和网格细胞形成和导航的。论文引入了“多尺度后继者表征”作为地点和网格细胞计算背后的数学原理。这一原理被提出为构建认知地图的基础。

提出了一个神经网络模型,该模型被训练学习从编码为特征向量的32种不同动物物种中派生出的语义空间的认知地图。通过训练,网络有效地识别了这些物种之间的相似性,并构建了一个“动物空间”的认知地图。

该神经网络模型实现了用于非空间导航任务的后继者表征(SR),并结合了记忆痕迹理论和认知地图理论。SR被视为模拟地点细胞放电模式的一种方式。它涉及计算环境中状态的未来奖励矩阵,并使用它们构建表征。基于SR发展的认知地图可以用于通过任意认知地图进行导航,以及在新输入和过去记忆中寻找相似性。

模型展示了创建具有不同尺度的层次化认知地图的潜力。细粒度地图显示了特征空间中动物向量的均匀分布,而粗粒度地图则按生物类别对动物进行聚类,例如两栖动物、哺乳动物和昆虫。该模型还展示了它可以通过从认知地图中插值表征来准确表示完全新的或不完整的输入。

这种模型的实现为理解大脑如何处理和导航抽象概念空间提供了新的视角,并可能有助于开发更智能的人工智能系统,这些系统能够学习和适应不断变化的环境。通过将抽象概念空间映射到类似于空间导航的神经表征中,这些模型可以帮助揭示大脑如何在复杂环境中识别模式和关系。

(Whittington等人,2020年)将空间记忆和关系记忆问题视为结构抽象和泛化的例子。这意味着,就像不同的空间环境共享共同的规律性,允许进行推断和捷径一样,类似的结构规律性也使得非空间关系问题中能够进行推断。分解表征涉及将知识的不同方面分开,并灵活地重新组合它们以代表新的经验,这对学习和进行推断是有益的。作者引入了托尔曼-艾肯鲍姆机器(Tolman-Eichenbaum machine, TEM)作为一个模型,利用分解和结合来构建一个能够在空间和非空间领域泛化结构知识的关系记忆系统。TEM预测,尽管海马重映射可能看起来是随机的,但实际上反映了跨环境保持的结构表征。作者在地点细胞和网格细胞中验证了这一预测,提出了一个统一的框架,用于海马-内嗅皮层在各种任务中的表征、推断和泛化。

论文描述了一个无监督学习问题,涉及一个代理任务,该代理任务需要预测从图的概率转换中派生的序列中的下一个感官体验。代理被呈现感官观察序列以及有关引起图上相邻节点之间转换的关系或动作的信息。存在不同类型的关系,如家族层级或空间导航。当代理经历了图上所有可能的转换时,它可以将整个图存储在记忆中并进行完美预测。然而,如果事先知道图的结构属性,即使在经历所有转换之前,也可以进行完美预测。这是因为理解结构允许代理根据已知模式推断额外的关系和转换。

例如,在家族层级中,了解结构允许代理进行诸如“Bob有一个女儿,Emily”的推断,这立即导致其他推断,如“Emily是Alice的孙女和Cat的侄女”,而无需直接经历这些转换。同样,在空间导航中,理解二维图的结构使代理能够在坐标上放置一个新节点,并推断其与图上其他点的连接关系信息。

感官预测问题被分解为两个主要组成部分:关系图结构和感官观察。理解关系结构有助于路径整合,而关系记忆将感官观察绑定到结构中的位置。为了促进泛化,模型将与抽象位置相关的变量(跨地图概括)与那些植根于感官体验的变量(特定于特定地图)分开。这些变量在神经网络中被表示为单元群体。

主要目标是学习神经网络(NN)权重,这些权重能够表示关系结构中的位置并形成关系记忆。这些记忆通过Hebbian学习存储,并稍后被检索。由此产生的神经网络架构与海马形成的功能解剖学非常相似,因为海马表征是通过结合感官输入和抽象位置形成的。为了推断抽象位置的新表征,TEM根据当前动作/关系从先前的抽象位置执行路径整合。路径整合中的错误累积使用存储在海马记忆中的联合表征进行校正。在具有自重复结构的情况下,认知地图可以分层组织。该模型包括多个并行流,每个流接收感官输入并拥有自己的抽象位置表征。

该研究强调了TEM学习方案与醒睡算法和Helmholtz机器(Dayan等人,1995年)之间的相似性。它表明,从清醒经历中提取规律性的海马重放可能涉及从环境的生成模型中抽样,就像TEM所做的那样。

(O'Reilly等人,2014年)回顾了与补充学习系统(CLS)框架(McClelland, McNaughton & O'Reilly, 1995年)相关的观点,该框架解释了为什么大脑需要两个专门的学习和记忆系统,并指定了它们的中心属性:海马作为快速学习情景记忆的稀疏、模式分离系统,以及新皮层作为逐渐整合跨情景以提取潜在语义结构的分布式、重叠系统。

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2024-07-01,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读