OpenSU3D 利用2D基础模型,构建实例级3D场景表示,超越当前所有3D场景理解水平!

OpenSU3D 利用2D基础模型,构建实例级3D场景表示,超越当前所有3D场景理解水平!

在本文中,作者提出了一种新颖的、可扩展的方法来构建开放集的实例级3D场景表示,从而推进对3D环境的开放世界理解。现有方法需要预先构建的3D场景,并因逐点特征向量学习而面临可扩展性问题,这限制了它们在复杂 Query 上的有效性。 作者的方法通过使用2D基础模型递增地构建实例级3D场景表示,有效地聚合了实例级细节,如 Mask 、特征向量、名称和标题,克服了这些限制。作者引入了特征向量的融合方案,以增强它们在复杂 Query 上的上下文知识和性能。 此外,作者还探索了大型语言模型,以增强自动标注和空间推理任务的鲁棒性。作者在ScanNet和Replica [2]数据集的多个场景上评估了所提出的方法,展示了零样本泛化能力,超过了当前开放世界3D场景理解的现有技术水平。 项目页面:https://opensu3d.github.io/。

I Introduction

人工智能技术的迅速发展已经引发了一系列社会、经济和文化变革。在众多领域中,这项技术已经成为了创新和增长的关键驱动力。然而,随着人工智能技术的广泛应用,作者也必须面对一系列挑战和问题。本文将探讨人工智能技术在社会、经济和文化领域中的应用及其所面临的挑战,并提出了相应的解决方案。

Motivation

近期人工智能的进步在开放集目标检测和2D图像的上下文理解方面取得了重大突破,这主要得益于如CLIP[3]、SAM[4]等预训练的基础模型,以及视觉与语言模型的整合[5,6]。然而,将这些成功经验应用于3D场景仍具挑战性。当前的3D方法[7,8,9,10,11]虽然在创新性方面有所建树,但尚未达到其2D对应方法的性能水平。弥合这一差距对于需要3D交互的应用至关重要,如机器人技术和数字孪生等领域,这将彻底改变作者感知和与三维世界互动的方式。

Limitations of Current Methods

近期的工作令人印象深刻地将二维基础模型整合用于开放世界三维场景理解。然而,这些方法存在几个局限性。这些方法大多被设计为批量处理或非增量方法,需要在实际操作前获取完整的3D场景数据,这在许多机器人应用的实际操作中是不切实际的。这些方法主要从二维基础模型(如CLIP [3, 12])生成3D特征向量,但缺乏一个通用的策略来外推来自其他类型二维基础模型的2D到3D信息。此外,创建密集的、逐点特征向量不仅带来内存和可扩展性问题,还使得在场景中隔离不同实体这一关键任务变得复杂,这对于实际应用至关重要。尤其值得注意的是,现有方法似乎在处理简单 Query 时有效,但在处理更复杂的空间 Query /任务时缺乏所需的深度和上下文理解。

Proposed Approach

作者提出了一种新颖的方法来构建开放集的3D场景表示,该方法解决了开放词汇实例回忆(物体搜索)、分割、标注和空间推理的问题。作者的方法利用2D基础模型从RGB-D图像中提取实例级信息,使用GroundedSAM [13]获取 Mask 、边界框、名称和预测分数,以及使用GPT-4V [6]进行详细描述。对于每个实例,从多个尺度提取CLIP [3]的特征向量并进行融合。图像中的每个实例都被分配一个唯一的ID,并有一个相关的2D分割 Mask 。这些 Mask 通过使用深度和姿态数据反投影,构建每个图像的分割3D场景。作者的方法跟踪并更新基于重叠区域技术的2D和3D分割 Mask 及相应的元信息,使得在探索环境时能够高效、可扩展且递增地构建3D场景。实例级表示和特征融合方案融入了局部上下文,有助于在关系 Query 中区分同一类别内的实例。

Key contributions

本研究在3D场景理解领域做出了以下主要贡献:

1. 作者提出了一种增量式且可扩展的方法,用于开放集3D场景理解和实例分割,该方法将来自单个图像的实例级信息无缝集成到统一的3D场景表示中,利用2D基础模型。

2. 作者开发了一种创新性的特征融合公式,通过上下文 Query 实现对同一类别内实例的识别,并提高了整体开放词汇3D目标搜索性能。

3. 作者探索将大型语言模型与构建的3D场景表示结合使用,以实现自动标注和复杂的空间推理 Query 。

II Related Work

Foundation & Large Language Models

基础模型通过在大规模数据上的训练,已经在各种任务中实现了前所未有的性能,从而革新了人工智能。CLIP [3]、BLIP [14] 以及类似的模型融合了视觉和文本数据,创建了统一的表征,从而在多模态任务(如图像字幕生成、视觉问答和跨模态检索)中提高了性能。在分割领域,LSeg [15] 和 OVSeg [16] 提供了可提示和开放词汇的能力。基于 SAM [4] 的接地模型,如 GSAM [13] 和 SEEM [17],通过结合额外的语义和情境信息来上下文化输出,从而提高了模型预测的解释准确性和相关性。这使得在图像分割、目标检测和场景理解等任务中能实现更精确和上下文感知的应用。语言模型 [18, 19] 在自然语言任务上表现出色,而它们与视觉 [6, 20] 的融合推动了开放世界理解的发展。本研究探讨了一种可泛化的方法,用于提取和关联2D图像与3D空间之间的信息,利用基础模型和大型语言模型的能力。

3D Scene Segmentation

语义分割是3D视觉领域的一个关键挑战。像Voxblox++ [21]和Kimera [22]这样的方法将语义信息与SLAM(同步定位与映射)结合,而Hydra [23]和场景图融合[24]等其他方法则在语义分割的场景之上构建3D场景图,然而,这些技术仍然在封闭集范式内操作。近期的研究,包括[25]和SAM3D [26],通过分析从RGB图像反投影的语义分割重叠点来识别3D实例,并且非递增地生成开放集的细粒度3D Mask 。相比之下,[25]提供了一种递增的、封闭集的稀疏点图方法,每次更新都有固定的计算量。作者提出了一种递增方法,使用SAM的2D Mask 和基于区域重叠的技术,以恒定的更新计算生成细粒度的3D实例 Mask 。此外,作者的方法有效地跟踪2D-3D Mask ID,从而实现了从每幅图像 Mask 到完整3D场景的高效信息传递。

3D Scene Understanding

三维场景理解通过利用2D视觉-语言模型,将其丰富的特征映射到3D空间以进行开放词汇 Query ,已经取得了显著的进展。早期的作品如OpenScene [8] 和 ConceptFusion [11],将来自CLIPSeg [12] 和 CLIP [3]的2D特征向量投影到3D空间,展示了其潜力,但也存在由于密集的点表示而导致的计算和可扩展性问题。最近的工作OpenMask3D [27] 提出了一种以实例为中心的方法,使用Mask3D [28],避免了可扩展性问题,但它仍然不是增量的,需要事先获取所有数据。此外,一些研究[11, 27]探索了高级特征工程,将来自以目标为中心和更大图像区域的CLIP向量融合,以捕捉局部和全局上下文。尽管已经取得了进展,但在计算、可扩展性以及非增量方法方面的挑战,仍需要更高效、适应性更强和更灵活的解决方案。

3D Spatial Reasoning

在全球三维空间推理方面,开放世界场景理解仍然具有挑战性。近期的研究3DCLR [7]、3DLLM [9]和GroundedLLM [29]提出了利用大型语言模型(LLM)进行三维推理的创新方法,但对于GPT-4V [6]这类模型而言,精确的二维空间推理仍然具有挑战性,如文献[30]所示。在二维空间推理方面,近期的研究如Set of Mark Prompting [30]探讨了提示方法以直接使用GPT4V [6]。作者采用了这种方法[30],通过策略性提示,使用LLM对作者构建的场景进行三维空间推理。

同时期工作

同时,像Segment3D [31]、OpenIns3D [32]和SayPlan [33]等方法也在处理三维场景理解问题。OVSG [16]和ConceptGraph [34]与作者的研究重点紧密相关,即关注于增量、可扩展的基于实例的表示。然而,作者独特地依赖于几何原理来合并三维 Mask ,而非CLIP相似性,实验结果显示这带来了更好的性能。此外,作者没有为空间推理构建单独的场景图;而是通过定制提示,利用LLM固有的推理能力来处理作者构建的场景。

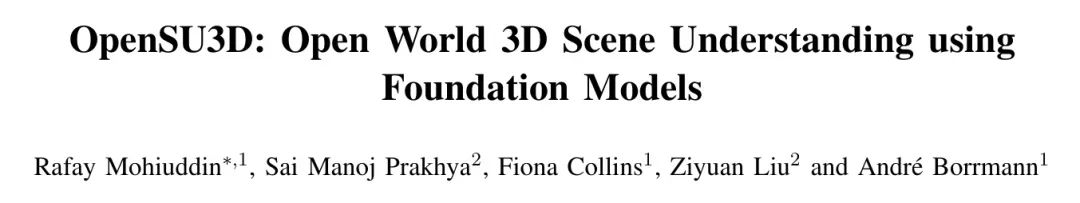

III Method

作者的方法处理一系列的RGB-D图像及其姿态,以创建一个开放集的3D场景表示,适用于开放世界场景理解任务,如开放词汇目标检索、3D分割、标注和空间推理。如图1所示,该流程包含两个主要模块:

1. 单图像特征提取: 从每幅图像中提取实例级 Mask 、嵌入和元信息,并为每个实例分配一个唯一ID以实现精确跟踪。

2. 2D到3D融合与跟踪: 从每幅图像的2D Mask 创建3D语义图,并通过跟踪相应的ID将2D信息关联到3D空间。

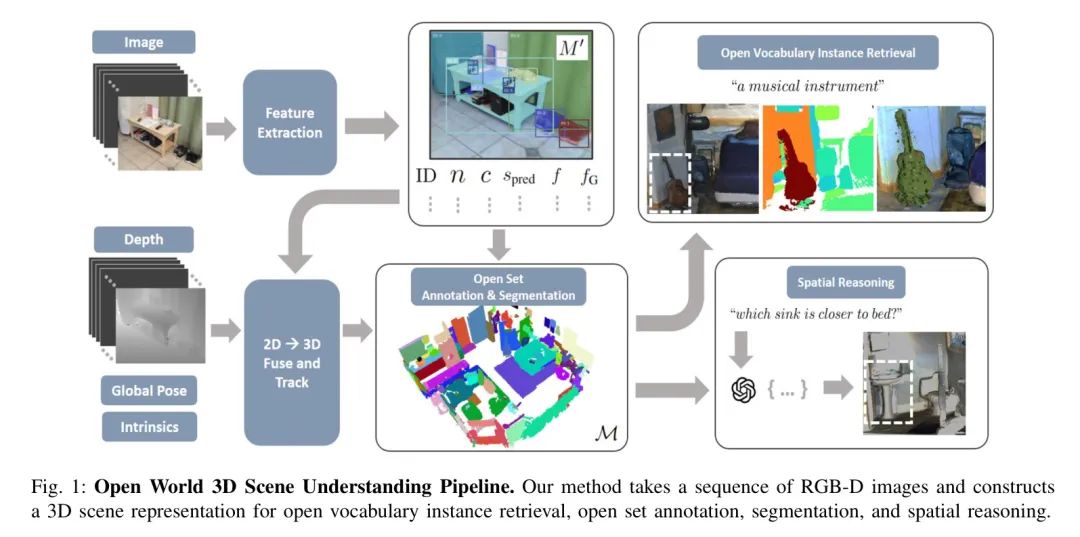

Per-Image Feature Extraction

如图2所示,特征提取过程从一系列RGB图像开始,。采用步长对子集进行采样,以确保合理的重叠以最小化计算冗余。对于每个图像,使用ground-edSAM [13]获取2D Mask 、边界框和预测得分。基于的每个实例的裁剪图像被传递给GPT-4V [6],以获得标签(名称)和描述目标的详细标题。

每个实例都被分配一个唯一的ID,并且 Mask 被更新为,这些ID以及在每个 Mask 周围添加像素的边框来界定实体。特征向量通过两阶段的CLIP编码器提取:

- 提取一个全局特征向量用于整张图像。

- 通过基于缩放比例的多尺度裁剪图像,创建特定实例的特征向量,然后使用第III-D节讨论的多尺度特征融合方案融合每个裁剪图像的向量。

更新的 Mask 以及实例级元数据,包括ID、名称、标题、预测得分、融合特征向量和全局特征向量,都被存储在中的每个图像中。

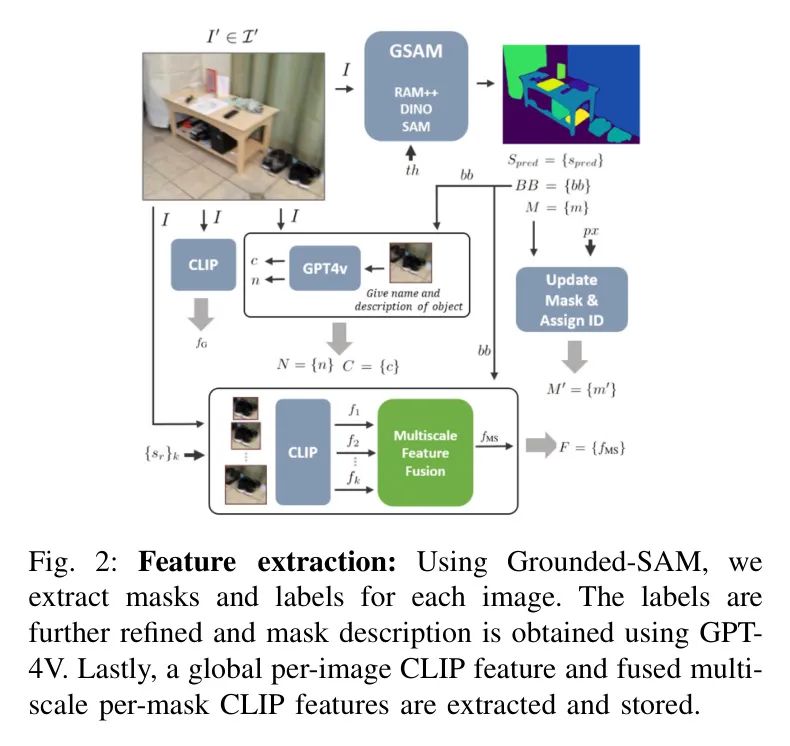

2D to 3D Fusion & Tracking

如图3所示,作者通过初始化一个完整3D场景的空3D点云来启动融合与跟踪模块,该点云表示为 ,并定义一个全局哈希表 用于跟踪唯一ID,定义为:。

对于图像 ,检索相关的元素,包括深度图 、全局姿态 、更新的 Mask 和相机内参 。图像中每个像素 利用深度数据反投影到3D空间,并根据 Mask 分配一个语义标签,从而生成单个图像的3D点云 。

请注意,公式部分保持不变,以满足您不翻译Markdown公式的要求。

利用的边界,作者从中抽取了,其中只包含在边界内的点。执行了搜索,使用欧氏距离函数将中的点与中的点进行匹配。如果,作者将与对应的索引与的索引分组,以获得所有重叠点的相应索引对。这种搜索策略将的搜索空间限制在仅重叠区域,因此每次更新所需计算量(搜索空间)是恒定的。

为了跟踪和更新匹配的ID,类似于SAM3D的[26]方法,作者首先为每个片段获取唯一的ID列表以及相应表示每个片段的总点数列表。

对于中的每个片段,其点数为,作者使用索引对获取与重叠的中的点集。从这些点中,作者导出唯一的片段ID列表及其相应的总点数列表。

如果重叠比满足一个预定义的阈值,即 ,作者将执行ID替换和更新操作。具体来说,在中出现的所有将被替换为,以得到,然后将其与连接。此外,为了保持恒定的稀疏性,还可以从中删除点集,确保每次更新都有固定的计算需求。

更新后的ID随后被添加到中;相反,如果重叠比未达到阈值要求,则在中添加一个新的条目。

Post Processing

更新后的点云集根据在中的重叠比更新了对应的ID,连同每幅图像的元数据一起被处理,以构建一个以实例为中心的整个场景的3D地图,定义如下:

对于每个独特的3D目标,作者执行基于DBSCAN的聚类以减少噪声并实现细粒度分割。相应地,重新计算3D边界框及其质心。对于与3D目标对应的每个多视角图像,使用检索2D ID 、名称、标题、预测分数和特征向量,以进行汇总和融合。每个3D实例的标签和标题根据最大的预测分数进行分配;或者,对于具有前个预测分数的图像中的每个目标裁剪,可以使用LLM [6]通过提示“根据给定的名称列表为目标分配一个名称”来细化标签,从而得到更准确的名字。最后,通过多视角方案(如第III-D节所述)融合前个分数的特征向量,得到对应多个视角的特征向量。

Feature Fusion

给定图像中一个实例的多尺度裁剪特征向量集 和对应于3D实例多视角图像的特征向量集 ,一个简单直接的特征融合方案如下所示对这些特征向量进行聚合:

然而,如等式4和等式5所示,这种简单的融合方案是有限的,并且对于相对 Query 的性能较低,这一点在第五节A中的消融研究中将被强调。此外,正如OpenMask3D [27]的研究发现,观察到多尺度裁剪添加了冗余的上下文,较大的裁剪会降低整体目标的召回性能。为了解决这些问题,作者提出了一个改进的多尺度融合方案,如等式6所示。作者提出的融合方案通过基于余弦相似度对最佳匹配裁剪分配权重,有效地降低较大裁剪的影响。

对于多视角特征的综合,作者借鉴了ConceptFusion [11]的方法,该方法专注于融合2D像素级特征,作者提出直接合并全局特征向量 ,在为每个实例合成多视角特征向量时定义如下:

Instance Retrieval & Segmentation

在给定地图 的情况下,开放词汇3D目标搜索或3D实例检索与分割分为两个阶段。首先,使用CLIP文本编码器处理 Query 以获得特征向量 。其次,计算所有3D实例 的余弦相似度得分,并检索具有最大相似度得分的3D实例的分割 Mask ,即 作为对 Query 最可能的响应。

Spatial Reasoning

对于涉及复杂空间推理的 Query ,关键思想是利用像GPT-4这样的大型语言模型的长上下文窗口,基于对构建的场景的连贯3D表示和元数据(如 Mask 标签、质心、边界框以及描述)进行空间推理,并使用上下文学习。通过简化地图,以及使用定义的提示策略设计的系统提示一起传递:

- 使用'名称'和'描述'来理解目标。

- 使用'ID'来引用目标。

- 使用'笛卡尔坐标'。

- 获取'质心'和'边界框'信息。

- 如有必要,计算'欧几里得距离'。

- 如有必要,假设'容差'。

IV 实验设置

Datasets

在彻底的定性和定量评估中,作者使用了半合成数据集Replica [2]中的多个场景以及真实世界的ScanNet [1]数据集中的场景。与之前的研究[11, 34]类似,由于需要进行大量的人工评估,因此选择了有限数量的场景。

Implementation Details

Iv-B1 Models Utilized

作者采用了GroundedSAM [13](一种基于RAM++ [35] 和SAM [4]来生成实例分割 Mask 和边界框。GPT-4V [6](gpt-4-vision-preview,gpt-4-1106-preview)被用于为实例创建详细描述和名称以及空间推理。CLIP编码器 [3] 用于实例特征向量。

Iv-B2 Hyper parameter Settings

对于所有数据集,作者使用了相同的超参数,这些超参数是通过在Replica [2](第V-A节)上进行消融研究确定的。作者设置 ,选择前 张图像,并应用 ,使用 个 Level 的裁剪,缩放比例递增 ,即 。为了确保在所选数据集中帧之间有足够的重叠,采用了 的步幅。对于GroundedSAM [13],阈值设置如下:IoU-0.4,边界框-0.25,文本-0.25。 像素的填充用来标定实例 Mask 之间的边界。重叠比例评估使用 Voxel 大小为 和重叠阈值 。DBSCAN后处理采用 和最小簇大小为20个点。GPT-4 [6] 的配置温度为0。

Iv-B3 Filtering and Post-Processing

为了防止背景大物体(如墙壁、地面、屋顶、天花板)以及边界框占据图像面积大于95%的物体特征向量与前景物体表现出相似性,从而不利地影响召回率和得分分布,这些物体被排除在外。在DBSCAN后处理中,拥有点数达到最大簇80%以上的簇被视为具有唯一ID和属性的独立实例。在GPT-4 [6]无法检测到目标的情况下,实例被分配RAM++ [35]名称,并给予简化描述:“场景中的一个物体”。

Quantitative Evaluation

所提出的方法使用标准指标进行评估:平均召回准确率(mAcc)、频率加权的交并比(F-mIoU)以及在IoU阈值下的平均精度(AP),同时还包括ScanNet [1]中定义的AP50和AP25。对于开放词汇的性能表现,类似于[27, 34],作者使用提示“场景中的一个物体”和 GT 标签检索3D Mask 。作者将检索到的和 GT Mask 下采样到0.25厘米 Voxel 大小,并应用最近邻搜索来识别相交点。作者在Replica [2]数据集上与最先进模型进行了比较,使用了相同的提示和基础模型。

Qualitative Evaluation

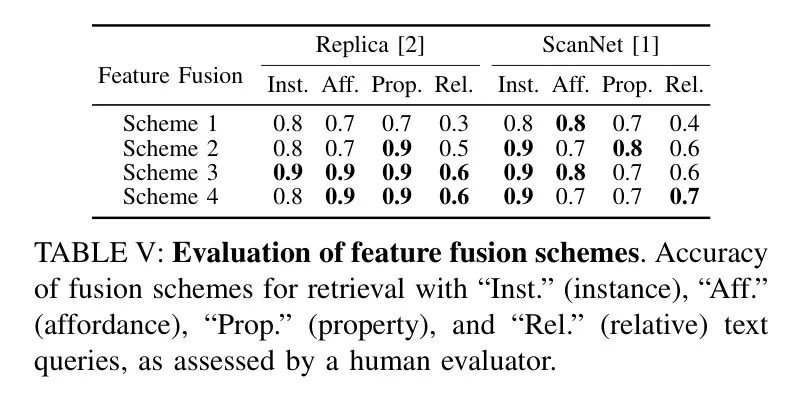

在开放词汇实例检索、标注、分割和空间推理方面进行了广泛的定性评估,并通过人工评估进行了性能检验。对于开放词汇实例检索,针对实例、功能、属性和相对 Query 提出了超过1000个 Query 。使用CLIP [3]和四种融合方案来评估性能:

方案1 代表直接聚合多尺度(方程4)和多视角特征(方程5),_方案2_ 代表更新后的多视角特征(方程7),_方案3_ 代表更新后的多尺度特征(方程6),并增加了裁剪扩展比例(),_方案4_ 代表结合了更新后的多视角(方程7)和多尺度(方程6)特征融合公式。

所提出方法的标注和分割能力通过人工验证标签分配和 Mask 合并来进行评估。对于空间推理,所有场景中使用了70个复杂问题进行测试,并采用大型语言模型(见第三节-F),以评估提示策略在空间推理中的可行性。

V Results and Discussion

在本节中,作者展示了作者实验的结果,并详细讨论了所发现的见解。作者研究的目的是探究各种参数对AI模型性能的影响。作者进行了一系列实验,每个实验都旨在操纵一个特定因素,同时保持所有其他因素不变。本节的组织结构如下:首先,作者描述了实验设置及用于评估的指标。接着,作者呈现实验的结果,随后对观察到的趋势及其含义进行彻底的分析和讨论。

Ablation Studies

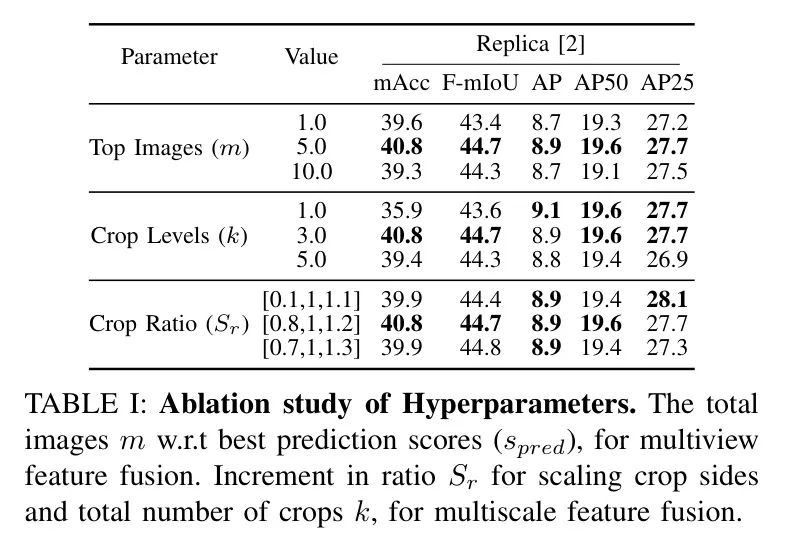

为了评估超参数的影响,作者使用定量指标对作物 Level 、顶部图像 和作物比例 进行了消融研究。顶部图像 影响多视角特征融合(方程7),表示用于聚合的特征向量。作物比例 和作物 Level 影响多尺度特征融合(方程4),决定了特征向量聚合的作物大小和数量。作物 Level 放大了作物比例 的效果,因为更高的 值在相同的 下会导致更大的作物。

与 OpenMask3D [27] 类似,作者发现这些超参数的极端值会恶化结果。较低的 值减少了冗余,而较高的 值可能会包含不良图像,如表1 所示。较低的 和 值可能不会损害模型,但可能会引入冗余。较大的 值增加了上下文信息,但可能会使相似性分数饱和。

表1: 超参数消融研究。 针对多视角特征融合的总图像数 与最佳预测得分 () 相关,以及针对多尺度特征融合的作物比例增量 和总作物数 。

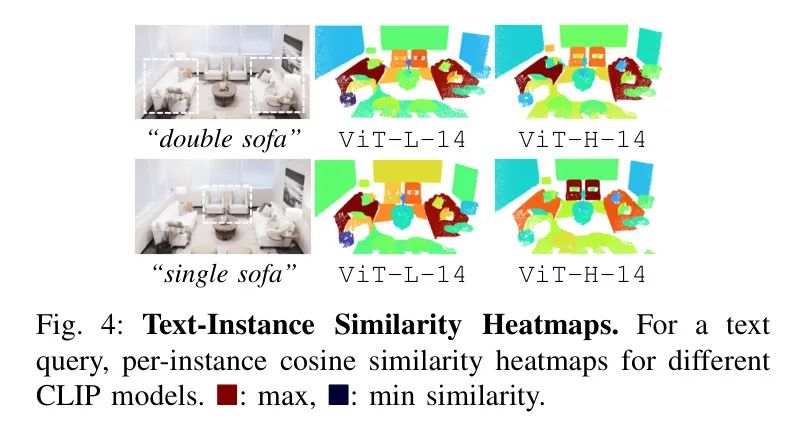

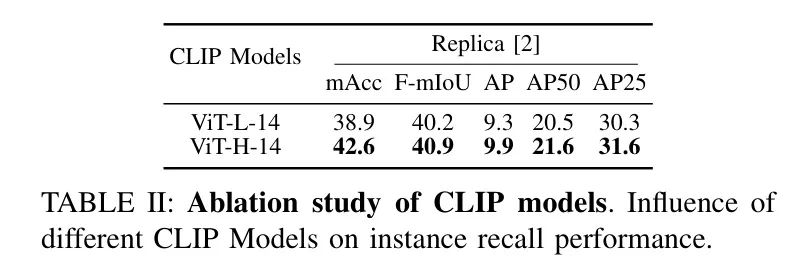

此外,还进行了使用不同 CLIP 模型变体的消融研究。如表2 所示,较大的 CLIP 变体提高了整体性能。例如,图4 显示,较大的 CLIP 模型能更好地将属性与 Query 目标关联起来,区分 "单沙发" 和 _"双沙发"_。

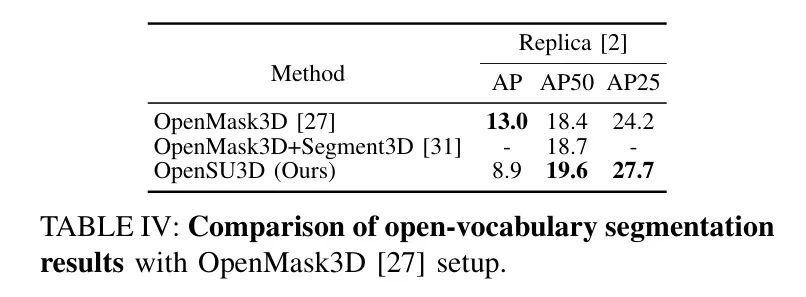

Iv-B1 Quantitative Comparison with Baseline Methods

提出的方法在定量指标上展示出与 Baseline 方法相当或更优的性能,如表格III和IV所示。这些表格比较了针对开放词汇 Query 的分割 Mask 准确性和精确度,并与 GT Mask 进行了对比。为了公平比较,作者遵循了原始的ConceptGraph [34]和OpenMask3D [27]的设置。总体而言,作者的方法在所有指标和数据集上的表现均达到或超过了 Baseline 水平。

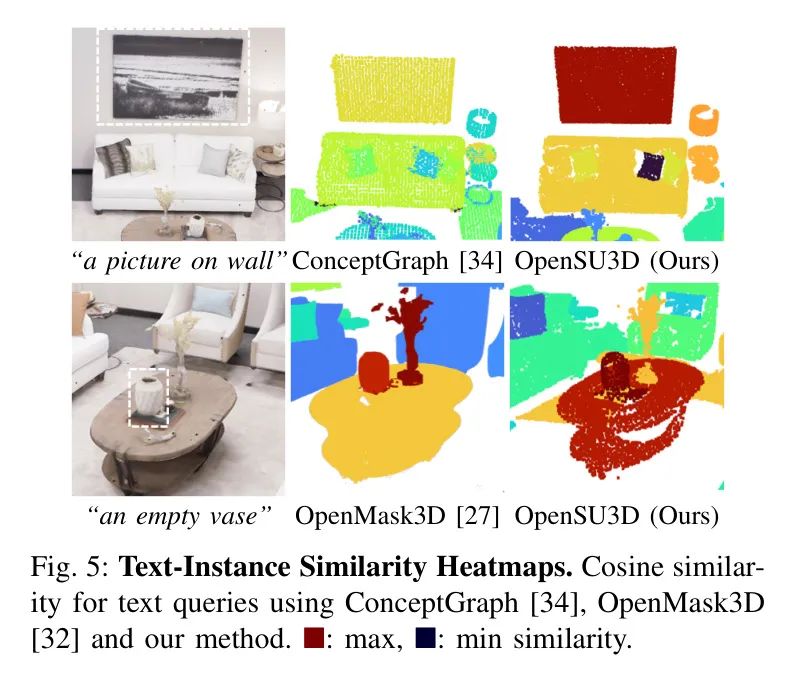

Iv-B2 Qualitative Comparison with Baseline Methods

定量评估主要针对封闭词汇表的评估设计,依赖于召回准确性,但这并不能反映开放词汇 Query 的真实世界需求。这些依赖于 Mask Proposal 数量[31]的方法可能并不能准确反映真正的性能。

为了解决这些限制,作者在图5中提供了与基准工作的全面定性比较。目标是评估对于开放词汇 Query 召回正确分割 Mask 的能力,为相关目标分配高相似度分数,为不相关目标分配低分数。特别是,作者提出的方法在2D到3D的关联以及相似度分数的分布方面表现更好,这得益于作者提出的多尺度多视角特征融合公式(方程6和方程7)。如图5所示,对于 Query “墙上的画”和“一个空花瓶”,两种基准方法都召回了错误的物体,而作者的方法则完美工作。

Iv-B3 Assessment of Feature Fusion Schemes

作者对第IV-D节中定义的特征融合方案进行了定性评估。结果总结在表5中。

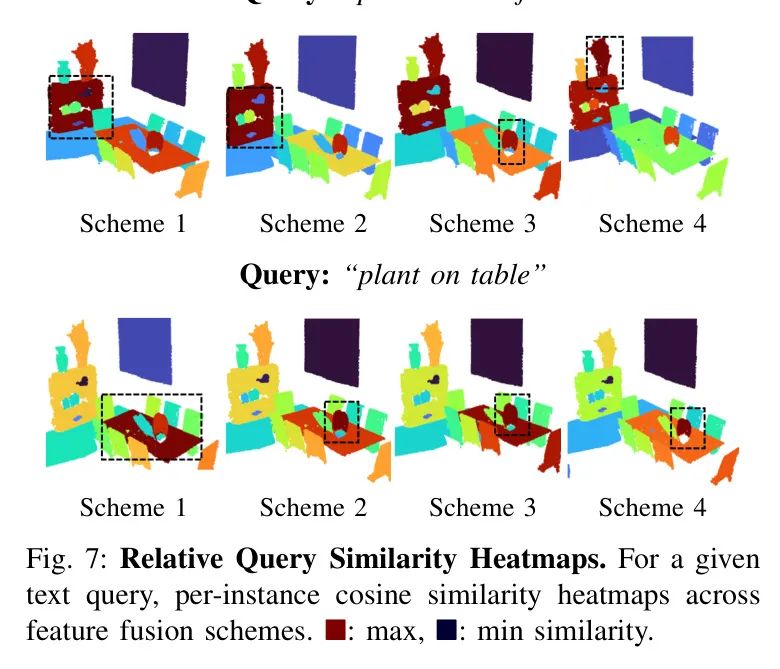

对于_Instance_、_Property_和_Affordance_ Query ,所有方案的性能相似。然而,对于_Relative_ Query ,采用作者提出的多尺度和多视角融合公式(方程7和6)的_Scheme 2_和_Scheme 3_超越了_Scheme 1。融合了这两种公式的_Scheme 4_在分割 Mask 的召回精度上取得了最佳表现。

如图7所示的相似性得分热力图显示,_Scheme 1_经常错误地将最高分分配给最大的实例。相比之下,_Schemes 2, 3,_ 和 _4_的更新融合公式提高了实例 Mask 的召回和相似性得分分布,其中_Scheme 4_整体表现最佳。

表2:CLIP模型的消融研究。不同CLIP模型对实例召回性能的影响。表4:与OpenMask3D [27]设置的开词汇分割结果比较。

CONCLUSION

总之,本研究提出了一种可扩展和递增的开放世界3D场景理解框架,解决了当前非递增方法的局限性。通过利用2D基础模型,作者的方法构建了详细的实例级3D场景表示,有效地追踪和关联了特定实例的信息,如特征向量、名称和标题。

所提出的特征融合方案增强了模型对复杂查询的上下文化能力和解释能力。

此外,使用大型语言模型进行自动标注和高级空间推理任务,展示了该方法的多功能和鲁棒性。

全面的评估表明,与现有最先进解决方案相比,作者的方法在零样本泛化方面取得了卓越的性能。未来,作者计划探索3D动态场景中的时空推理,并将该方法从室内扩展到大型户外环境。

参考

[1].OpenSU3D: Open World 3D Scene Understanding using.