MIT & Caltech & AWS 提出 ALDI,目标检测新突破, 超越现有方法,再次刷新 SOTA!

MIT & Caltech & AWS 提出 ALDI,目标检测新突破, 超越现有方法,再次刷新 SOTA!

目标检测器在处理与训练集不同的数据时往往表现不佳。最近,域自适应目标检测(DAOD)方法在应对这一挑战上取得了显著成果。不幸的是,作者发现了系统性的基准测试陷阱,这些陷阱使过去的成果受到质疑,并阻碍了进一步的发展:

- 由于基准线能力不足导致性能高估,

- 不一致的实现实践阻碍了方法的透明比较,

作者通过以下方式解决这些问题:

- 引入统一的基准测试和实现框架 Align and Distill(ALDI),以支持DAOD方法的比较和未来的发展

- 提出了一种公正且现代的DAOD训练和评估协议,以解决基准测试的陷阱

- 推出了一个新的DAOD基准数据集 CFC-DAOD,支持在多样化的真实世界数据上进行评估

- 提出了一种新方法 ALDI++,该方法以大幅领先的优势取得了最先进的结果。

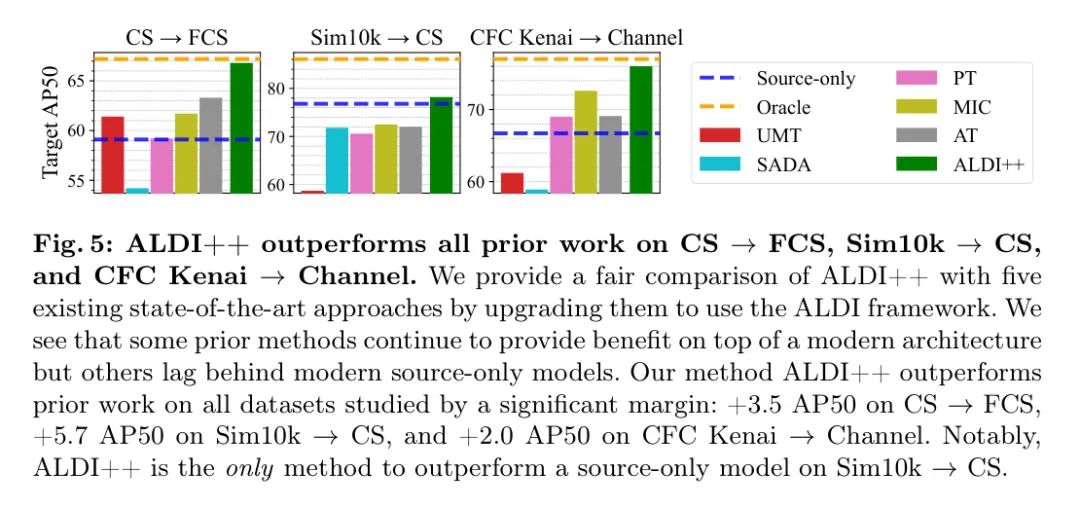

ALDI++ 在 Cityscapes Foggy Cityscapes 上的AP50超过了先前最先进的方法+3.5,在 Sim10k Cityscapes 上超过了+5.7 AP50(作者的方法是唯一一种超过公正基准线的方法),在 CFC Kenai Channel 上超过了+2.0 AP50。作者的框架、数据集和最先进的方法为DAOD领域提供了一个关键的重新设定,并为未来的研究奠定了坚实的基础。

1 Introduction

域适应目标检测的挑战。 尽管现代目标检测器在许多基准测试中表现出色,但当测试数据与训练数据存在分布偏移时,其性能通常会受到严重影响[41]。例如,在环境监测应用中,当检测器在新环境中部署时,其泛化能力不佳。同样,在医疗应用中,如果模型在不同的医院或硬件上部署,与其训练时的情况不同,性能也会变差。不幸的是,在现实世界的应用中,以监督方式收集解决此类分布偏移所需的其他标注往往是困难、昂贵或耗时的。

在这些情境中,一个吸引人的选择是 _无监督领域自适应目标检测(DAOD),该方法试图在从“源”域(用于训练)转移到“目标”域(用于测试)[29, 32] 时提高检测性能,而不使用目标域的监督。

当前范式。 研究界已经建立了一套标准的基准数据集和方法论,这些数据集和方法论捕捉了推动域自适应目标检测(DAOD)部署的挑战。基准数据集由被划分为两组的标记数据组成:源域和目标域,每组来自不同的域。DAOD方法与传统监督学习一样,使用源域图像和标签进行训练,并能够访问 未标注 的目标域图像。目标域的标签在训练中是不可用的。

为了衡量DAOD方法的性能,研究行人使用源域模型(source-only models)和最优模型(oracle models)作为参考点。源域模型——有时也被称为 Baseline (baselines)——仅用源域数据训练,代表了在没有领域适应情况下性能的下界。最优模型则使用有监督的目标域数据训练,代表了一个完全有监督的上界。在DAOD中的目标是在没有目标域监督的情况下,缩小源域模型与最优性能之间的差距。

进展的阻碍。 最近发布的结果表明,DAOD异常有效,其性能是仅源模型的两倍,甚至超过了完全监督的预言模型[34, 5, 8]。然而,在仔细检查后,作者发现当前的基准测试实践存在问题,这些问题对上述结果提出了质疑:

P1: 不当构建的仅源域和Oracle模型导致了性能提升的高估。作者发现,仅源域和Oracle模型的一致构建方式没有适当地隔离领域自适应的特定组件,导致性能改进的误归因。作者展示了当仅源域和Oracle模型公平构建时——即使用与DAOD方法相同的架构和训练设置——没有现有方法能超越Oracle,并且许多方法甚至不能超越仅源域模型(图1),这与近期工作的主张形成了鲜明对比。这些结果表明,作者没有一个准确衡量DAOD有效性的方法。

P2:不一致的实施实践阻碍了方法间的透明比较。作者发现现有的领域自适应目标检测(DAOD)方法使用了各种不同的目标检测库,并且训练设置不一致,这使得很难判断性能的提升是来自于新的DAOD方法,还是仅仅因为优化了超参数。作者发现调整这些超参数——其值通常在不同方法之间有所不同,而且在论文中并未报告——可能会导致比所提出方法本身更大的性能变化(参见第6.3节),因此作者不能直接接受所报告的进展。如果没有能力进行公平的比较,作者就无法透明地评估贡献,也无法在方法论上取得原则性的进步。

P3:(a)缺乏多样化的基准测试和(b)过时的模型架构,导致对方法的泛化能力过度估计。DAOD基准测试主要集中在城市驾驶场景与合成分布偏移[28; 48],而方法仍然继续使用过时的检测器架构与以前的工作进行比较[9]。潜在的前提假设是方法在应用领域和基础架构上表现相同。作者展示实际上,_方法的排名在不同的基准测试和架构之间会发生变化_,这表明已发布的结果对于使用现代架构和真实世界数据的实践者可能不具有参考价值。

对DAOD研究的重大重启。 DAOD在一系列现实世界应用中具有潜在的影响力,但这些系统性的基准测试陷阱阻碍了进展。作者旨在解决这些问题,并通过以下贡献为DAOD的未来进步打下坚实的基础:

Align and Distill (ALDI),针对DAOD的统一基准测试和实现框架。为了使比较公平,作者首先在前期工作中识别关键主题(第2节),并将通用组件统一为一个最先进的框架,即_ALDI_(第3节)。ALDI便于对现有技术进行详细研究,并简化新方法的实施流程,支持未来的研究。

一个由ALDI启用的公平且现代的DAOD方法训练协议。

作者提供了对所识别的基准测试陷阱的定量证据,并提出了一个更新的训练和评估协议来解决这些问题(第6.1节)。这使得作者能够为DAOD社区设定更现实和具有挑战性的目标,并首次对DAOD领域中的先前工作进行公平的比较(第6.2节)。

一个新的基准数据集CFC-DAOD,源自于环境监测中一个真实世界的适应性挑战(第5节)。CFC-DAOD增加了DAOD基准的多样性,并且明显比现有的选择要大。作者展示了在不同基准上方法的排名会发生变化(第6.2节),因此,社区将从这一额外的比较点中受益。

一种名为ALDI++的新方法,以巨大的优势取得了最先进的结果。在所有基准测试中采用相同的模型设置,ALDI++在Cityscapes Foggy Cityscapes上的AP50超过了之前的最先进水平+3.5,在Sim10k Cityscapes上超过了+5.7 AP50(其中作者的方法是唯一一种超越公平源仅模型的 方法),在CFC Kenai Channel上超过了+2.0 AP50。

2 Related Work

在最近的DAOD研究中,主导的两个方法论主题是:_特征对齐_ 和 _自训练/自蒸馏_。作者首先概述这些主题及之前将它们结合在一起的努力,然后在第3节中,利用它们的共性来激发作者提出的统一框架,_Align and Distill_。

在DAOD中的特征对齐。 特征对齐方法旨在使目标域数据“看起来像”源域数据,从而减少分布偏移的幅度。最常用的方法是采用对抗性学习目标来对齐源数据和目标数据特征空间[9, 10, 16, 57]。野生环境下的Faster R-CNN[9]在图像和实例 Level 上使用了对抗性网络。SADA[10]将此扩展到不同特征 Level 的多个对抗性网络。其他方法提出了挖掘判别性区域[57],不同地加权局部和全局特征[47],融入不确定性[40],以及使用注意力网络[51]。也提出了使用图像到图像翻译技术在像素 Level 上进行对齐,直接修改输入图像[12]。

在DAOD中的自我训练/自我蒸馏。 自我训练方法使用一个“教师”模型在目标域数据上预测伪标签,然后这些伪标签被用作“学生”模型的训练目标。自我训练可以被视为一种_自我蒸馏_[6, 43]的类型,这是知识蒸馏[7, 25]的一个特例,其中教师和学生模型共享相同的架构。最近在DAOD中的自我训练方法大多数基于Mean Teacher [50]框架,在该框架中,教师模型作为学生模型参数的指数移动平均(EMA)进行更新。针对DAOD对Mean Teacher的扩展包括:MTOR,它利用图结构来强制学生-教师特征一致性[4],概率教师(PT),它使用概率定位预测和软蒸馏损失[8],以及对比平均教师(CMT),它使用MoCo [21]来强制学生-教师特征一致性[5]。

结合特征对齐和自我训练。几种方法同时采用了特征对齐和自我训练/自我蒸馏,这激励了作者提出一个统一的框架。无偏均值教师(Unbiased Mean Teacher, UMT)[12]结合了均值教师和图像到图像的翻译,在像素 Level 对齐源数据和目标数据。自适应教师(Adaptive Teacher, AT)[55]使用了均值教师和一个图像 Level 的判别网络。 Mask 图像一致性(Masked Image Consistency, MIC)[26]使用了均值教师、SADA和一个 Mask 增强来强制教师与学生的一致性。因为这些方法在不同的代码库中实现,并使用了不同的训练方法和超参数设置,所以目前尚不清楚哪些贡献最有效,以及特征对齐和自我训练在多大程度上是互补的。作者通过在ALDI框架中重新实现这些方法来解决这些问题,并在第6节中进行公平的比较和消融研究。

DAOD数据集。Cityscapes (CS) Foggy Cityscapes (FCS) [11, 48] 是一个流行的DAOD基准,它模拟了由于城市驾驶场景中天气变化引起的域偏移。该数据集包含了八种车辆和行人类别。Sim10k CS [28] 提出了一个Sim2Real挑战,从视频游戏图像适应到真实世界的图像。这个基准专注于单一类别,“汽车”。其他常见的任务包括从PascalVOC [15]中的真实图像适应到剪贴画和水彩画图像[27]。由于CS FCS和Sim10k CS在DAOD文献中的广泛应用和关注实际应用,作者报告了这两个任务的结果。作者注意到现有的基准反映了一组相对狭窄的潜在DAOD应用。为了研究方法是否能够泛化到城市驾驶场景之外,在第5节中,作者引入了一个源自环境监测中真实适应挑战的新数据集,其中的图像与现有基准大不相同。

3 Align and Distill (ALDI): Unifying DAOD

作者首先介绍了一种名为_Align and Distill (ALDI)_的新基准测试和实现框架,用于DAOD。ALDI将现有方法统一在一个通用框架中,使得可以进行公平的比较并解决P2问题,即不一致的实施实践,同时也为开发一种名为ALDI++的新方法奠定了基础,该方法取得了最先进的表现(第4节,第6.2节)。该框架在图2中进行了可视化。所有组件在第6.3节中被逐一分析。

数据。 DAOD涉及两个数据集:一个标记好的源数据集 和一个 未标注 的目标数据集 。在每一个训练步骤中,会构建一个大小为 的小批量,包含 个源图像和 个目标图像。

模型。 学生模型 和教师模型 使用相同的权重进行初始化,通常这些权重是通过在ImageNet、COCO或上进行有监督的预训练获得的。"在上的预训练"通常被称为"预热"。学生模型通过反向传播进行训练。教师模型的权重不是通过反向传播更新,而是更新为学生权重的指数移动平均(EMA)[50]。

训练涉及三个目标:

1. 使用源数据的监督训练。 每个标记的源样本 通过某些 变换,即可能的源领域变换集合,然后通过学生模型进行处理,以获得给定的 GT 目标 的监督损失 。在作者的案例中, 是Faster R-CNN损失[44]。

2. 目标数据自蒸馏。 每个 未标注 的目标样本 都会通过教师模型和学生模型。教师的预测 作为学生预测 的蒸馏目标,产生蒸馏损失 ,这些损失会通过学生模型进行反向传播。在计算 之前,教师的输出会经过后处理,以软目标(例如逻辑回归或softmax输出)或硬目标(例如经过阈值处理的伪标签)的形式呈现。

在经过教师模型之前,目标样本 会通过一些 变换,这是一组“弱”变换——例如,随机水平翻转——这些变换使得教师模型能够提供高质量的预测 。同样的图像也会传递给学生模型,但这次是通过 变换,这种变换通常包含“更强”的数据增强,比如颜色抖动或随机擦除。

表1:ALDI统一并扩展了现有工作。 作者展示了重现五项先前工作以及作者的方法ALDI++的设置。更多详情请见图2和第3节。** Warm up 阶段:** 固定时长(固定),作者的方法(作者的,第4节)。增强: 随机翻转(F),多尺度(M),裁剪与填充(CP),颜色抖动(J),cutout [13](C),MIC [26]。:批次中有一半的图像使用增强。:大小为的小批量中目标域部分。后处理: 在蒸馏之前对教师预测的处理:sigmoid/softmax(锐化),为伪目标性求和类别预测(求和),置信度阈值(阈值),NMS。:蒸馏损失:硬伪标签(硬),连续目标(软)。:特征对齐损失:图像级对抗(图像),实例级对抗(实例),图像到图像翻译(图像2图像)。:在ALDI实现(最后一列)中使用但不在原始实现(倒数第二列)中使用的设置。:仅源域和最优结果源自[34]。

3. 特征对齐。通过一个对齐目标 使得 和 在图像或特征层面上在域之间强制执行不变性,从而实现“对齐”。

统一先前工作。 作者通过在ALDI之上重新实现五种最近提出的方法来展示作者框架的通用性:UMT [12],SADA [10],PT [8],MIC [26] 和 AT [34]。在表1中,作者列举了重现每种方法所需的设置。

4 ALDI: Improving DAOD

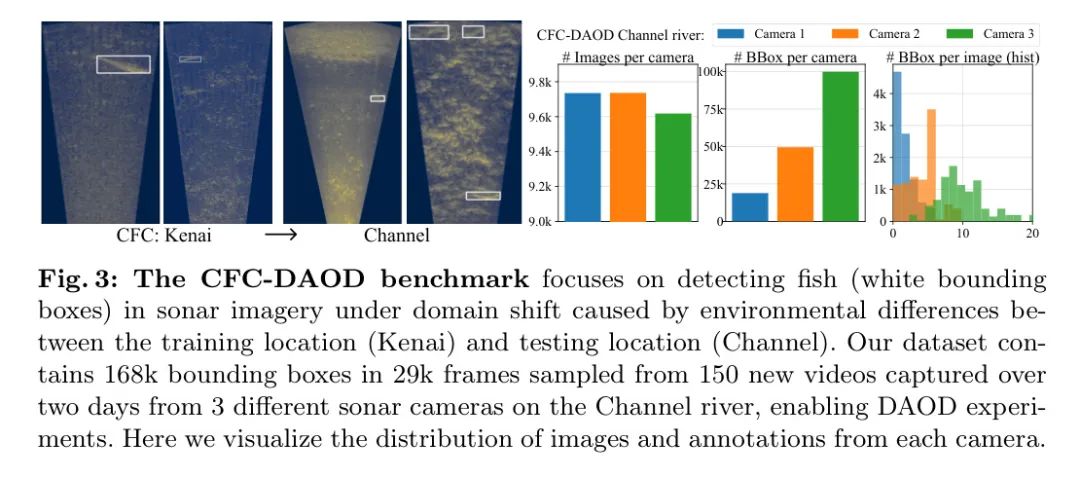

作者接下来提出了两种针对_Align and Distill_方法的新颖增强,从而形成了新的方法ALDI++。作者在第6.2节中展示这些增强措施带来了最先进的结果,并在第6.3节中对每个组成部分进行了消融研究。

1. 坚韧的烧录(burn-in) 首先作者提出了一种新的“烧录”策略,用于在仅源域数据 上对教师模型 进行预训练。在学生-教师方法中的一个关键挑战是提高目标域伪标签的质量。作者指出,在自训练的早期阶段,伪标签的质量在很大程度上由初始教师模型 的“分布外(OOD)泛化”能力决定,因此作者提出了一种旨在提高烧录期间OOD泛化的训练策略。作者在烧录过程中加入了强烈的数据增强,包括随机调整大小、颜色抖动和随机擦除,并在烧录期间保持了模型的EMA副本,这两种策略之前已被证明可以改善OOD泛化和鲁棒性[1, 2, 18]。作者是首个将这些策略用于DAOD烧录的。

2. 多任务软蒸馏。 大多数先前的工作通过使用置信度阈值和非最大值抑制,从教师预测的 中生成“硬”伪标签(见表1)。然而,在目标检测中,这种策略对所选择的置信度阈值敏感,会导致自我训练受损的假阳性和假阴性错误[31]。作者从知识蒸馏的文献中汲取灵感,并提出使用“软”蒸馏损失——即不进行阈值处理,直接将教师预测得分作为目标——这使得作者能够消除置信度阈值这一超参数。

作者独立提炼了Faster R-CNN的每个任务——区域 Proposal 网络定位()和目标性(),以及感兴趣区域 Head 定位()和分类()。在每一个阶段,教师为学生使用的同一组输入 Proposal 提供提炼目标——即第一阶段的 Anchor 点,以及第二阶段的学生区域 Proposal :

在每次迭代中,学生蒸馏损失 计算如下:

这里的蒸馏损失 由两部分组成: 和 \tag{7}。其中 和 分别是平滑L1损失,而 和 是交叉熵损失,且默认情况下 。具体视觉描述请参见图2。作者将在补充材料中提供更多实现细节。

一项早期的DAOD工作,PT [8],也使用了软蒸馏损失,但作者指出作者的方法解决了两个不足之处:(1)PT需要一种定制的“概率R-CNN”架构来进行蒸馏,而作者的方法具有普遍性,可以与任何两阶段检测器配合工作;(2)PT使用 作为间接代理来蒸馏 ,而作者的方法能够直接对每个任务进行蒸馏。

5 The CFC-DAOD Dataset

接下来,作者介绍作者的数据集贡献,CFC-DAOD,解决P3:(a)缺乏多样化的基准测试导致对方法通用性的过高估计。

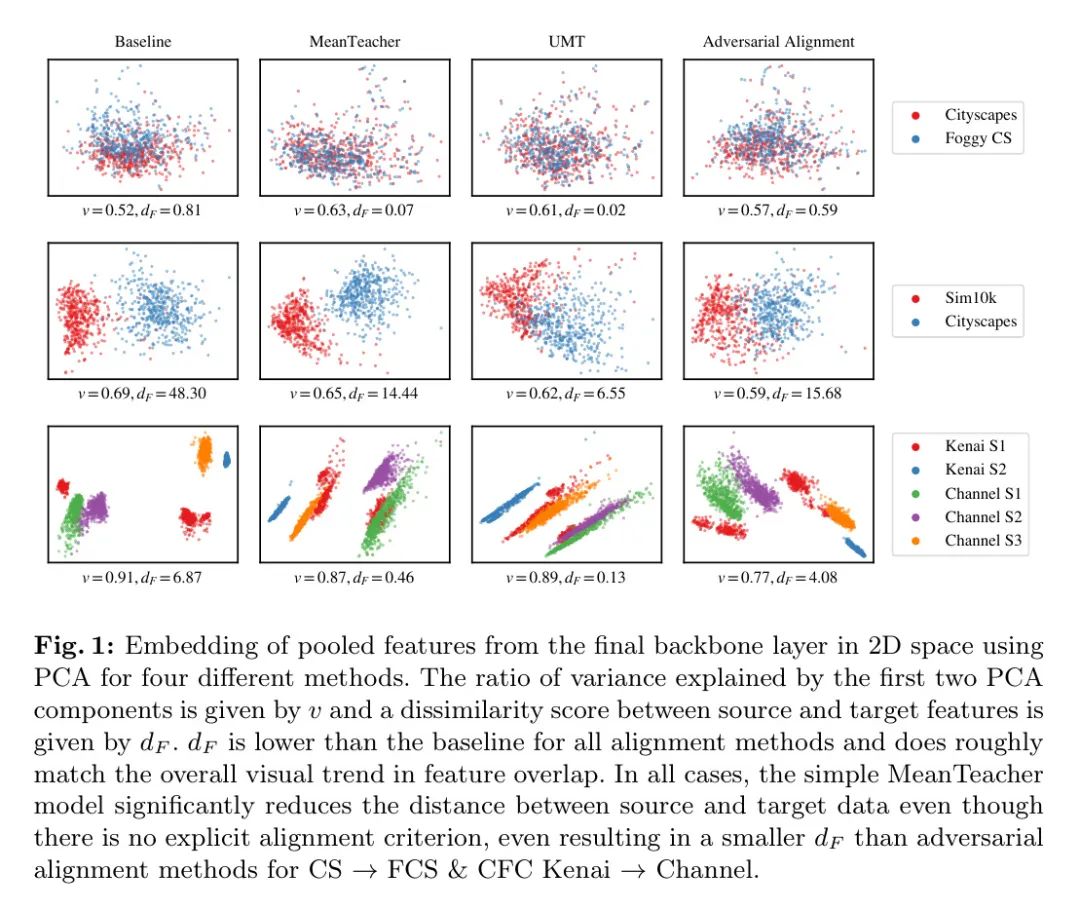

CFC. 加州理工学院鱼类计数数据集(CFC)[30]是一个来源于渔业监测的领域泛化基准,其中使用声纳视频来检测和计数迁徙的鲑鱼。检测任务由单一类别(“鱼”)组成,领域偏移是由摄像机部署之间的现实环境差异引起的。作者将这个应用识别为研究DAOD方法泛性的机会,因为它与现有的DAOD基准存在明显差异——特别是,声纳图像是灰度的,信噪比低,前景物体很难与背景区分开来——然而CFC关注的是泛化而非适应,并且_不包括进行DAOD所需的数据_。

CFC-DAOD 作者提出了对CFC的扩展,称为CFC-DAOD,以使得在这个应用领域内能够研究DAOD。该任务是从源地点“Kenai”进行适配,即CFC的默认训练集,到难以应对的目标地点“Channel”。作者从“Channel”河上通过3种不同传感器在两天内捕捉的150个新视频中,抽取了29k帧并收集了额外的168k边界框标注(见图3)。为了保持一致性,作者严格按照原作者描述的用于收集原始CFC数据集的视频抽样协议进行操作(见[30])。作者对CFC的补充对于DAOD至关重要,因为它为领域适应方法增加了一个无监督的训练集,并为训练基准方法增加了一个有监督的训练集。作者保留了CFC中的原始有监督的Kenai训练集(70k图像中的132k标注)和原始的Channel测试集(13k图像中的42k标注)。作者注意到这比现有的DAOD基准数据集(CS包含3.5k图像中的32k实例,而Sim10k包含10k图像中的58k实例)要大得多。更多数据集统计信息请参见补充材料。作者将数据集公开。

6 Experiments

在本节中,作者提出了一个更新后的DAOD(第6.1节)基准测试协议,该协议使作者能够公平地分析ALDI++与先前工作(第6.2节)的性能,并进行广泛的消融研究(第6.3节)。

数据集。作者在Cityscapes Foggy Cityscapes,Sim10k Cityscapes,以及CFC Kenai Channel数据集上进行了实验。除了与之前的工作保持一致外,这些数据集还代表了三种常见的适应场景,捕捉了一系列现实世界的挑战:分别是天气适应、Sim2Real(模拟到现实)和环境适应。作者注意到在以前的工作中,对于Cityscapes数据集所使用的哪些 GT 标签存在不一致之处。作者使用的是Detectron2版本。

指标。 对于所有实验,作者报告了PascalVOC的指标——平均精度均值(mean Average Precision),其中IoU 0.5("AP50")[15]。这与之前在Cityscapes、Foggy Cityscapes、Sim10k和CFC上的工作保持一致。

A New Benchmarking Protocol for DAOD

重新审视仅源域和Oracle模型。 这里作者解决了P1:不当地构建的仅源域和Oracle模型,导致性能提升的过度估计。DAOD的目标是开发自适应技术,使用 未标注 的目标域数据来提高目标域的性能。因此,为了适当隔离 自适应特定 技术,任何不需要目标域数据就能运行的技巧也应该被仅源域和Oracle模型使用。在作者的案例中,这意味着仅源域和Oracle模型也应该利用与DAOD方法相同的强大增强和EMA更新。在图4中作者展示了结果仅源域和Oracle模型,并表明包括这些组件显著提升了仅源域和Oracle模型性能(在雾Cityscapes数据集上分别提升了+7.2和+2.6 AP50)。这对于DAOD研究具有重大影响:因为仅源域和Oracle模型并未用等效的组件构建,之前源于更好泛化的性能提升现在被 错误地归因 于DAOD。使用适当构建的仅源域和Oracle模型,DAOD的提升要谦逊得多(见图5)。

现代化架构。作者接下来解决P3:(b) 过时的模型架构导致对方法的泛化能力过度估计。在DAOD领域的先前研究中,已经使用较旧的骨架网络(例如VGG-16)以便与之前发表的结果进行比较。为了调查这些结果是否能够推广到现代实验设置,作者的实验采用了一个现代的检测框架[54],其默认设置包括多尺度输入转换和COCO预训练。作者使用了ResNet-50骨架网络[23],配合特征金字塔网络[35]和ViTDet[33]。作者在附录中提供了更多细节。仅源数据和oracle模型也将接受这些升级。

Fair Comparison and State-of-the-Art Results

作者比较了ALDI++与在作者框架上重新实现的五种最先进的DAOD方法:UMT [12],SADA [10],PT [8],MIC [26],以及AT [34];有关用于复现它们所使用的ALDI设置,请参见表1。作者采用了第6.1节提出的公平基准测试协议。结果展示在图5中。所有方法(包括ALDI++)在所有基准测试中都使用了相同的设置。

ALDI++ 在CS到FCS、Sim10k到CS以及CFC Kenai到Channel上的表现是当前最先进的。 ALDI++ 在CS到FCS上比先前的最先进技术提高了3.5 AP50,在Sim10k到CS上提高了5.7 AP50(作者的方法是唯一一种能超越公平源仅模型的性能的方法),在CFC Kenai到Channel上提高了2.0 AP50。此外,作者在CS到FCS和CFC Kenai到Channel上实现了接近最优水平的性能(分别相差0.4和0.9 AP50),而其他方法在源仅模型和最优模型之间的差距不到一半。

现代架构和公平的仅源域模型为DAOD基准测试带来了范式转变。作者的基准测试协议为DAOD性能边界提供了显著的重新设定。一个公平且现代的仅源域模型——在从未接触过任何目标域数据的情况下进行训练——在目标AP50上取得了比所有先前发布的DAOD方法都要高的成绩(见图1)。同样地,与之前的工作相比,作者看到oracle性能提升了57%。

6.2.2 Relative performance of all methods decreases compared to fair source-only and oracle models.

重新在ALDI中实现最新的SOTA方法可以提高所有方法的绝对性能;然而,与仅源域模型相比,性能有所下降。有几种情况下,现代化的DAOD方法实际上比一个公正的仅源域模型还要差。值得注意的是,一个仅源域模型在Sim10 CS上的表现超越了之前所有已发布工作的升级版本。作者还发现,没有任何最新的方法在任何数据集上超越了一个公正的先验知识模型,这与之前的工作[5, 8, 34]中的主张相反。

不同数据集和架构下,方法的排名各不相同。 MIC和AT在所有数据集上始终是表现最佳的 methods。UMT的表现因数据集间图像生成的难度差异而有所不同(具体示例见补充材料)。SADA在CS FCS和CFC Kenai Channel上的表现不如其他方法,但在更难的Sim10k CS上缩小了这一差距。这些差异突显了在现代背景下进行基准测试的重要性,因为作者看到先前发布的方法并不总是与目标检测领域中的一般性进展相辅相成。这些结果还证明了CFC-DAOD作为DAOD方法比较的另一个参考点是有用的。

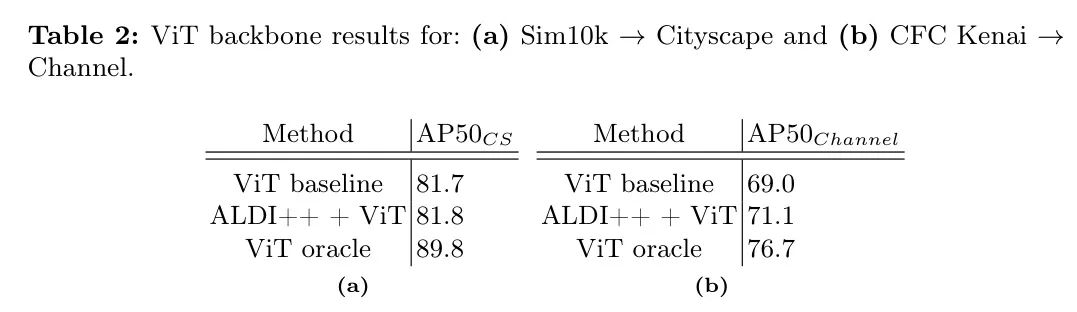

ALDI 与新的检测器变种兼容。 作者将 ALDI 升级为使用 VitDet [33]。由于 VitDet 是基于 Faster R-CNN 的两阶段架构,这不需要对作者的多任务蒸馏损失进行修改。作者展示了 ALDI 在升级后的 VitDet 仅源模型上继续展现出改进(见图1 中的 CS FCS 和补充材料中的其他数据集)。作者发现 ViT ALDI 与 ViT oracle 之间存在较大差距,这表明未来工作在提高性能方面具有潜力。

Ablation Studies

在本节中,作者对ALDI在CS到FCS上每个组件的性能进行消融研究。对于每次消融,除非另有说明,作者采用表2所示的设置,每次消融一列。作者的默认预烧阶段使用了与表1中_Fixed_策略相同的增强方法,但采用早停法进行模型选择,并且所有的自训练运行都使用相同的预烧预训练权重进行初始化,以便公平比较。有关其他定义,请参见表1。

网络初始化(预热)。在图5(a)中,作者分析了作者提出的预热策略的影响(见第4节)。作者用目标域的AP50以及收敛时间来衡量性能,收敛时间定义为模型首次超过其最终目标域性能95%的训练时间。作者将作者的方法与以下两种方法进行比较:(1) 没有针对数据集的预热,即以COCO权重开始;(2) 过去研究使用的方法——固定预热时长,例如10k次迭代。作者发现作者的方法在训练速度和准确度上都有显著提升,相较于没有预热的训练,AP50提高了10%以上,训练时间减少了10倍。

源数据增强。在图5(b)中,作者消融了源领域数据增强集合。作者比较了使用弱增强(随机翻转和多尺度训练)、强增强(颜色抖动和随机擦除)以及弱增强和强增强的组合,注意到先前的研究在这方面有所不同,但通常没有报告所使用的设置(见表1)。作者发现,在整个源领域训练批次上使用强源增强优于使用弱增强以及二者的组合。

目标增强方法。在表2(a)中,作者研究了将不同的增强方法用于目标域输入到学生模型中的效果(作者注意到,根据先前的工作,对于教师模型的目标域输入始终使用弱增强方法)。作者看到,更强的增强方法一致地提高了性能,最佳的性能来自于最近提出的MIC增强方法[26]。

\begintable} \begin{tabular}{cB_{tgt/B{}_{FCS} 从64.5下降到59.3。

自我蒸馏。**在表2(b)中,作者分析了作者提出的多种任务软蒸馏方法的效果(参见第4节)。请注意,对于这些实验,起始模型是ALDI++,而不是表2中的简单模型。作者将作者的方法与之前工作中使用的“硬”伪标签方法进行了比较,在那里,教师预测通过非最大值抑制和0.8的硬置信度阈值进行后处理[12, 34, 37, 26]。对于作者提出的“软”蒸馏方法,作者首先在两个检测器阶段使用sigmoid来锐化目标性预测,并使用softmax进行分类预测,默认温度均为1。作者发现,与硬目标相比,作者提出的软目标提高了性能。

特征对齐。最后作者研究了特征对齐的使用。作者实现了一种对抗性特征对齐方法,包括图像 Level 和实例 Level 的特征判别器(作者的实现与SADA表现相当,同时训练更为简单;详见补充材料)。在表2(c)中,作者展示了单独使用特征对齐(即不使用自训练)能带来高达2.6 AP50的性能提升。然而,这些性能增益小于自训练所观察到的(AP50分别为61.7和63.1)。当与自训练技术结合使用时,特征对齐的额外好处降至 0.2 AP50。这表明自训练是目前最有前景的进展途径,并且还需要开展更多研究来开发互补的方法。作者还注意到,特征对齐方法引入的训练不稳定性可能并不值得实际应用中微小的性能提升。

7 Discussion and Conclusions

在这项工作中,作者提出了ALDI框架和一个改进的DAOD基准测试方法,为DAOD研究界提供了至关重要的重新设定;一个新的数据集CFC-DAOD,增加了DAOD基准的多样性和现实世界适用性;以及一个名为ALDI++的新方法,该方法推进了现有技术水平。作者最后总结了关键发现。

网络初始化具有巨大的影响。 作者发现计算机视觉的普遍进步超越了DAOD领域的进展:仅使用Resnet50-FPN源域模型的表现就超过了所有基于VGG的DAOD方法,而仅使用VitDet源域模型的表现也超过了所有基于Resnet50-FPN的DAOD方法。同样地,仅在源域模型中添加更强的增强和EMA(指数移动平均)就能使得目标域的表现优于某些适应方法,并且在网络初始化( Warm up )期间包括这些升级也能提高适应性能。

域自适应目标检测(DAOD)技术是有帮助的,但并未像之前声称的那样达到先验级性能[34, 5, 8]。 表现最佳的DAOD方法,包括ALDI++,相较于仅源域模型有所提升(见图1和图5)。然而,与之前发表的结果相比,没有一种DAOD方法达到先验级性能,这表明仍有改进的空间。对于像VitDet这样的更强架构,DAOD方法与先验之间的差距甚至更大。这是未来研究的一个有前景的领域。

源自现实世界领域适应挑战的基准可以帮助社区发展出普遍有用的方法。作者发现,DAOD方法在不同的数据集上并不一定能表现相同(见图5)。多样化的基准有助于确保作者不仅仅是对某一个特定用例的挑战进行过度拟合,同时也突显并支持在具有影响力的应用中的进展。作者贡献的代码库和基准数据集为这一努力提供了必要的起点。

在DAOD领域,缺乏透明的比较导致了增量式进步。 大多数在DAOD领域表现优异的前期工作都是DANN [17](2016年)和Mean Teacher [50](2017年)的结合,再加上一些特定的训练技术。如果没有公平的比较,就有可能提出近乎重复的方法,这些方法仅通过对超参数的调整仍然能实现“最先进”的性能。作者的方法ALDI++为基于 Align and Distill 的方法设立了一个强有力的比较基准,要超越它将需要算法上的创新。

验证是房间里的大象。 作者的所有实验以及之前在DAOD领域发布的所有工作,都使用了目标域验证集来进行模型和超参数的选择。这违反了无监督域适应中的一个关键假设:一开始就没有可用的目标域标签。之前的研究已经表明,在现实的验证条件下,可能根本无法实现域适应性能的改进 [38, 39, 31]。因此,作者的结果(以及之前发表的工作)实际上只能被视为DAOD性能的上限。虽然这很有价值,但还需要进一步研究,以开发出DAOD有效的无监督验证程序。

致谢。本材料基于以下支持的工作:国家科学基金会(NSF)计算与信息科学及工程研究生奖学金编号2313998,麻省理工学院电子工程与计算机科学系奖学金编号4000184939,麻省理工学院J-WAFS种子基金编号2040131,以及加州理工学院Resnick可持续发展研究所影响基金“在太平洋西北地区为保护和渔业管理连续、准确且成本有效地计数迁徙鲑鱼。” 本材料中表达的意见、发现、结论或建议是作者的观点,不一定反映NSF、MIT、J-WAFS、加州理工学院或RSI的观点。作者感谢麻省理工学院超级云和林肯实验室超级计算中心提供的高性能计算资源[45]。作者还感谢阿拉斯加州渔猎部持续的合作以及提供的数据,以及Sam Heinrich、Neha Hulkund、Kai Van Brunt和Rangel Daroya的有益反馈。

1 Additional Experiments

Adversarial Feature Alignment

作者报告了所使用的对抗性特征对齐网络(s)的额外消融研究,将作者在图像 Level 对齐和实例 Level 对齐的实现与 Baseline 方法及SADA进行了比较。正如作者在表1a、表1b和表1c中所见,最佳设置因数据集而异。在主论文第6.1节中,默认情况下作者的特征对齐实验同时使用了实例 Level 和图像 Level 的对齐。有关进一步的实现细节,请参见下面的第2.4节。

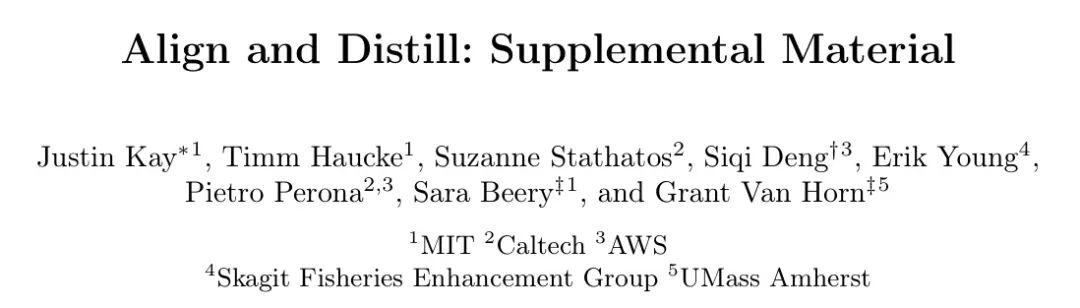

Visualizing Alignment

作者研究不同方法中源数据和目标数据在特征空间的重叠情况。对于每种方法,作者会汇聚 Backbone 网络中最高层的特征图,可以是全局汇聚("图像 Level ")或每个实例汇聚("实例 Level ")。然后,作者使用主成分分析(PCA)将这些汇聚的特征向量嵌入到2D空间中进行视觉检查(见图1)。此外,作者还基于FID [24] 计算一个不相似性分数,通过将高斯分布拟合到源特征和目标特征上,然后计算它们之间的Frechet距离。

ViT backbones

作者在表2(a)(Sim10k Cityscapes)和表2(b)(CFC Kenai Channel)中展示了将ALDI++与VitDet [33]结合使用的结果。作者看到,即使整体架构变得更加强大,ALDI仍然能持续在 Baseline 之上展示改进,尽管这些改进的幅度较小,这一点也在本文第6.3节(CS FCS结果)中报告。

Teacher update

作者在表3中比较了在自训练过程中更新教师的其他方法与使用指数移动平均(EMA)的效果。作者看到,EMA明显优于使用固定教师(即原始自训练,其中伪标签在训练前一次性生成)以及在没有EMA的情况下学生作为自己的教师。

Example of (Un)Fair Comparisons

在图2中,作者展示了一个案例研究,说明了为什么在DAOD研究中进行公平的比较很重要。作者比较了两项性能相似的前期工作,AT和MIC,发现实施不一致导致了这两种方法之间比较的不透明性。值得注意的是,最初报告的结果甚至使用了不同的 GT 测试标签。当在相同的现代框架ALDI上重新实现时,作者首次能够公平地比较这两种方法。

2 Implementation Details

Re-implementations of Other Methods

在这里,作者提供了在ALDI框架之上重新实现先前工作的额外细节。作者的实现细节在图3中进行了可视化。

自适应教师模型[34]自适应教师(AT)采用了主论文表2中基础配置的默认设置,并加上了一个图像 Level 的对齐网络。为了公平复现,作者在所有AT实验中使用了作者的对齐网络实现,而不是作者自己的。

MIC[26] 作者重新实现了 Mask 图像一致性增强作为一个Detectron2转换,以提高效率。作者还实现了MIC的“质量权重”损失重加权过程,尽管在作者的实验中作者发现它会使性能略微下降(在Foggy Cityscapes上的AP50从62.8降到63.1,没有使用该过程)。

概率性教师[8] 概率性教师(PT)利用了以下技术:(1)一种自定义的Faster R-CNN架构,该架构使定位预测具有概率性,称为“高斯R-CNN”;(2)一种Focal Loss目标;(3)可学习的 Anchor 点。作者将这三部分组件的实现移植到了作者的框架中。需要注意的是,作者首先必须烧录一个高斯R-CNN,因此PT无法使用与其他方法完全相同的起始权重。

SADA [10] 作者将SADA的官方实现迁移到Detectron2中。请注意,SADA不包括预热(burn-in)或自训练,因此基础实现就是Detectron2的 Baseline 配置。

无偏均值教师 [12] 作者的实现反映了来自[12]的UMT配置。

Faster R-CNN Losses

在这里,作者描述了标准的Faster R-CNN损失函数,然后再说明作者如何将这些损失函数修改为“软”蒸馏损失。Faster R-CNN包括两个阶段:区域 Proposal 网络和感兴趣区域 Head 。

区域 Proposal 网络(RPN):

输入。 区域 Proposal 网络(RPN)的输入包括:

由 Backbone 网络提取的特征(例如,在作者的多数实验中使用的带有特征金字塔网络的Resnet-50)。

一组代表检测初始候选的 Anchor 框。

输出。 对于每个 Anchor 点,RPN预测两件事情:

一个称为“目标性”的二分类,表示 Anchor 框内的内容是前景还是背景。

Anchor 点的回归目标,表示对框进行调整以更紧密地包围任何前景物体。

计算损失。 为了评估这些预测的 Proposal ,每个 Proposal 都会根据与最近的真实框的交并比(IoU)匹配到前景或背景。在这些匹配的基础上,在Detectron2的默认设置中,对于(1)计算二进制交叉熵损失,对于(2)计算平滑L1损失。

Faster R-CNN中的一个关键挑战是前景和背景 Anchor 点之间的严重不平衡。为了解决这个问题,在计算损失时,会采样较少的 Proposal (默认设置中为256个),并指定一个前景比例(默认设置中为0.5)。对所有 Proposal 计算目标性损失,而边界框回归损失仅针对前景 Proposal 计算(因为网络应该如何回归背景 Proposal 是未定义的)。

4.2.2 Region of interest (ROI) heads:

输入. ROI Head 作为输入:

来自区域建议网络(RPN)的 Proposal 。在训练过程中,这些 Proposal 按照所需的前景/背景比例进行采样,这与计算RPN中损失时所使用的程序类似。然而,请注意,这些 Proposal 与用于计算RPN损失的 Proposal 是不同的。在Detectron2的默认设置中,以0.25的前景比例,从512个RPN Proposal 中采样作为ROI Head 的输入。

裁剪的主干特征,通过使用如ROIAlign [22] 的方法提取。这些是位于每个 Proposal “内部”的主干特征图中的特征。

输出。 ROI Head 随后为每个 Proposal 预测:

多类分类。

最终边界框的回归目标,表示对边界框进行调整以更紧密地包围任何前景物体。

计算损失。 预测框再次基于交并比与真实框进行匹配,以计算损失。默认情况下,作者对(1)计算交叉熵损失,对(2)计算平滑L1损失。(2)同样只针对前景预测进行计算。

Soft Distillation Losses for Faster R-CNN

蒸馏损失是在教师预测和学生预测之间计算的。一种选择是基于一个置信度阈值参数来选择教师最自信的预测作为“伪标签”。这些伪标签取代了标准Faster R-CNN损失中的学生真实边界框。作者将这种方法称为使用“硬目标”。

相比之下,这里作者描述了如何计算“软”损失,使用教师的中间输出引导学生,而不进行阈值处理。

区域建议网络(RPN)。教师和学生的RPN从相同的 Anchor 点开始。作者使用2.2节中描述的相同采样程序来选择用于损失计算的 Proposal 。重要的是,作者确保从教师和学生那里采样相同的 Proposal ,这样它们就可以直接进行比较。作者使用sigmoid函数对教师的目标性预测进行后处理,以使它们更加明确。然后,作者计算教师的后sigmoid输出和学生的目标性预测之间的二进制交叉熵损失。作者还计算教师的RPN回归预测和学生的RPN回归预测之间的平滑L1损失。回归损失仅在教师的后sigmoid目标性得分 0.8的 Proposal 上进行计算。

ROI Head 。 Faster R-CNN的第二阶段为每个RPN Proposal 预测一个分类和回归,因此,作者需要使学生和教师的输入 Proposal 相同,以便直接比较它们的输出。为了实现这一点,在软蒸馏过程中,作者使用学生的RPN Proposal 来初始化学生和教师的ROI Head ——直观地说,作者希望教师告诉学生“如何处理”第一阶段提出的建议。

作者对教师的分类预测使用softmax进行后处理以使其更加明确,然后计算教师后处理后的softmax预测与学生分类预测之间的交叉熵损失。作者同时计算教师回归预测与学生回归预测之间的平滑L1损失。作者只在教师的最高得分类别预测不是背景类别的情况下计算回归损失。

Adversarial Feature Alignment

作者实现了两个网络,分别在图像 Level 和实例(边界框) Level 执行对抗性对齐。作者的方法受到Faster R-CNN in the Wild [9] 和 SADA [10] 的启发。

图像 Level 的对齐。 作者构建了一个对抗性判别器网络,该网络在图像 Level 接收 Backbone 特征。默认情况下,作者使用如[35]中所述的特征金字塔网络的“p2”层。作者使用一个简单的卷积头,包含一个隐藏层。作者的默认设置产生的这个torch模块:

卷积判别器( (模型): 顺序模型( (0): Conv2d(256, 256, 卷积核大小=(3, 3), 步长=(1, 1)) (1): ReLU() (2): 自适应平均池化2d(输出大小=1) (3): 展平(开始维度=1, 结束维度=-1) (4): 线性(输入特征=256, 输出特征=1, 偏置=True) ) )

实例级对齐。作者还实现了一个实例级对抗性对齐网络,它将ROI Head 分类头的最后一个隐藏层作为输入。默认情况下,作者的实例级判别器由一个隐藏的全连接层组成。作者的默认设置导致了以下这个torch模块:

FCDiscriminator( (model): Sequential( (0): Flatten(start_dim=1, end_dim=-1) (1): Linear(in_features=1024, out_features=1024, bias=True) (2): ReLU() (3): Linear(in_features=1024, out_features=1, bias=True) ) ) }

翻译为:

FCDiscriminator( (model): 顺序模型( (0): 展平(开始维度=1, 结束维度=-1) (1): 线性(输入特征=1024, 输出特征=1024, 偏置=True) (2): ReLU激活函数() (3): 线性(输入特征=1024, 输出特征=1, 偏置=True) ) ) }

3 Experiment Details

Backbone Pretraining

在作者的实验中,作者评估了两种不同的基础模型:一种带有特征金字塔网络[35]的ResNet-50[23],以及一种带有ViTDet[33]的ViT-B[14]。这两个基础模型都在ImageNet-1K分类任务和COCO实例分割[36]任务上进行了预训练。此外,ViT-B基础模型还使用了在[20]中提出的 Mask 自动编码器目标进行预训练。

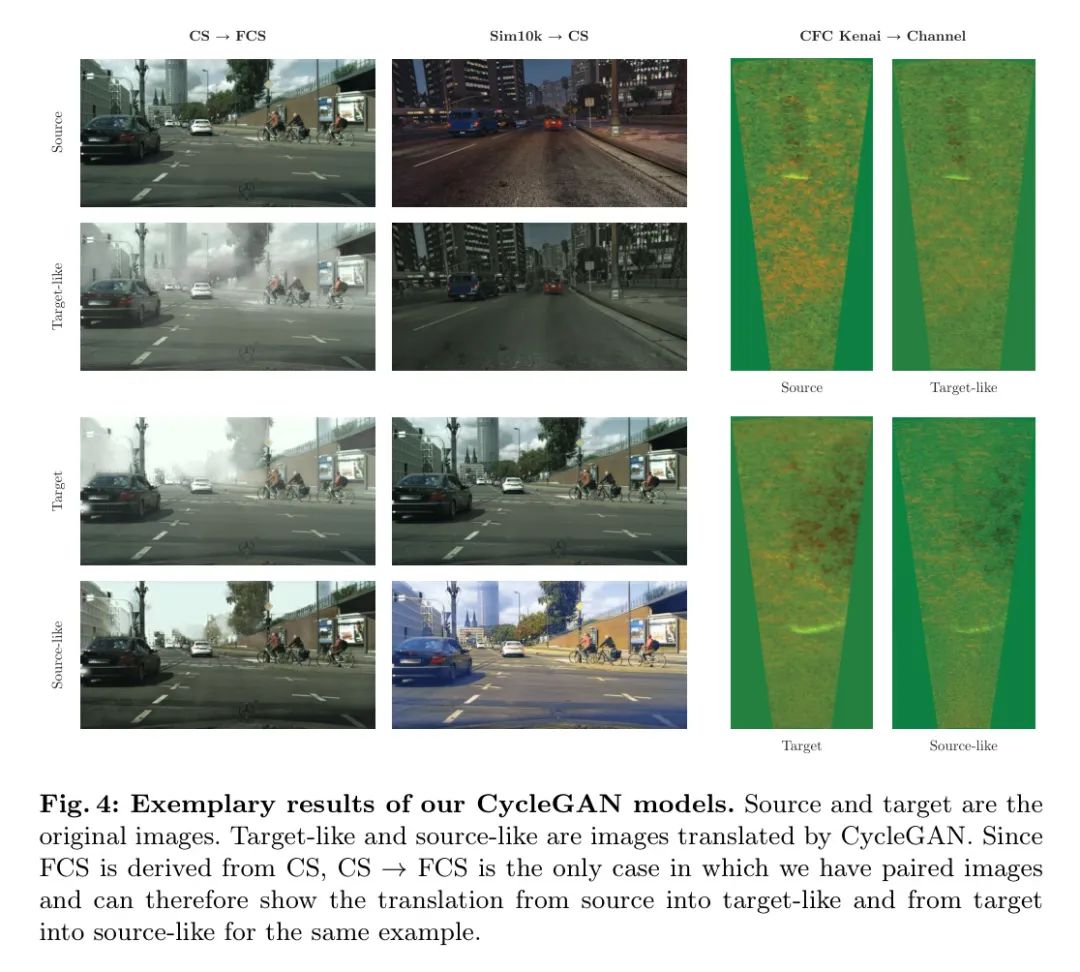

Image-to-Image Translation

与在特征空间中进行对抗性对齐的SADA [10]不同,UMT [12]在图像(即像素)空间中对齐域。这是通过训练和使用一个非配对的图像到图像翻译模型来尝试将源数据集中的图像转换为看起来像目标数据集的图像(“目标类似”),反之亦然(“源类似”)。作者遵循[12]使用CycleGAN [56]图像到图像翻译模型。作者训练CycleGAN 200个周期(Cityscapes 雾霾Cityscapes,Sim10k CS)或20个周期(Kenai Channel),并分别根据训练数据集中源与源类似以及目标与目标类似图像之间的平均Frechet初始距离(FID)[24]选择最佳模型。对于FID的计算,作者使用[42]中提出的clean-fid实现。作者在训练数据集上计算FID,因为UMT只使用这些数据集的翻译图像,这就是为什么作者只对训练数据上的最佳拟合感兴趣。然后作者在[12]的基础上提前使用选定的模型生成源类似和目标类似数据集,以便在主域适应方法训练之前。作者注意到调整CycleGAN的超参数或使用其他图像到图像翻译方法可能可以提高UMT的性能,然而为了公平复现,作者使用默认值。作者在图4中展示了用于训练UMT [12]的CycleGAN模型的一些示例性结果。

Other Training Settings

作者固定了总的有效批处理大小为48个样本,以便在所有实验中进行公平的比较。对于训练,作者在分布在四个节点上的8个Nvidia V100(32GB)GPU上执行每个实验。作者使用了MIT Supercloud [45]。

4 CFC-DAOD Dataset Details

与其他DAOD基准测试一样,CFC-DAOD由两个域的数据组成,即源域和目标域。

Source data

训练: 在CFC-DAOD中,源域训练集由原始CFC数据发布中的训练数据组成,即来自"Kenai左岸"地点的视频帧。作者使用了原始CFC论文[30]中引入的3通道"Baseline++"格式。为了进行ALDI论文中的实验,作者对空帧进行了下采样,使其大约占总数据的10%,结果是76,619张训练图像。为了可复现性,作者发布了确切的子样本集。然而,在发布关于CFC-DAOD的结果时,研究行人可以根据自己的需要使用原始CFC训练集,并不要求使用作者下采样的"Baseline++"数据。

验证: CFC-DAOD Kenai(源)验证集与原始CFC验证集相同。作者使用了原始CFC论文中的3通道“Baseline++”格式。共有30,454张验证图像。

Target data

训练: 在CFC-DAOD中,目标域的“训练”集包含了来自CFC中“Kenai Channel”位置的新数据。对于DAOD方法,这些帧应被视为 未标注 的,而对于Oracle方法,则被视为已标记的。作者还使用了“Baseline++”格式,并使用作者原始代码从原始视频文件生成图像文件以保证一致性。目标训练图像共有29,089张。

测试: CFC-DAOD目标域测试集与CFC中的“Kenai Channel”测试集相同。作者采用“Baseline++”格式。该测试集包含13,091张目标测试图像。研究行人应该在此数据上公布最终的mAP@Iou=0.5数值,并可以使用此数据来进行模型选择,以便与先前的方法进行公平的比较。

5 The ALDI Codebase

作者将ALDI作为一个基于现代检测器实现的开放源代码库发布。该代码库针对速度、准确性和可扩展性进行了优化,训练速度比现有的DAOD代码库快达5倍,同时所需的代码行数减少了多达13倍。这些特性使得作者的框架对于在实应用中开发检测模型的实践者以及推动DAOD领域前沿的研究行人都具有很高的价值。

Detection Framework

作者设计ALDI代码库旨在轻量级且可扩展。因此,作者在Detectron2的最新版本[54]之上构建。Detectron2的最后一个标记版本是2021年11月的v0.6,然而自那时以来已经有许多升级导致了最先进的表现。因此,作者使用一个固定的版本,作者称之为基于非官方的v0.7拉取请求的v0.7ish,提交编号7755101,日期为2023年8月30日。目前,作者将这个版本的Detectron2作为pip可安装的子模块包含在ALDI代码库中,注意到一旦官方版本发布,它就不再需要作为一个子模块(即,它将能够直接通过pip安装,无需克隆任何代码)。

作者的代码库对底层的Detectron2代码未做任何修改,使其成为一个轻量级的独立框架。这与现有的DAOD代码库(见表4)形成对比,后者通常在其实现过程中复制并修改底层框架。作者是构建在Detectron2之上,而不是内部,因此与其他DAOD代码库相比,作者的代码库最多可小13倍,同时提供更多的功能。作者指出,在表4中,其他代码库实现单一方法,而作者的支持所有研究的方法。

Speedups

作者在其他基于Detectron2的代码库中发现了训练过程中的重大瓶颈。特别是,作者发现数据加载器和变换实现不够高效。例如包括以下这些问题:

在增强过程中,来回转换张量在torch、numpy和PIL之间。作者解决了这个问题,根据需要重新实现了转换,使得所有操作都保持在torch中。

使用torchvision中的随机色调变换。作者发现,在禁用ColorJitter变换的此组件后,性能上的变化非常小。

为弱增强和强增强图像使用单独的数据加载器。作者改为在每个域使用一个数据加载器,并设置一个钩子,在执行强增强之前获取弱增强的图像。

作者重新实现了AT、MIC等使用的数据加载器和增强策略,使其更加高效,与AT相比,每张图像的训练时间提高了5倍。

参考

[1].Align and Distill: Unifying and Improving Domain Adaptive Object Detection.