从文本到图像:AutoBench-V利用LVLMs实现高效视觉问答评估 !

从文本到图像:AutoBench-V利用LVLMs实现高效视觉问答评估 !

大型视觉语言模型(LVLMs)已成为推进视觉和语言信息融合的重要工具,为各种复杂应用和任务提供了便利。 然而,LVLMs的评估面临着巨大的挑战,因为评估标准始终需要大量的人力物力进行构建,且一旦构建完成就变得静态,缺乏灵活性。尽管在文本模态中已经探索了自动评估,但视觉模态仍然有待深入挖掘。 因此,在本研究中,作者提出一个问题:“LVLMs能否作为自动评估标准的途径?”作者引入了AutoBench-V,这是一个按需提供评估的自动化框架,即根据模型能力的特定方面来评估LVLMs。 当接收到评估能力时,AutoBench-V利用文本到图像模型生成相关图像样本,然后利用LVLMs协调视觉问答(VQA)任务,从而高效灵活地完成评估过程。通过对五个所需用户输入(即评估能力)下的七个流行LVLMs进行广泛评估,该框架表现出有效性和可靠性。 作者观察到以下几点: (1)作者构建的基准准确地反映了任务难度的变化; (2)随着任务难度的增加,模型之间的性能差距扩大; (3)尽管模型在抽象层次理解方面表现出强大的性能,但在细节推理任务中表现不佳; (4)构建具有不同难度 Level 的数据集对于进行全面而详尽的评估至关重要。 总的来说,AutoBench-V不仅成功地利用LVLMs进行自动化评估,还揭示了LVLMs作为评判者的巨大潜力在各个领域。

1 Introduction

大型语言模型的繁荣为各种下游应用带来了显著的进步。随着LLM能力的增长,研究行人开始探索将视觉信息理解能力整合到LLM中,催生了大型视觉语言模型的。这些模型在广泛的成对图像-文本数据集上进行训练,使他们能够通过有效地整合视觉和文本信息进行复杂的多模态推理。

随着LVLMs的广泛采用,评估这些模型变得越来越重要,以更好地了解其局限性和可靠性。最近的研究强调了需要全面而复杂的评估标准,准确评估LVLMs在不同模态上的能力。各种基准旨在评估LVLMs包括3D理解、感知和认知能力、多学科理解和推理等一系列能力。尽管这些工作扎实地评估了LVLMs某些方面的能力,但它们缺乏支持按需评估不同能力方面的灵活性。最近的研究探讨了使用生成AI自动评估,这提供了在变化评估维度时的灵活性,并减少了基准数据集构建的人力成本。

尽管这些研究关注LLM的自动评估,但作者的目标是将其扩展到视觉模态,通过回答这个问题:“LVLMs可以作为自动基准的路径吗?”自动评估LVLMs面临几个关键挑战。首先,需要根据输入需求明确确定要评估的目标能力。这是相关图像和适当视觉问答(VQA)任务生成的基础,以准确评估LVLMs在这些特定方面的性能。其次,生成的图像和VQA任务应与评估目标相关且准确反映评估目标。第三,需要减轻从“评估者LVLM”在问题生成过程中可能出现的答案泄露风险。这个问题出现在负责生成问题的模型表现出自我提升偏见,即被评估的模型也被用于生成评估案例。

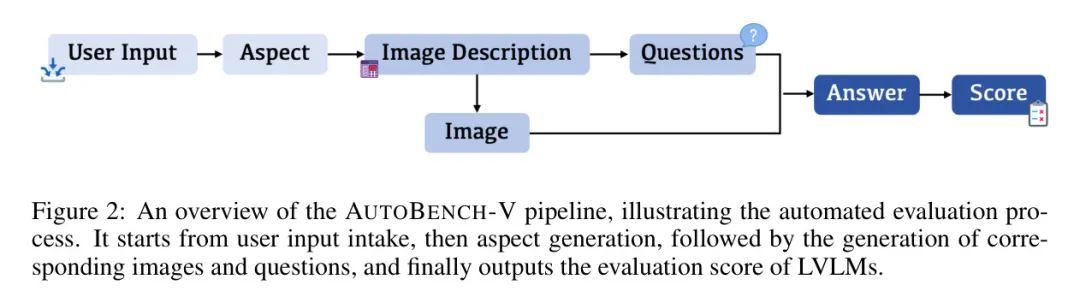

为应对上述挑战,作者提出AutoBench-V,该系统支持根据用户对模型能力的特定方面(例如空间理解)的需求进行LVLM的自动化评估。首先,输入需求由一个“检查器LVLM”处理,将其分为几个总体方面。每个方面进一步分为几个细粒度组件,为这些组件生成不同难度 Level 的图像描述。为了确保描述与对应图像一致,采用自验证机制,利用视觉问答技术。此外,实现了一个错误控制机制,以防止对生成问题和参考答案产生负面影响。生成的疑问和图像随后被呈交给评估的LVLM以生成响应,这些响应与参考答案(Liu等人,2024)进行评估。AutoBench-V的流程如图2所示。

通过利用AutoBench-V,作者对五种热门的LVLMs(语言模型)进行了广泛的评估,涵盖了五个必需的评价能力。结果表明,随着任务难度的增加,LVLMs的表现呈下降趋势,不同LVLMs之间表现各异。尽管在高级理解方面表现出色,但在详细推理方面存在困难,这揭示了未来研究的改进关键领域。作者还对生成的案例进行了多次人工评估实验,结果取得了积极成果,证实了作者的方法的可靠性。总之,作者的主要贡献有三个方面:

自动化LVLM评估框架。所提出的AutoBench-V是首个用于评估LVLMs能力的自动化框架。该框架利用文本到图像模型生成评估图像,并使用GPT-40作为评估者进行VQA评估。这一自动化显著减少了人类参与,提高了评估过程的效率和客观性。

经过大量实验验证框架的有效性。作者进行了全面的实验,包括对多个模型进行主要评估,考官优势测试,选项位置偏见分析以及人工评估。结果证实了该框架在评估LVLMs方面的稳健性和有效性。

深入分析LVLMs在不同视觉任务上的表现。通过使用各种用户输入进行系统评价,作者发现LVLMs在抽象概念理解方面表现出强大的熟练程度,而在具体视觉推理任务上的表现相对较低。这些见解为作者提供了关于当前LVLM技术状态的视角,突显了未来发展和探索的潜力领域。

2 Related Works

LVLM 模型基准测试 LVLM 模型的出现极大地推动了多模态模型的发展,展示了其在多模态感知和推理能力方面的卓越进步。这使得过去,专注于孤立任务表现基准已不足以进行全面评估。后续研究已经引入了针对 LVLM 模型在各种多模态任务上的评估基准。然而,这些基准往往在提供能力细致评估和稳健评估指标方面有所不足。因此,最近的研究强调了开发高级、全面的基准以更准确评估 LVLM 模型的多模态理解和推理能力的重要性。然而,这些基准仍存在不同类型的局限性。例如,LVLM-eHub 和 LAMM 使用了几个广为人知但并不足够新颖的数据集,忽略了在 LVLM 训练过程中数据泄漏的可能性。因此,MMStar(Chen 等人,2024)旨在通过构建一个精英视觉不可或缺的数据集,解决 LVLM 训练中存在的视觉内容不必要的数据泄漏问题。

与之前的工作相比,AutoBench-V不仅在LVLMs的整个基准测试过程中实现了自动化--显著减轻了人力负担并最大限度地减少了主观偏见--而且还扩展和定制了评估过程,以满足细粒度的用户需求。

自动基准测试。 语言模型(LLM)的重大早期进展推动了各种旨在自动化评估过程的基准测试的发展。例如,LMLxamQA 采用了“语言模型作为评估者”的概念,创建了一个全面且可扩展的评估框架。此外,DyVal 和DyVal2 都强调了动态评估的重要性,其中DyVal关注推理任务,而DyVal2采用了一种更广泛的心理学方法。AutoBencher 自动化了为评估LLM生成新、难和引人注目的数据集的过程,从而进一步扩大了自动化基准测试的范围。其他努力,如UniGen(Wu等人,2024)和Task Me Anything ,专注于为评估LLM/LVLMs在不同任务上的性能开发更定制和相关的基准测试。

3 AutoBench-V

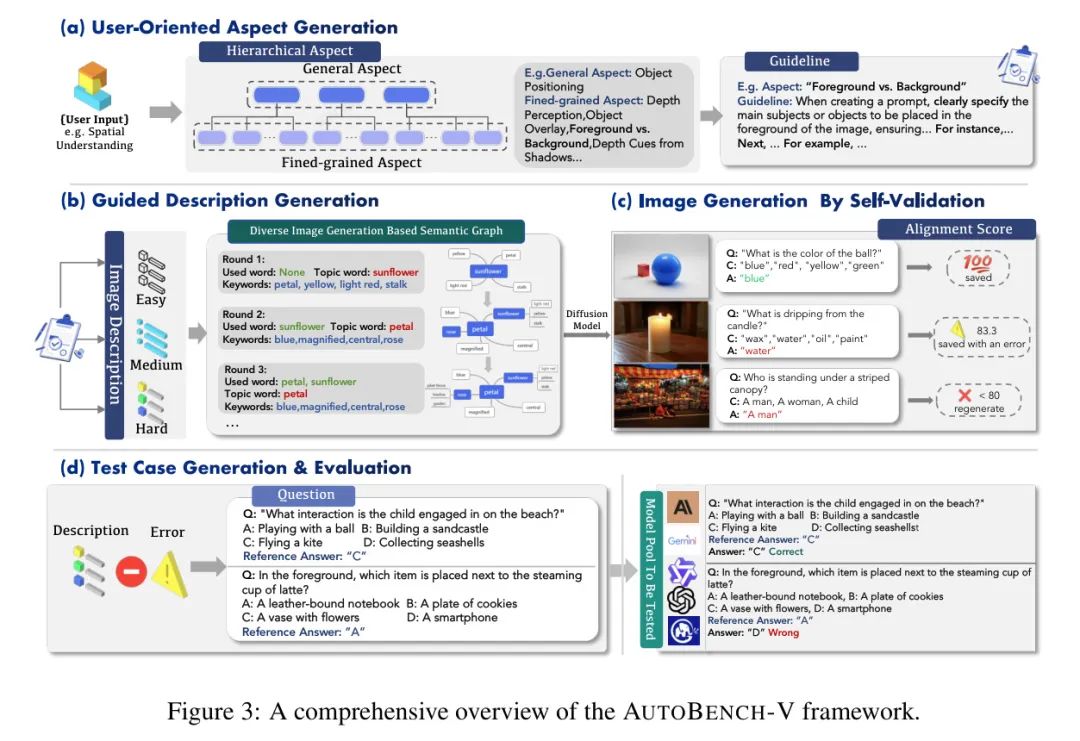

在本节中,作者介绍了AutoBench-V,这是一个用于自动化LVLMs基准测试的框架,由一个LVLM 和一个文本到图像模型驱动。如图3所示,AutoBench-V包括四个模块(小等,2024):面向用户的方面生成,引导描述生成,通过自验证生成的图像生成,以及测试用例生成与评估。

User-Oriented Aspect Generation

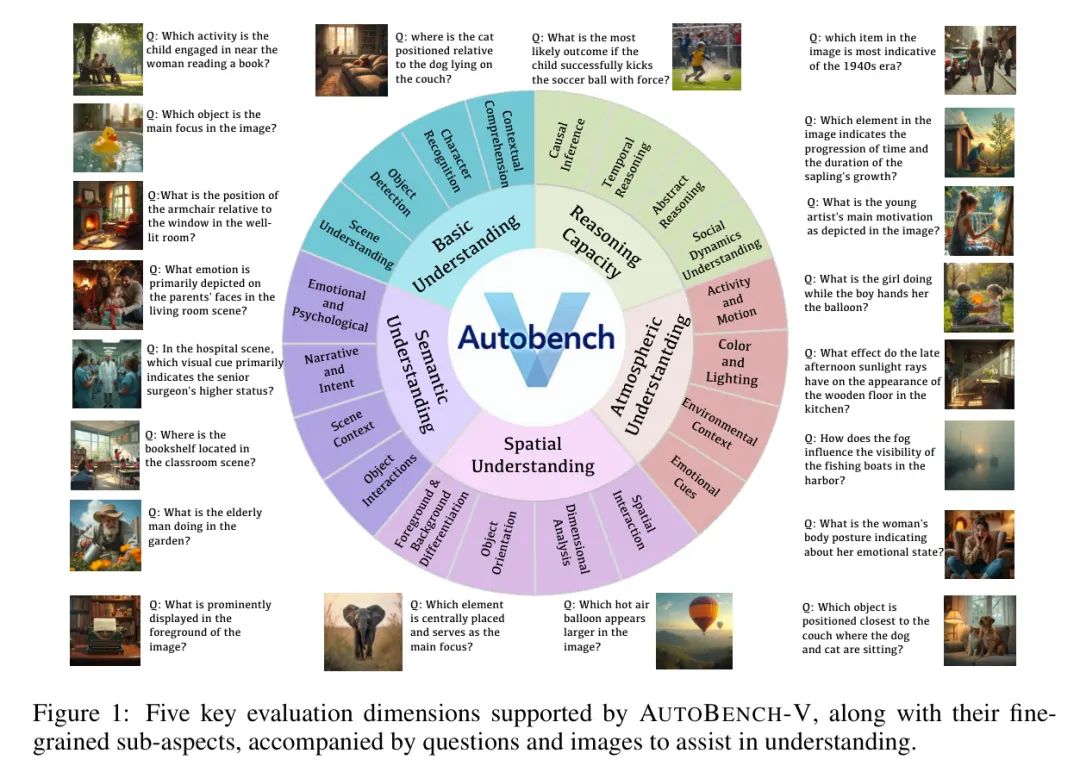

用户输入可以指定针对LVLMs能力的特定评估目标。AutoBench-V涵盖了以下关键评估方面,这些方面对于评估LVLMs的能力至关重要:《基本理解》、《空间理解》(李等,2023b)、《语义理解》(孟等,2024)、《推理能力》(刘等,2023b)和《大气理解》(Geetha等,2024)。值得注意的是,用户输入不仅限于上述类型,可以根据需要进行定制。

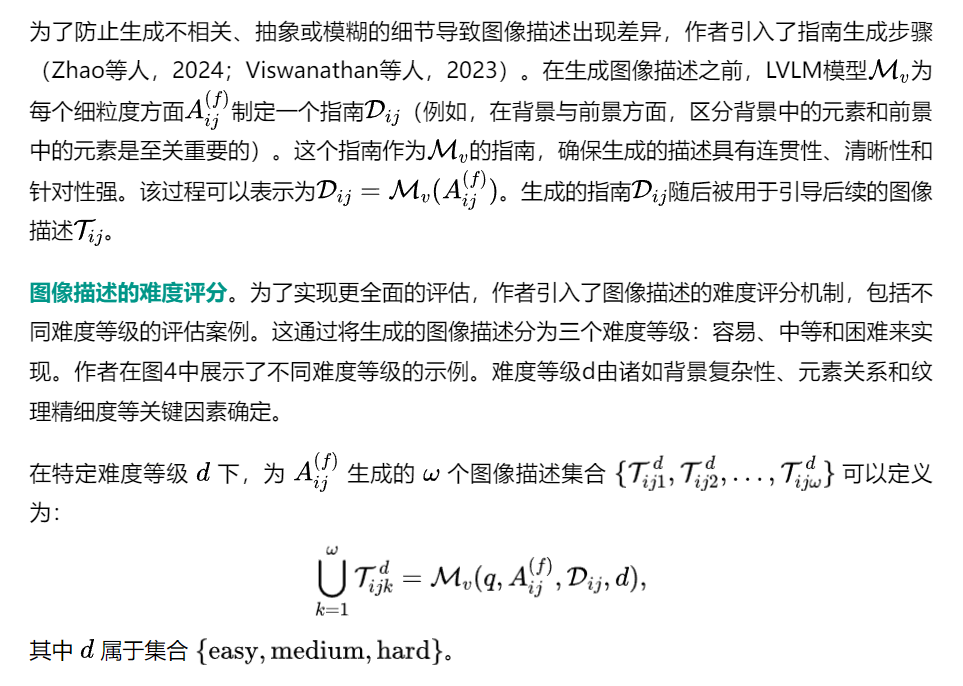

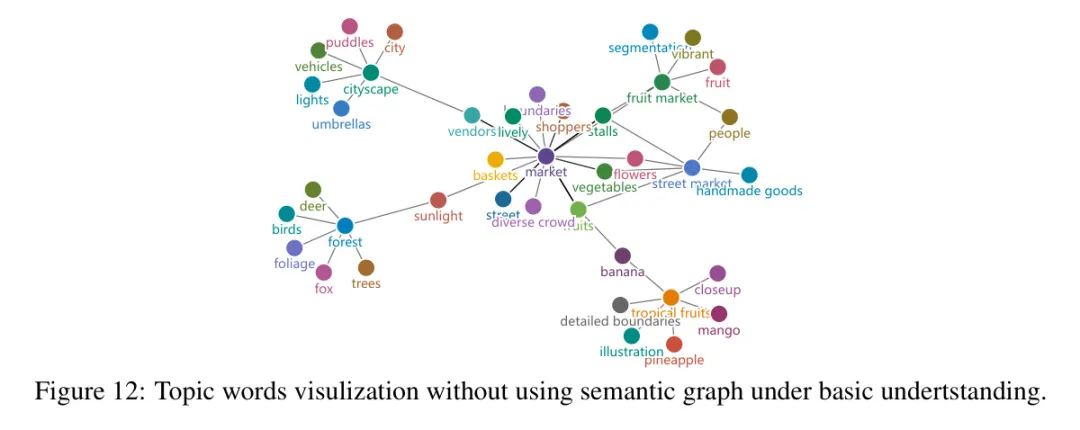

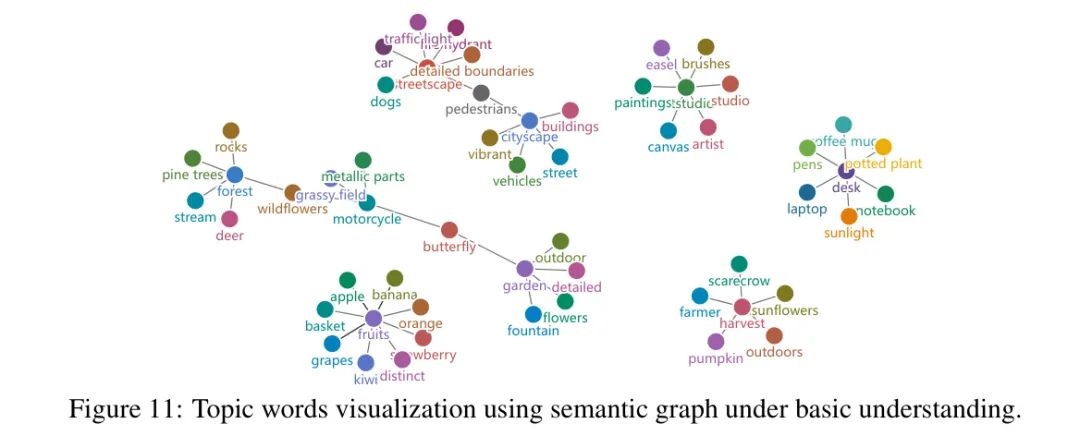

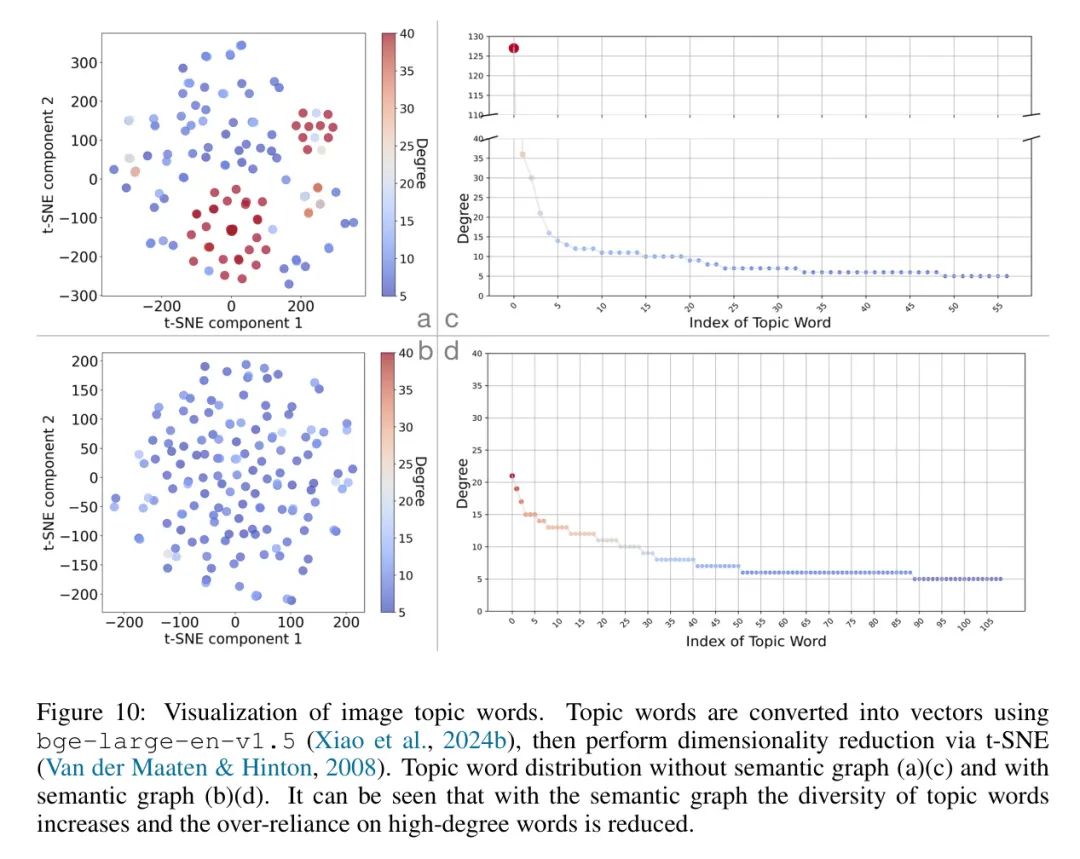

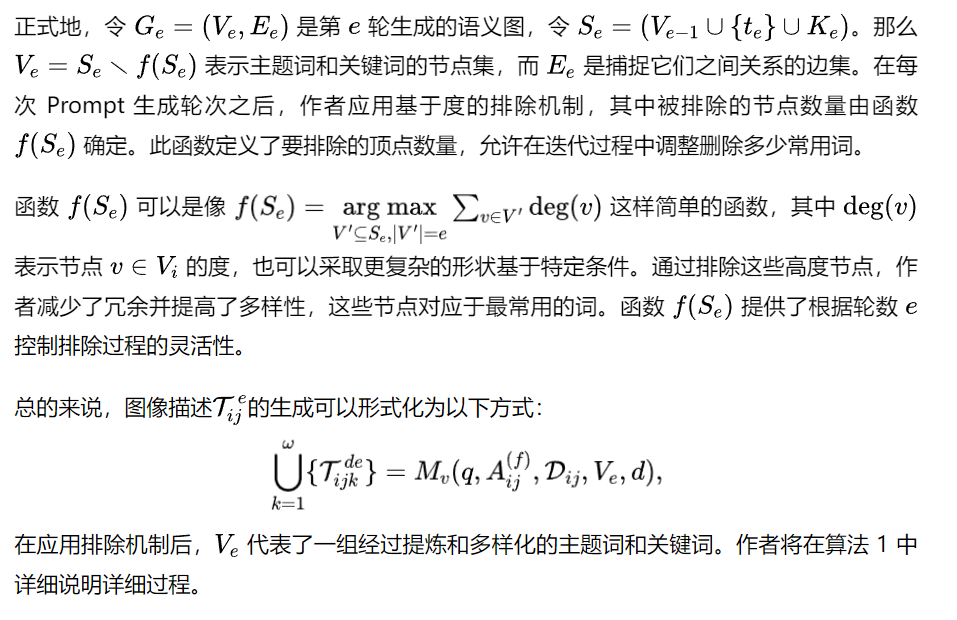

层次化方面生成。对于每个用户输入,作者推导出一组表示特定能力项目的方面。例如,如图1所示,上下文理解是基本理解下的一个方面。然而,直接从用户输入生成方面可能导致语义重复,降低多样性和可靠性。

Guided Description Generation

Image Generation By Self-Validation

Test Case Generation & Evaluation

4 Experiment

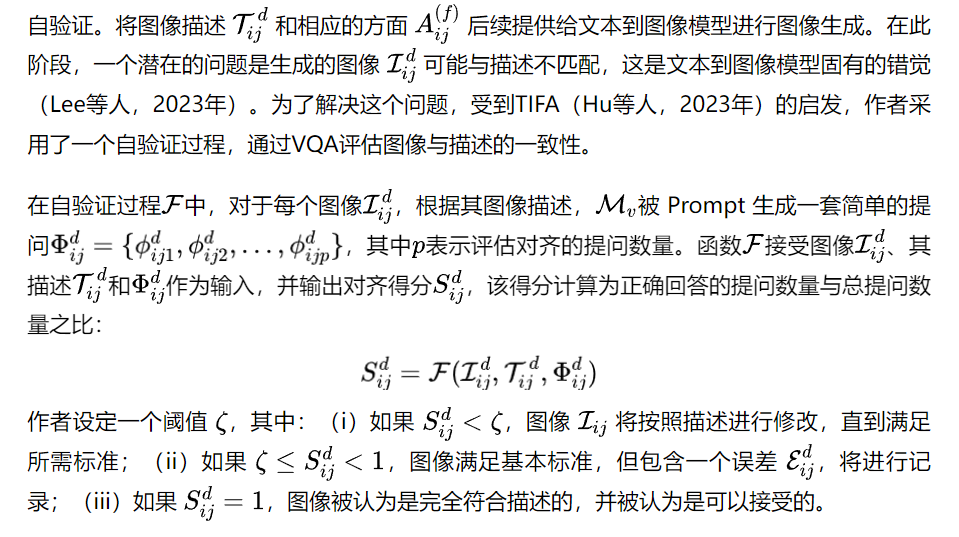

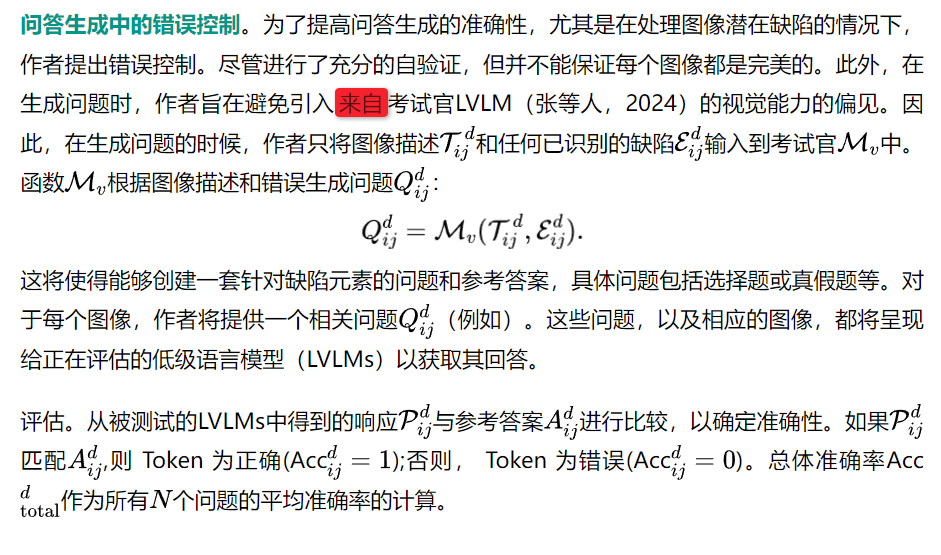

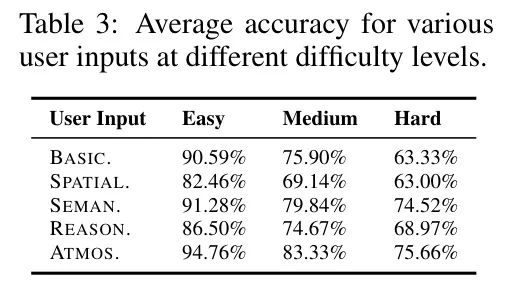

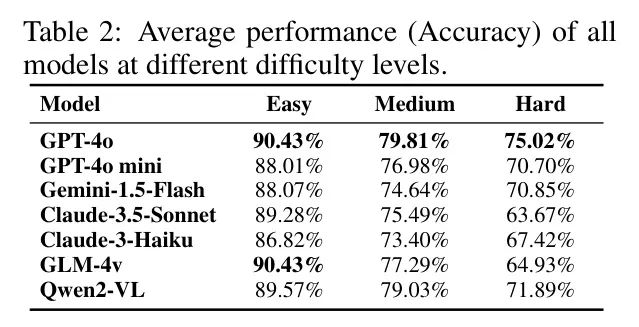

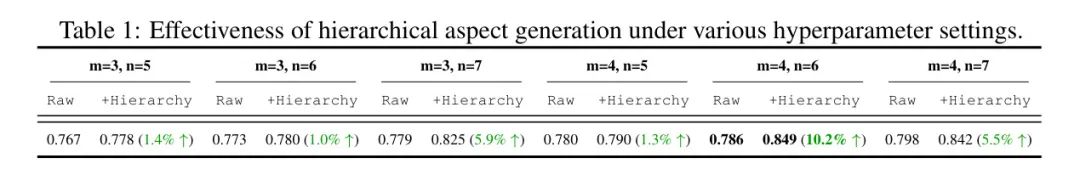

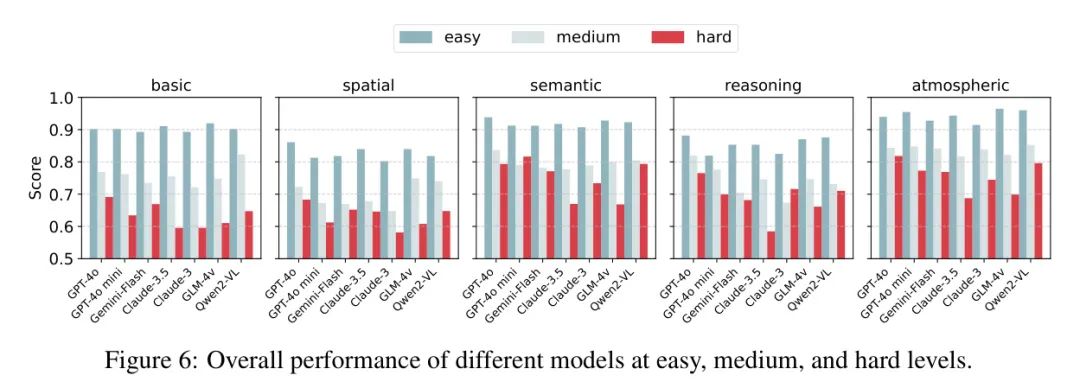

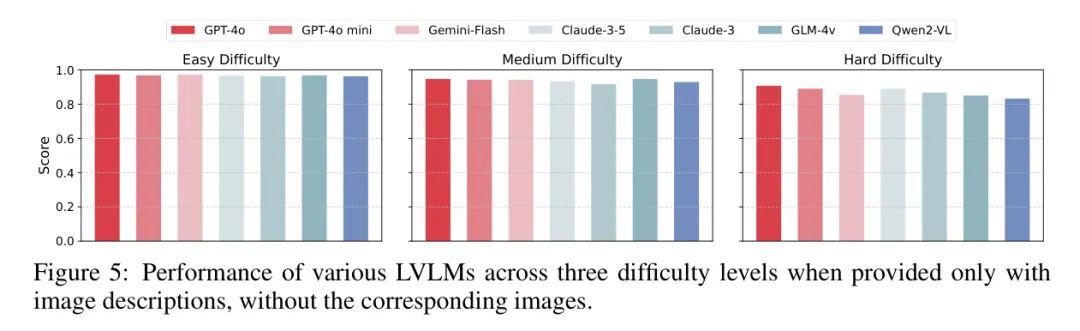

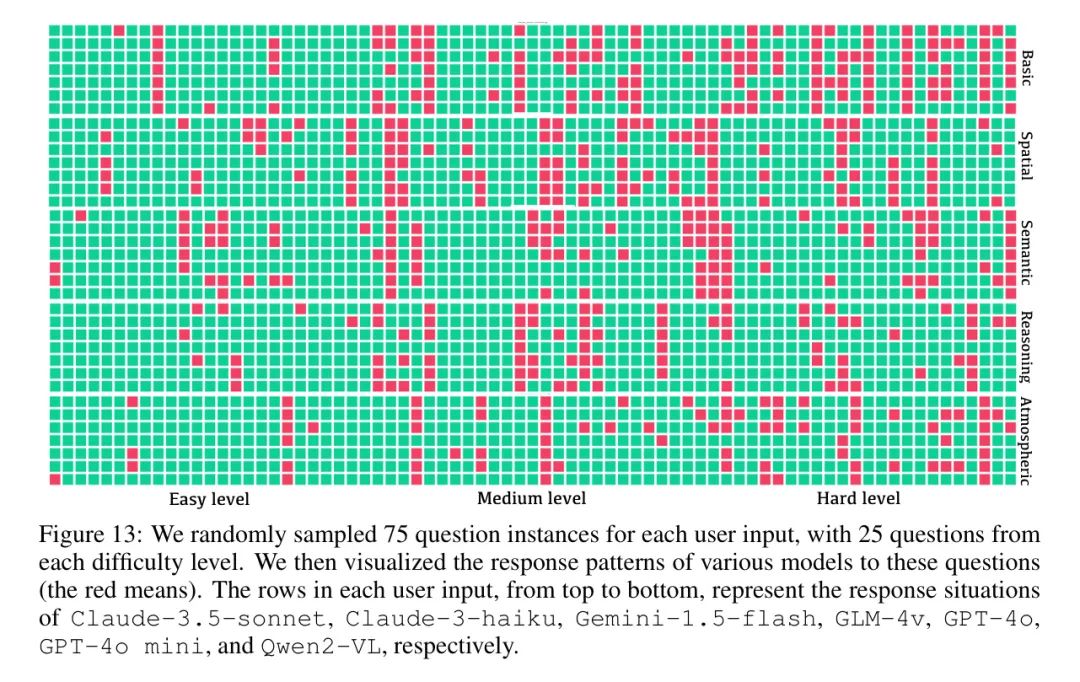

在本节中,作者使用Autobench-V评估了最新的七种模型,并进行了人工评估以验证作者的实验发现。首先,作者通过图5中的实验结果展示了Autobench-V如何显著降低潜在答案泄露和自我增强偏差。接下来,根据图6、表1、表2和表3,作者分析了各种评估因素(例如用户输入)和问题难度对模型性能的影响,这揭示了几个有启发性的发现。然后,作者在图8中呈现了五个用户输入类别,难度水平不同的模型排名,并讨论了Autobench-V生成过程中的人类评价。最后,作者研究了评估过程中的位置偏见,如图9所示。

Experimental Setup

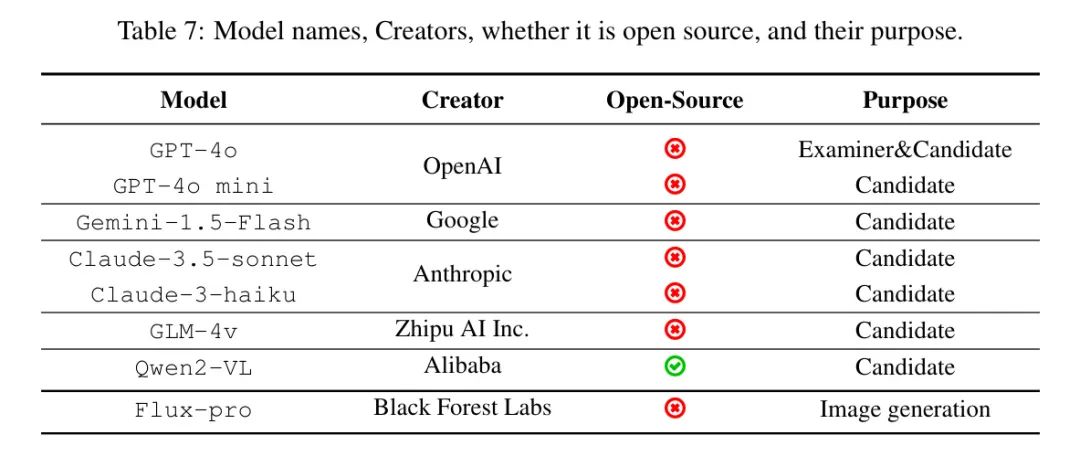

选定的模型。在评估LVLMs时,作者选择了七个具有代表性的模型:GPT-4o,GPT-4o mini ,Claude-3.5-Sonnet,Claude-3-Haiku,Gemini-1.5-Flash(DeepMind,2024年),GLM-4v ,以及开源Owen2-VL(Bai等人,2023年),详细内容见表7。这些先进的模型在图像理解方面表现出色。一些著名的开源模型,如Llava-1.6 和MiniGPT-4 ,也被测试过,发现它们的性能较差。此外,它们的性能与其他模型有显著差异,因此在作者的评估中没有讨论它们。由于其整体性能强大,作者选择GPT-4o作为生成图像描述、问题和答案的检查模型。然后,这些描述被传递到Flux-pro(blackforestlabs,2024年),这是一个以图像生成著称的文本到图像模型。

作者还尝试了其他文本到图像模型。然而,它们的性能不佳。这种组合使得基于图像的有效自动化生成问题变得可行,这对评估过程至关重要。

实验设置:作者设置n=4为一般方面的数量,m=6为细粒度方面的数量,因为这种配置生成的方面多样性最高,如表1所示,可以获得更广泛的场景和元素。作者设置ω=10,即每个细粒度方面有10张图片。因此,作者针对每个用户输入(每个用户输入有三个难度等级)评估720张图片。对于容易难度,作者设置自验证阈值ζe=1,因为场景更简单,包含更少的元素,因此需要更高的阈值。对于中等和困难难度等级,图片包含更多元素,因此作者将阈值降低到ζm=ζh=0.8,以避免效率受损。遵循的误差控制机制确保了阈值的正确性。

Examiner Priority

为了减轻自我提升偏差(例如,当被评估的模型也用于生成评估案例时)可能导致的问题,作者通过让AutoBench-v从图像描述而非直接从图像中生成问题,提高了评估的公平性。这种方法将视觉信息与生成过程分离,减少了自我提升偏差(Ye等人,2024年)的风险,如果问题来源于评估者模型的(GPT-4o)视觉能力,可能会导致不公平的比较。通过仅使用文本描述进行生成,作者排除了GPT-4o特定视觉处理能力的影响,从而确保了更公平的评估。

为了验证该方法的公平性,作者在避免模型直接访问图像的情况下,让模型在阅读图像描述的同时回答相关问题。如图5所示,结果显示所有模型在各种问题上的表现一致,变化范围很小(简单问题的变化为0.4%,困难问题的变化为2.4%)。这种一致性表明,在没有视觉输入的情况下,模型的文本理解能力几乎相等,这意味着该基准有效评估了视觉理解能力,并未明显偏向于检查者LVLM(即GPT-4o)。

Main Results

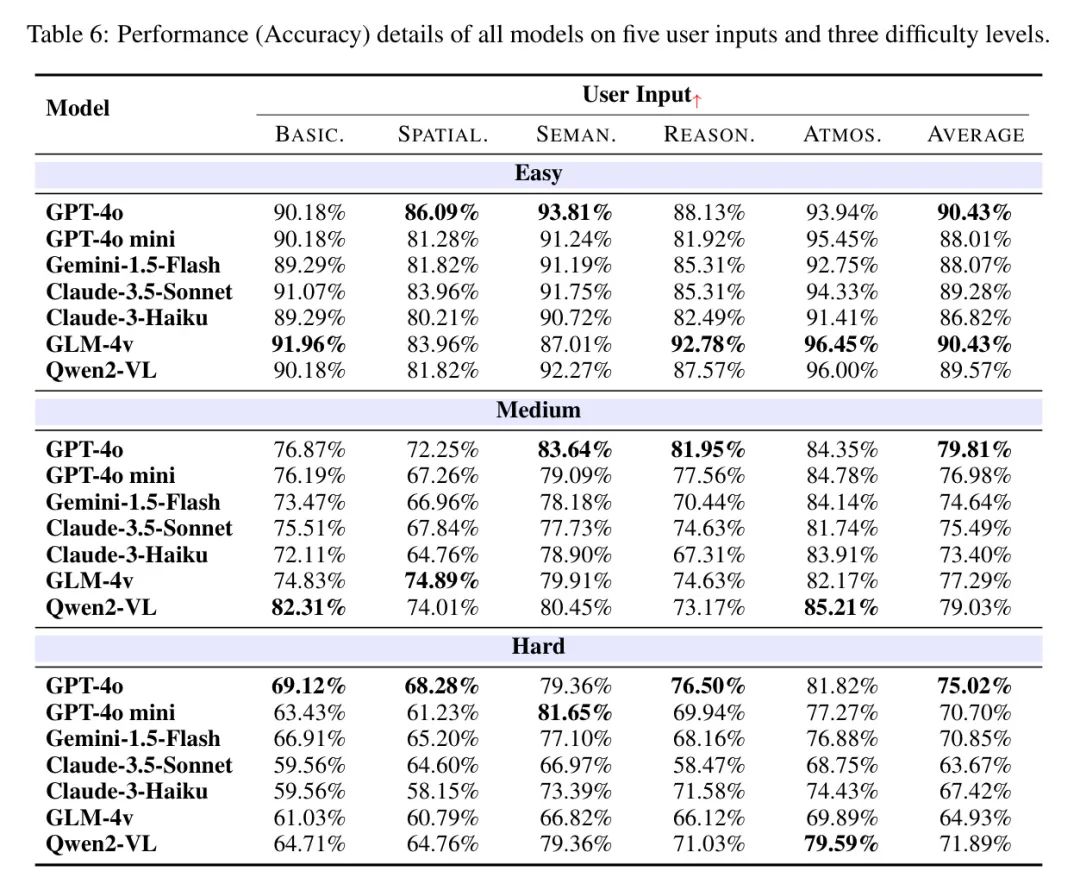

如图6所示,通过在AutoBench-V上评估各种模型,作者可以观察到一些可带来未来工作洞察的发现。详细结果见表6。

模型性能随着任务难度的增加而降低,GPT-4o在所有任务上表现出最强的平均性能。这一趋势在所有模型中都是一致的,从容易到困难,分数逐渐下降,如图13所示。例如,GPT-4o在容易 Level 的平均分数为90.43%,而在困难 Level 为75.02%。尽管整体上分数有所下降,但GPT-4o在各难度 Level 上仍保持领先地位。此外,该结果还强调了在容易和中等之间的显著变化。尽管随着难度的增加,有几个样本的分数有所提高,但大多数趋势仍然呈现出下降趋势,这加强了作者的难度分级机制的有效性。

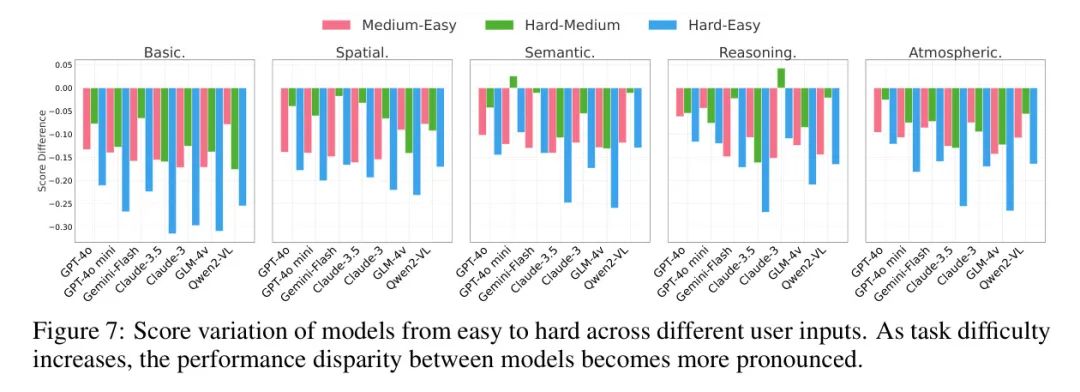

随着任务难度的增加,模型之间的性能差距变得更加明显。如图7所示,各模型的性能下降与任务难度增加而变化。Claude-3.5-Sonnet和GLM-4v等模型出现了更明显的下降。在困难的语义任务中,GPT-4o保持了强大的得分为79.36%,与Claude-3.5-Sonnet和GLM-4v的66.97%和66.82%相比,突显了GPT-4o处理复杂抽象概念的优越能力。三个难度等级的模型标准差分别为1.26%、2.14%和3.74%,随着任务难度的增加,差异性逐渐增大。

值得注意的是,像GPT-4o和GLM-4v这样的模型在难度等级上表现出更小的得分波动,表明在不同难度水平上的稳定性。相反,像Claude-3.5和Qwen2-VL这样的模型表现出更大的得分波动,表明对难度变化的敏感性较高。

模型在语义和大气理解方面表现出色,但在空间和推理任务上有所欠缺。如表3所示,作者的结果在难度等级上呈现一致的模式。模型在语义和大气理解方面表现出色,在难度达到74.52%和75.66%时,分别保持了很高的准确率。然而,空间和推理任务更具挑战性,在难度达到时,准确率下降到63.00%。这些发现表明,尽管LVLMs在理解语义内容和场景氛围方面已经发展了强大的能力,但在涉及空间关系和复杂视觉推理的任务上仍然存在局限性。为了解决这些问题,作者建议未来的研究可以探索训练策略,以强调在LVLMs中增强空间推理和复杂视觉问题解决能力。

Model Rank Overview

图8揭示了不同模型在各种难度下的不同性能模式。值得注意的是,像GPT-4o这样的模型,虽然在简单任务上没有显著优势,但在更具挑战性的场景(例如,困难问题)上表现出色。相反,像GLM-4v这样的模型在更容易的任务上表现良好,但当任务难度增加时,其能力会减弱。这表明模型在不同难度水平上的能力存在不平衡,突显了跨难度评估的重要性。这也表明AutoBench-V在揭示这些不平衡方面是有效的。

Human Evaluation

作者在两个方面进行了人评:指导性描述生成的有效性以及问题和参考答案之间的对齐。关于人评的详细信息,请参见附录D。最终,作者使用“对齐率”(即对齐样本占总样本的比例)来表示人评的结果。

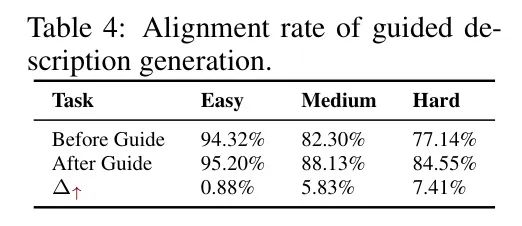

指导性描述生成。作者为每个细粒度方面制定了描述生成指南,以减少图像描述的模糊性,确保更好地与主题对齐,并防止出现差异。人类评估显示,这些指南显著改善了问题-答案对齐,尤其是在更具挑战性的任务中,如表4所示。

问题与答案对齐。 在实施生成指南后,作者对检查模型生成的问与答的准确性进行了人工评估,以评估检查模型在基于图像任务中产生的问题与答案对齐的准确性。如表4所示,评估结果得到了高分,证实了模型在生成图像任务中的问题与答案对齐的有效性。

Position Bias

由于由LLM生成的参考答案倾向于聚集在选项A,作者手动设置正确选项均匀分布。为了研究这种方法是否必要,作者进行了实验以检查潜在的位置偏见(Zheng等人,2023年)。作者评估了所有正确答案都放在选项A和D的情况,并将产生的分数与均匀分布的情况进行比较(即每个选项25%),如图9所示。偏差率使用以下公式计算:,其中是条件(A或D)的模型分数,是选项均匀分布时的分数。

5 Conclusion

在本研究中,作者提出了AutoBench-V,这是一个专门用于Level-VM(LVLM)基准测试的完全自动化框架。该框架集成了确保数据集生成多样化、可靠,以及模型评估公正的一系列创新模块。

通过大量实验,作者证明了AutoBench-V促成的评估过程的鲁棒性和无偏性。作者的研究得出的见解为该领域的未来研究奠定了坚实的基础。

参考文献

[0]. AutoBench-V: Can Large Vision-Language Models Benchmark Themselves。