每日学术速递12.24

CV - 计算机视觉 | ML - 机器学习 | RL - 强化学习 | NLP 自然语言处理

Power by Kimi&苏神 编辑丨AiCharm

Subjects: cs.CV

1.On Calibration in Multi-Distribution Learning

标题: 多分布学习中的校准

作者:Rajeev Verma, Volker Fischer, Eric Nalisnick

文章链接:https://arxiv.org/abs/2412.14142

摘要:

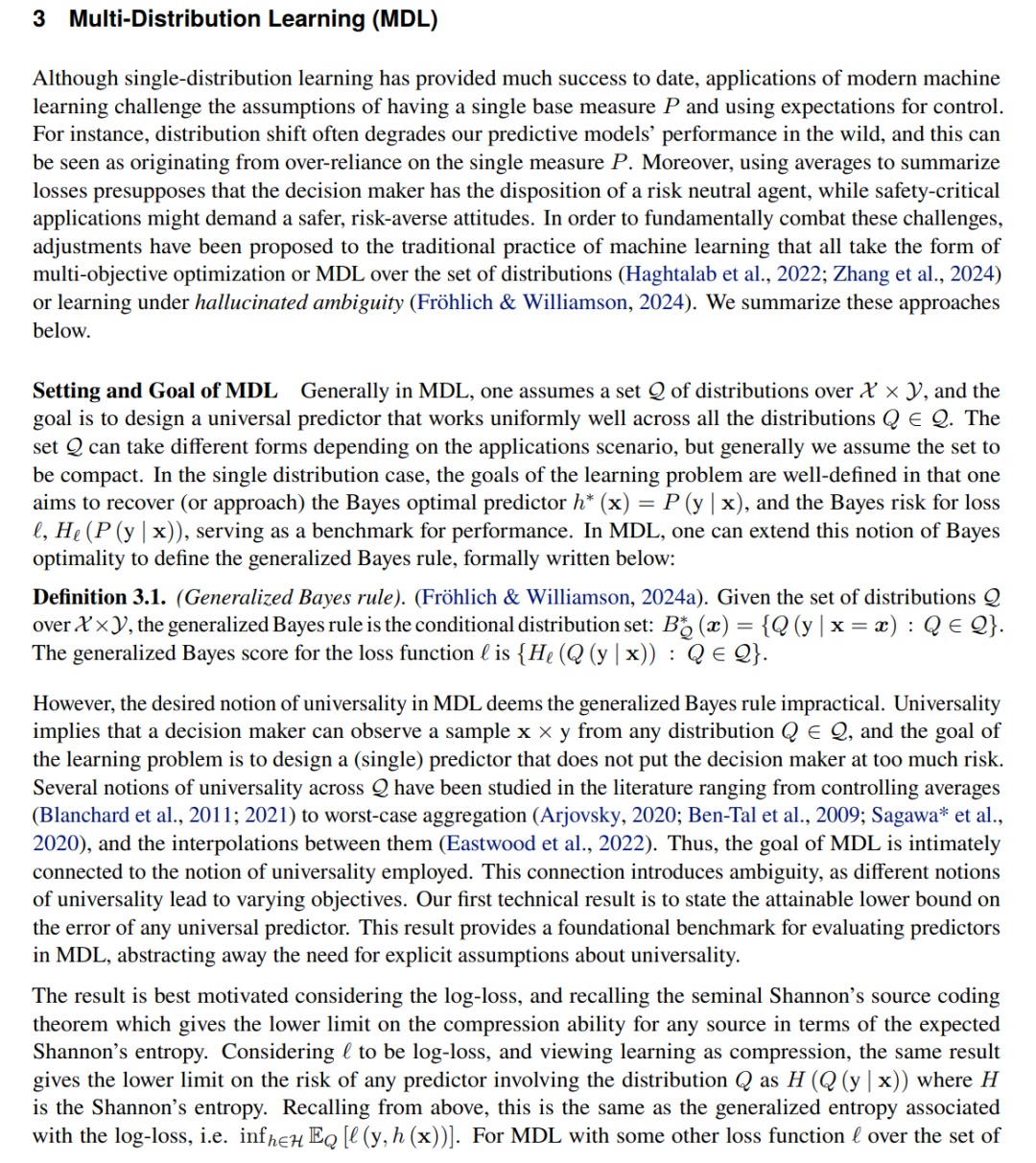

现代机器学习中鲁棒性、公平性和决策的挑战导致了多分布学习 (MDL) 框架的制定,其中预测器跨多个分布进行优化。我们研究 MDL 的校准属性,以更好地了解预测器如何在多个分布中均匀地执行。通过分解适当评分损失的经典结果,我们首先推导出 MDL 的贝叶斯最优规则,证明它最大化了相关损失函数的广义熵。我们的分析表明,虽然这种方法可确保最小的最坏情况损失,但它可能会导致多个分布中的不均匀校准误差,并且即使在贝叶斯最优性下也存在固有的校准-细化权衡。我们的结果凸显了一个关键的局限性:尽管 MDL 有希望,但在设计针对多个分布的预测变量时必须谨慎,以尽量减少差异。

这篇论文试图解决什么问题?

篇论文探讨了多分布学习(Multi-Distribution Learning, MDL)框架中的校准(calibration)问题。具体来说,论文试图解决以下几个问题:

- 多分布预测器的校准性质:论文研究了在多分布学习框架下,预测器如何在多个分布上统一表现良好,即校准性质。这涉及到理解预测器在不同分布上的表现是否一致。

- 最小最坏情况损失与校准误差的关系:通过分析,论文揭示了在多分布学习中,即使在贝叶斯最优性(Bayes optimality)下,也存在固有的校准-精细化(calibration-refinement)权衡,即在某些分布上降低误差可能会增加其他分布上的校准误差。

- 多分布学习中的校准差异性:论文指出,在多分布学习中,不同分布之间的校准误差是不均匀的,这是一个基本问题,即使在理论上和算法上也不能像单分布情况那样消除校准差异。

- 多分布学习对鲁棒性和公平性的影响:论文强调了多分布学习在设计针对多个分布的预测器时必须谨慎,以最小化差异,这对于实现多分布学习在鲁棒性和公平性方面的潜力至关重要。

- 决策理论中校准的后果:论文讨论了校准在决策理论中的后果,特别是在多分布学习中,决策者需要小心以充分利用MDL的潜力。

总的来说,论文试图深入理解多分布学习中的校准问题,并探讨这一问题对于机器学习在安全关键应用中的鲁棒性、公平性和决策制定的影响。

论文如何解决这个问题?

论文通过以下几个步骤来解决多分布学习(MDL)中的校准问题:

理论分析:

- 论文首先通过经典结果分解适当的评分损失,推导出MDL的贝叶斯最优规则,并展示它如何最大化相关损失函数的广义熵。

- 分析揭示了即使这种方法确保了最小最坏情况损失,也可能导致多个分布之间的非均匀校准误差,并存在固有的校准-精细化权衡。

校准性质的推导:

- 论文提出了一个关于MDL中预测器误差的可达到的下界(Proposition 3.2),并建立了任何分布中校准误差的界限,以多个分布中预测器的性能差异来表征校准差异。

几何解释:

- 利用适当的评分损失和广义熵函数之间的联系,论文从几何上解释了校准误差和精细化误差,提供了对MDL中校准误差直观的理解。

决策理论后果:

- 论文讨论了MDL中校准对决策理论的后果(Proposition 4.4),指出即使在MDL框架中实现了贝叶斯最优性,决策者在利用MDL的潜力时也必须小心,因为他们受到他们可以考虑的成本函数类型的限制。

实际应用的指导:

- 论文讨论了这些理论结果对实践的相关性,特别是在医疗保健等领域,强调了在不同设施中使用统一预测器时校准的重要性,并提出了一些可能的解决方案,例如直接最小化校准误差的上界或确保整体误差对每个分布都显著降低。

对特定应用的影响:

- 论文特别关注了分布鲁棒优化和公平性这两个MDL框架中突出的应用,并讨论了这些发现对实际应用中鲁棒性和公平性的影响。

未来研究方向:

- 论文提出了未来研究的方向,包括研究特定算法对MDL校准的影响,以及在实际设置中实证研究这些理论结果的影响。

通过这些步骤,论文不仅分析了MDL中的校准问题,还提供了对如何设计更鲁棒和校准良好的模型的见解,这些模型可以在分布不确定性下使用。此外,论文还强调了在实际应用中实现MDL的全部潜力时需要考虑的设计选择和潜在限制。

论文做了哪些实验?

根据提供的论文内容,论文本身并没有提到具体的实验部分。论文主要集中在理论分析和概念探讨上,旨在研究多分布学习(MDL)框架下的校准问题,并探讨其对鲁棒性、公平性和决策制定的影响。论文通过以下几个方面来阐述其观点和发现:

- 理论推导:通过数学推导来分析MDL中的贝叶斯最优规则和校准误差。

- 概念解释:解释了校准、精细化以及它们与损失函数和风险最小化之间的关系。

- 决策理论分析:探讨了校准在决策理论中的含义,尤其是在MDL框架下。

- 实际应用讨论:讨论了MDL在分布鲁棒优化和公平性等应用中的影响。

- 未来研究方向:提出了未来可能的研究方向和实际应用中可能需要考虑的设计选择。

由于论文主要聚焦于理论分析,因此并未提及实验验证部分。实验部分通常会在应用型研究中出现,用于验证理论分析或算法在实际数据集上的表现。在论文的讨论部分,作者提到了未来研究将考虑实证研究这些理论结果的影响,这意味着实验部分可能会在未来的工作中出现。

论文的主要内容:

这篇论文主要探讨了多分布学习(MDL)框架中的校准问题,并分析了校准对于鲁棒性、公平性和决策制定的影响。以下是论文的主要内容总结:

问题背景:

- 论文指出,在机器学习中,特别是在安全关键的应用中,对鲁棒性、公平性和可靠决策的需求日益增加。

- 传统的机器学习假设样本来自单一固定分布,而MDL旨在跨越一组分布学习预测器,并在这些分布上表现良好。

多分布学习(MDL)框架:

- MDL框架允许通过优化多个分布上的预测器来应对分布偏移、公平性和决策制定中的挑战。

- 论文提出了MDL的贝叶斯最优规则,并展示了如何通过广义熵最大化来推导这一规则。

校准分析:

- 论文分析了MDL中预测器的校准性质,发现即使在贝叶斯最优条件下,也存在校准误差的非均匀分布。

- 论文提出了校准误差与性能差异之间的关系,并指出了校准与精细化之间的权衡。

理论结果:

- 提出了MDL中预测器误差的可达到下界,并建立了校准误差的界限。

- 论文还讨论了校准对于决策理论的影响,指出MDL框架提供的最坏情况损失保证并不总是能转化为对任意成本函数的保证。

实际应用与指导:

- 论文讨论了MDL在分布鲁棒优化和公平性等应用中的后果,并为实践者提供了如何考虑校准问题的建议。

未来研究方向:

- 论文提出了未来研究的方向,包括算法研究、校准误差量化、校准-精细化权衡的深入分析等。

2.IP2P: Unsupervised Instruction-based Image Editing via Cycle Edit Consistency

标题:UUIP2P:通过循环编辑一致性进行无监督的基于指令的图像编辑

作者: Enis Simsar, Alessio Tonioni, Yongqin Xian, Thomas Hofmann, Federico Tombari

文章链接:https://arxiv.org/abs/2304.05977

项目代码:https://enis.dev/uip2p/

摘要:

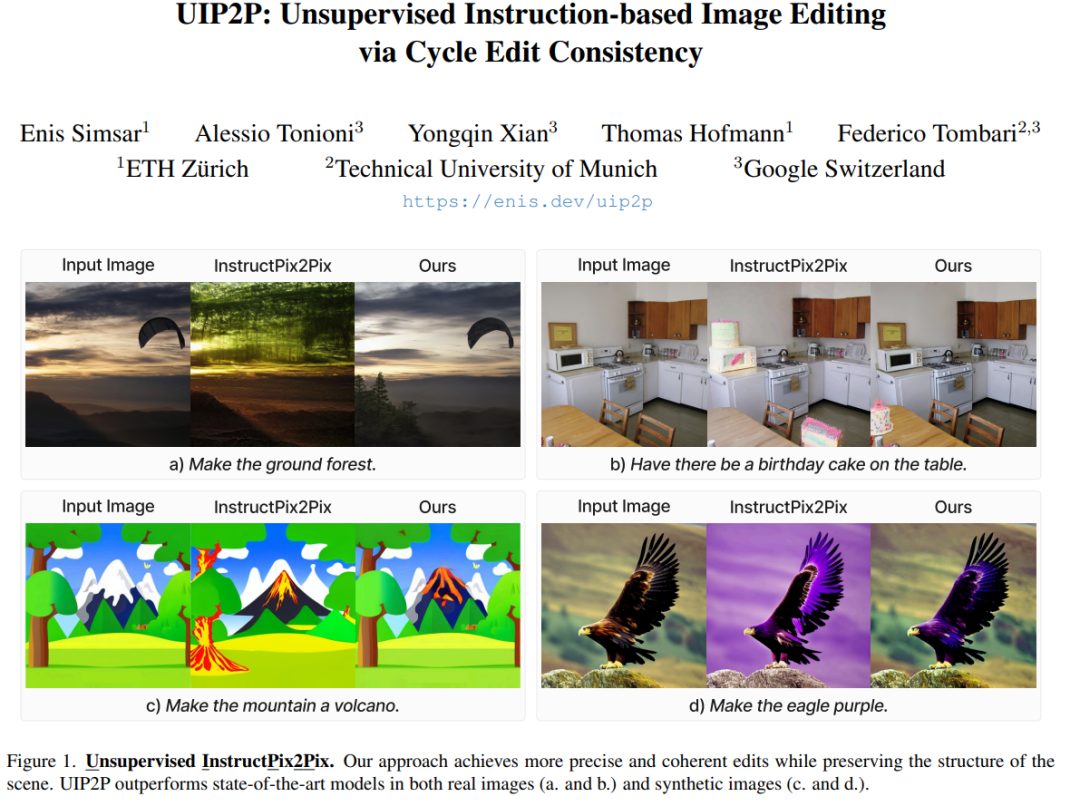

我们提出了一种基于指令的图像编辑的无监督模型,该模型消除了训练期间对真实编辑图像的需要。现有的监督方法依赖于包含输入图像、编辑图像和编辑指令三元组的数据集。这些是通过现有的编辑方法或人工注释生成的,这会引入偏差并限制其泛化能力。我们的方法通过引入一种称为循环编辑一致性(CEC)的新颖编辑机制来解决这些挑战,该机制在一个训练步骤中应用前向和后向编辑,并强制图像和注意力空间的一致性。这使我们能够绕过对真实编辑图像的需求,并首次解锁包含真实图像标题对或图像标题编辑三元组的数据集的训练。我们的经验表明,我们的无监督技术在更广泛的编辑范围内表现更好,具有高保真度和精度。通过消除对预先存在的三元组数据集的需求,减少与监督方法相关的偏差,并提出 CEC,我们的工作代表了基于指令的图像编辑的扩展方面的重大进步。

这篇论文试图解决什么问题?

这篇论文提出了一个名为UIP2P(Unsupervised Instruction-based Image Editing via Cycle Edit Consistency)的无监督模型,旨在解决基于指令的图像编辑中依赖真实编辑图像数据集进行训练的问题。具体来说,论文试图解决以下几个关键问题:

- 现有方法的依赖性:现有的基于指令的图像编辑方法主要依赖于监督学习,需要大量的包含输入图像、编辑后的图像和编辑指令的数据集。这些数据集通常通过现有的编辑方法生成或人工标注,引入了偏差,并限制了模型的泛化能力。

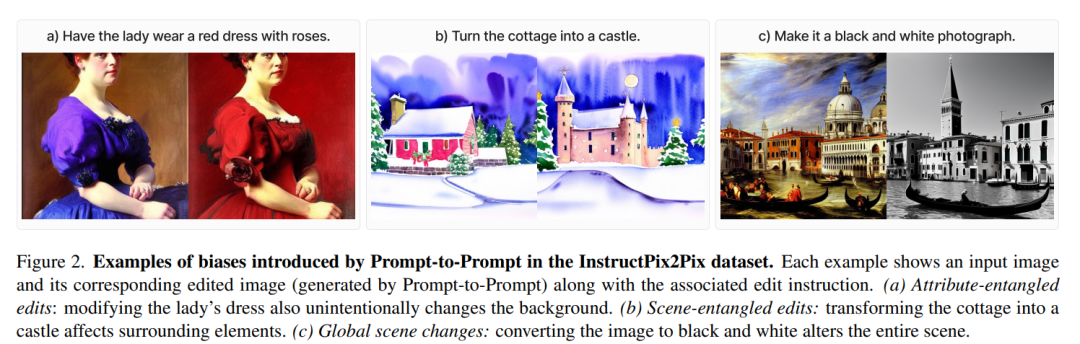

- 数据集偏差和限制:使用Prompt-to-Prompt方法或人工标注生成的数据集会引入偏差,例如属性纠缠和场景纠缠的编辑,影响图像中非预期的部分,或者导致整个场景的重大变化。此外,人工标注数据集的获取成本高且不切实际,限制了模型开发和大规模训练。

- 无监督学习的需求:为了克服上述挑战,论文提出了一种无监督技术,通过引入循环编辑一致性(Cycle Edit Consistency, CEC)机制,允许在训练过程中应用前向和反向编辑,并在图像和注意力空间中强制执行一致性,从而无需依赖真实编辑图像的数据集。

- 扩展性和多样性:通过消除对预存在编辑图像数据集的需求,减少与监督方法相关的偏差,并提出CEC,论文的工作代表了在解锁基于指令的图像编辑扩展性方面的一个重要进步,使得能够在更广泛的编辑类型和真实图像数据集上进行训练。

综上所述,论文的核心贡献在于提出了一种无监督的基于指令的图像编辑方法,通过CEC机制消除了训练过程中对真实编辑图像的需求,提供了一种更可扩展的替代当前监督方法的方案,并在真实图像数据集上展示了其有效性。

论文如何解决这个问题?

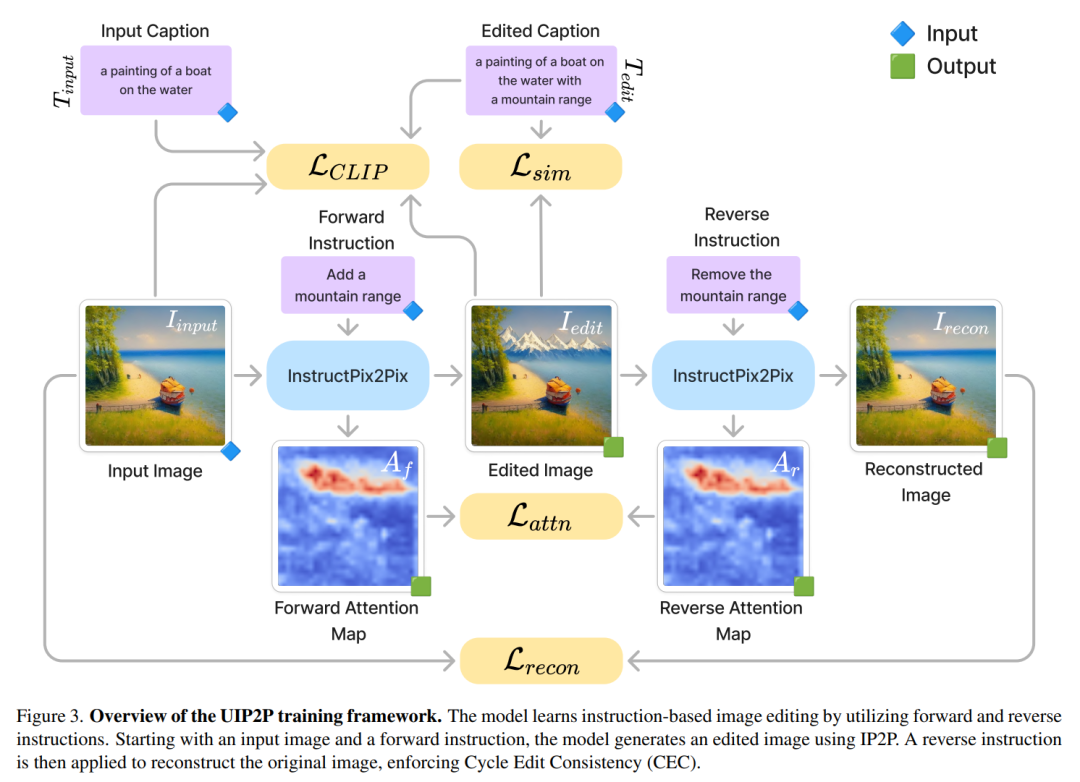

论文通过提出一个名为UIP2P(Unsupervised Instruction-based Image Editing via Cycle Edit Consistency)的无监督模型来解决依赖真实编辑图像数据集进行训练的问题。UIP2P的核心在于引入了一种新颖的编辑机制——循环编辑一致性(Cycle Edit Consistency,简称CEC)。以下是该方法的关键步骤和组件:

1. 循环编辑一致性(CEC)

- 概念:通过应用前向和反向编辑,在单次训练步骤中强制执行图像和注意力空间中的一致性,从而不需要真实的编辑后图像。

- 过程:给定一张图片和一个前向编辑指令(例如,“将天空变成粉色”),模型生成编辑后的图片。然后应用一个反向指令(例如,“将天空变回蓝色”),目标是恢复原始输入图像。

2. 关键组件

- 文本和图像方向一致性:利用CLIP嵌入对齐文本指令和图像修改之间的语义关系,确保输入和编辑图像之间的关系对应于它们各自的标题之间的关系。

- 注意力图一致性:确保在前向和反向编辑期间生成的注意力图对齐,保证模型在初始编辑及其反转过程中一致地关注图像的相同区域。

- 重建一致性:通过最小化重建图像和原始输入之间的像素级和语义差异,确保模型能够可靠地撤销其编辑。

- 统一预测与变化的扩散步骤:在前向(F)和反向(R)过程中独立预测一步的噪声,并将其应用于多个扩散步骤,以重建图像。

3. 损失函数

- CLIP方向损失:确保图像空间中应用的变换与CLIP语义空间中的文本指令对齐。

- 注意力图一致性损失:确保在前向和反向编辑中编辑的是图像的相同区域。

- CLIP相似度损失:鼓励编辑后的图像在语义上与提供的文本指令保持一致。

- 重建损失:确保在应用反向指令后能够恢复原始图像。

4. 总损失函数

- 将上述各个损失进行加权组合,形成总损失函数,用于模型训练。

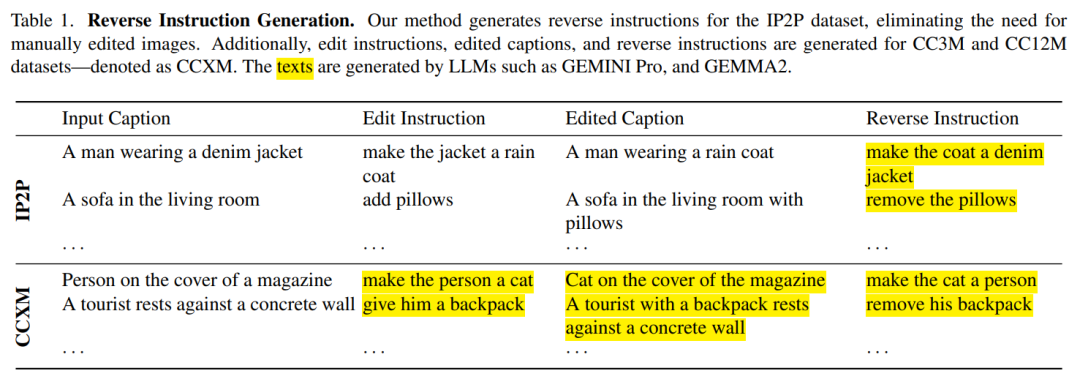

5. 训练数据

- 利用大型语言模型(LLMs)自动生成反向编辑指令,以扩展数据集,从而允许在没有手动编辑图像的情况下进行训练。

通过这种方式,UIP2P能够在没有真实编辑图像数据集的情况下进行训练,减少了对人工标注数据的依赖,提高了模型的泛化能力,并扩展了基于指令的图像编辑的应用范围。

论文做了哪些实验?

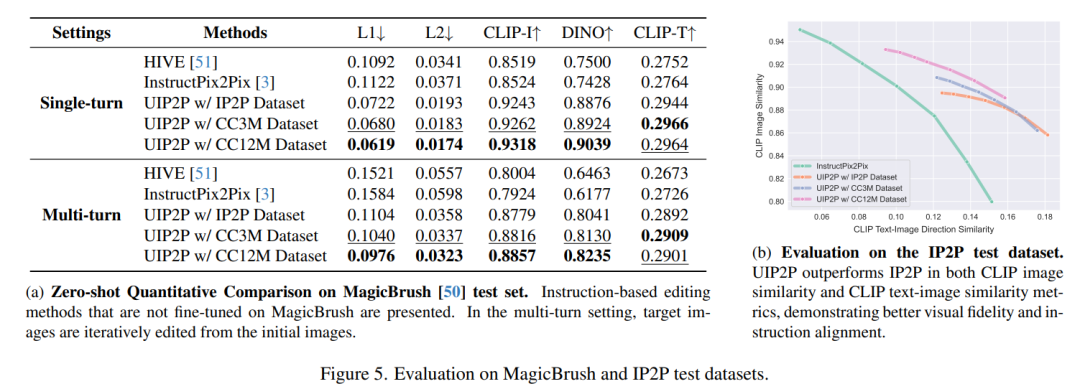

论文中进行了一系列的实验来评估UIP2P(Unsupervised Instruction-based Image Editing via Cycle Edit Consistency)模型的性能。以下是实验的主要内容:

1. 实验设置

- 数据集生成:使用InstructPix2Pix数据集以及扩展到真实图像数据集CC3M和CC12M,生成包含前向和反向编辑指令的数据集。

- 基线模型:与多个模型进行比较,包括InstructPix2Pix、MagicBrush、HIVE、MGIE和SmartEdit。

- 实现细节:UIP2P基于Stable Diffusion模型进行微调,使用不同的训练目标,主要关注循环编辑一致性(CEC)。

2. 定性结果

- 展示了UIP2P在不同任务和数据集上与基线方法相比的编辑结果,包括颜色修改、物体移除和结构变化等任务。

3. 定量结果

- 用户研究:通过Prolific Platform进行用户研究,比较不同方法在编辑匹配度和编辑应用准确性方面的表现。

- IP2P测试数据集:在IP2P测试数据集上使用CLIP图像相似度和CLIP文本-图像相似度评估视觉保真度和指令对齐度。

- MagicBrush测试数据集:在MagicBrush测试数据集上使用L1和L2范数评估像素精度,CLIP-I和DINO嵌入评估图像质量,以及CLIP-T确保与局部文本描述的对齐。

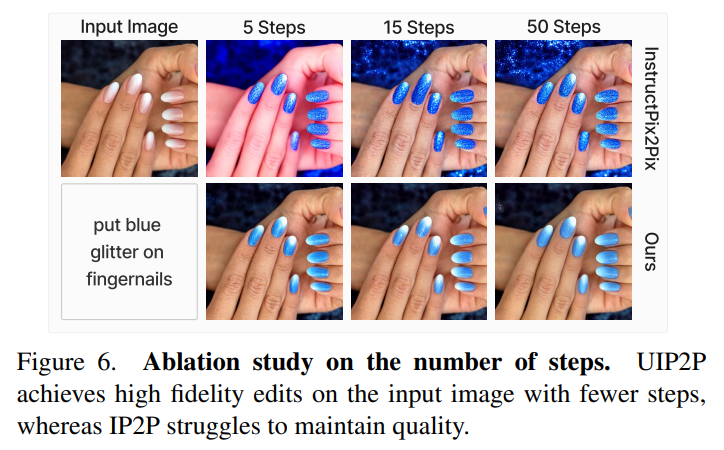

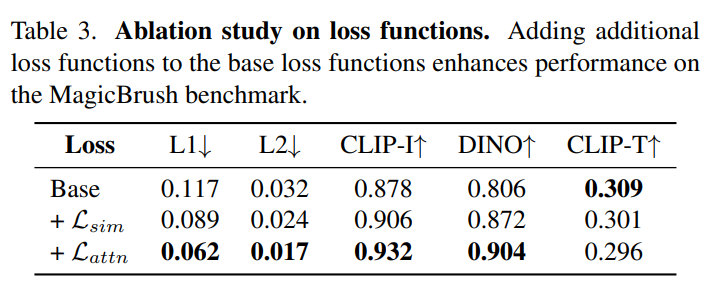

4. 消融研究

- 损失函数:评估不同损失函数对模型性能的影响。

- 扩散步骤数量:分析在推理过程中变化扩散步骤数量对图像质量的影响。

5. 效率分析

- 比较UIP2P与IP2P在推理时间上的效率,展示UIP2P在较少的DDIM步骤下如何保持高保真度的编辑。

这些实验全面评估了UIP2P模型在不同方面的表现,包括编辑质量、用户偏好、与现有技术的比较以及模型的效率和泛化能力。通过这些实验,论文证明了UIP2P作为一种无监督的基于指令的图像编辑方法的有效性和实用性。

论文的主要内容:

这篇论文提出了一个名为UIP2P(Unsupervised Instruction-based Image Editing via Cycle Edit Consistency)的无监督模型,用于基于指令的图像编辑。以下是论文的主要内容总结:

- 问题陈述:

- 现有的基于指令的图像编辑方法依赖于包含输入图像、编辑后的图像和编辑指令的数据集,这些数据集要么由现有的编辑方法生成,要么由人工标注,存在引入偏差和限制泛化能力的问题。

- 方法介绍:

- UIP2P通过引入循环编辑一致性(CEC)机制,消除了对真实编辑图像的需求,允许在单次训练步骤中应用前向和反向编辑,并在图像和注意力空间中强制执行一致性。

- 关键贡献:

- 提出了一种无监督技术UIP2P,它在训练期间不需要真实的编辑图像,提供了一种比当前监督方法更可扩展的替代方案。

- 引入了CEC,确保在前向和反向编辑过程中保持一致性,实现精确、高保真的编辑,准确反映用户指令。

- 展示了该方法在各种真实图像数据集上的可扩展性和多样性,无需依赖现有的数据集,显著扩展了基于指令的图像编辑的应用范围。

- 实验结果:

- 通过在真实图像数据集上进行广泛的实验,展示了UIP2P在多种编辑任务上的性能,包括颜色修改、物体移除和结构变化等。

- 与现有的监督和无监督方法相比,UIP2P在保持图像结构的同时,实现了更精确和一致的编辑效果。

- 结论:

- UIP2P作为一种无监督的基于指令的图像编辑框架,利用CEC确保编辑的可逆性和一致性,无需依赖真实编辑图像,具有高保真度和精确性,并且在多种编辑任务上具有竞争力。

总的来说,这篇论文提出了一个创新的无监督学习方法,通过循环编辑一致性机制,解决了现有基于指令的图像编辑方法的局限性,提高了模型的泛化能力和可扩展性,并在真实图像数据集上展示了其有效性。

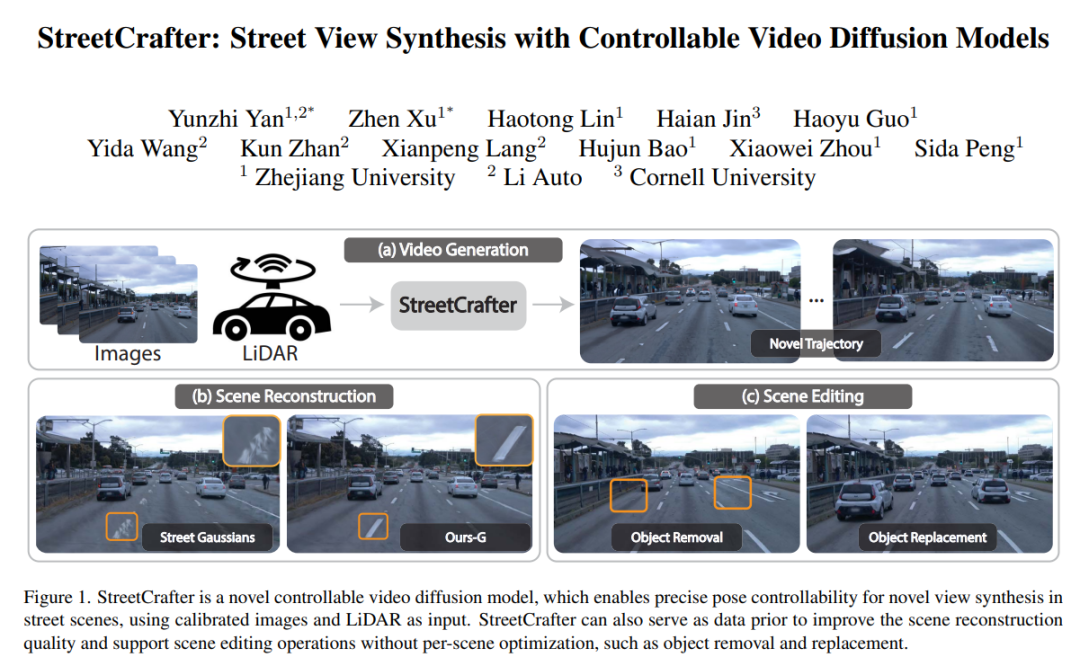

3.StreetCrafter: Street View Synthesis with Controllable Video Diffusion Models

标题:StreetCrafter:具有可控视频扩散模型的街景合成

作者:Yunzhi Yan, Zhen Xu, Haotong Lin, Haian Jin, Haoyu Guo, Yida Wang, Kun Zhan, Xianpeng Lang, Hujun Bao, Xiaowei Zhou, Sida Peng

文章链接:https://arxiv.org/abs/2412.13188

项目代码:https://zju3dv.github.io/street_crafter

摘要:

本文旨在解决车辆传感器数据的真实感视图合成问题。神经场景表示的最新进展在渲染高质量自动驾驶场景方面取得了显着的成功,但随着视点偏离训练轨迹,性能显着下降。为了缓解这个问题,我们引入了 StreetCrafter,这是一种新颖的可控视频扩散模型,利用 LiDAR 点云渲染作为像素级条件,充分利用生成先验进行新颖的视图合成,同时保留精确的摄像机控制。此外,利用像素级激光雷达条件使我们能够对目标场景进行精确的像素级编辑。此外,StreetCrafter的生成先验可以有效地融入动态场景表示中,以实现实时渲染。 Waymo Open Dataset 和 PandaSet 上的实验表明,我们的模型能够灵活控制视点变化,扩大视图合成区域以满足渲染需求,这优于现有方法。

这篇论文试图解决什么问题?

这篇论文试图解决的问题是如何在图像到视频合成(image-to-video synthesis)中实现精确控制对象轨迹,尤其是在处理3D空间中的运动时,现有方法面临的困难和挑战。具体来说,论文中提到的问题包括:

- 2D轨迹输入的局限性:传统的视频合成方法通常依赖于在图像上直接绘制的2D轨迹输入。这些方法虽然能在一定程度上表示运动,但它们在解释2D动作到3D空间时存在模糊性和复杂性,因为单一的2D路径可能对应多个3D轨迹,这使得在3D空间中精确控制对象运动变得不足。

- 3D轨迹提取的困难:从场景中提取准确的3D轨迹是一项额外的挑战,尤其是在存在遮挡或对象之间复杂交互的场景中。对于用户而言,输入有效的3D轨迹并非易事,通常需要专业知识和工具来在3D空间内准确定义对象路径,这对于艺术家和非专业用户来说可能是一个障碍。

- 交互式视频合成的需求:随着拖拽式交互的直观性,其在控制图像到视频合成中对象轨迹的应用越来越广泛。然而,现有方法在2D空间执行拖拽时,通常面临处理平面外运动时的歧义问题。

为了解决这些问题,论文提出了一个名为LeviTor的新方法,它通过将对象掩码抽象成少数几个聚类点,并结合深度信息和实例信息作为控制信号,来实现3D轨迹控制。这种方法不仅继承了2D拖拽的便利性,而且便于在3D空间中控制轨迹,扩大了创造性的范围。

论文如何解决这个问题?

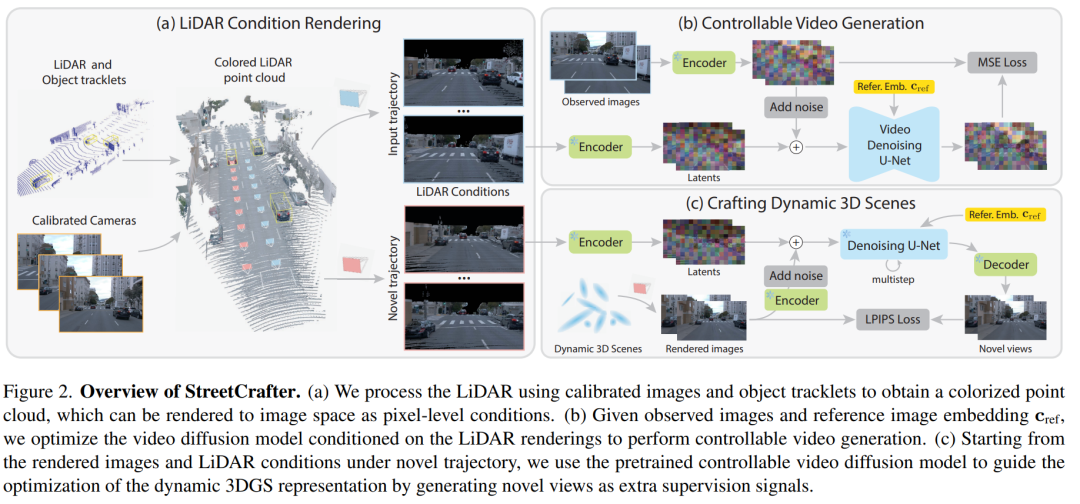

论文通过以下几个关键步骤解决从车载传感器数据进行逼真视角合成的问题:

- 提出StreetCrafter模型:

- 引入一个新型的可控视频扩散模型StreetCrafter,该模型使用激光雷达(LiDAR)点云渲染作为像素级条件,以实现对新颖视角合成的精确相机控制。

- 构建LiDAR条件:

- 利用校准图像和对象轨迹对LiDAR点云进行处理,生成彩色点云,并将其渲染为像素级条件图像,以此将新颖相机轨迹与输入校准图像在像素级别上建立联系。

- 训练和推理:

- 使用输入图像和相机轨迹训练模型,将LiDAR条件编码到模型的潜在空间中,并在推理时基于新颖相机轨迹生成对应的LiDAR条件,通过迭代去噪过程生成新视角图像。

- 将StreetCrafter蒸馏到动态3DGS表示:

- 为了实现实时渲染,论文进一步将StreetCrafter模型蒸馏到一个动态的3DGS(3D Gaussian Splatting)表示中,使其能够在大视角变化下进行高质量的视角合成。

- 场景表示和新视角生成:

- 使用3DGS表示动态城市场景,并从新颖视角渲染图像,这些图像作为额外的监督信号用于优化3DGS表示。

- 损失函数:

- 定义了结合输入视图和新视角生成的损失函数,包括L1、SSIM、LPIPS损失,以及额外的LiDAR深度损失、天空掩码损失和移动对象正则化损失。

通过上述步骤,论文实现了一个能够精确控制相机视角并生成逼真街景图像的系统,同时支持场景编辑操作,如对象移除和替换,而无需针对每个场景进行优化。此外,该方法在Waymo Open Dataset和PandaSet上进行了评估,实验结果表明该方法在图像质量、尤其是视角外推方面超越了现有方法,同时保持实时渲染的能力。

论文做了哪些实验?

论文中进行了以下实验:

- 实验设置:

- 使用Waymo Open Dataset和PandaSet进行实验,这些数据集提供了10Hz的前置摄像头和同步的激光雷达数据。

- 从Waymo验证集中选取15个序列(约100帧)和PandaSet中选取5个序列(80帧)进行测试。

- 输入图像分辨率分别为Waymo的1066×1600和PandaSet的900×1600。

- 与基线方法的比较:

- 与3DGS、Street Gaussians、EmerNeRF、UniSim和NeuRAD等方法进行比较。

- 通过PSNR、LPIPS和FID等指标评估渲染质量和速度。

- 定性比较:

- 展示了在Waymo和PandaSet数据集上的输入视图、基线方法和StreetCrafter方法的输出图像的定性比较。

- 定量结果:

- 提供了在Waymo和PandaSet数据集上的定量结果,包括PSNR、LPIPS和FID指标。

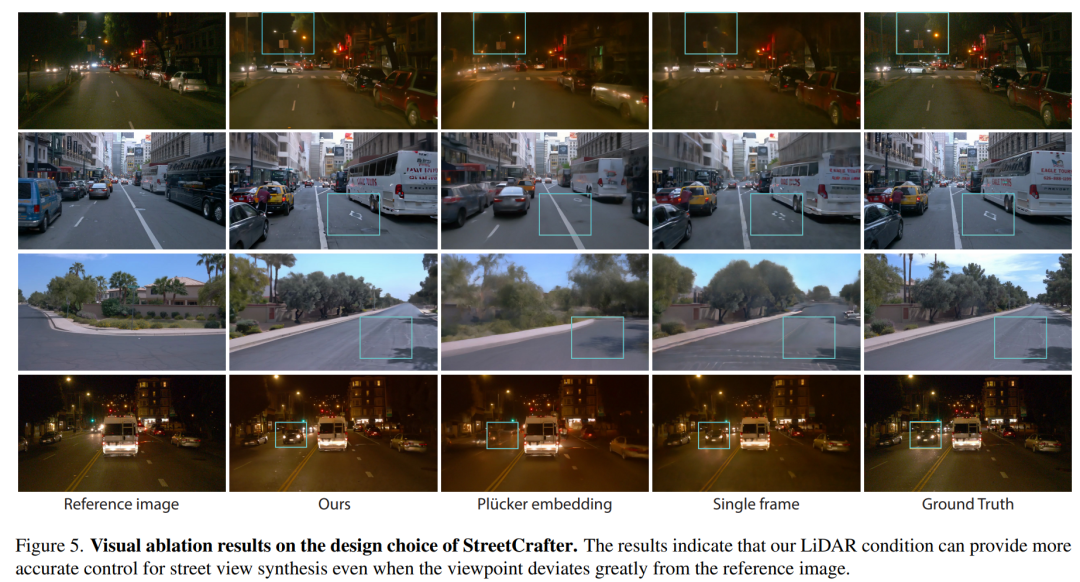

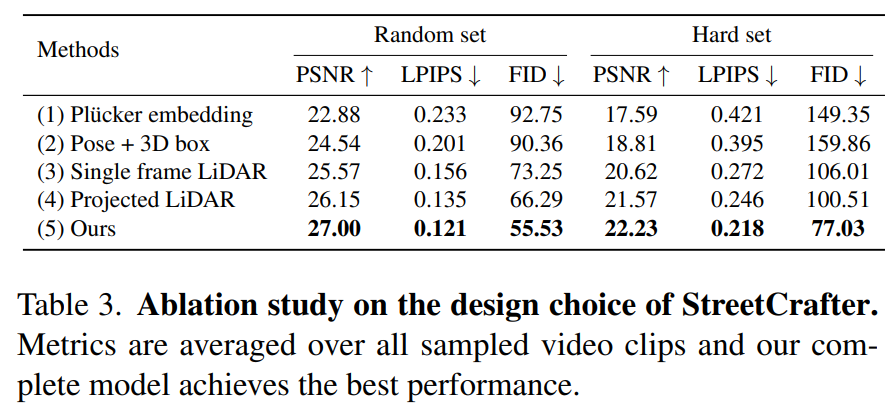

- 消融研究:

- 分析了StreetCrafter的设计选择,包括相机姿态条件、聚合LiDAR条件的影响。

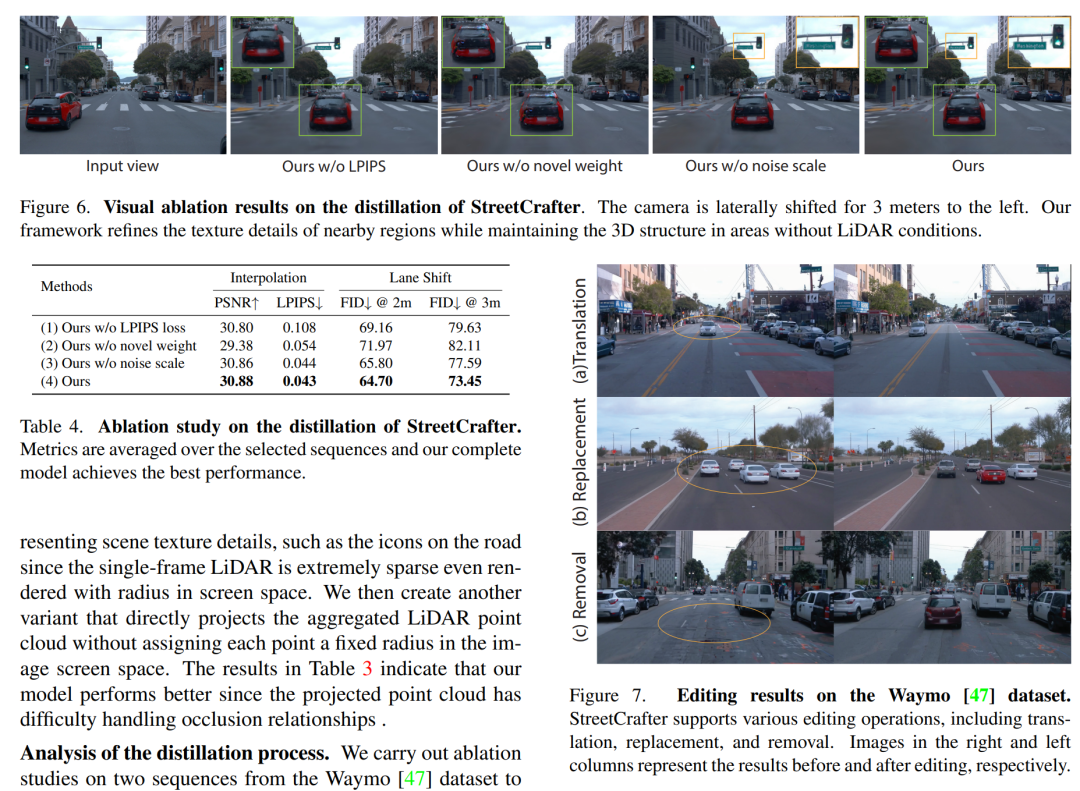

- 探讨了在蒸馏过程中不同的优化策略,如LPIPS损失、新视角权重和噪声规模的影响。

- 场景编辑:

- 展示了StreetCrafter支持的场景编辑操作,包括对象平移、替换和移除。

- 额外实验:

- 提供了更多编辑结果和在不同设置下的比较结果。

- 展示了视角插值结果,并进行了关于LiDAR条件、新视角采样比例和噪声规模的进一步消融研究。

这些实验旨在验证StreetCrafter方法在新颖视角合成、渲染质量和场景编辑方面的性能,并与现有技术进行比较。通过这些实验,论文展示了其方法的有效性和优势。

论文的主要内容:

这篇论文的主要内容包括以下几个方面:

问题定义:

- 论文旨在解决从车载传感器数据进行逼真视角合成的问题,特别是在视点偏离训练轨迹时保持渲染质量的挑战。

方法论:

- 提出了StreetCrafter,一个基于可控视频扩散模型的新颖方法,利用LiDAR点云渲染作为像素级条件,以实现精确的相机控制和新颖视角合成。

- 介绍了如何构建LiDAR条件,以及如何将这些条件整合到视频扩散模型中进行训练和推理。

技术贡献:

- StreetCrafter能够实现像素级的编辑操作,如对象移除和替换,无需针对每个场景进行优化。

- 通过将StreetCrafter蒸馏到动态3DGS(3D Gaussian Splatting)表示,实现了实时高质量的视角合成。

实验评估:

- 在Waymo Open Dataset和PandaSet上进行了广泛的实验,与现有方法进行了比较,验证了StreetCrafter在图像质量、视角外推和实时渲染方面的优势。

- 展示了定性和定量结果,包括PSNR、LPIPS和FID等指标。

消融研究:

- 通过一系列消融实验,分析了StreetCrafter设计选择的影响,包括相机姿态条件、LiDAR条件渲染和蒸馏过程中的优化策略。

场景编辑:

- 展示了StreetCrafter支持的场景编辑操作,包括对象的平移、替换和移除。

结论与未来工作:

- 论文总结了StreetCrafter的主要贡献,并讨论了其局限性和未来可能的研究方向。

总体而言,这篇论文提出了一个创新的方法来处理自动驾驶场景中的视角合成问题,通过结合LiDAR数据和视频扩散模型,实现了高质量的街景合成和场景编辑功能。