DeepSeek发布新论文NSA,OpenAI又开始慌了

DeepSeek发布新论文NSA,OpenAI又开始慌了

这几天,梁文锋参与发表了 DeepSeek 新论文: NSA 注意力机制,又是一个改变AI格局的技术。

今年真是AI大年,DeepSeek接连放大招,要知道从推理模型R1发布(1月20日)到文生图多模态Janus Pro 7B(1月30日),再到这次的NSA技术,一个月之内连续三个王炸级别的产品或技术发布。

用膝盖都能猜到OpenAI开始慌了,马斯克也绷不住站出来高呼Grok-3是最聪明的AI,最焦虑的可能还是英伟达(因为NSA就是减少对GPU性能的依赖),真是非常的精彩。

我理解这次NSA的影响不亚于R1,为什么呢?咱们得先理解NSA是什么,以下是我粗浅的认识。

论文里讲NSA是一种稀疏注意力机制,目的是为了提升大语言模型处理长文本的效率,能用传统大模型不到十分之一的时间去读完一本《红楼梦》这类的长文本。

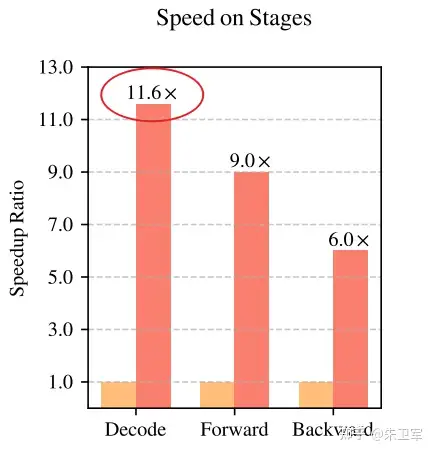

它的特点就是快、非常的快(+1100%),当然准确率和理解能力的也会有小范围的提升(+10%左右)。

NSA采用了三种注意力机制来提升速度,分别是压缩分支、选择分支、滑动窗口,而且对GPU硬件的使用做了优化。

这是啥?是不是一头雾水。先看看下面的流程图,咱们再举案例来形象的解释。

以用读小说为例来理解可能更易懂。

一般来说,我们拿到小说是从头到尾一个字一个字的读,读完了你才知道来龙去脉,传统模型处理长文本也是这样的流程。

而NSA会分三步来读小说,首先是看目录(压缩分支),然后根据需求来精度相关章节(选择分支),最后随时回顾相关的前后几页内容(滑动窗口)。

这样就保证了使用不到十分之一的时间就能掌握整本书,而且由于它能记住最近看的内容,所以细节准确度也会提升。

除了软件外,NSA对GPU硬件也做了优化,传统模型处理长文本需要高性能GPU才能跑,但NSA把计算分解成可并行处理的"流水线工序",让每块显卡都能均衡的工作,这样普通显卡也能跑长文本,就像把一个汽车组装任务,分成了冲压、喷漆、线束等各环节,每个环节工作量都相对饱和但又不过载。

由于这样的GPU优化设置,NSA在处理64k文本时,比传统模型节省高达87%的显存,可以说非常的强了,这就是英伟达会焦虑的原因,大模型越来越依赖算法,而非硬件。

下面再以名侦探柯南破案的案例来解释下NSA的机制。

柯南在一个案件找到了几百个监控视频,但为了好检索信息,它把这些视频按时间线分了类(压缩分支),根据需求去找时间线(选择分支),而不是每个视频一一查看,初步找到嫌疑人后,它聚焦在嫌疑人出现的某个时间线前后三天的视频(选择分支),进一步搜集证据,最终确认凶手身份。

在这个过程中,柯南把任务做了拆解,把案例分成物证组、视频组、外勤组等分头来协作完成(GPU优化),效率大大提升。

这就是NSA提速的过程,确实是很牛的一项技术。

NSA论文下载链接:

https://arxiv.org/pdf/2502.11089