大语言模型-01-语言模型发展历程-03-预训练语言模型到大语言模型

大语言模型-01-语言模型发展历程-03-预训练语言模型到大语言模型

IT从业者张某某

发布于 2025-03-15 22:01:20

发布于 2025-03-15 22:01:20

简介

1.1语言模型发展历程

语言模型发展历程

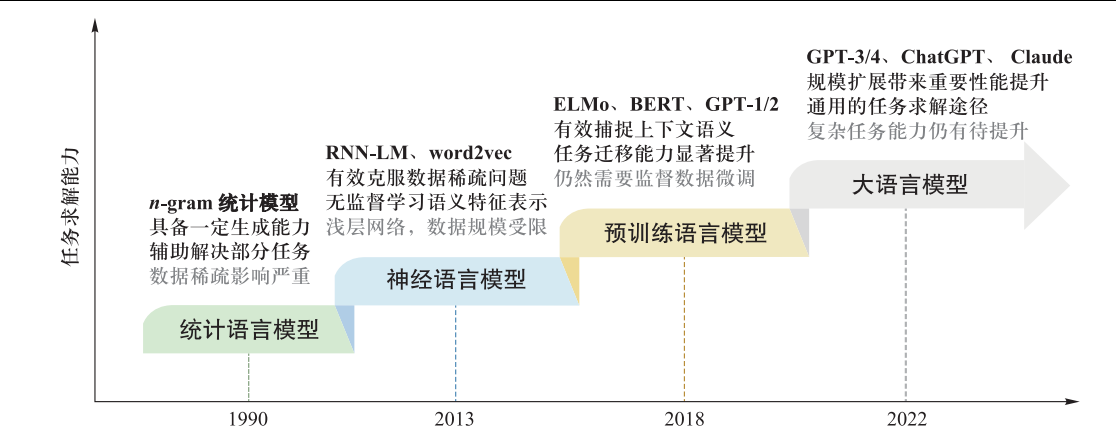

语言模型通常是指能够建模自然语言文本生成概率的模型。 从语言建模到任务求解,这是科学思维的一次重要跃升。 语言模型的发展历程如下:

神经语言模型(Neural Language Models,NLM)

预训练语言模型(Pre-trained Language Model,PLM)

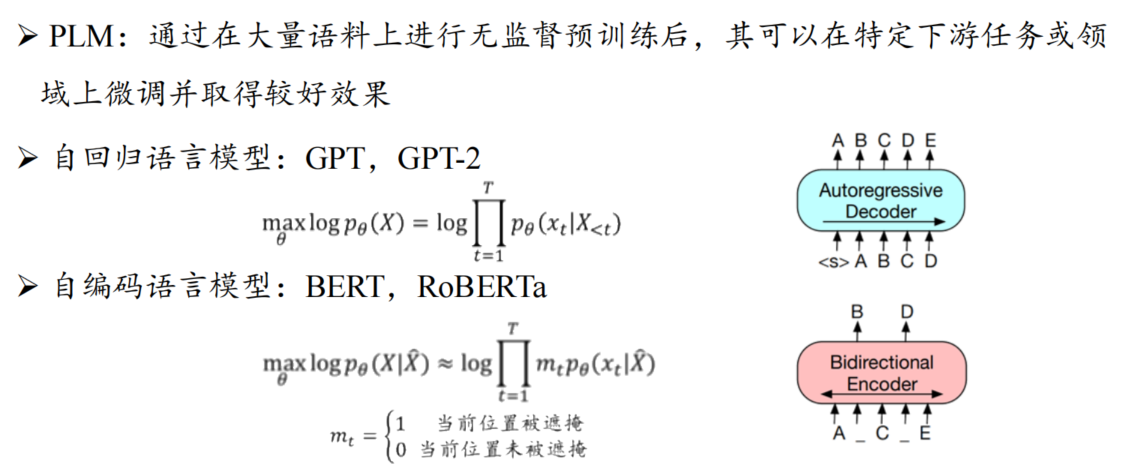

预训练语言模型是一种在大规模文本数据上进行无监督学习得到的语言模型。它通过学习语言的统计规律、语法结构和语义表示,为各种自然语言处理任务提供强大的基础。

PLM 的重要性

提高效率 传统的自然语言处理方法通常需要针对特定任务进行大量的标注数据和复杂的特征工程。而 PLM 可以通过预训练在大规模数据上学习通用的语言表示,然后在特定任务上进行微调,大大减少了对标注数据的需求和任务特定的工程工作量,提高了开发效率。 提升性能 由于在大规模数据上进行了充分的学习,PLM 能够捕捉到丰富的语言知识和语义信息,从而在各种自然语言处理任务上取得更好的性能表现。例如,在文本分类、命名实体识别、机器翻译等任务中,PLM 已经成为了主流的方法,并不断刷新着性能记录。

PLM 的实现方法

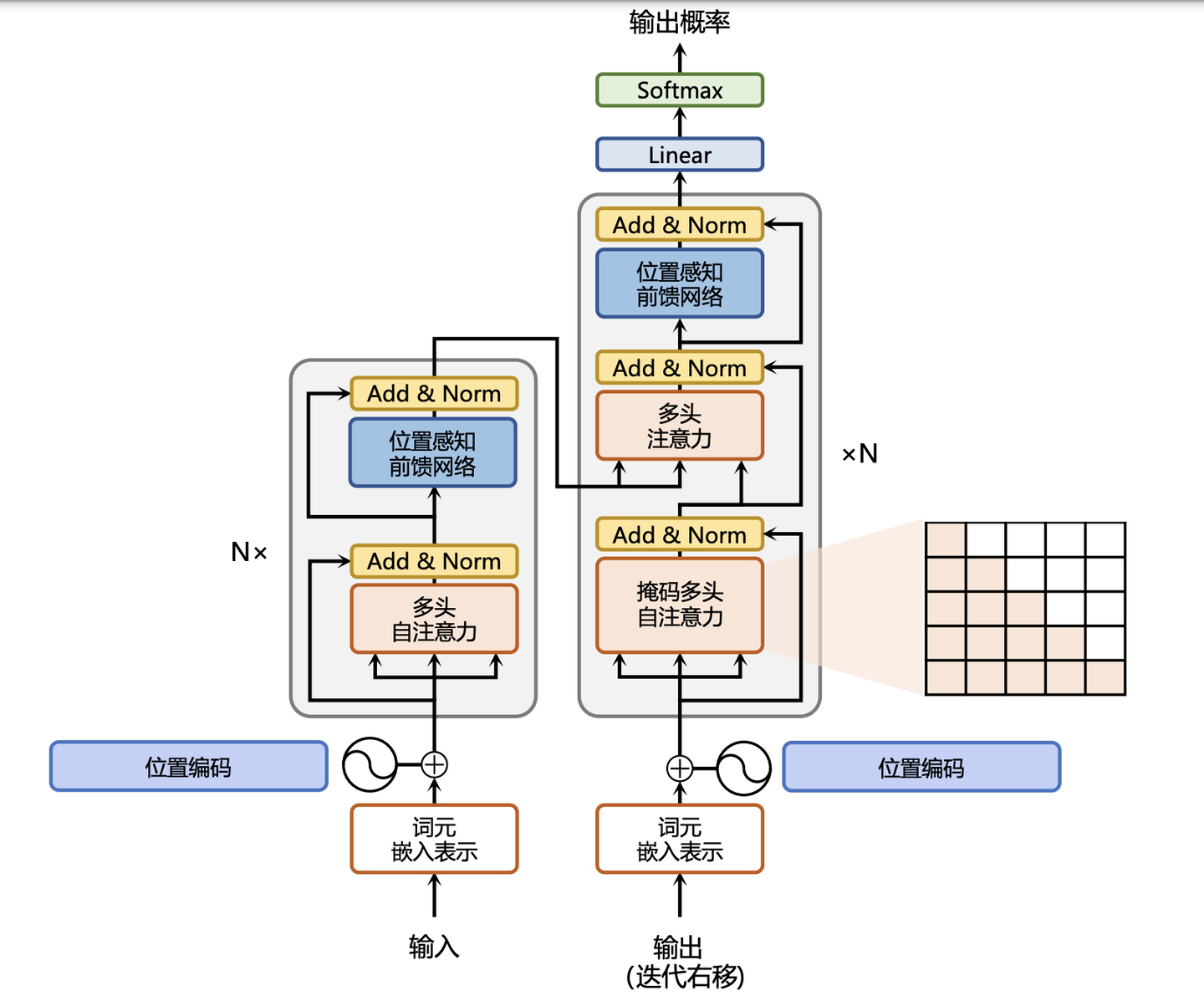

基于 Transformer 架构 目前大多数先进的 PLM 都采用了 Transformer 架构,这是一种基于自注意力机制的神经网络架构。Transformer 能够有效地捕捉长距离依赖关系,并且具有并行计算的优势,非常适合处理自然语言这种序列数据。

预训练任务

常见的预训练任务包括语言模型(Language Modeling)、掩码语言模型(Masked Language Modeling)、下一句预测(Next Sentence Prediction)等。 语言模型任务是根据给定的上文预测下一个单词,通过这种方式,模型可以学习到语言的统计规律和语义表示。 掩码语言模型任务是随机掩盖输入文本中的一些单词,然后让模型预测被掩盖的单词,这可以帮助模型更好地理解上下文信息。 下一句预测任务是判断两个句子是否在原文中是连续的,这可以帮助模型学习到句子之间的关系。

大规模数据和计算资源

训练一个有效的 PLM 需要大量的文本数据和强大的计算资源。通常会使用互联网上的大规模文本数据集,如维基百科、新闻文章、小说等。同时,需要使用高性能的 GPU 服务器或分布式计算平台来加速训练过程。

传统语言模型存在局限性,需要使用特殊的技术进行模型能力提升

➢ 缺乏背景知识。需要知识图谱等外部知识源补充 ➢ 任务泛化性较差。 需要针对特定任务进行微调,适配成本较高 ➢ 复杂推理能力较弱。通常需要对于结构进行修改,或者进行大规模微调 尽管早期研究工作较多,但是没有工作能够通过统一途径同时解决上述代表性挑战

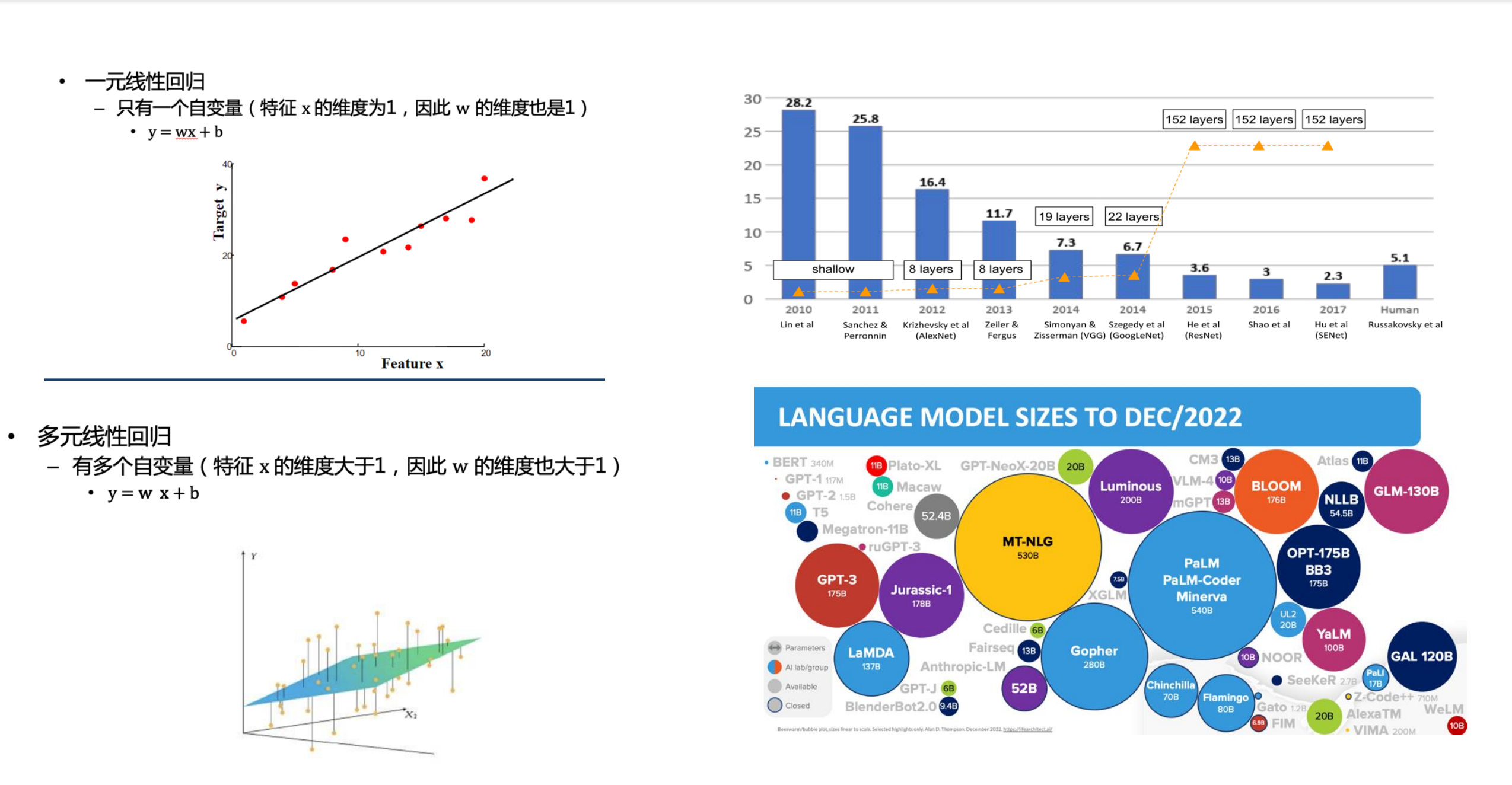

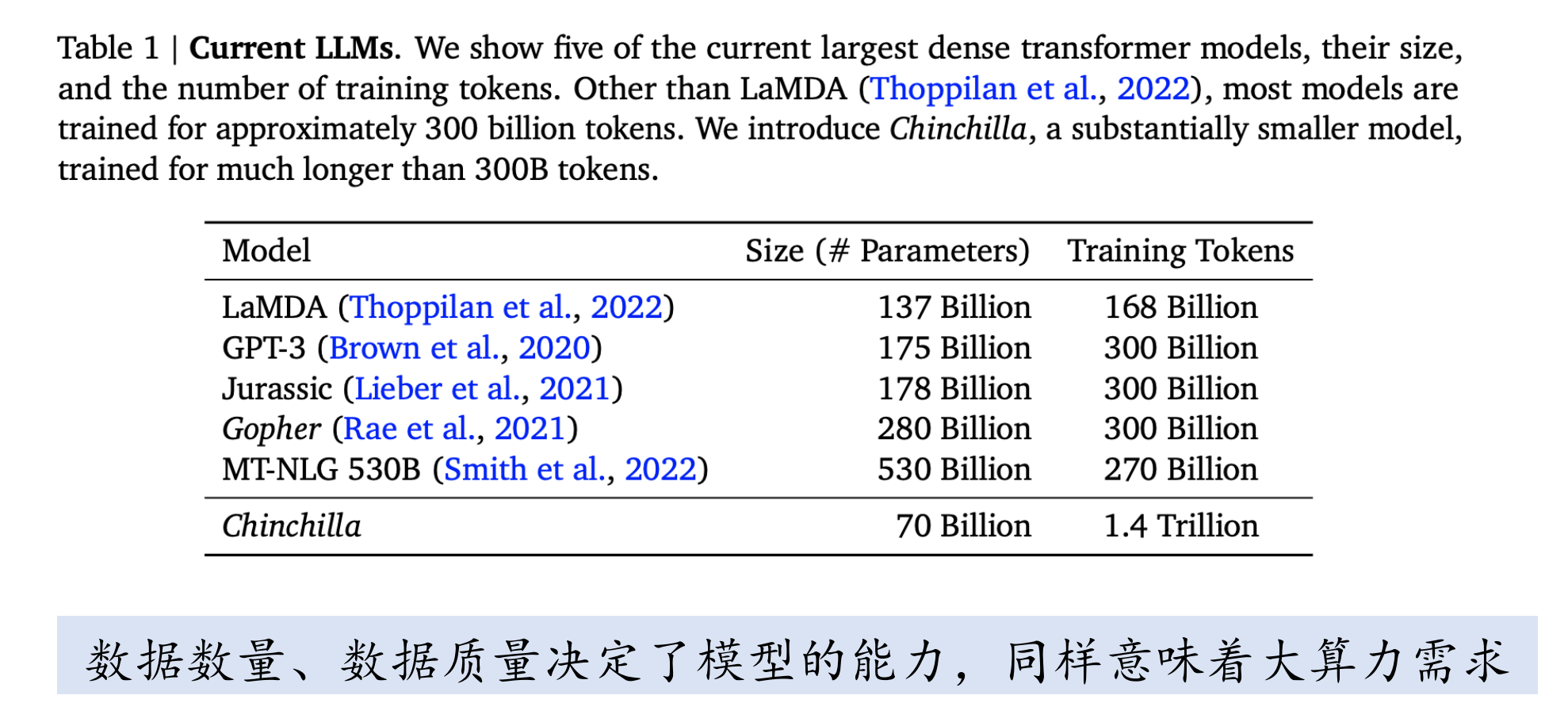

大语言模型的到来

海量无标注文本数据预训练得到的大型预训练语言模型

通常指参数规模达到百亿、千亿甚至万亿的模型 经过大规模数据预训练的数十亿参数的高性能模型也可以称为大语言模型

与传统语言模型构建的差异

极大地扩展了模型参数和数据数量 需要更为复杂、精细的模型训练方法

模型需要能够学习更多的数据知识

本文参与 腾讯云自媒体同步曝光计划,分享自作者个人站点/博客。

原始发表:2025-03-12,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读

目录