惠普实验室:大规模III-V/Si异质集成光子器件平台助力下一代光计算(二)

惠普实验室:大规模III-V/Si异质集成光子器件平台助力下一代光计算(二)

四、基于 III-V on Si平台 的光神经网络

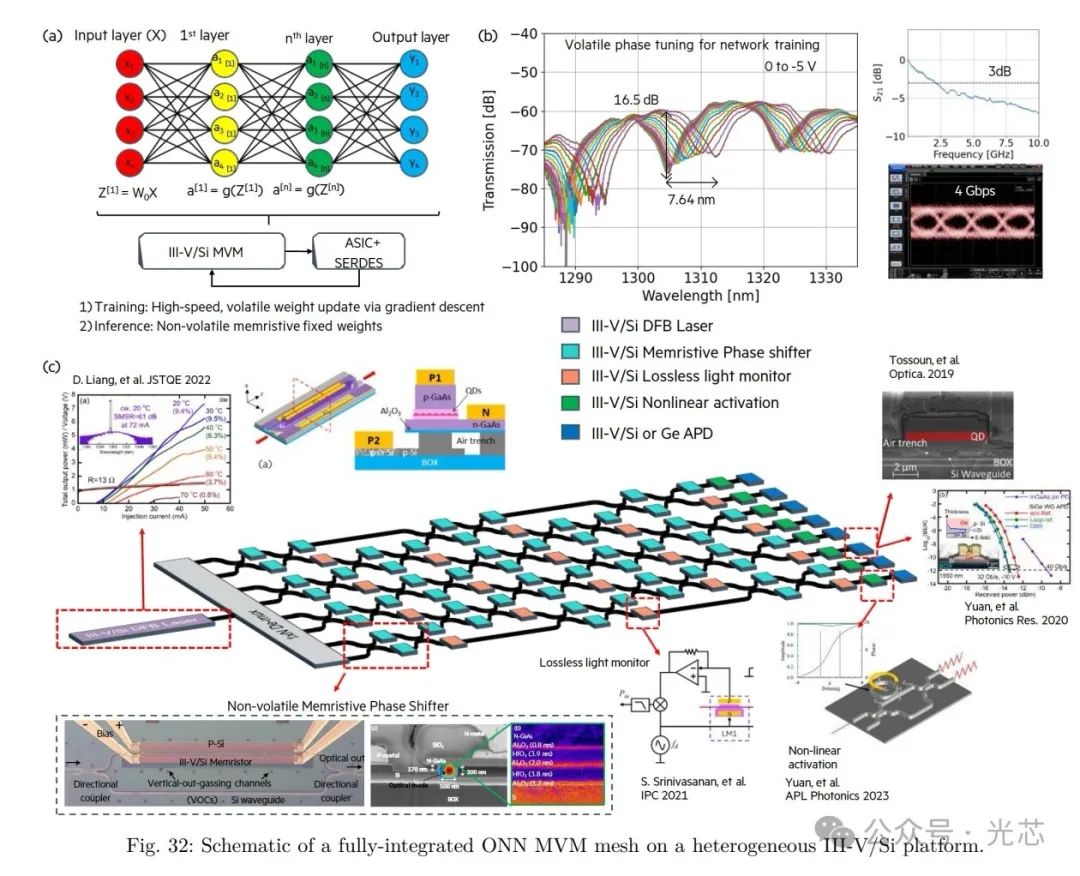

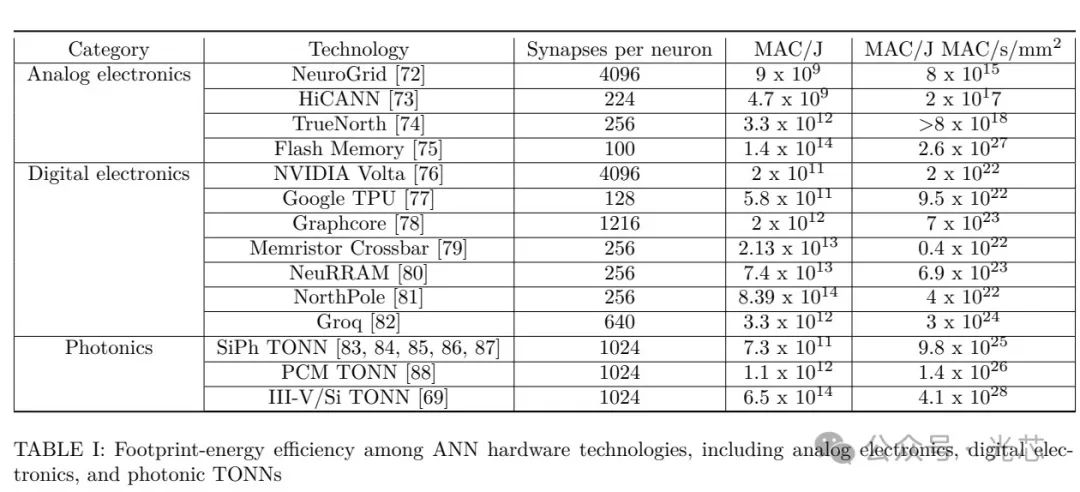

在人工智能和机器学习快速发展的背景下,构建高效的光子集成电路对于提升计算性能至关重要。传统的电子计算架构在处理大规模 AI 任务时面临着诸多挑战,如能耗高、计算速度受限等,而光子集成电路凭借其独特的优势成为解决这些问题的关键研究方向。 (一)张量化光神经网络(TONN) TONN 的出现源于对 AI 计算效率的追求,模型压缩技术中的修剪方法为其提供了灵感。在传统的光神经网络中,随着模型规模的扩大,计算资源的消耗呈指数级增长,严重限制了其应用范围。

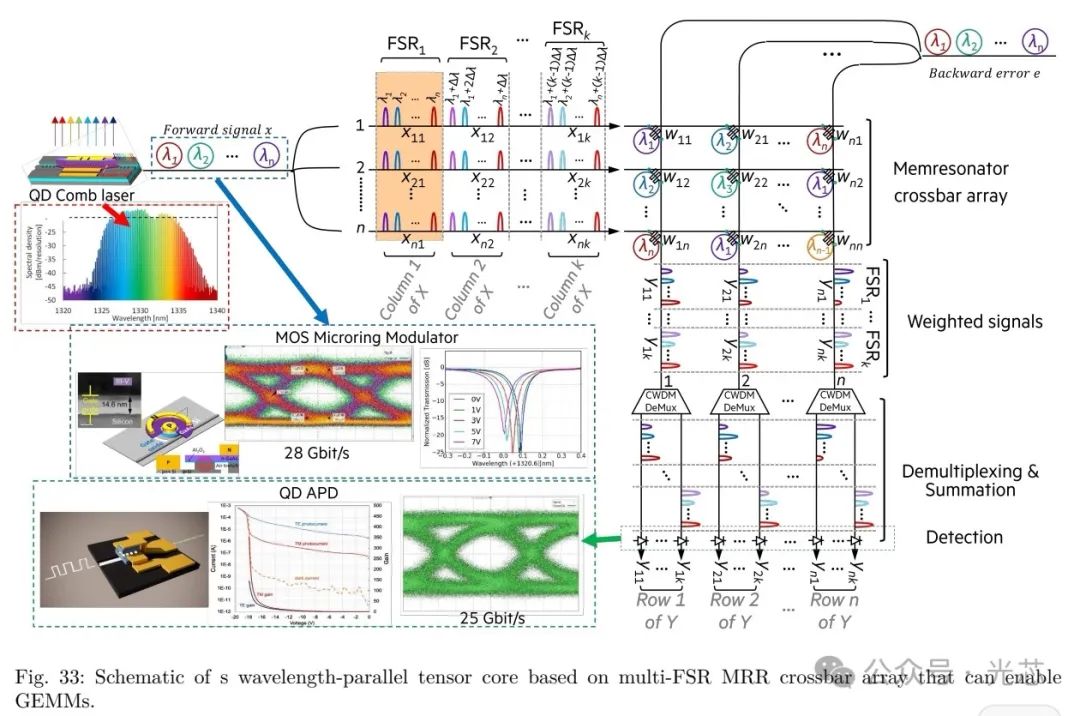

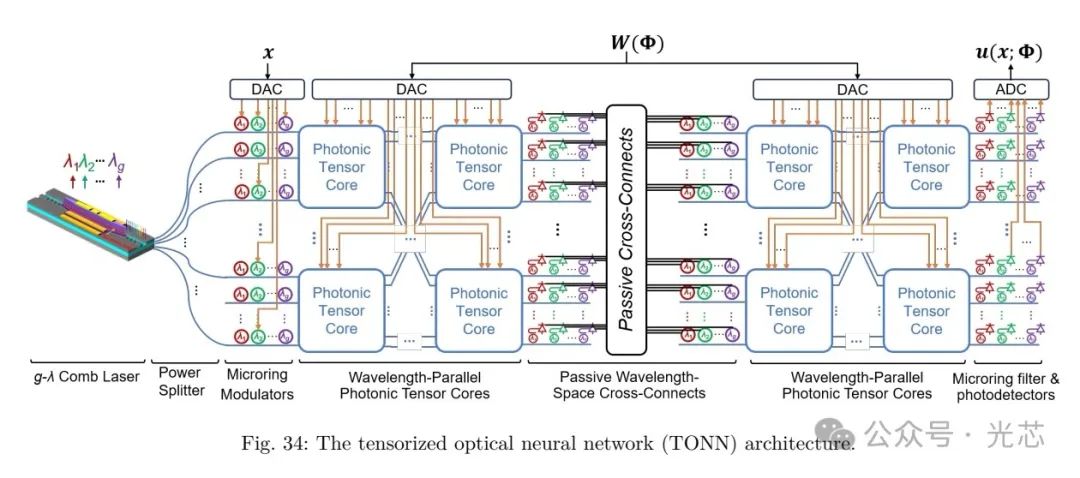

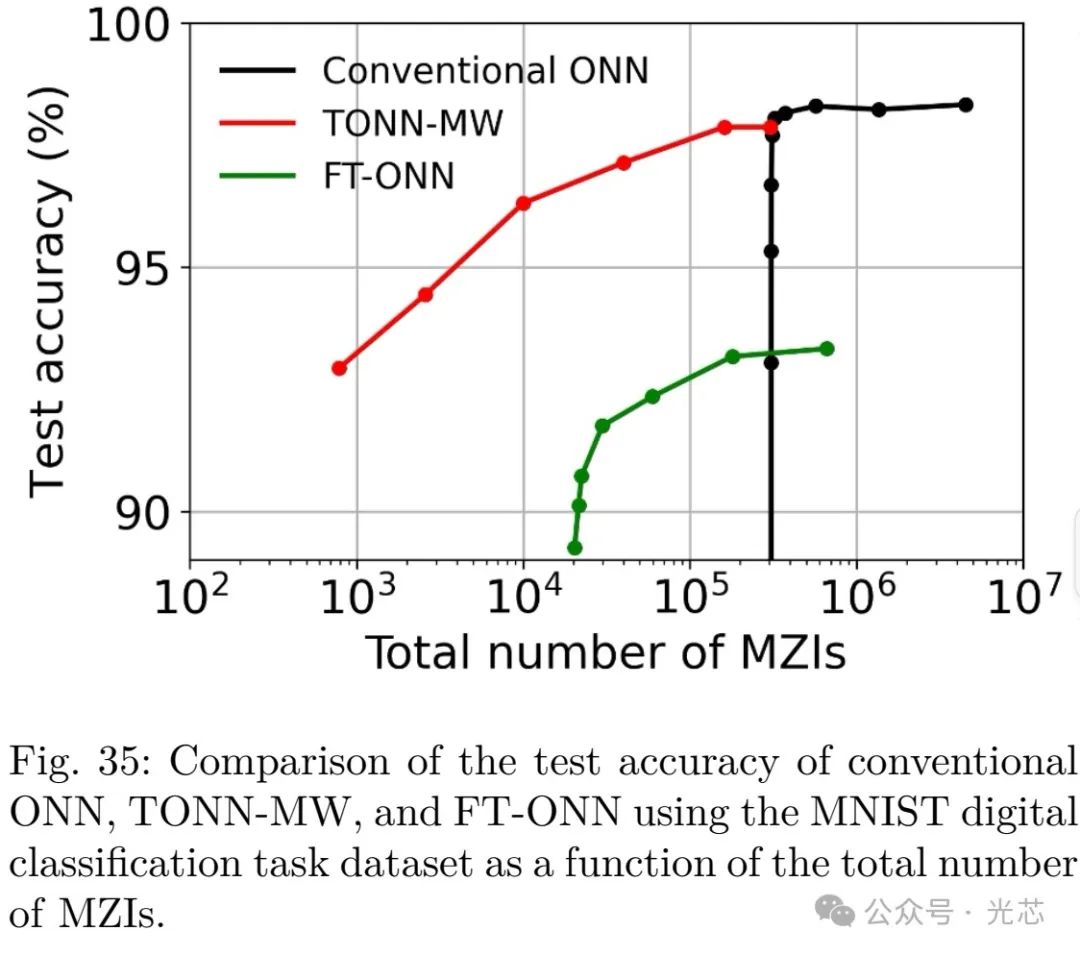

TONN 通过利用 TT 分解技术,巧妙地压缩了 ONNs 中相对不重要的参数,从而在保持较高计算精度的同时,大幅减少了计算资源的需求。在实现过程中,它在波长和空间域模拟张量积,创新性地采用多自由光谱范围(multi-FSRs)MRR 交叉阵列或宽带 MZI 网格作为光子张量核。这种架构设计充分利用了光的并行处理能力,通过波长分复用(WDM)技术增加波长并行性,进一步提高了计算效率。在 MNIST 数字分类任务这一经典的测试场景中,TONN 展现出了卓越的性能优势。相比传统 ONNs,它能够减少 79 倍的 MZIs 和 5.2 倍的级联阶数,却依然实现了>95%的准确率。在面积-能量效率方面,其((MAC/J)·(MAC/s/mm²))相比其他光子平台(PCM 和硅光子学)提高了 2.9×10²倍,相比最先进的数字电子设备也提高了 1.4×10²倍,为光子神经网络在实际应用中的可行性和优势提供了有力的证据。然而,TONN 的结构较为复杂,对光电器件的性能和一致性要求极高,在大规模制造过程中,难以保证每个器件都能达到理想的性能指标,从而可能影响整体网络的性能稳定性。此外,目前的 TT 分解算法在处理某些复杂的神经网络结构时,可能无法达到最优的压缩效果,导致计算资源的浪费仍然存在。

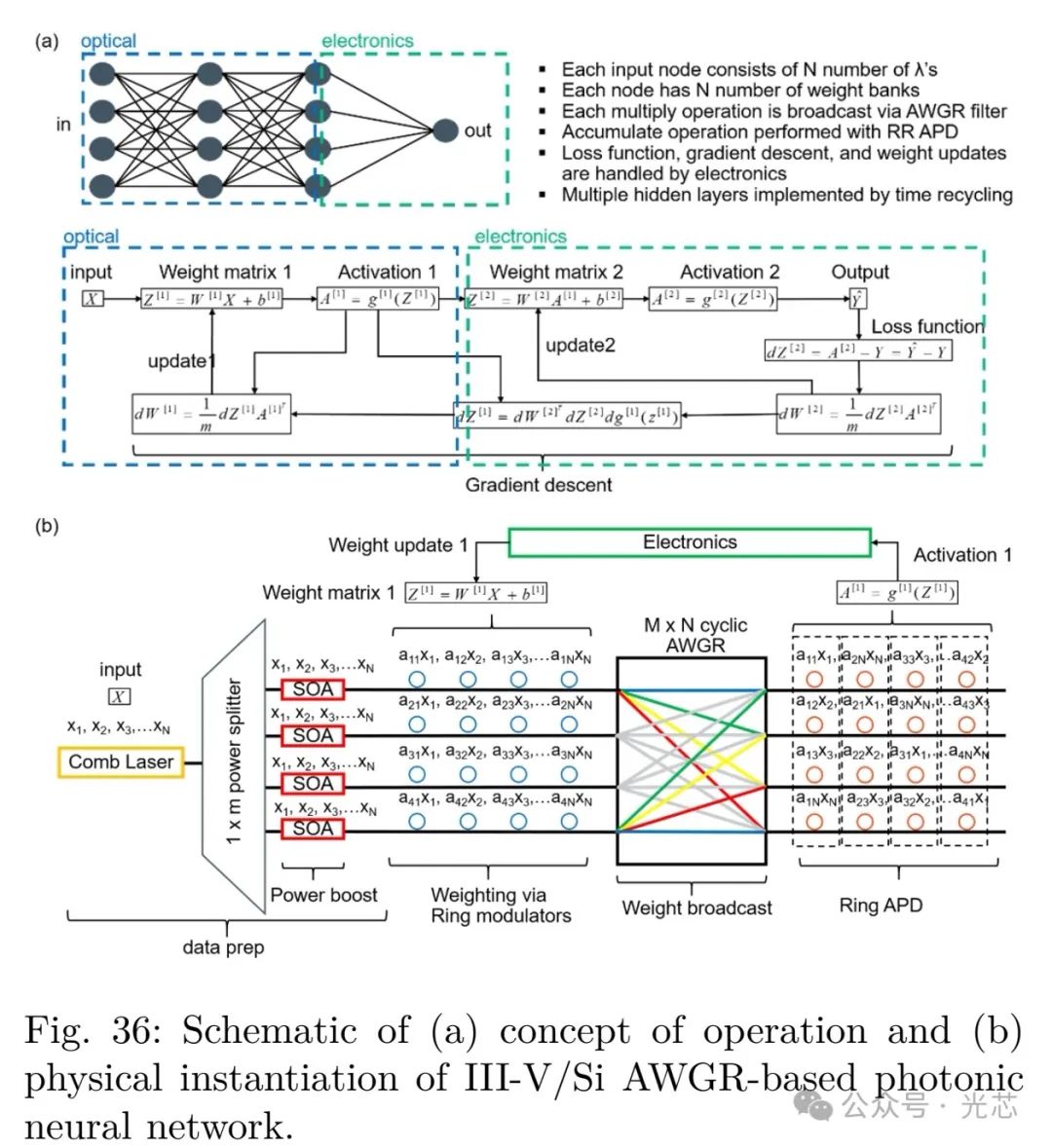

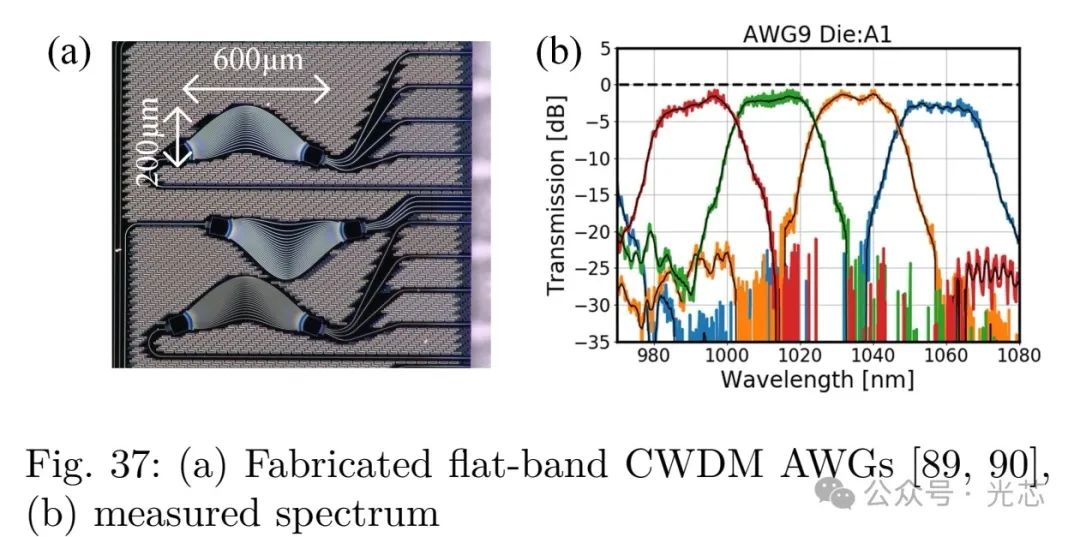

(二)基于 AWGR 的神经网络

基于阵列波导光栅路由器(AWGR)构建的神经网络为光计算提供了另一种有效的架构思路。在传统的光计算架构中,权重的实现和信号的传输往往存在效率低下和能耗高的问题。

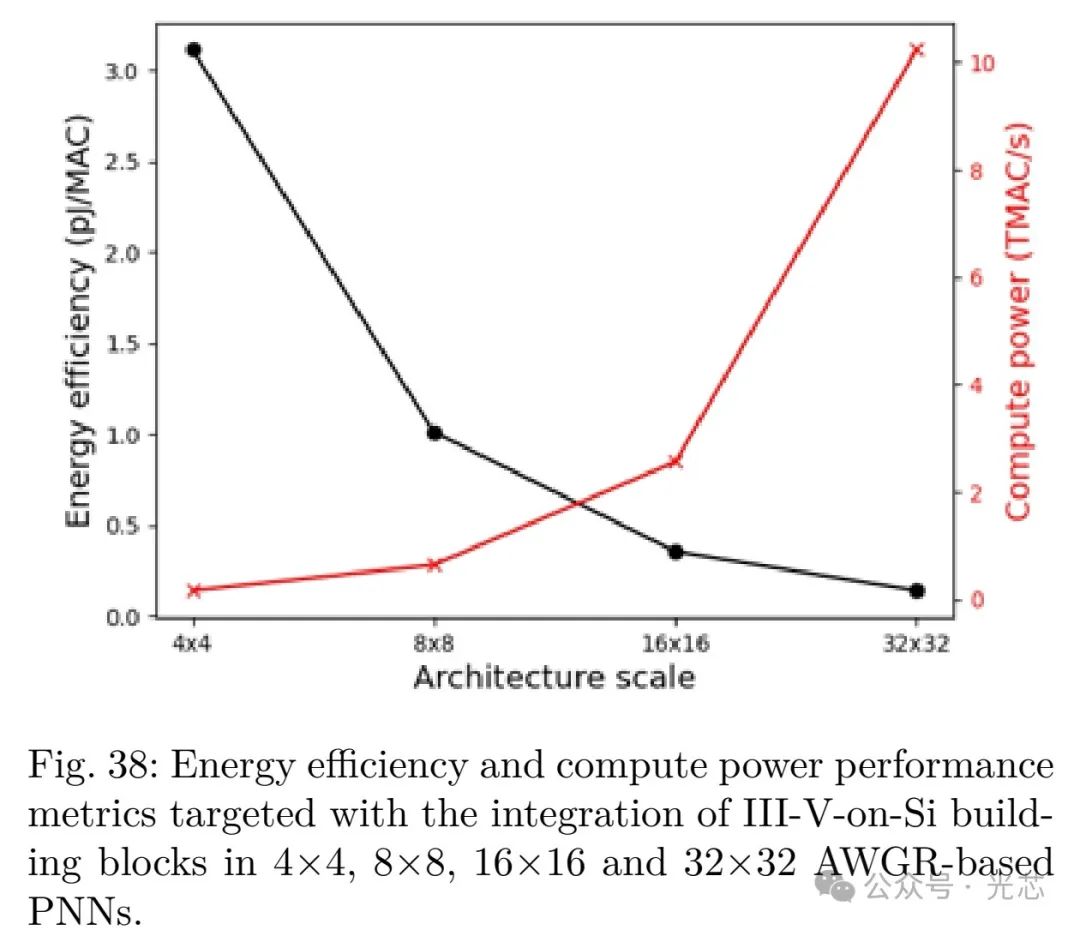

在这种架构中,从单个梳状源的功率分配开始,利用 Booster SOAs 补偿功率分配过程中产生的固有损耗,确保了信号的强度和质量。通过环调制器实现权重的精确控制,将权重广播到环 APDs 进行激活和检测,随后电子设备进行求和、损失函数计算、微分和最终激活等一系列操作,并及时更新环调制器权重,实现了神经网络的高效运行。通过时间复用技术,能够有效地实现多个隐藏层,极大地扩展了网络的深度和复杂度。结合高速低能耗忆阻光子器件,该架构在能量效率方面表现出色,计算能力也得到了显著提升。

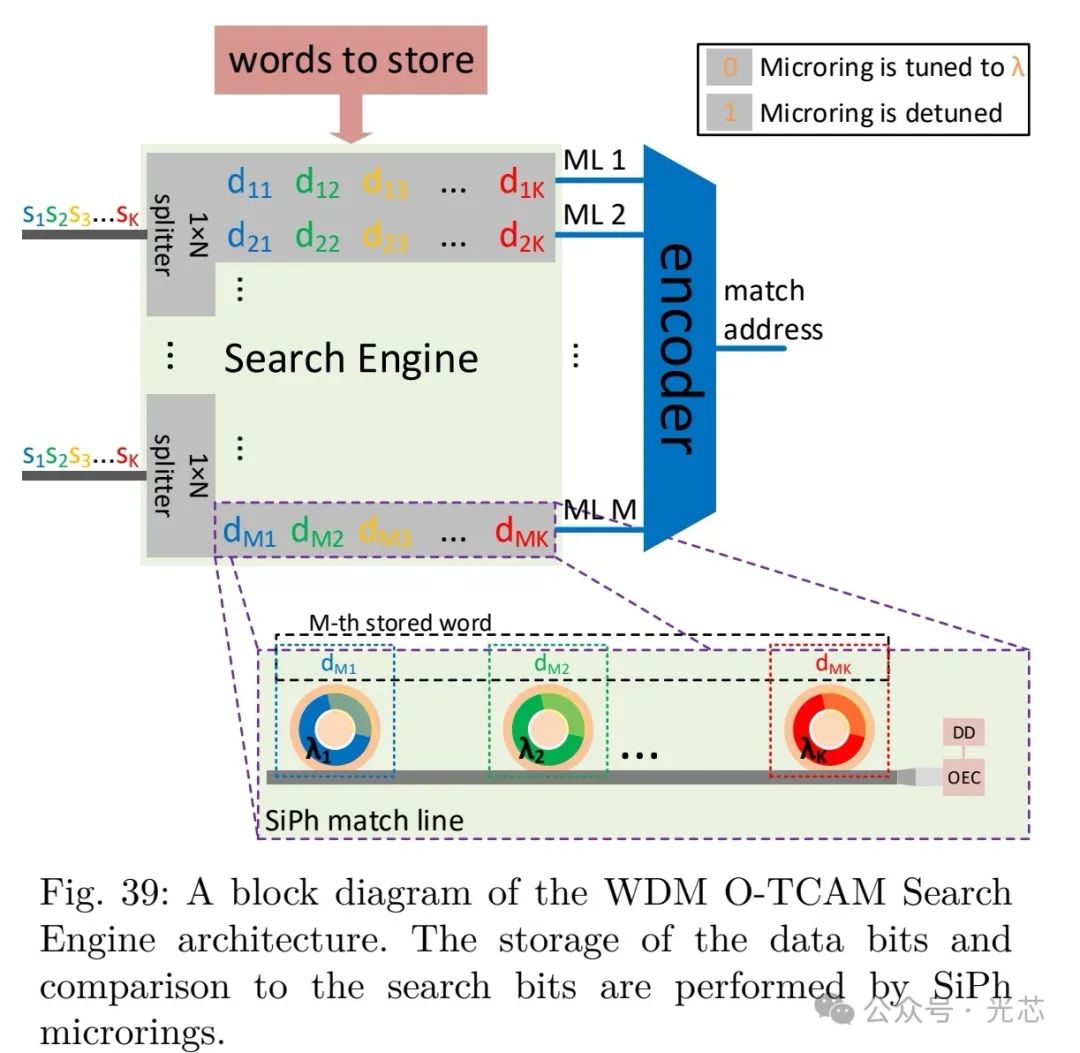

在实际测试中,当系统在 10GHz 下运行时,4×4 至 32×32 的 AWGR 基光子张量核能量效率可达 3.2pJ/MAC,通过进一步优化架构和器件性能,有望实现 0.14pJ/MAC 和 10.24TMAC/s 的卓越性能。但该架构在信号传输过程中存在一定的串扰问题,随着网络规模的扩大,不同波长信号之间的干扰可能会影响计算的准确性。而且,AWGR 的制造工艺复杂,对精度要求极高,成本也相对较高,限制了其大规模推广应用。 (三)WDM可寻址存储器(O-TCAM)

可寻址存储器(CAM)在现代计算机系统中具有重要地位,尤其是在机器学习和深度学习领域,其快速搜索和匹配能力能够显著提高数据处理效率。传统的电子 CAM 在能耗和速度方面面临着瓶颈,促使科研人员探索基于光子技术的解决方案。

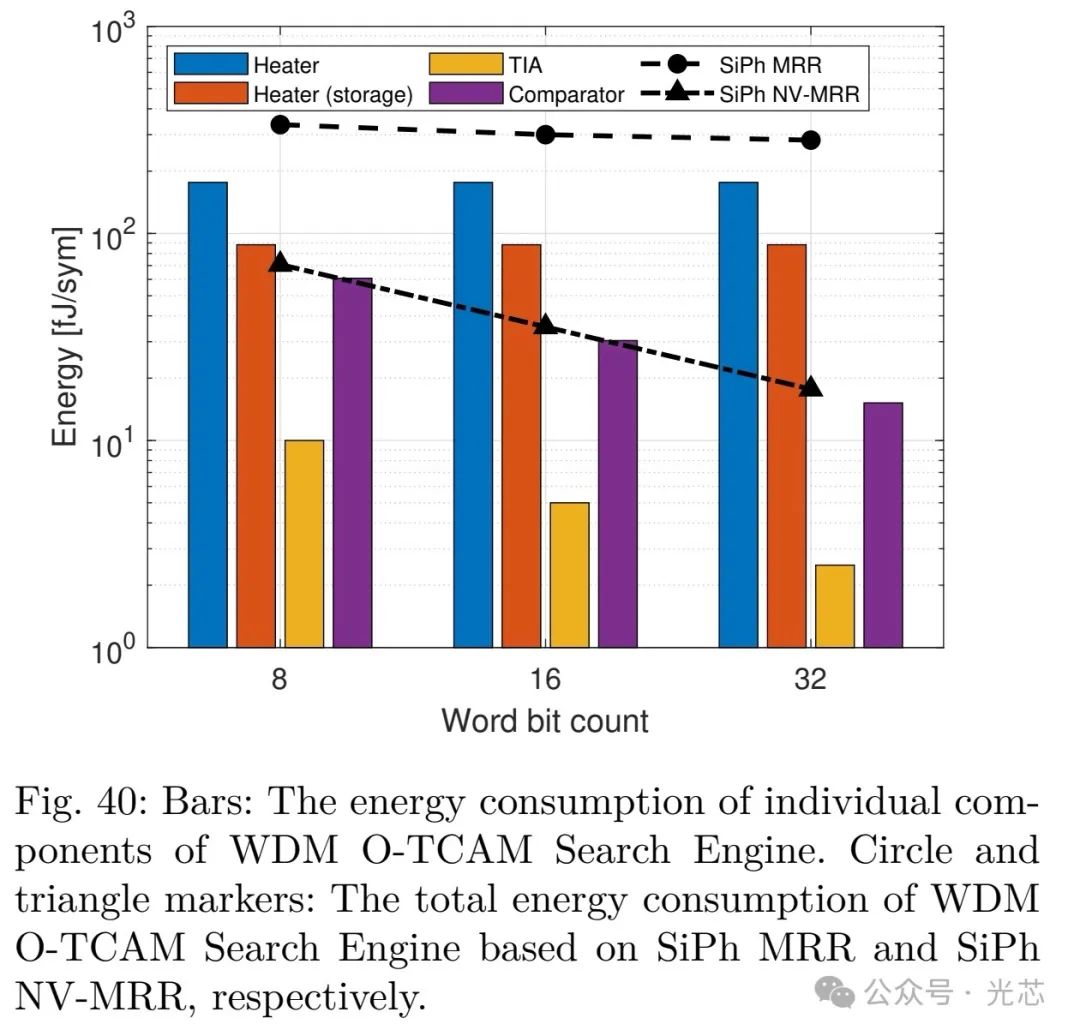

本文开发的 WDM 和 TDM 两种光学三元 CAM(O-TCAM)架构为解决这一问题提供了新的途径。在 WDM O-TCAM 中,利用硅光子非易失性微环谐振器(NV-MRRs)存储数据是一项关键创新。与传统的 SiPh 微环谐振器(MRRs)相比,NV-MRRs 显著降低了能量消耗。这是因为在传统 MRRs 中,用于后制造调谐和数据存储的加热器消耗了大量的能量,而 NV-MRRs 避免了这一问题。通过扩展位运算点积编码方案,成功实现了搜索和数据字的矩阵 - 矩阵乘法,满足了光计算中对数据处理的需求。在详细的能量分析中发现,随着字长的增加,TIA 和比较器的能量贡献逐渐降低,进一步凸显了 NV-MRRs 的优势。实验结果有力地证明了新平台在降低 O-TCAM 搜索引擎总能耗方面的有效性,并且该架构能够在信号数据率下运行,避免了光电转换和数据率下转换过程中产生的延迟和能耗,有效解决了当前存在的延迟瓶颈问题。但 WDM O-TCAM 架构的存储容量相对有限,在处理大规模数据存储时可能需要大量的硬件资源,且其编码和解码过程较为复杂,对控制系统的要求较高,增加了系统的设计和实现难度。

五、讨论与挑战

III-V/SOI 平台在光子计算领域展现出诸多优势,但大规模 PICs 的发展仍面临着热管理和可扩展性这两大关键挑战,这两者对系统性能、稳定性及未来应用拓展有着深远影响。

在热管理方面,III-V/Si 激光器在芯片上工作时产生的热量散热困难,这主要归因于 SOI 衬底中的低折射率埋氧(BOX)层。该 BOX 层虽对低损耗波导的形成至关重要,但其低热导率严重阻碍了器件层热量向硅衬底的散发,致使热量积聚,影响激光器性能及系统稳定性。例如,在实际测试中,若长时间运行激光器而不采取有效散热措施,会导致激光波长漂移、输出功率不稳定等问题,进而影响整个光计算系统的准确性和可靠性。

微环激光器虽因其低功耗和小尺寸在大规模集成光子计算电路中极具潜力,但紧凑设计使其具有较大阻抗,进一步增加了热管理的复杂性。为应对此问题,所设计的热分流器发挥了关键作用。通过在激光结构中添加金属热分流器,可有效引导热量穿过 BOX 层传导至硅衬底。模拟结果显示,这种设计能实现高达 4 倍的加热减少,热阻抗提升 30% - 40%,最大连续波激光温度提高超 35°C,显著改善了热性能,为微环激光器在大规模集成中的稳定应用提供了有力支持。

此外,热管理还涉及到移相器的选择。传统的热光移相器在调节光信号相位时会产生大量热量,随着电路规模扩大,散热问题愈发突出。相比之下,无热移相器如 MOSCAP 基和非挥发性移相器优势明显。它们在工作过程中产生的热量极少,能有效减少散热负担,同时其光学插入损耗也较低,有利于提高系统的整体性能和集成度。例如,在构建高密度光子集成电路时,采用无热移相器可使器件布局更加紧凑,减少因散热问题导致的器件间隔增大,从而提高芯片的集成密度和性能。

在可扩展性方面,随着 AI 模型规模呈指数级增长,对光子神经形态计算芯片的计算能力和存储容量提出了更高要求。当前的光子神经形态计算芯片在芯片上仅能容纳 3 层神经网络,这主要受限于电路面积和信号传输损耗。在网络层间,虽通过电光调制器实现了片上非线性激活函数,但随着层数增加,电路复杂度急剧上升,信号损耗累积严重,使得进一步扩展电路面临巨大挑战。

为提升可扩展性,可充分利用平台上的 SOAs 和激光器。它们不仅可作为非线性激活函数,增强光信号处理能力,还能补偿电路中的损耗,确保信号在多层网络中的有效传输。例如,在实验中,通过引入 SOAs 对光信号进行放大和非线性处理,成功实现了在一定程度上增加神经网络层数,且保持了较好的计算精度和信号质量。

器件的寿命和可靠性是影响系统长期稳定运行的重要因素,其与制造工艺和材料质量紧密相关。以MOSCAP移相器为例,为实现低泄漏电流,需要高质量的氧化物材料作为栅极氧化物。在大规模生产中,若材料质量控制不佳或制造工艺出现偏差,会导致移相器性能下降,如泄漏电流增加、调谐效率降低等问题,进而影响整个光子计算系统的性能和可靠性。

此外,器件性能的均匀性和可变性也是大规模光子计算电路面临的挑战之一。在同一芯片上,不同器件的性能可能存在差异,这会影响神经网络的计算精度和稳定性。为解决此问题,硬件感知训练是一种有效的方法。通过在训练过程中对不同器件的性能差异进行评估和补偿,可调整权重值,使神经网络在存在器件性能差异的情况下仍能保持较高的准确性,且无需增加额外的硬件复杂性。例如,在一些实验中,采用硬件感知训练算法后,系统对器件性能差异的容忍度显著提高,在一定程度上缓解了因器件性能不均匀带来的问题。

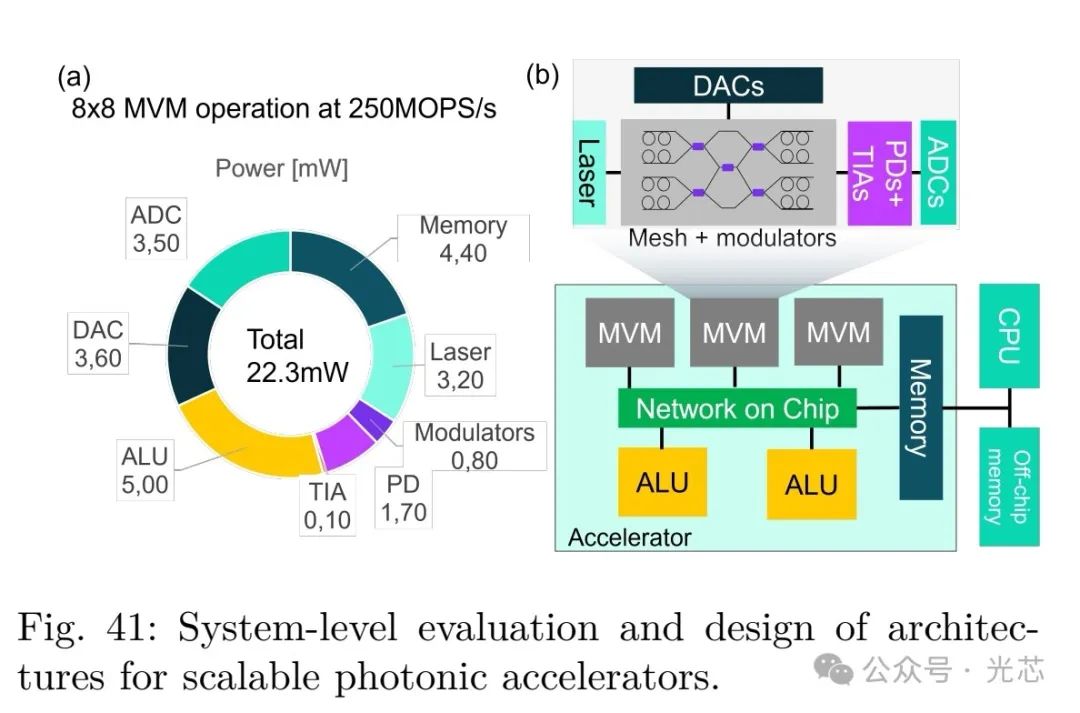

系统级设计是实现全光子 AI 加速器的关键环节。虽然光子组件在处理 AI 工作负载的某些方面具有优势,但在数据存储和检索等功能上,在光域中实现仍面临诸多困难。因此,光子 AI 加速器更可能采用与数字电子设备混合集成的架构。然而,目前这种混合系统的协同设计尚处于探索阶段,存在诸多亟待解决的问题。

其中,光学和电子组件之间的带宽不匹配是一个突出问题。光信号具有高带宽的优势,但在与电子组件交互时,由于电子器件的带宽限制,可能导致数据传输瓶颈,影响系统整体性能。例如,在高速数据传输过程中,电子器件可能无法及时处理光信号转换后的电信号,造成数据积压和延迟。

E/O 转换的能量开销也是一个重要挑战。光电和电光转换过程中会消耗大量能量,降低了系统的能源效率。在大规模计算中,频繁的 E/O 转换会使能耗显著增加,限制了光子 AI 加速器的应用场景和性能提升。

为应对这些系统级设计挑战,开发的系统级模拟器具有重要意义。该模拟器能够对加速器内部的所有组件,包括 PIC、内存和 E/O 转换器等的计算速度和能耗进行精确建模。在模拟过程中,通过在每个模拟时钟周期评估组件性能模型,可深入分析系统的运行状态和性能瓶颈。例如,在对某一特定 AI 工作负载的模拟中,发现数字域中的非线性激活函数消耗了约 22%的总功率,而光子组件在 PIC 中仅占总功耗的 25%,这为优化系统架构提供了明确的方向,凸显了采用全光激活函数的节能潜力。

此外,多核和多芯片方法为提升光子 AI 加速器的可扩展性提供了有效途径。通过在一个加速器系统中并行操作多个光子张量核,如采用多chiplet 方法,可显著提高计算能力。利用系统级模拟器框架,可对不同规模和架构的多核系统进行设计和评估,优化芯片间通信和资源分配,以实现更高的性能和可扩展性。例如,在一些模拟实验中,采用多核架构后,系统的计算吞吐量得到了大幅提升,证明了这种方法的可行性和有效性。

六、总结与展望

本文所展示的异质 III-V-on-硅光子器件平台在下一代光子 AI 加速器领域取得了创新性的突破。通过将多种高性能有源和无源器件成功集成在硅基平台上,在构建 TONN 加速器方面展现出卓越的性能优势。

在面积 - 能量效率方面,相比现有的其他光子平台(如 PCM 和传统硅光子学)以及最先进的数字电子设备,该平台实现了显著提升。这主要得益于其独特的器件设计和集成工艺,例如在光源、光子突触权重、非线性激活函数等关键器件的创新上。量子点梳状激光器提供了高效的多波长光源,异质 MOS - 电容移相器大幅提高了突触权重的调谐效率,全光和光电非线性激活函数增强了神经网络的计算能力,这些创新共同作用,使得 TONN 加速器在处理 AI 任务时能够以更低的能耗和更小的芯片面积实现更高的计算性能。

这种高性能的光子 AI 加速器在未来的计算领域具有广阔的应用前景。在边缘计算方面,其低能耗和高计算效率的特点使其能够满足边缘设备对 AI 计算能力的需求,同时降低设备的能耗和散热要求,延长设备的续航时间和使用寿命。例如,在智能物联网设备、移动终端等边缘场景中,可实现实时的图像识别、语音处理等 AI 任务,为用户提供更加智能和便捷的服务。

在数据中心应用中,可有效处理大规模的数据和复杂的 AI 模型,加速深度学习任务的训练和推理过程,提高数据中心的计算效率和资源利用率。例如,在大规模图像分类、自然语言处理等任务中,能够显著缩短处理时间,提升系统的响应速度,满足日益增长的数据处理需求。

尽管该平台已经取得了显著的进展,但要实现大规模的应用和商业推广,仍面临着诸多挑战。在技术层面,如前文所述,热管理、可扩展性、器件可靠性等问题需要进一步深入研究和解决。在制造工艺方面,需要不断优化和完善,提高器件的一致性和稳定性,降低生产成本。在系统集成方面,需要加强光子组件与数字电子设备的协同设计,解决带宽不匹配、能量开销等问题,提高混合系统的整体性能。

未来的研究工作将围绕这些挑战展开。在热管理方面,继续探索新的散热材料和结构,提高散热效率,降低热阻,确保器件在高温环境下的稳定运行。在可扩展性方面,研究新的电路架构和算法,进一步提高光子神经网络的层数和规模,提升计算能力。在器件可靠性方面,深入研究材料和工艺对器件寿命的影响,开发新的可靠性测试方法和标准,提高器件的可靠性和稳定性。在系统集成方面,加强跨学科合作,融合光子学、电子学和计算机科学等领域的技术,优化混合系统的设计和性能。

总之,异质 III-V-on-硅光子器件平台为 AI 硬件的发展开辟了新的路径,虽然目前还存在一些挑战,但随着研究的不断深入和技术的不断进步,有望在未来的人工智能和高性能计算领域发挥更加重要的作用,推动计算技术的革命性发展。