HotChips 2025深度解析(二):CPU破摩尔定律困局,图形渲染迈入AI驱动时代

HotChips 2025深度解析(二):CPU破摩尔定律困局,图形渲染迈入AI驱动时代

光芯

发布于 2025-09-11 14:25:09

发布于 2025-09-11 14:25:09

本文来自于youtube博主“最佳拍档”的硬核解说(视频链接:https://youtu.be/fgoQYlLT_IY?si=lEgESWSKvmaATEyY),视频很长但也讲解得超级棒,大家可以看下原视频,总共有一个小时的时间,这里将作者的原稿拆解成三篇来写,分别涵盖:

①AI计算领域 + 网络领域 + 光I/O领域

② CPU领域 + 图形领域

③ 安全领域 + 散热领域

第一篇链接:HotChips 2025深度解析(一):AI计算突破“数据传不动”瓶颈,网络与光I/O成关键支撑

五、CPU 领域:摩尔定律触顶下的 “多技术融合”

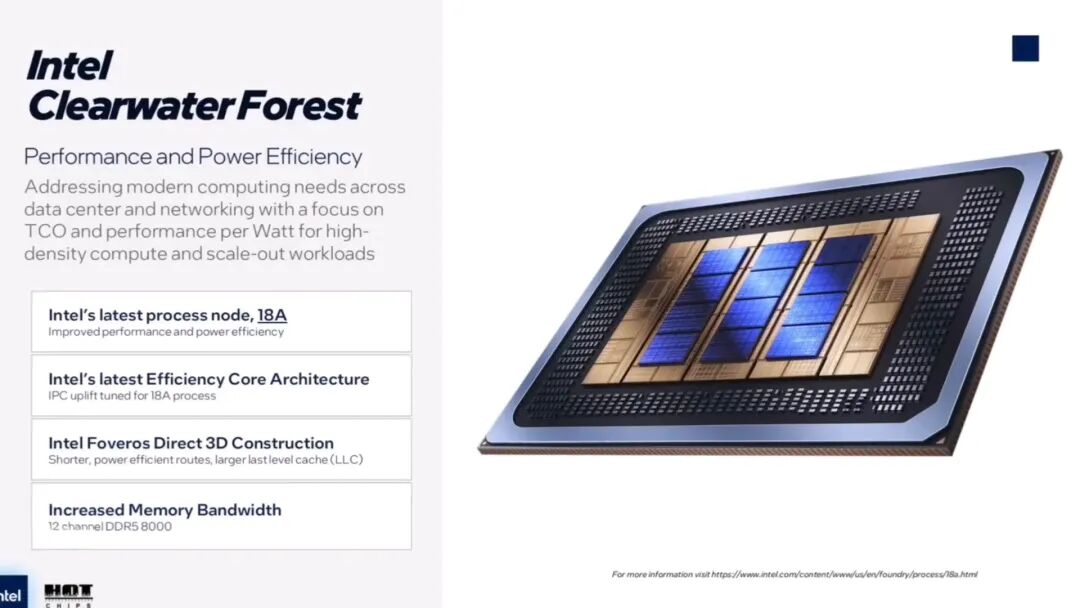

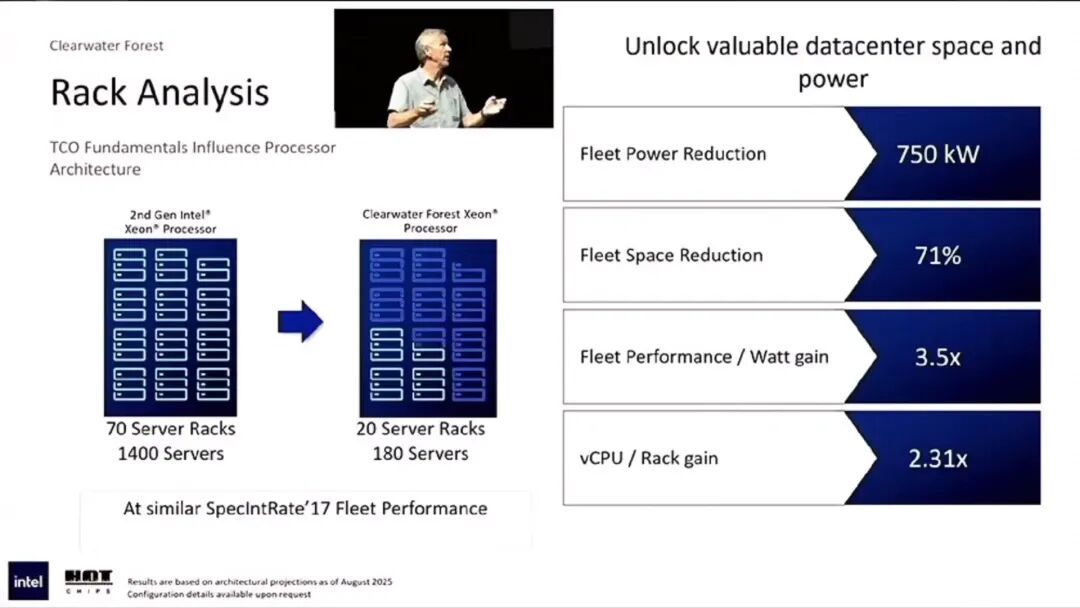

1. 英特尔 Clearwater Forest

- 规格与工艺:288 核处理器,采用 Intel 18A 制程与 3D 封装技术,核心思路是 “3D 堆叠提升缓存和内存带宽”。

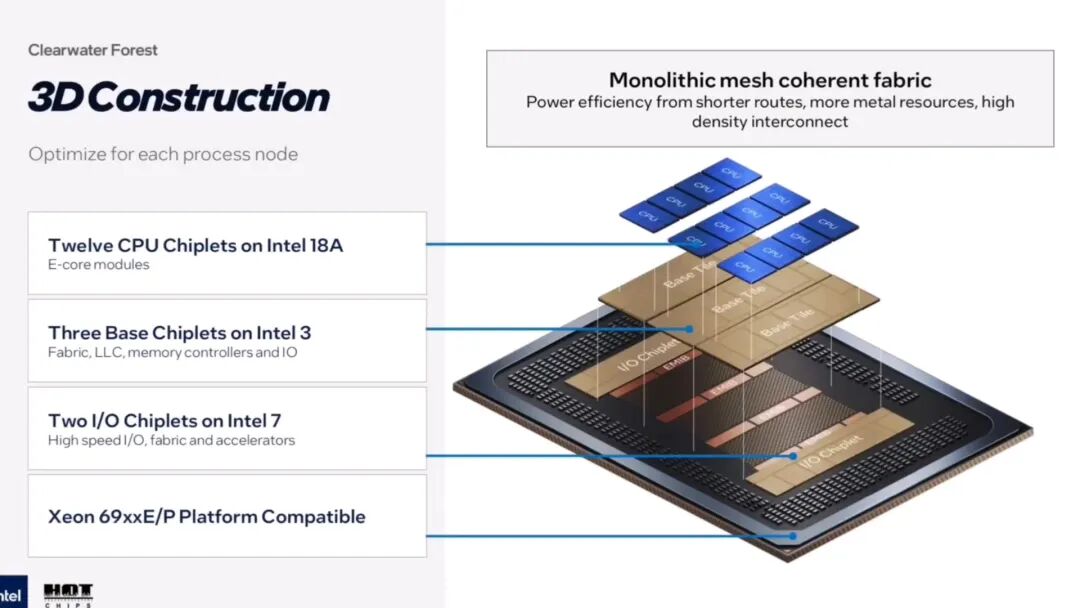

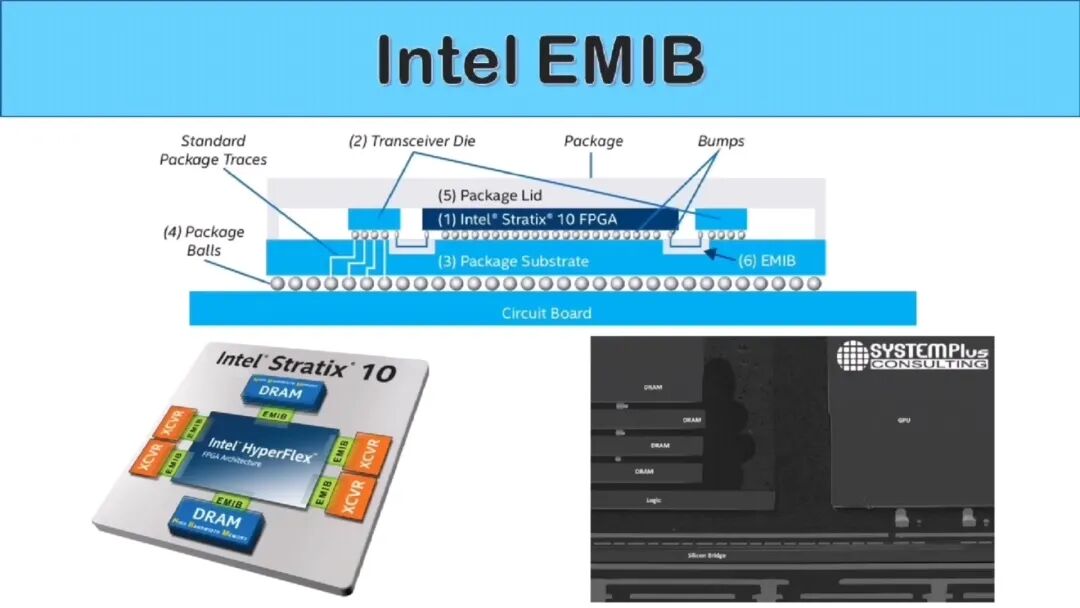

- Chiplet 设计:12 个能效核 CPU Chiplet 用 Intel 18A 工艺,3 个基础 Chiplet 用 Intel 3 工艺,2 个 I/O Chiplet 沿用上一代 Sierra Forest 的 Intel 7 工艺;芯片间用 EMIB(嵌入式多芯片互连桥,英特尔成熟封装技术,高带宽、低延迟)连接。

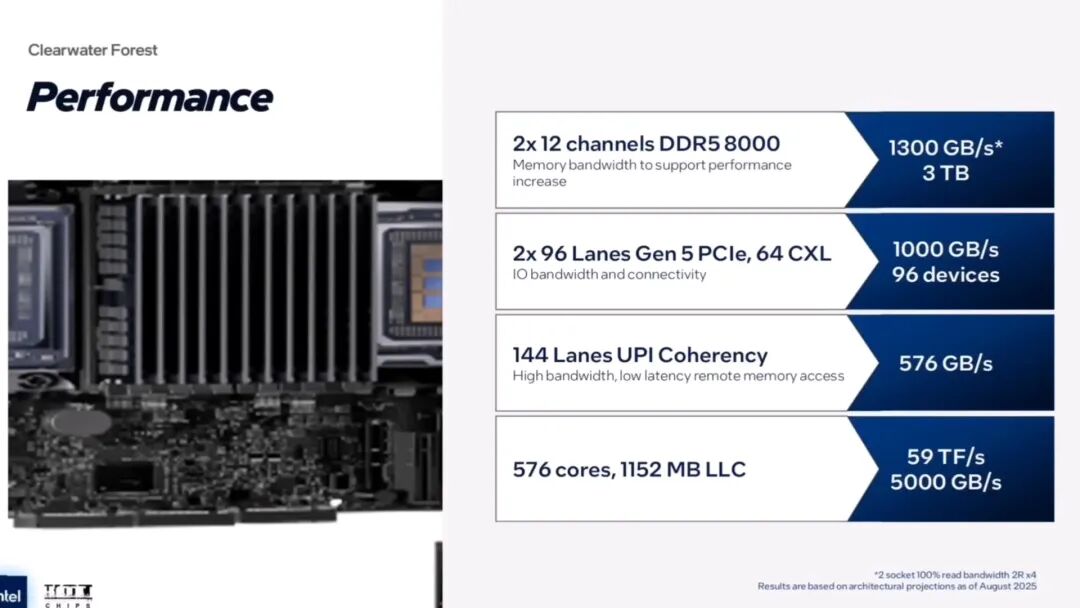

- 缓存优势:末级缓存(LLC)1152MB,每个插槽 576MB;每个 144 核 Tile 含 108MB LLC,两个 Tile 共 216MB;大缓存减少内存访问次数,降低延迟,适配 AI 推理、数据库场景。

- 架构优化:

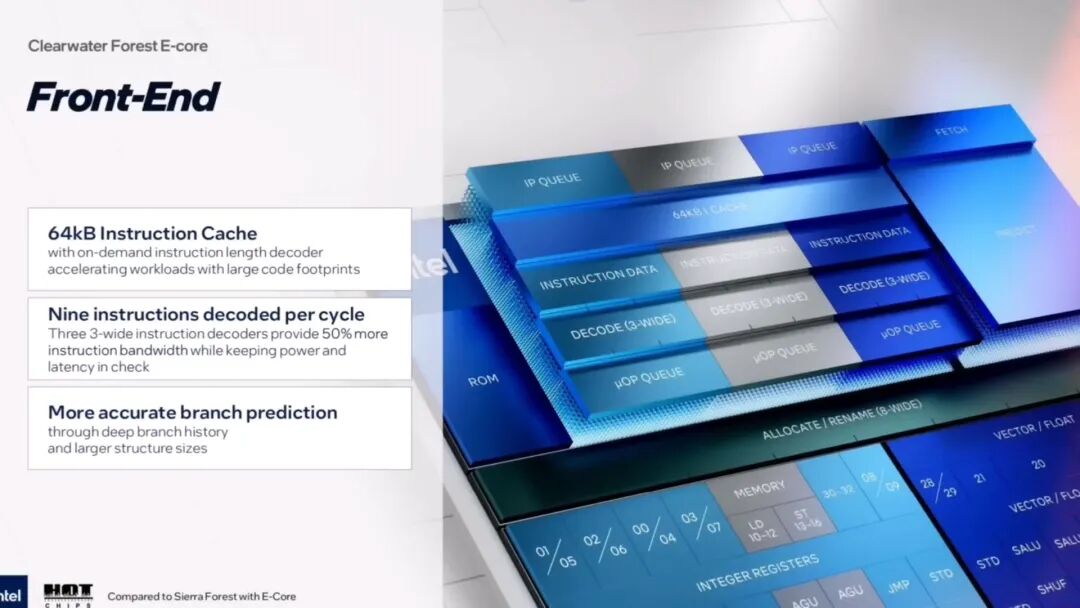

- 前端:3 个 3-wide 指令解码器,指令宽度提升 50%(一次读更多指令,提升执行效率);优化分支预测器,减少 “预测错误” 性能损失。

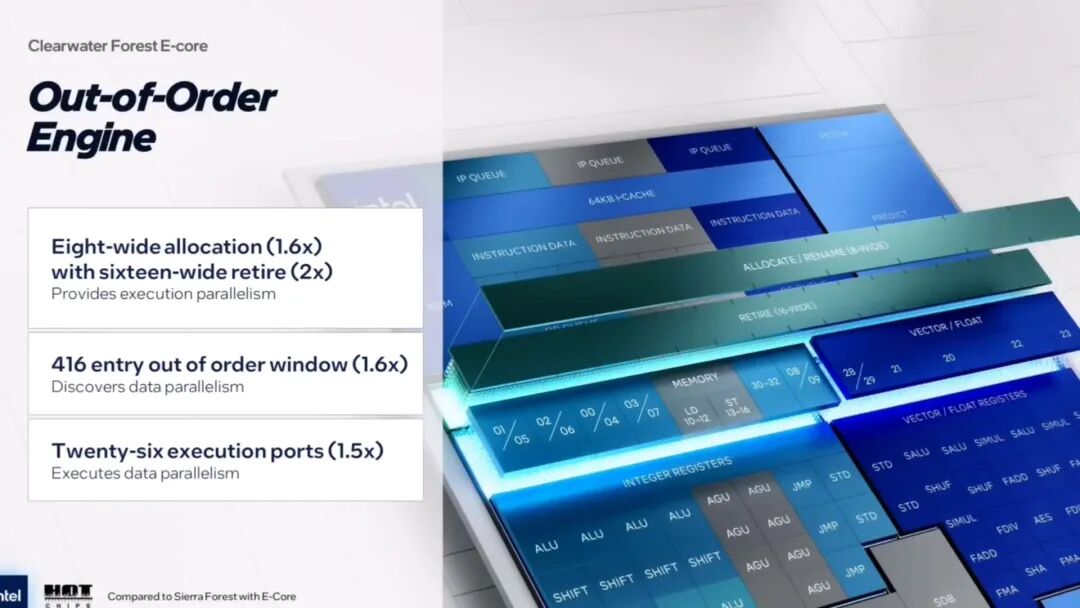

- 后端:乱序执行引擎从每时钟周期调度 5 个操作提升到 8 个,执行端口增至 26 个,整数和向量执行能力翻一倍,多线程性能显著提升。

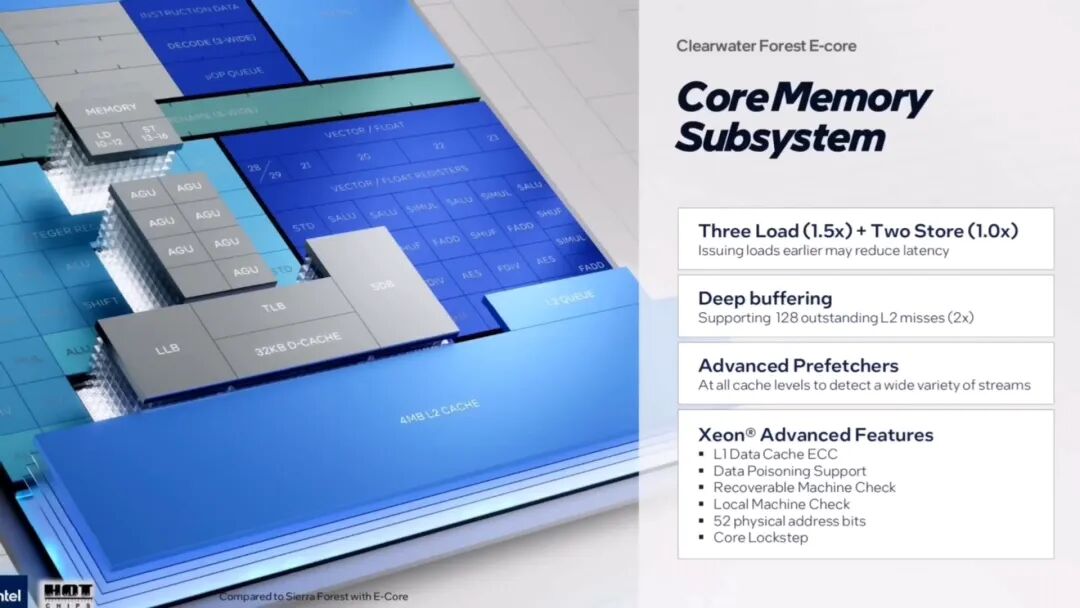

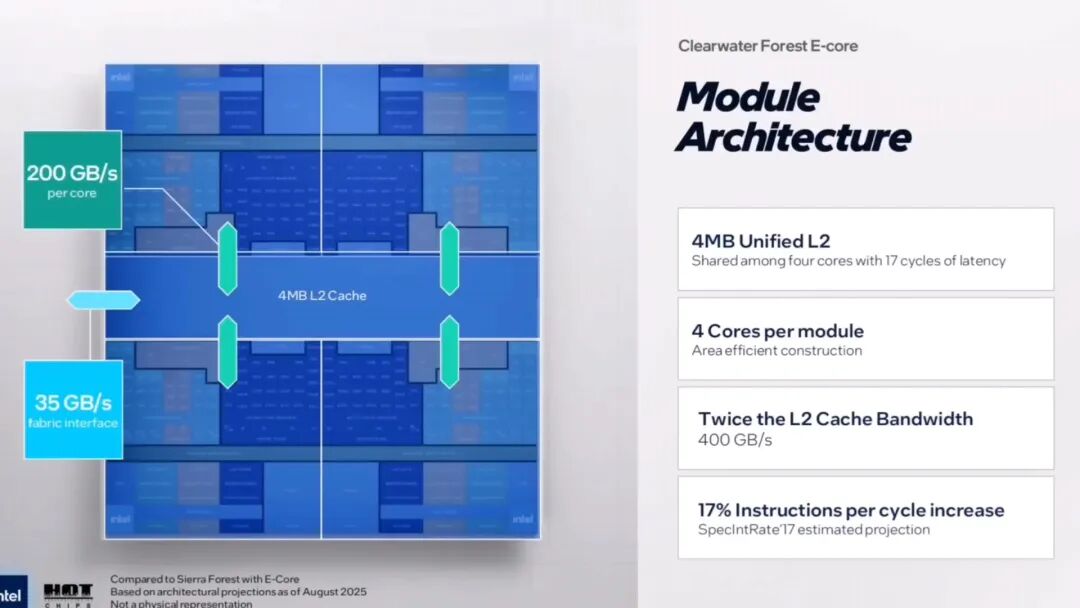

- 内存子系统:L2 未命中缓冲区大小翻倍(存 128 个未命中数据,减少 CPU 等待时间);单个模块 4 个核心共享 4MB 统一 L2 缓存,L2 带宽比上一代翻倍(400GB/s);双插槽系统中每个芯片含 12 个 DDR5-8000 内存通道,总内存带宽 1300GB/s;机架每瓦性能是上一代 Sierra Forest 的 3.5 倍。

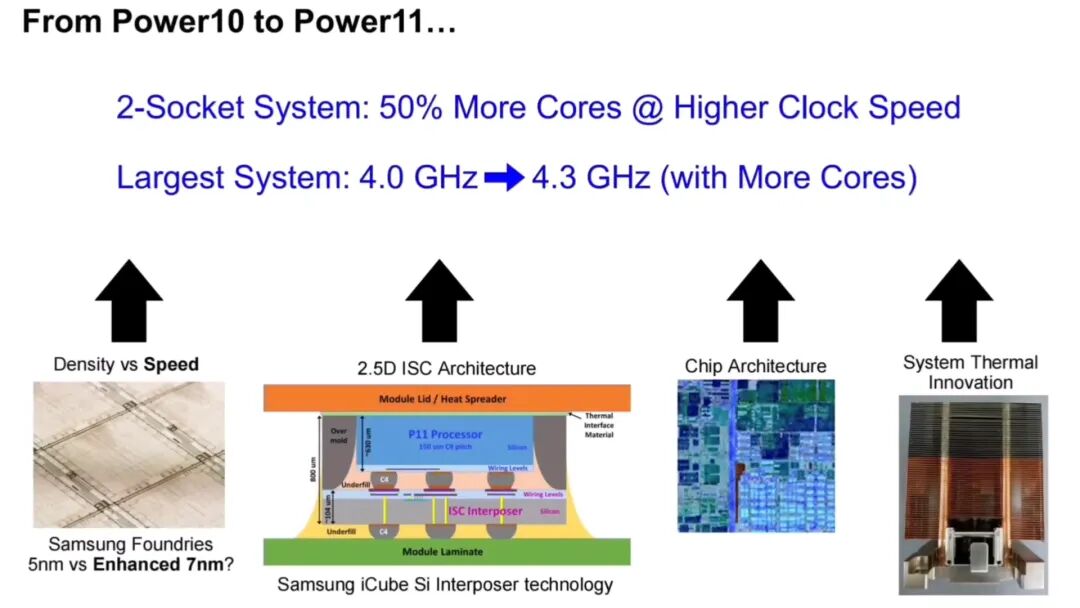

2. IBM Power11

- 工艺与理念:三星 7nm 工艺,设计理念 “按需增加核心数”(不盲目堆核心,按实际需求优化架构)。

- 后代计划:聚焦六点 —— 插槽集成硅片数为上一代 3 倍、利用良率协同效应、保持跨 Chiplet 高带宽连接、优化 OMI 内存效率、减少延迟提升拓扑协同性、保证长期发展效率与灵活性。

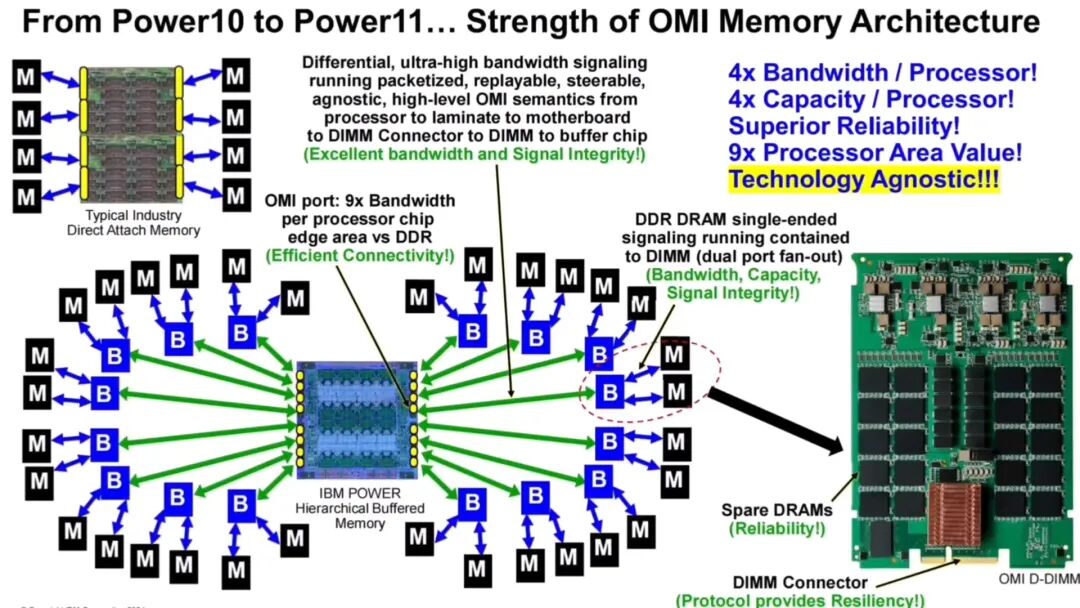

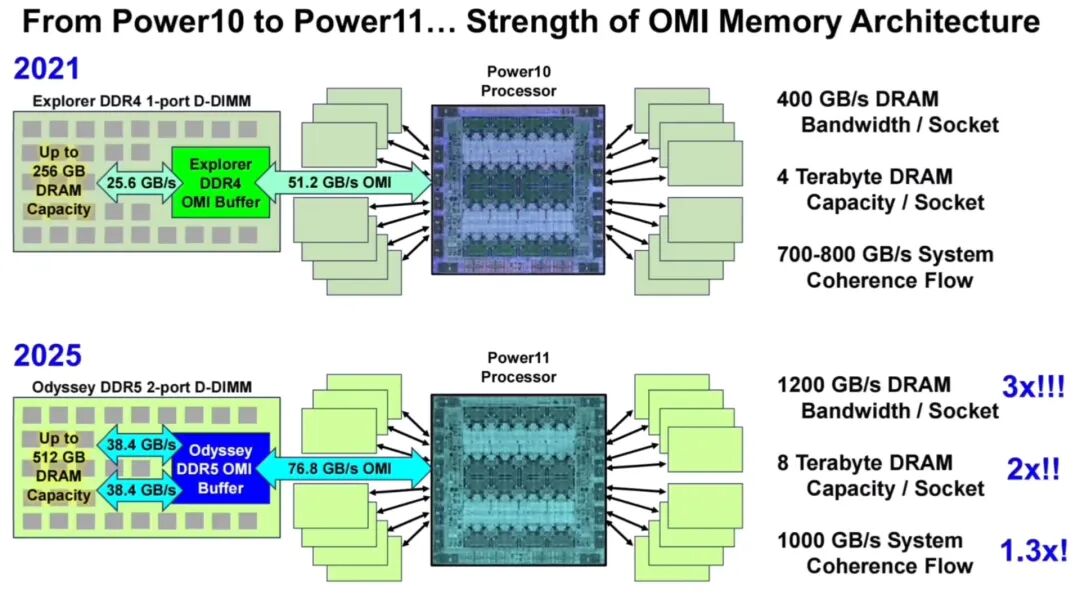

- 核心升级:OMI 内存架构(分层内存架构);一块芯片最多支持 32 个 DDR5 内存端口(传输速度最高 38.4Gbps),将推出定制化内存规格 OMI D-DIMM;目标 8TB DRAM 和 1TB/s 以上内存带宽,基于 DDR5 实现,成本低于 HBM(IBM 不看好 HBM,因容量低难满足大规模数据处理);OMI 缺点是缓冲区增加 6-8ns 延迟,IBM 认为容量和带宽优势更值得。

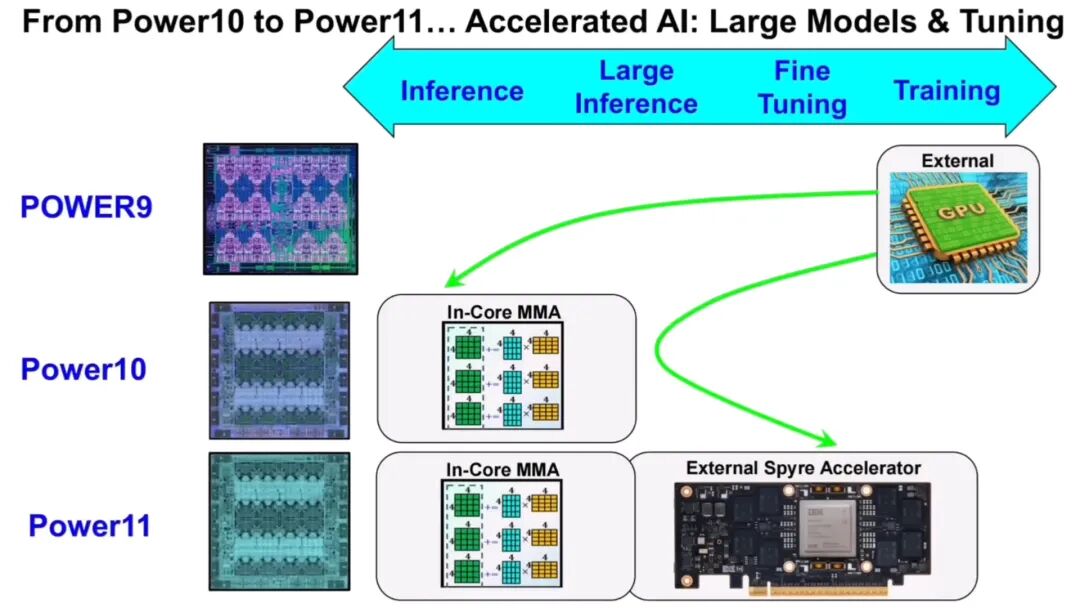

- 加速器支持:优化对外部 PCIe 加速器的支持,搭配自研 Spyre 加速器提升 AI 计算性能(如机器学习场景中,Spyre 卸载 Power11 计算任务,让 CPU 专注数据调度,整体性能提升)。

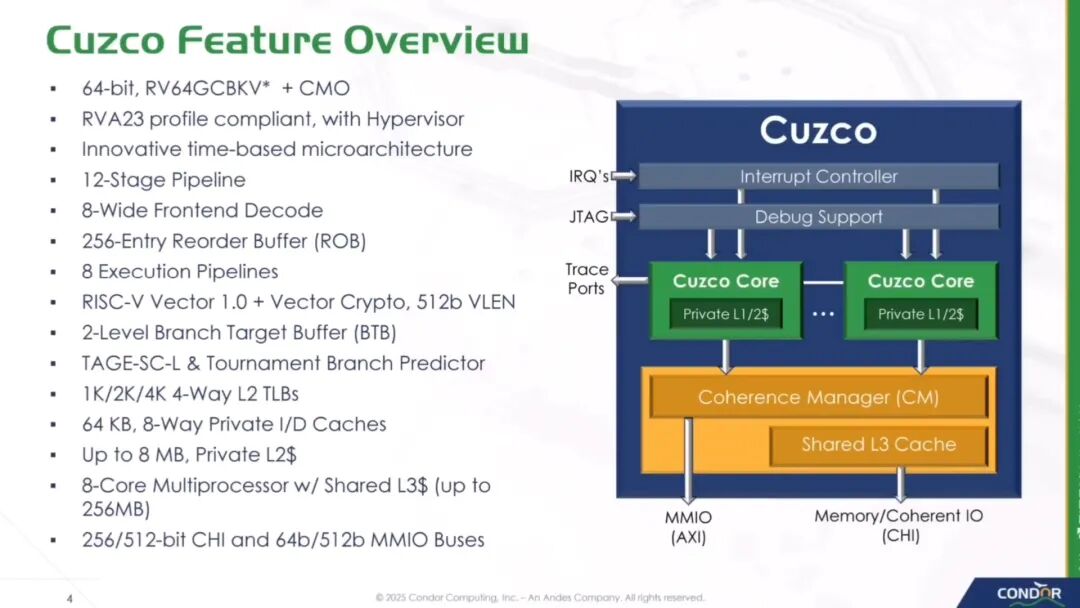

3. Condor Computing Cuzco

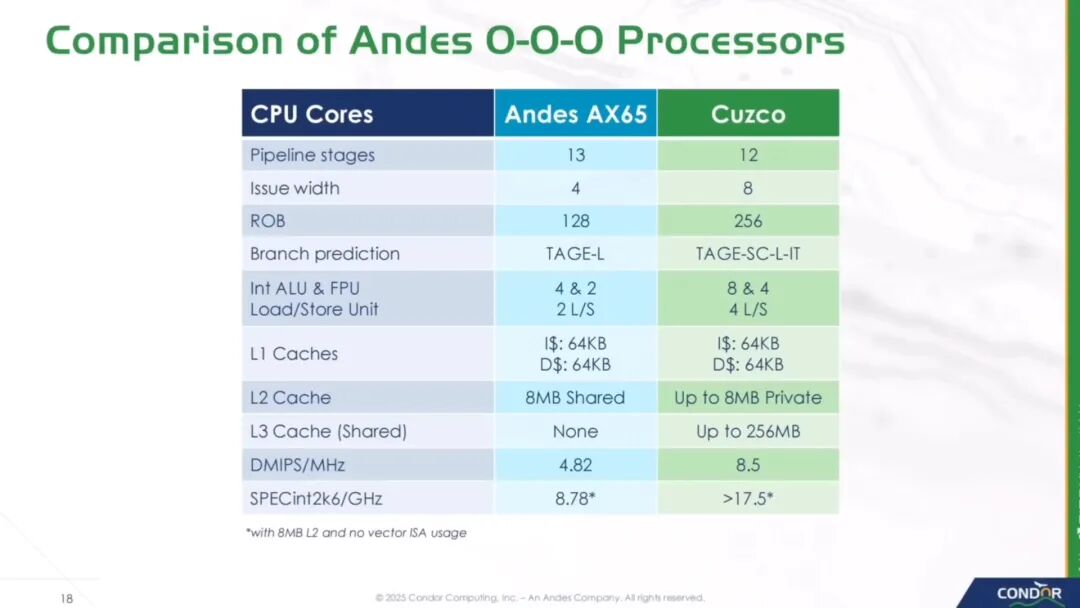

- 定位与团队:晶心科技子公司 Condor Computing 推出的首款高性能 RISC-V CPU IP,由 50 人团队完成,性能优于相近功耗的高性能授权 CPU。

- 核心优势:

- 成本低:RISC-V 开源架构,无需交授权费。

- 能效高:针对低功耗场景优化。

- 扩展性强:每集群 8 个高性能计算 CPU 核心,可按需扩展核心数。

- 兼容性好:符合面向高性能 RISC-V 计算的最新 RVA23 规范,软件生态可复用。

- 灵活定制:完全支持 ISA(指令集架构)定制,可按客户需求添加特殊指令。

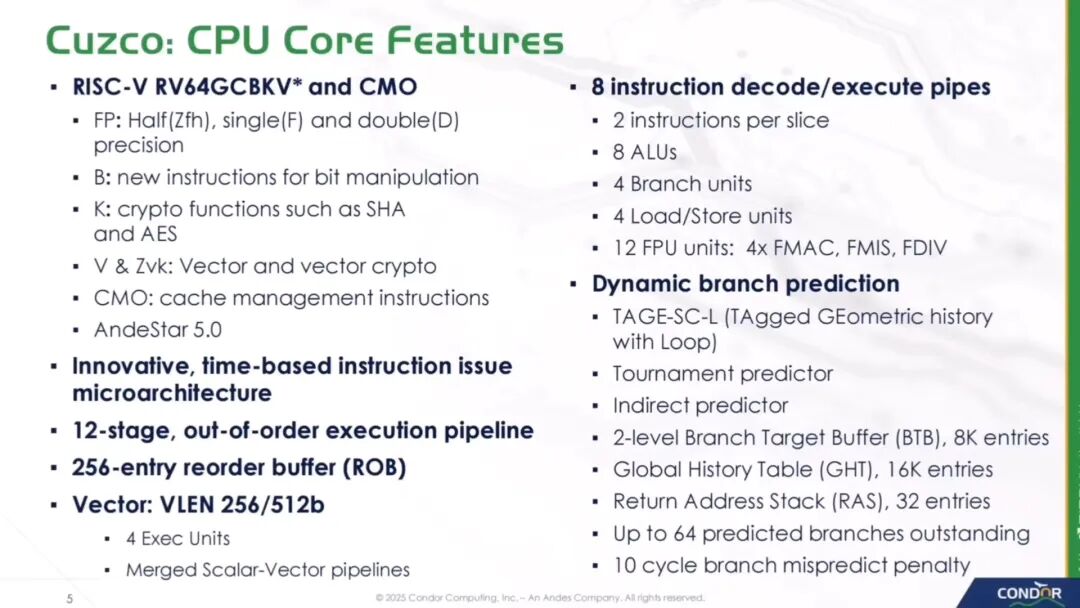

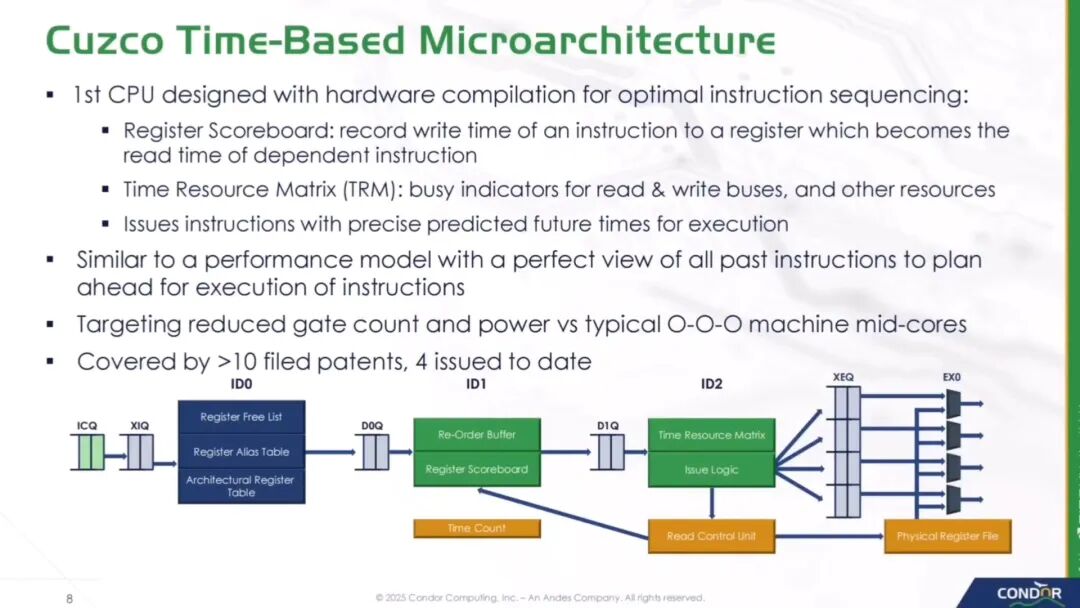

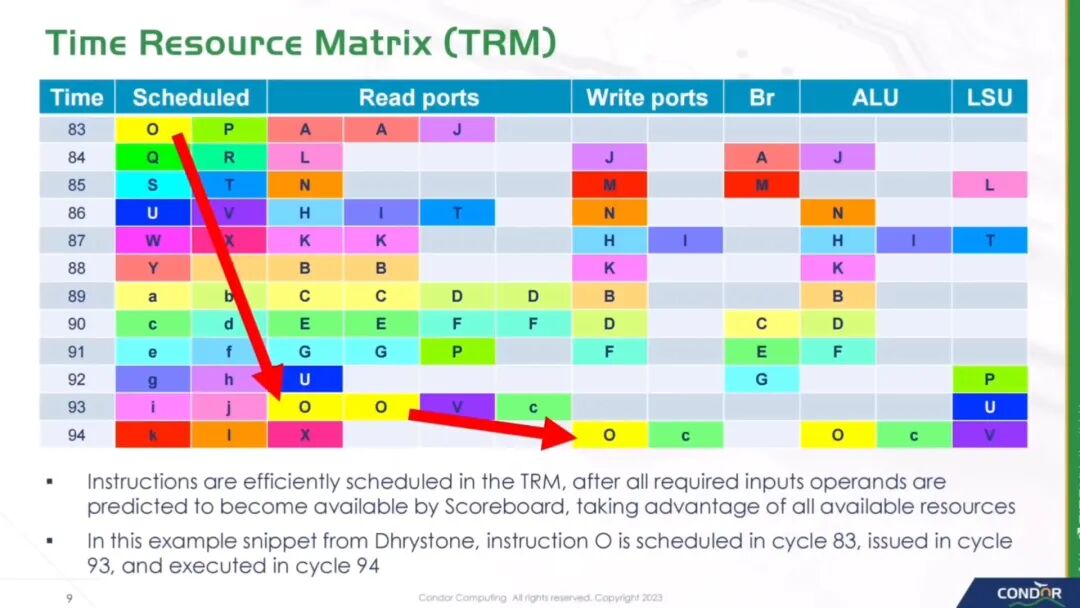

- 创新设计:基于时间的微架构 —— 传统乱序执行 CPU 需复杂调度逻辑(晶体管多、功耗高),Cuzco 用硬件编译排序指令,通过 “寄存器计分板” 和 “时间资源矩阵(TRM)” 精确预测指令执行时间,提前安排顺序;优势:调度确定性降低逻辑复杂性,消除复杂运行时每周期调度,减少动态功率,用更少晶体管实现更高能效。

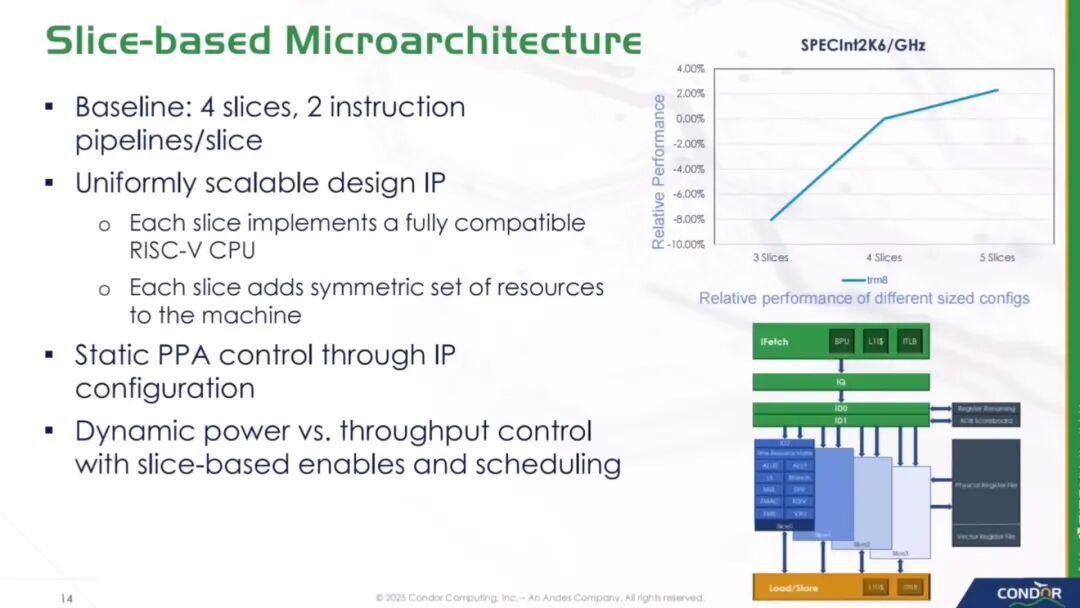

- 架构与性能:采用 slice 设计,最多支持 8 个核心,每个核心有私有 L2 缓存,多个核心共享 L3 缓存(分层缓存平衡延迟和容量);SPECint2006 测试中,每时钟周期性能几乎是晶心科技当前 AX65 核心的两倍。

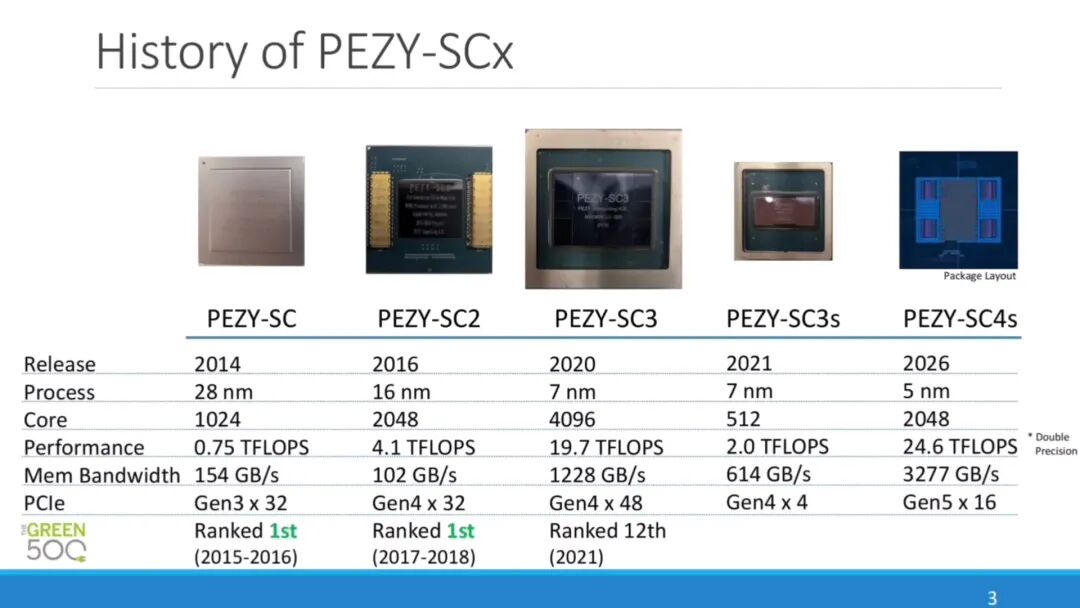

4. PEZY Computing PEZY-SC4s

- 架构类型:第四代 MIMD(多指令多数据)多核处理器,特点是 “每个核心可执行不同指令、处理不同数据”,适配高度独立线程应用(科学计算、基因组分析);PEZY 认为此类应用中 MIMD 比 SIMD 更有效(充分利用线程独立性)。

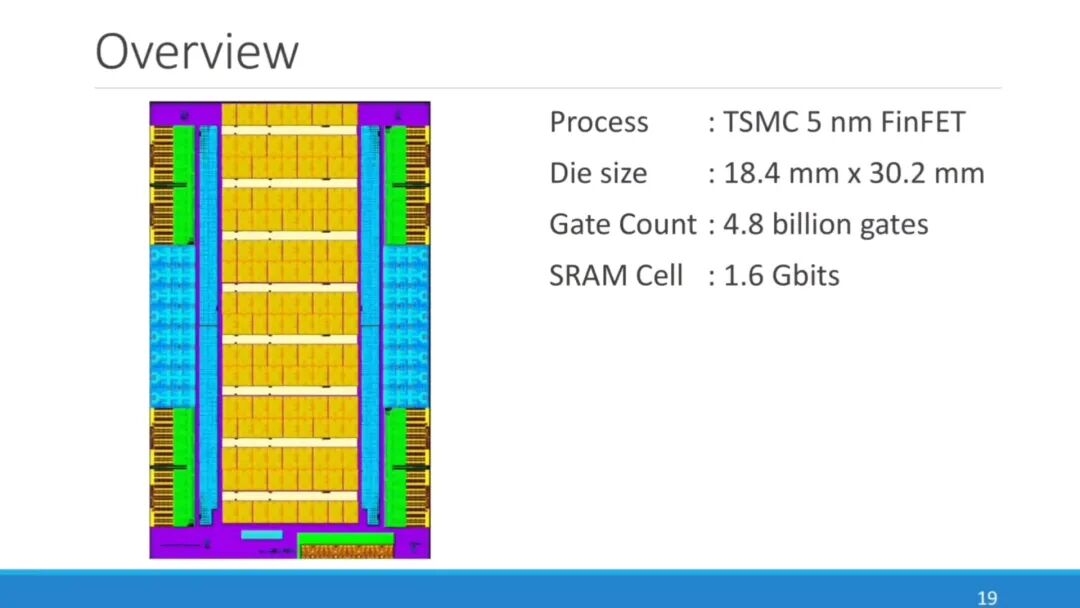

- 硬件参数:台积电 5nm FinFET 工艺,芯片尺寸 18.4mm×30.2mm(约 556mm²),集成 48 亿晶体管,SRAM 容量 1.6Gb;内部总线读带宽 12TB/s、写带宽 6TB/s。

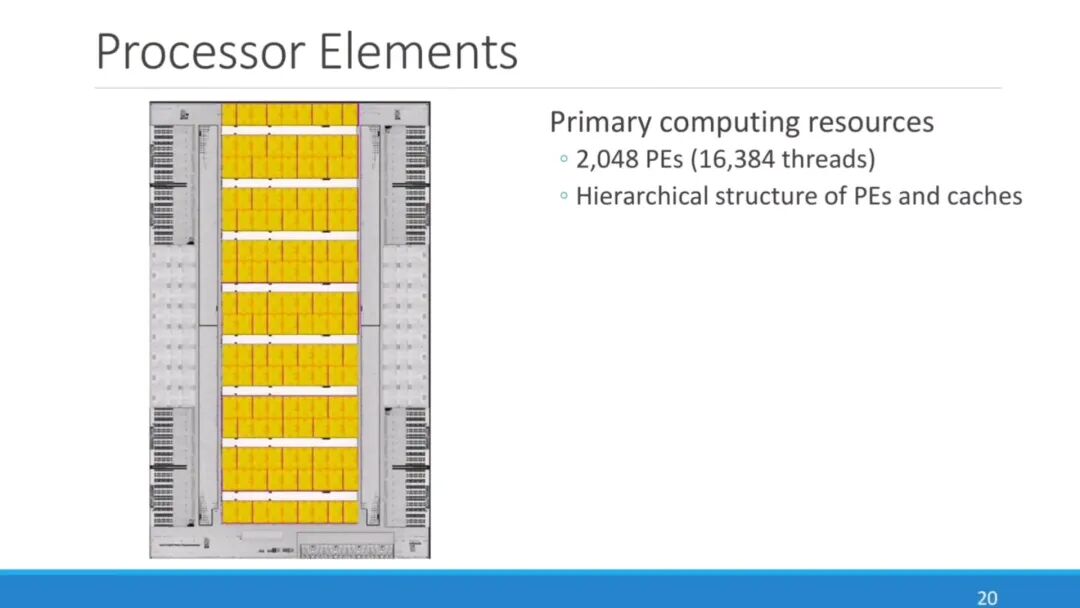

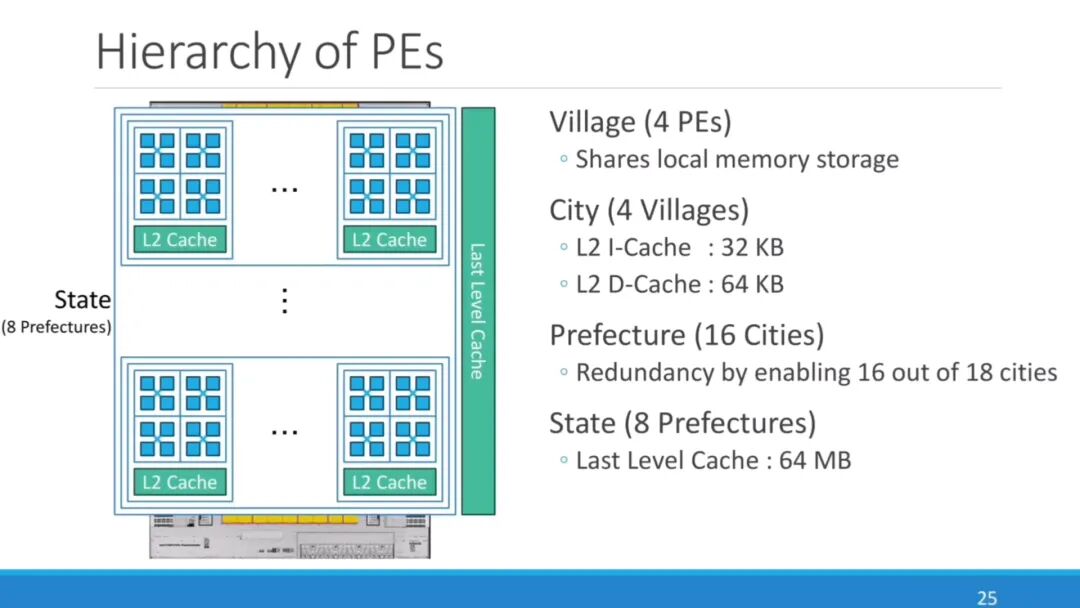

- 计算与内存:2048 个处理单元(PE),支持 16384 个线程;PE 和缓存分层设计(减少数据访问延迟,提升线程并行效率);外部内存采用 HBM3(4 个设备,带宽 3.2TB/s、容量 96GB);外部接口是 PCIe Gen5(16 个 lane,带宽 64GB/s)。

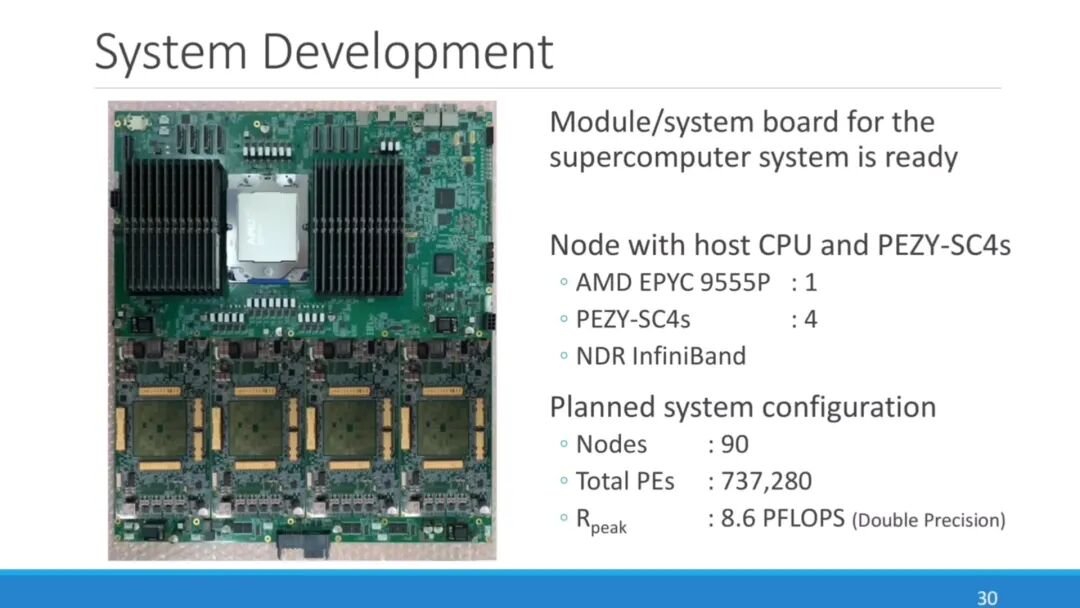

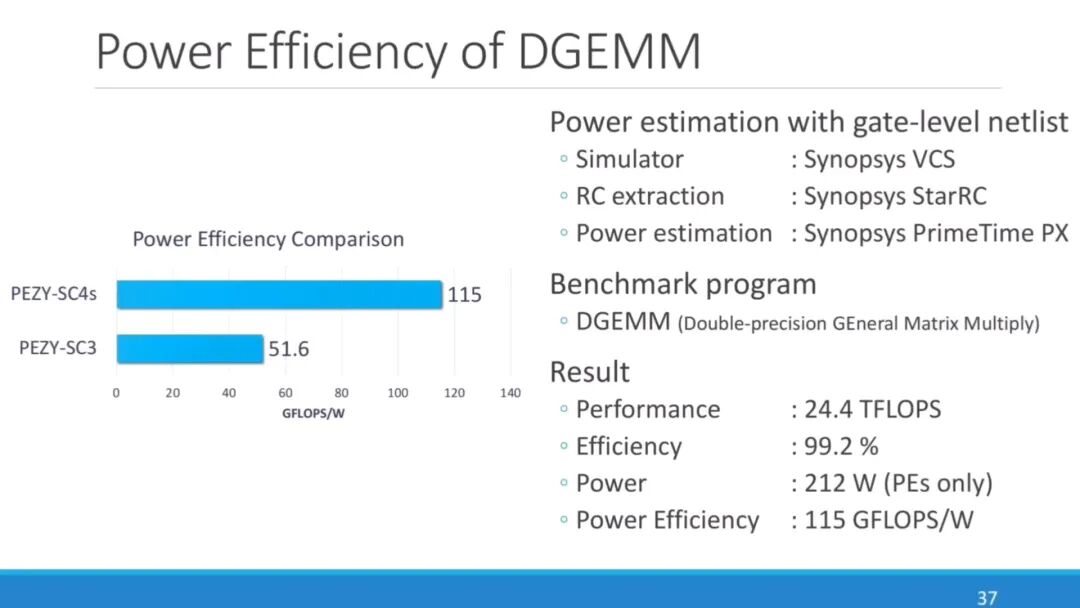

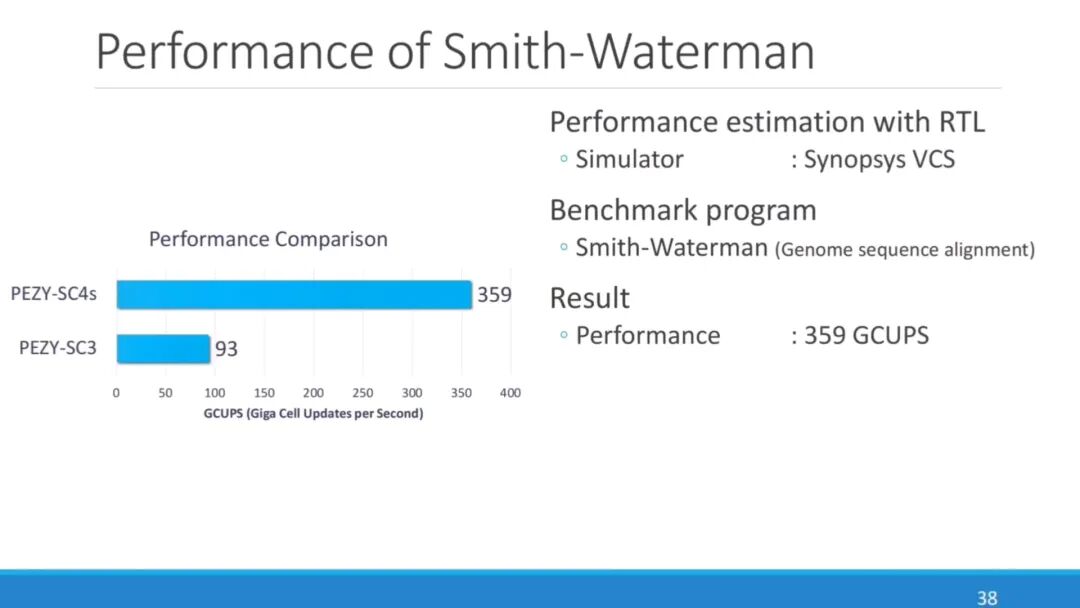

- 系统部署与性能:设计 “主机 CPU+PEZY-SC4s” 节点,每个节点含 1 张 AMD EPYC 9555P CPU、4 张 PEZY-SC4s 和 NDR InfiniBand 网卡;规划 90 个节点系统,共 737280 个 PE,双精度峰值算力 8.6PFLOPS(适配气候模拟、量子化学);仿真测试:双精度 DGEMM(通用矩阵乘法)功率效率是上一代 2 倍以上,Smith-Waterman(基因组序列比对算法)性能 359GCUPS(是上一代 PEZY-SC3 的 3.86 倍)。

- 未来规划:开发第五代 PEZY-SC5(计划 3nm 或更小工艺,2027 年发布);开发硬件描述语言 Veryl(作为 SystemVerilog 的开源替代方案),PEZY-SC5 核心组件用 Veryl 开发,目标降低芯片设计门槛。

六、图形领域:AI 驱动渲染效率提升

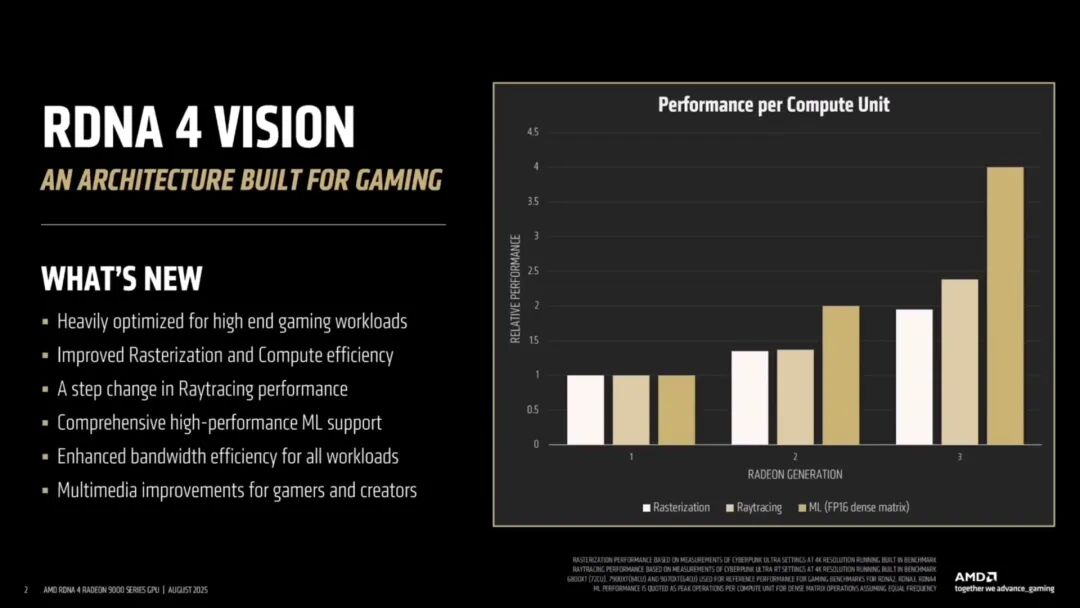

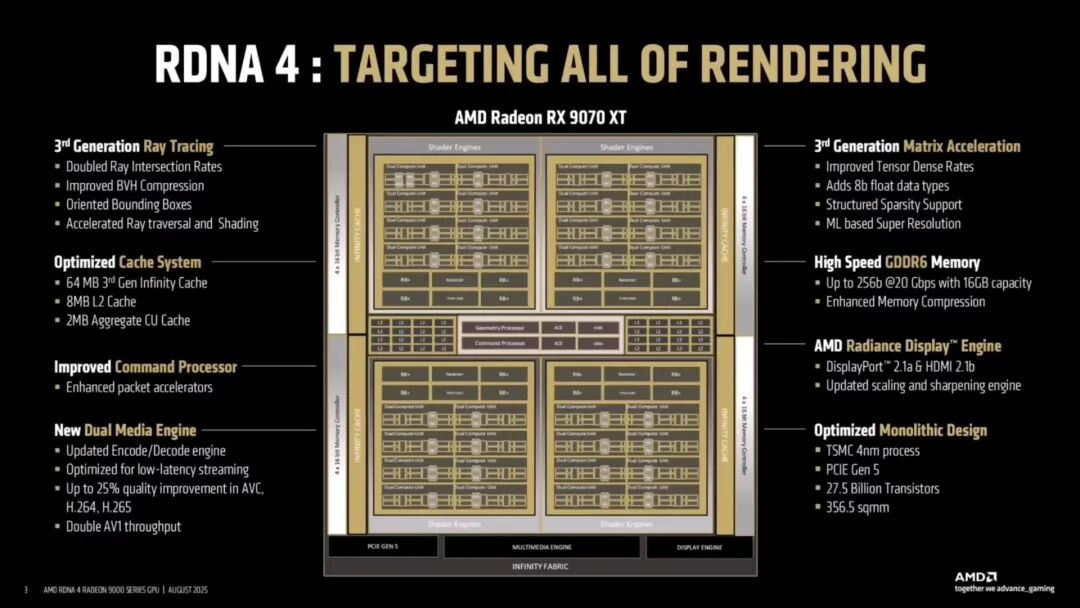

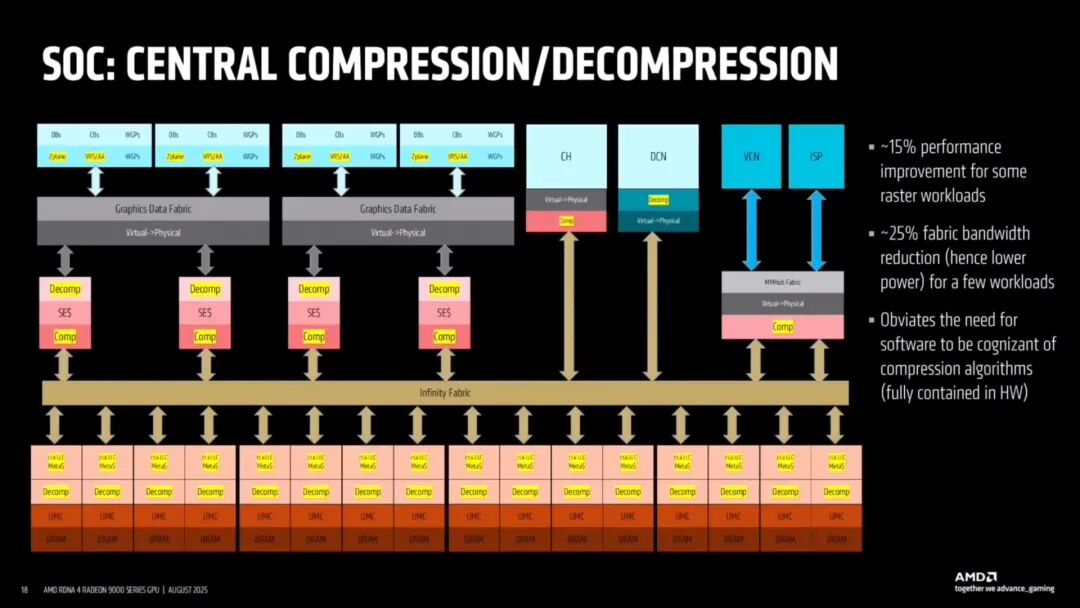

1. AMD RDNA 4

- 定位:专为下一代游戏和创作设计,核心升级 “AI 算力 + 光线追踪优化”,支持严苛游戏、先进视频编码、流媒体生产力场景。

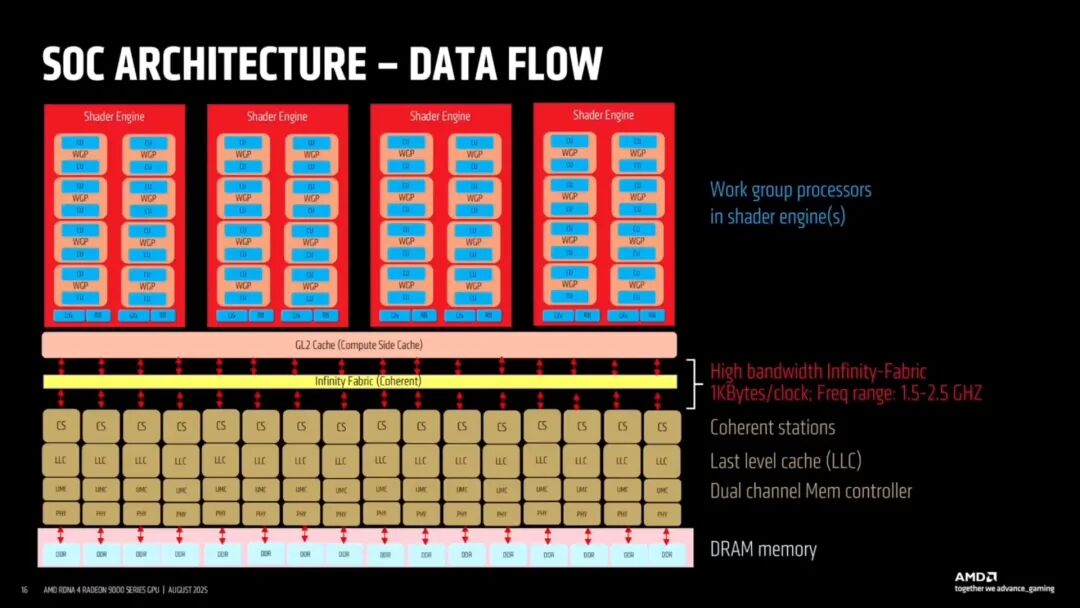

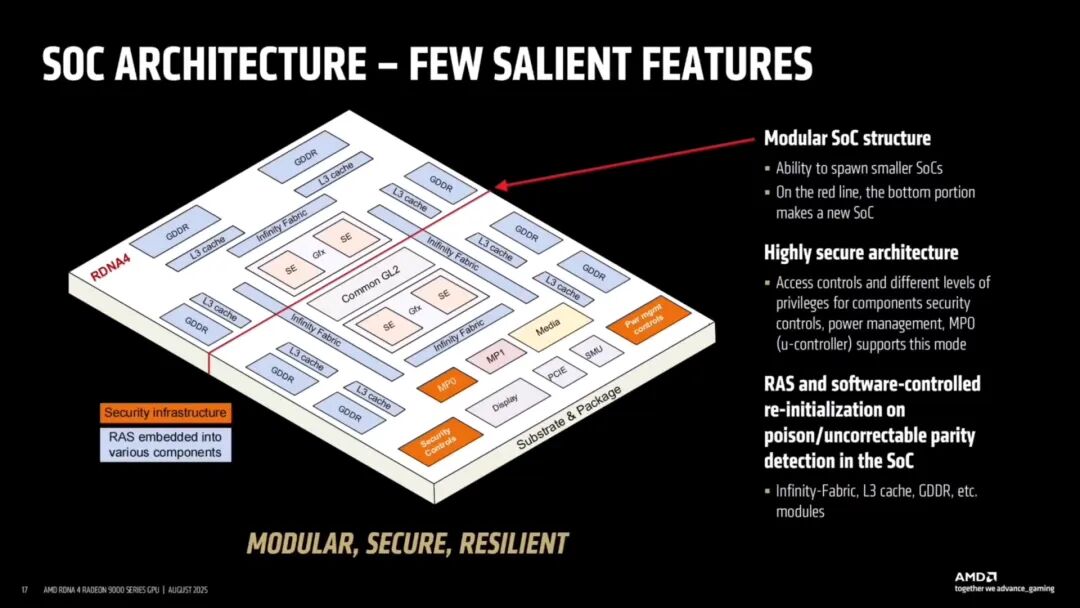

- 架构灵活性:SoC 架构高度可扩展,可按市场需求调整配置,打造从入门到旗舰的多产品 SKU,无需重新设计架构,降低开发成本。

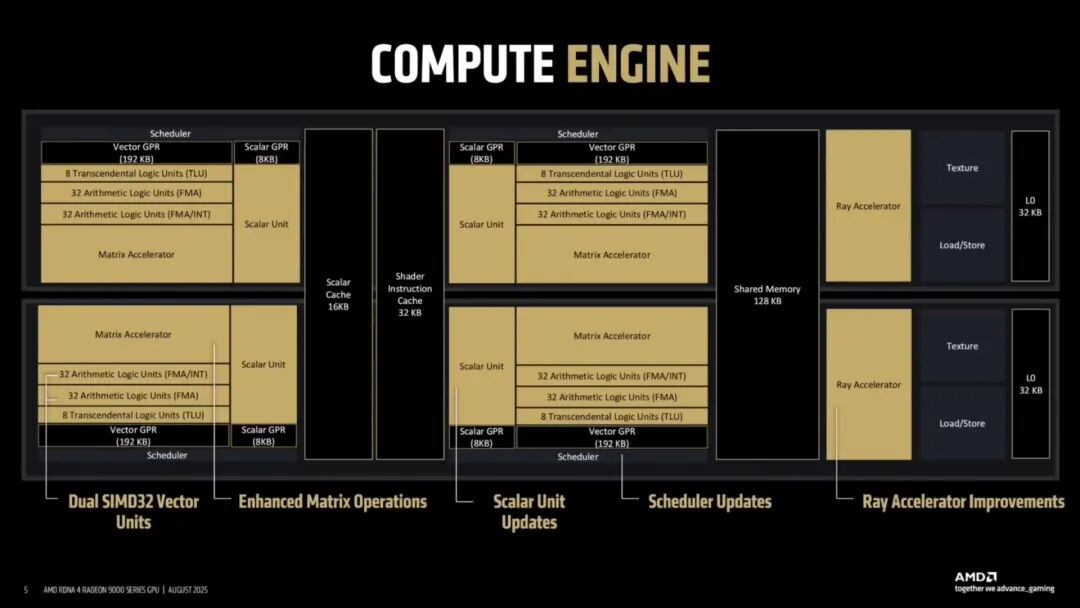

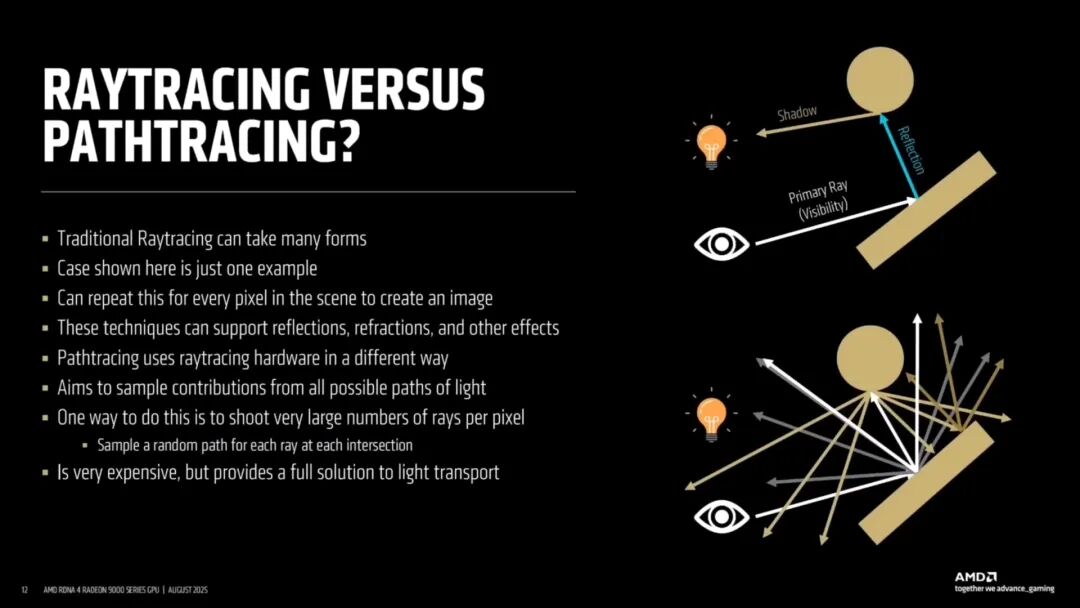

- 游戏负载优化:

- 栅格化与计算效率:优化着色器引擎执行逻辑,提升多边形渲染和通用计算速度。

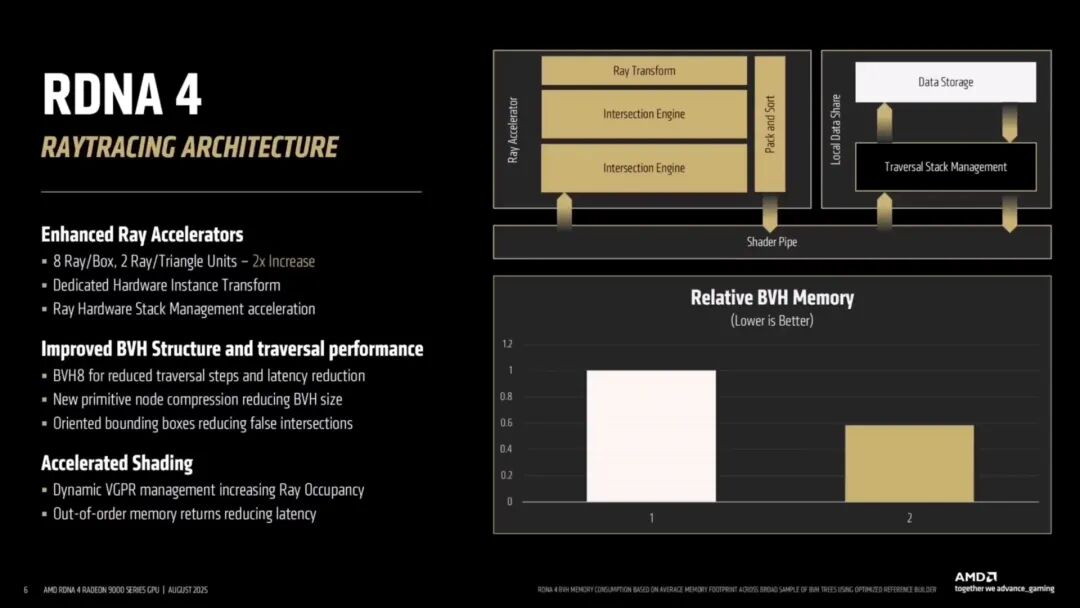

- 光线追踪性能:光线求交性能比上一代翻一倍;新增专用硬件实例转换器(将 “实例转换” 从着色器程序转移,让着色器专注渲染);BVH(边界体积层次结构)从 4 列加宽到 8 列(高效组织场景数据,减少计算量);节点压缩技术减少 BVH 尺寸,降低内存占用;“定向边界框” 优化(传统轴对齐边界框对不规则物体包裹性差,定向边界框按物体形状调整,提升光线相交测试效率)。

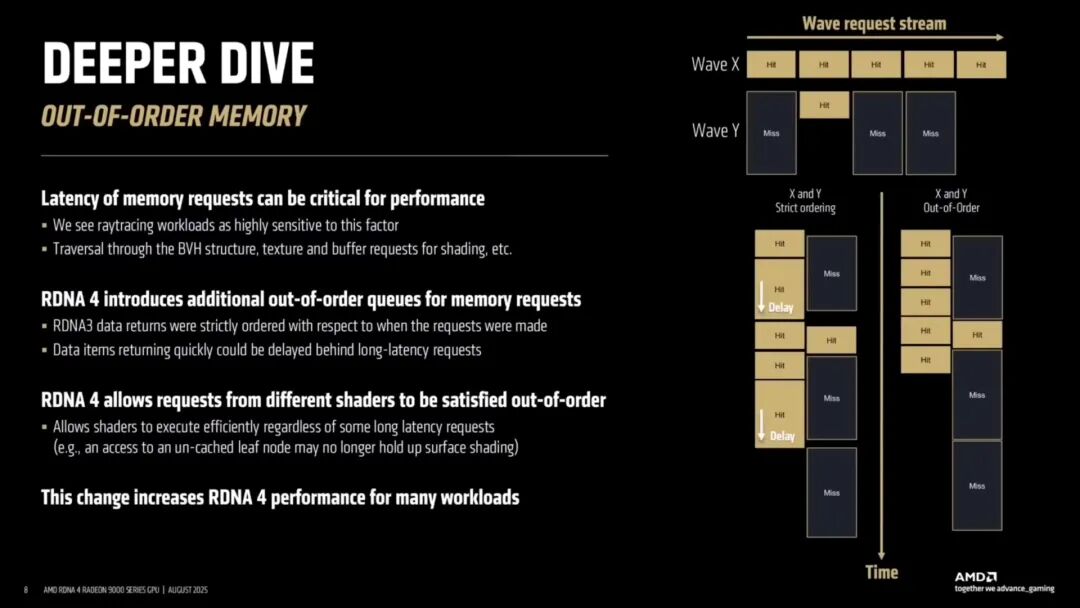

- 内存访问:优化乱序内存访问,高优先级请求优先处理,适配光追 “频繁访问内存” 场景。

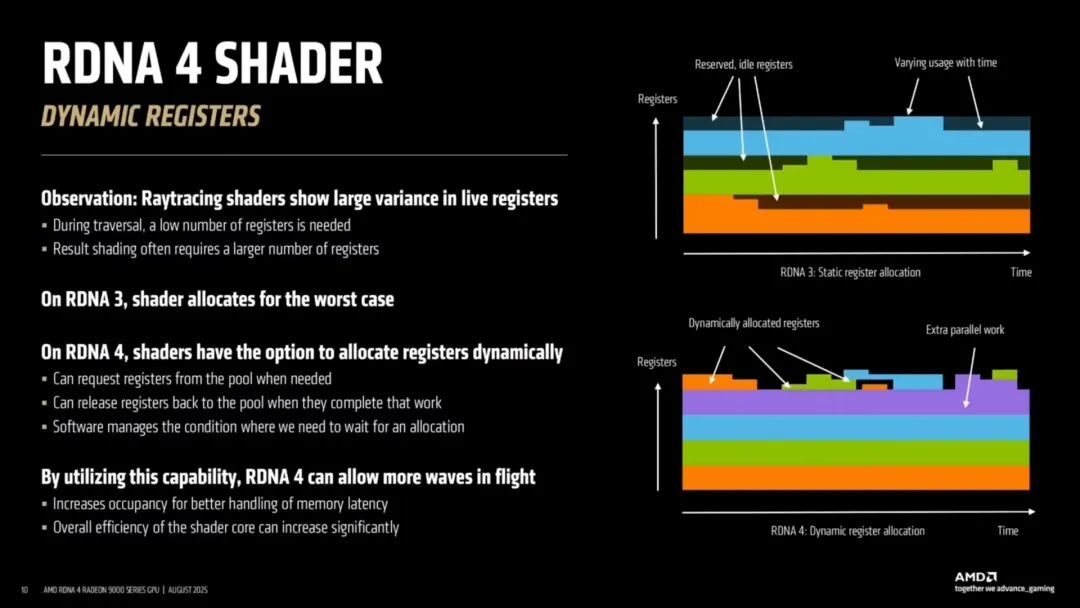

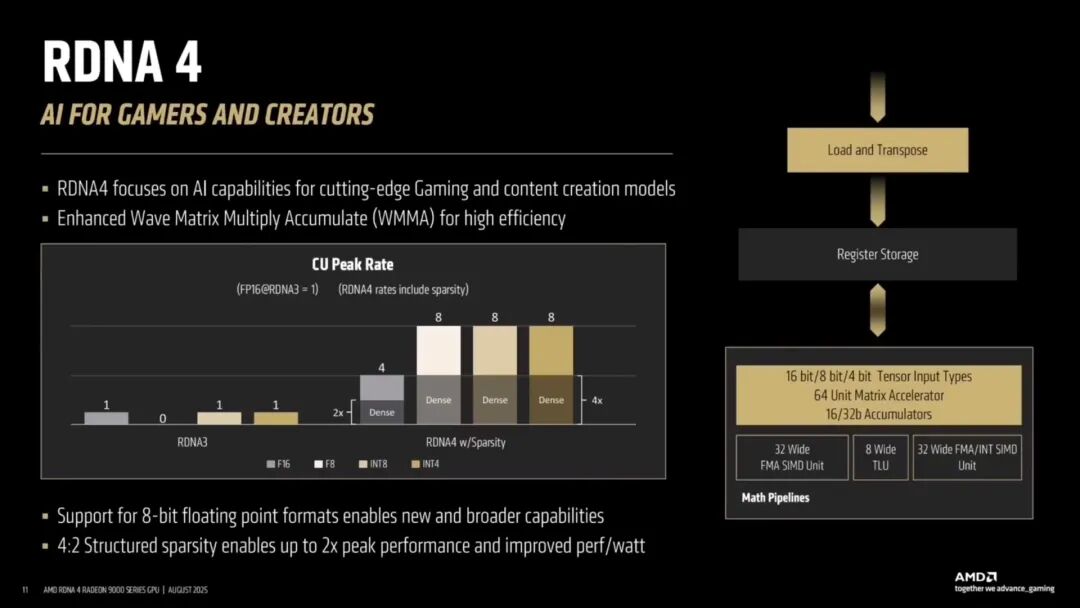

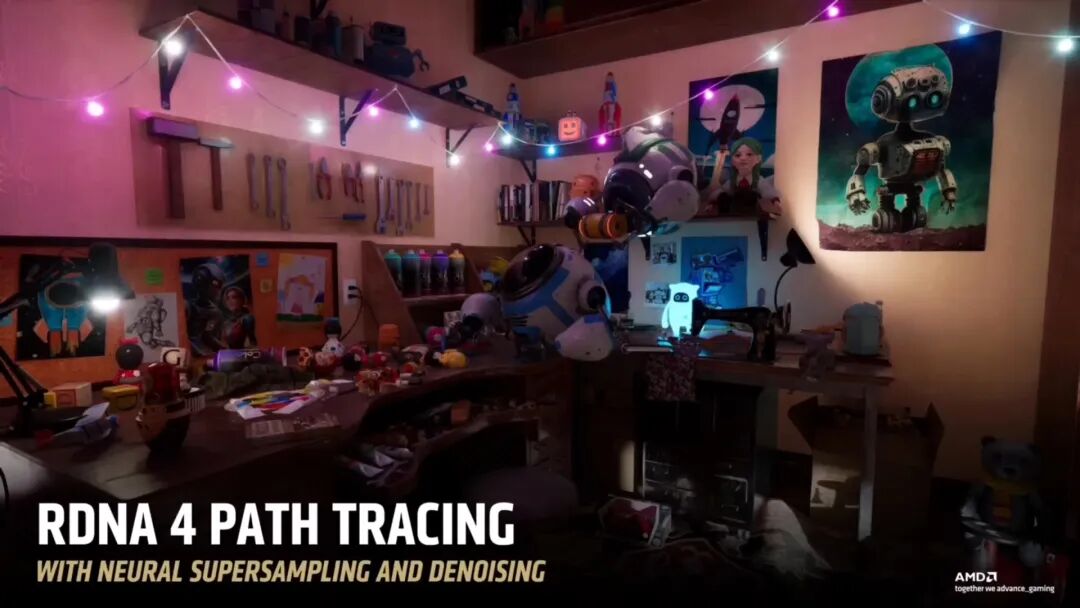

- 着色器与 AI:着色器引擎通过动态寄存器分配增加 “传播波数”(传播波是着色器并行执行单元,数量越多并行能力越强);支持 FP8 精度和稀疏化功能(FP8 保证画质下提升算力密度,稀疏化跳过无效数据计算,减功耗延迟);AI 应用:神经辐射缓存存储场景辐射信息,神经超采样和去噪技术填补画面空白,兼顾速度与画质。

- 存储与兼容性:Infinity Fabric 带宽 1KB 每时钟频率;架构模块化(如 Navi 48 GPU 可切成两半造更小 GPU,减少开发变体工作量,提升可靠性);新内存压缩 / 解压缩功能(硬件处理,软件透明),部分栅格工作负载性能提升约 15%,fabric 带宽占用率降低约 25%,无需软件修改。

2. 英伟达 Blackwell

- 核心方向:“神经渲染”,RTX Blackwell 为 “神经渲染新时代奠定基础”;神经渲染核心是 “融合传统图形与 AI”(用 AI 生成画面,非完全依赖光栅化 / 光追),兼顾视觉保真度、沉浸式体验、低功耗,支持游戏 AI agent(如动态 NPC)。

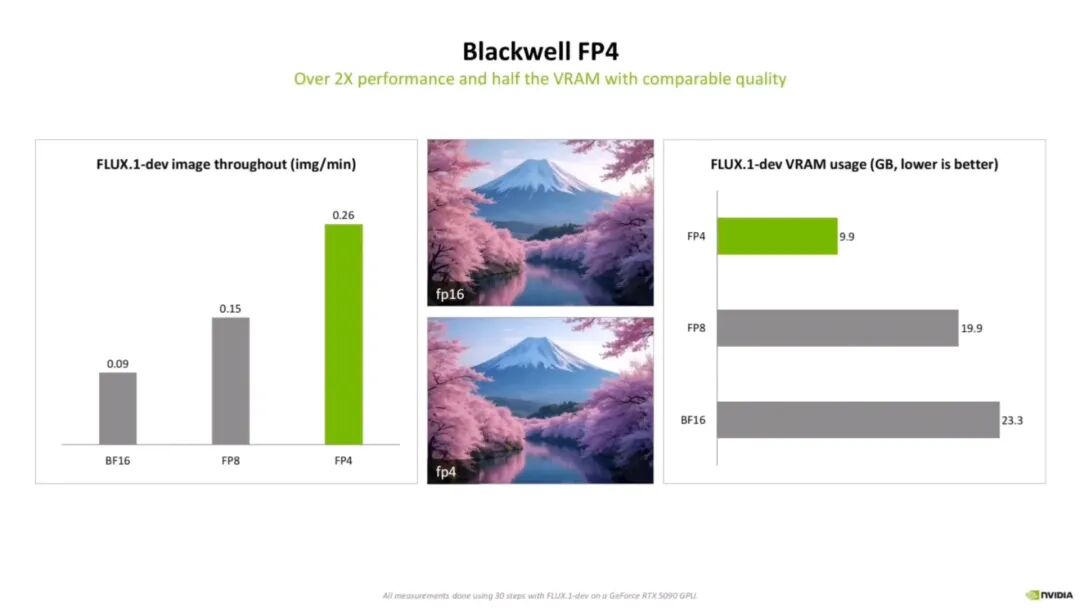

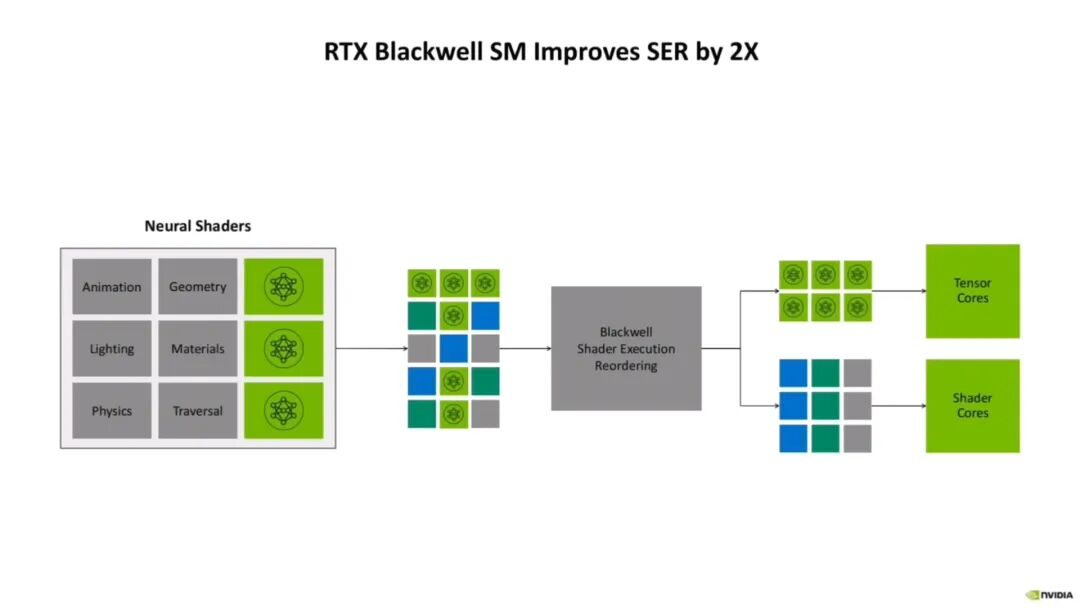

- AI 性能优化:大量使用 FP4 计算(精度低于 FP8,但算力密度更高,适配 AI 渲染 “精度要求不高” 场景,降内存占用和功耗);“着色器执行重排序” 技术(根据着色器执行状态动态调整任务顺序,保持 GPU 核心 SM 满载,避免资源浪费)。

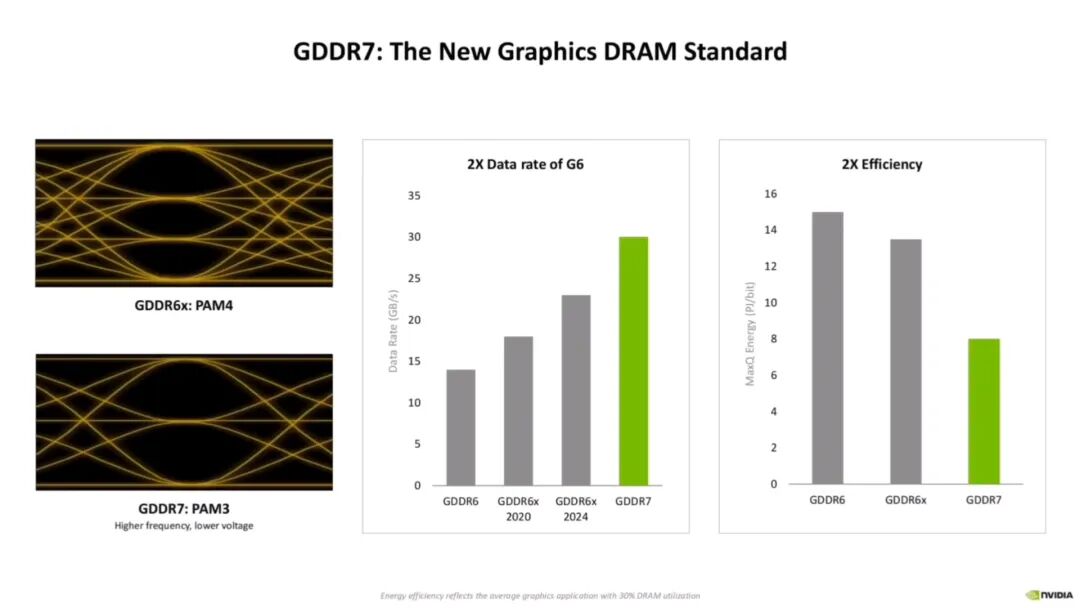

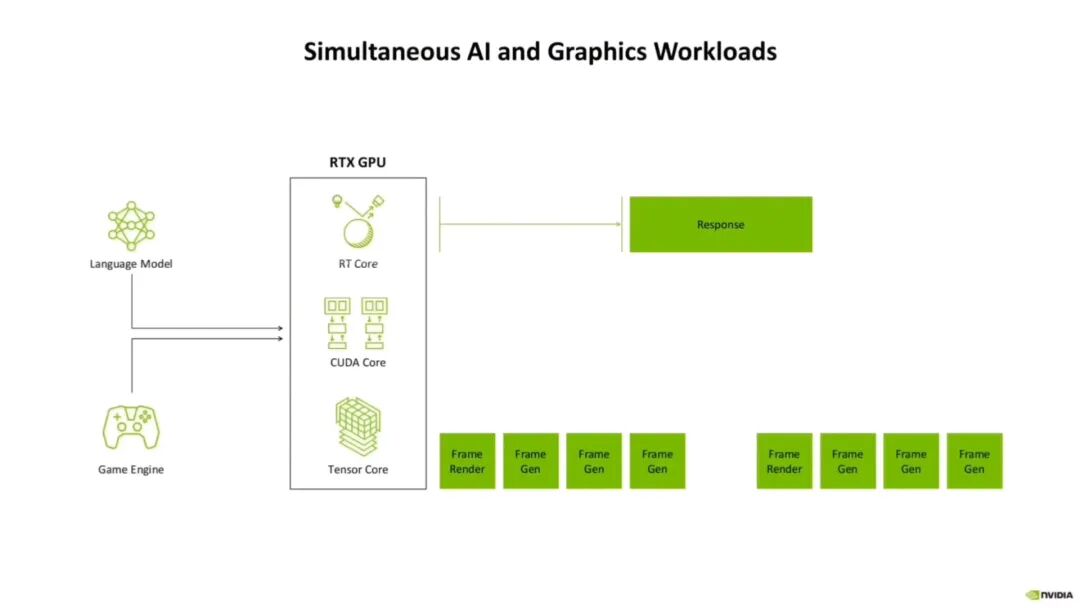

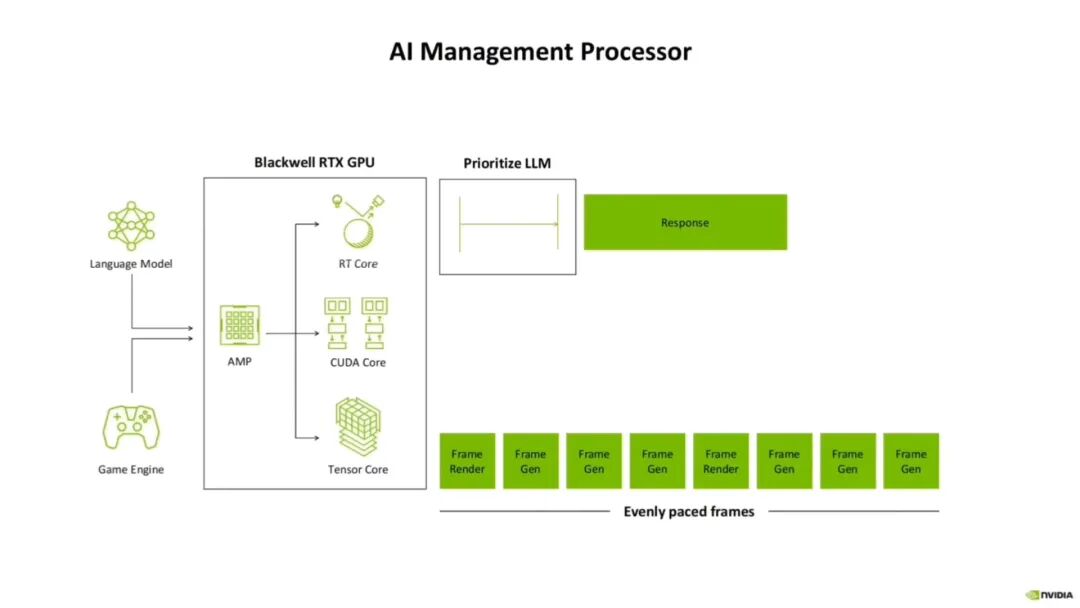

- 内存与响应:支持 GDDR7(采用 PAM3 调制技术,与 GDDR6X 的 PAM4 相比,每时钟周期位数少但 SNR(信噪比)高,支持更高时钟速度,带宽更高且电压低、功耗少);优化 “首 token 执行时间”(混合图形 / 机器学习工作负载中,首 token 时间越短 AI 响应越及时);集成 AI 管理处理器,协调图形和机器学习交错工作(如游戏渲染间隙调度 AI 任务,避免任务等待)。

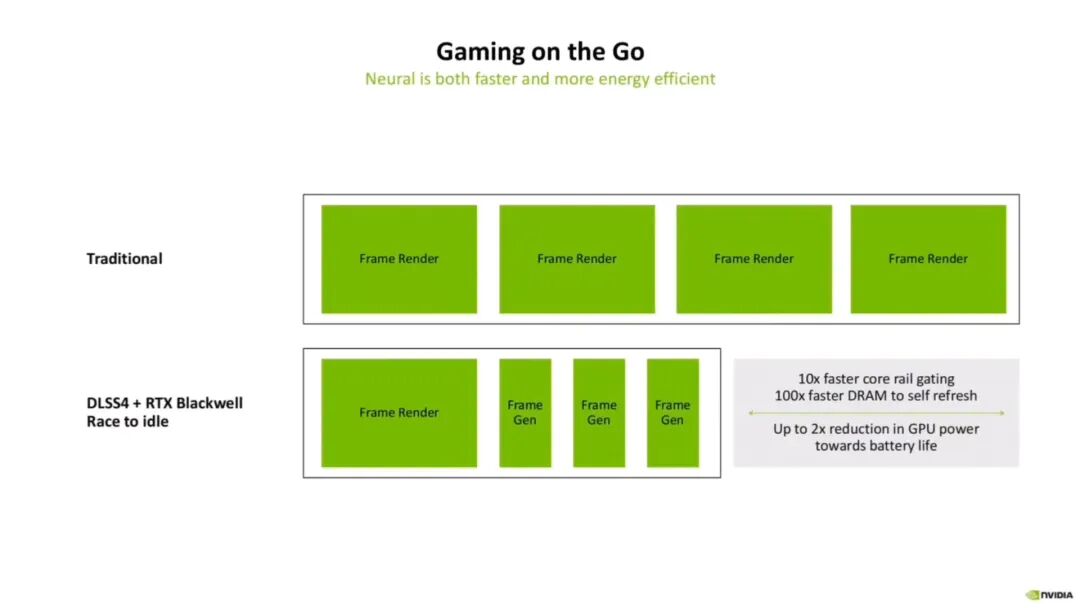

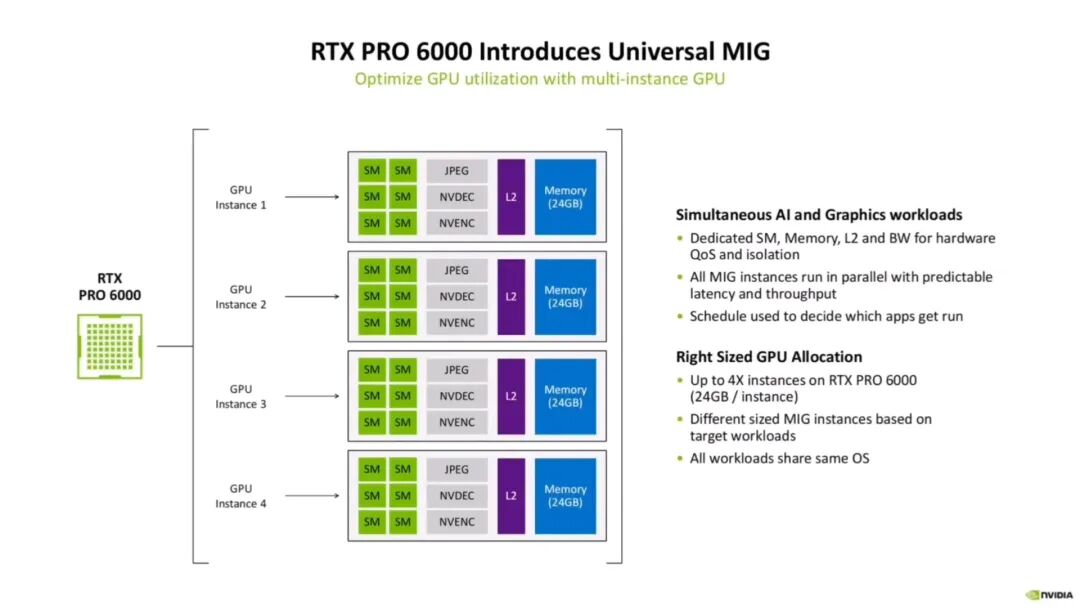

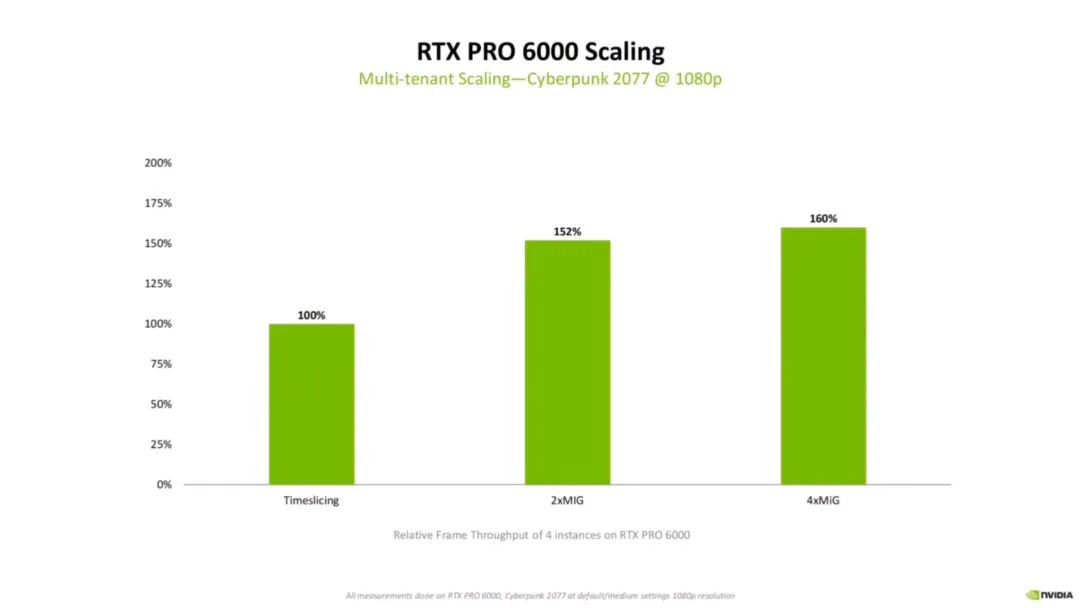

- 能效与资源利用:帧生成技术(AI 生成中间帧),保证帧率下减半 GPU 功耗(适配移动设备、笔记本);支持 MIMD(通用多实例 GPU)—— 将一张 GPU 分成多个独立虚拟 GPU,同时运行多个工作负载;实例:RTX Pro 6000 处理 1080p 客户端负载时,拆成多个虚拟 GPU 并行执行,4 个 MIG 实例比传统时间切片(timeslicing)性能提升 60%。

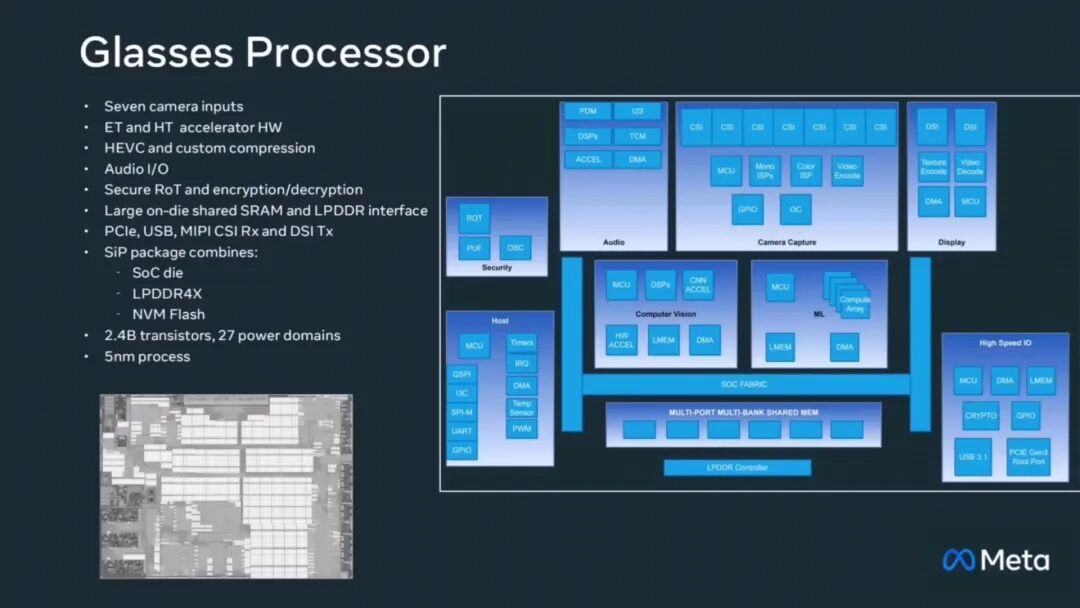

3. Meta Orion(AI 眼镜专用芯片)

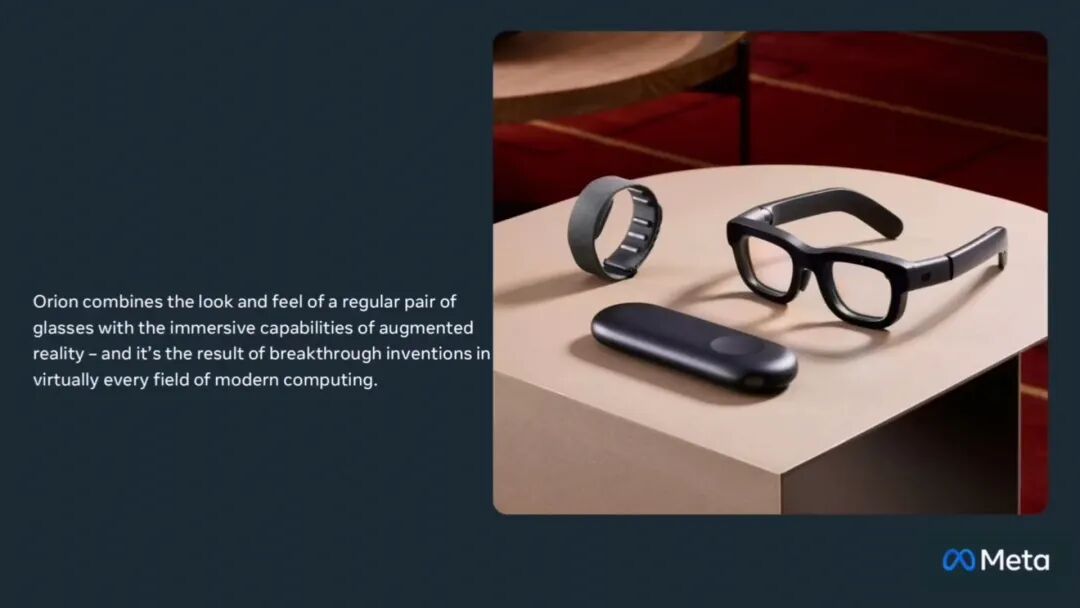

- 原型特点:普通眼镜外观 + AR 沉浸式功能,突破 AI 眼镜 “空间小、功耗低” 极限(眼镜功耗预算仅几瓦,但需实时处理眼动追踪、手势识别、WRL(世界锁定渲染))。

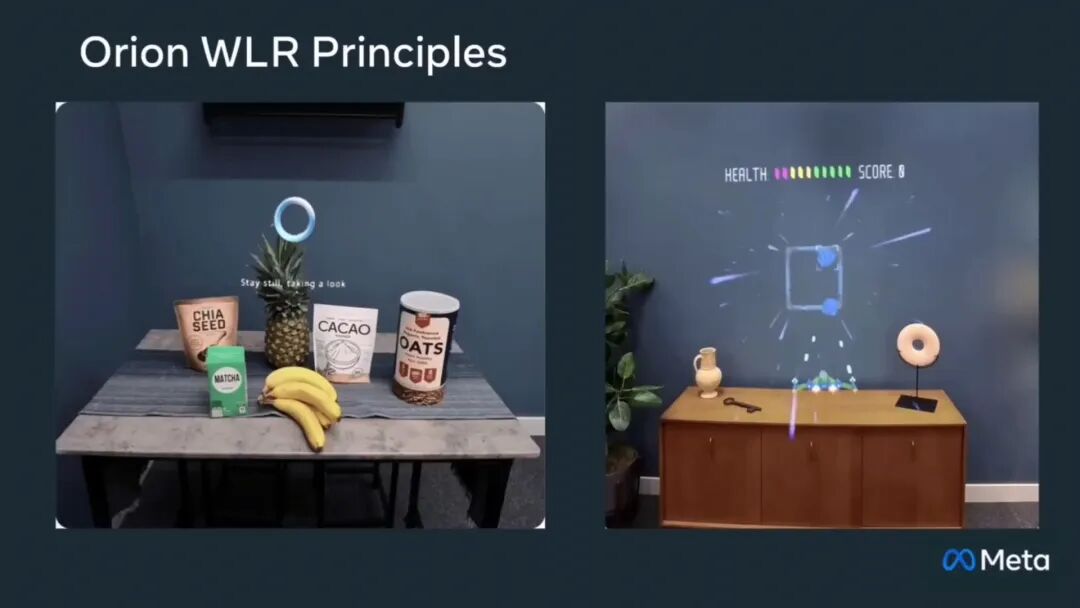

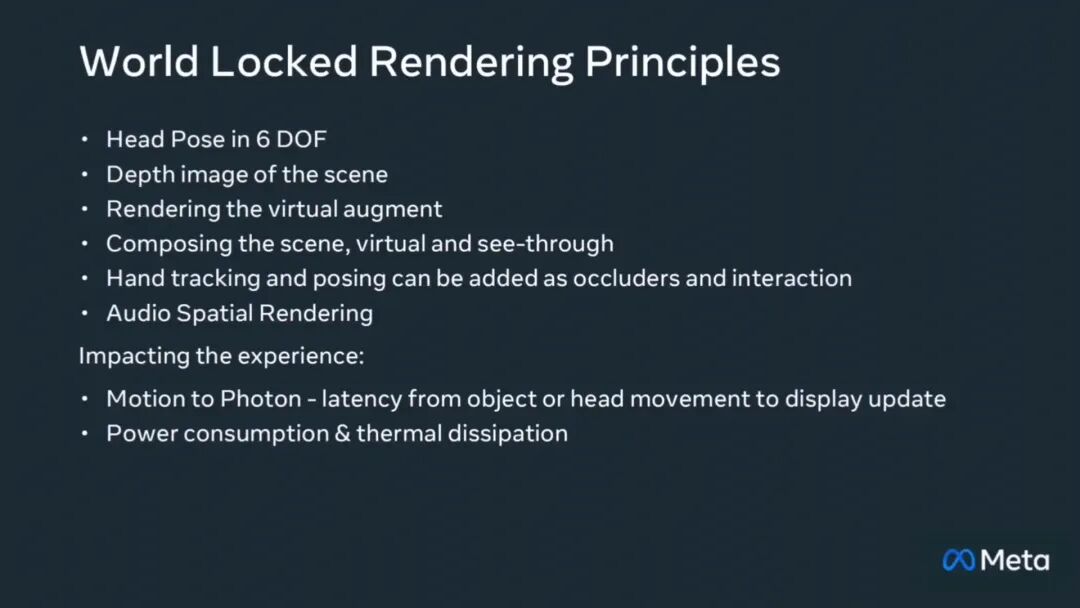

- 核心挑战:WRL(AR/MR 关键技术,将虚拟物体固定在现实世界特定位置,避免用户移动时 “飘”)—— 延迟超 20ms 用户眩晕,功耗高则续航短,需专用芯片加速。

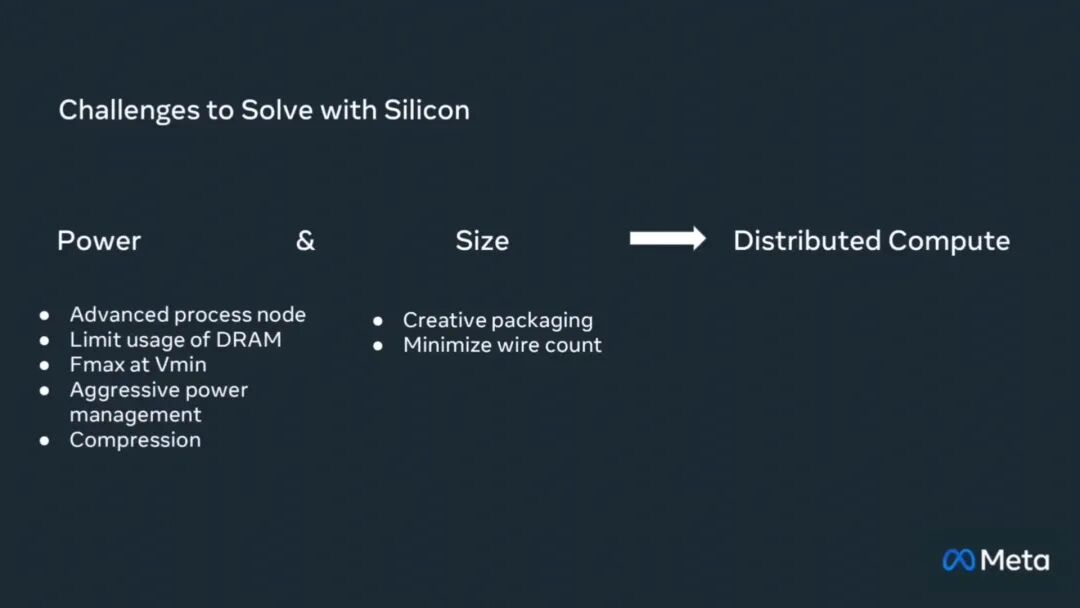

- 功耗与空间优化:

- 先进工艺:5nm 工艺(小面积集成大量晶体管,控功耗)。

- 内存策略:减少 DRAM 使用(DRAM 功耗高、体积大),尽量用片上 SRAM 存储数据。

- 电压与管理:Vmin Fmax 优化(保证性能下降低最小工作电压,减静态功耗);动态电源管理与数据压缩(按任务负载调电压频率,压缩数据传输量)。

- 封装与设计:创意封装(如 SiP)减体积,优化引脚设计减线数(降干扰和功耗)。

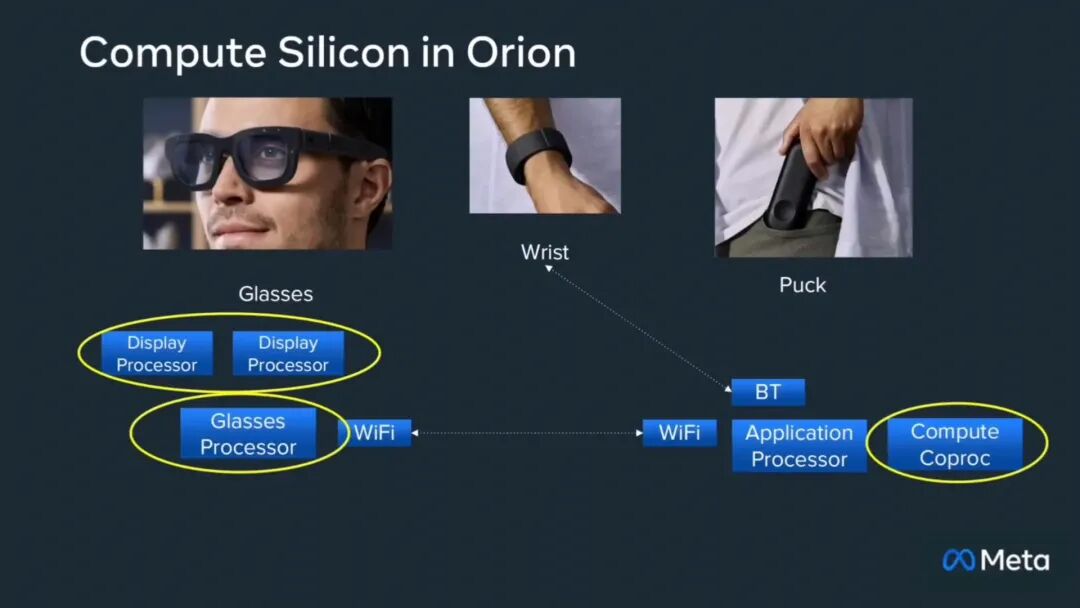

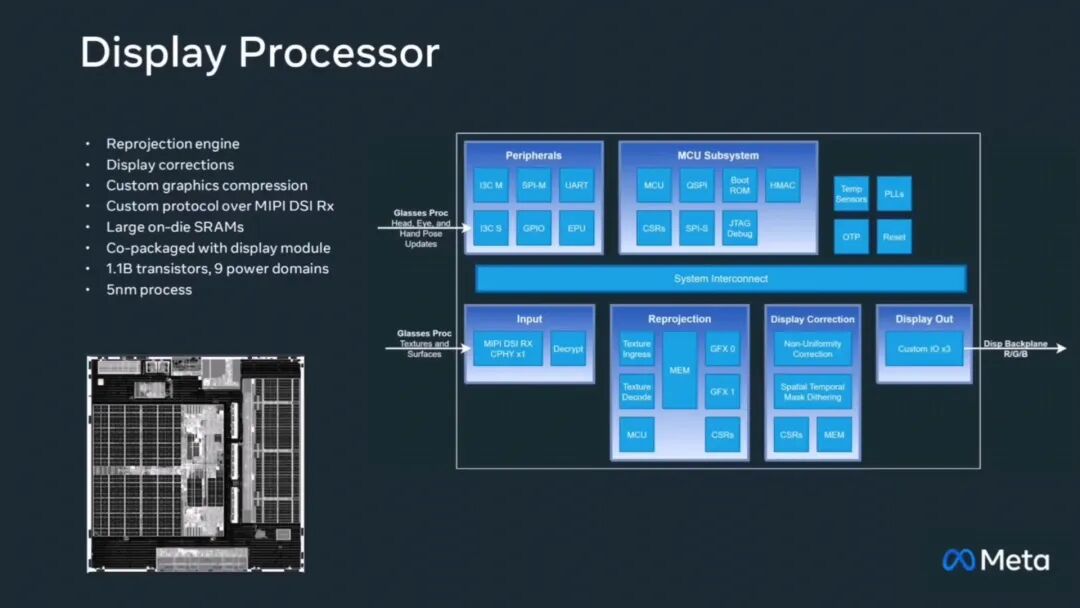

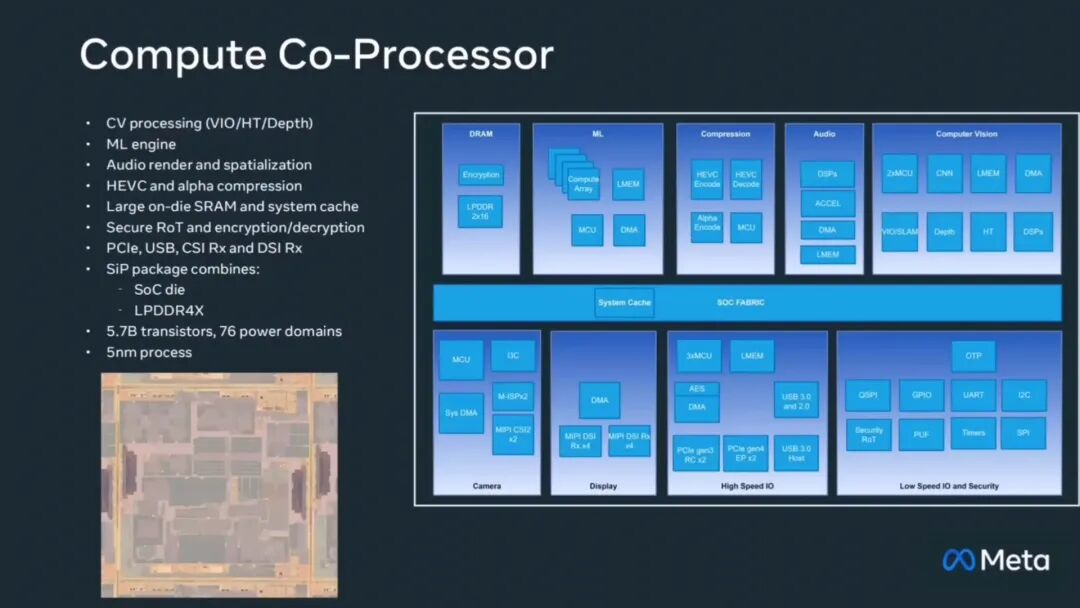

- 任务拆分与硬件:

- 显示处理器:每只眼睛对应一个,负责重新投影 / 时间扭曲(根据用户实时位置调整图像视角,确保虚拟与现实对齐);无外部存储器,数据存片上 SRAM(避 DRAM 延迟功耗)。

- 眼镜处理器:处理眼动、手部追踪及摄像头输入;SiP 封装,5nm 工艺,集成 24 亿晶体管(眼镜芯片中晶体管数量领先)。

- 计算协处理器:5nm 工艺,配 LPDDR4X 内存,集成 57 亿晶体管;负责计算机视觉、机器学习、音频渲染、HEVC 编码(如手势识别 AI 推理);大尺寸片上 SRAM 缓存(减内存访问延迟)。

- 负载分配:重负载(复杂 AI 推理)放外部 Puck 设备,眼镜本地处理低延迟任务(WRL、眼动追踪),平衡功耗、体积与实时性。

- Puck 设备芯片:包含三个主要处理芯片, 分别是显示处理器、眼镜处理器和计算协处理器,眼镜处理器负责处理所有的眼动、手部追踪以及摄像头输入,采用系统级封装SiP,5nm工艺,集成24亿颗晶体管。

- 安全:芯片植入 “安全信任根”,确保进出数据加密;Puck 设备图像为 HEVC 编码,眼镜处理器需几毫秒内完成 “解码→重新编码为显示处理器专有格式”,解码性能要求高。

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2025-09-10,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读

目录