DINOv3:无需标注的视觉革命,如何用16.89亿图像重塑AI未来

DINOv3:无需标注的视觉革命,如何用16.89亿图像重塑AI未来

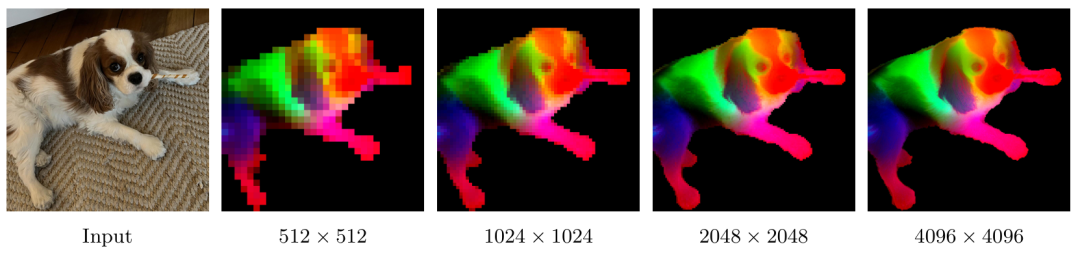

图:DINOv3在4096×4096超高分辨率下的特征表现。通过PCA将特征映射为RGB,清晰展示了模型对细节的精准捕捉能力

一、数据说话:DINOv3的硬核实力

"无需人工标注,仅通过观察世界就能理解万物"——这不是科幻小说,而是Meta最新发布的DINOv3视觉基础模型已经实现的突破。与传统依赖人工标注的模型不同,DINOv3从16.89亿无标签图像中自主学习,却在多项任务上超越了需要大量标注数据的专家模型。

关键性能指标对比表

任务/数据集 | DINOv3 | 最佳竞争对手 | 提升幅度 |

|---|---|---|---|

ADE20k语义分割 | 63.0 mIoU | DINOv2 | +6.1 mIoU |

Met艺术作品检索 | 85.9 GAP | DINOv2 | +10.8分 |

AmsterTime历史匹配 | 85.9 mAP | AM-RADIO | +7.6分 |

细粒度分类(Fine-S) | 87.0% | SigLIP 2 | +1.3% |

COCO目标检测 | 66.1 mAP | InternImage-G | 新SOTA |

★行业专家评价:计算机视觉专家李教授表示:"DINOv3的最大突破在于证明了自监督学习可以达到甚至超越监督学习的性能边界,这将彻底改变AI开发范式。"

二、技术揭秘:DINOv3的三大核心突破

1. 智能数据引擎:从170亿图像中提炼精华

DINOv3团队面临的首要挑战:如何从海量无序图像中提取有效信息?他们从Instagram公共帖子中收集了约170亿图像,通过创新的分层k-means聚类和平衡采样算法,构建了高质量数据集LVD-1689M。

图:不同数据整理方法对比。DINOv3的数据混合策略在IN1k k-NN、IN1k Linear等多项指标上表现最佳

关键创新点:

- 将高质量数据集(ImageNet1k)与网络爬取数据按10%:90%比例混合

- 采用分层采样确保各类别均衡覆盖

- 通过检索和聚类技术消除数据冗余

2. Gram锚定:解决大规模训练的致命难题

在训练7B参数模型时,研究人员发现一个致命问题:随着训练时间延长,模型的密集特征图质量会逐渐下降,导致分割、深度估计等任务性能衰退。

DINOv3团队创新性地提出"Gram锚定"技术:

- 计算特征图的Gram矩阵(空间相关性)

- 使用7B教师模型作为Gram教师提供稳定参考

- 通过损失函数约束学生模型保持空间一致性

"这一技术使模型在长时间训练后仍能保持高质量特征表示,"DINOv3论文第一作者解释道,"没有它,模型在密集预测任务上的性能会显著下降。"

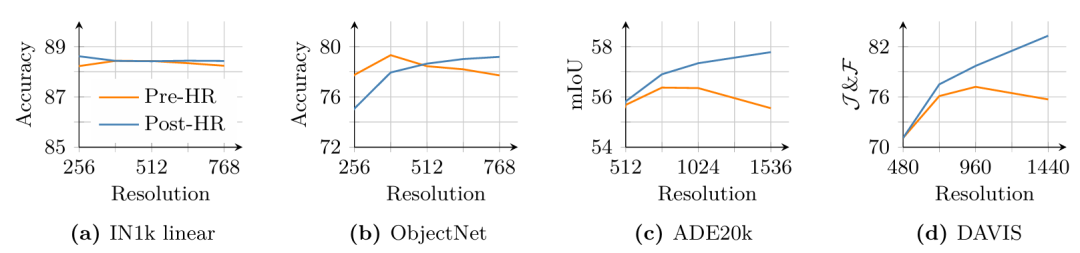

3. 高分辨率适应:突破视觉理解的天花板

现代视觉应用往往需要处理512×512甚至更高分辨率的图像。DINOv3通过混合分辨率训练策略,确保模型在各种分辨率下都能保持高性能:

- 在训练小批次中动态采样不同分辨率(512×512至768×768)

- 采用Gram锚定技术维持高分辨率特征质量

- 特别优化了4096维输出处理能力

图:高分辨率适应(HR)前后的性能对比。在ADE20k分割任务上,mIoU从58.1提升至63.0

三、实战表现:超越专家模型的全能选手

1. 语义分割:无需微调即达SOTA

在ADE20k基准测试中,仅使用冻结的DINOv3骨干网络,配合简单的Mask2Former解码器,就达到了63.0 mIoU,与需要微调的ONE-PEACE持平,大幅超越其他模型。

更令人惊讶的是:

- 在COCO-Stuff上达到53.5 mIoU,比之前SOTA高3.1点

- 在VOC 2012上达到82.3 mIoU,提升4.5点

- 无需对骨干网络进行任何微调,大大节省计算资源

2. 树冠高度估计:卫星图像分析新标杆

DINOv3团队将模型应用于卫星图像分析,在树冠高度预测任务中取得了突破性成果:

模型 | SatLidar Val (MAE) | SatLidar Test (MAE) | Sao Paulo (块R²) |

|---|---|---|---|

DINOv3 Sat | 2.25 | 2.56 | 0.68 |

Tolan et al. | 2.38 | 2.61 | 0.65 |

DINOv2 | 2.41 | 2.69 | 0.63 |

★"DINOv3卫星模型在所有基准测试上都取得了最先进性能,"论文指出,"这对于全球碳监测和森林管理至关重要。"

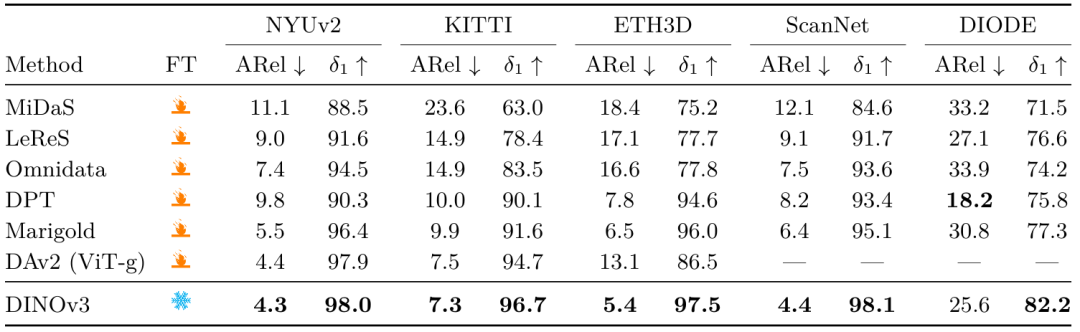

3. 3D理解:单目深度估计的新高度

将DINOv3集成到Depth Anything V2管道中,仅使用冻结的骨干网络,就在多个深度估计基准上达到SOTA:

表:DINOv3在NYU Depth v2、KITTI等深度估计基准上的表现全面超越现有方法

关键优势:

- 无需对骨干网络进行微调(其他方法都需要)

- 继承了DINOv2强大的模拟到现实(sim-to-real)能力

- 在所有数据集上达到新的最先进水平

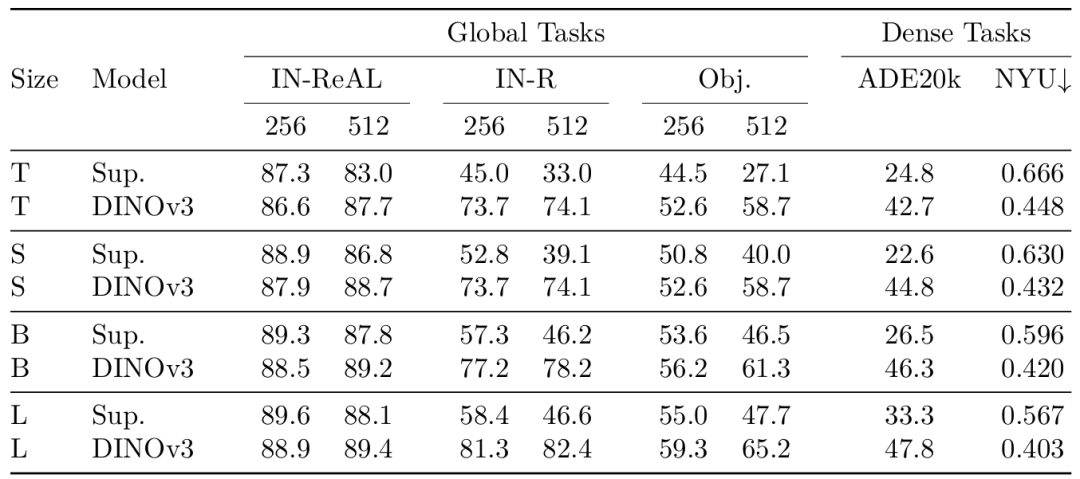

四、模型家族:满足不同场景需求

考虑到不同应用场景对计算资源的需求差异,DINOv3团队推出了完整的模型家族:

ViT系列:从紧凑型到超大规模

模型 | 参数量 | ADE20k mIoU | ImageNet k-NN |

|---|---|---|---|

ViT-S | 2100万 | 52.8 | 84.6 |

ViT-B | 8600万 | 56.3 | 86.7 |

ViT-L | 0.3B | 58.9 | 87.2 |

ViT-H+ | 0.8B | 61.5 | 87.5 |

ViT-7B | 6.7B | - | 88.9 |

ConvNeXt系列:边缘设备的理想选择

模型 | 参数量 | ADE20k mIoU | 相比监督模型提升 |

|---|---|---|---|

CNX-T | 2800万 | 42.7 | +17.9 mIoU |

CNX-L | 10000万 | 47.8 | +14.5 mIoU |

★特别亮点:将7B参数的ViT模型知识蒸馏到ConvNeXt架构,实现了性能与效率的完美平衡。"这连接了两种根本不同的架构,"论文强调,"突显了我们蒸馏过程的多功能性和有效性。"

五、真实挑战:DINOv3的局限性

尽管DINOv3表现出色,但了解其局限性同样重要:

1. 计算资源门槛

- 7B参数模型需要至少48GB显存才能运行

- 训练需要256个GPU,耗时数周

- 对中小企业构成实际部署挑战

2. 特定任务表现

- 在OCR密集型任务上,仍落后于弱监督模型约10个百分点

- 对于某些高度专业化的医学影像任务,仍需领域微调

3. 训练复杂性

- 大规模训练中出现的"高范数补丁异常值"问题

- 需要Gram锚定等特殊技术维持特征质量

- 高分辨率适应增加了训练复杂度

"没有完美的模型,"DINOv3团队坦言,"我们的目标是提供一个通用基础,让研究者和开发者能够在此基础上针对特定需求进行优化。"

六、实践指南:如何开始使用DINOv3

1. 入门路径建议

开发者类型 | 推荐模型 | 上手难度 | 适用场景 |

|---|---|---|---|

初学者 | ViT-S | ★★☆☆☆ | 图像分类、简单分割 |

中级开发者 | ViT-B | ★★★☆☆ | 目标检测、细粒度分类 |

高级研究者 | ViT-L/ViT-H+ | ★★★★☆ | 高精度分割、3D理解 |

资源受限环境 | CNX-T/CNX-L | ★★☆☆☆ | 边缘设备、移动应用 |

2. 快速上手资源

- GitHub仓库:https://github.com/facebookresearch/dinov3

- Hugging Face模型:https://huggingface.co/facebook/dinov3-small

- Colab示例:DINOv3入门教程

- 预训练模型下载:官方模型库

3. 实战小技巧

- 从高分辨率开始:对于分割等密集任务,直接使用512×512输入

- 善用特征金字塔:结合不同层的特征提升性能

- 冻结骨干网络:大多数任务无需微调骨干网络

- 尝试测试时增强:在关键任务上使用多尺度推理提升3-5%性能

七、未来展望:自监督学习的新纪元

DINOv3的成功预示着计算机视觉的范式转变:

- 数据民主化:摆脱对人工标注的依赖,使AI技术能扩展到更多缺乏标注数据的领域

- 模型通用化:单一模型可服务于多种任务,降低开发和部署成本

- 跨域迁移:从自然图像到卫星图像,模型展现出惊人的适应能力

- 终身学习:SSL不需要人工干预,非常适合在不断增长的网络数据中进行持续学习

★行业洞察:据Gartner预测,到2026年,70%的视觉AI应用将采用自监督学习技术,较2023年增长4倍。DINOv3开源的战略意义在于:通过降低技术门槛,构建更广泛的视觉AI生态系统。

结语:观察世界,理解世界

DINOv3不仅是一项技术突破,更是AI发展哲学的转变——让机器像人类一样,通过观察世界来理解世界。正如论文中所说:"自监督学习特别适合于训练可用的大量观测数据",这为AI在科学发现、环境保护等领域的创新应用打开了无限可能。

"我们的目标不是取代专业模型,而是提供一个通用基础,让研究者能够专注于解决实际问题,"DINOv3团队表示,"当AI不再被标注数据所束缚,创新的边界将无限扩展。"

思考题:您的行业是否面临数据标注成本高的问题?DINOv3的自监督学习方法可能带来哪些变革?欢迎在评论区分享您的见解!