AI工程师必读:深入浅出,掌握视觉语言模型(VLM)的方方面面

原创AI工程师必读:深入浅出,掌握视觉语言模型(VLM)的方方面面

原创

聚客AI

发布于 2025-09-22 17:53:47

发布于 2025-09-22 17:53:47

本文较长,建议点赞收藏,以免遗失。

随着AI大模型的迅速发展,深入理解视觉语言模型(Vision-Language Model, VLM)的技术内核与发展现状是至关重要的。VLM标志着多模态人工智能的一个重要突破,它使模型能够同时处理图像与文本,从而完成更接近人类认知的复杂任务。今天我将基于行业技术文档,系统梳理VLM的核心机制、优化方法、评测体系及当前挑战,希望能帮助到各位。

一、什么是VLM大模型

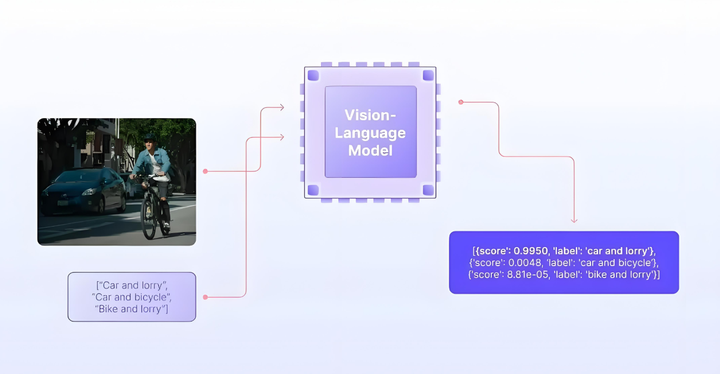

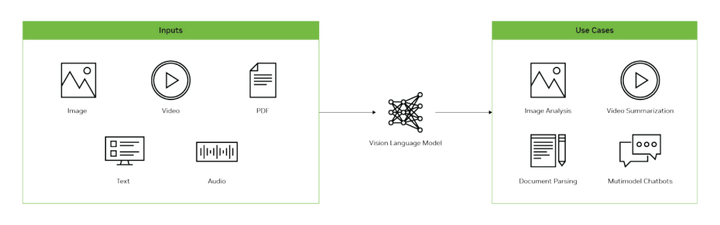

VLM是一种能够同时处理和理解图像与文本的人工智能模型。它融合了计算机视觉(CV)与自然语言处理(NLP)技术,实现对多模态信息的联合理解与生成。与单模态模型(如纯文本LLM或纯视觉CNN)不同,VLM可接受图像和文本作为输入,并输出文本或其他形式的响应,典型任务包括:

- 视觉问答(VQA):根据图像内容回答自然语言问题;

- 图像描述生成:为输入图像生成文本描述;

- 多模态对话:支持基于图像内容的连续对话。

VLM极大地拓展了AI在自动驾驶、智能助理、创意生成等领域的应用潜力。

二、VLM的工作原理

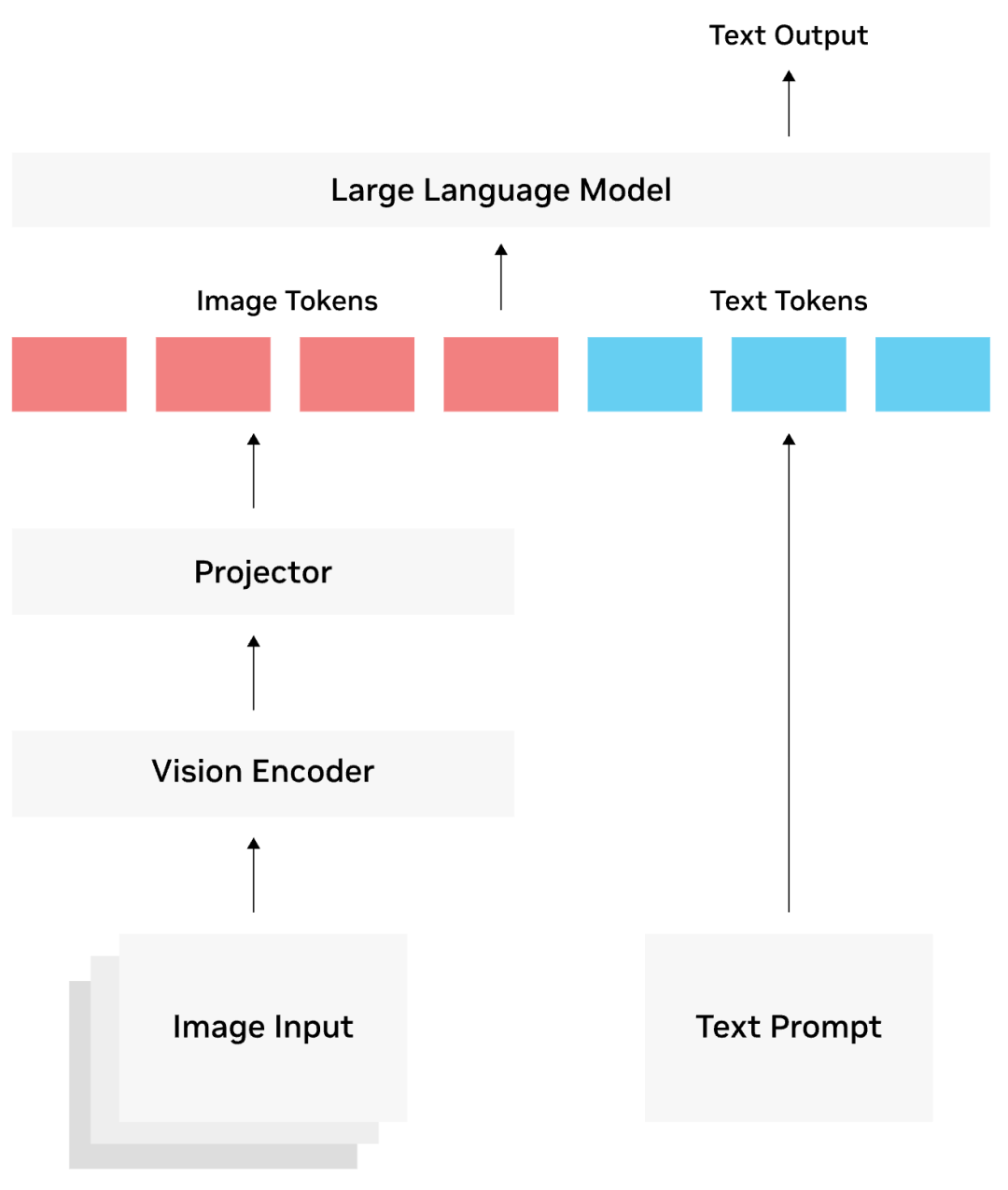

VLM的核心是将视觉和文本信息映射到同一语义空间,使语言模型能够“理解”图像内容。其结构通常包括三部分:

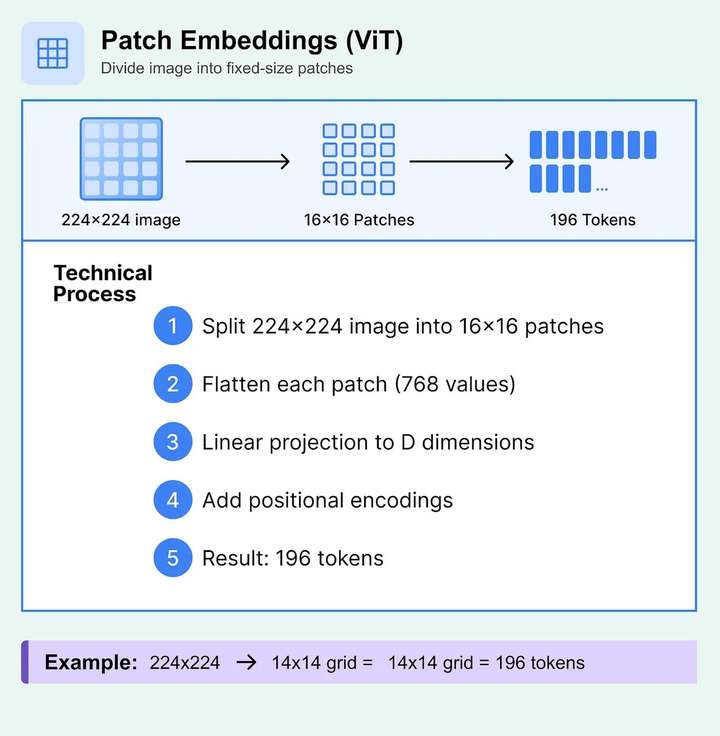

视觉编码器(Vision Encoder): 使用预训练视觉模型(如ViT或CLIP的视觉编码器)将图像转换为特征向量(Embeddings),捕获关键视觉信息。

ps:关于ViT具体的工作原理,我之前有写过一个详细的技术文档,这里就不过多去说了,粉丝朋友自行查阅:《如何处理图像、音频等让LLM能识别理解?》

语言模型(Language Model): 作为VLM的推理核心,常用大型预训练语言模型(如Llama、Gemma等)处理文本并生成响应。

连接模块(Connector/Projector): 通常为轻量级神经网络(如MLP),负责将视觉特征向量投影到语言模型的嵌入空间,实现模态对齐。

工作流程:

- 图像通过视觉编码器提取特征;

- 文本通过分词和词嵌入转换为向量;

- 连接模块将图像特征与文本特征融合为统一输入序列;

- 语言模型基于该序列生成文本输出。

三、VLM的推理逻辑

VLM推理分为两个阶段:

Prefill(预填充)阶段:

- 图像与文本输入被编码并融合为统一序列;

- 模型计算整个序列的Key-Value Cache(KV Cache),存储上下文信息;

- 该阶段计算密集,但仅执行一次。

Decode(解码)阶段:

- 基于KV Cache,模型以自回归方式逐个生成输出Token;

- 每生成一个Token,便更新KV Cache,逐步构建完整响应;

- 该阶段循环执行直至生成结束符或达到长度限制。

四、VLM推理优化方法

为提升推理效率与资源利用率,常采用以下优化策略:

KV Cache优化: 使用PagedAttention管理内存,避免显存碎片;对图像Token的K/V进行压缩或共享,减少冗余。

ps:这里如果你对KV Cache工作原理不理解,建议粉丝朋友看看我之前写的文档:《小白也能看懂的LLMs中的KV Cache,视觉解析》

连续批处理(Continuous Batching): 动态调度请求,提高GPU利用率与系统吞吐量。

视觉Token优化: 通过剪枝、合并或自适应数量控制,减少不必要的图像Token数量。

模型量化: 将模型权重与激活值转换为INT8/INT4格式,降低显存与计算开销。

并行计算与推理引擎: 采用Tensor Parallelism、Pipeline Parallelism等并行策略,并借助vLLM、TensorRT-LLM等高性能推理引擎加速。

五、VLM的测试方法

VLM测试需兼顾功能正确性与推理性能:

1. 功能正确性测试

单元测试:验证视觉编码器、连接模块等组件的输出是否符合预期;

端到端测试:构建涵盖VQA、图像描述等任务的测试集,使用关键词匹配或LLM-as-Judge(如GPT-4作为裁判)评估输出质量;

回归测试:确保模型迭代中核心功能不退化。

2. 推理性能测试

关键指标:

- 延迟:Time to First Token(TTFT)与Time Per Output Token(TPOT);

- 吞吐量:Requests per Second(RPS)与Output Tokens per Second;

- 资源使用:GPU利用率与显存占用。

测试方法: 使用负载生成工具(如locust、k6)模拟并发请求,分析系统在不同负载下的性能瓶颈。

六、VLM的评测指标

为客观评估VLM能力,常用以下基准与指标:

- VQA-v2、TextVQA、GQA:用于视觉问答任务,评估答案准确性;

- MSCOCO Captions、NoCaps:评估图像描述生成质量,使用BLEU、CIDEr等指标;

- MMBench、MME、MMMU:综合评估模型在多模态感知、推理、专业领域理解等方面的能力;

- POPE:专门用于检测模型是否产生视觉幻觉(Hallucination);

- 开源工具:如VLMEvalKit,支持超过80个VLM的一键式评测。

七、当前挑战与未来方向

尽管VLM发展迅速,仍面临多项挑战:

- 视觉幻觉:模型可能生成图像中不存在的细节;

- 细粒度理解不足:对物体细节、空间关系的识别仍不精确;

- 视频处理困难:时序建模与高计算成本限制了对视频的理解;

- 数据偏见与安全:训练数据中的偏见可能导致模型输出不公平或有害内容;

- 评测体系局限:现有基准难以全面评估模型的创造力、推理能力与安全性。

笔者总结

视觉语言模型是推动多模态人工智能发展的关键力量。从基础结构、推理机制到优化与评测,VLM技术栈正在不断成熟。然而,视觉幻觉、细粒度理解、视频扩展及安全性等问题仍是未来研究的重点。随着这些挑战逐步被攻克,VLM有望成为构建下一代通用人工智能系统的核心组件。好了,今天的分享就到这里,我们下期见。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

评论

登录后参与评论

推荐阅读

目录