解决GRPO优势归因错误,Chunk-GRPO让文生图模型更懂"节奏"

解决GRPO优势归因错误,Chunk-GRPO让文生图模型更懂"节奏"

deephub

发布于 2025-11-15 11:52:32

发布于 2025-11-15 11:52:32

点击上方“Deephub Imba”,关注公众号,好文章不错过 !

文本到图像(T2I)生成模型的发展速度超出很多人的预期。从SDXL到Midjourney,再到最近的FLUX.1,这些模型在短时间内就实现了从模糊抽象到逼真细腻的跨越。但问题也随之而来——如何让模型生成的不仅仅是"一张图",而是"正确的那张图"?这涉及到如何让AI理解人类在审美、风格和构图上的真实偏好。

强化学习(RL)成为解决这个问题的关键技术。通过将人类偏好分数作为奖励信号,可以对这些大模型进行微调。群体相对策略优化(GRPO)是近期比较热门的方案。但清华大学和快手的研究团队最近发现,这个方法存在一个隐藏的根本性缺陷。

这个缺陷会让模型学错东西,即便最终生成的图像看起来还不错。论文"SAMPLE BY STEP, OPTIMIZE BY CHUNK: CHUNK-LEVEL GRPO FOR TEXT-TO-IMAGE GENERATION"提出了一个叫Chunk-GRPO的解决方案,思路直接并且效果出众,算是训练生成模型思路上的一次转向。

GRPO的问题:不准确的优势归因

要理解Chunk-GRPO做了什么,得先搞清楚现有方法的问题出在哪。论文把这个问题叫做"不准确的优势归因"(inaccurate advantage attribution)。

可以用一个类比来说明。假设你在教学徒做酸面团面包,整个流程有17个步骤。学徒做了两个面包——面包A各方面都很棒,面包B勉强及格。作为师傅,你给A打了高分(+10),给B打了低分(+2)。

标准GRPO的做法相当于告诉学徒:"面包A的每一个步骤都比B好。"它把最终的高分奖励追溯性地分配给制作A的所有17个步骤。

但实际情况可能是,做A的第3步时学徒差点打翻面团,而做B的第3步手法其实很标准。标准GRPO仍然会奖励A的糟糕第3步,惩罚B的正常第3步,就因为最终结果不同。这就是"不准确的优势归因"——模型被强化的某个具体动作,单独看其实是个错误。训练几千次之后,这种错误的反馈信号会让模型困惑,导致训练不稳定,效果也达不到最优。

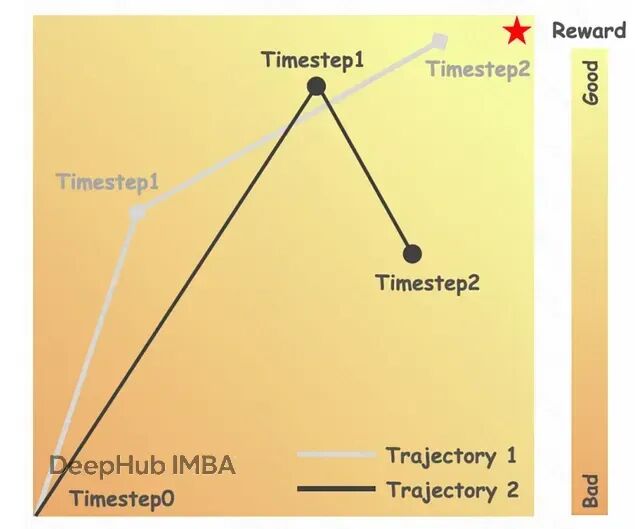

论文用图像生成的真实案例展示了这个问题:

轨迹1有更好的最终图像,但与轨迹2相比,有更差的中间步骤(t=1)。说明标准GRPO如何错误地奖励轨迹1中的坏步骤。

除了归因不准确,还有第二个相关问题:忽略时间动态。做面包的17个步骤重要程度其实不同——步骤1到5是建立面团基础结构,步骤6到12是发酵和发展,步骤13到17是烘烤收尾。每个阶段的作用和特点都不一样。

在基于流匹配(flow-matching)的T2I生成中也是类似的情况。模型从纯噪声开始,逐步细化成连贯图像。早期时间步决定整体构图和主体,做大幅度的粗调整;中间步骤细化形状,添加中等细节;最后的步骤打磨光照、纹理这些精细元素。标准GRPO对决定"这是只猫"的步骤和细化猫眼睛反光的步骤给予相同的优化权重,这既低效,也违背了生成过程本身的阶段性特征。

Chunk-GRPO的核心思路:按块而非按步优化

Chunk-GRPO的解决方案很简单:停止对每个步骤做微观管理,改为按阶段思考。不再评估每个单独的步骤,而是把相关步骤分组成"块"(chunk),对每个块的整体表现进行评估。

还是面包的例子。与其对17个步骤逐一反馈,不如评估三个阶段:混合揉面阶段(步骤1-5)面团基础建得怎么样?发酵整形阶段(步骤6-12)发酵控制和整形技巧如何?烘烤冷却阶段(步骤13-17)温度掌握和外皮发展是否到位?

在块级别优化的好处是,第3步那个小失误会被整个"混合揉面"块的表现平均掉。如果这个块里其他步骤都做得好,块整体还是算成功的。这种方法对偶发的孤立错误更加泛化,也更符合专家实际教学和学习复杂技能的方式——不是把知识切成无数个离散点,而是按连贯的多步骤动作来组织。

"动作分块"(action chunking)这个概念在机器人学等领域已经被证明很有效,能帮机器人学会流畅的长时程任务,而不是生硬的逐步动作。Chunk-GRPO论文是首次系统性地把这个思路应用到T2I模型的强化学习微调中。

具体机制上,Chunk-GRPO改变了优化目标。它不再为每个时间步t计算重要性比率(importance ratio,衡量策略变化的指标),而是为整个块j计算一个重要性比率,方法是取该块内所有步骤重要性比率的几何平均值。然后把最终的优势值(来自最终图像的奖励)应用到这个块级的单一数值上。

从步骤级到块级优化的转变直接缓解了不准确归因的问题。一个原本不错的步骤序列中出现的单个坏步骤,不会再获得不该有的奖励。优化信号变得更平滑也更稳定,能更真实地反映该生成阶段的实际贡献。

但这带来一个关键问题:怎么确定块的边界?是分3块、5块还是其他?每块大小要相同吗?论文的第二个巧妙之处就在这里。

时间动态引导的分块策略

如果随意把17个生成步骤分成4、4、4、5这样的块,确实已经比步骤级优化好了。并且论文的消融实验证实,几乎任何形式的分块都优于不分块。

但他们想知道:能不能找到一种有原则的方法来定义块边界?生成过程是否存在某种自然的内在结构可供参考?

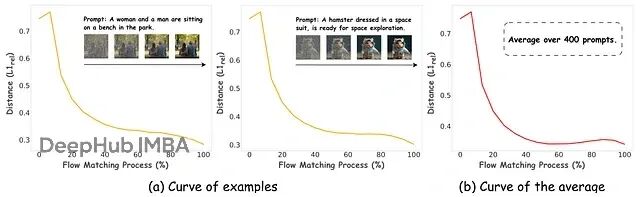

他们通过分析流匹配过程的时间动态(temporal dynamics)找到了线索。使用的指标是相对L1距离L1_rel,本质上衡量图像的潜在表示从一个时间步到下一步的变化幅度——高值表示剧烈变化,低值表示微调细化。

当把这个指标在FLUX.1模型的生成时间步上画出来时,他们发现了一个规律:

流匹配的提示不变时间动态,显示跨时间步的L1_rel距离曲线。曲线应该在开始时显示高值,在中间下降,在结束时上升。注释图表以显示生成的"阶段":"结构定义"、"细化"和"细节刻画"。

图表显示出清晰、一致且与提示无关的模式。不管模型生成的是"一只猫坐在垫子上"还是"火星上降落的宇宙飞船",创作的节奏都是一样的。

早期时间步的L1_rel值很高,模型在做大幅度跳跃,把纯噪声转化为基本构图,这是粗略草图阶段。中间时间步L1_rel降低,变化变得细致,模型在细化形状、清理构图、填补细节,相当于上色和阴影阶段。后期时间步L1_rel可能再次上升,模型添加高频细节、纹理和最终光效,进入打磨阶段。

这个动态曲线提供了一种数据驱动的自然分割方式。作者据此实现了时间动态引导的分块(temporal-dynamic-guided chunking),在生成节奏发生变化的位置设置块边界。

针对17个采样步骤的实验,他们采用了4个块,大小分别是[2, 3, 4, 7]。这不是随便定的,反映的是模型自身的行为特征:块1(大小2)是定义宏观结构的初始混乱阶段;块2(大小3)和块3(大小4)是图像成型的核心细化期;块4(大小7)是添加细节和打磨输出的漫长收尾阶段。

这就是Chunk-GRPO的关键。它不只是简单地把步骤凑成组,而是把它们分成与模型内部工作流对应的、语义上有意义的阶段。就像听艺术家的创作过程,在每个主要阶段结束时给反馈,而不是每一笔都打断。

技术细节:从步骤级到块级的数学转换

对想深入了解的读者,这里拆解一下Chunk-GRPO的具体机制。得先看标准GRPO的目标函数。

步骤级GRPO的数学形式

在流匹配的标准GRPO中,策略(T2I模型,记为θ)通过最大化目标J(θ)来更新。简化后大致是这样:

J(θ) ≈ Σ_i Σ_t [ r_t^i(θ) * A^i ]这里i是给定提示下生成的每张图像的索引。t是时间步,从1到T。A^i是第i张图像的优势(advantage),通过比较最终图像的奖励与组内平均奖励计算得到。关键是,A^i对所有时间步t都相同——这就是"不准确优势归因"问题的数学体现。r_t^i(θ)是时间步t的重要性比率,衡量新策略θ相对旧策略θ_old在该步骤上的转换概率比值,反映策略的变化程度。

优化过程会推动策略增加那些导致高优势图像的步骤的概率。但因为A^i是常数,所有步骤都被同等地推动。

块级方案的重构

Chunk-GRPO重新定义了这个目标。不对每个时间步t求和,而是对数量更少的块j求和:

J(θ) ≈ Σ_i Σ_j [ r_j^i(θ) * A^i ]优势A^i还是一样的(基于最终图像),但重要性比率现在定义在块级别。论文把块级重要性比率r_j^i(θ)定义为该块内步骤级比率的几何平均:

r_j^i(θ) = ( Π_{t ∈ ch_j} r_t^i(θ) )^(1/cs_j)其中ch_j是块j包含的时间步集合,cs_j是块j的大小,Π表示连乘。

为什么这样更好?论文附录有数学分析,直观理解就是这种平均化过程提供了更平滑稳定的优化地形。通过几何平均,任何一个可能有噪声或者异常的单个r_t^i(θ)的影响都会被抑制。传回模型的梯度信号不再是一连串尖锐的、可能相互矛盾的步骤级指令,而是针对整个生成阶段的更平滑、更整体的引导。

论文附录的分析表明,在存在不准确优势归因的情况下,块级目标可以被证明比标准步骤级GRPO目标更接近"真实"目标,尤其是当块大小保持适度(比如5或更小)时。这为实验结果提供了理论支撑。

加权采样策略

作者还引入了一个可选的增强方案——加权采样策略(weighted sampling strategy)。

训练时为了提效,常见做法是只对每个训练样本的一部分时间步(或块)计算损失,通常采用均匀采样。但作者认为不同块在学习中的重要性不一样。

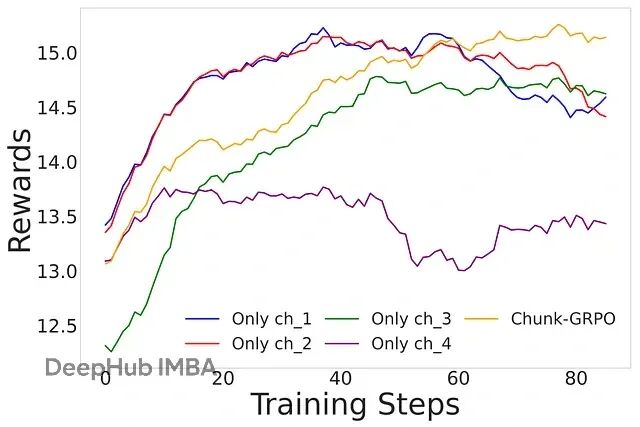

他们做了个消融实验,只训练某一个特定的块,结果发现优化早期的高噪声块(比如块1)带来的偏好分数提升最大,但也有不稳定的风险:

训练特定块的结果,显示训练单个块时的性能改进。图表应该显示训练早期块(ch1)给出高奖励但可能不稳定,而后期块(ch4)更稳定但改进较少。

基于这个发现,他们设计了加权采样方案,让训练过程更偏重那些平均L1_rel距离更高的块——也就是发生剧烈变化的阶段。策略目标是兼得两头:通过聚焦高影响区域来加速偏好对齐。

不过从结果看,这种能力是有代价的。可以把它理解为一个旋钮,调高能获得更好的偏好对齐,但有时会"破坏"图像的核心结构——典型的奖励黑客(reward hacking)现象。

实验结果:量化和视觉上的改进

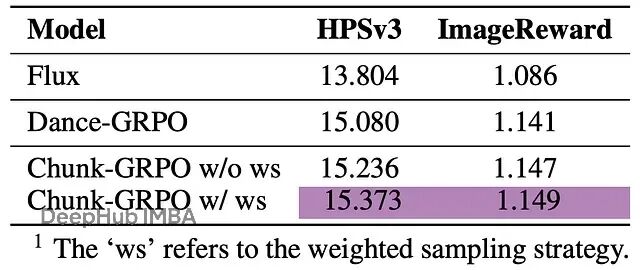

任何方法最终都要看输出质量。Chunk-GRPO在这方面表现不错,研究团队把它和基础FLUX.1模型以及标准步骤级Dance-GRPO做了对比。

数值指标

在偏好对齐基准测试上,Chunk-GRPO有明显提升:

偏好对齐的结果,显示HPSv3和ImageReward分数。使用清晰的标签,如"基础模型(FLUX.1)"、"标准RL(Dance-GRPO)"和"Chunk-GRPO"。突出显示Chunk-GRPO的获胜分数。

Chunk-GRPO在训练用的域内奖励模型(HPSv3)和域外模型(ImageReward)上都持续高于标准GRPO,说明改进具有泛化性,不是单纯针对测试调优。带加权采样的版本(w/ ws)把偏好分数推得更高。

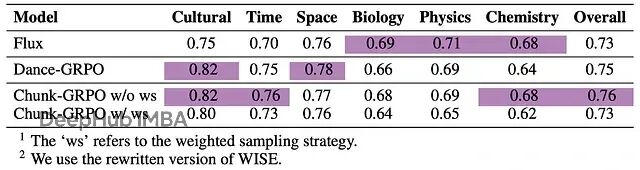

在WISE基准测试上,这个测试评估模型根据物理、生物、文化等领域的世界知识生成图像的能力,不带加权采样的Chunk-GRPO拿到了最高总分,展现出对语义概念更好的理解:

WISE的结果,显示WISE基准测试结果。再次强调Chunk-GRPO(w/o ws)获得了最高的"总体"分数。

有意思的是,加权采样策略在提升审美偏好的同时,在基于知识的WISE和指令遵循的GenEval基准上反而略有损失。这印证了前面提到的权衡:激进地优化"感觉"有时会牺牲语义准确性。对需要平衡这些竞争目标的实践者来说,这是个值得注意的发现。

视觉质量

数字之外,图像本身更有说服力。大量样本显示Chunk-GRPO生成的图像确实更好:

Chunk-GRPO显著提高了图像质量,特别是在结构、光照和细粒度细节方面,展示了块级优化的优越性。

和已经很强的基础模型及标准RL调优版本比,Chunk-GRPO的图像在结构和构图上更连贯、更有意图感;光照处理更戏剧化也更真实,对比度、阴影和高光的物理合理性更好;色彩更饱满,纹理更细腻,细节更丰富。

FLUX、DanceGRPO、不带时间动态的Chunk-GRPO、带时间动态的Chunk-GRPO和带加权采样的Chunk-GRPO之间的额外可视化比较。

论文也展示了失败案例。有个具有挑战性的提示,加权采样策略在激进追求更好外观时把提示中的关键对象给漏掉了。这种分析帮助理解模型的行为边界。

说明审美质量和语义准确性之间存在这种权衡,实际应用时如何调优,取决于具体场景的需求侧重。

未来方向和局限

Chunk-GRPO是个不小的进步,但论文作者也指出了后续研究的空间。

一个比较有吸引力的方向是超越单一奖励信号,在不同块之间使用异质奖励(heterogeneous rewards)。可以设想对早期结构块用关注构图正确性的奖励模型,对后期打磨块用关注照片真实感和精细细节的另一个奖励模型。这种做法更精细,也更像人类艺术指导的工作方式。

另一个改进点是分块策略本身。目前块边界是预先计算好的,训练时保持固定。更高级的系统可以实现自适应或动态分块(self-adaptive or dynamic chunking),让模型在训练过程中学习最优块边界,甚至针对不同提示做调整。

抛开这些具体扩展,Chunk-GRPO的核心理念——让优化过程与模型固有动态对齐——本身就很有价值。它提示应该把这些大型神经网络当作有自己内部逻辑的复杂系统来对待,学会配合它们工作,而不是简单粗暴地强行训练。

这项工作展现了AI研究有意思的地方:理论洞察、工程技巧和可见的最终效果结合在一起。从优化步骤转向优化块,不只是小的技术调整,而是在教AI艺术家按照更接近人类艺术家的方式思考——分阶段,有意图,按自然节奏来。结果确实更好看。

总结

T2I模型的标准RL方法有个"不准确优势归因"的毛病,把好图像的最终奖励错误地应用到每个生成步骤,包括那些有问题的步骤。这些方法还忽视了不同时间步在生成中的差异化作用。

Chunk-GRPO的解决办法是把连续时间步分组成"块",把这些块作为整体单元来优化,让训练信号更平滑,过程更稳定。块的划分不是随意的,而是由模型自身的"时间动态"决定——创作过程的自然节奏,通过图像在每步的变化幅度来度量。这让优化过程和模型的内部工作流保持一致。

实验结果显示Chunk-GRPO生成的图像在结构、光照和细节上都更优秀,在审美偏好和世界知识基准测试上的得分也高于标准方法。

这个思路开辟了新的研究方向,比如为不同块使用不同的奖励模型,或者开发能在训练中自适应的动态分块策略。

论文:

https://arxiv.org/abs/2510.21583

作者:ArXiv In-depth Analysis

喜欢就关注一下吧:

点个 在看 你最好看!

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2025-11-01,如有侵权请联系 cloudcommunity@tencent.com 删除

本文分享自 DeepHub IMBA 微信公众号,前往查看

如有侵权,请联系 cloudcommunity@tencent.com 删除。

本文参与 腾讯云自媒体同步曝光计划 ,欢迎热爱写作的你一起参与!

评论

登录后参与评论

推荐阅读

目录