AI大模型推理优化:KV缓存的“组合式复用”

AI大模型推理优化:KV缓存的“组合式复用”

数据存储前沿技术

发布于 2025-11-20 17:42:46

发布于 2025-11-20 17:42:46

阅读收获

- 洞察LLM推理瓶颈:理解大语言模型推理高成本和高延迟的根本原因,以及KV缓存复用在其中的核心作用。

- 识别传统缓存局限:认识到“前缀缓存”在RAG、长期记忆等非连续、组合式上下文场景下的失效机制,及其导致的“完全重新计算”困境。

- 掌握“组合式复用”新范式:学习Pliops提出的“组合式复用”方案,包括“选择性Token重计算”的“缝合”技术,以及“基于内容的块切分”、“数据块去噪”和“数据块驱逐”三大核心技术支柱。

- 理解存储系统新挑战:分析高性能LLM缓存对底层存储系统在小数据块、随机读写IOPS和容量方面提出的全新需求。

全文概览

随着大语言模型(LLM)在各行各业的广泛应用,其高昂的推理成本和显著的延迟已成为制约其规模化落地的主要瓶颈。在LLM的自回归特性中,高效复用“KV缓存”是降低成本、提升速度的关键。然而,您是否发现,在RAG(检索增强生成)、ReAct/RAISE或长期记忆等现代LLM应用场景中,传统的“基于前缀的KV缓存复用”方法正面临严峻挑战?这些应用往往需要动态、非连续地组合上下文,导致简单的前缀复用失效,进而不得不进行代价高昂的“完全重新计算”。本文将深入探讨这一“前缀假设”失效的困境,并介绍一种创新的“组合式复用”范式,以及它如何重塑LLM推理的效率边界,同时对底层存储系统提出哪些新的要求。

问题背景

KV缓存的复用至关重要

KV缓存的复用至关重要

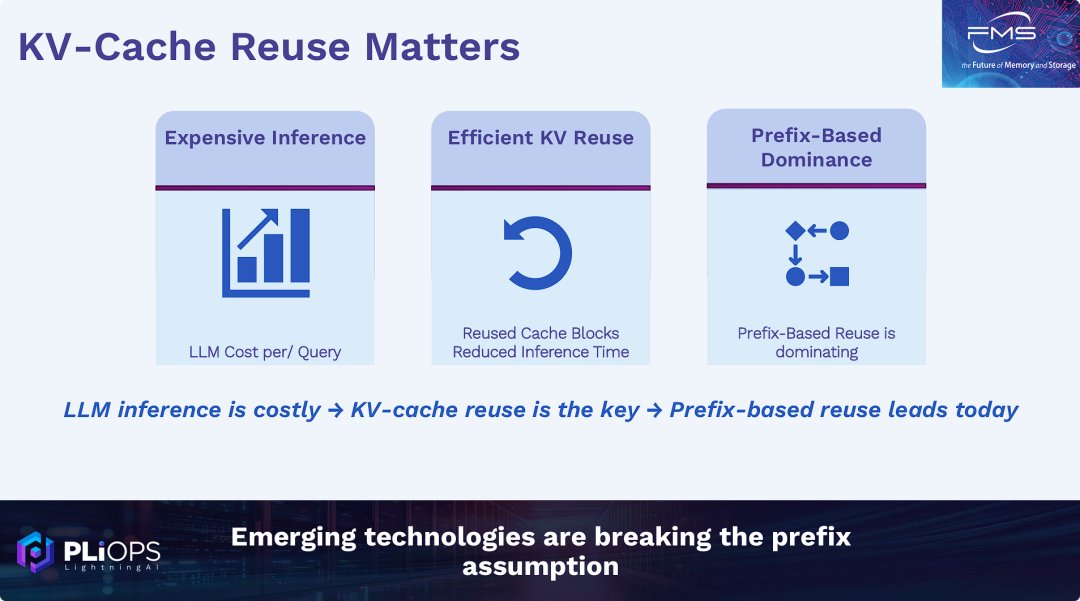

PPT的核心观点是:

- 问题: 大语言模型(LLM)的推理成本非常高(自回归特性)。

- 解决方案: 解决高成本和高延迟的关键在于高效地复用“KV缓存”(自注意力机制减少计算,产生KV缓存,以存换算)。

- 现状: 目前行业内主流的KV缓存复用技术是“基于前缀的复用”(Prefix-Based Reuse)。

- 未来趋势/挑战: 演讲者(PLIOPS)即将提出一个新观点,即“前缀假设”(认为基于前缀的复用总是最优的假设)正在被新兴技术所打破,预示着将有新的、可能更优的KV缓存管理技术出现。

Tip

“前缀缓存” (Prefix Caching) 指的是:

在LLM开始生成第一个词(这个阶段也叫 "Prefill" 或 "Ingestion")之前,系统会首先完整处理一遍用户输入的全部“前缀”(例如一个很长的问题或一段历史对话),并将这个“前缀”的全部KV缓存计算出来并存储好。

经典推理场景(非连续对话),基于此构建了 Prefix-Based Reuse

- 它假设上下文 (Context) 是单一、连续、固定不变的。

- 它假设一个会话的上下文总是

[固定的历史前缀] + [用户的新问题]。 - 因此,它只需要在KV缓存的末尾追加新内容即可,复用 Prefix 的KV缓存,节约计算资源。

定义问题

组合式上下文的LLM应用

组合式上下文的LLM应用

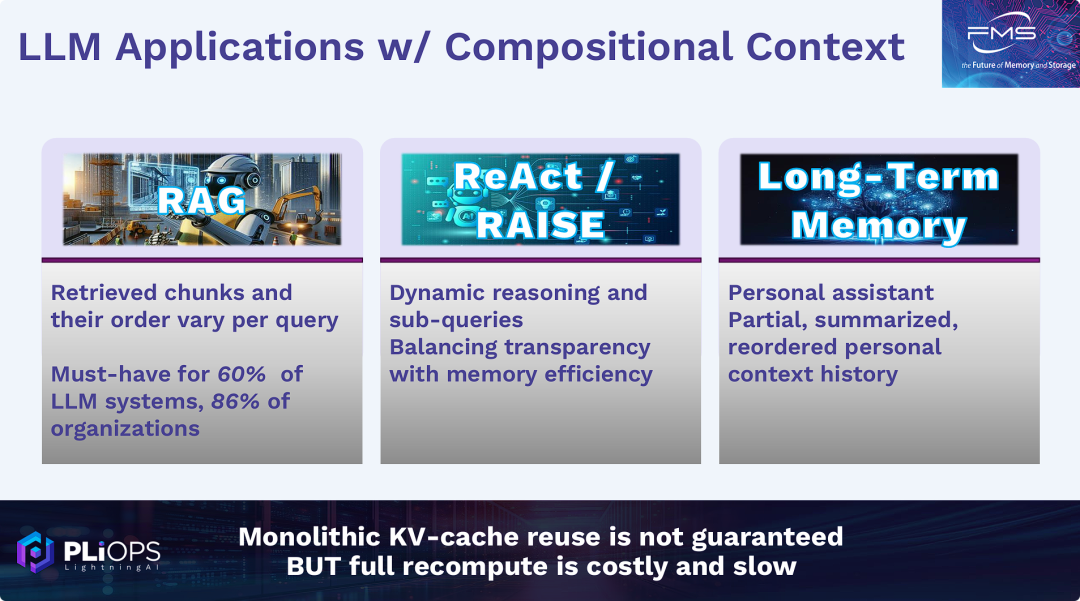

PPT的核心观点是:

- “前缀假设”失效: PPT列举了三种LLM应用场景(RAG、ReAct/RAISE、长期记忆)。

- 共同特性: 这三种应用的共同点是它们的上下文(Context)是“组合式”的(Compositional),而不是固定的。上下文可能是动态检索来的(RAG)、动态推理生成的(ReAct),或者是经过摘要和重排的(长期记忆)。

- 引出问题: 在这些场景下,传统“基于前缀”的KV缓存复用方法失效了(因为前缀不再固定不变,即“单体式KV缓存复用无法保证”)。

- 面临的困境: 如果不能复用KV缓存,就必须“完全重新计算”(Full Recompute),而这又会导致高昂的成本和缓慢的速度。

长期记忆的应用实例

长期记忆的应用实例

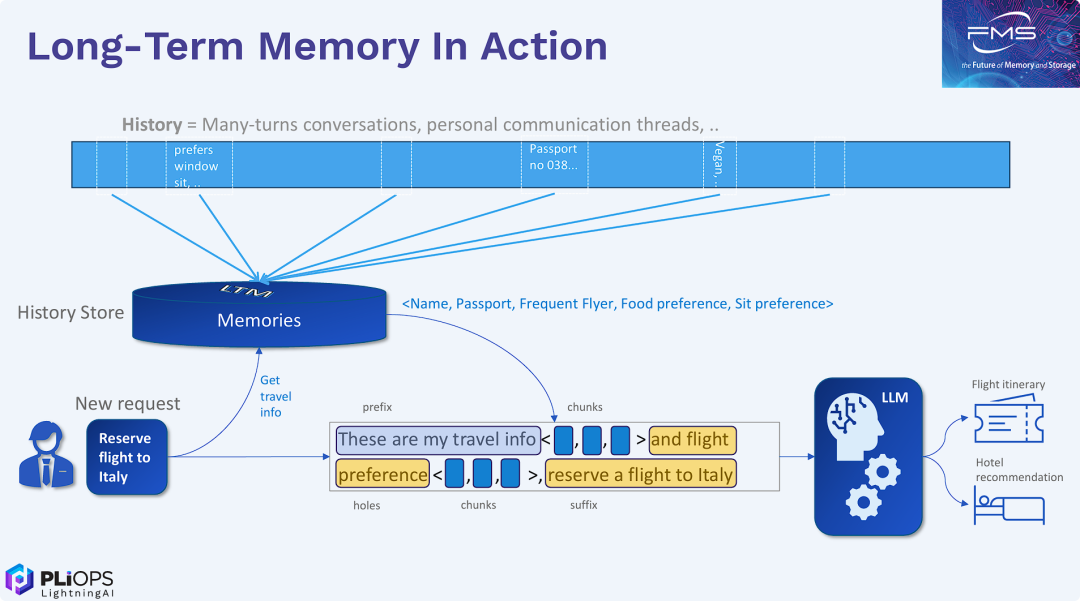

PPT的核心观点是详细拆解“长期记忆”应用传统的“前缀假设”。

- 上下文是动态组合的: 在RAG或长期记忆这类应用中,发给LLM的完整提示词(Context)不是一个固定的前缀加上新问题,而是通过一个 “模板”(Template)动态构建的。

- “空洞”与“注入”: 这个模板包含一个固定的 “前缀” (Prefix)、一个 “后缀” (Suffix)(即用户的新请求),以及两者之间的 “空洞” (Holes)。

- 非连续的KV缓存: 系统会根据新请求从“历史存储”中动态检索相关的 “数据块” (Chunks),并将其 “注入” (Inject) 到这些空洞中。

- 打破前缀假设: 这种“注入”操作导致了上下文的非连续性。虽然"前缀"部分的KV缓存可以被复用,但它与"后缀"部分的KV缓存在内存中不是连续的,因为中间插入了动态的“数据块”。这使得上一张PPT提到的“单体式/整体式KV缓存复用”(即简单的基于前缀的复用)变得无效。

方案概括

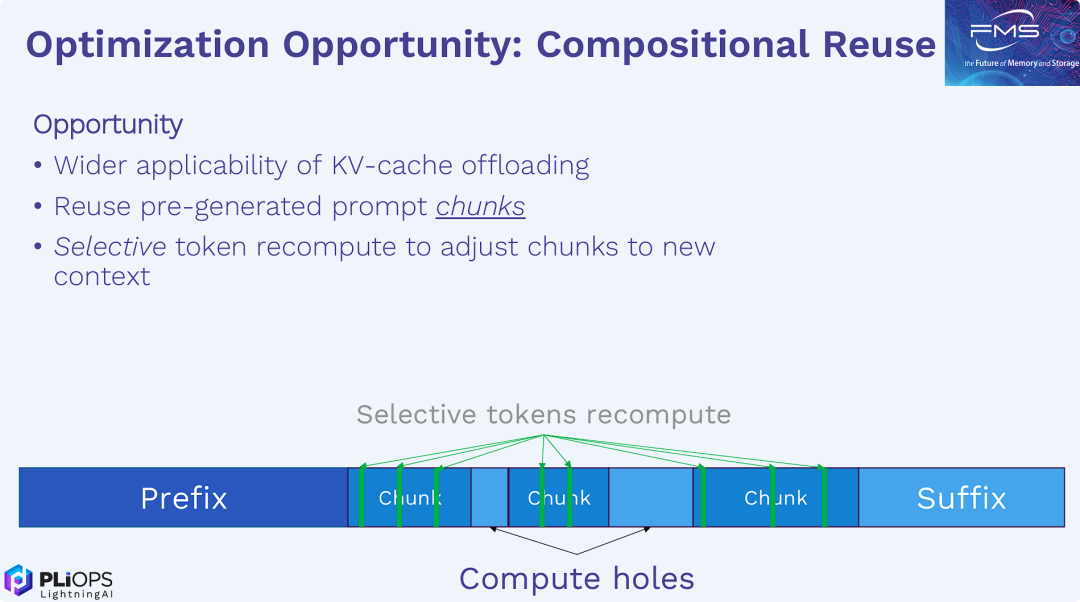

PPT提出了解决前几页所描述问题的核心方案:“组合式复用” (Compositional Reuse)。

- 问题的回顾: RAG和长期记忆等应用与经典的KV缓存调用逻辑存在矛盾,它们动态地将“数据块”(Chunks) 注入到“前缀”(Prefix) 和“后缀”(Suffix) 之间,导致KV缓存非连续(如图所示的 "holes")。

- 传统的困境: 要么完全重新计算(代价高昂且缓慢),要么(因为非连续性)无法使用简单的基于前缀的复用。

- 提出的解决方案 (组合式复用):

- 复用所有部分: 可以复用 "Prefix"、所有 "Chunks" 以及 "Suffix" 的预计算KV缓存。

- 解决非连续性: 关键的优化点在于,不需要为了连接这些块而重新计算所有内容。只需要执行 “选择性Token重计算” (Selective tokens recompute)。

- “缝合”上下文: 通过仅重新计算 "holes"(空洞)周围以及 "Chunks" 边缘的少量Token,系统就能正确理解它们之间的位置关系(positional encoding),从而将这些分离的缓存块“缝合”成一个连贯的上下文,供LLM的注意力机制(Attention)使用。

- 最终价值: 这种方法避免了“完全重新计算”的巨大开销,实现了对非连续、组合式上下文的高效KV缓存复用。

核心技术

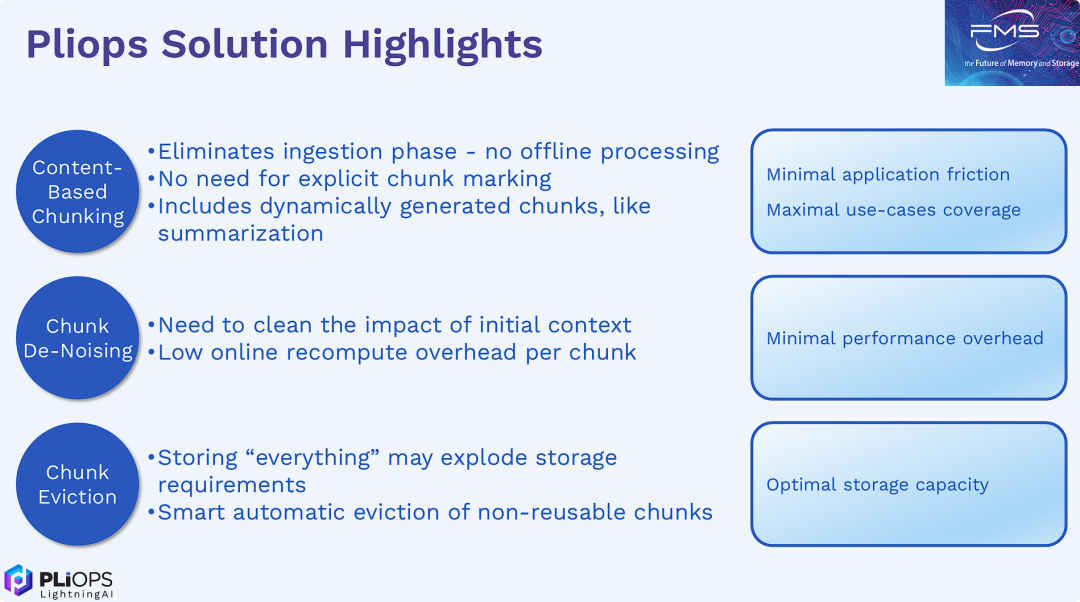

Pliops 解决方案亮点

Pliops 解决方案亮点

Pliops解决方案的核心技术阐述

它详细说明了Pliops如何实现(前几张PPT提出的)高效“组合式KV缓存复用”。

该方案主要依靠三大技术支柱:

- “基于内容的块切分” (Content-Based Chunking):解决了“复用什么”的问题。它能自动、实时地识别和创建可复用的KV缓存块(Chunks),无需人工干预,极大降低了集成难度。

- “数据块去噪” (Chunk De-Noising):解决了“如何复用”的问题。它通过低开销的在线处理,清除了缓存块中残留的“旧上下文”信息,使其能够干净地“缝合”到新的上下文中,从而保证了高性能。

- “数据块驱逐” (Chunk Eviction):解决了“存储成本”的问题。它通过智能的缓存淘汰策略,自动管理KV缓存的生命周期,防止存储空间无限膨胀,实现了最优的存储效率。

Success

“组合式重用”的核心创新是:

- 在推理层,用 “选择性Token重计算” (Selective recompute) 算法,代替了“完全重新计算”(Full recompute),实现了对非连续KV缓存块的低开销 “缝合” 与 “去噪”。

- 在数据层,用 “基于内容的自动分块” (Content-Based Chunking) 和 “智能驱逐” (Smart Eviction) 算法,解决了“哪些块值得重用”以及“如何高效管理海量缓存块”的难题。

总结

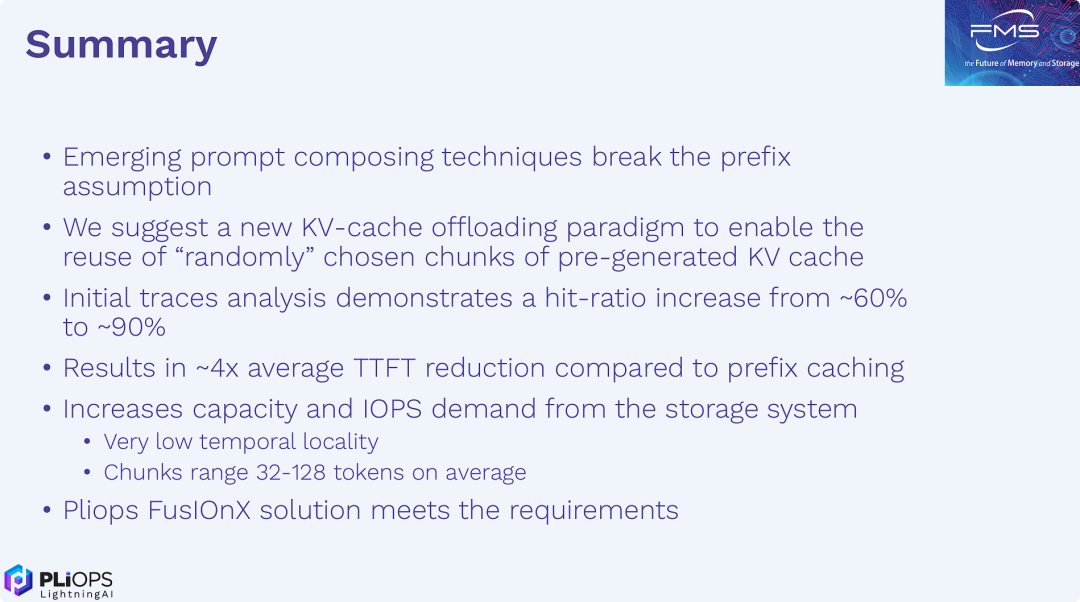

- 重申问题: 现代长上下文LLM应用(RAG等)使得传统“前缀缓存”失效。

- 提出Pliops的新范式: “组合式复用”——通过高效管理和复用非连续的、动态的KV缓存块(Chunks)。

- 展示巨大收益: 该范式能将缓存命中率从60%提高到90%,并带来4倍的TTFT(首个Token时间)降低。

- 识别新挑战: 这个方案的实现(KV缓存卸载)对存储系统提出了极高的小数据块、随机读写IOPS和容量需求。(LLM上下文的IO特征)

- 提供最终答案: Pliops的 "FusIOnX" 解决方案(一种存储加速技术)恰好能完美应对这一全新的存储挑战,从而使其提出的高性能LLM缓存范式得以真正落地。

延伸思考

这次分享的内容就到这里了,或许以下几个问题,能够启发你更多的思考,欢迎留言,说说你的想法~

- Pliops的“组合式复用”方案在实际部署中,如何平衡“选择性Token重计算”的开销与KV缓存的复用效率,以实现最佳的性能收益?

- 除了Pliops提出的存储加速技术,您认为还有哪些新兴的存储架构或技术路线能够有效应对LLM上下文的IO特征挑战,并支持未来更大规模的KV缓存卸载?

- 随着LLM上下文窗口的不断扩大,以及多模态LLM的兴起,KV缓存的管理和优化将面临哪些新的复杂性?“组合式复用”范式是否仍能保持其优势,或者需要进一步的演进?

原文标题:Beyond Prefix Caching[1]

Notice:Human's prompt, Datasets by Gemini-2.5-Pro

#FMS25 #KVCache优化

---【本文完】---

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2025-11-12,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读

目录