SC 25:哥伦比亚大学与 NVIDIA 联合提出 ACTINA框架,优化 OCS AI 网络性能与能效

SC 25:哥伦比亚大学与 NVIDIA 联合提出 ACTINA框架,优化 OCS AI 网络性能与能效

光芯

发布于 2025-11-26 18:58:27

发布于 2025-11-26 18:58:27

在AI大模型训练需求呈指数级增长的今天,数据中心的算力与功耗正逼近极限——据预测,到本十年末,AI工作负载的训练功耗需求可能激增200倍。传统数据中心依赖静态电分组交换(EPS)网络,存在高功耗、带宽弹性不足、链路利用率低等瓶颈,而光交换(OCS)凭借动态带宽分配、低功耗和多代带宽升级支持的优势,有望成为破解AI网络困境的关键技术之一。哥伦比亚大学Keren Bergman团队与NVIDIA联合提出的ACTINA框架,通过量化评估体系、创新重配置策略和高效拓扑设计,为大规模AI系统的光可重构网络提供了完整解决方案,其核心成果已在SC ’25会议上正式发布。

参考链接:

哥伦比亚大学SiPAM架构:硅光OIO+OCS构建高带宽内存池,支撑万亿级LLM迭代时间缩3.5倍+跨代兼容

该工作的贡献总结如下:

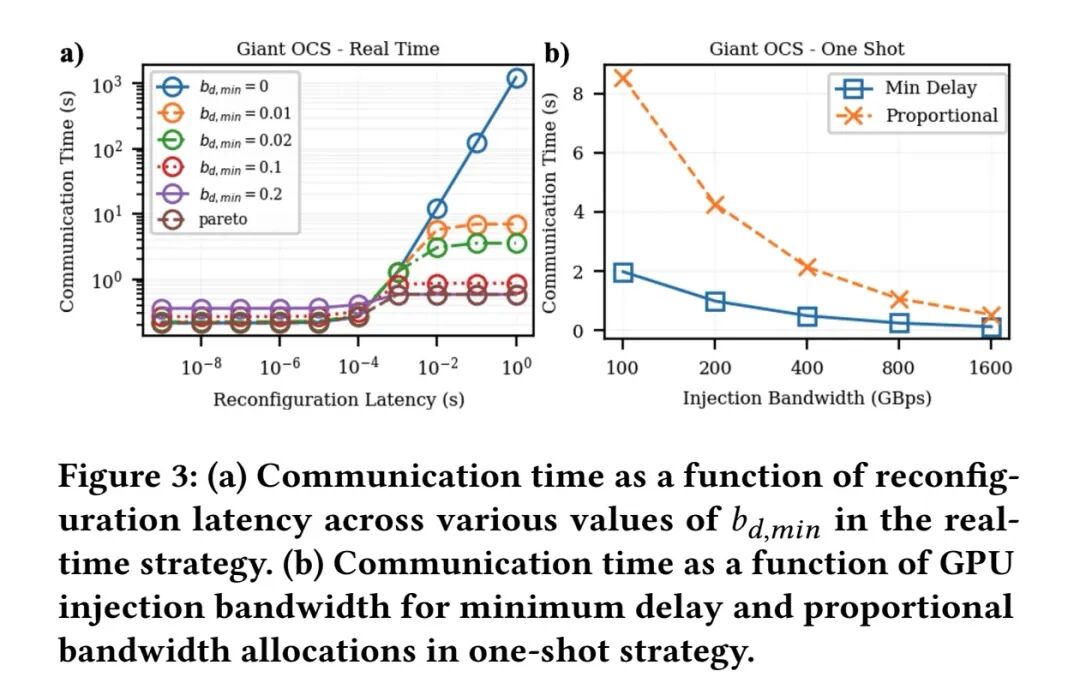

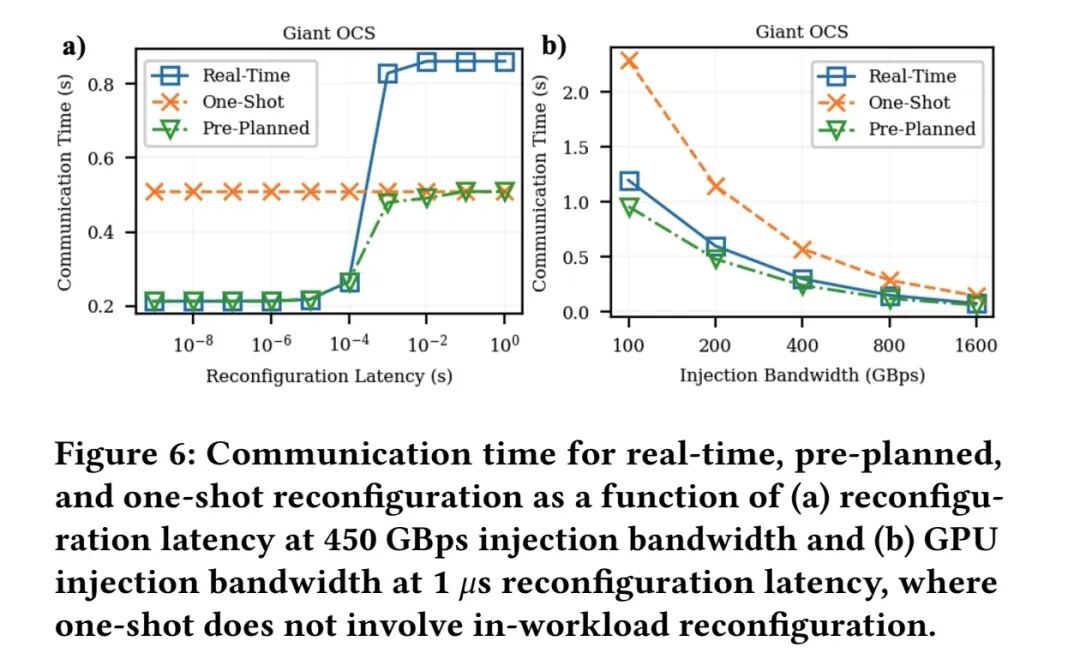

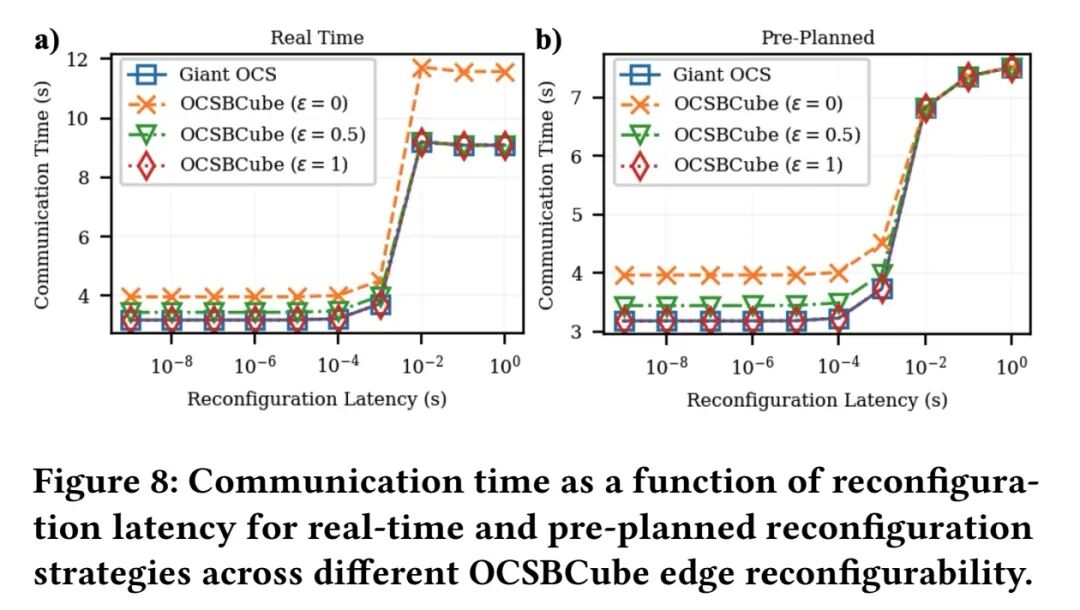

- 时间维度:提出两种工作负载内重构策略 —— 实时策略和预规划策略,二者具有不同的性能 - 复杂度权衡。预规划策略设定了性能上限,相比常用的一次性重构方法性能提升高达 2.3 倍,但要求重构延迟较低(<100 us);而在新兴链路技术(如共封装光学CPO)支持的足够高的每 GPU 带宽条件下,一次性重构无需工作负载内重构即可达到相当的性能。

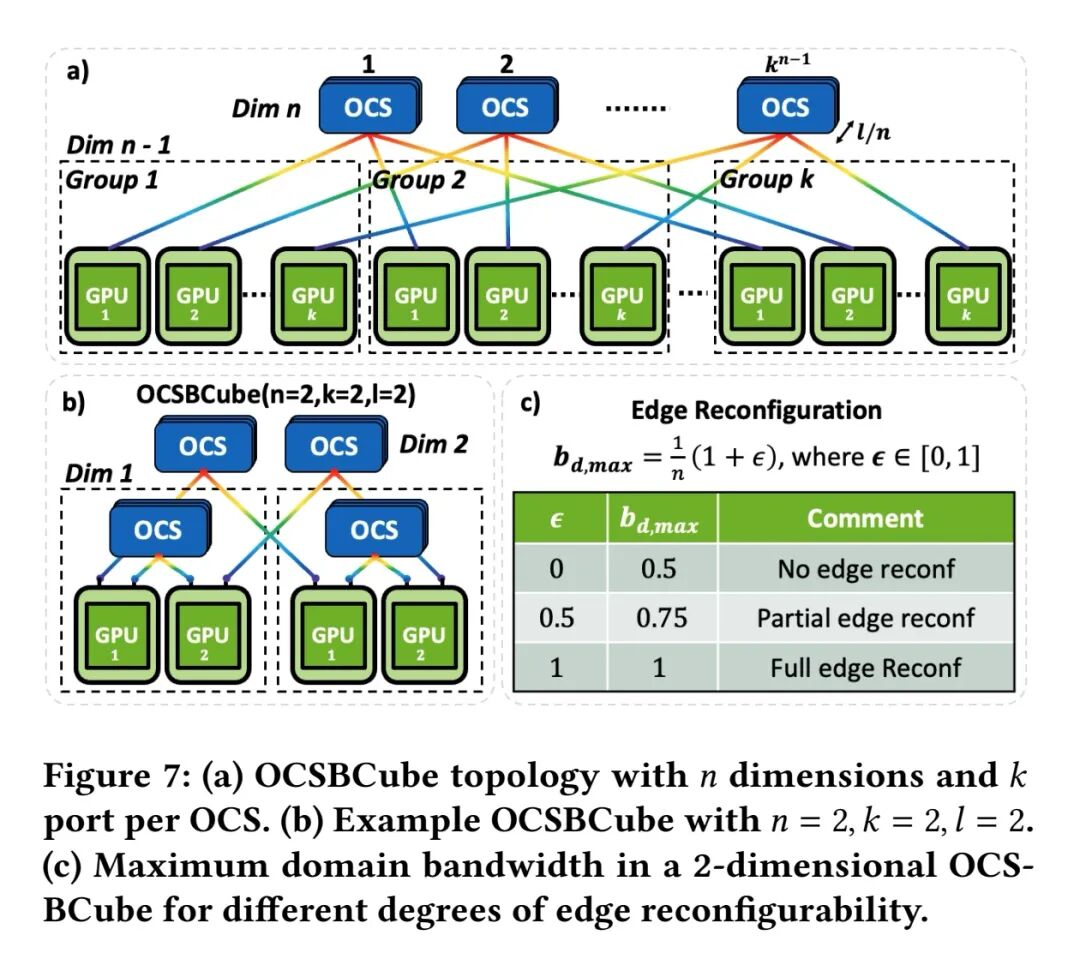

- 空间维度:提出 OCSBCube 拓扑 —— 一种支持 OCS 的拓扑结构,具备多维全连接直接通信、细粒度重构和低功耗特性。评估表明,OCSBCube 的训练迭代时间与支持 OCS 的胖树拓扑相当,但能耗降低高达 1.72 倍;同时,其能源效率与支持 OCS 的三维环面拓扑持平,但迭代速度提升高达 1.84 倍。

- 提出的评估方法提供了一个全面框架,可评估不同 OCS 技术下支持 OCS 的网络性能,为下一代光可重构架构的设计提供指导,以满足新兴 AI 系统的功耗和计算需求。

一、AI网络的核心挑战与OCS技术机遇

AI/ML工作负载的爆发式增长,对数据中心网络提出了双重要求:既要满足分布式训练中高频次、大容量的通信需求,又要控制整体功耗。传统网络架构存在明显短板:静态EPS网络(如折叠Clos拓扑)功耗高、传输距离有限,且存在多次电光转换损耗;直接拓扑(如高维Torus)虽功耗较低,但连接固定、灵活性差,难以适配复杂作业调度与故障管理。

OCS技术的出现打破了这一僵局。与静态网络不同,OCS可动态重构链路、按需分配带宽,且硬件成本低、功耗低,已在大规模生产数据中心和ML集群中部署。而AI工作负载的独特优势——通信模式具有确定性(依赖并行化策略),为更频繁的“工作负载内重配置”提供了可能,可在更细时间粒度上让网络拓扑匹配通信需求。不过,硬件层面的切换延迟、端口数量限制,以及重配置策略的复杂度,此前制约了这一方向的发展,主流方案仍采用“单步重配置”(每工作负载仅重构一次)。

近年来,MEMS OCS和硅光子技术的进步(更快切换速度、更多端口、更低功耗),为动态重配置提供了硬件基础。ACTINA框架正是基于这一背景,从时间和空间两个维度探索光可重构网络的设计空间,构建了量化评估体系并提出创新解决方案。

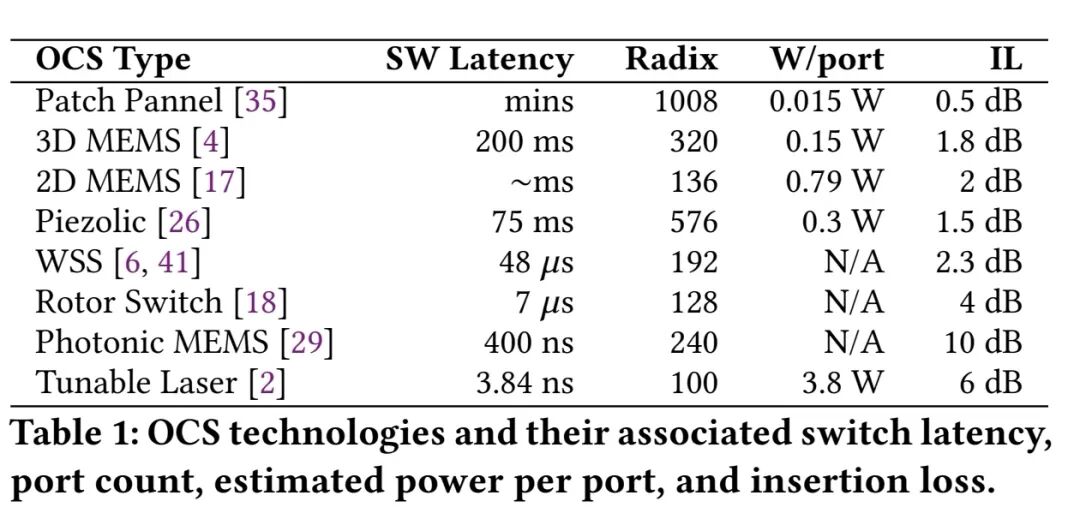

表 1 对比了各类 OCS 技术的切换延迟、端口数量和估计的每端口功耗。机器人配置的 MEMS 系统、压电驱动的 OCS 能够扩展到高端口数量,已实现商业化并应用于生产环境,但受限于切换速度较慢;而集成硅光子切换技术面临扩展性和信号损耗方面的挑战,但具有成本更低、尺寸更紧凑的优势;可调谐激光器和基于阵列波导光栅(AWG)的技术切换速度快,但存在功耗和扩展性方面的限制。商用 OCS 的定价尚不透明,因其仍属于新兴技术,产量较低,当前成本无法代表未来的商业应用和可行性。此外,不同技术的成本结构差异也使得直接对比难以实现。本文研究旨在提供一种系统化方法,评估 OCS 关键特性(如延迟、功耗和端口数量)对网络整体性能的影响,为未来的技术选择提供参考。

二、AI网络的基础:并行化策略与网络架构演进

要理解ACTINA的设计逻辑,需先明确AI分布式训练的核心并行化策略及其通信特征:

- 数据并行(DP):每个GPU持有完整模型,处理数据分片,通过全归约同步梯度;

- 张量并行(TP):每个GPU持有模型层分片,处理完整数据,通过全收集、归约散射等操作同步中间结果;

- 流水线并行(PP):模型层按顺序分区到不同GPU,通过点对点通信交换数据,需拆分微批处理以减少流水线气泡;

- 专家并行(EP):混合专家(MoE)层的专家分布在不同GPU,需在DP节点间通过全对全通信同步。

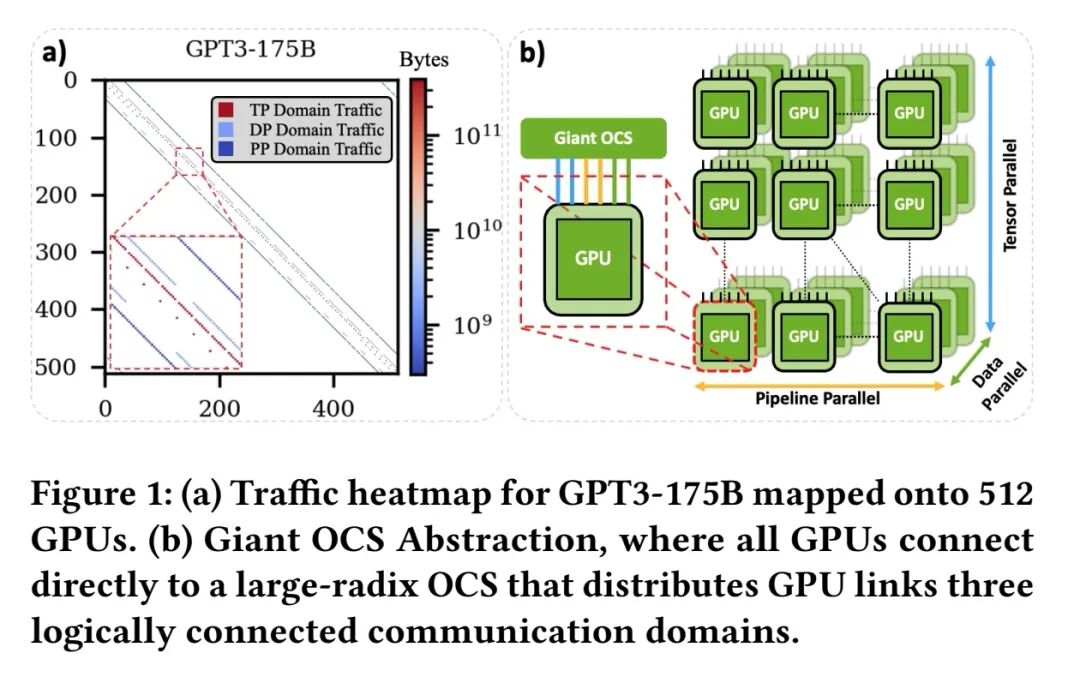

实际工作负载常采用混合并行策略,每个GPU需参与DP、TP、PP三个独立通信域的传输。这一通信特征,决定了网络需具备灵活适配不同域带宽需求的能力。

从网络架构来看,当前AI网络分为两类:静态网络(如Torus、Dragonfly、折叠Clos变体)通过固定链路满足通信需求,但适配性差、功耗高;光可重构网络(如TOPOOPT、TPUv4 Pod、RotorNet)通过OCS动态调整拓扑,分为“需求感知型”(单步重配置,适配特定并行策略)和“需求无关型”(高频循环重构,近似均匀带宽分配)。前者重构频率低、复杂度高,后者虽简单但端口需求大、适配性不足。ACTINA的核心创新,正是利用AI工作负载的确定性通信特征,融合两者优势,提出更高效的重配置策略与拓扑设计。

三、ACTINA方法论:量化评估光可重构网络的核心框架

ACTINA构建了一套系统的方法论,从时间和空间维度评估光可重构网络的性能权衡,为策略与拓扑设计提供理论支撑。

1. DNN计算图建模

DNN工作负载可表示为有向无环图(DAG),其中通信子图(Gₙ)包含全归约、全收集等通信节点,且这些节点分属TP、DP、PP三个通信域。由于AI工作负载的通信模式具有确定性,可通过分析通信子图的流量大小、目标节点,精准识别最优重配置时机。对于PP域的非对称点对点通信与TP/DP域的对称集合通信,只需优化不同PP索引GPU的计算图,即可推广至整个集群。

2. Giant OCS抽象与逻辑拓扑

为简化网络建模,ACTINA提出Giant OCS抽象:所有GPU通过可转向光链路直接连接到一个大端口无阻塞OCS,可任意分配链路资源,模拟任意拓扑。基于这一抽象,可通过带宽-延迟流体模型估算通信操作耗时,并优化重配置策略。逻辑拓扑层面,GPU带宽被划分为三个通信域的分配比例(bd),满足Σbd=1,无需复杂的流量矩阵匹配,仅需基于重配置策略分配带宽即可。

3. 控制平面与重配置延迟考量

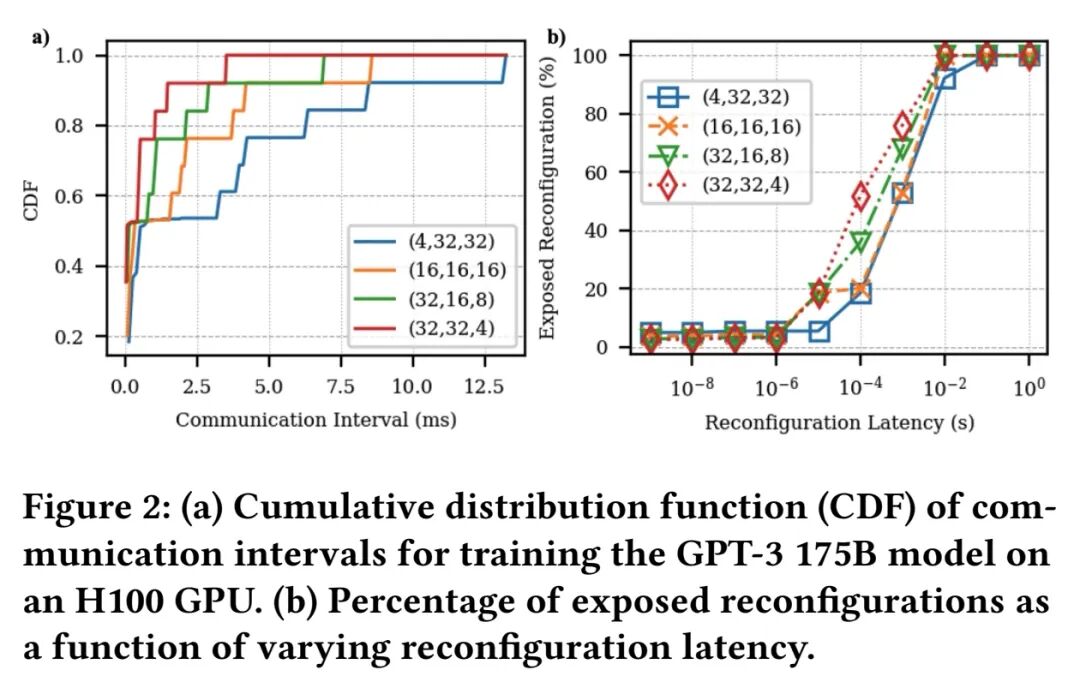

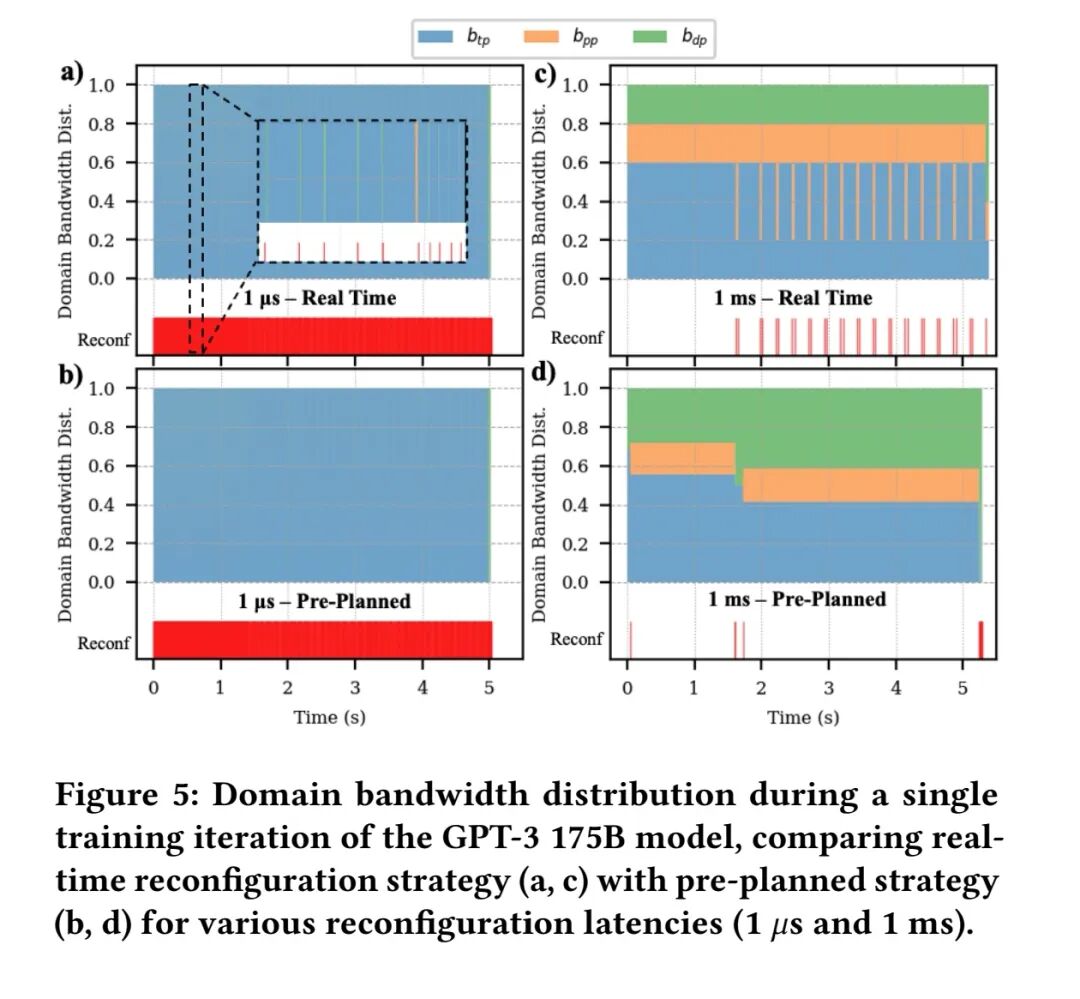

ACTINA采用软件定义网络(SDN)控制平面,重配置需经历“数据包排空-OCS重构-收发器同步-端口激活”四步,总延迟为端到端重配置延迟。为掩盖重配置开销,可将重配置事件嵌入CUDA计算图,与计算过程重叠。实际暴露的重配置延迟(tr')需结合通信间隔计算:若连续通信节点的间隔大于重配置延迟,开销可完全掩盖;否则仅暴露差值部分。实验显示,GPT3-175B训练中超过50%的通信间隔短于1ms,低延迟OCS(<1μs)可最大化掩盖重配置开销。

4. 评估方法

基于Calculon框架(Transformer大模型性能分析工具),ACTINA构建了图基DNN性能模型,模拟H100 GPU的计算与内存能力,并实现了重配置策略与拓扑的独立网络后端。采用α-β成本模型表征集合通信性能,通过跳数调整延迟乘数,通过重配置决策调整带宽乘数,全面评估网络性能。

四、工作负载内重配置策略:实时与预规划的双重突破

ACTINA提出两种工作负载内重配置策略,分别平衡“低复杂度”与“全局最优”,适配不同硬件延迟特性。

1. 实时策略:低复杂度的局部优化

实时策略仅基于当前和前一个通信节点的信息决策,时间复杂度为O(1),包含两个核心机制:

- 阈值触发:当重配置后通信时间节省量超过阈值(本文设为0)时触发重配置,即tcₒ - (tcᵣ + tr) > 0(t_cₒ为无重配置通信时间,tcᵣ为有重配置通信时间);

- 最小域带宽(bd,min):为每个通信域预留最小带宽,避免后续通信无可用带宽导致强制重配置。例如b_d,min=5%时,每个域至少保留5%带宽,单个域最大可分配90%带宽。

实验表明,低重配置延迟(<1ms)时,小bd,min(如0)性能更优;高延迟时,大bd,min(如0.2)可减少重配置频率,降低开销。通过前几轮迭代优化bd,min,可逼近帕累托最优解。

2. 预规划策略:全局最优的智能调度

利用通信子图的先验知识,预规划策略通过全局优化确定重配置时机,核心包括:

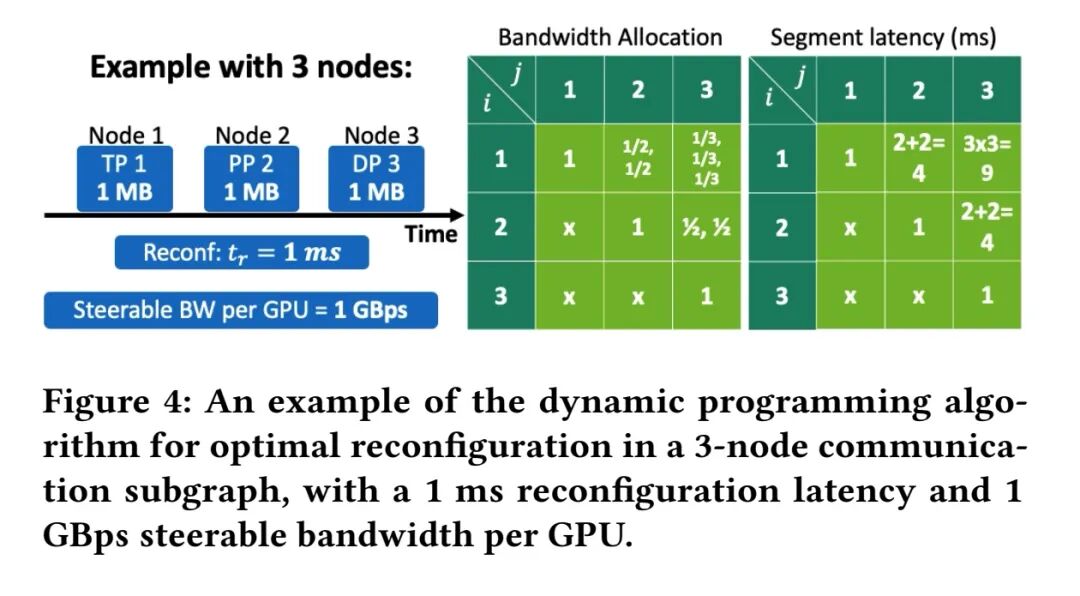

- 带宽分配优化:将带宽分配建模为网络效用最大化问题,以“负流量-带宽比”为效用函数,推导最优分配方案——各域带宽与流量平方根成正比,而非简单的比例分配,可显著降低总通信时间;

- 动态规划(DP)最优重配置:将通信节点划分为多个片段,每个片段起始时执行重配置,通过DP求解最小总通信时间。递归关系为OPT[j] = min1≤i≤j {L[i][j] + tr + OPT[j-1]},其中L[i][j]为片段i-j的通信时间。DP算法时间复杂度为O(N³),远低于暴力搜索的O(2ᴺ)。

3. 策略性能对比

低重配置延迟(<100μs)时,预规划策略可实现高达2.3倍于单步重配置的性能提升,实时策略因频繁重配置(每域切换触发)性能接近预规划;高延迟(≥1ms)时,单步重配置因开销低逐渐逼近最优性能;当GPU注入带宽足够高(>1600GBps,如CPO技术支持),三种策略性能收敛,无需复杂的工作负载内重配置。

五、OCSBCube拓扑:多维直连重构的能效巅峰

在空间维度,ACTINA提出OCSBCube拓扑,融合OCS的动态性与BCube的扩展性,解决传统拓扑“重配置粒度粗”“带宽利用率低”的问题。

1. 拓扑设计核心

OCSBCube基于BCube递归结构,将每个EPS替换为OCS,每个服务器替换为GPU,GPU通过可转向光链路均匀分布在n个维度。核心特征包括:

- 多维直连:OCSBCube(n,k,l)包含kⁿ个GPU和n级OCS,直径为n(通常n=2或3),二分带宽随维度指数增长,支持每个GPU与n(k-1)个同伴直接通信;

- 边缘可重构性:一般情况下,GPU 注入带宽(即光纤)在 n 个维度上均匀分布。然而,普通 BCube 的带宽无法跨维度重构,当流量模式要求跨维度的非均匀带宽时,会导致带宽利用率不足。因此,这里采用波长可重构多端口收发器替换 GPU 上的多个收发器。该收发器设计利用密集波分复用(DWDM)梳状激光器技术提供的海量波长并行性,能够跨不同光纤重构波长,实现波长跨链路重配置以及网络边缘的动态带宽分配,用ε∈[0,1]表征可重构程度。ε=1时可将全带宽转向单一维度,ε=0时带宽均匀分配,ε=0.5时单维度最大可分配75%带宽;

- 多维作业映射:将每个通信域映射到尽可能多的维度,例如需pd个GPU的域均匀分布在n个维度,每个维度分配pd/n个GPU,充分利用全注入带宽,无需域间重配置。

2. 与传统拓扑的关键差异

- 对比OCS-Fat-Tree:OCS-Fat-Tree依赖层级EPS,重配置粒度粗、带宽利用率低,且EPS功耗随带宽快速增长;OCSBCube无EPS,直接光连接减少电光转换损耗,能效更优;

- 对比TPUv4 Pod(3D-Torus):TPUv4仅支持外层链路重配置,带宽限制为单域2条链路,不支持工作负载内重配置;OCSBCube支持细粒度带宽重构,单域可利用全维度带宽,迭代速度更快。

3. 性能-功耗权衡优势

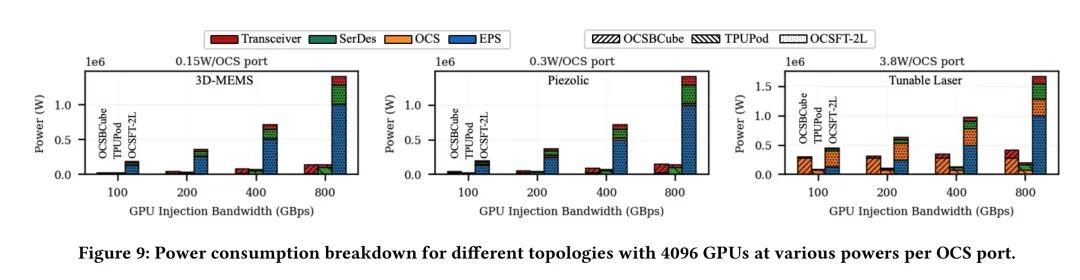

在实验设置中,通过考虑系统中每个组件的功耗贡献来计算每种拓扑的总功耗。假设每个 GPU 的功耗为 700W;链路的功耗通过功率密度(pJ/bit)乘以工作链路带宽计算:TPUPod 和 OCSFT-2L 中的电链路由SerDes供电,假设其功耗为 5 pJ/bit;光链路假设使用共封装光学(CPO)收发器,功耗同样设置为5 pJ/bit;假设一个 72 端口 NVSwitch 类型的 EPS 功耗为 275 W,并采用线性缩放以考虑不同的端口数量和每端口带宽;OCS 功耗通过改变每端口功耗建模,遵循表 1 所示的范围。每个网络的总功耗通过组件数量乘以相应的组件功耗计算得出。

图 9 展示了在选定的 OCS 功耗下,不同拓扑(含 4096 个 GPU)的功耗分解。首先观察到,随着 GPU 注入带宽的增加,OCSFT-2L 的功耗快速增长,这是因为 EPS 的功耗需求快速增加;相比之下,OCSBCube 和 TPUPod 的功耗增长较慢,因为它们更多地依赖于带宽无关的 OCS。由于大量的 EPS 和 SerDes 汇聚,OCSFT-2L 始终表现出最高的功耗。在较低的 OCS 功耗下,OCSBCube 和 TPUPod 的总功耗相似,但随着 OCS 功耗增加,OCSBCube 的功耗超过 TPUPod,因为其 OCS 组件数量更多。此外,可以注意到,在较低的 OCS 功耗下,收发器功耗是 OCSBCube 和 TPUPod 的主要贡献者;而当 OCS 功耗增加到 3.8 W(Tunable laser方案)时,OCS 功耗成为主要贡献者。

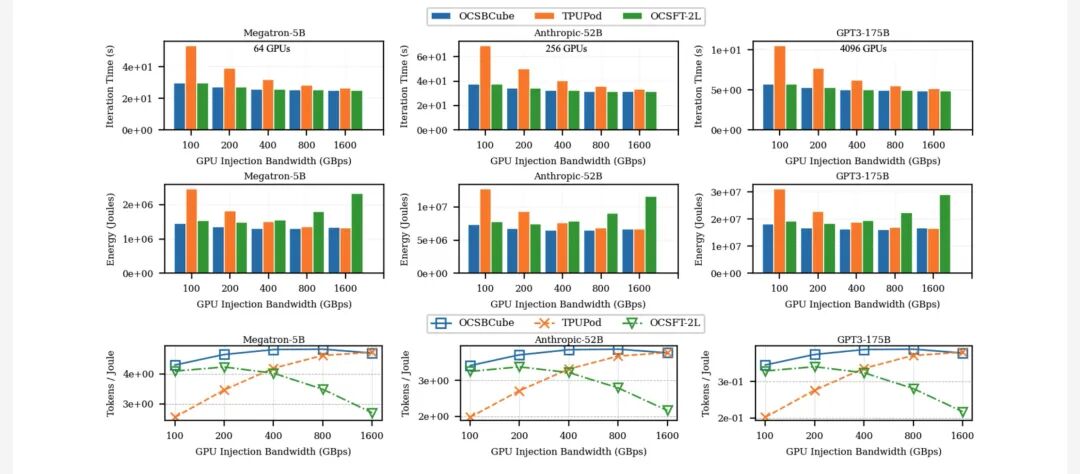

为评估 OCS 拓扑的性能和功耗权衡,本工作考察了三种不同规模的基于 Transformer 的训练工作负载:Megatron-5B(64 个 GPU=4 张量并行 ×2 数据并行 ×8 流水线并行)、Anthropic-52B(256 个 GPU=4 张量并行 ×4 数据并行 ×16 流水线并行)和 GPT3-175B(4096 个 GPU=4 张量并行 ×32 数据并行 ×32 流水线并行)。假设重构延迟为 1ms,每端口 OCS 功耗为 3.8 瓦。

图 10 展示了迭代时间(上图)、能耗(中图)和每焦耳token数(下图)随 GPU 注入带宽的变化。可以观察到,OCSBCube 的迭代时间与 OCSFT-2L 相当,但能耗更低(高达 1.72 倍),因为 OCSBCube 避免使用 EPS 和电 SerDes 组件 —— 这些组件的功耗随带宽增加而快速增长。另一方面,虽然 OCSBCube 和 TPUPod 在较高带宽下的能耗相似,但 OCSBCube 的迭代速度更快(高达 1.84 倍),因为其具有更精细的执行中重构能力,能够为所有通信域高效利用所有可用带宽;而 TPUPod 的固定三维环面拓扑和基于环的集合操作限制了每个通信域仅能使用两条链路的带宽。

此外,OCSBCube 在每焦耳token数方面始终优于其他拓扑,提升高达 1.75 倍。可以观察到,在较高带宽下,TPUPod 实现了更好的权衡,因为其从增加带宽中获得的性能提升超过了光收发器的额外功耗成本(尤其是与使用更多光收发器的 OCSBCube 相比)。相反,在较高注入带宽下,SerDes 和 EPS 的功耗需求不断增加,显著降低了 OCSFT-2L 的每焦耳token数。

这些结果表明,在功耗受限的数据中心环境中,OCSBCube 和 TPUPod 均比 OCSFT-2L 具有更好的功耗效率,允许部署更多的 GPU。然而,由于 OCSBCube 在带宽重构方面具有更高的灵活性,能够实现更高效的数据传输和资源利用,因此其性能优于 TPUPod。总体而言,与其他拓扑相比,OCSBCube 通过更低的能耗和更快的训练速度,降低了数据中心的运营成本。

六、结论与未来展望

ACTINA框架通过量化评估体系、创新重配置策略和OCSBCube拓扑,为AI网络的光可重构升级提供了完整解决方案:低延迟OCS(<100μs)下,预规划策略实现2.3倍性能提升;高带宽场景(>1600GBps)下,单步重配置仍能保持最优性能;OCSBCube拓扑实现“Fat-Tree级性能”与“3D-Torus级能效”的双重突破,性能-功耗权衡提升1.75倍。

未来工作将聚焦三个方向:一是多租户共享集群的作业映射,实现网络资源的物理隔离与动态分配;二是故障弹性与资源可用性评估,提升拓扑鲁棒性;三是优化面向可重构网络的集合通信算法,进一步提升数据传输效率。随着OCS技术与AI网络的深度融合,ACTINA框架有望成为下一代AI数据中心网络设计的核心参考,推动大模型训练向“更高性能、更低功耗”的方向演进。

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2025-11-18,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读