Intel SC25报告:NVL576之后,光子学将引领超算解聚时代

在 超算大会SC 25上的第五届国际高性能计算资源解耦研讨会(5th International Workshop on RESource DISaggregation In High-Performance Computing)中,Intel IATG 的 Fabrizio Petrini 带来了主题为 “光子学赋能:超算与 AI 解耦时代的系统解决方案” 的重磅演讲,深度剖析了高性能计算(HPC)与人工智能(AI)领域的资源解耦趋势、技术瓶颈及未来突破路径,全方位解读了从当前标杆 NVIDIA NVL72 到 2027 年旗舰 NVL576 的技术演进,以及光子学网络在解耦系统中的核心支撑作用。

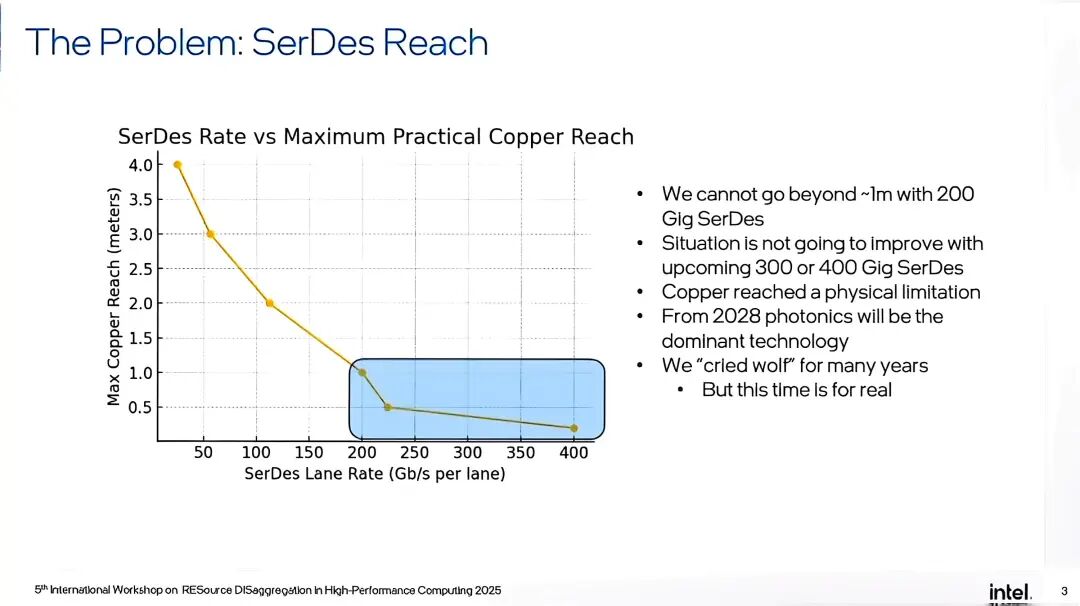

在超算与人工智能领域,系统性能的持续突破始终受限于底层硬件与网络架构的物理边界。当200Gig、400Gig速率的SerDes逐渐成为主流,铜缆技术的物理极限已愈发清晰,而以NVIDIA NVL系列为代表的AI/HPC系统,正站在从铜缆向光子学转型的关键节点。本文将基于前沿技术演讲与公开架构文档,深入解析这一转型背后的技术困境、当前系统的现状与挑战,以及光子学如何成为超算与AI系统规模化发展的核心突破口。 ◆ 铜缆的终局:物理限制下的技术瓶颈

长期以来,铜缆凭借稳定性强、成本低廉、集成便捷等优势,成为超算与AI系统内部连接的主流选择。但随着数据传输速率迈向300Gig甚至400Gig,铜缆的物理特性已难以支撑技术演进的需求——其传输距离被严格限制在1米左右,即便在理想条件下也难以突破2米。业内人士早已多次预警这一问题,但直到近年,随着AI模型规模指数级增长,铜缆的局限性才真正成为系统升级的“硬枷锁”。 演讲中明确指出,铜缆已触及物理极限,这一结论并非主观判断,而是基于多家供应商的内部技术路线图得出的共识:2028年将成为关键转折点,此后除同一电路板内的近距离连接外,铜缆将逐步退出超算与AI系统的核心连接场景,光子学将成为替代技术。这一转型并非单纯的技术迭代,而是从定量到定性的根本性变革——它将彻底改变系统的设计逻辑、编程方式、硬件架构乃至总体拥有成本(TCO),成为超算与AI领域不可逆转的技术趋势。 ◆ 当下标杆:NVIDIA NVL72的架构现状与痛点

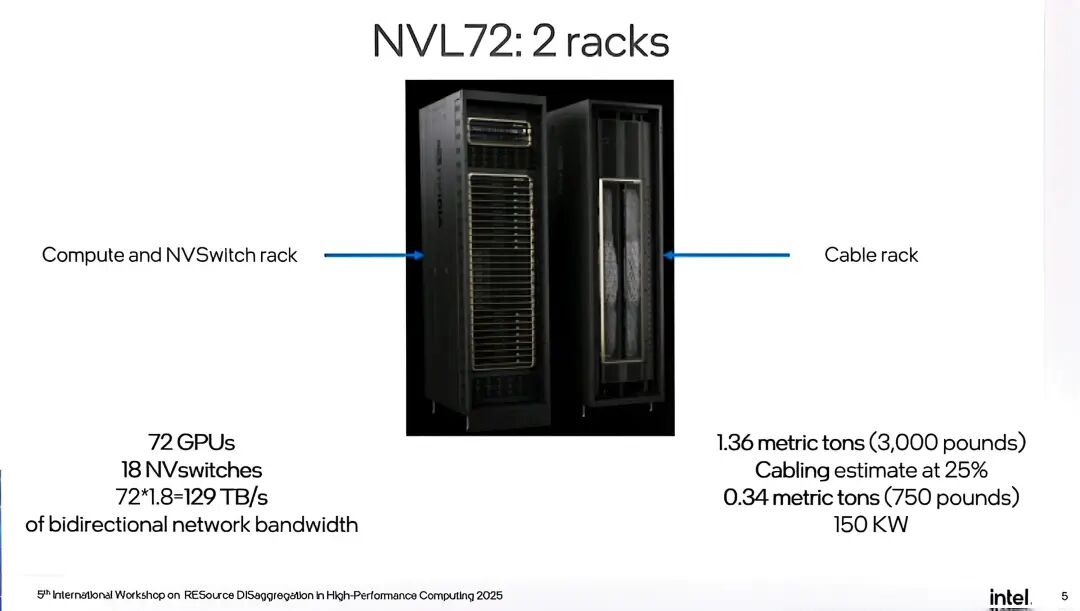

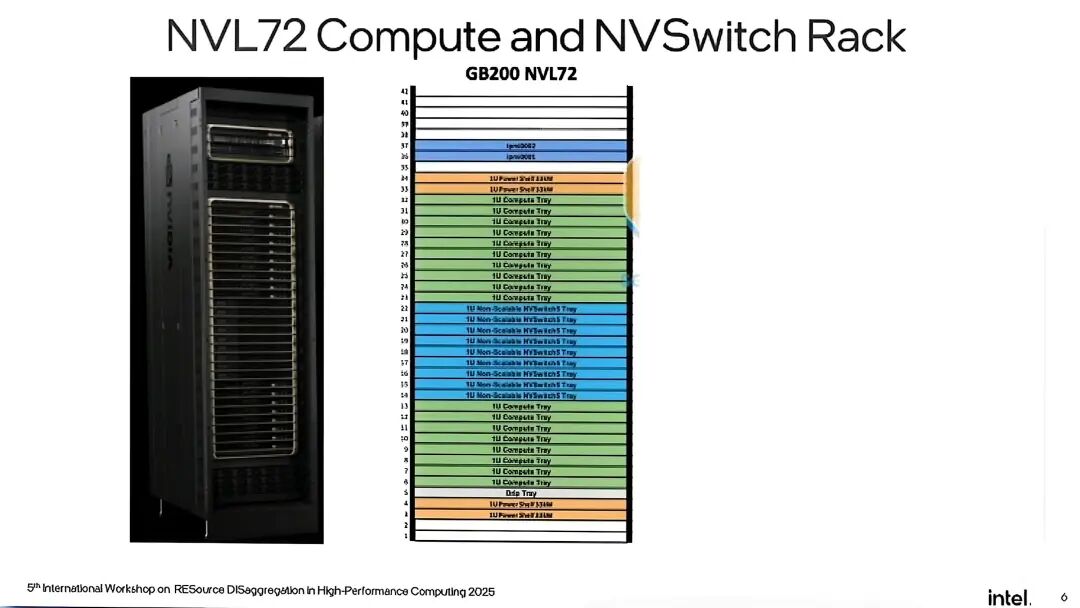

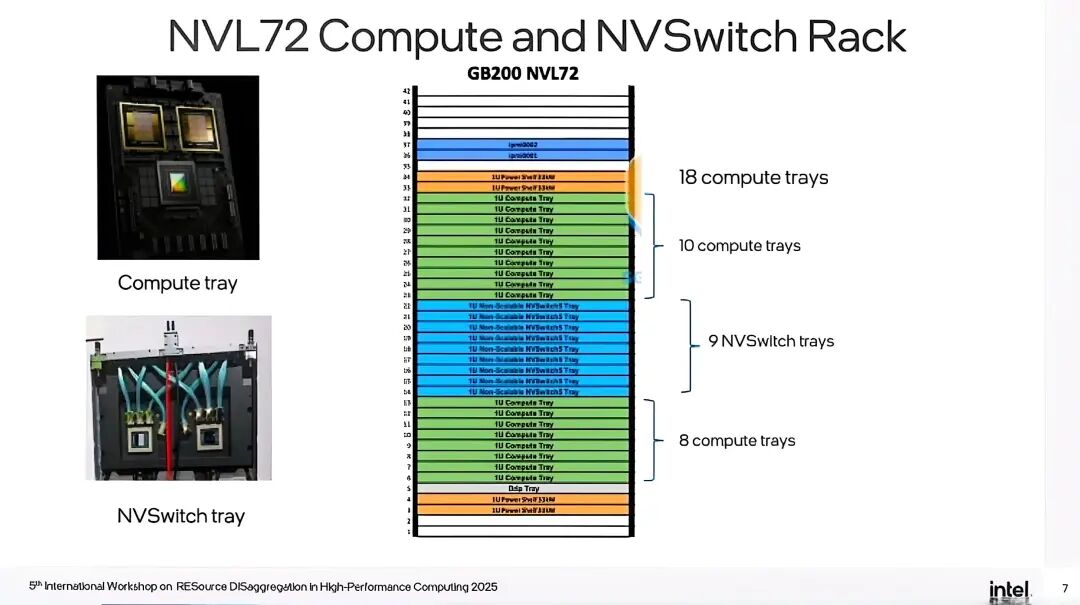

作为当前AI系统的标杆,NVIDIA NVL72的设计与性能数据,直观反映了铜缆时代超算架构的特点与局限。该系统由两个机架构成:一个是包含72个GPU的计算机架,另一个是线缆机架,其双向网络带宽达到129TB/s,功耗高达150KW,对数据中心的供电与散热提出了严苛要求。

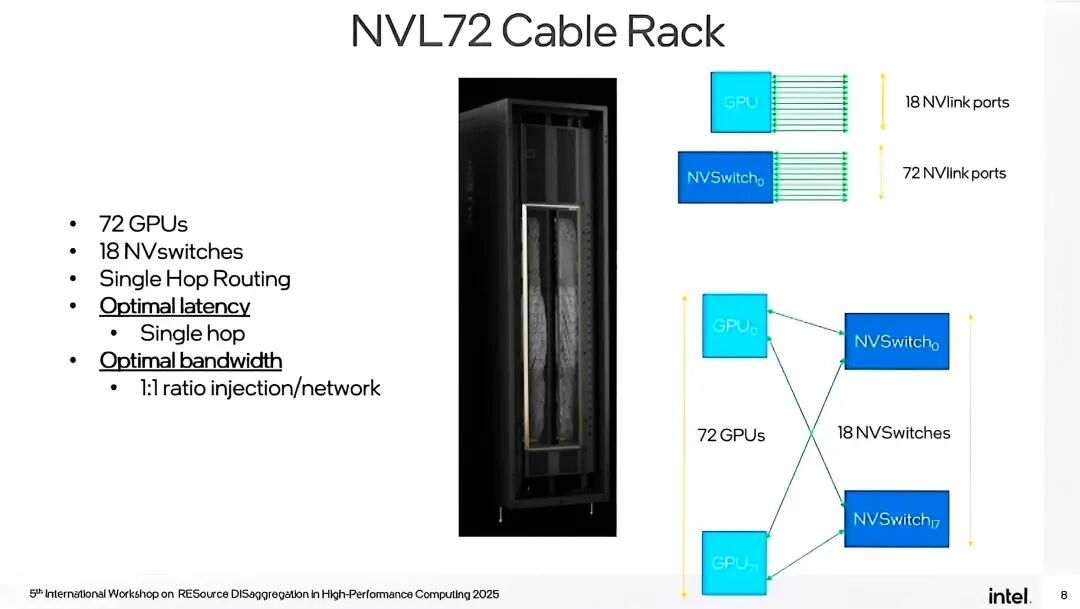

NVL72的架构设计围绕“最小化传输距离”展开,采用最优单跳拓扑结构,通过并行网络链路实现性能提升——18个NVSwitch与72个GPU构成二分图连接,每个GPU的连接数与交换机数量对应,每个交换机的连接数则匹配GPU总数,确保数据传输仅需单跳即可完成,在铜缆的距离限制内实现了最优时延与带宽。

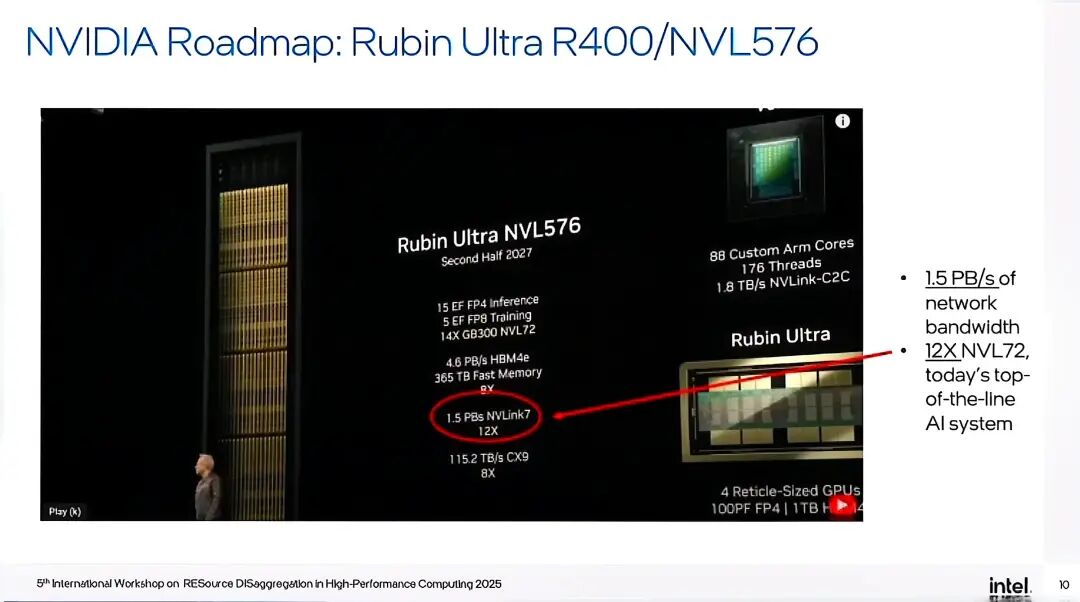

但这一设计的代价同样显著。演讲中分享了一个极具代表性的细节:在Supercomputing展会的NVIDIA展台,打开NVL72的线缆机架需要四名工作人员协作——两人开门,两人推动线缆束,其重量之大可导致连接器弯曲、地板变形。更关键的是,该系统的刀片服务器更换流程极其繁琐,耗时长达4-5小时,严重影响系统的维护效率。这些问题的根源,正是铜缆在高带宽需求下的物理特性限制——为了在1米左右的有效距离内实现高密度连接,必须使用大量厚重线缆(750磅),最终导致系统体积庞大、重量超标、维护困难。 ◆ 未来挑战:NVL576的升级之路与不可逾越的铜缆枷锁 面向2027年及以后,NVIDIA推出的NVL576(基于Rubin Ultra R400 GPU)将成为下一代AI系统的核心,但它同时也将铜缆技术的局限性推向了极致。作为NVL72的12倍带宽升级版本,NVL576的设计目标是实现1.5PB/s的机架总带宽,但其架构复杂度与技术挑战也呈指数级增长。

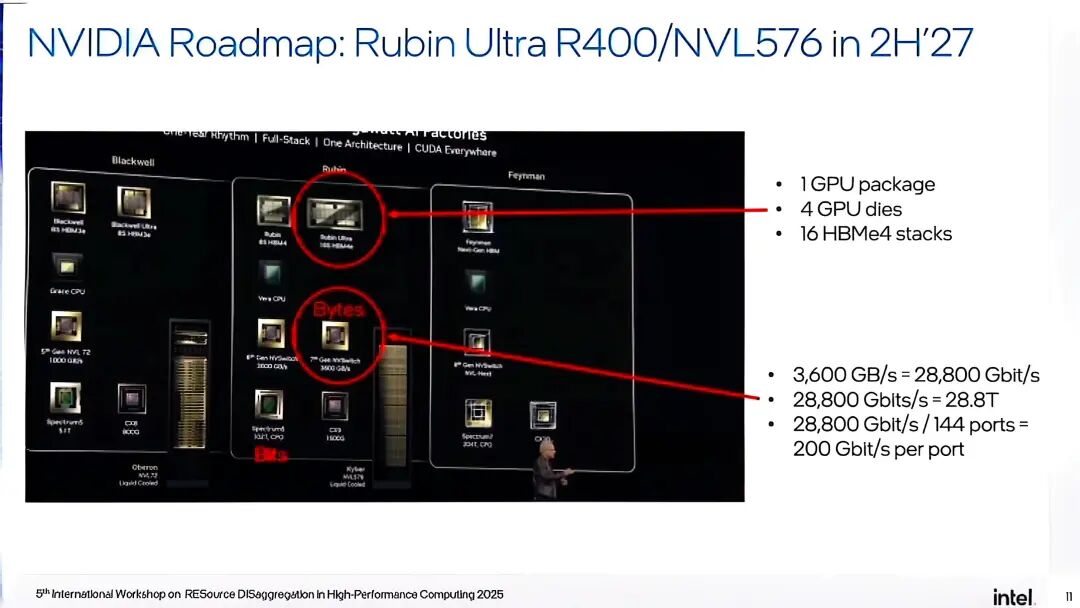

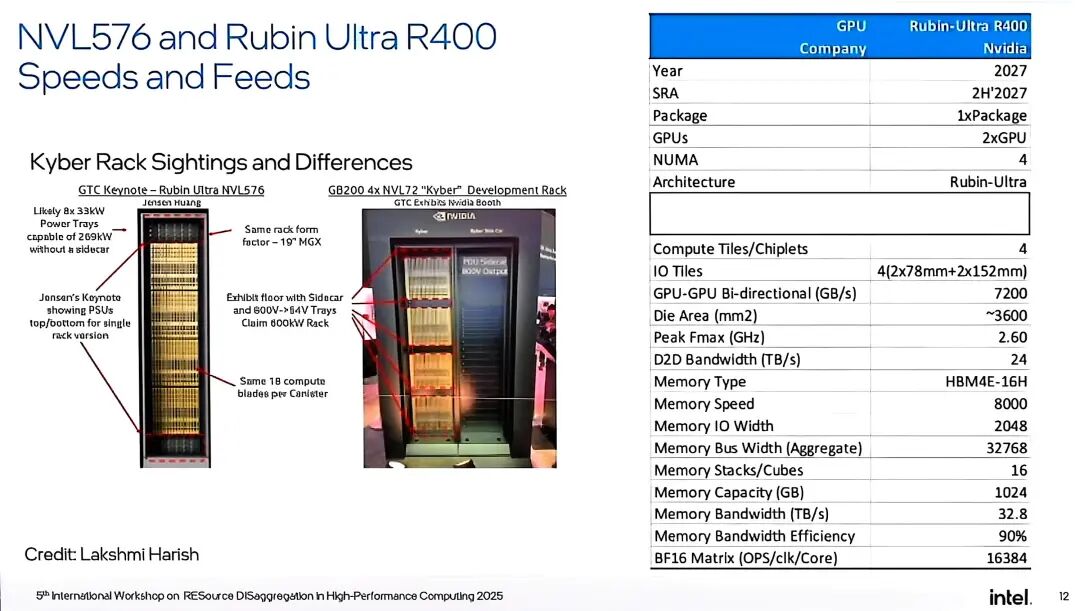

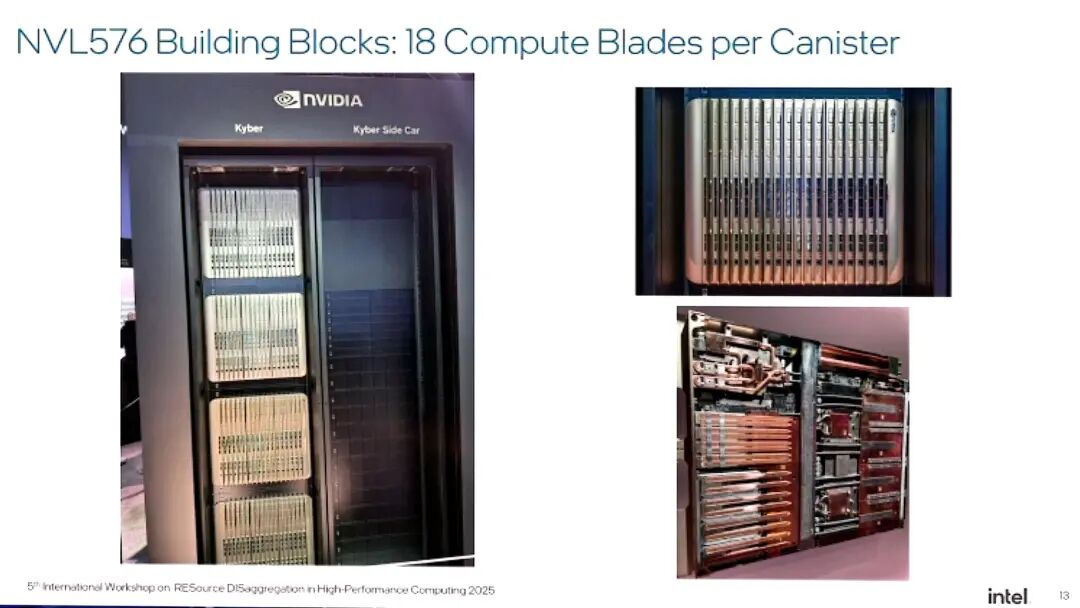

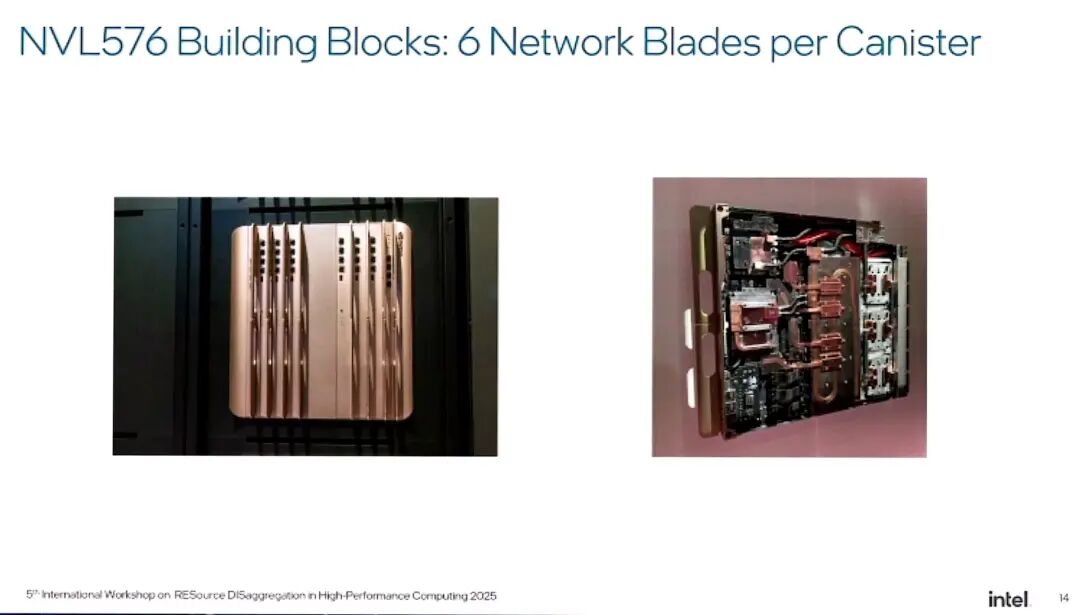

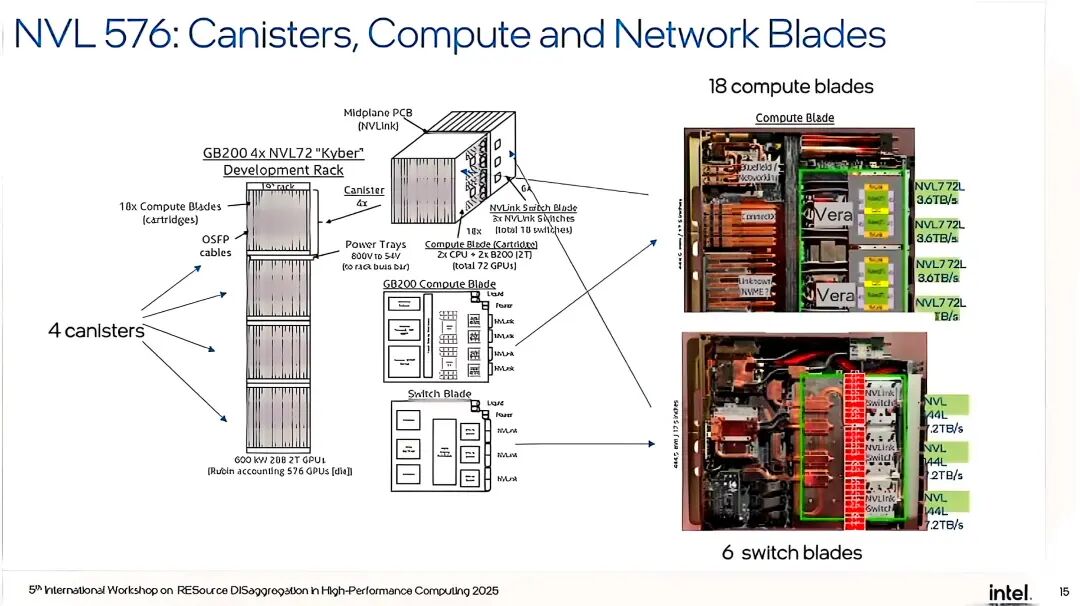

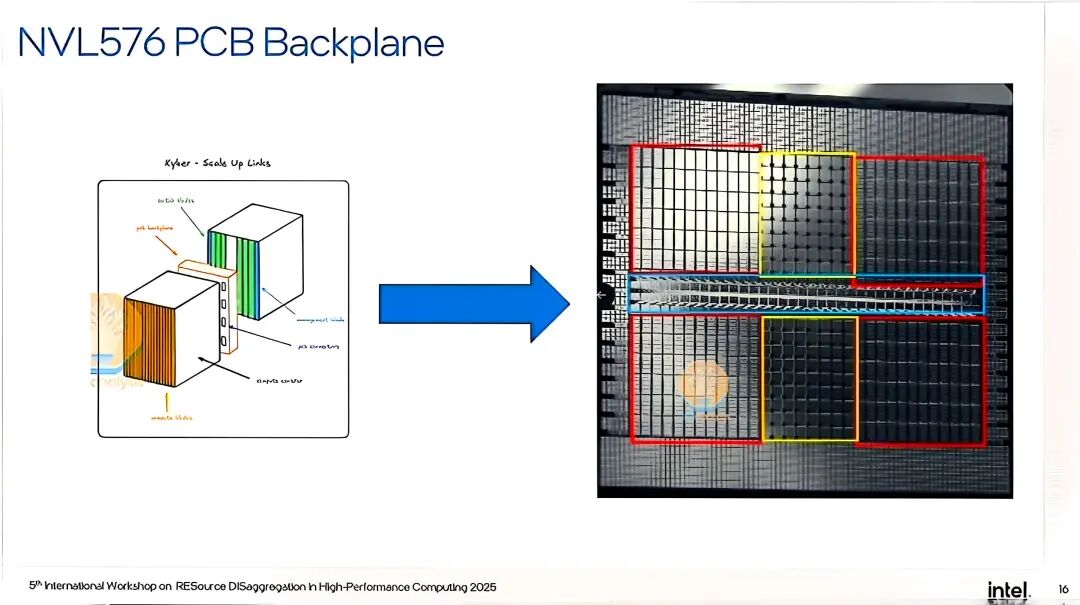

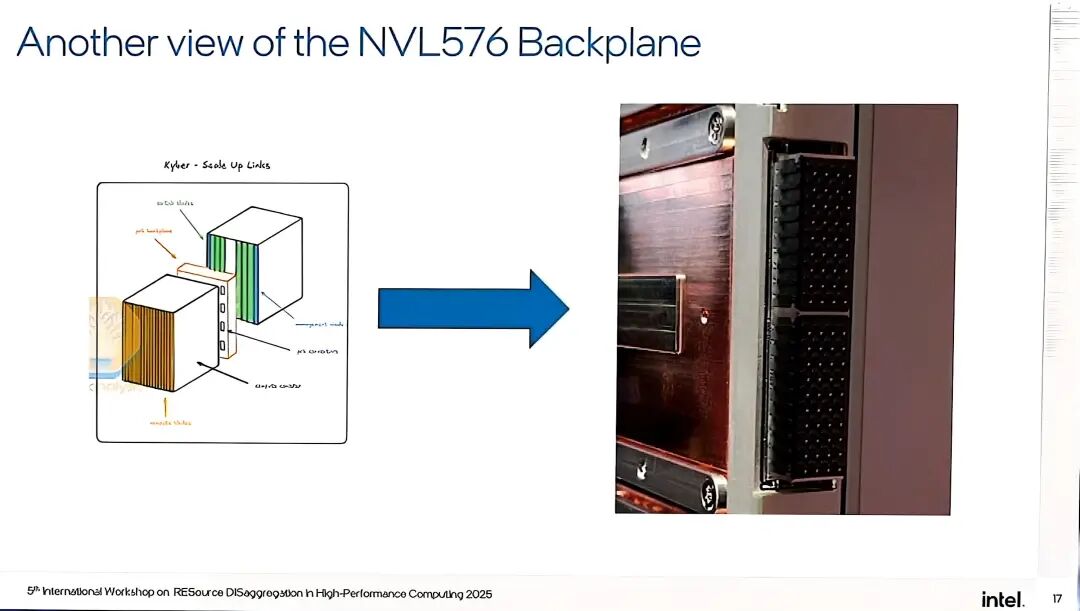

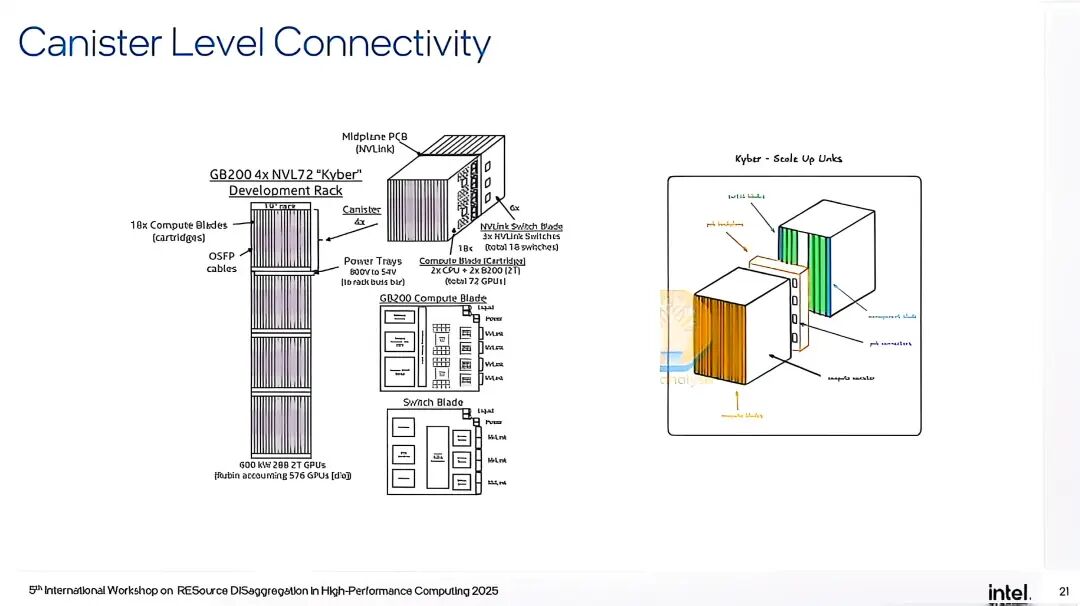

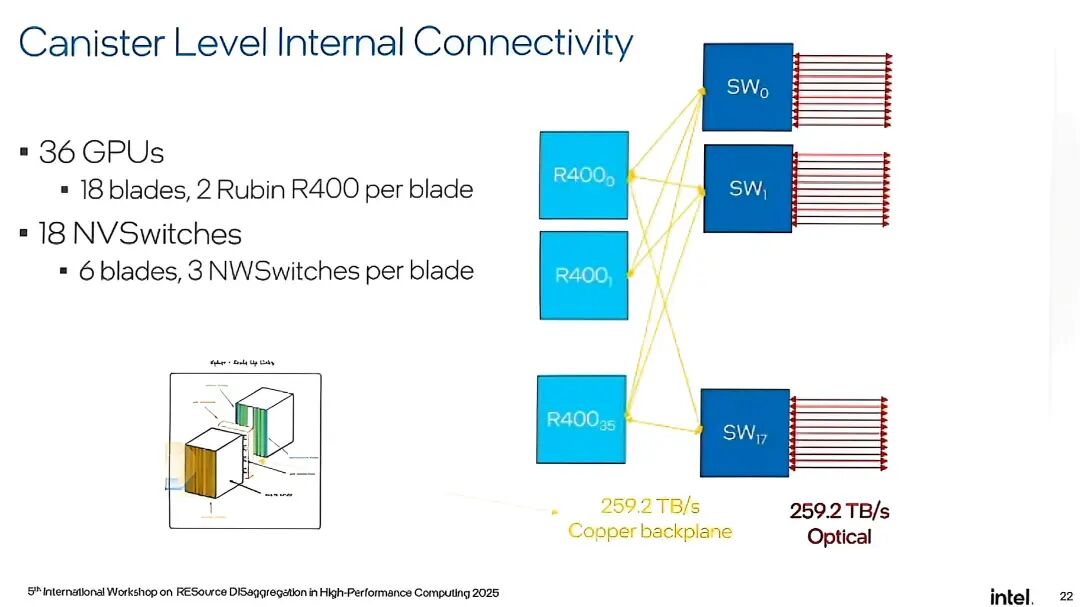

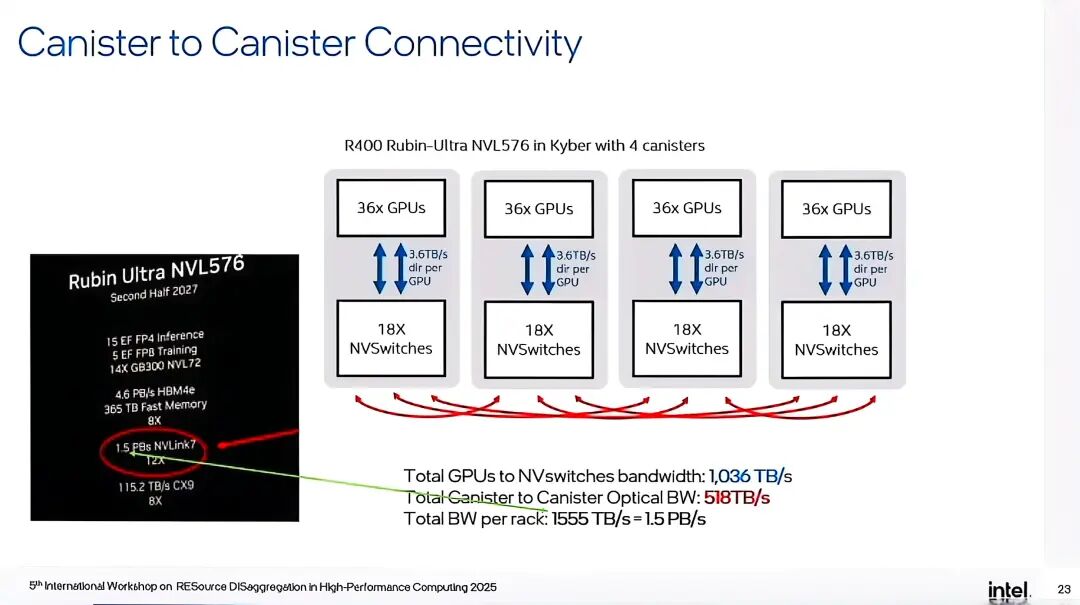

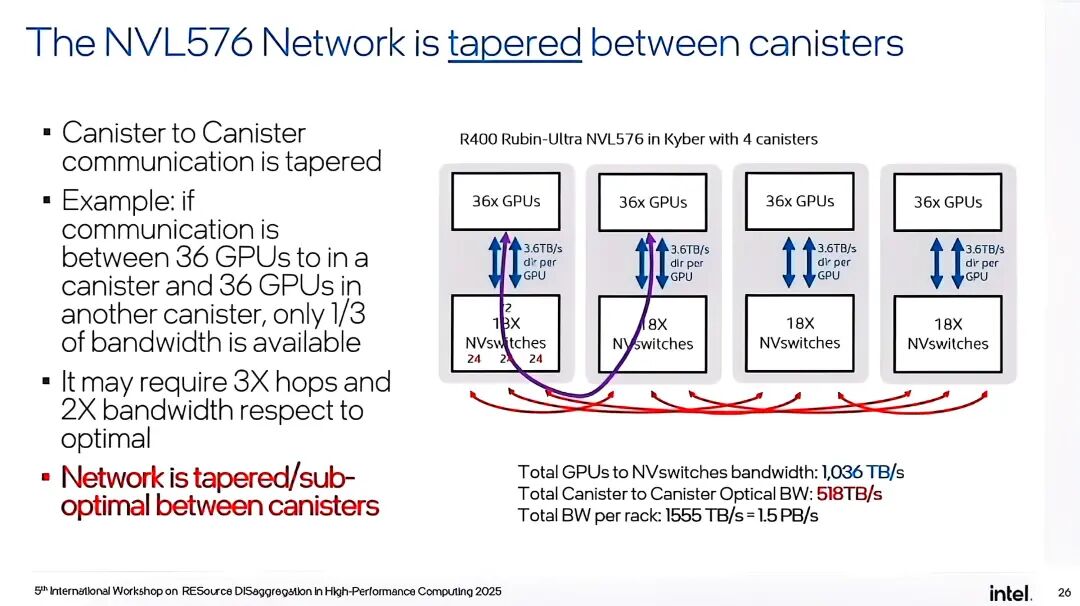

NVL576采用了“罐式(canister)”设计,每个机架包含4个canister,每个canister配备18个计算blade与6个网络blade,单个计算刀片集成2个Rubin Ultra R400 GPU,整机共144个GPU。每个网络blade包含3个NVswitch,4个canister总计72个NVswitch,形成高密度的计算与网络架构。系统通过中板PCB(Midplane PCB)实现canister内铜缆连接,采用OSFP线缆进行外部扩展,整体设计在铜缆技术框架下尽可能突破带宽限制。

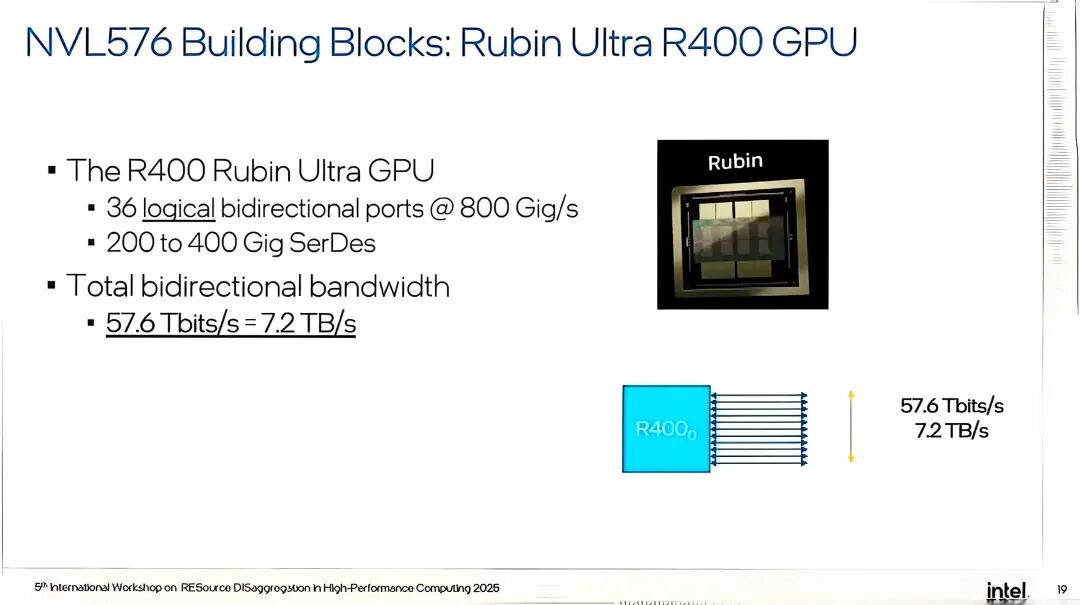

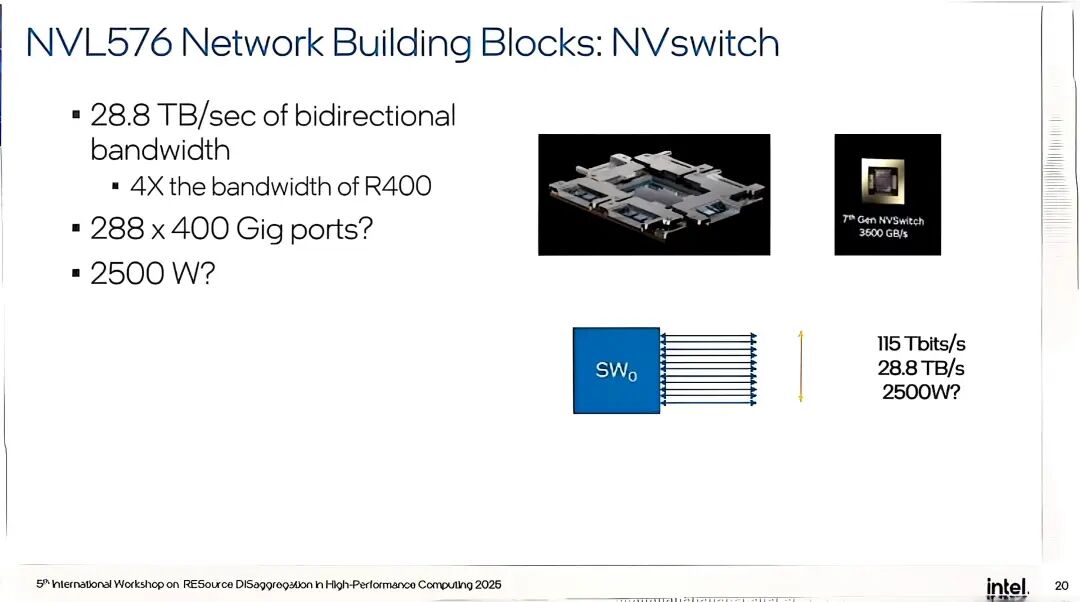

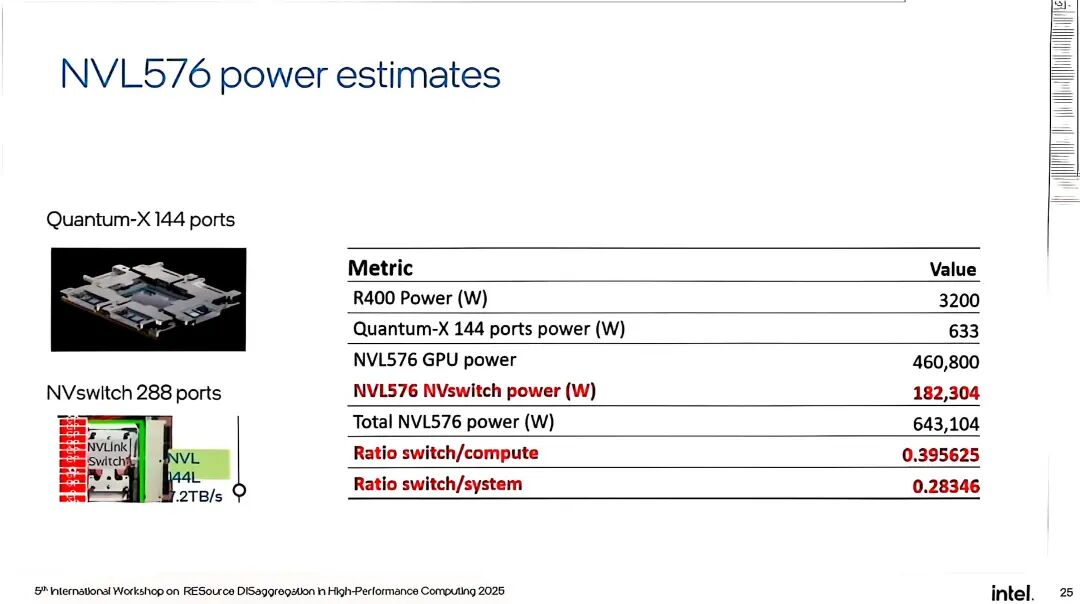

Rubin Ultra R400 GPU作为核心计算单元,性能参数十分亮眼:单个GPU封装包含4个GPU裸片,配备36个逻辑双向端口,端口速率达800Gig/s,支持200-400Gig SerDes,总双向带宽达到57.6Tbits/s(7.2TB/s),功耗预计约3200W。与之配套的NVswitch同样实力强劲,配备288个400Gig端口,总双向带宽达28.8TB/s(115Tbits/s),功耗估计约2500W,是当前Quantum-X交换机144端口版本带宽的4倍。

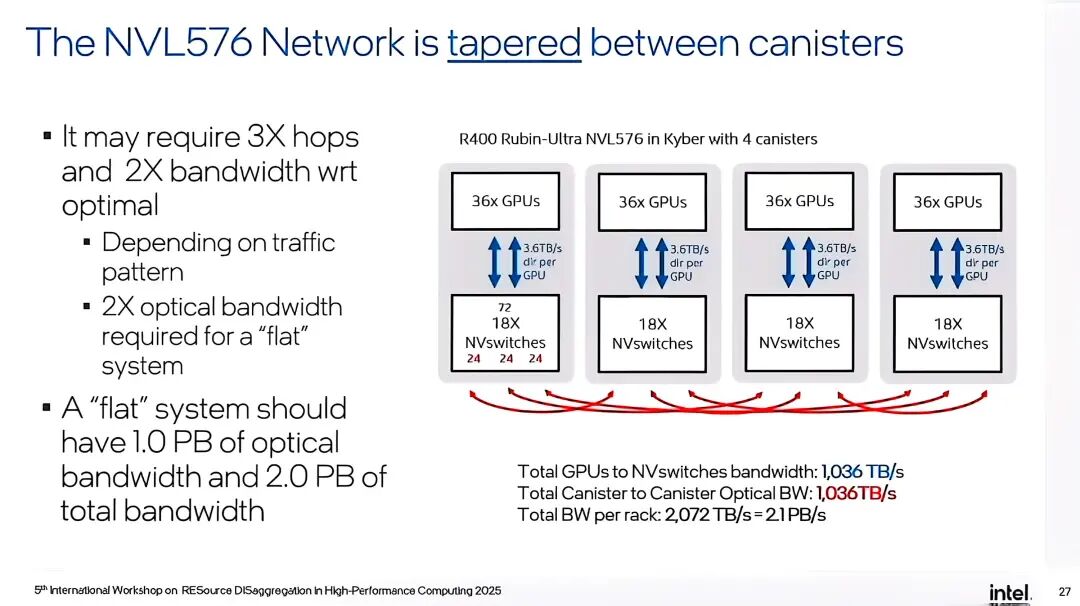

从带宽分布来看,NVL576在canister内通过正交PCB背板实现259.2TB/s的连接带宽,而canister间连接则依赖光子学技术,提供518TB/s的光带宽;GPU到NVswitch的总带宽达到1036TB/s,整机总带宽1.5PB/s。但即便如此,系统仍面临难以逾越的瓶颈:首先是网络的“锥形限制”,canister间通信仅能获得1/3的最优带宽,若要实现全系统无阻塞的“扁平”架构,需将光带宽提升至2PB/s,且数据传输可能需要经过3跳路由,不仅增加延迟,更超出了当前混合架构的承载能力。

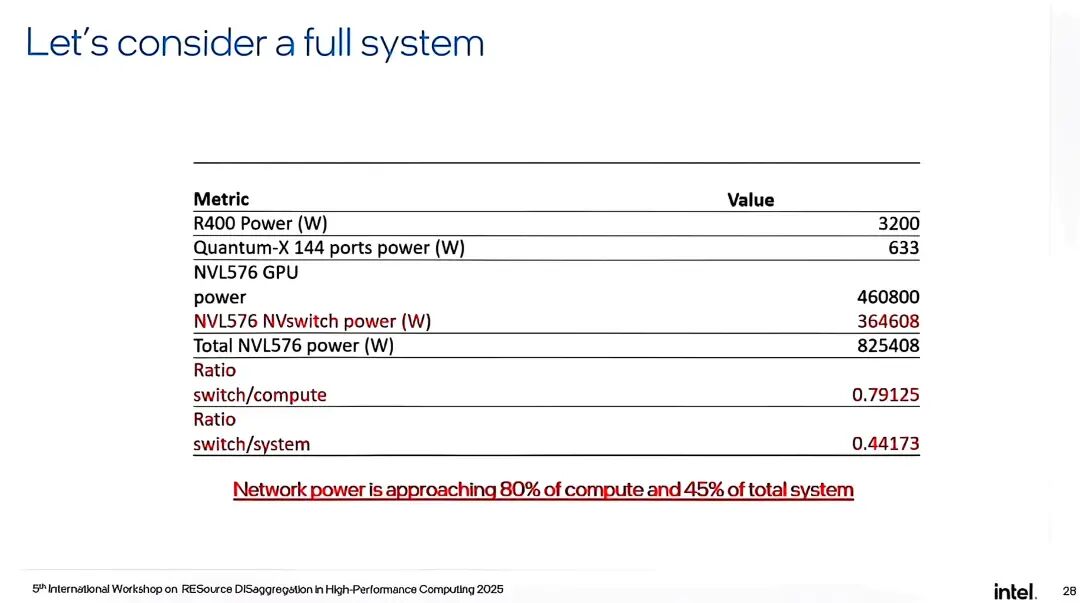

其次是功耗与成本的失控。根据公开数据估算,NVL576的GPU总功耗达460800W,NVswitch总功耗为364608W,整机总功耗高达825408W(约825KW),远超NVL72的150KW。更值得关注的是功耗占比的结构性变化:过去HPC系统遵循“网络成本不超过5%”的公理,而NVL576的网络功耗已接近计算部分的80%,占系统总功耗的45%左右。这一变化背后,是AI应用对通信密集度的需求激增,传统“轻网络、重计算”的架构已无法适配,而铜缆技术为实现高带宽所付出的功耗代价,进一步推高了系统的TCO。

此外,NVL576的可制造性也备受质疑。行业分析人士指出,系统宣称的6个网络刀片可能无法满足实际连接需求,需增加至8个或更多,而铜缆正交背板的高密度连接设计面临物理空间与信号干扰的双重挑战。演讲者也坦言,即便基于现有设计,1.5PB/s的带宽目标其可制造性仍存疑——铜缆技术已被物理定律推向极限,任何进一步的性能提升都将面临“投入产出比失衡”的困境。

◆ 技术突围:光子学驱动的解聚式系统架构

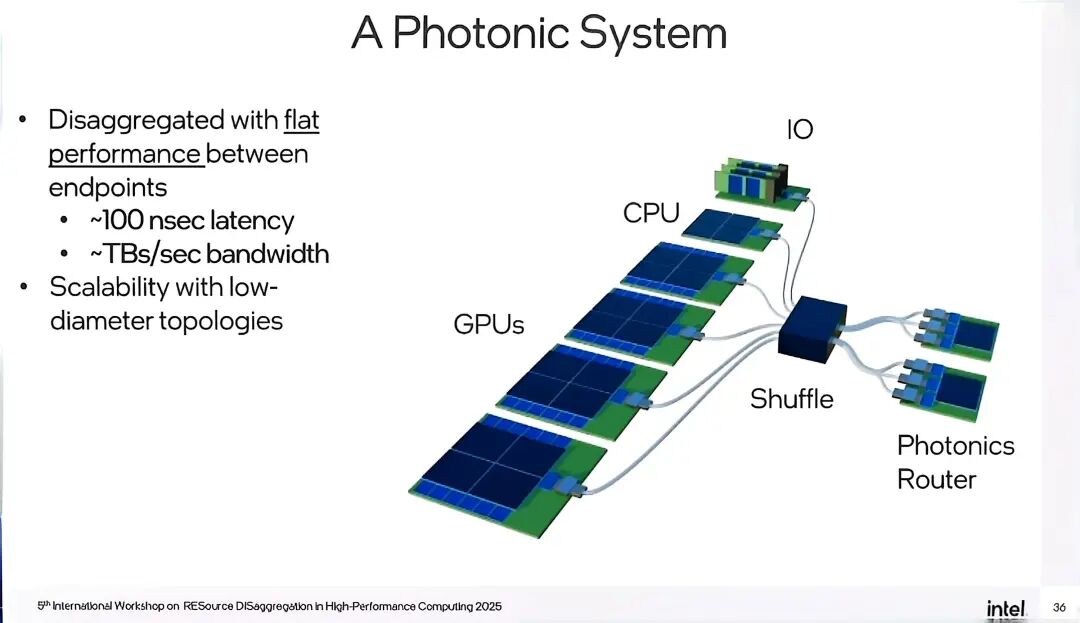

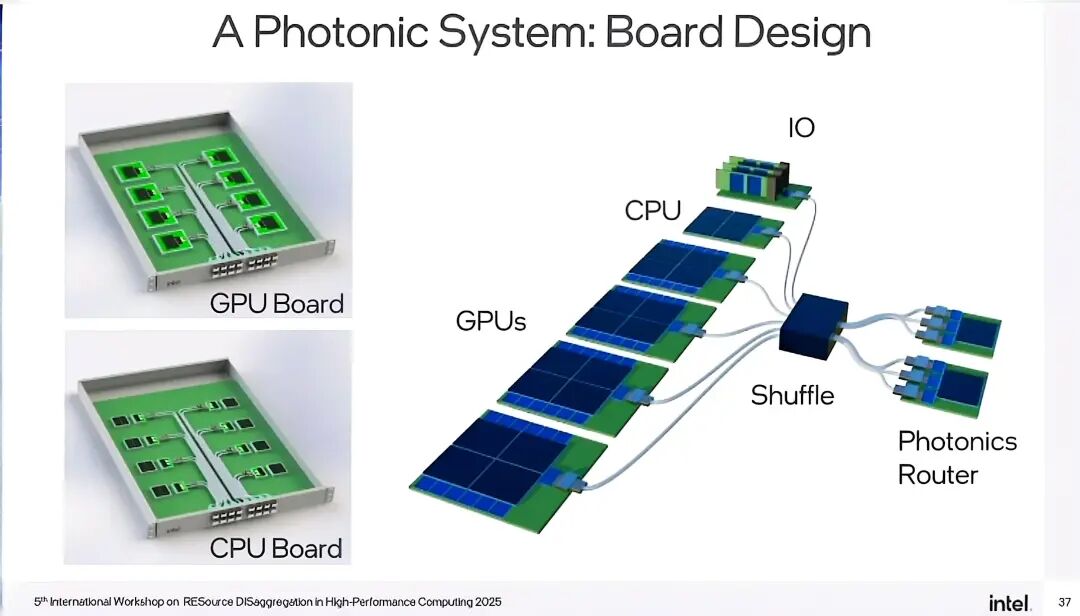

当铜缆技术走到尽头,光子学成为超算与AI系统实现规模化发展的唯一选择。与铜缆相比,光子学不仅能突破传输距离的限制,更能实现功耗、带宽、 时延的协同优化,其核心价值在于推动系统从“聚合式”向“解聚式”转型,彻底重构超算与AI的架构逻辑。

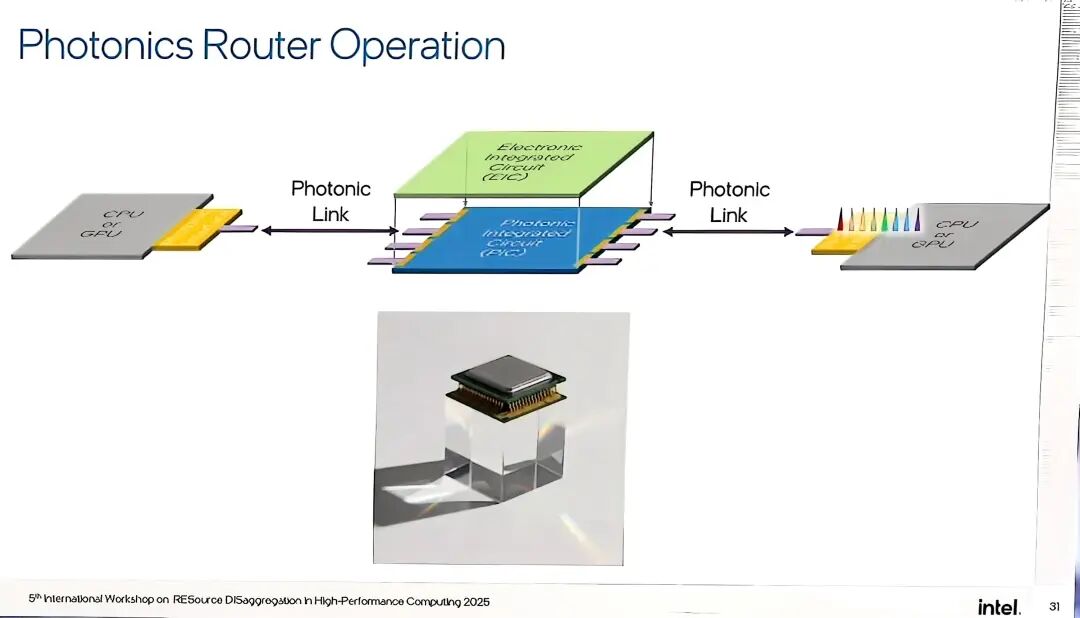

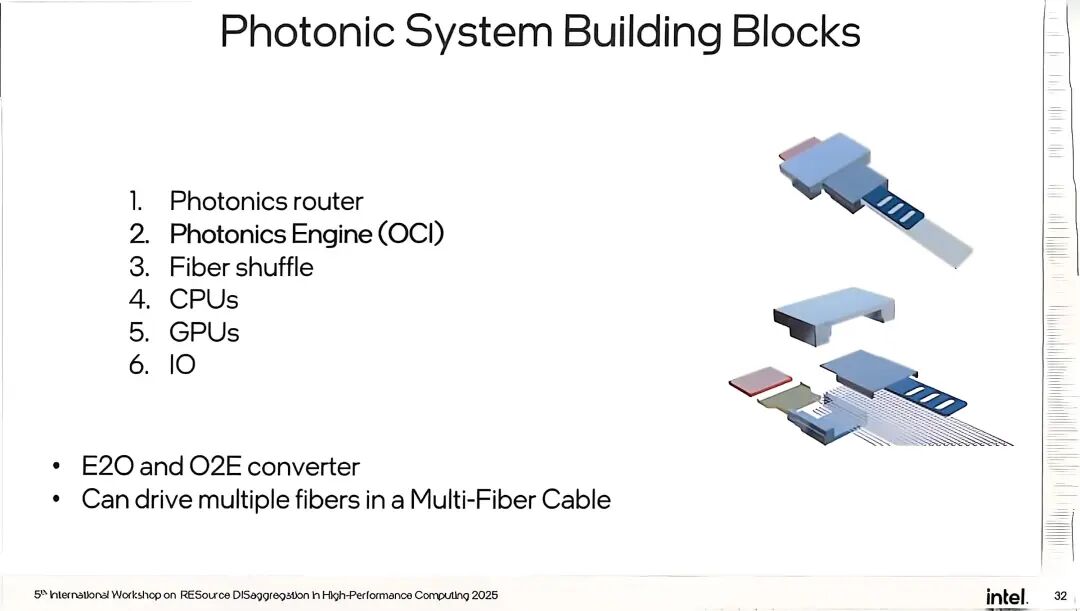

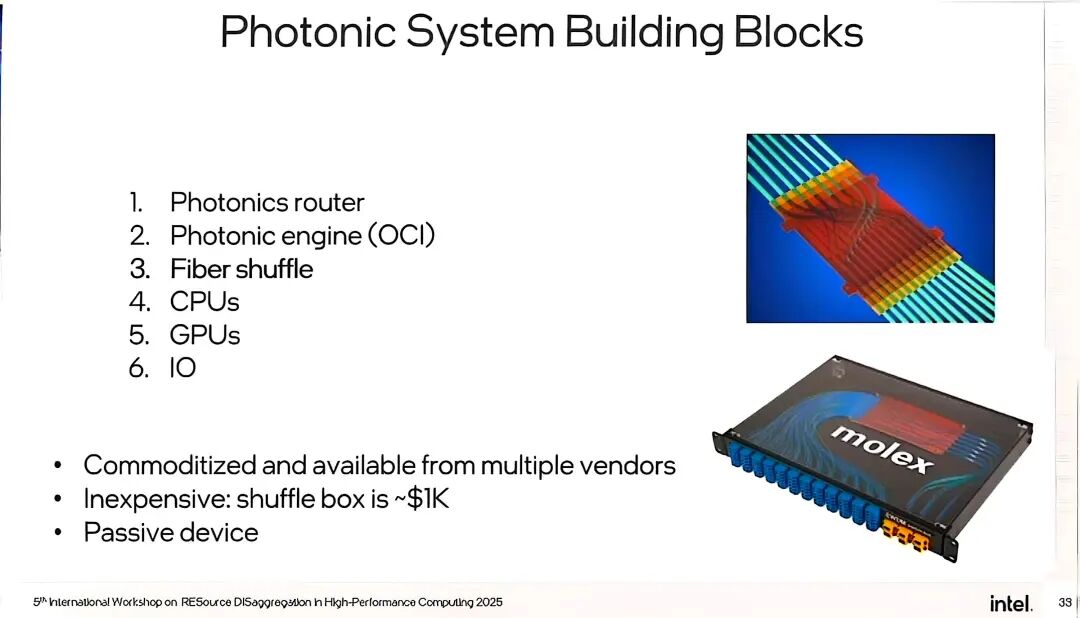

光子学系统的核心组件包括四大模块:光子路由、光子引擎(OCI)、光纤交换器与CPU/GPU终端。其中,光子路由器是解聚式架构的核心,采用WDM(波分复用)技术,支持TB/s级带宽与~100ns的时延,能够实现扁平化、低直径拓扑,确保系统在解聚状态下仍具备高效的端到端性能。光子引擎(OCI)负责电-光(E2O)与光-电(O2E)转换,其功耗占比与铜缆系统形成鲜明对比——光子学系统的功耗预计仅为铜缆系统的1/3,且能有效避免铜缆的散热压力。

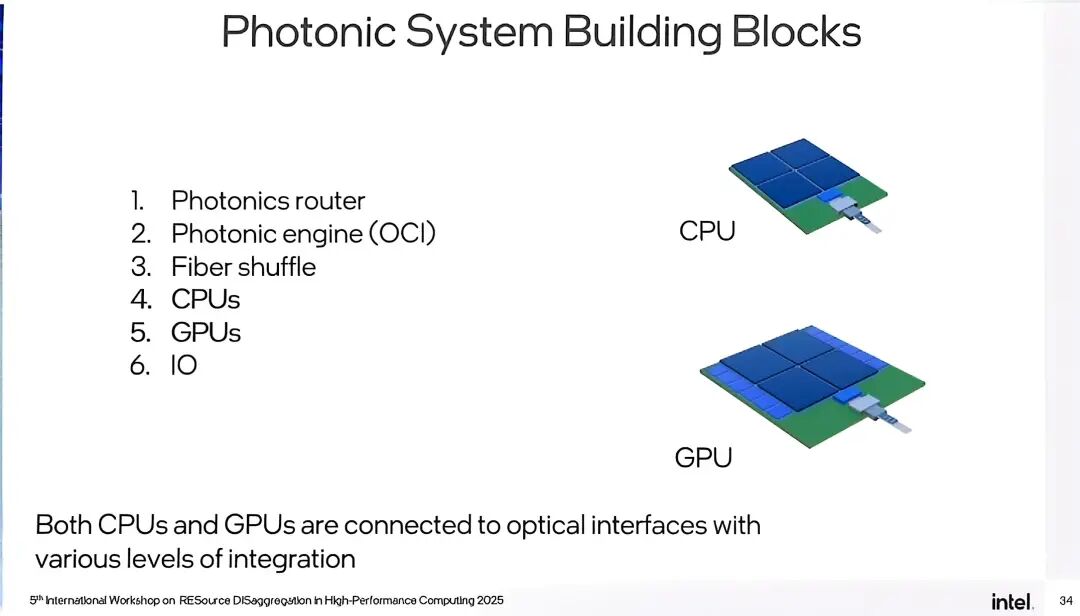

光纤重排器作为无源器件,具有成本低廉(约1000美元/台)、易于量产的优势,可支持多厂商供应,有效降低系统的供应链风险。值得注意的是,光子学系统的集成方式正朝着“近封装”演进——CPU与GPU通过不同层级的集成方案连接至光接口,既保证了连接的稳定性,又降低了终端设备的改造难度。

与NVL系列的聚合式架构不同,光子学解聚式系统彻底摆脱了铜缆对距离与密度的限制:计算节点(CPU/GPU)与网络节点通过光纤灵活连接,无需再为缩短传输距离而进行高密度聚合,系统的物理布局更灵活,维护效率大幅提升(无需再面对沉重的线缆束与繁琐的刀片更换流程)。同时,光子学系统的带宽可随节点数量线性扩展,网络成本与功耗占比更趋合理,能够有效解决AI应用的通信密集需求与TCO控制之间的矛盾。

不过,光子学技术的落地仍面临挑战:激光组件的成本与安全性、3D堆叠封装的技术难度、光开关的量产良率等问题,仍是行业需要攻克的关键点。但演讲中强调,这些挑战已不再是“能否解决”,而是“何时解决”——当铜缆系统的TCO与可制造性触及天花板,市场需求将倒逼光子学技术加速成熟,而当前多家头部企业的研发投入已证明,光子学的规模化应用已进入倒计时。

◆ 结语:架构革命背后的技术必然 从NVL72到NVL576,铜缆技术在超算与AI领域的应用已逼近极限,而光子学的崛起并非偶然,而是技术演进与市场需求共同作用的必然结果。这场转型不仅是传输介质的更换,更是系统架构的根本性革命——它打破了聚合式架构的物理枷锁,让解聚式系统成为可能,为超算与AI的持续规模化发展提供了新的技术路径。 演讲中多次强调,技术决策的核心驱动力并非单纯的性能提升,而是TCO与量产能力(HVM)。光子学系统之所以能成为下一代技术标杆,正是因为它在突破性能瓶颈的同时,能够有效控制功耗与成本,适配大规模量产的需求。2028年的技术转折点已清晰可见,铜缆的时代即将落幕,而光子学将开启超算与AI系统的新篇章。

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2025-11-28,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读