从空冷到浸没式液冷:AI数据中心热管理与光模块技术的协同革新

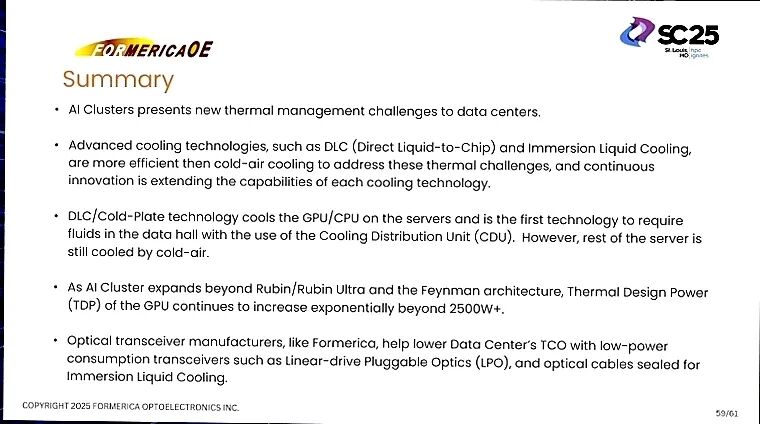

随着AI与HPC(高性能计算)集群规模持续扩张,数据中心正面临前所未有的热管理与功耗挑战。GPU热设计功耗(TDP)呈指数级增长,即将突破2500W+,传统冷却技术与光通信方案已难以平衡性能、效率与成本。Formerica Optoelectronics在SC 25会议上,以“从传统到下一代光学:空冷、液冷、浸没——重新思考、评估、定义”为主题,系统阐述了数据中心冷却技术的演进路径,以及线性驱动可插拔光学(LPO)与浸没式液冷光学解决方案的技术突破,为AI时代数据中心的高效运行提供了关键支撑。

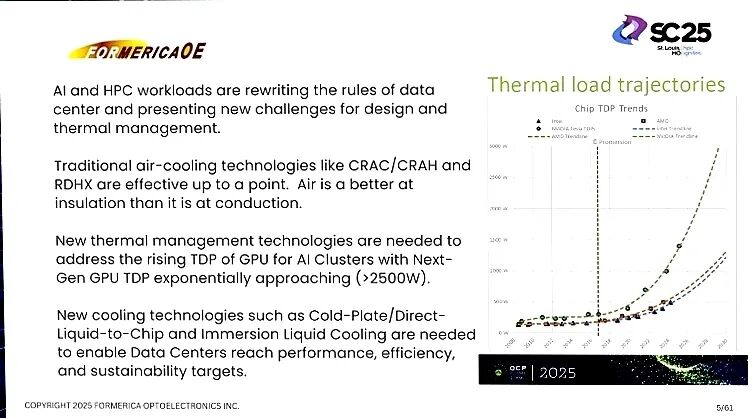

一、AI数据中心的核心困境:热管理与功耗的双重压力 AI与HPC工作负载彻底改写了数据中心的设计规则,核心矛盾集中在热管理与功耗控制上。一方面,AI集群的功率密度持续飙升,从DGX A100到Rubin Ultra(NVL576),单机架功耗不断突破上限,传统依赖CRAC/CRAH机组与散热管道的空冷技术逐渐触及性能天花板;另一方面,数据中心需在提升计算能力的同时,降低总拥有成本(TCO)、减少空间占用,并满足可持续发展目标,这对冷却效率与设备兼容性提出了更高要求。

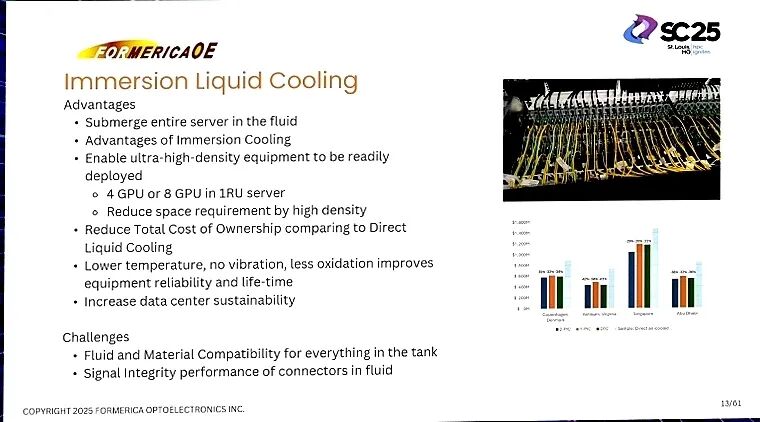

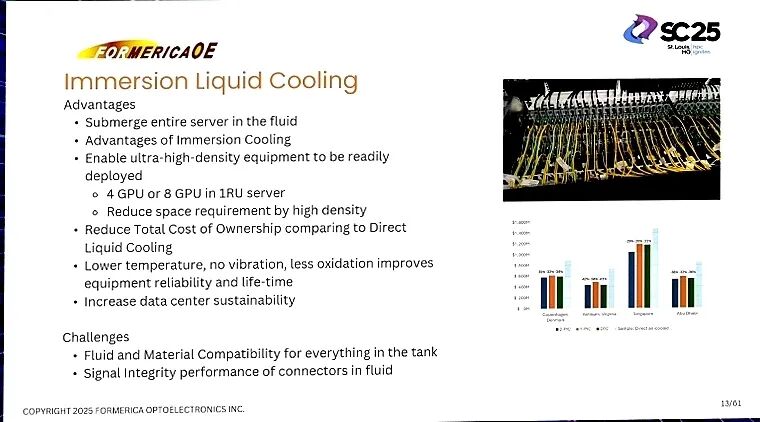

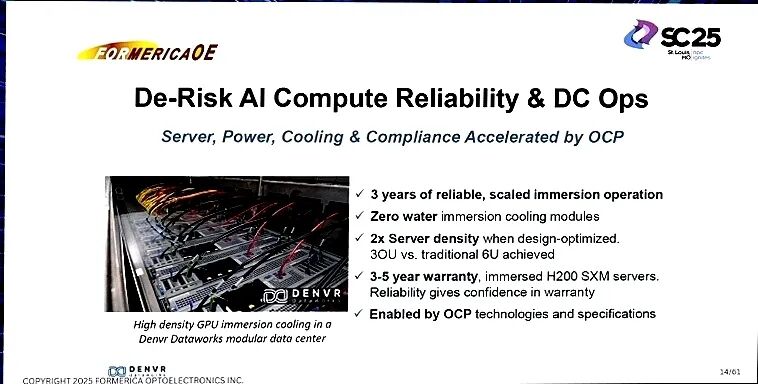

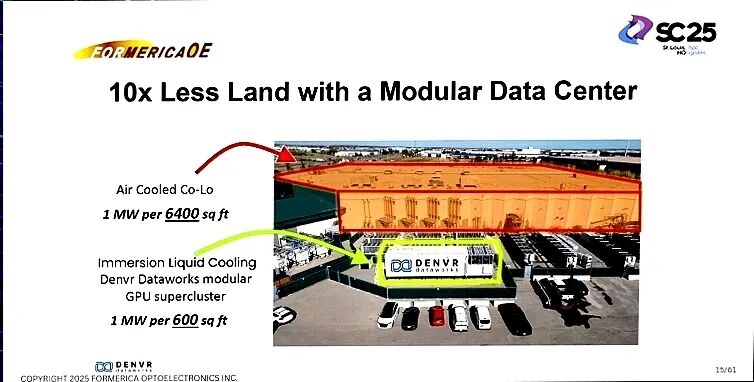

空气的隔热性能优于导热性能,传统空冷不仅散热效率有限,还需配备大量风扇与管道,既占用宝贵的机房空间,又产生持续噪音。随着GPU TDP向2500W+迈进,单纯依赖空冷或局部冷却技术已无法解决全域散热问题,下一代冷却技术与低功耗光通信方案的协同创新成为必然选择。 二、冷却技术的迭代之路:从空冷到浸没式液冷的进化 为应对热管理挑战,数据中心冷却技术经历了从传统空冷到精准液冷的逐步升级,不同技术路径各有优劣,也推动着行业向更高效、更可靠的方向演进。 传统空冷技术凭借成熟度与低成本长期占据市场,但在高功耗场景下的局限日益凸显,散热效率不足、空间占用大、噪音污染等问题成为其适配AI集群的主要障碍。冷板/直接液冷(DLC)技术针对性解决了GPU与CPU的核心散热需求,通过液体直接接触发热部件实现高效降温,但该技术仅覆盖核心组件,服务器其余子系统仍需依赖空冷辅助,且存在管道泄漏与泄漏检测的潜在风险。 作为下一代主流冷却技术,浸没式液冷通过将整个服务器浸入专用冷却流体中,实现了全部件的全域散热,展现出显著优势:支持超高密度部署,1RU服务器可容纳4或8块GPU,大幅降低空间需求;流体散热避免了机械振动,减少设备氧化,显著提升硬件可靠性与使用寿命;无需额外风扇与复杂管道,实现无噪音运行,同时降低整体功耗与TCO,助力数据中心达成可持续发展目标。

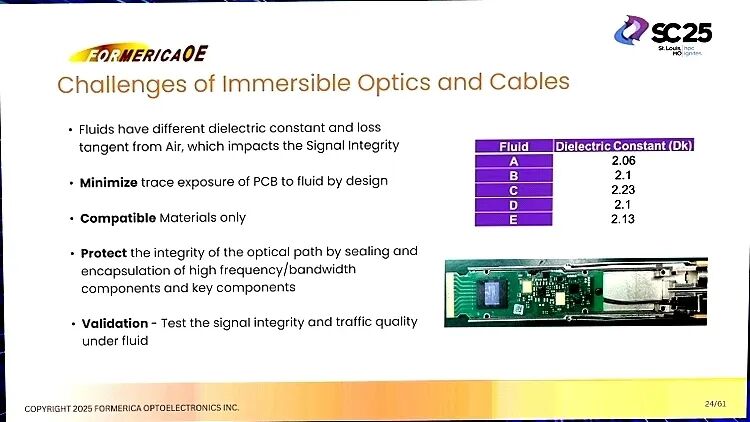

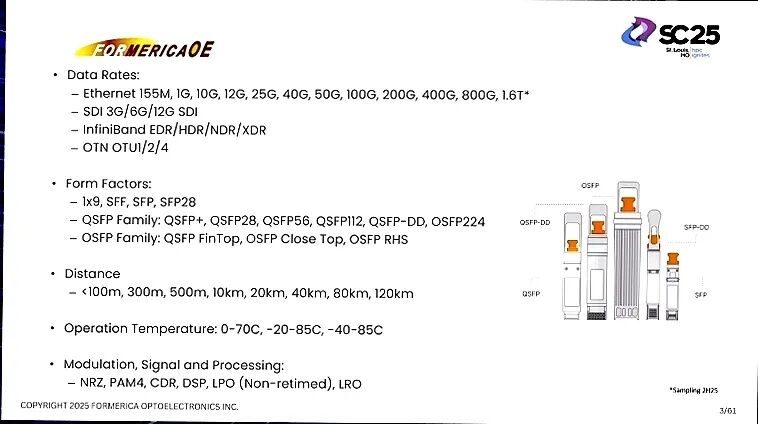

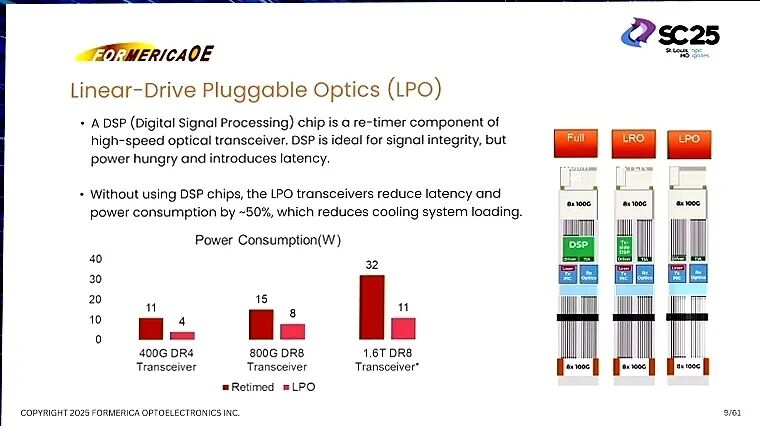

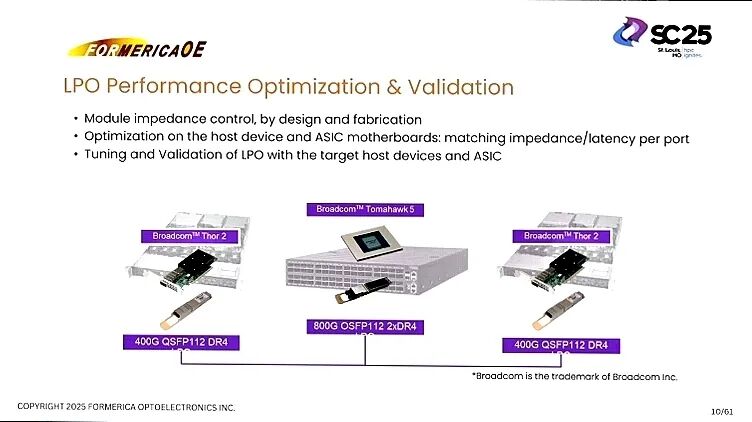

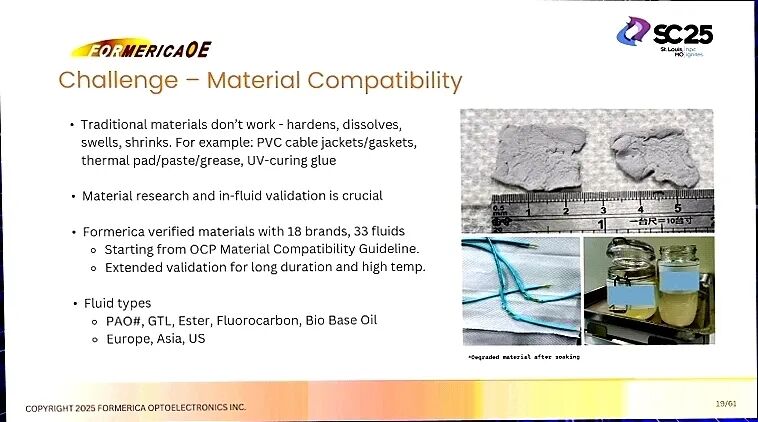

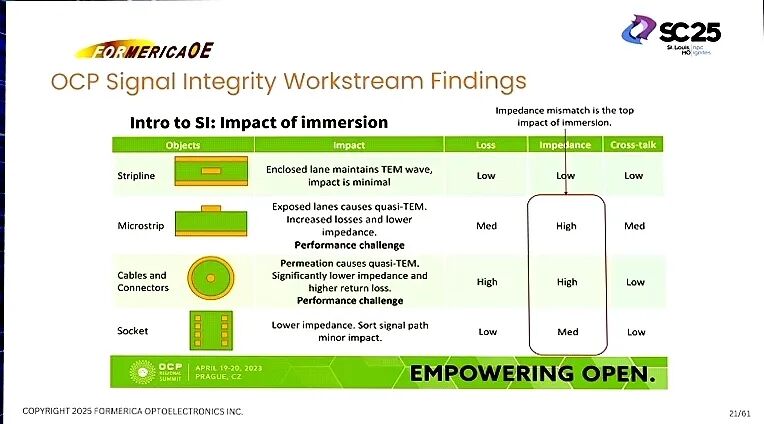

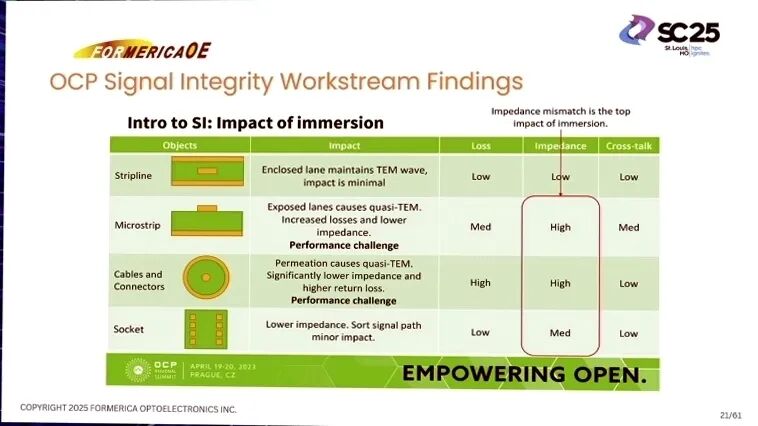

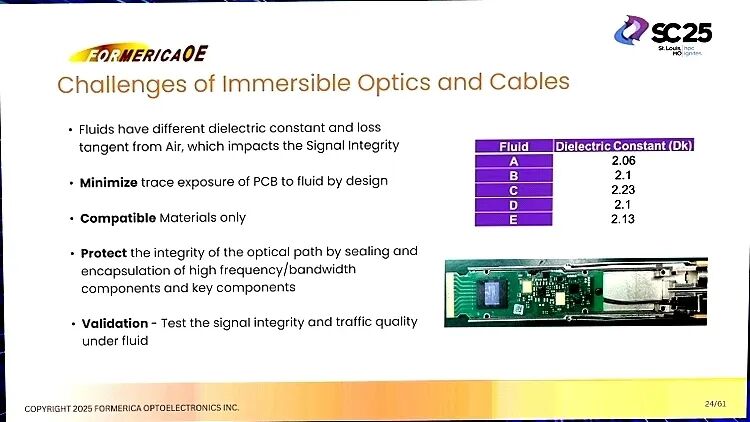

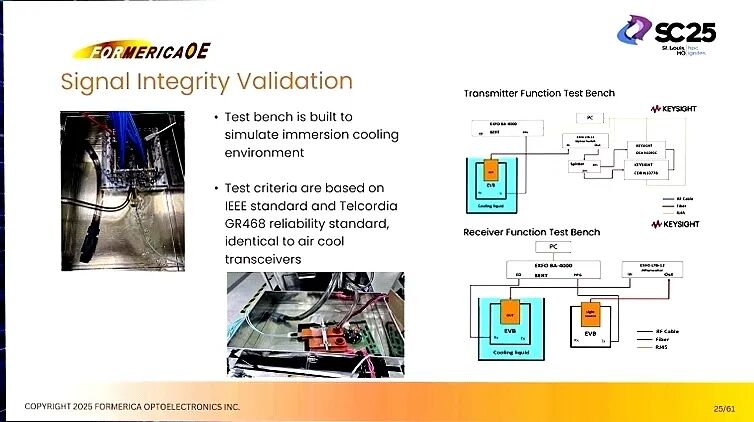

但浸没式液冷也面临独特挑战:冷却流体与服务器各类材料的兼容性需严格验证,信号在液体环境中的完整性易受介电常数变化影响,此外标准化与互操作性问题也亟待行业协同解决。这些挑战成为制约浸没式液冷规模化应用的关键瓶颈,也推动着光学通信与材料技术的针对性创新。 三、核心技术突破:LPO与浸没式光学解决方案的协同赋能 针对AI数据中心的功耗与冷却痛点,Formerica推出了以线性驱动可插拔光学(LPO)技术与浸没式液冷光学解决方案为核心的组合拳,从功耗控制与散热适配两个维度实现技术突破。 (一)LPO技术:低功耗光通信的核心支撑 传统高速光模块依赖DSP(数字信号处理)芯片进行信号重定时,虽能保障信号完整性,但存在功耗高、 时延大的问题,间接增加了冷却系统负担。LPO技术通过移除DSP芯片,重构信号传输架构,实现了双重核心优势:功耗降低约50%, 时延显著减少,直接缓解了数据中心的功耗与散热压力;同时通过模块阻抗的设计与制造控制,以及与主机设备、ASIC主板的阻抗/延迟匹配优化,确保了高速传输性能。

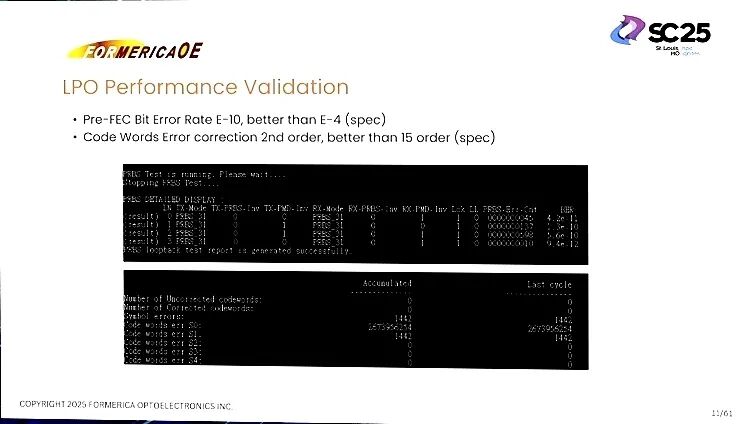

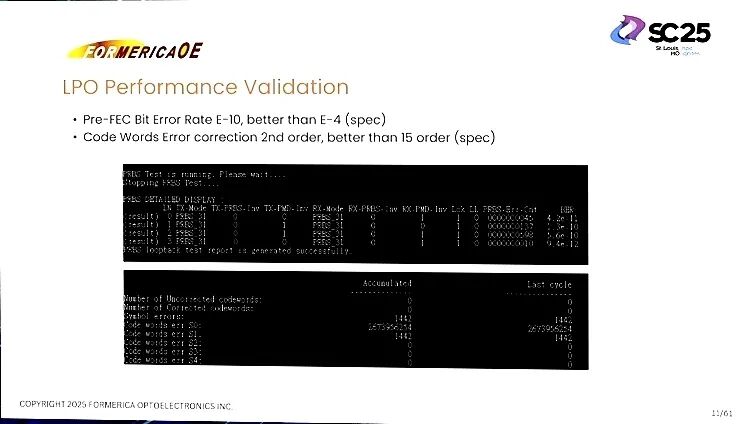

目前,LPO技术已完成多平台验证,在400G QSFP112 DR4与Broadcom Thor2、800G OSFP112 2xDR4与Broadcom Tomahawk5等组合测试中,前向纠错前误码率(Pre-FEC BER)达到E-10,优于E-4的行业标准,二阶纠错能力也超出规范要求,完全满足AI集群高速低延迟的通信需求。 (二)浸没式液冷光学解决方案:突破场景适配瓶颈 针对浸没式液冷的核心挑战,Formerica通过系统性测试与设计优化,构建了成熟的浸没式光学解决方案,关键突破集中在材料兼容性与信号完整性两大维度。

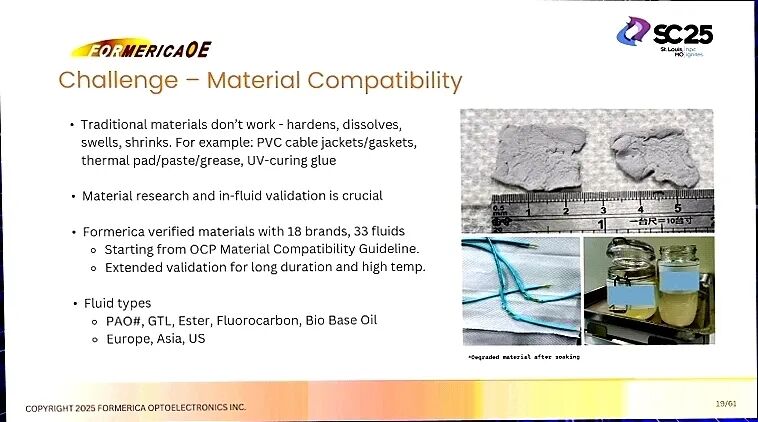

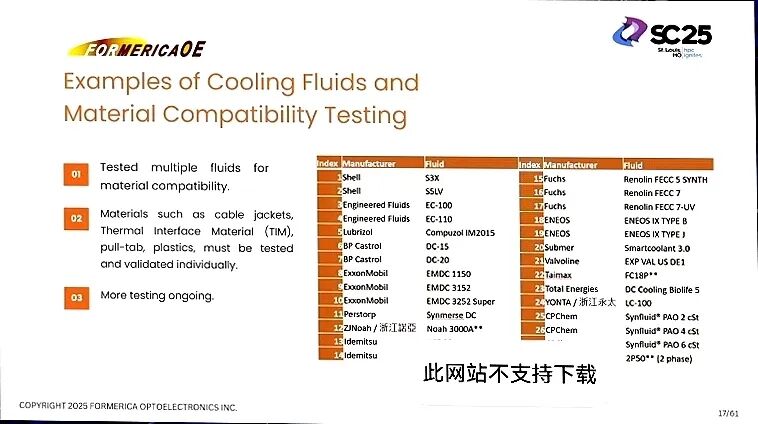

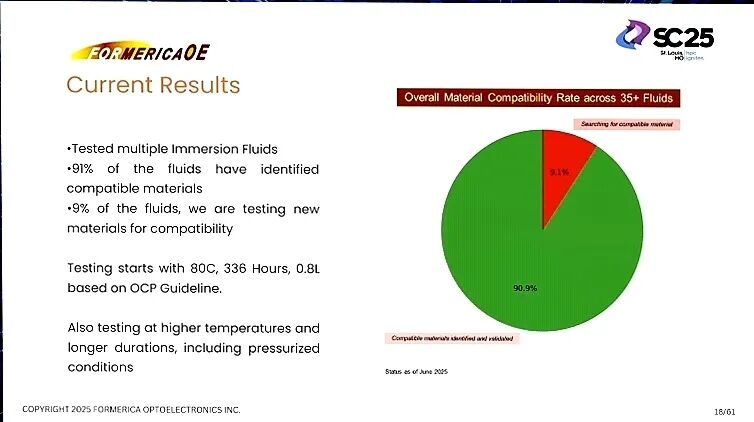

在材料兼容性方面,团队基于OCP材料兼容性指南,开展了大规模测试验证,覆盖Shell、Fuchs、Engineered Fluids等18个品牌的35+种冷却流体,包括PAO、GTL、酯类、碳氟化合物、生物基油等多种类型,最终实现90.9%的兼容率。测试不仅涵盖常温环境,还延伸至高温、加压等严苛条件,初始测试以80℃、336小时、0.8L为标准,确保电缆护套、热界面材料、塑料件等关键组件在长期使用中不出现硬化、溶解、膨胀或收缩等问题,彻底解决传统材料在浸没环境中的适配难题。

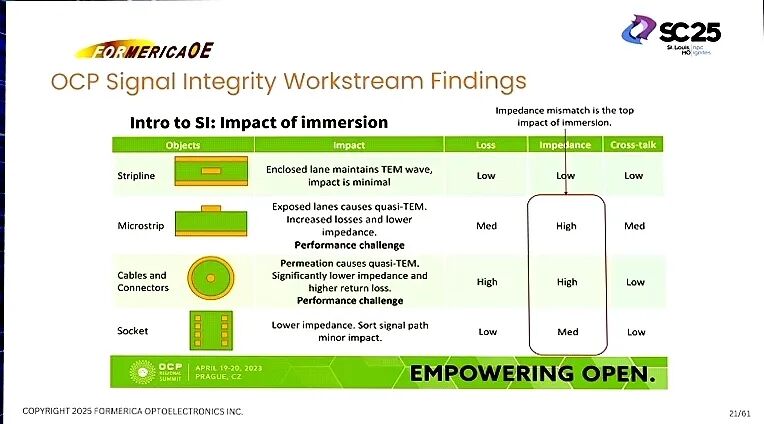

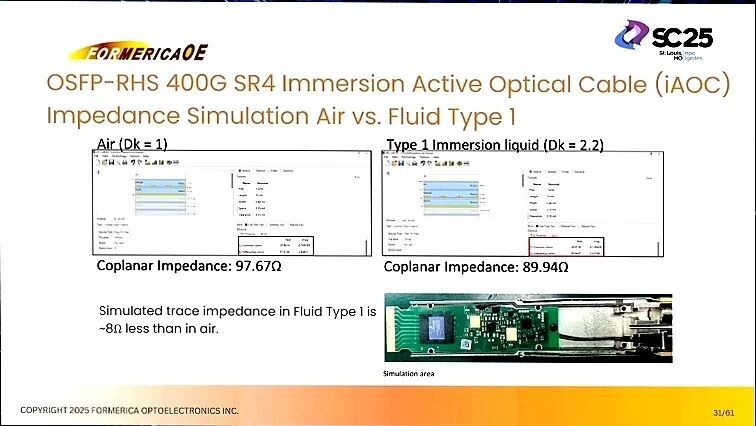

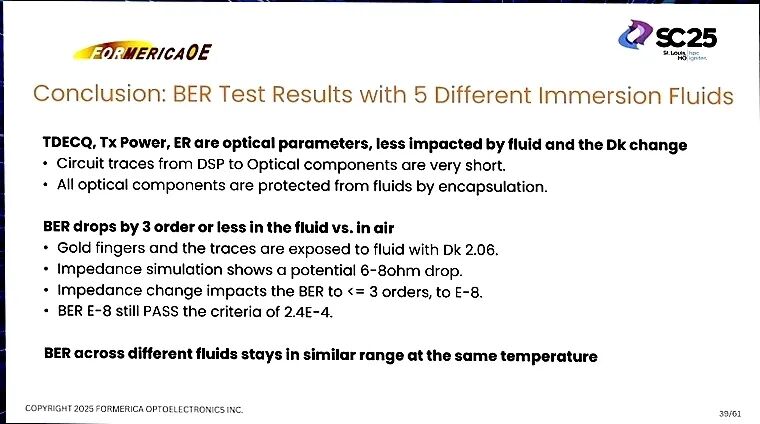

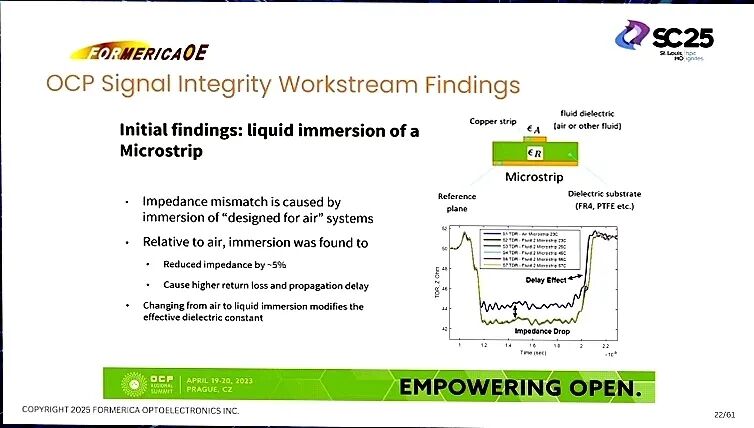

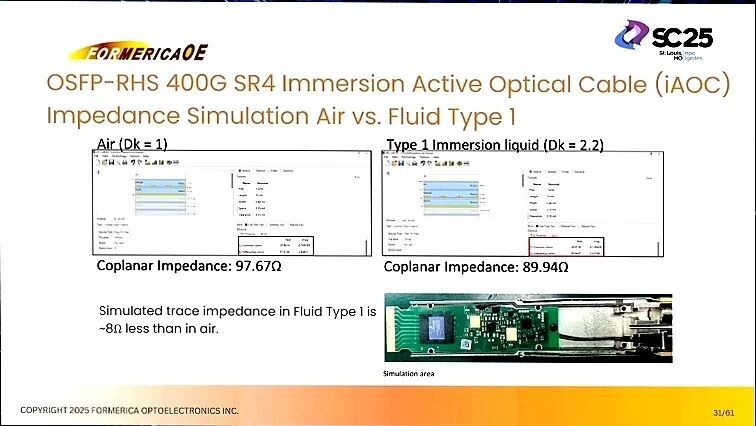

信号完整性方面,液体介质的介电常数(如部分流体Dk=2.06)与空气(Dk=1)存在显著差异,易导致阻抗失配与信号传输质量下降。为应对这一问题,解决方案通过三大设计优化实现突破:对光学组件进行封装保护,避免流体直接接触;优化PCB设计,最大限度减少线路暴露;针对不同流体的介电特性与损耗角正切值,进行传输线路的针对性调校。测试数据显示,OSFP-RHS 400G SR4浸没式有源光缆(iAOC)在流体环境中的共面阻抗为89.94Ω,虽较空气环境的97.67Ω降低约8Ω,但仍处于稳定传输的合理范围,未对信号质量造成实质性影响。

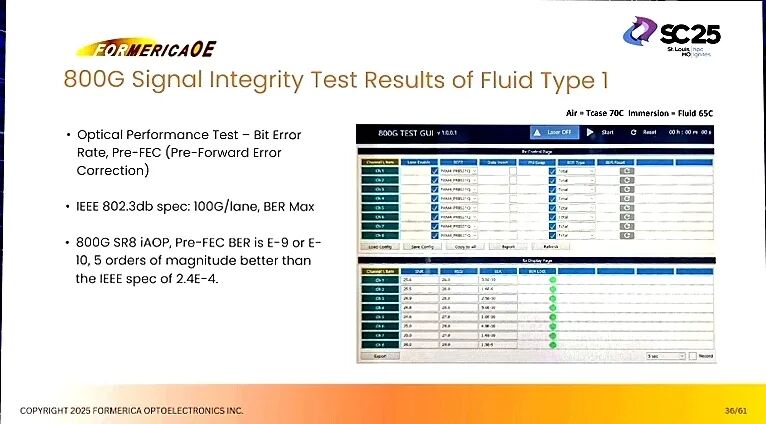

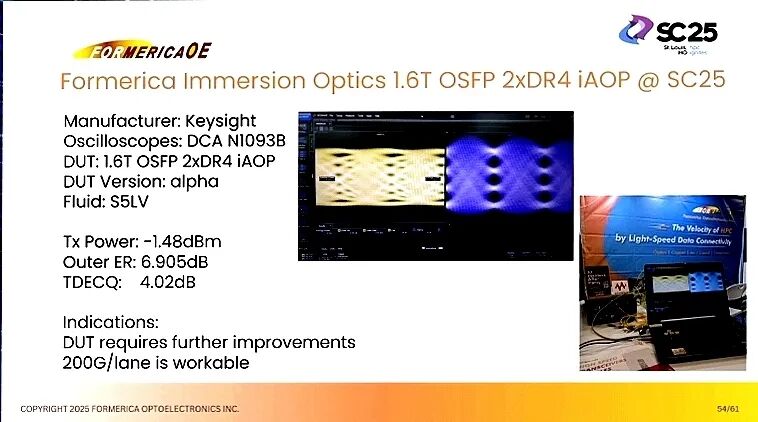

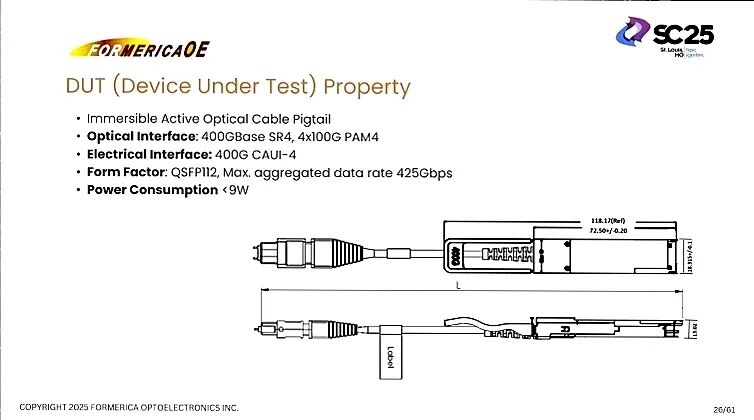

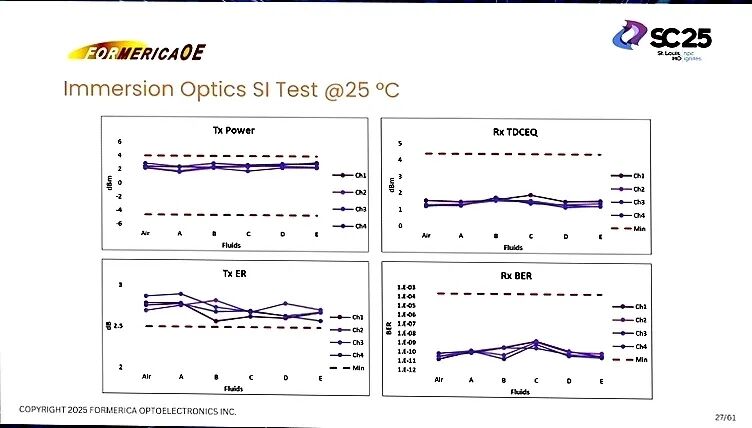

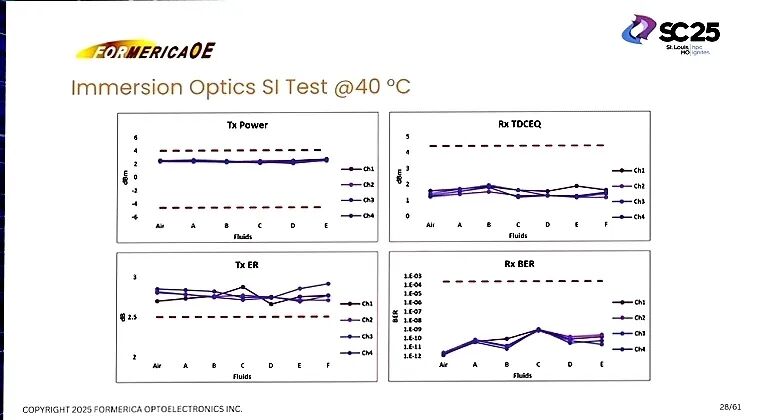

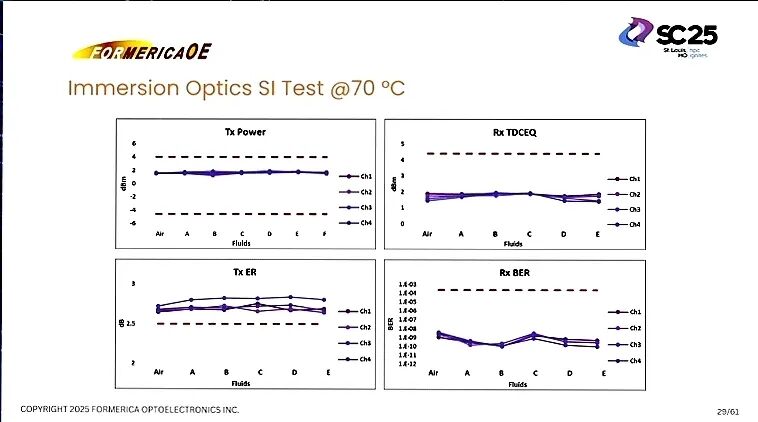

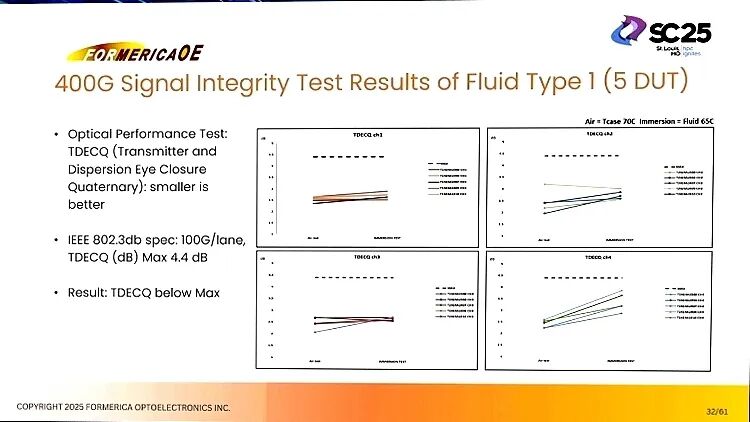

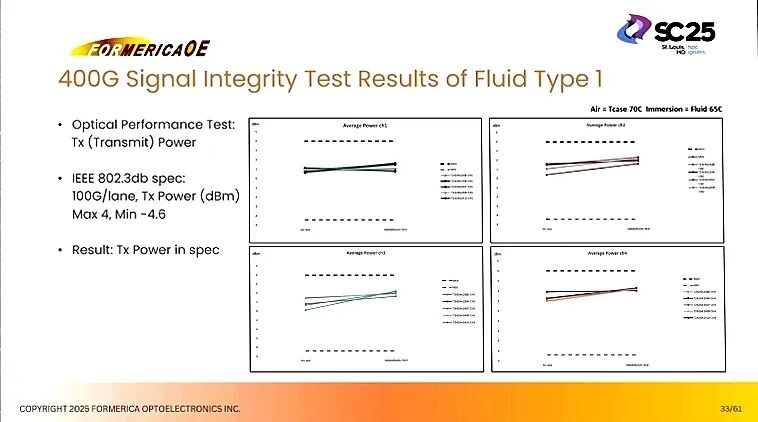

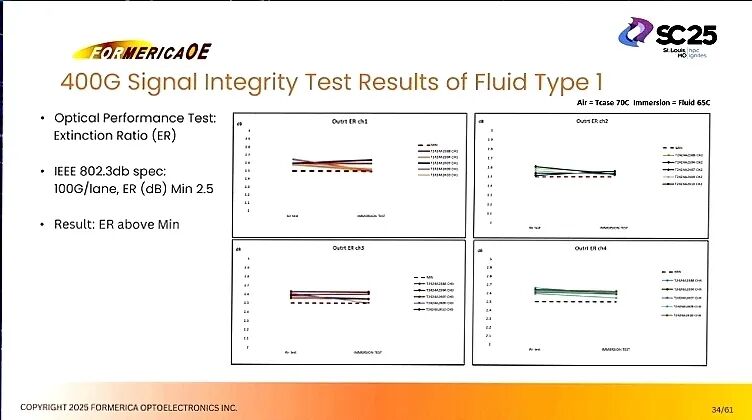

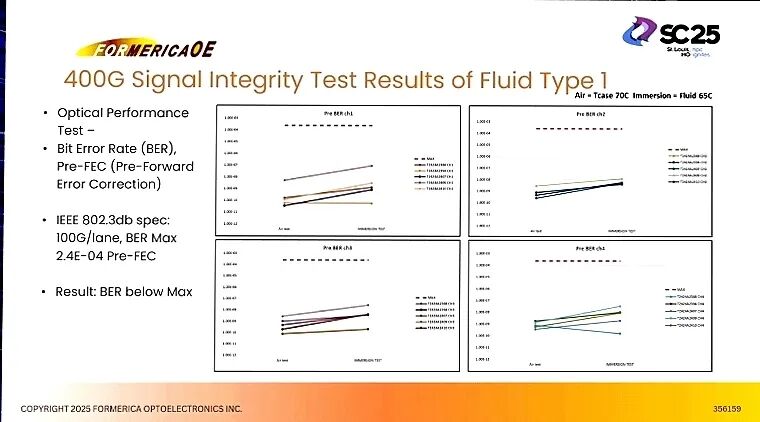

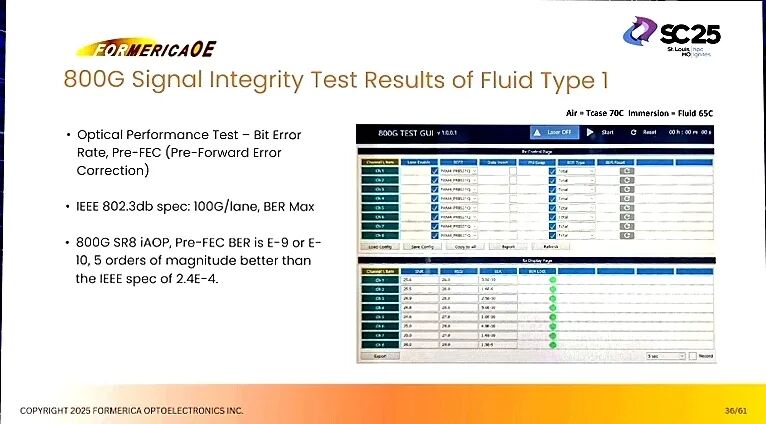

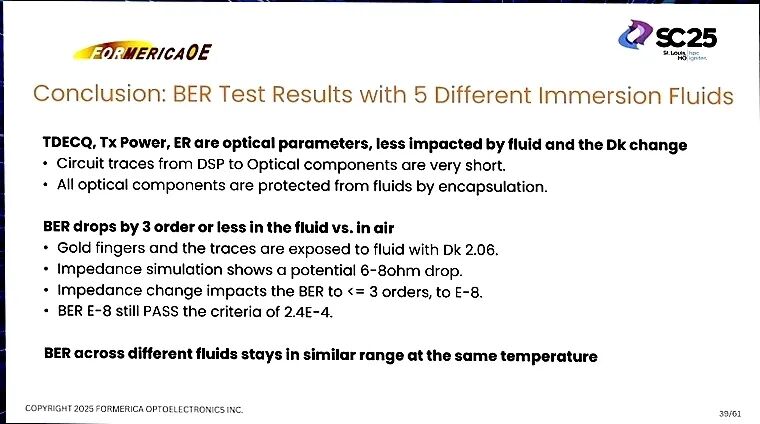

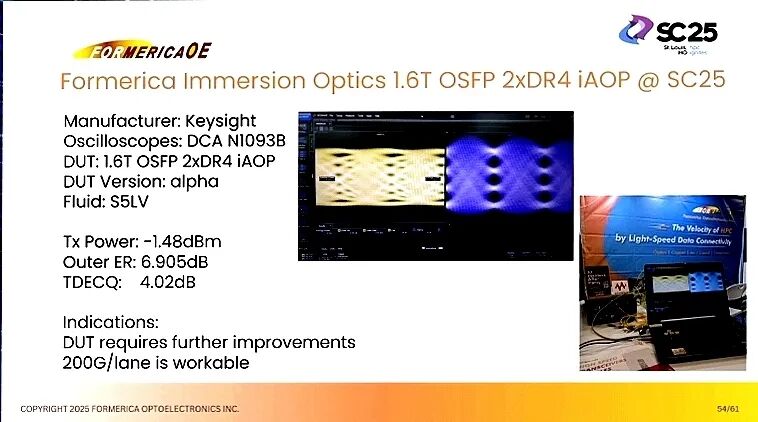

(三)测试验证:性能与可靠性双达标 一系列严苛测试验证了浸没式光学解决方案的实用性与稳定性。在性能测试中,400G与800G iAOC的关键参数均满足IEEE 802.3db标准:TDECQ(发射色散眼闭度)低于4.4dB的最大值要求,发射功率处于-4.6dBm至4dBm的规范区间,消光比(ER)高于2.5dB的最小值标准,Pre-FEC BER低于2.4E-04的上限,其中800G iAOC的BER更是达到E-9至E-10,较标准要求提升5个数量级。

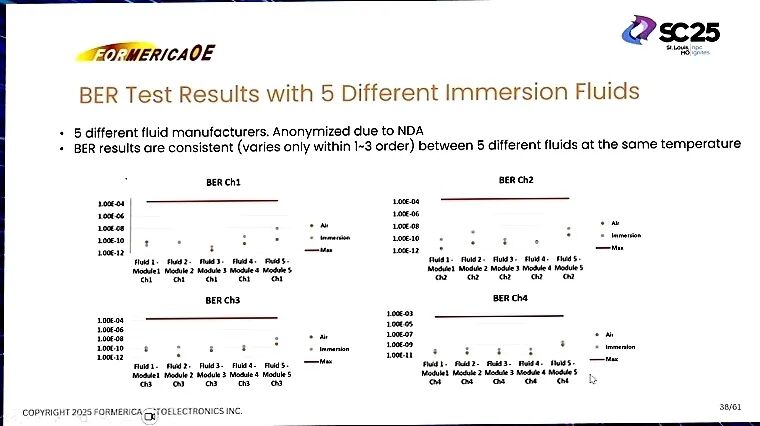

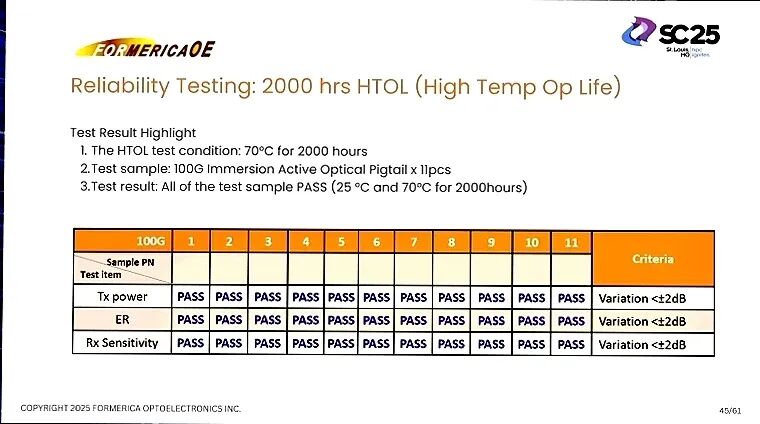

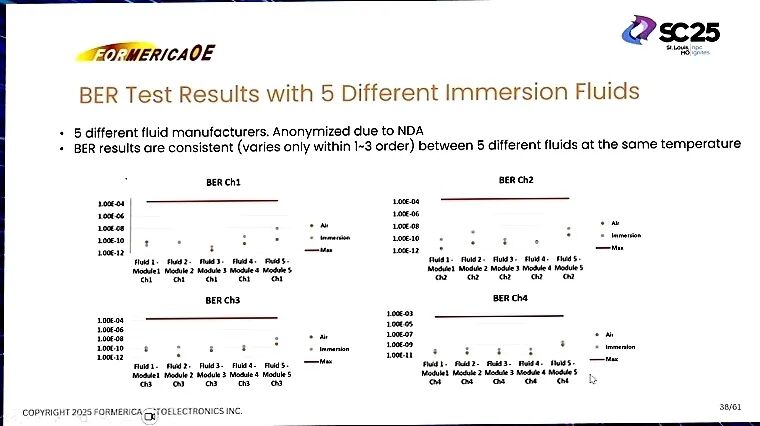

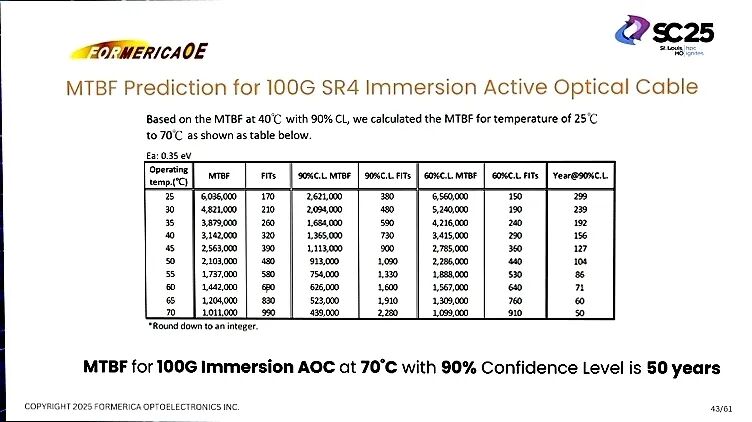

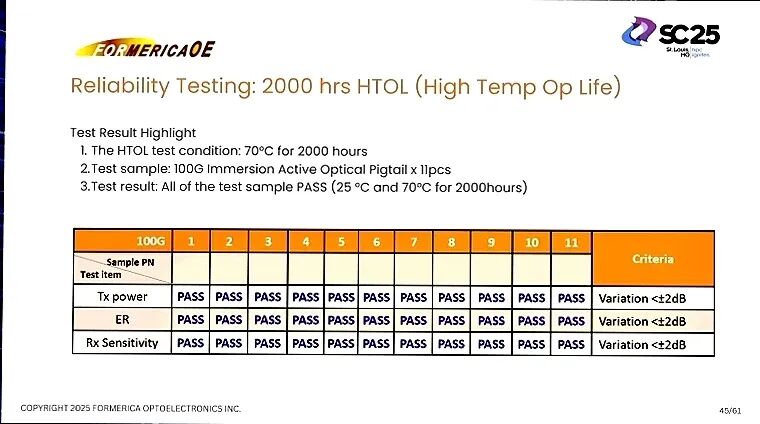

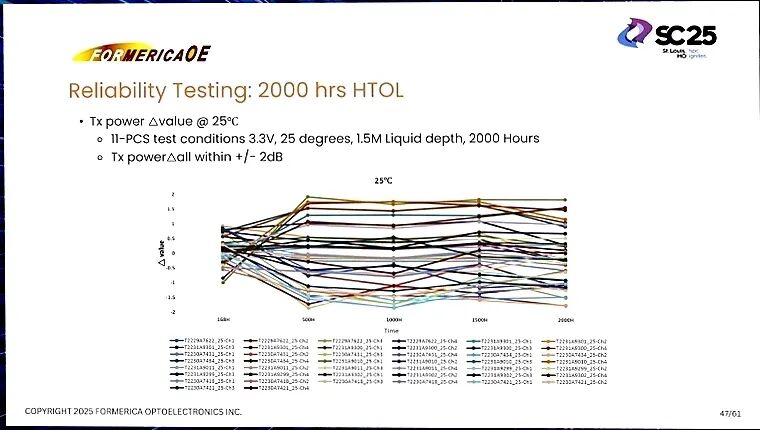

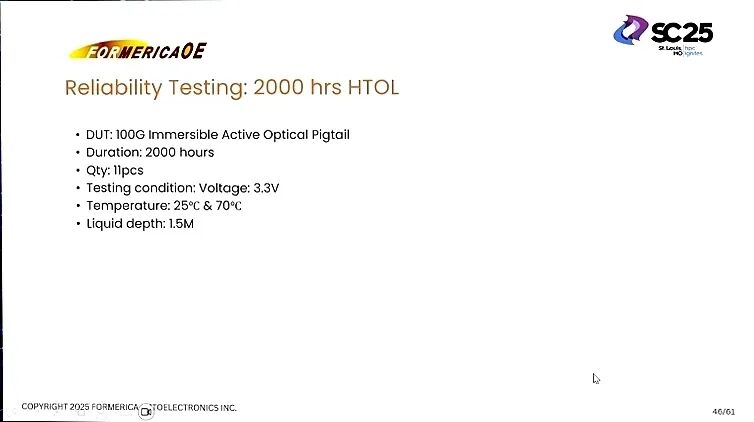

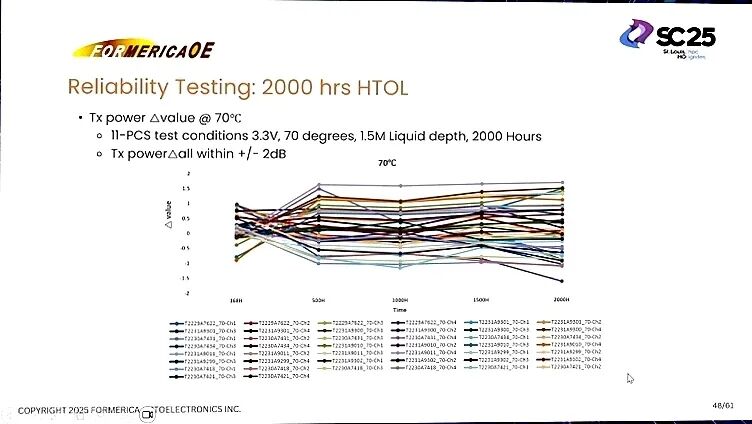

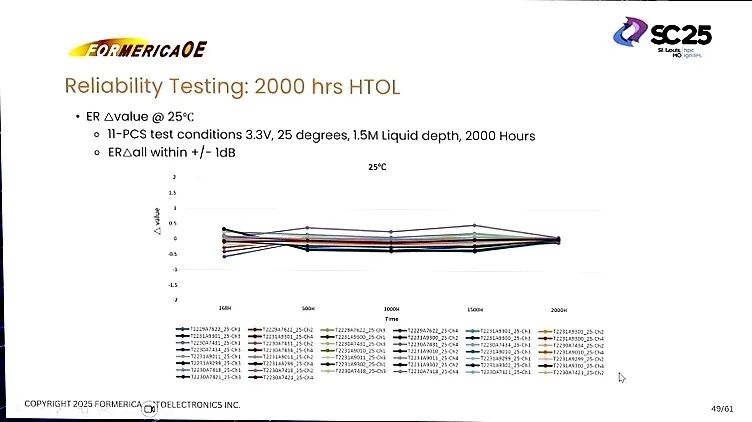

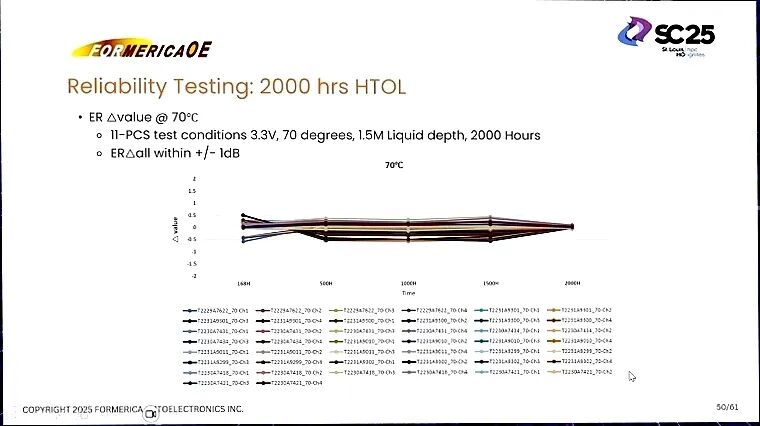

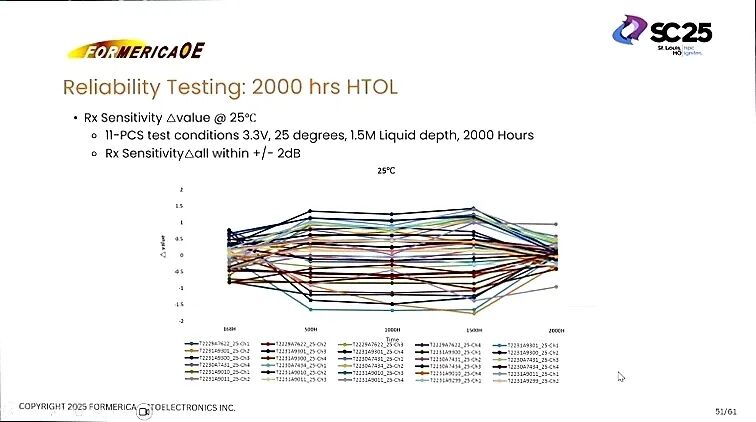

可靠性测试同样表现优异:100G QSFP28 SR4 iAOC在70℃、90%置信水平下的平均无故障时间(MTBF)达到50年;11个100G浸没式有源光尾纤样品,在3.3V电压、1.5米液深条件下,分别经过25℃与70℃、2000小时的高温工作寿命(HTOL)测试,发射功率、消光比、接收灵敏度的变化量均控制在±2dB以内(消光比更是控制在±1dB内),全部通过验证。此外,5种不同品牌冷却流体的对比测试显示,相同温度下BER仅在1-3个数量级内波动,一致性良好,证明解决方案对不同流体环境的适配能力。

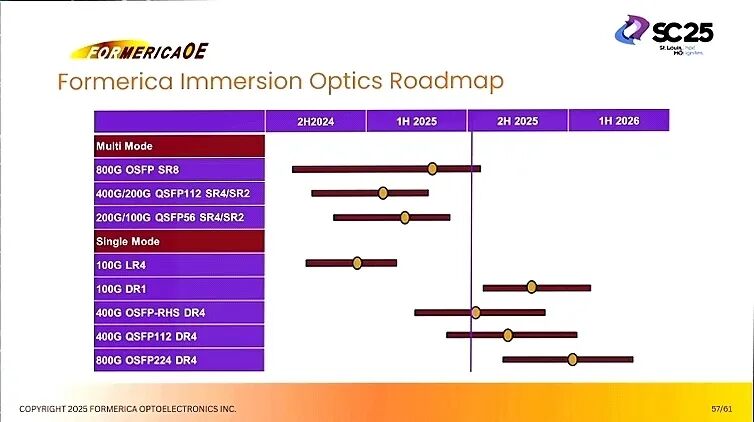

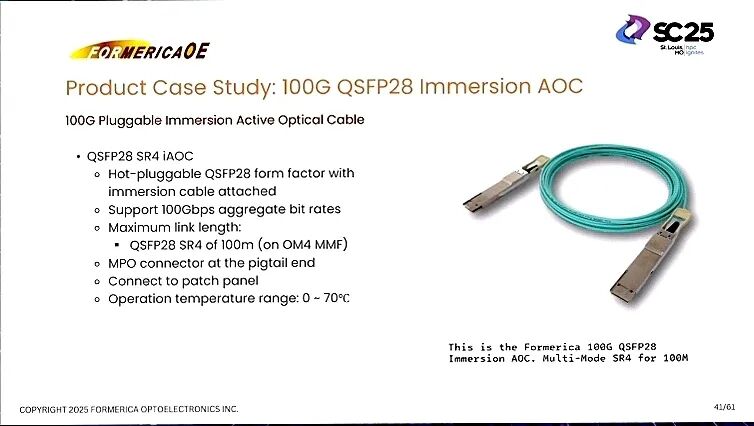

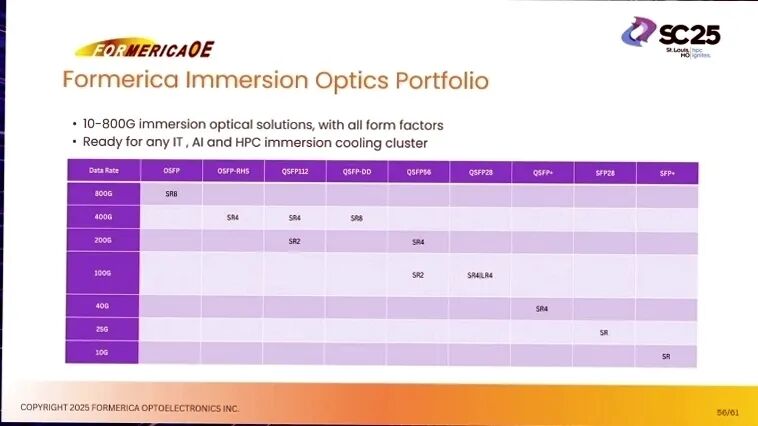

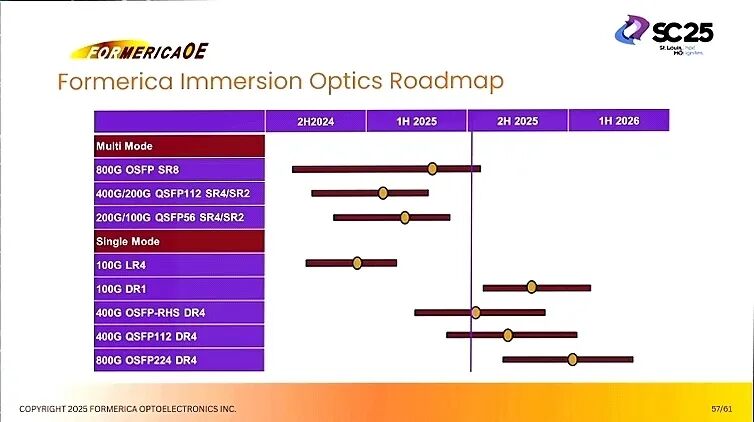

四、产品布局与未来路线:全面覆盖AI/HPC场景需求 当前,Formerica已构建覆盖10G至800G浸没式光学产品组合,包含QSFP、OSFP等多种封装形式,可适配IT、AI与HPC各类浸没式冷却集群。根据产品路线图,2024年下半年至2026年上半年,将持续丰富产品线:2024年下半年推出200G/100G QSFP56 SR4/SR2与100G DR1/LR4;2025年上半年上线400G QSFP112 DR4与400G/200G QSFP112 SR4/SR2;2025年下半年推出800G OSFP SR8多模产品;2026年上半年实现400G OSFP-RHS DR4单模与800G OSFP224 DR4的量产,形成全速率、全场景的产品矩阵。

五、结语:技术协同开启数据中心高效时代 AI数据中心的规模化发展,推动着冷却技术与光通信技术的深度协同。从传统空冷到冷板液冷,再到浸没式液冷,冷却技术的演进核心是追求更高的散热效率与更低的TCO;而LPO技术与浸没式光学解决方案的创新,则为高功耗、高密度场景提供了关键的通信支撑。

Formerica通过无DSP的LPO技术实现功耗减半,以90.9%的材料兼容率与达标信号完整性突破浸没式液冷的应用瓶颈,再通过严苛测试验证产品可靠性,形成了“低功耗通信+高效散热适配”的完整解决方案。这些技术突破不仅满足了当前GPU TDP攀升带来的热管理需求,更通过降低数据中心的功耗、空间占用与碳足迹,助力行业达成可持续发展目标。 随着浸没式液冷与LPO技术的规模化部署,数据中心正从“被动散热”向“主动优化”转型,未来将实现性能、效率与环保的三重平衡,为AI与HPC技术的持续创新提供坚实基础。

完整报告如下:

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2025-12-01,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读