告别“金鱼脑”!谷歌用「嵌套学习」让AI像人类一样终身学习

告别“金鱼脑”!谷歌用「嵌套学习」让AI像人类一样终身学习

Henry Zhang

发布于 2026-01-07 17:55:40

发布于 2026-01-07 17:55:40

你是否有过这样的感觉,强大如 DeepSeek、豆包、ChatGPT这样的 AI 助手,却像一条只有7秒记忆的金鱼?你刚刚在对话中告诉它的事情,一旦开启新话题,它就忘得一干二净!

这背后的症结在于当前绝大多数的 AI 模型是无状态的,通俗地说是一种“顺行性遗忘症”:它们拥有海量的“固化”知识(预训练数据),却无法将你我对话中产生的“新见闻”有效地转化为长期记忆。

但这一切,或许即将成为历史。

近日,谷歌研究院的一篇 NeurIPS 2025 Poster 文章《嵌套学习:深度学习架构的幻象》(Nested Learning: The Illusion of Deep Learning Architectures),提出了一种全新的AI学习范式: 嵌套学习(NL,Nested Learning)。这不仅仅是技术的迭代,更像是关于“学习本质”的哲学革命,旨在赋予AI像人类一样持续学习、自我进化的能力。该文章被一些同行认为是 Transformer 级别的创新。

一、AI的“阿喀琉斯之踵”:学完就忘

要理解这项突破的意义,我们得先看看当下AI的“记忆困境”。

我们可以把现在的主流大模型想象成一位已经毕业离校的博士。他在学校里(预训练阶段)博览群书,学富五车。但当他步入社会工作(部署上线),就几乎停止了系统性的学习,只能依靠在校时积累的知识来应对问题。对于社会上的新趋势、新知识,他要么完全不知,要么只能通过临时抱佛脚(上下文学习)来勉强应付,而且转眼就忘。

从神经学视角看,其核心问题是:

- 长期记忆固化:模型在预训练后,核心知识(存储在模型参数中)就像被刻在石头上,极难修改。

- 短期记忆脆弱:对话中的上下文信息,就像写在沙滩上的字,潮水(新对话)一涌上来,就消失得无影无踪。

这就导致了AI的一个核心矛盾:它看似无所不知,实则无法在与你我的互动中真正“成长”,它被永远地困在了“训练数据截止日”那个时间里。

AI目前的顺行性遗忘症

为了克服大模型“金鱼脑”的先天缺陷,业界已研发出多种为大模型“补脑”的记忆增强方案。

比如近年来备受瞩目的RAG(检索增强生成),就像给大模型配备了一位随叫随到的图书管理员——通过可扩展的外部知识库,这位“管理员”能在需要时快速找到相关资料,为大模型补充信息。

除此之外,在算力成本可接受的情况下,上下文窗口的扩展可为模型加长记忆胶片,允许更多的对话内容被记录下来。另一种思路则是将用户的会话状态序列化存入数据库,如同把每次对话都存档,在需要时精准提取并拼接成上下文。

为了提升效率,工程师们还想出了更精巧的办法:有的把对话核心信息压缩成摘要,这好比将一部电影提炼成五分钟的剧情梗概;有的则采用多轮对话专用微调,如同训练模型理解连续剧般的情节关联,更好地捕捉语义的连贯性。

然而,这些方法虽然在一定程度上缓解了大模型的记忆尴尬,但它们本质上都只是为失忆者配备的备忘录——无论形式如何精巧,都未能改变大模型缺乏内在记忆核心这一根本事实。

二、嵌套学习:给AI装上“多层次记忆大脑”

那么,嵌套学习是如何打破这堵墙的呢?

传统的深度学习,可以理解为“一层层堆乐高”。网络层数越多,模型越“深”,理论上模型的表达能力越强。但嵌套学习告诉我们,光有结构的“深度”还不够,我们更需要学习的“深度”。

嵌套学习的核心思想是:将整个AI模型看作一个由多个“学习代理”组成的嵌套系统。每个代理都是一个独立的“关联记忆系统”,负责在不同的时间尺度上学习和运作,就好比一个高效运转的现代公司:

- 一线员工(如注意力机制):反应最快,直接处理实时涌入的信息(比如每一条对话),但他们的工作记忆很短暂。

- 中层经理(如前馈层):他们会整理一线员工汇报的信息,总结出一些模式和短期策略,更新频率稍慢。

- 高管董事会(最慢更新的核心参数):他们负责制定公司的长期战略和核心文化,不会因为单个项目而轻易改变,但会在关键时刻根据重要报告进行战略性调整。

而在嵌套学习框架下,从一线到董事会,每个层级都在持续地、以不同节奏地学习和更新。快节奏的模块负责应对当下,慢节奏的模块则负责沉淀智慧,形成一个持续进化的整体。

三、3大“黑科技”,让AI从静态程序变为动态学习者

嵌套学习不仅仅是个漂亮的理论,文章中还催生了三个实实在在的技术飞跃:

1. 深度优化器:让“学习的方法”也学会学习

现在机器学习训练过程中使用的模型优化器(如Adam),它们的算法是固定的,像一套动作是预设好的广播体操,它们没有“记忆”,不知道上一个动作对下一个动作有何影响。

嵌套学习视角下,优化器本身也是“学习者”,可从静态的数学公式,改变成可动态学习的“微型神经网络”(如MLP),这个微型神经网络以当前梯度为输入,其任务是学习并输出一个更智能的更新方向。从而优化器变成具备记忆和策略的“元学习引擎”。

2. 自修改模型:让 AI 拥有“自我进化”的能力

这可能是最大胆的一步,序列模型能够自主修改自身学习规则,意味着AI能够根据当前处境,动态地改变自己“学习的方式”。如同一个学生,不再满足于消化老师传授的知识,而是开始摸索和创造属于自己的学习方法论。这是通向拥有自主性AI的关键一步。

3. 连续体内存系统:告别非黑即白的记忆模式

嵌套学习使用了“连续体内存系统”(CMS),打破了传统“短时记忆-长时记忆”的二元划分模式,将记忆视为一个平滑的频谱,完美地模拟了人类从瞬时记忆到工作记忆,再到长期记忆的自然流动过程:

- 高频记忆:像缓存,快速读写,负责处理当下。

- 中频记忆:像笔记本,定期整理,形成经验。

- 低频记忆:像教科书,缓慢修订,沉淀为核心知识。

这完美地模拟了人类从瞬时记忆到工作记忆,再到长期记忆的自然流动过程,彻底告别了“金鱼脑”。

四、希望之光:HOPE架构初露锋芒

为了验证理论,论文的团队构建了一个名为 HOPE 的架构,它将能自我修改的序列模型与连续体内存系统融为一体。

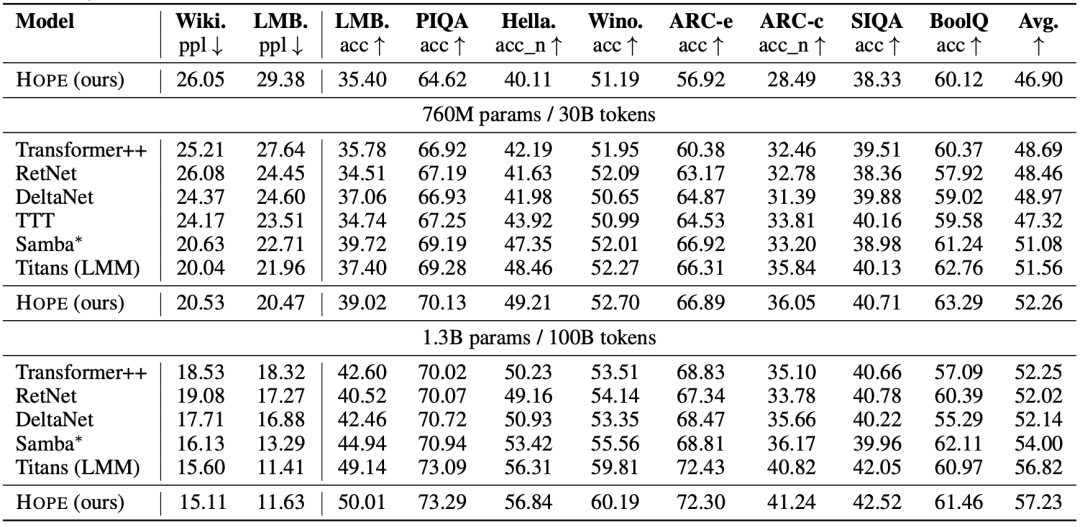

原论文的测试结果

在多项标准测试中(如语言建模、常识推理),HOPE 都展现出了卓越的性能:

- 在13亿参数规模下,其在 LAMBADA 语言理解任务上的准确率首次突破了50%大关,超过了同规模的 Transformer 等主流模型。

- 在 PIQA、HellaSwag 等需要常识的推理任务中,它也全面领先。

- 最关键的是,它在持续学习和长上下文理解任务中表现出的强大能力,证明它确实初步具备了“在飞行中改进引擎”的魔力。

五、结语:走向真正“活”的智能时代

我觉得嵌套学习最迷人的地方,在于它超越了技术本身。智能的强大或许不在于网络的“静态深度”,而在于学习过程的“动态深度”,即拥有多少不同的学习层次。这与人脑的运行机制不谋而合:我们的大脑本身就是天然的“嵌套学习系统”。它通过不同频率的脑电波协同工作,管理着不同时间纬度的任务:快速的β波处理紧急的即时反应,像模型中的注意力机制;舒缓的α波负责日常的信息整合与创意发散,如同模型的中间层;而在深度睡眠时,缓慢的θ波和δ波则主导着记忆的巩固与清理,这正是模型“连续体内存系统”将短期经验沉淀为长期知识的生物原型。嵌套学习,正是在工程上复现这种大自然的智慧。

虽然嵌套学习的研究尚在起步阶段,但它无疑为我们点亮了一座灯塔,很可能会成为构建下一代 AI 模型范式的基础机制之一。虽然它还只是个框架和原型,但它指出的方向很清晰:AI 不只是要“更大、更深”,而是要像人一样学会在不同时间尺度上管理自己的记忆和学习方式。

未来,我们身边的AI将不再是那个“出道即巅峰”的静态天才,而是一个能够在与我们的交互中积累经验和共同成长的智慧伙伴。

到那时,我们再回顾今天AI的“金鱼脑”,也许会像我们翻看儿时骑着带辅助轮自行车的照片一样,感慨之余怀念那段蹒跚学步的起点。

参考文献:

1)https://abehrouz.github.io/files/NL.pdf

2)https://neurips.cc/virtual/2025/loc/san-diego/poster/116123

3) https://research.google/blog/introducing-nested-learning-a-new-ml-paradigm-for-continual-learning/

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2025-11-29,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读