Nat. Biomed. Eng. | 面向泛化病理定位的无标注多模态视觉–语言模型

Nat. Biomed. Eng. | 面向泛化病理定位的无标注多模态视觉–语言模型

DrugAI

发布于 2026-01-14 16:55:42

发布于 2026-01-14 16:55:42

DRUGONE

病理定位是医学影像诊断中的关键步骤,但现有深度学习方法高度依赖专家标注,且在真实临床环境中泛化能力有限。研究人员提出了一种无需标注、具备良好泛化能力的多模态视觉–语言模型 AFLoc。该方法通过多层级语义对齐的对比学习,将医学影像特征与临床报告中的多粒度语义进行系统匹配,从而在不依赖人工标注的情况下实现病灶定位与诊断。研究人员在胸部 X 光、视网膜眼底和组织病理三种模态、多个外部数据集上验证了该模型,结果表明 AFLoc 在无标注定位与零样本诊断任务中均优于现有方法,并在部分任务上达到甚至超过人工基准水平。

精准的病理定位有助于提高诊断准确性并指导个体化治疗。然而,传统监督学习方法依赖大量高质量标注数据,而精细的病灶标注往往需要经验丰富的临床专家,成本高、效率低,且在不同数据集和新疾病场景下泛化能力不足。

尽管自监督学习、异常检测和医学视觉–语言预训练方法在一定程度上缓解了标注依赖,但现有方法要么难以处理复杂、多样的病理表现,要么仅能提供粗粒度定位。如何在无需标注的前提下,实现跨疾病、跨模态、具有临床可用性的精准病理定位,仍是一个核心挑战。

方法

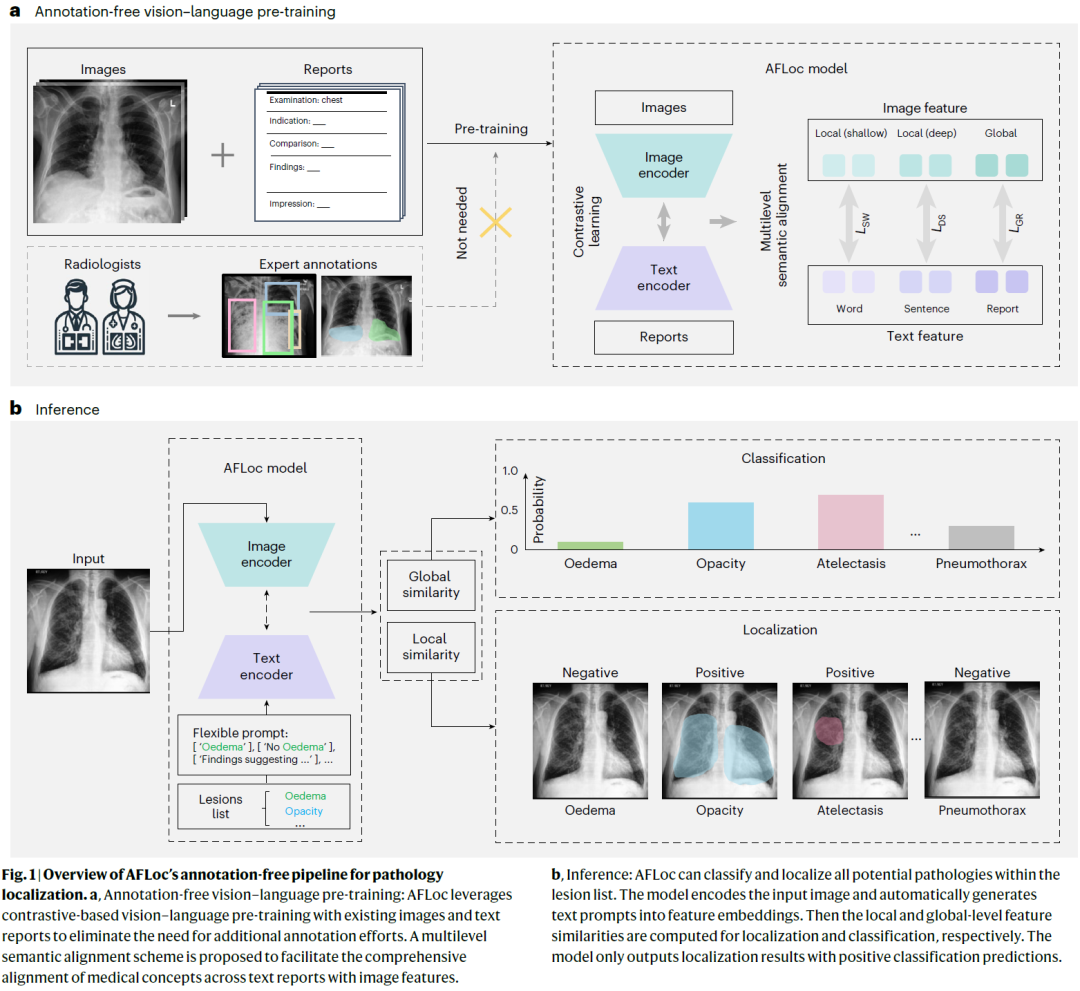

AFLoc 是一个基于对比学习的多模态视觉–语言模型。研究人员从医学影像中提取浅层局部特征、深层局部特征和全局特征,并从临床报告中提取词级、句级和报告级语义特征。通过多层级语义对齐机制,不同尺度的图像特征与不同粒度的文本语义被同时对齐学习。模型在预训练阶段仅使用影像–报告对,不需要任何病灶标注;在推理阶段,通过灵活的文本提示即可完成病理分类与对应区域的自动定位。

图 1|AFLoc 的无标注病理定位整体流程示意图。

结果

跨模态的无标注病理定位性能

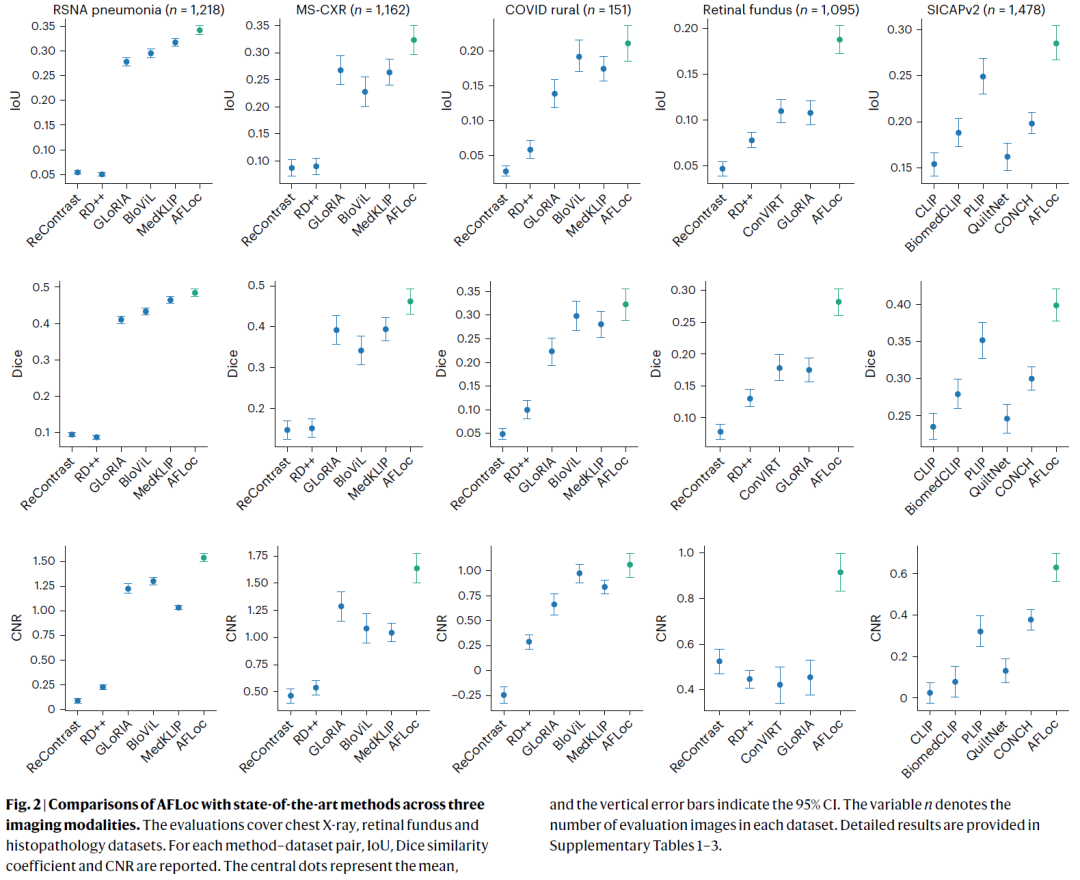

AFLoc 在胸部 X 光、视网膜眼底和组织病理图像上均可实现零样本病理定位。与多种现有视觉–语言模型和异常检测方法相比,AFLoc 在 IoU、Dice 和对比噪声比等指标上均取得最优或接近最优表现,显示出稳定的跨模态泛化能力。

图 2|AFLoc 与现有先进方法在三种影像模态上的性能对比。

胸部 X 光中的病理定位

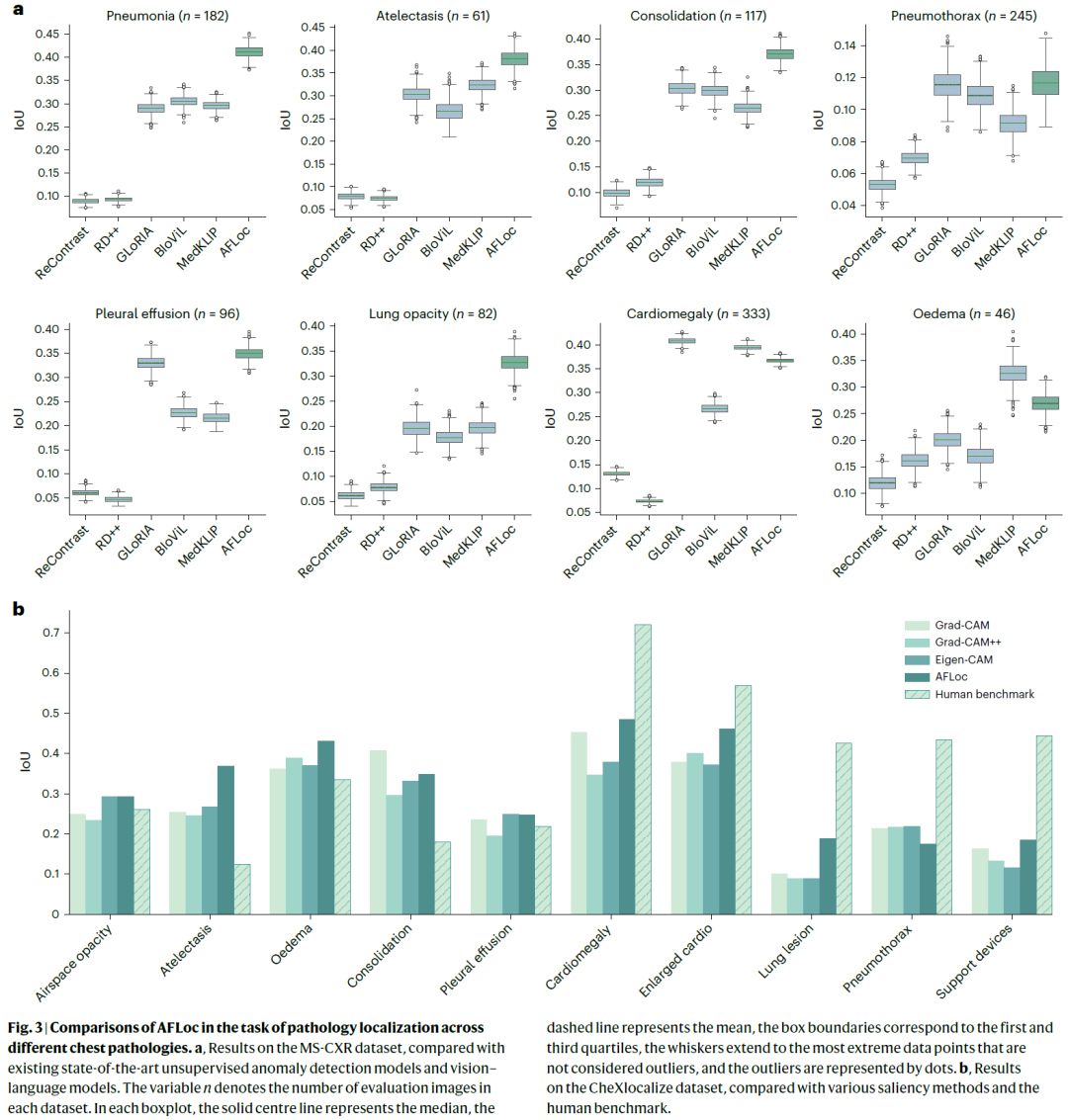

在多个外部胸部 X 光数据集上,AFLoc 能够准确定位肺炎、肺不张、胸腔积液等常见及低对比度病灶。在多个任务中,其定位精度明显优于现有方法,并在部分病理类型上超过人工基准水平,体现出较强的临床潜力。

图 3|AFLoc 在不同胸部病理定位任务中的性能对比。

视网膜眼底病灶定位

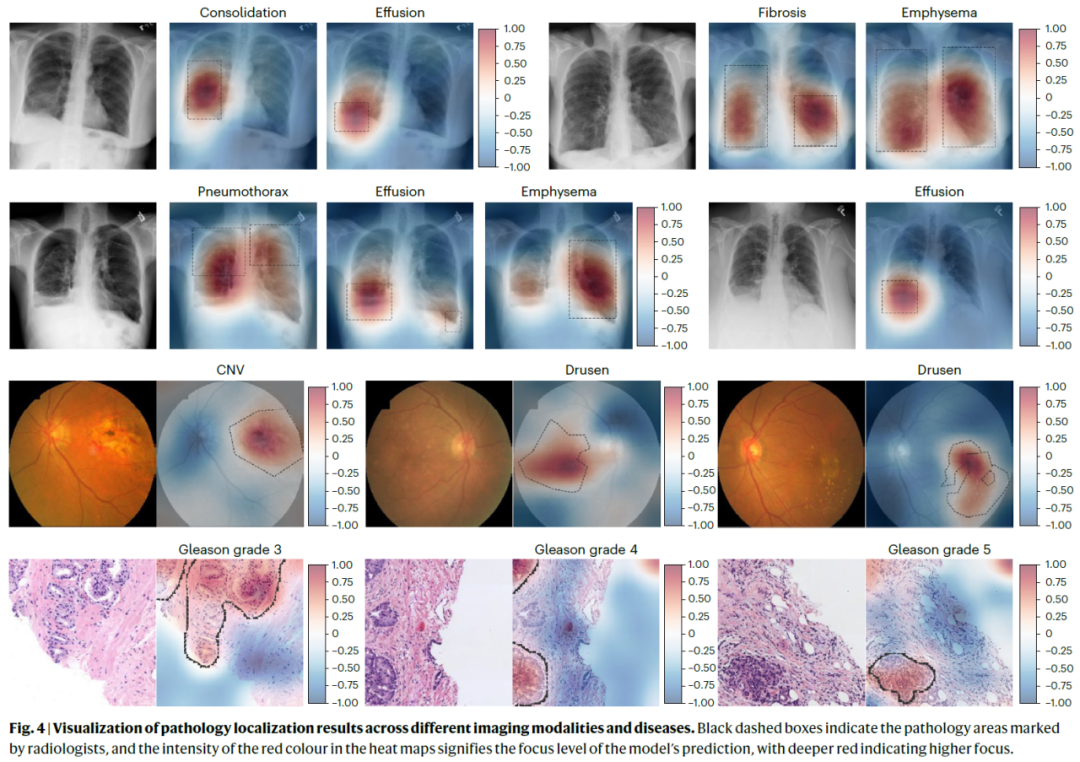

AFLoc 在脉络膜新生血管、玻璃膜疣等视网膜病变的定位中表现突出,能够在无标注条件下准确聚焦细微且分散的病灶区域,优于多数对比方法,显示出其在眼科影像中的适用性。

图 4|不同影像模态与疾病类型下的病理定位结果可视化。

组织病理中的异常组织定位

在前列腺癌等组织病理任务中,AFLoc 能够有效定位异常组织区域,其整体性能优于通用视觉–语言模型和专用病理基础模型,表明该方法能够处理高复杂度的组织结构变化。

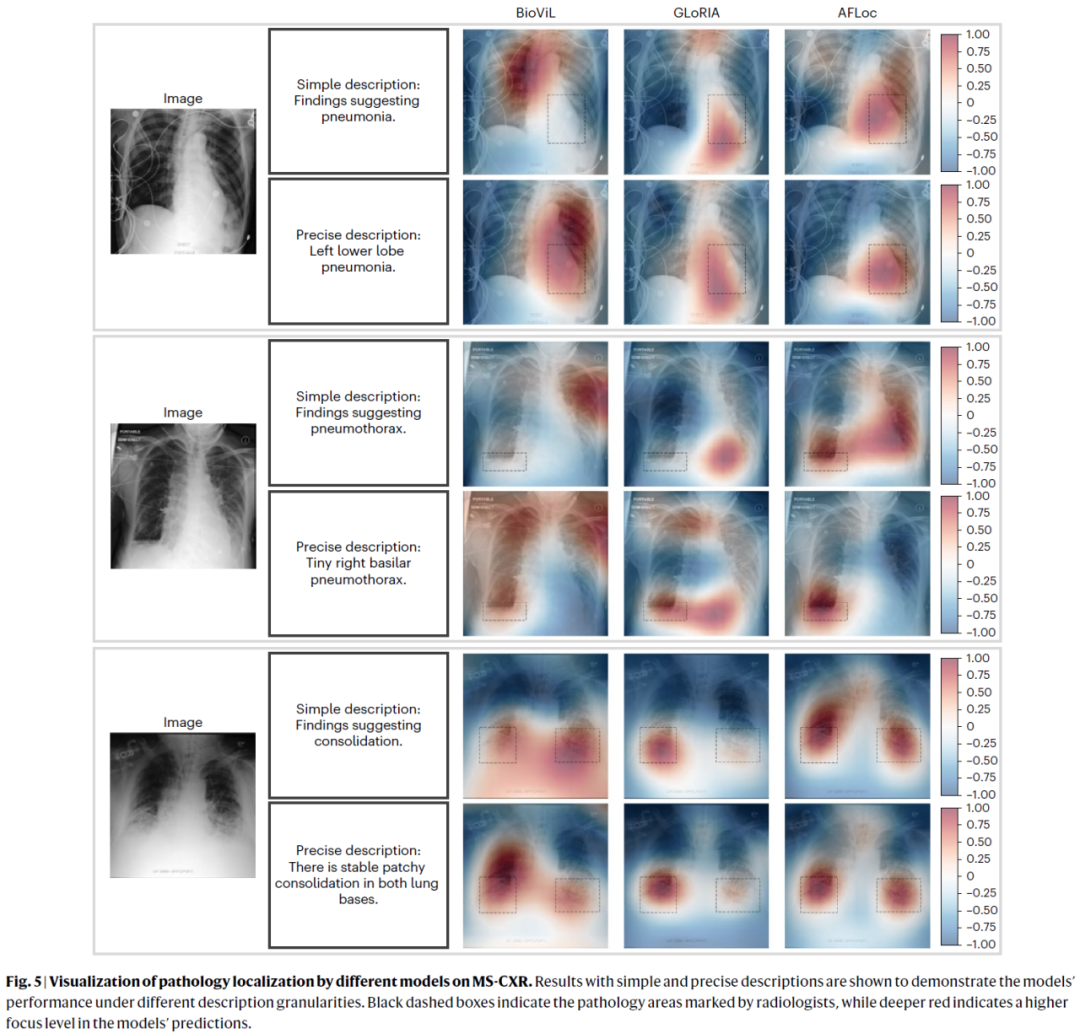

图 5|不同模型在 MS-CXR 数据集上的病理定位可视化对比。

无标注诊断与临床辅助价值

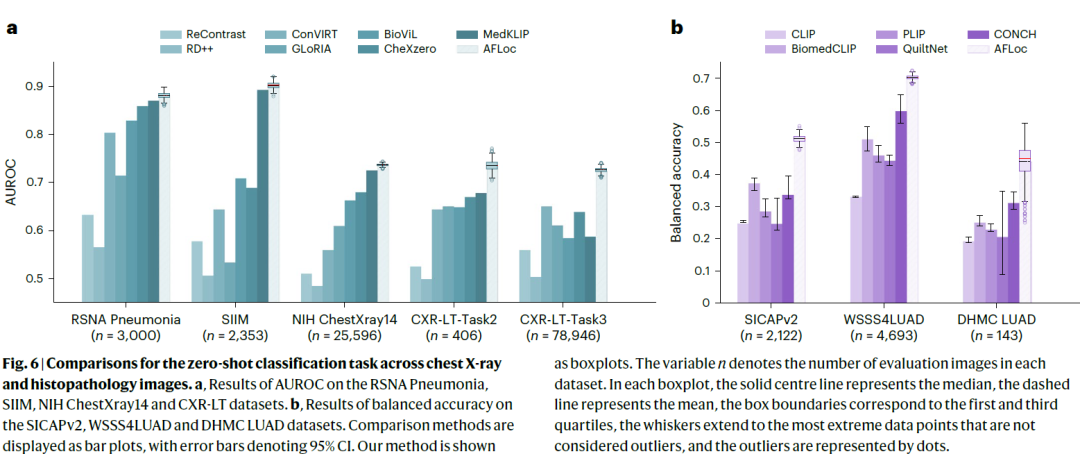

除定位外,AFLoc 还在零样本诊断任务中取得较高分类性能。在部分设置下,引入 AFLoc 的定位结果可提升医生诊断准确率并显著缩短阅片时间,显示其作为临床决策支持工具的潜在价值。

图 6|胸部 X 光与组织病理影像上的零样本分类任务性能对比。

讨论

研究结果表明,AFLoc 通过多粒度语义对齐有效缓解了医学影像中“弱文本定位信息”与“复杂病理形态”之间的鸿沟,实现了无需标注的精准病理定位。该模型在多模态、多疾病和新兴病理场景下均表现出良好的泛化能力,具有重要的临床应用前景。

研究人员认为,未来可通过更精细的多尺度特征融合、不确定性建模以及引入临床反馈机制,进一步提升模型在复杂真实环境中的可靠性与可解释性。

整理 | DrugOne团队

参考资料

Yang, H., Zhou, HY., Liu, J. et al. A multimodal vision–language model for generalizable annotation-free pathology localization. Nat. Biomed. Eng (2026).

https://doi.org/10.1038/s41551-025-01574-7

内容为【DrugOne】公众号原创|转载请注明来源

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2026-01-07,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读