ComfyUI v0.12.2 发布——新增 4B ACE Step 1.5 模型支持,修复多项稳定性问题!

ComfyUI v0.12.2 发布——新增 4B ACE Step 1.5 模型支持,修复多项稳定性问题!

福大大架构师每日一题

发布于 2026-02-09 14:49:54

发布于 2026-02-09 14:49:54

在这里插入图片描述

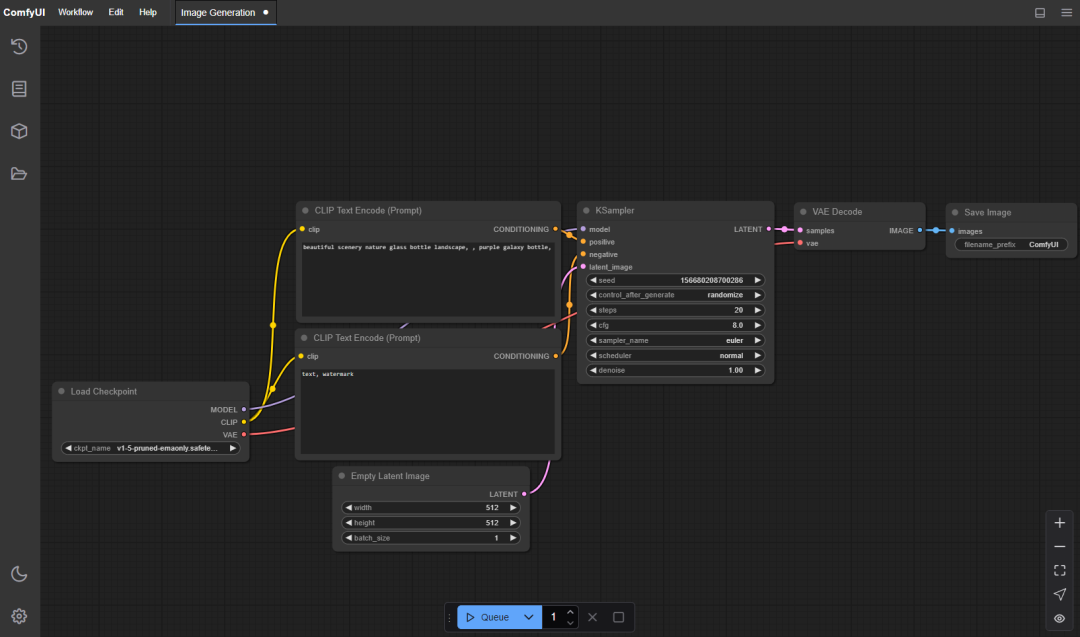

在这里插入图片描述

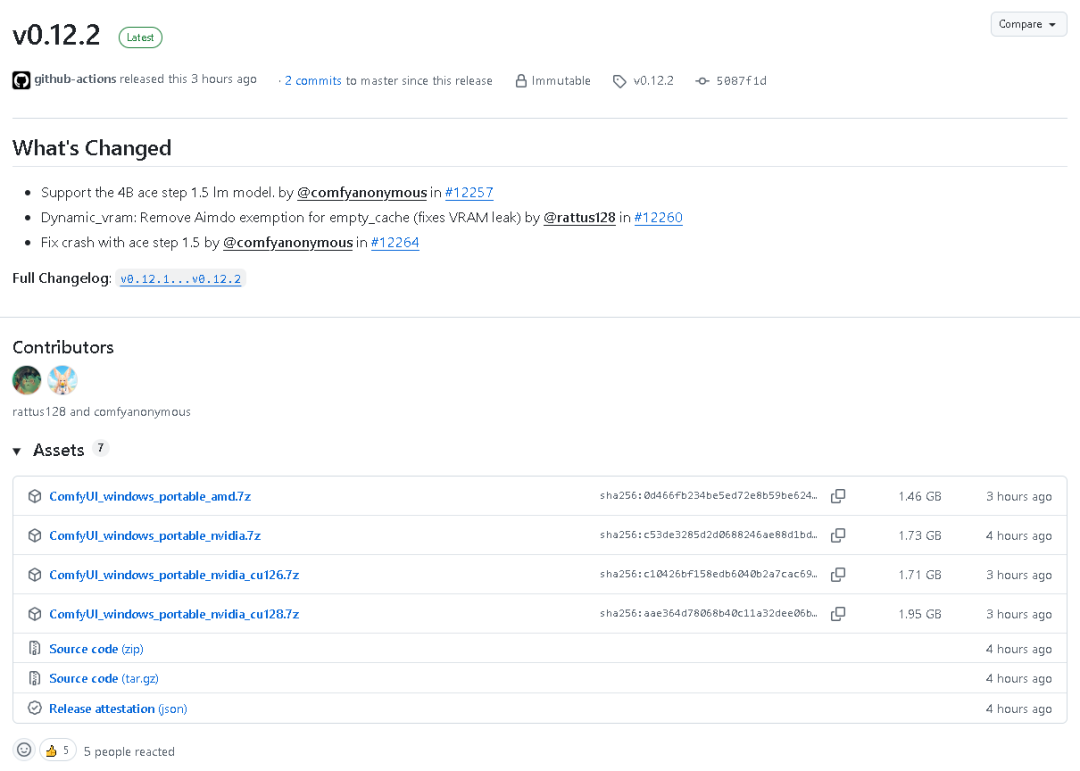

在这里插入图片描述

2026 年 2 月 4 日,ComfyUI 正式推出了 v0.12.2 版本。本次更新为“Immutable Release”,仅支持修改版本标题和说明。虽然版本序号看似小幅提升,但更新内容十分扎实,重点围绕新模型支持与显存管理优化展开,进一步提升了系统的模型兼容性与运行稳定性。

💡 版本概览

- • 版本号: v0.12.2

- • 发布日期: 2026 年 2 月 4 日

- • 版本性质: Immutable release(不可更改代码,仅可修改标题与说明)

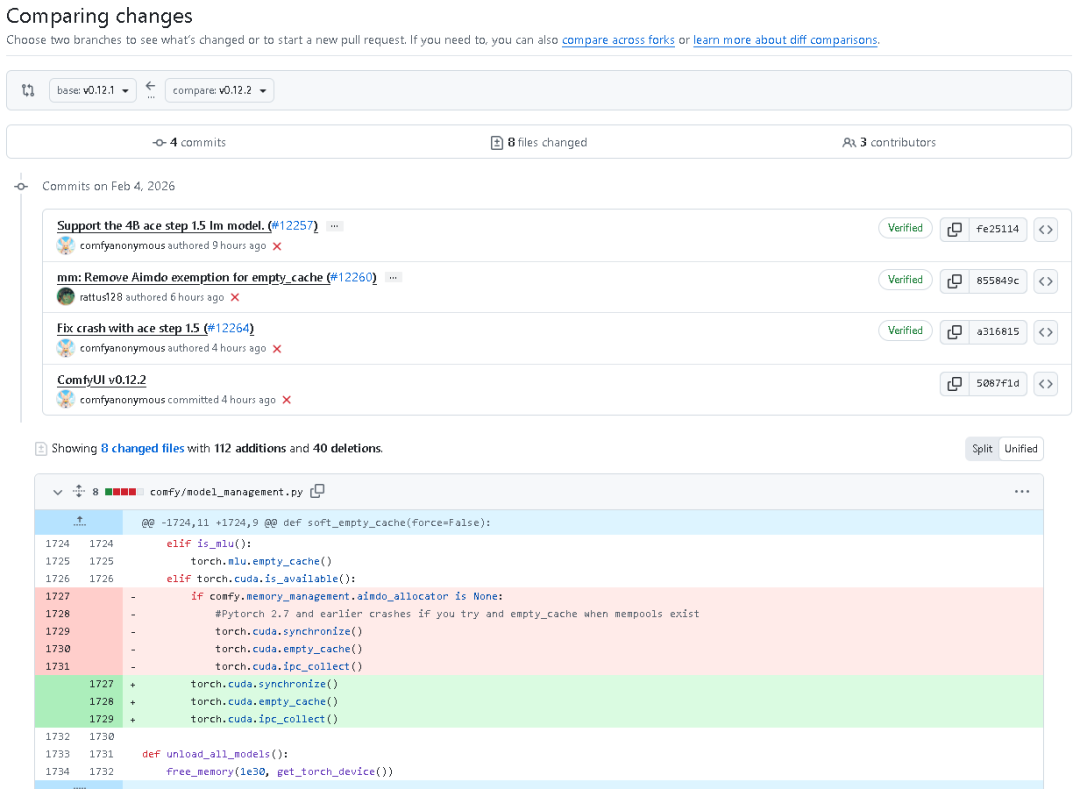

此次更新共有 4 次提交(4 commits),8 个文件修改,由 3 位贡献者协同完成,主要更新集中在模型支持、显存管理以及兼容性修复等方面。

⚙️ 更新亮点一:新增 4B ACE Step 1.5 模型支持

v0.12.2 中最重磅的更新是支持了 ACE Step 1.5 的 4B LM 模型。

在此前版本中,ComfyUI 已支持 Qwen3_2B 系列相关模型。本次更新在 comfy/text_encoders/ace15.py 与 comfy/text_encoders/llama.py 文件中,正式扩展了对更大参数量模型 —— Qwen3_4B_ACE15_lm 的支持。

新增内容包括:

- • 新增模型类:

Qwen3_4B_ACE15_lm - • 新增配置类:

Qwen3_4B_ACE15_lm_Config - • 更新 ACE15TEModel 逻辑,可根据参数

lm_model自动加载 2B 或 4B 模型。 - • 在切换不同 LM 模型时,内部常数与显存估算逻辑自动调整。

此外,comfy/sd.py 和 comfy/supported_models.py 亦同步适配,能够自动检测并加载 Qwen3_2B 或 Qwen3_4B 模型,从而实现双版本自动识别与切换支持。

🚀 简而言之,v0.12.2 让 ACE Step 1.5 用户能够灵活选择更大、更高精度的 4B 模型,显著提升了生成效果和扩展性。

🧠 更新亮点二:显存管理优化,修复 Dynamic VRAM 内存泄漏

在 comfy/model_management.py 中,移除了空缓存时对 Aimdo 的豁免处理逻辑,修复了可能的显存泄漏问题。

torch.cuda.synchronize()

torch.cuda.empty_cache()

torch.cuda.ipc_collect()以往版本中,如果 Aimdo allocator 为空,会导致 empty_cache() 无法正确释放显存,从而引发长时间运行后的显存泄漏。

v0.12.2 现已修复此问题,为长时间推理场景带来了更稳定的运行保障。

⚡ 更新亮点三:Dynamic VRAM 逻辑增强,优化版本兼容提示

main.py 中的 Dynamic VRAM 初始化逻辑得到改进:

- • 新增 Pytorch 版本检测机制:当 Pytorch 版本低于 2.8 时,将自动禁用 DynamicVRAM,并提示用户降级至传统内存管理模式。

- • 优化日志等级,将部分信息从 “info” 调整为 “warning”,提高日志可读性。

这意味着,ComfyUI 现在能更智能地识别当前执行环境,避免由于版本不兼容造成的推理崩溃或显存估算异常。

🔧 其他优化与修复

- • 修复 ACE Step 1.5 相关崩溃问题:在核心逻辑文件中修复了模型加载出错问题。

- • 更新版本号文件:

comfyui_version.py与pyproject.toml均已同步更新至 v0.12.2。 - • 改进推理逻辑:部分

sample_manual_loop_no_classes代码块现在加入了音频 token 范围控制,提升音频处理稳定性。 - • logit 计算逻辑:在 llama 模型结构中加入了 BaseQwen3 类统一 logits 计算,进一步增强模型通用性。

🧩 技术细节概览

模块 | 更新内容摘要 |

|---|---|

model_management.py | 删除 Aimdo 例外机制,修复显存泄漏 |

sd.py | 自动识别 4B / 2B LM 模型类型 |

supported_models.py | 新增 Qwen3_4B 模型检测逻辑 |

ace15.py | 新增 Qwen3_4B_ACE15 模型类与 lm_model 参数 |

llama.py | 新增 Qwen3_4B_ACE15_lm_Config 并整合 BaseQwen3 结构 |

main.py | 增强 Pytorch 版本检测与 Dynamic VRAM 警告逻辑 |

pyproject.toml | 项目版本更新为 0.12.2 |

comfyui_version.py | 同步版本号更新 |

🧭 版本总结

代码地址:github.com/Comfy-Org/ComfyUI

ComfyUI v0.12.2 是一次针对 模型支持与内存管理机制 的重要优化版本:

- • ✅ 新增 4B ACE Step 1.5 模型支持

- • ✅ 修复显存泄漏问题

- • ✅ 优化 Dynamic VRAM 初始化与版本兼容逻辑

- • ✅ 提升模型推理的稳定性与兼容性

此版本虽然结构变化不大,但为未来的 大模型扩展与长时推理环境 打下了坚实基础。

结语: ComfyUI 团队通过 v0.12.2 的更新,再次展现出其对稳定性和扩展性的极致追求。如果你正在使用 ACE Step 模型或需要更高显存利用效率,这是一次值得立即升级的版本。

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2026-02-04,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读

目录