大语言模型和智能体应用实践指南:以体育竞技人工智能实践为例(下)

原创大语言模型和智能体应用实践指南:以体育竞技人工智能实践为例(下)

原创

走向未来

发布于 2026-02-12 21:39:28

发布于 2026-02-12 21:39:28

大语言模型和智能体应用实践指南:以体育竞技人工智能实践为例

文 | 王文广(kdd.wang@gmail.com)

大语言模型和智能体驱动的体育竞技人工智能应用实践指南-1.jpg

第六章 预测引擎构建:量化不可见的“势头”与胜率

处理完数据后,我们需要构建数学模型来回答两个核心问题:球员现在的状态(势头)如何?谁会赢得下一场比赛?

6.1 势头建模:超越排名的动态指数

传统的ATP/WTA排名基于过去52周的积分,具有严重的滞后性。它无法反映一名球员“本周”或“今天”的状态。我们需要构建一个实时的实力指数(Power Index)。

模型架构:

这是一个加权的时间序列模型,其核心公式应包含以下因子:

- 表现(Performance): 基于结构化数据的硬指标(近5场胜率、发球得分率)。

- 舆论(Punditry/Sentiment): 来自NLP管道的情绪得分。大量正面报道会推高指数。

- 体量(Volume): 媒体讨论的热度。

- 场地加成(Surface Boost): 球员在特定场地(红土/草地)的历史表现系数。

衰减逻辑:

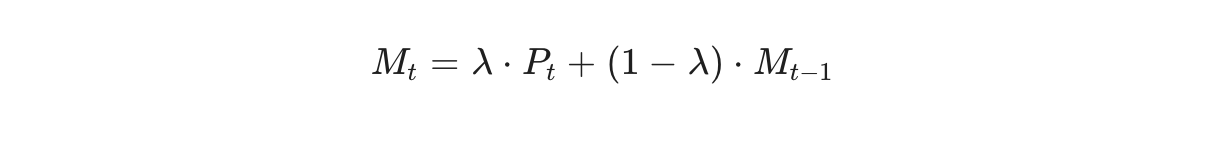

采用指数加权移动平均(EWMA)。

其中

是当天的综合表现得分,

是衰减因子。这种设计确保了越近期的表现权重越大,使模型能敏锐捕捉到“连胜”带来的心理势头,或“伤退”带来的断崖式下跌。

6.2 胜率预测 (L2W):AutoAI与实时推理

AutoAI的应用:

构建“获胜概率”(Likelihood to Win)模型时,不应依赖单一算法。应利用AutoAI(自动化机器学习)流程:

- 特征工程: 自动生成特征组合,如“A的一发得分率 - B的接发得分率”。并将上文计算的“实力指数”作为一个关键特征输入。

- 模型竞赛: 并行训练Logistic Regression, XGBoost, LightGBM, Random Forest等多个模型。

- 超参数优化: 使用贝叶斯优化寻找最佳参数。

- 集成学习: 最终输出往往是多个表现最优模型的加权集成(Ensemble)。

赛中实时更新(In-Play Prediction):

预测不是静态的。在比赛进行中,模型需要订阅实时比分流。每打完一分,模型根据当前的局分、发球权以及球员的体能衰减曲线(基于跑动距离数据),重新计算胜率。这要求推理服务的延迟必须控制在毫秒级。

第七章 神经符号架构:图模互补解决幻觉难题

依靠统计模型可以得到准确的概率,但无法生成人类可理解的深度分析。依靠大语言模型(LLM)可以生成流畅的文本,但容易产生幻觉。

神经符号AI(Neuro-Symbolic AI) 是解决这一矛盾的终极方案。它结合了连接主义(LLM)的泛化能力和符号主义(知识图谱)的逻辑确定性。

7.1 范式一:大模型构建知识图谱 (LLM for KG)

传统的知识图谱构建成本极高。在体育领域,我们可以利用LLM作为“认知解析器”。

- 输入: 赛后采访文本:“我的反手今天感觉很迟钝,因为昨晚没睡好。”

- 抽取: LLM识别出实体(Player, Backhand, Sleep)和因果关系。

- 构建三元组: (Player_A) --[has_issue]--> (Backhand) --[caused_by]--> (Fatigue)。”

通过这种方式,非结构化的叙事被转化为结构化的、可查询的知识(Knowledge),存储在图数据库(如Neo4j或NebulaGraph)中。

7.2 范式二:知识图谱增强大模型 (GraphRAG)

当用户提问:“为什么看好A击败B?”时,系统不直接调用LLM,而是执行图谱增强检索(GraphRAG)。

多跳推理(Multi-hop Reasoning):

传统的向量检索(Vector RAG)只能找到相似的文本片段。而GraphRAG可以在图谱中游走:

- 第一跳: 找到B球员的节点,发现其属性 Weakness: Low_Bouncing_Ball(惧怕低弹跳球)。

- 第二跳: 找到A球员的节点,发现其战术风格 Tactic: Slice(擅长切削,切削球弹跳低)。

- 推理路径: A的切削球 --> 导致低弹跳 --> 击中B的弱点。

事实锚定:

系统将这条推理路径(子图)转化为自然语言提示词(Prompt),喂给LLM:“已知A擅长切削,而B惧怕低弹跳球,请生成分析。”

此时,LLM不再是在“创作”,而是在“翻译”图谱中的逻辑。这从根本上消除了幻觉,实现了可解释的因果推理。

第八章 本体感知生成 ( OAG):从预测到决策闭环

在企业级应用中,单纯的对话是不够的,我们需要系统能够根据环境变化主动调整行为。这需要引入本体(Ontology) 、 动态对象集(Dynamic Object Sets) 和本体感知生成 (Ontology-Aware Generation,OAG)的概念。

8.1 动态对象集:构建精准的上下文切片

传统的RAG检索往往会带入无关信息。动态对象集 是一种基于逻辑过滤的上下文构建机制。

场景模拟: 预测“阿尔卡拉斯在美网夜场的表现”。

- 意图识别: 系统识别出关键属性:Player=Alcaraz, Tournament=US Open, Time=Night。

- 动态集合构建: 系统向本体层发送查询指令,实时筛选出一个对象集合:Set = Filter(Matches, Winner=Alcaraz OR Loser=Alcaraz, Condition=NightSession)。

- 上下文注入: 只有这个集合中的数据(及其关联的伤病、新闻对象)会被注入到LLM的系统提示词中。

这种机制确保了LLM的推理完全基于“此时、此地、此人”的精准事实,而非泛泛而谈。

8.2 动作类型 (Action Types):知行合一

体育AI的价值最终体现在决策上。我们在本体中定义动作(Actions),赋予LLM“写”数据的能力。

流程闭环:

- 分析: LLM基于图谱判断A球员有高概率获胜。

- 决策: LLM调用定义好的工具函数 Submit_Prediction(Winner=A, Confidence=0.85)。

- 回写(Write-back): 这一预测被作为一个新的数据对象写入本体库。

- 副作用(Side Effect): 写入操作触发Webhook,自动向教练组发送战术建议邮件,或向博彩系统发送下注指令。

通过定义动作,我们将AI从一个被动的“咨询顾问”变成了一个主动的“执行代理”。

第九章 交互革命:从单向广播到多智能体协作

传统的体育数字体验是静态的:用户浏览比分板,阅读编辑写好的战报。这是一种单向的“广播模式”。生成式AI的出现,使得“对话模式”成为可能。用户不再是被动的信息接收者,而是可以向系统提问、索取定制化分析的主动参与者。

要实现这一转变,单纯接入一个大模型API是远远不够的。我们需要构建一个分层、模块化且具备路由能力的多智能体(Multi-Agent)架构。

9.1 智能体架构设计:感知、推理与行动的分离

我们在实践中(如UAF Match Chat)采用的是一种分层的智能体设计模式,将即时响应的轻量级任务与深度推理的重量级任务在架构上解耦。

第一层:中间件与意图路由 (Middleware & Routing)

这是系统的“前台接待”。所有的用户输入(文本或语音)首先进入中间件层。

- 意图识别: 使用轻量级的BERT模型或分类器,迅速判断用户意图。是询问“现在几点了”(简单事实),还是“分析阿尔卡拉斯的反手策略”(复杂推理)?

- GenAI Shielding(生成式AI护盾): 这是一个关键的成本与延迟优化机制。对于高频的、标准化的简单查询(如比分、赛程),系统完全绕过昂贵的大模型,直接调用规则引擎或缓存数据库,通过答案合成器(Answer Synthesizer) 组装回复。这能将响应延迟从1.5秒降低到0.2秒,并节省90%的Token成本。

第二层:定制扩展应用与LangGraph编排

对于复杂推理任务,请求被路由到定制扩展层(Custom Extension)。这里托管着基于LangGraph或Autogen编排的智能体集群。

- ReAct模式(Reasoning + Acting): 智能体不仅仅是聊天,它们遵循“观察-思考-行动”的循环。

- 思考: 用户问“为什么A赢了?”。智能体判断需要获取比赛数据和新闻评论。

- 行动: 调用 Stats_API 获取数据,调用 News_Retrieval 获取舆论摘要。

- 观察: 拿到数据后,再次思考,最终生成回答。

- 工具调用(Tool Use): 智能体必须被赋予访问外部工具的权限,如向量数据库检索(RAG)、SQL查询接口或实时比分流。

9.2 生成式计算 (Generative Computing):LLM作为可编程基础设施

我们将大模型视为一种可编程的基础设施(GenComp),而非不可控的黑箱。这意味着我们不依赖模型的“自由创作”,而是对其输出施加严格的结构化约束。

- 约束生成: 在生成战报或评论时,我们通过Logits Processor或专门的Prompt格式,强制LLM输出符合JSON Schema的结构化数据,而非自由文本。

- 确定性逻辑: 利用逻辑推理引擎(如Prolog或自定义规则)对LLM的输出进行二次校验。例如,如果LLM生成的战报说“A赢了”,但比分数据是“0-6, 0-6”,逻辑引擎会立刻拦截并强制重生成。

9.3 自动化解说:视觉与语言的对齐

AI不仅能写,还能看和说。自动化解说(AI Commentary)是多模态生成的典型应用。

- 视觉跟踪: 计算机视觉(CV)模型实时捕捉视频流中的球和球员轨迹,提取元数据(Metadata):{Event: "Forehand Winner", Player: "Alcaraz", Speed: "150km/h"}。

- Prompt工程: 将元数据填入模板,指示LLM生成解说词:“阿尔卡拉斯这记正手制胜分势大力沉,时速达到了150公里!”

- 语音合成与对齐: 利用TTS模型生成语音,并根据视频的时间戳进行强制对齐,确保解说词与画面同步。

第十章 可信赖AI (Trustworthy AI):构建黑箱之上的治理框架

在体育博彩、竞技分析等高风险场景中,AI的错误可能导致严重的信任危机。如果模型预测“A必胜”但结果相反,用户会感到被欺骗。因此,我们必须建立一套涵盖“校准”、“解释”和“公平性”的治理框架。

10.1 不确定性量化 (Uncertainty Quantification):诚实的AI

仅仅给出一个预测(如“胜率60%”)是不够的,系统必须诚实地告诉用户它对这个预测“有多大把握”。

- 分类校准 (Calibration): 未经校准的深度学习模型往往“过度自信”。比如它预测100场比赛胜率均为90%,但实际上只有70场赢了。

- 期望校准误差 (ECE): 我们使用Platt Scaling或Isotonic Regression技术对模型输出进行后处理校准,目标是将ECE降低到0.05以下。

- 可靠性图 (Reliability Plot): 系统实时监控校准曲线。只有当模型的置信度(Confidence)与实际准确率(Accuracy)高度对齐时,预测结果才会被展示给用户。这意味着,当系统说“60%概率获胜”时,在统计学上就真的对应60%的胜算。

10.2 可解释性 (XAI):Win Factors与自然语言归因

为了回答“为什么AI认为他会赢”,我们引入Shapley值(SHAP) 分析。

- 特征归因: 计算每个特征(如一发成功率、历史战绩、舆论指数)对单次预测结果的边际贡献。例如,模型基准分是0.5,最终预测是0.7,SHAP分析会告诉我们:Rank_Diff 贡献了+0.15,H2H_Record 贡献了+0.05。

- 自然语言转化: 原始的SHAP图对普通用户是天书。我们需要一个NLG模板将其“翻译”成人话:“阿尔卡拉斯在历史交锋中以3-1领先(+0.05),且近期在硬地表现强势(+0.15),这显著提升了他的获胜概率。”

10.3 公平性与偏见监测 (Fairness & Bias)

AI模型容易从历史数据中继承偏见。例如,可能会系统性低估排名较低但在上升期的年轻球员,或者对特定国籍的球员存在偏见。

- 差异化影响分析 (Disparate Impact): 我们在监控面板中实时计算不同群体(按性别、国籍、年龄段分组)的模型准确率和有利结果比率。

- 去偏训练: 一旦发现某一群体(如“非种子选手”)的预测准确率显著低于平均水平,MLOps管道会自动触发重训练,增加该群体的样本权重或引入对抗性去偏算法。

第十一章 决策优化:在有限屏幕上策展无限信息

一场比赛产生的数据点成千上万,但手机屏幕的空间是有限的。如何决定展示哪三条最有价值的数据?这不仅是一个设计问题,更是一个数学优化问题。

11.1 约束规划 (Constraint Programming)

我们将内容策展定义为一个约束满足问题 (CSP),利用CPLEX等优化引擎求解。

- 目标函数: 最大化展示信息的信息增益(Information Gain)和用户兴趣度(Interest Score)。

- 硬约束:

- 必须展示至少一个关键统计数据(如一发得分率)。

- 不能连续展示两条语义重复的数据(多样性约束)。

- 如果比分差距悬殊,优先展示“一边倒”的数据;如果比分胶着,优先展示“关键分”数据。

- 动态求解: 每次用户刷新页面,优化引擎都在毫秒级内解出最优的“展示组合”。这确保了用户看到的永远是当前语境下最具洞察力的内容,而非随机抽取的数据。

第十二章 工程与运维:高并发下的MLOps闭环

美国网球公开赛等顶级赛事的流量具有极端的脉冲性。系统必须在数百万并发下保持毫秒级响应,同时保证模型的持续更新。这需要一个成熟的MLOps(机器学习运维)闭环。

12.1 全生命周期自动化

- AutoAI训练: 当新数据进入,AutoAI自动进行特征选择、模型训练和超参数调优。

- 影子部署 (Shadow Deployment): 新模型训练完成后,不会立即替换旧模型。而是作为“影子”上线,接收实时流量进行推理,但不向用户展示结果。

- A/B测试与切换: 系统对比影子模型与现役模型的实时准确率。只有当影子模型在关键指标上显著优于现役模型时,才会自动执行流量切换。

12.2 无服务器胶水层 (Serverless Glue)

在架构中,UAF Code Engine(无码引擎)扮演了粘合剂的角色。

- 事件驱动: 数据清洗、模型触发、结果后处理等任务全部封装为无状态函数。

- 按需扩容: 当比赛开始,数据流涌入,函数实例瞬间从0扩容到几千个;比赛结束,资源自动释放。这种架构完美契合体育赛事的潮汐特性。

12.3 全栈可观测性 (Observability)

利用Prometheus和Grafana构建统一监控平台。

- 业务指标: 实时预测准确率、API调用量、用户停留时长。

- 系统指标: Pod CPU使用率、推理延迟(P99)、数据库锁等待时间。

- 模型指标: 数据漂移(Data Drift)、概念漂移(Concept Drift)、校准误差(ECE)。 一旦监测到数据分布发生显著变化(例如场地突然变湿导致所有球速变慢),系统会自动发出警报并触发紧急重训练流程。

第十三章 商业价值与未来展望

技术最终必须服务于商业和用户价值。这套复杂的AI系统究竟带来了什么?

13.1 商业价值的多维释放

- 对于粉丝:专业洞察的民主化。 过去,只有专业教练才能看懂的“胜负因子”和“势头分析”,现在通过AI以自然语言呈现给每一位普通观众。这极大地降低了观赛门槛,提升了粉丝的参与深度和停留时长。

- 对于赛事方 (USTA):数字化资产增值。 一个高粘性的数字平台是赞助商的乐土。通过“Have Your Say”等互动功能,平台收集了海量的用户意图数据,为精准营销提供了依据。

- 对于技术伙伴 (UAF):灯塔效应。 在全球瞩目的两周内,零故障支撑数千万用户,是技术实力的最强背书。

13.2 走向物理AI (Physical AI)

展望未来,体育AI将突破屏幕的限制,进入物理世界。

- 实时战术干预: 未来的系统将不仅是向观众解说,而是实时向佩戴耳机的教练发送战术建议:“对手的反手跑动距离已达极限,建议多打重复落点。”

- 训练机器人互联: 预测模型将直接驱动发球机器人,模拟下一场对手的球路风格,帮助球员进行赛前热身。

第十四章 总结与展望 (Conclusion & Outlook)

14.1 总结

本指南从基础设施、核心算法与应用交互三个维度构建闭环的体育AI生态系统:

- 基础设施层:确立混合云架构,利用自动扩缩容(HPA/VPA)应对体育赛事的脉冲流量;采用“多语言持久化”策略,通过向量数据库与图数据库打破了结构化与非结构化数据的孤岛。

- 智能引擎层:通过NLP管道的去偏与摘要技术,提炼了海量舆情信号;利用AutoAI构建了胜率与势头模型;核心在于“神经符号架构”的实践,通过知识图谱增强大模型(GraphRAG)与本体感知生成(OAG),解决了AI幻觉与时效性难题。

- 交互与治理层:利用多智能体架构(ReAct模式)实现了深度的自然语言对话;通过不确定性量化(ECE校准)与可解释性归因(SHAP),建立了用户对AI的信任;最终通过MLOps闭环实现了系统的持续进化。

14.2 从云端大脑到边缘触感

- 因果人工智能 (Causal AI) 的普及:目前的预测主要基于相关性。未来,因果推断(Causal Inference)将被更广泛地引入,AI将不仅仅预测“谁会赢”,而是能够模拟“反事实”(Counterfactual)场景——“如果纳达尔在第二盘没有更换球拍,结果会怎样?”这将彻底改变战术复盘的方式。

- 物理人工智能 (Physical AI) 的融合:AI将突破屏幕,进入物理实体。具备视觉与触觉反馈的机器人陪练将接入云端大脑,模拟费德勒的球路与真实球员对打;智能穿戴设备将不再只是记录心率,而是实时干预,通过微电流或触觉反馈纠正球员的动作发力结构。

- 端侧小模型 (SLM) 与隐私计算:为了保护运动员的极致隐私(如生物力学数据、战术秘密),高性能的小型语言模型将直接部署在球队的本地服务器甚至球员的个人设备上,在不联网的情况下提供具备专家级能力的战术辅助。

14.3 超个性化与数字孪生

- 全息数字孪生 (Holographic Digital Twin):对于顶尖运动员,系统将构建一个包含其生理参数、心理模型、技术习惯的完整数字孪生体。教练可以在孪生体上进行几千次的战术模拟演练,找出最优解,再应用到真实训练中。

- 粉丝体验的“千人千面”:未来的观赛将不再有统一的转播画面。生成式视频技术结合VR/MR设备,将允许每位观众从任意角度介入比赛。智能体解说员将根据观众偏好(战术控、八卦迷还是数据党)实时生成个性化的解说流。

- 算法裁判与规则重构:随着计算机视觉精度的进一步提升(达到毫米级),AI将接管更多的裁判工作,甚至可能催生新的比赛规则——例如根据AI判定的“精彩程度”或“难度系数”来动态调整得分权重,让竞技体育更具观赏性。

体育竞技的本质是对人类极限的挑战。人工智能不是要取代这种挑战,而是要成为那面最清晰的镜子,映照出人类潜能的每一个微小细节,并辅助我们突破它。未来已来,让我们拭目以待。

../futureland/Revised%20Reliable%20Large%20Models%20with%20Knowledge%20Augmentation.Cover.jp

微信图片_2025-02-24_215034_677

知识增强大模型 Reliable Large Models with Knowledge Augmentation

(电子工业出版社博文视点) (Springer)

比RAG更強:知識增強LLM型應用程式實戰 知识图谱: 认知智能理论与实战

(台湾深智數位) (电子工业出版社博文视点)

../二维码-微信公众号.jpg

../二维码-知识星球.jpg

【走向未来】微信公众号 【走向未来】知识星球

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

评论

登录后参与评论

推荐阅读

目录