每日学术速递7.1

CV - 计算机视觉 | ML - 机器学习 | RL - 强化学习 | NLP 自然语言处理

点击下方卡片,关注「AiCharm」公众号

Subjects: cs.CV

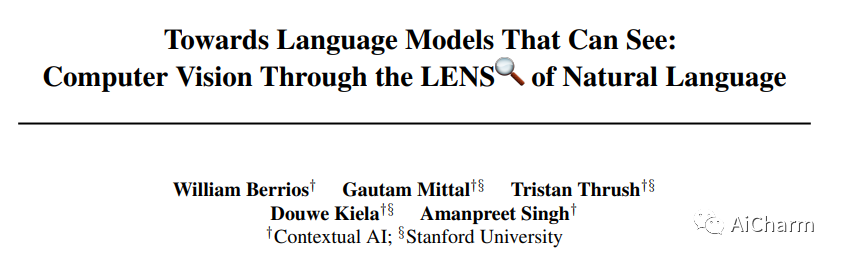

1.Towards Language Models That Can See: Computer Vision Through the LENS of Natural Language

标题:迈向可见的语言模型:通过自然语言的镜头实现计算机视觉

作者:William Berrios, Gautam Mittal, Tristan Thrush, Douwe Kiela, Amanpreet Singh

文章链接:https://arxiv.org/abs//2306.16410

项目代码:https://github.com/ContextualAI/lens

摘要:

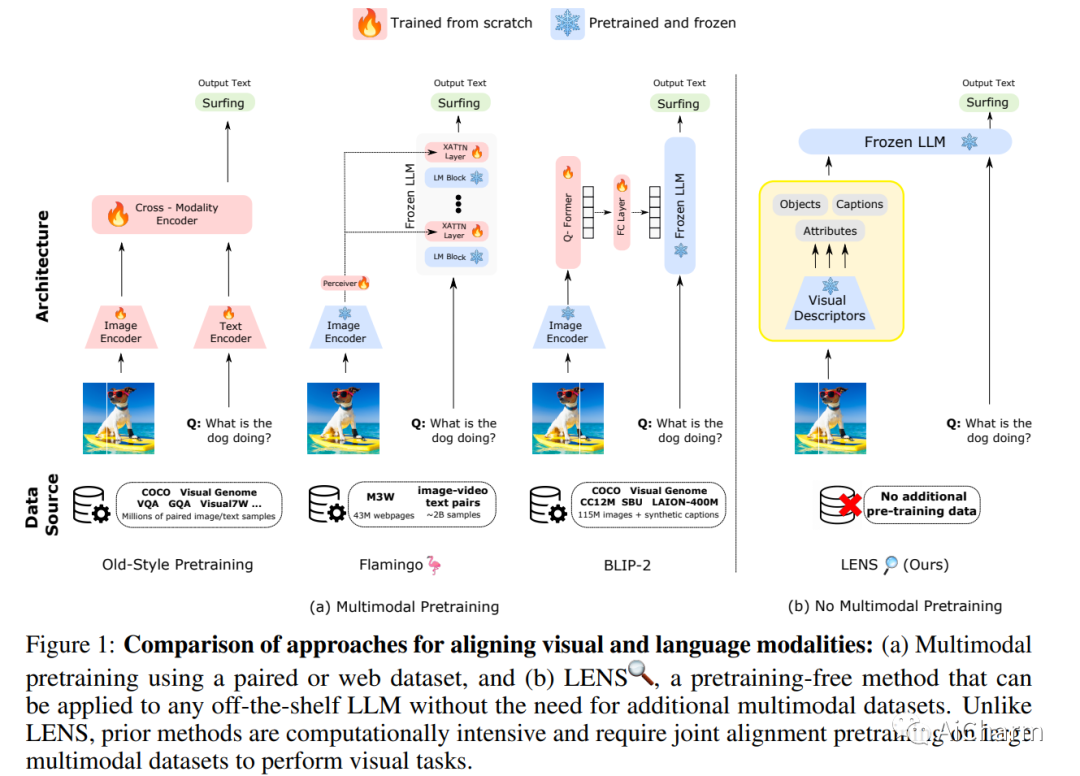

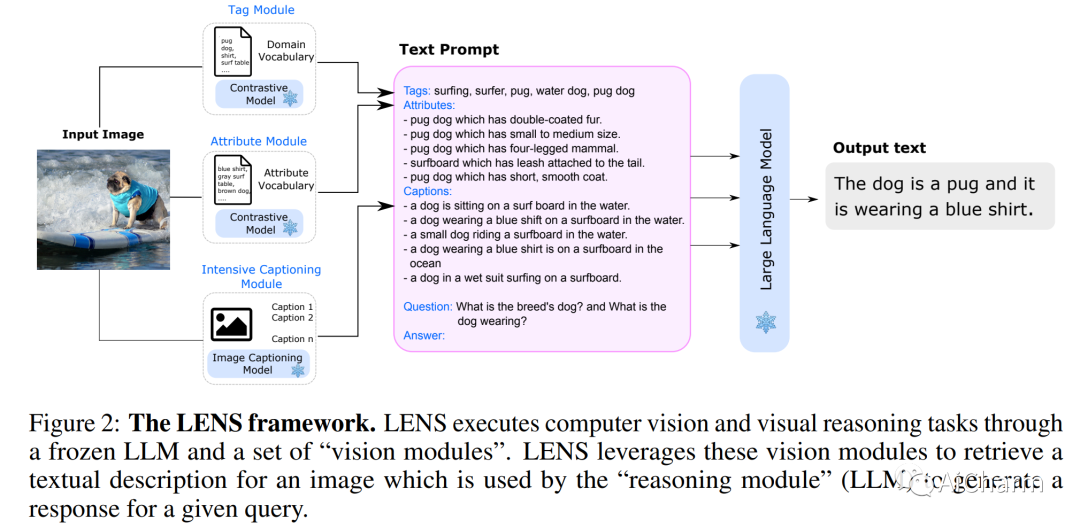

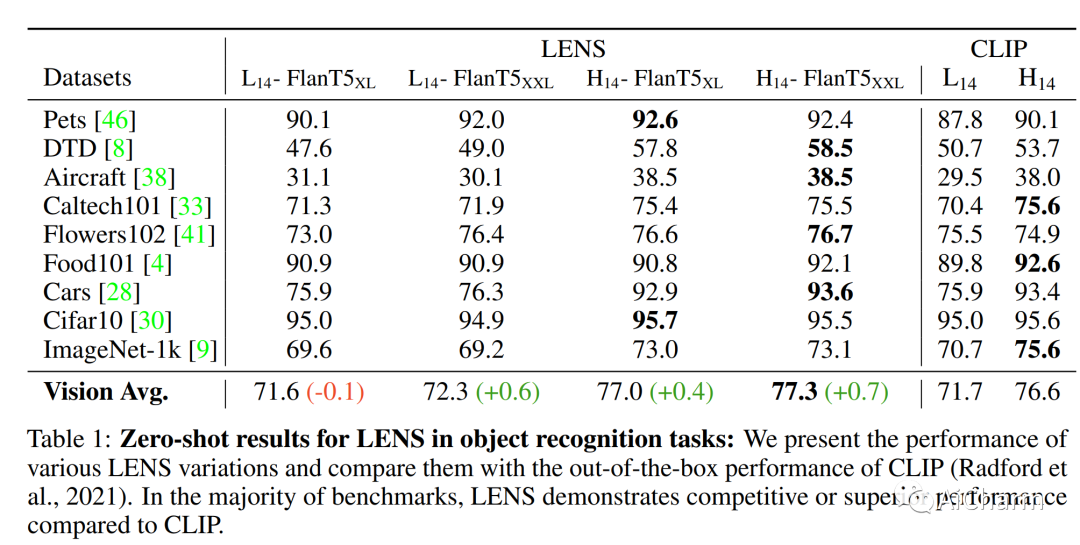

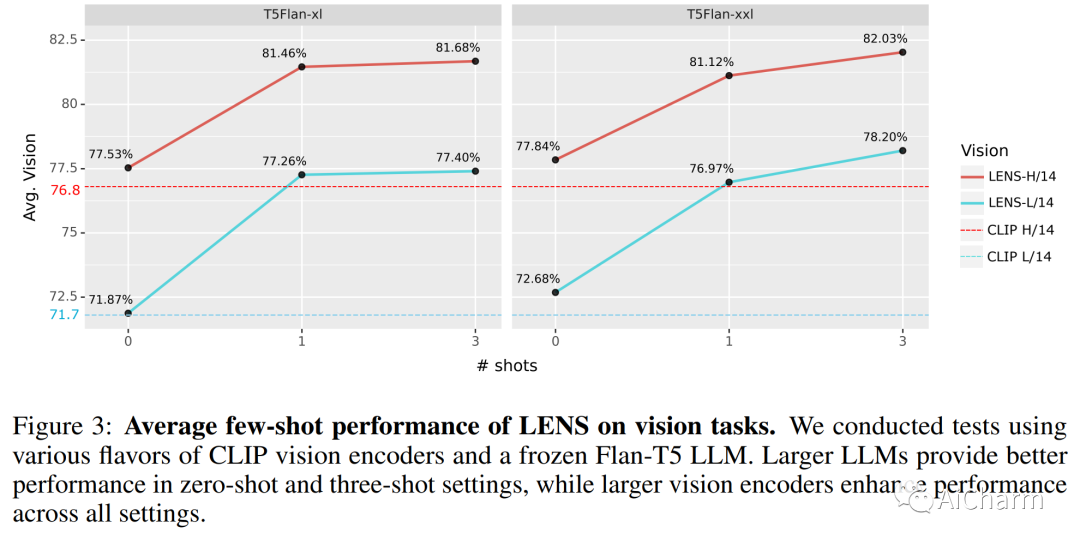

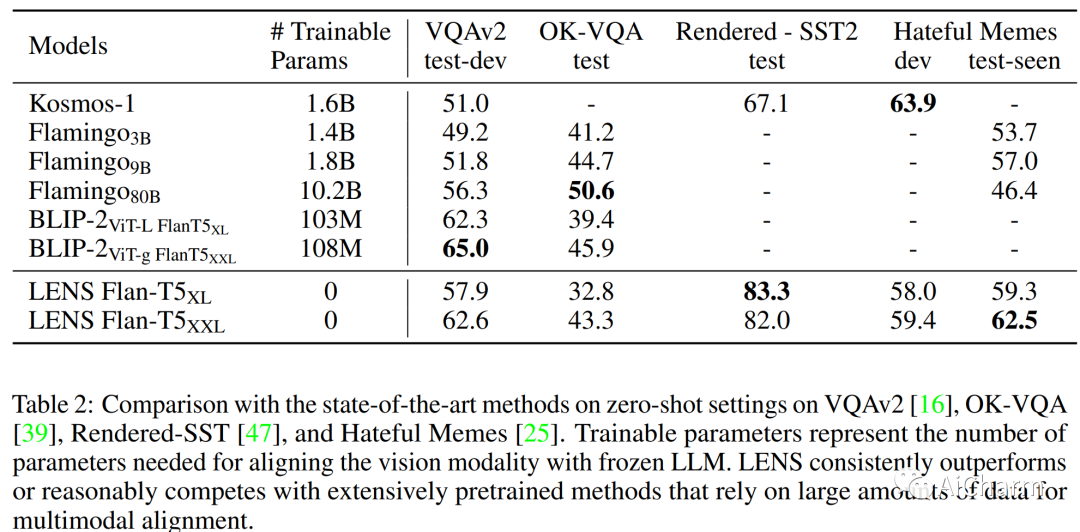

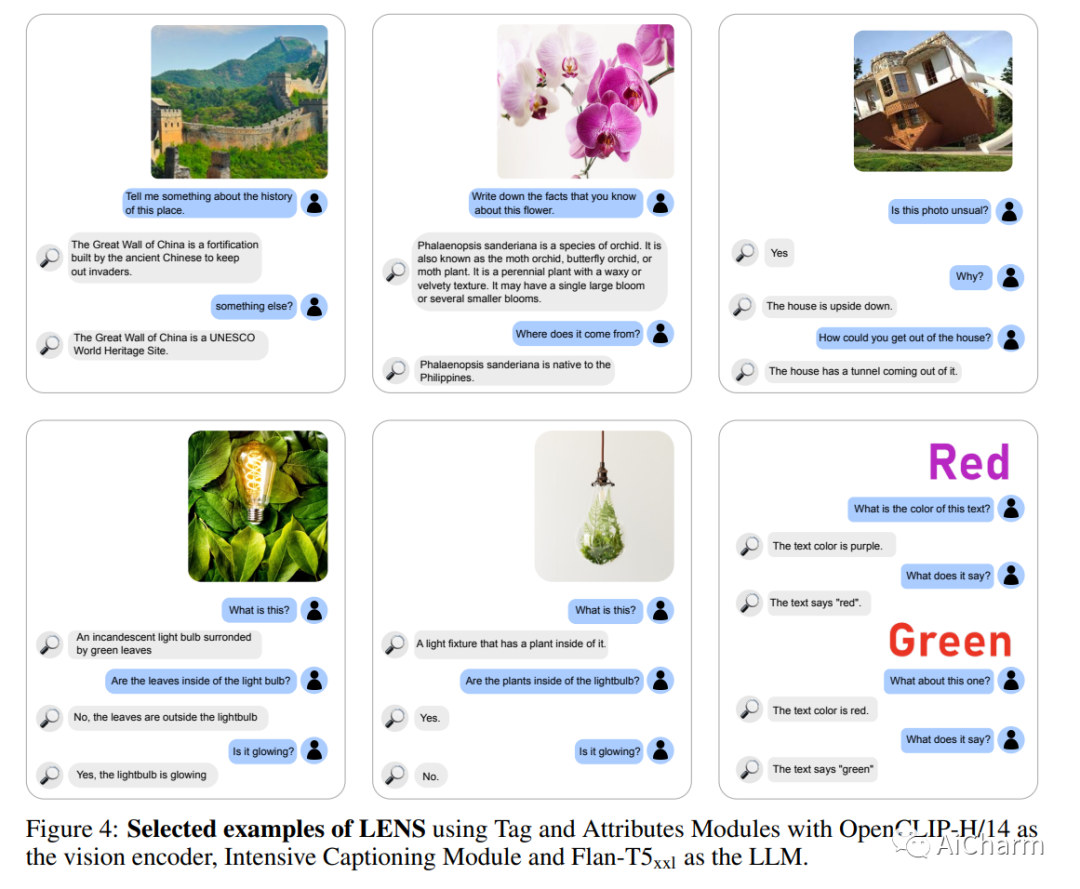

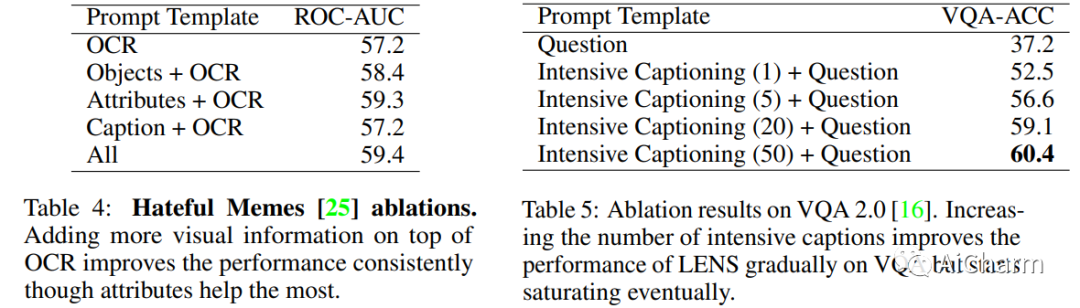

我们提出了 LENS,这是一种利用大语言模型 (LLM) 的力量来解决计算机视觉问题的模块化方法。我们的系统使用语言模型对一组独立且高度描述性的视觉模块的输出进行推理,这些模块提供有关图像的详尽信息。我们在纯计算机视觉设置(例如零样本和少样本目标识别)以及视觉和语言问题上评估该方法。LENS 可以应用于任何现成的法学硕士,我们发现采用 LENS 的LLM在更大、更复杂的系统中表现出很强的竞争力,而无需任何多模式培训。

2.TaCA: Upgrading Your Visual Foundation Model with Task-agnostic Compatible Adapter

标题:TaCA:使用与任务无关的兼容适配器升级您的 Visual Foundation 模型

作者:Binjie Zhang, Yixiao Ge, Xuyuan Xu, Ying Shan, Mike Zheng Shou

文章链接:https://arxiv.org/abs/2306.12642

项目代码:https://github.com/TencentARC/TaCA

摘要:

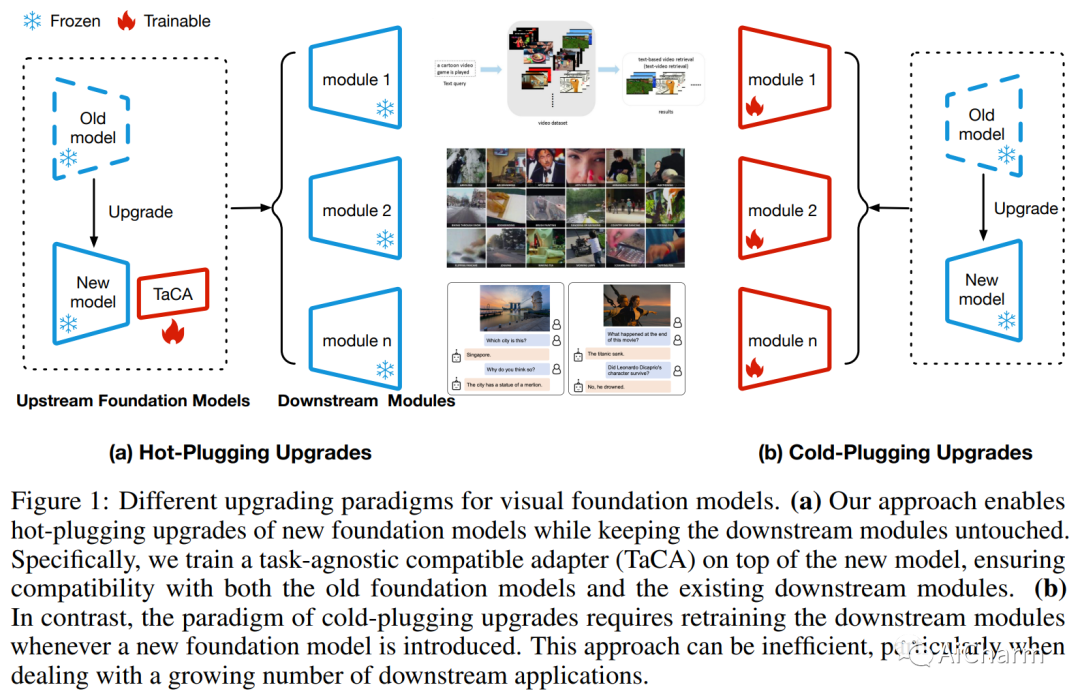

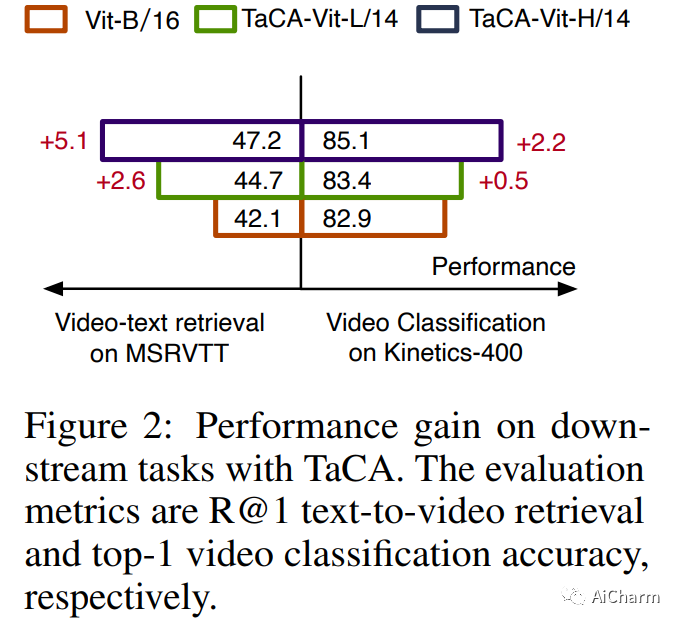

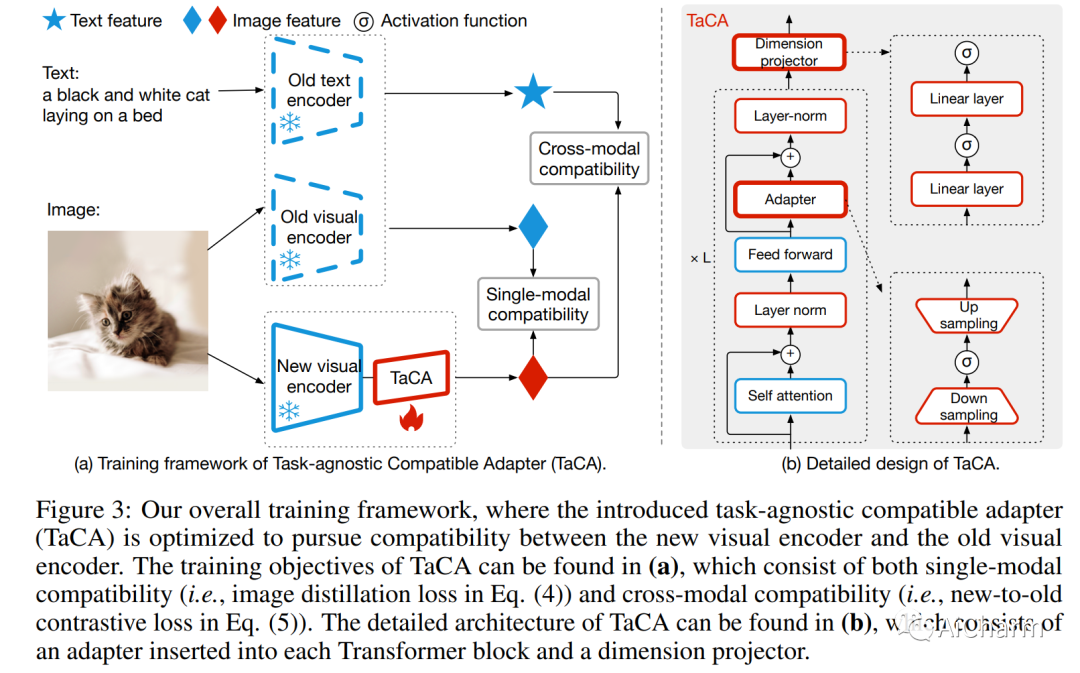

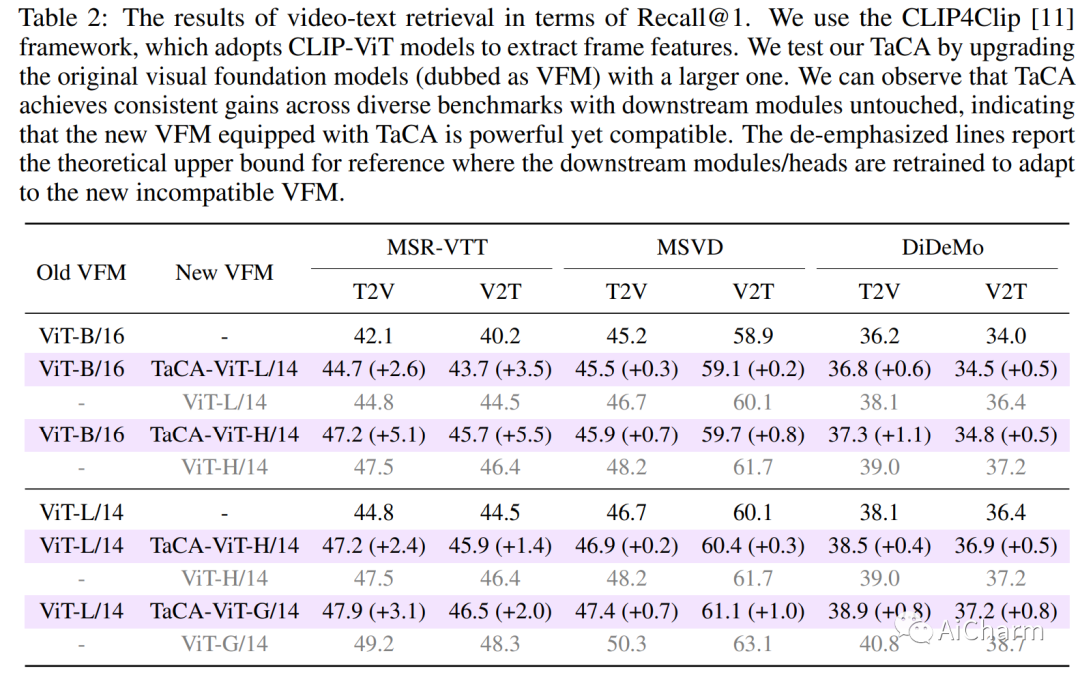

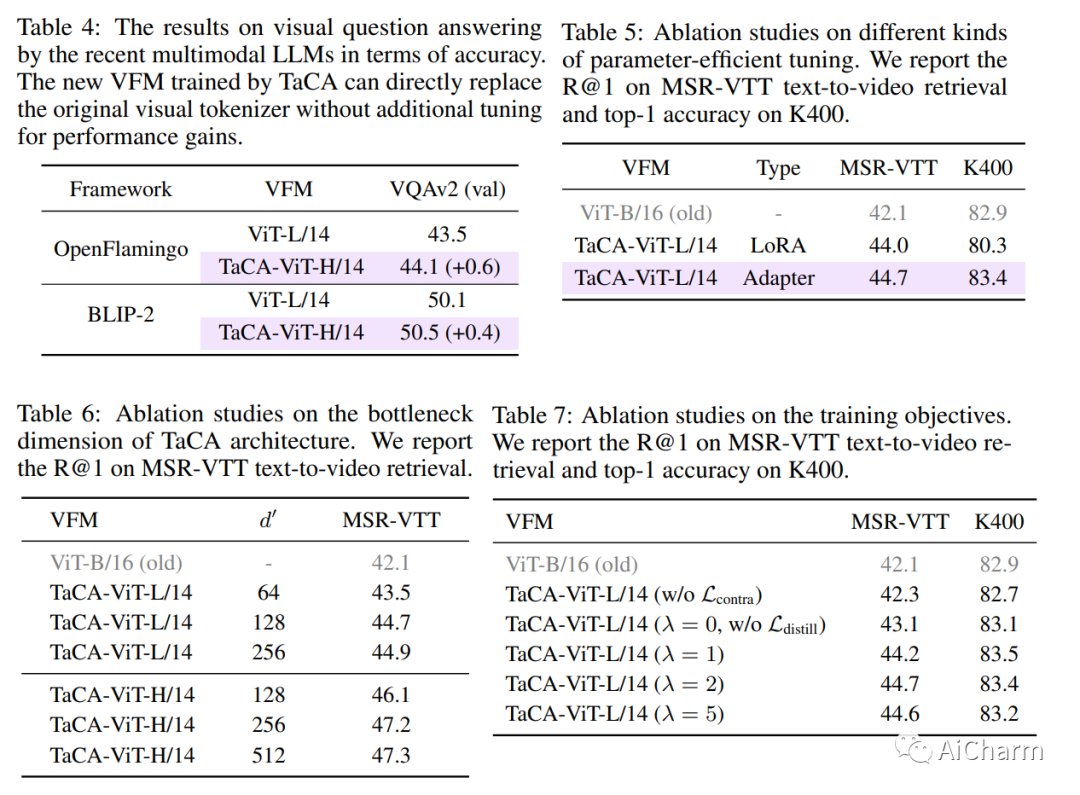

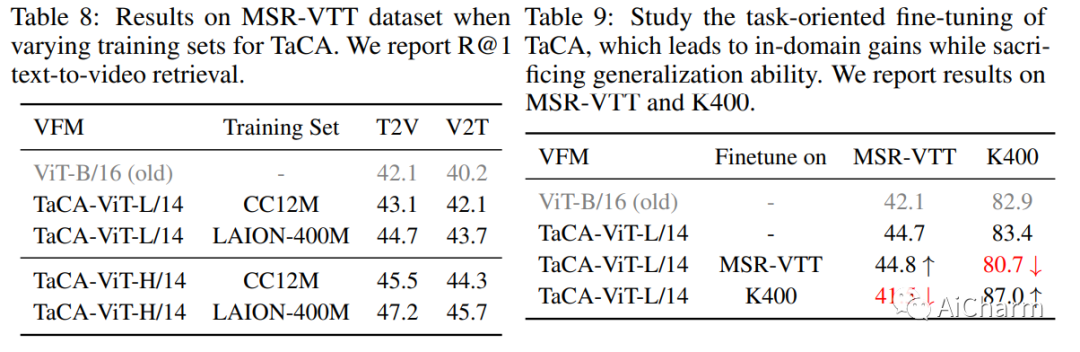

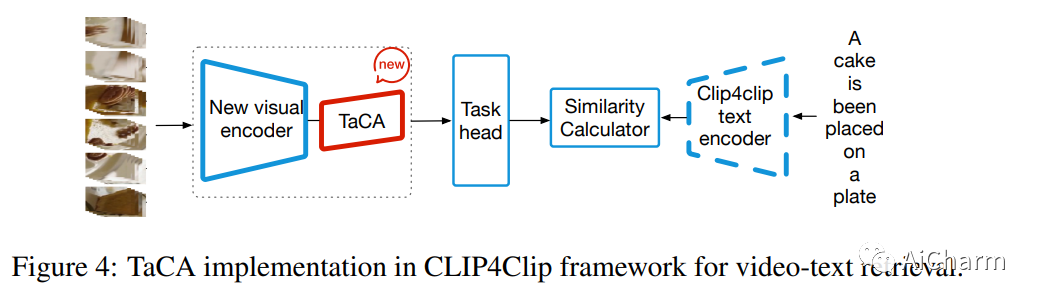

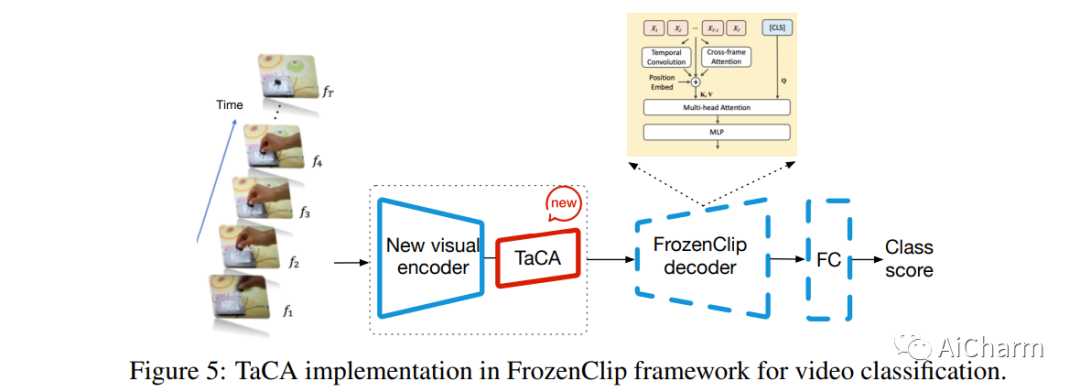

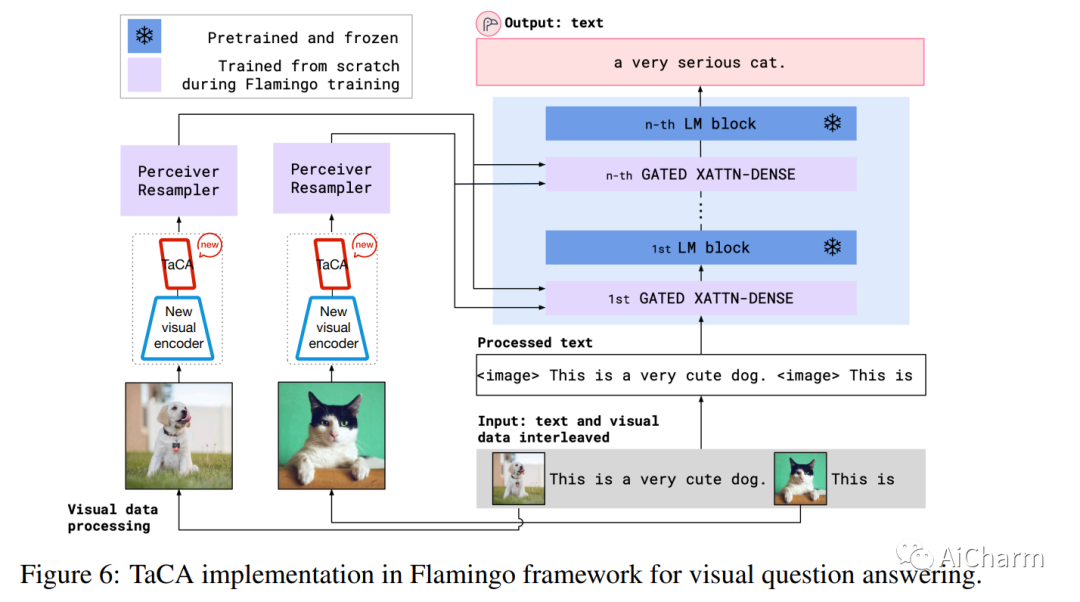

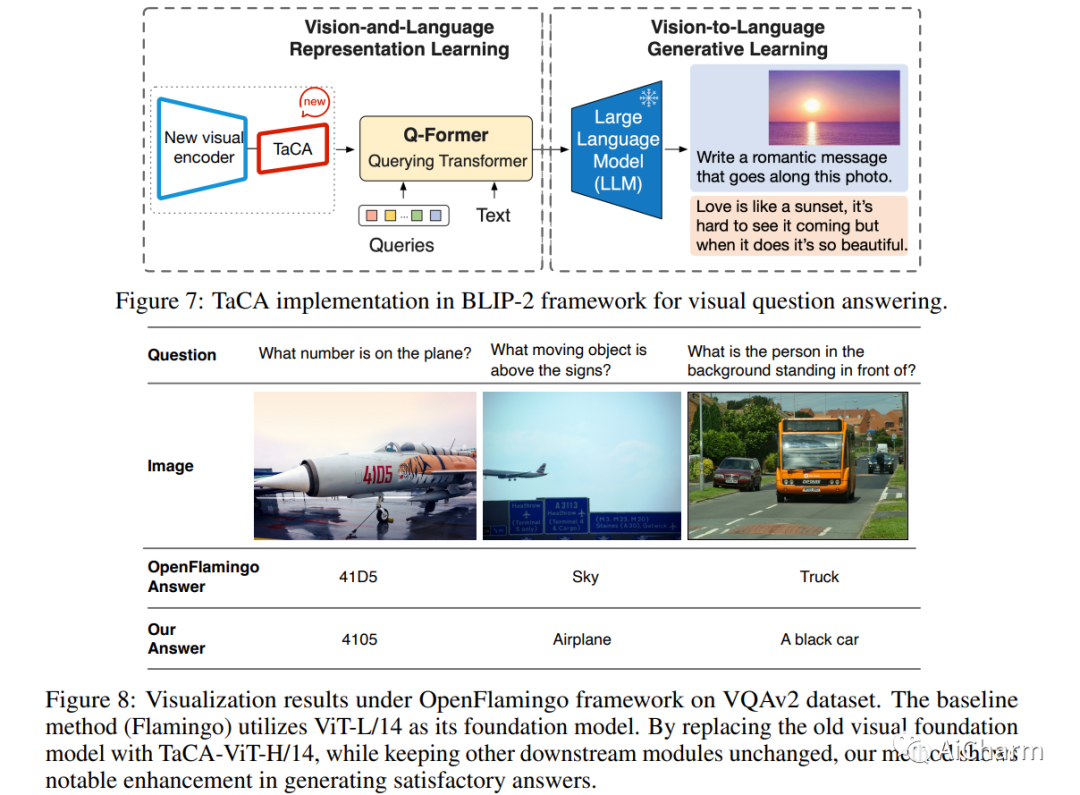

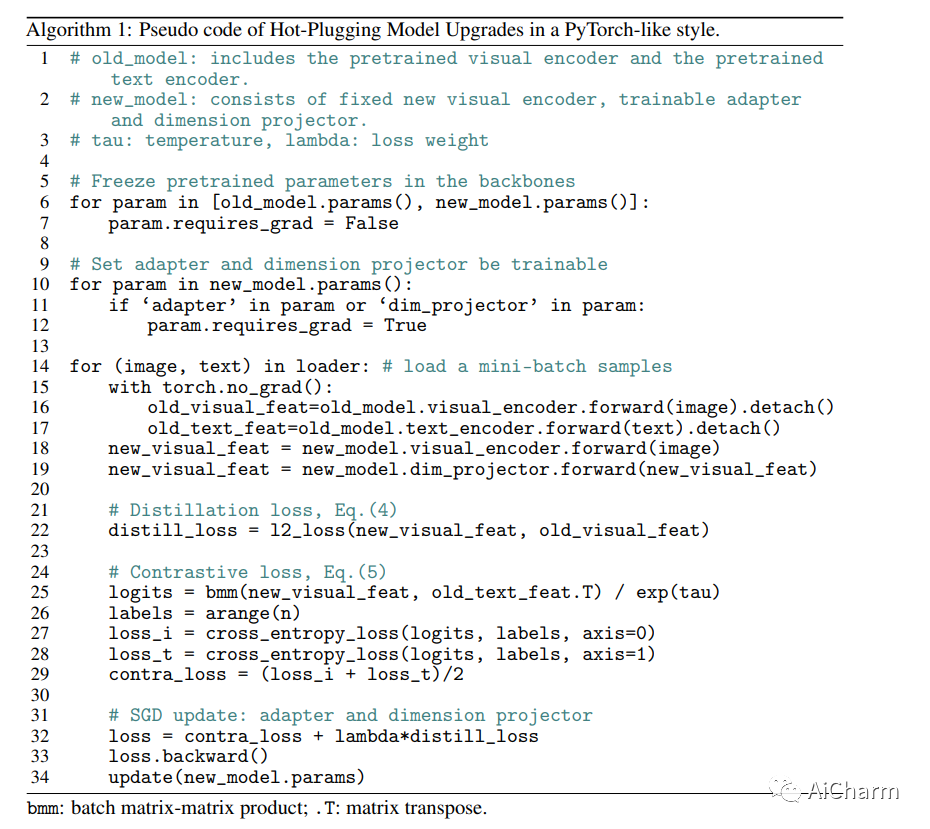

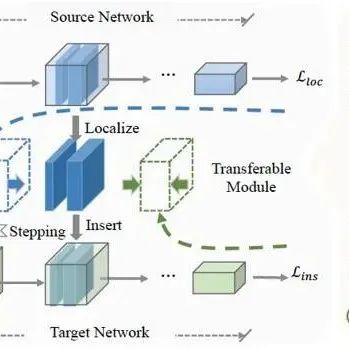

像 CLIP 这样的视觉基础模型擅长通过自监督方法从大量数据集中学习特征表示,展现出卓越的迁移学习和泛化能力。越来越多基于视觉基础模型的应用不断涌现,包括 BLIP-2 等创新解决方案。这些应用程序采用预先训练的 CLIP 模型作为上游特征提取器,并训练各种下游模块来完成不同的任务。在涉及系统升级需要更新上游基础模型的情况下,必须重新训练所有下游模块以适应新的基础模型,这是不灵活且低效的。在本文中,我们介绍了一种参数高效且与任务无关的适配器,称为 TaCA,它促进不同基础模型之间的兼容性,同时确保新模型的性能增强。TaCA 允许下游应用程序无缝集成性能更好的基础模型,而无需重新训练。我们使用不同规模的模型(参数多达 10 亿)对 TaCA 进行了广泛的实验验证,包括视频文本检索、视频识别和视觉问答等各种任务。结果一致证明了 TaCA 在视觉基础模型热插拔升级方面的新兴能力。代码和模型将在此 https URL 中提供。

3.HyenaDNA: Long-Range Genomic Sequence Modeling at Single Nucleotide Resolution

标题:HyenaDNA:单核苷酸分辨率的长距离基因组序列建模

作者:Eric Nguyen, Michael Poli, Marjan Faizi, Armin Thomas, Callum Birch-Sykes, Michael Wornow, Aman Patel, Clayton Rabideau, Stefano Massaroli, Yoshua Bengio, Stefano Ermon, Stephen A. Baccus, Chris Ré

文章链接:https://arxiv.org/abs//2306.15794

摘要:

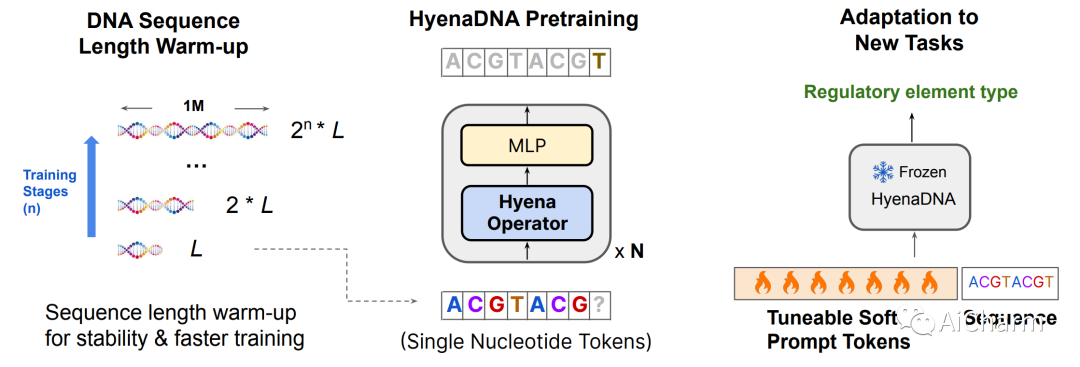

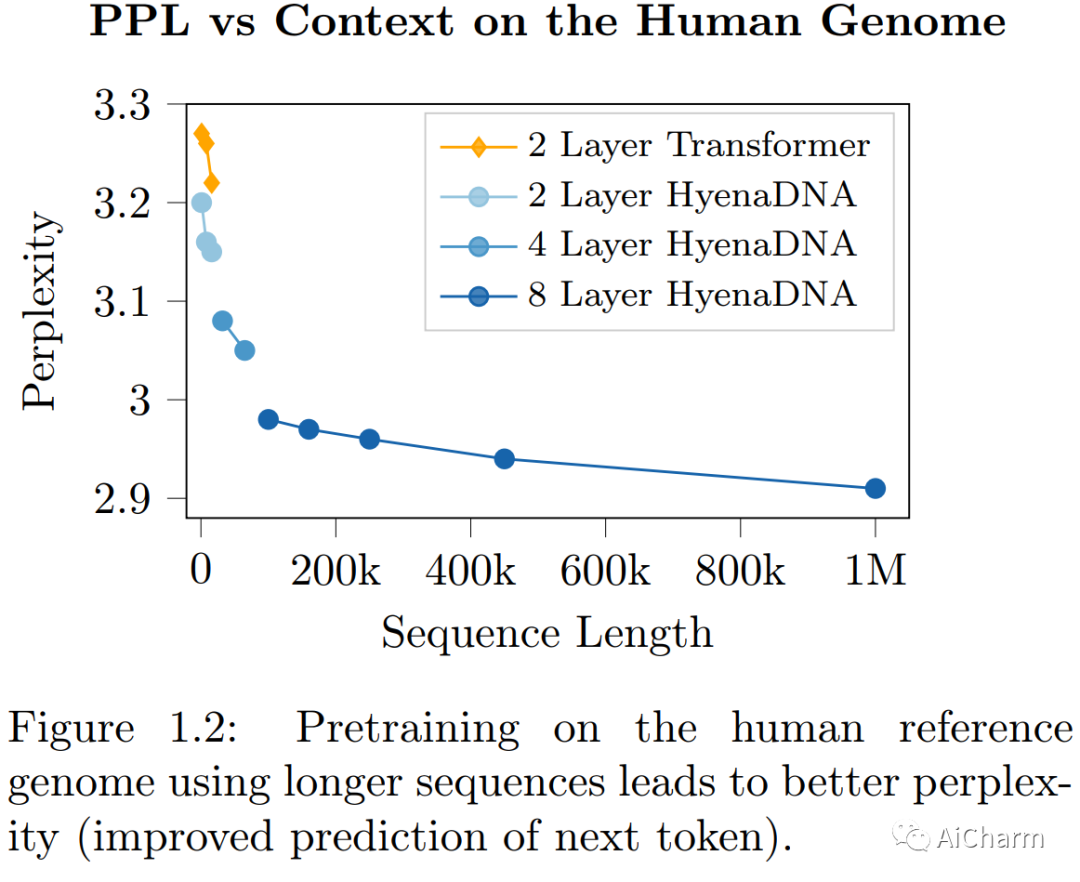

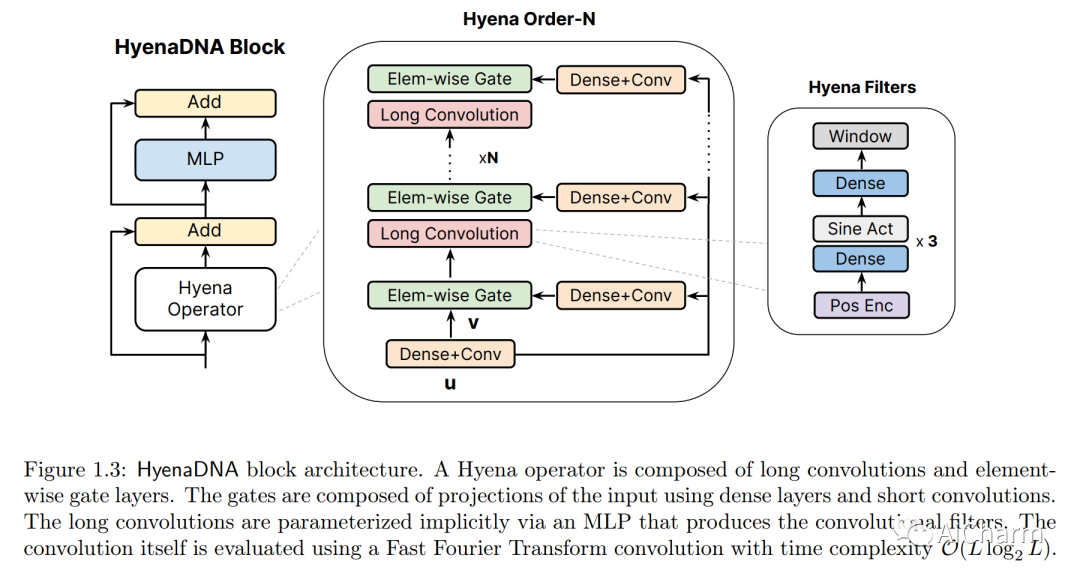

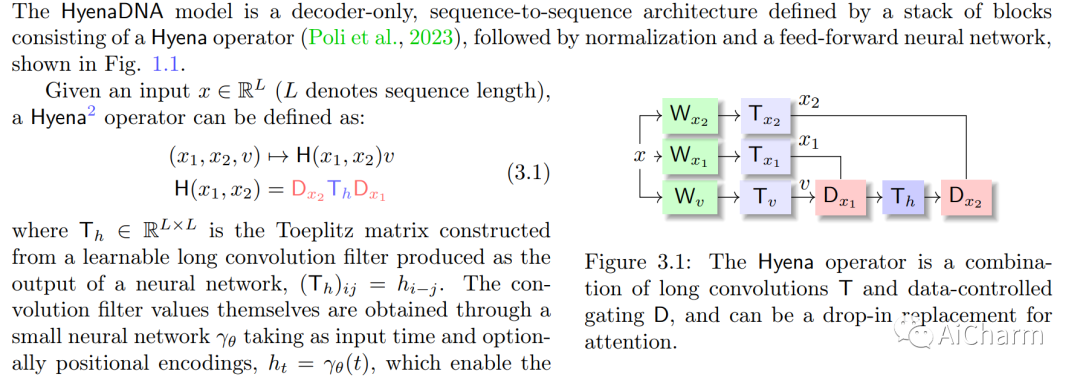

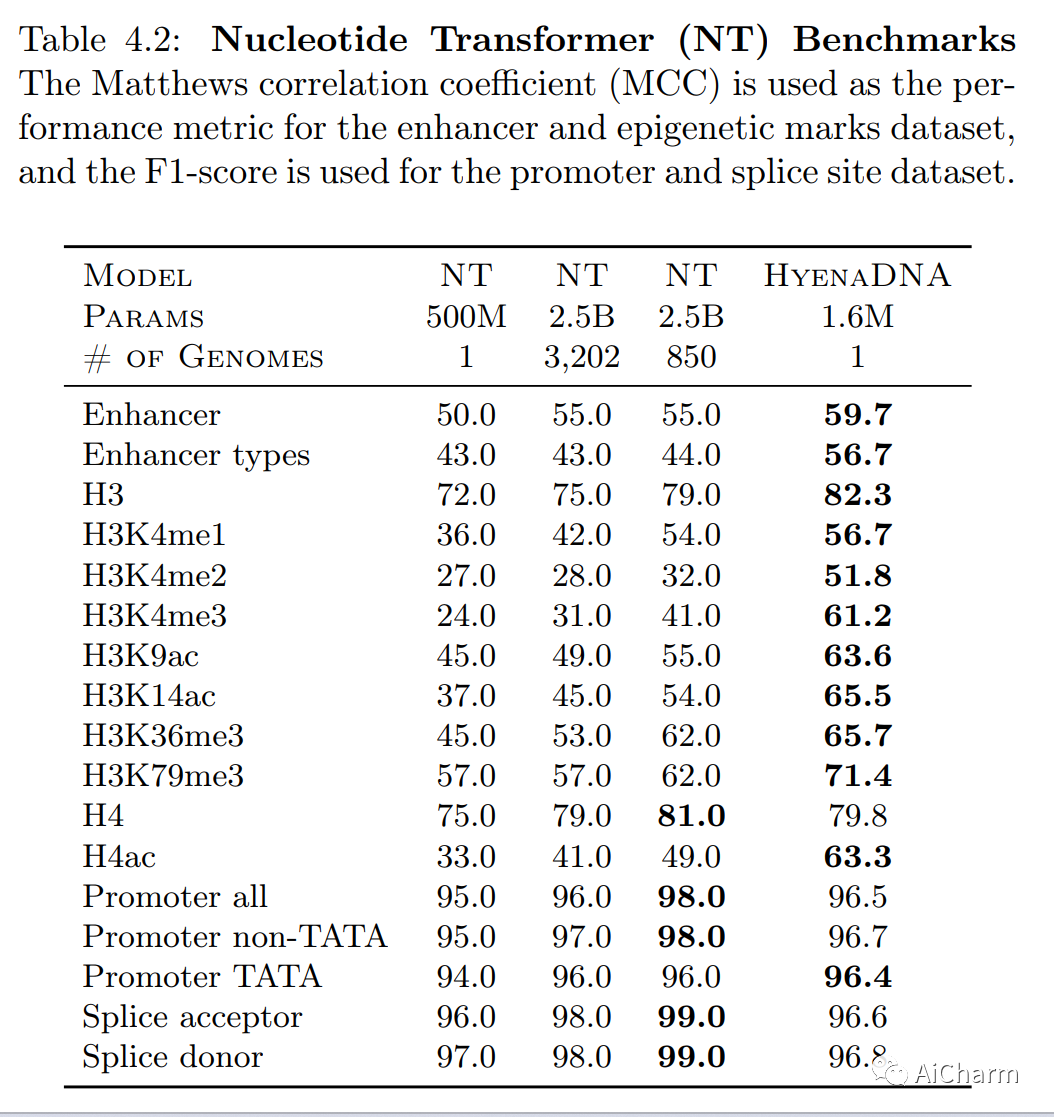

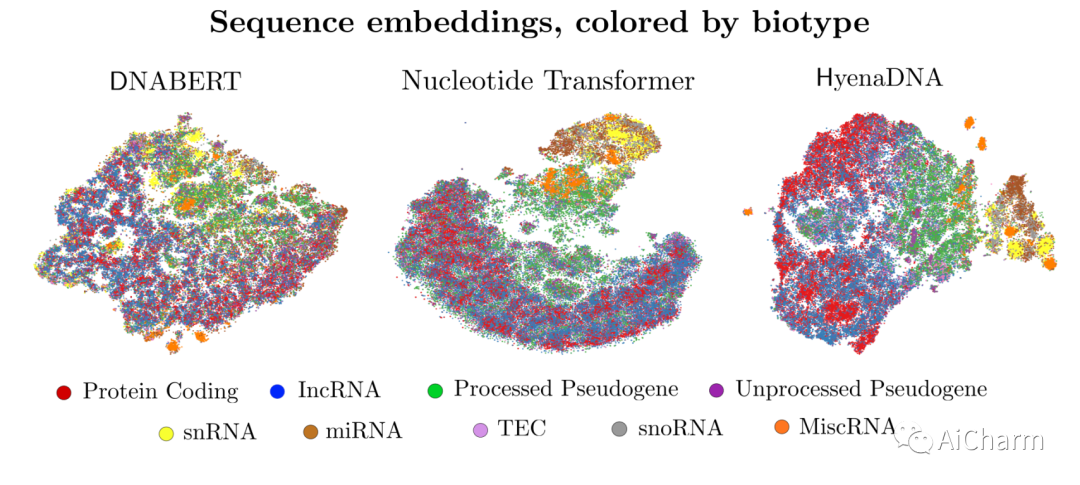

基因组 (DNA) 序列编码大量用于基因调控和蛋白质合成的信息。与自然语言模型类似,研究人员提出了基因组学的基础模型,从未标记的基因组数据中学习可概括的特征,然后可以针对下游任务(例如识别调控元件)进行微调。由于注意力的二次缩放,之前基于 Transformer 的基因组模型使用 512 到 4k 个标记作为上下文(< 人类基因组的 0.001%),极大地限制了 DNA 中远程相互作用的建模。此外,这些方法依赖标记器来聚合有意义的 DNA 单元,从而失去单核苷酸分辨率,其中细微的遗传变异可以通过单核苷酸多态性 (SNP) 完全改变蛋白质功能。最近,基于隐式卷积的大型语言模型 Hyena 被证明可以在质量上匹配注意力,同时允许更长的上下文长度和更低的时间复杂度。利用 Hyenas 新的远程功能,我们推出了 HyenaDNA,这是一种在人类参考基因组上进行预训练的基因组基础模型,在单核苷酸水平上上下文长度高达 100 万个标记,比之前基于密集注意力的模型增加了 500 倍。HyenaDNA 在序列长度上按二次方缩放(训练速度比 Transformer 快 160 倍),使用单核苷酸标记,并且在每一层都有完整的全局上下文。我们探索更长的上下文可以实现什么——包括在基因组学中首次使用上下文学习来简单地适应新任务,而无需更新预训练的模型权重。在 Nucleotide Transformer 的微调基准上,HyenaDNA 使用参数和预训练数据少几个数量级的模型,在 17 个数据集中的 12 个上达到了最先进的 (SotA)。在 GenomicBenchmarks 上,HyenaDNA 在所有 8 个数据集上平均超过 SotA +9 个准确度点。

推荐阅读

CVPR 2023 | 自动驾驶3D occupancy prediction挑战赛—冠军方案

CVPR 2023 | 神经网络超体?新国立LV lab提出全新网络克隆技术

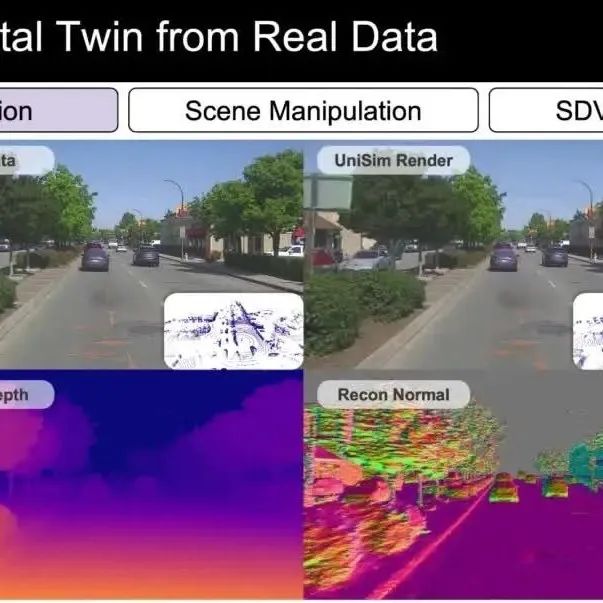

CVPR 2023|All in UniSim:统一的自动驾驶仿真平台

点击卡片,关注「AiCharm」公众号

喜欢的话,请给我个在看吧!