走向计算机视觉的通用人工智能:从GPT和大型语言模型中汲取的经验教训 (下)

走向计算机视觉的通用人工智能:从GPT和大型语言模型中汲取的经验教训 (下)

论文地址:https://arxiv.org/pdf/2306.08641.pdf

计算机视觉研究院专栏

Column of Computer Vision Institute

人工智能界一直在追求被称为通用人工智能(AGI)的算法,这些算法适用于任何类型的现实世界问题。

继续上一篇,详细描述通用人工智能

03

总 述

简而言之,AGI就是学习一个广义函数a=π(s)。尽管形式很简单,但老式的人工智能算法很难使用相同的方法、算法甚至模型来处理所有这些问题。在过去的十年里,深度学习提供了一种有效而统一的方法:人们可以训练深度神经网络来近似函数a=π(s),而不知道它们之间的实际关系。强大的神经网络架构(如transformer)的出现甚至使研究人员能够为不同的数据模式训练一个模型。

实现AGI存在巨大困难,包括但不限于以下问题。

- 数据的复杂性。真实世界的数据是多方面和丰富的。一些数据模态(例如,图像)可能具有相当高的维度,并且不同模态之间的关系可能是复杂和潜在的。

- 人类智力的复杂性。AGI的目标不仅是解决问题,还包括计划、推理、对不同事件的反应等。有时,人类行为和目标之间的关系是模糊的,很难用数学形式表示。

- 缺乏神经或认知理论。人类还不了解人类的智慧是如何实现的。目前,计算机算法提供了一种途径,但随着神经病学和/或认知学的未来研究,可能会出现更多的可能性。

04

GPT

NLP中AGI的火花

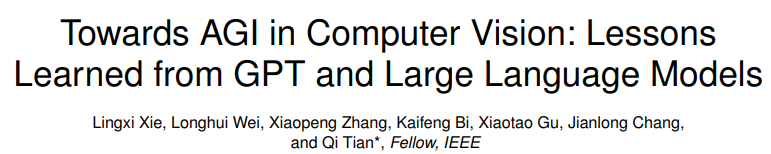

在过去的一年里,ChatGPT3、GPT-4和其他人工智能聊天机器人,如Vicuna4,在AGI方面取得了重大进展。它们是为自然语言处理(NLP)开发的计算机算法。通过与人类的聊天程序,他们可以理解人类的意图,并完成广泛的任务,只要这些任务能够以纯文本呈现。特别是,GPT-4在通用问题解决方面有很强的能力,被认为是NLP领域AGI的早期火花。

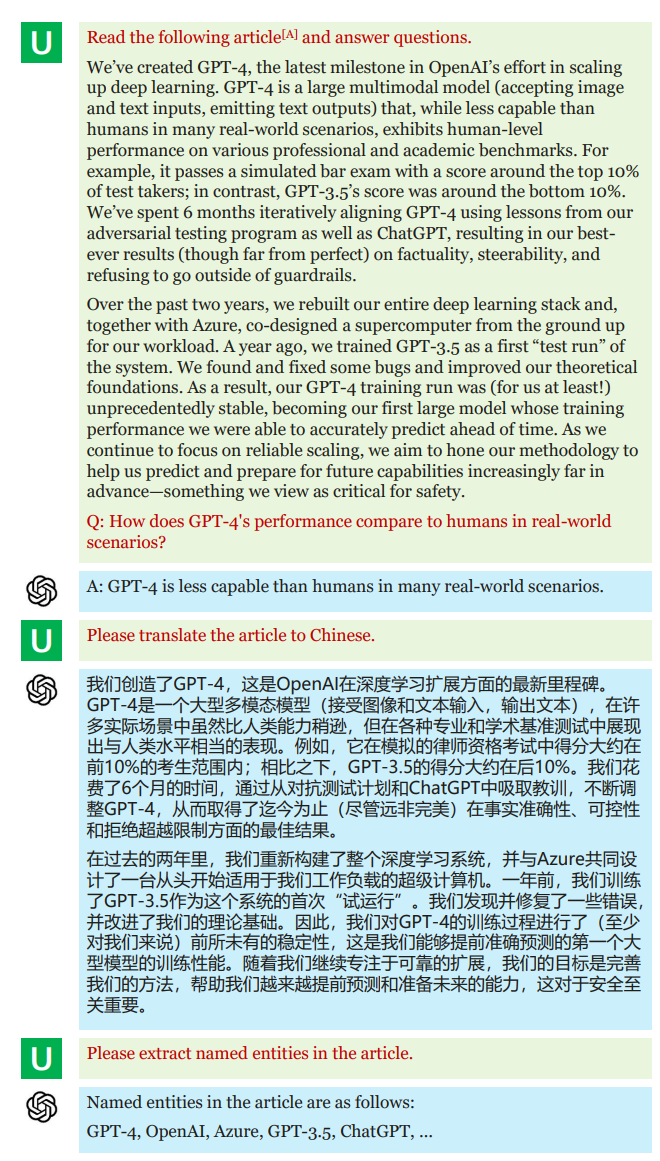

尽管GPT-4尚未向公众开放视觉界面,但官方技术报告展示了几个关于多模式对话的奇特例子,即基于输入图像的聊天作为参考。这意味着GPT-4已经具备了将语言特征与视觉特征相结合的能力,因此它可以执行基本的视觉理解任务。正如我们稍后将看到的,视觉社区已经为相同的目的开发了几种替代品,关键在于使用ChatGPT或GPT-4来生成(指导)训练数据。此外,通过简单的提示,GPT-4还能够调用用于图像生成的外部软件(例如,Midtravel,如下图所示)和用于解决计算机视觉中复杂问题的外部库(例如,HuggingFace库)。

这些人工智能聊天机器人是分两个阶段进行训练的。在第一阶段,使用自监督学习在大型文本数据库上预训练大型语言模型(LLM),其中大部分基于transformer架构。在第二阶段,预先训练的LLM由人工指令监督,以完成特定任务。如有必要,收集人类反馈并进行强化学习,以微调LLM,使其具有更好的性能和更高的数据效率。CV:AGI的下一个战场

05

AGI下一个战场

CV:AGI的下一个战场

人类基于多种数据模态感知世界。众所周知,我们所学的大约85%是通过我们的视觉系统完成的。因此,鉴于NLP社区已经显示出AGI的前景,自然会将计算机视觉(CV)或多模态(至少包括视觉和语言领域)视为AGI的下一个战场。

在此提供两项补充意见,以补充上述声明。首先,很明显,CV是NLP的超集,因为人类阅读文章首先识别捕获图像中的字符,然后理解内容。换句话说,CV中的AGI(或多模态)应涵盖NLP中AGI的所有能力。其次,我认为,在许多情况下,仅靠语言是不够的。例如,当人们试图找到关于未知物体(例如,动物、时尚等)的详细信息时,最好的方法是捕捉图像并将其用于在线搜索;单纯依赖文本描述可能会带来不确定性和不准确性。另一种情况是,正如我前面提及那样,在场景中引用细粒度语义(用于识别或图像编辑)并不总是容易的,而且以视觉友好的方式思考更有效,例如,使用点或框来定位目标,而不是说“穿着黑色夹克、站在黄色汽车前的人,和另一个人说话。”

理想与现实

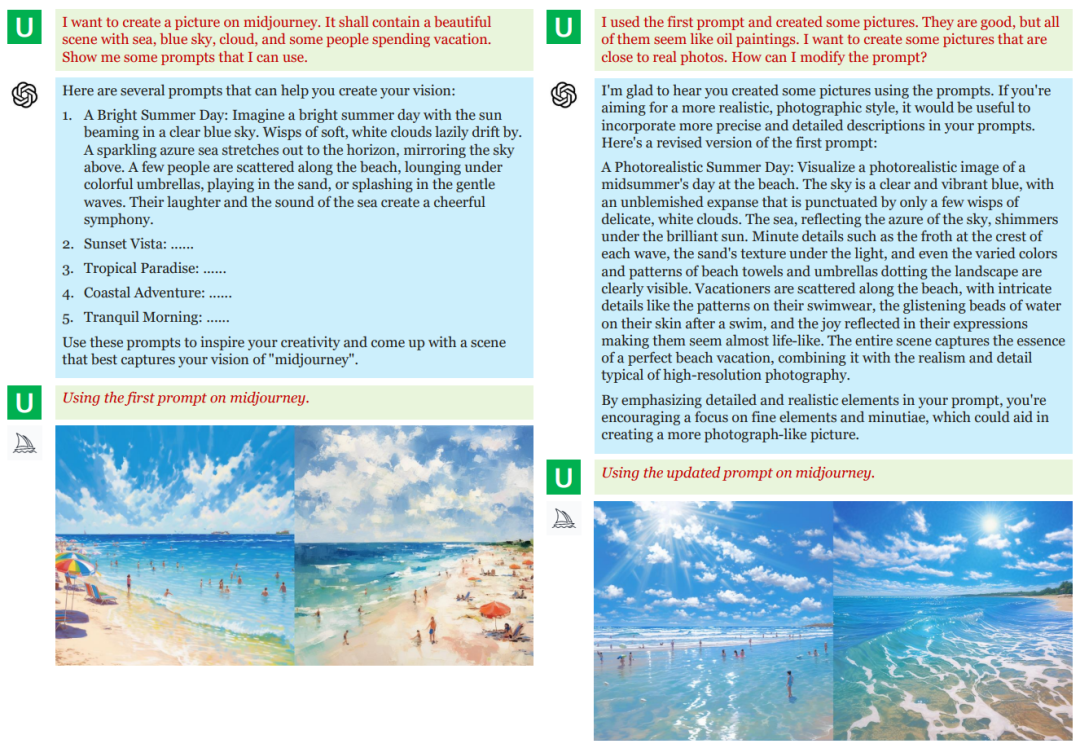

希望有一种CV算法,可以通过与环境交互来解决一般任务。注意,该要求不限于识别所有内容或基于图像或视频剪辑执行对话。它应该是一个整体系统,从人类那里接收通用命令并产生期望的结果。但是,CV的现状还很初步。如下图所示,CV一直在为不同的视觉任务使用不同的模块甚至系统。

统一是趋势

下面,我将最近关于CV统一的研究主题总结为五类。

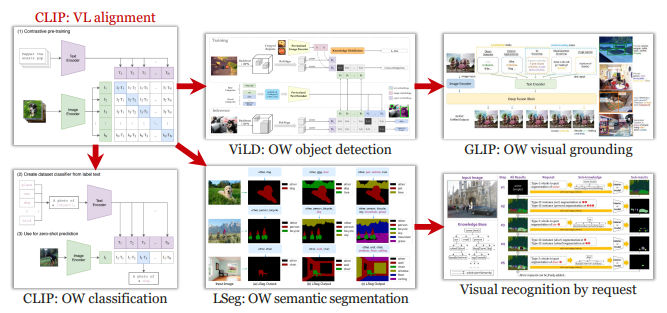

- Open-world Visual Recognition

在很长一段时间内,大多数CV算法只能识别训练数据中出现的概念,导致视觉概念的“封闭世界”。相反,“开放世界”的概念是指CV算法能够识别或理解任何概念的能力,无论它以前是否出现过。开放世界能力通常是由自然语言引入的,因为它是人类理解新概念的自然方式。这就解释了为什么图像字幕和视觉问答等与语言相关的任务促成了最早的视觉识别开放世界设置。

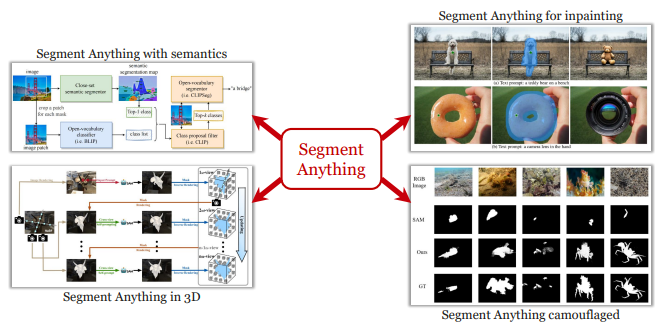

- The Segment Anything Task

Segment Anything任务是最近引入的一个通用模块,用于将原始图像像素聚类成组,其中许多像素对应于图像中的基本视觉单元。所提出的任务支持多种类型的提示,包括点、轮廓、文本等,并为每个提示或每个提示组合生成一些掩码和分数。在拥有约1000万张图像的大规模数据集上进行训练后,衍生模型SAM能够转移到广泛的分割任务中,包括医学图像分析、伪装对象分割、3D对象分割、对象跟踪,以及图像修复等应用场景。SAM还可以与最先进的视觉识别算法一起使用,例如将视觉基础算法产生的边界框细化为掩码,并将分割单元输入用于图像标记的开集分类算法。

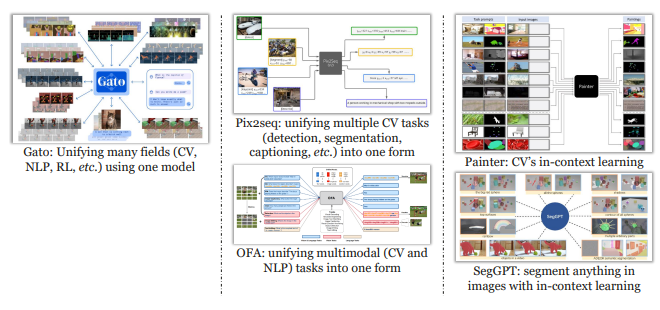

- Generalized Visual Encoding

统一CV任务的另一种方法是为它们提供通用的视觉编码。有几种方法可以实现这一目标。一个关键的困难在于视觉任务之间的巨大差异,例如,目标检测需要一组边界框,而语义分割需要对整个图像进行密集预测,这两者都与图像分类所需的单个标签非常不同。正如所有人都能理解的那样,自然语言提供了一种统一的形式来表示一切。一项名为pix2seq的早期研究表明,物体检测结果(即边界框)可以公式化为自然语言和坐标,然后转换为标记作为视觉模型的输出。在后来的版本pix2seq-v2中,他们对表示进行了概括,以目标检测、实例分割、关键点检测和图像字幕的输出。类似的想法也用于其他图像识别、视频识别和多模态理解任务。

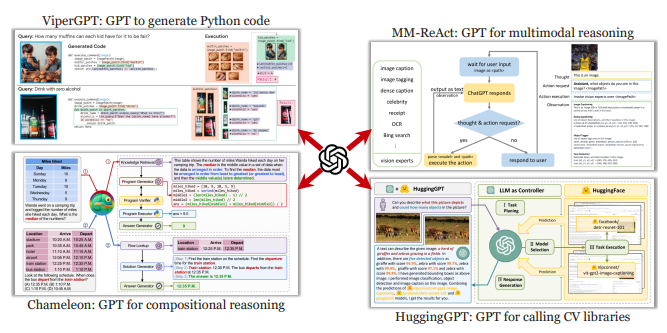

- LLM-guided Visual Understanding

视觉识别可能很复杂,尤其是当它涉及组成概念和/或视觉实例之间的关系时。端到端模型(用于视觉问答的视觉语言预训练模型)很难按照人类容易理解的程序产生答案。为了缓解这个问题,一种实用的方法是生成可解释的逻辑来帮助视觉识别。这个想法并不新鲜。几年前,在transformer架构出现之前,研究人员提出使用长短期记忆(LSTM)模型来生成程序,以便调用视觉模块作为复杂问题回答的模块。当时,LSTM的能力在很大程度上将这个想法限制在相对简单和模板化的问题范围内。

最近,大型语言模型(尤其是GPT系列)的出现使任意问题的转换成为可能。具体来说,GPT可以以不同的方式与人类相互作用。例如,它可以将基本识别结果总结为最终答案,或者生成代码或自然语言脚本来调用基本视觉模块。因此,视觉问题可以分解为基本模块。这对于逻辑问题尤其有效,例如询问对象之间的空间关系或取决于对象数量的问题。

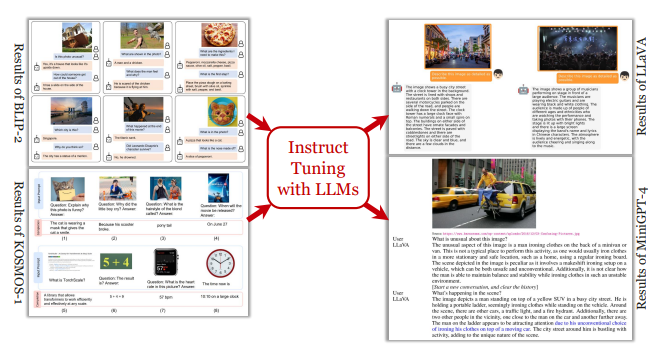

- Multimodal Dialog

多模式对话框将基于文本的对话框扩展到视觉领域。早期的工作涉及视觉问答,其中构建了具有简单问题的各种数据集。随着LLM的快速发展,通过将预先训练的视觉和语言模型一起微调,可以实现多轮问答。研究还表明,可以通过多模态的上下文学习或使用GPT作为逻辑控制器来回答广泛的问题。

最近,GPT系列中开发的一种新范式,命名为指导学习,被继承来提高多模式对话的质量。其想法是从GT实况注释或识别结果中提供一些参考数据(例如,目标、描述),并要求GPT模型生成指令数据(即丰富的问答对)。通过对这些数据进行微调(无需参考),视觉和语言的基础模型可以通过轻量级网络模块(例如Q-former)相互交互。多模式对话为计算机视觉提供了一个初步的交互基准,但作为一项语言指导任务,它也有开放世界视觉识别中分析的弱点。我们希望丰富查询形式(例如,使用通用视觉编码方法)可以将多模式对话推向更高的水平。

06

未来

从环境中学习

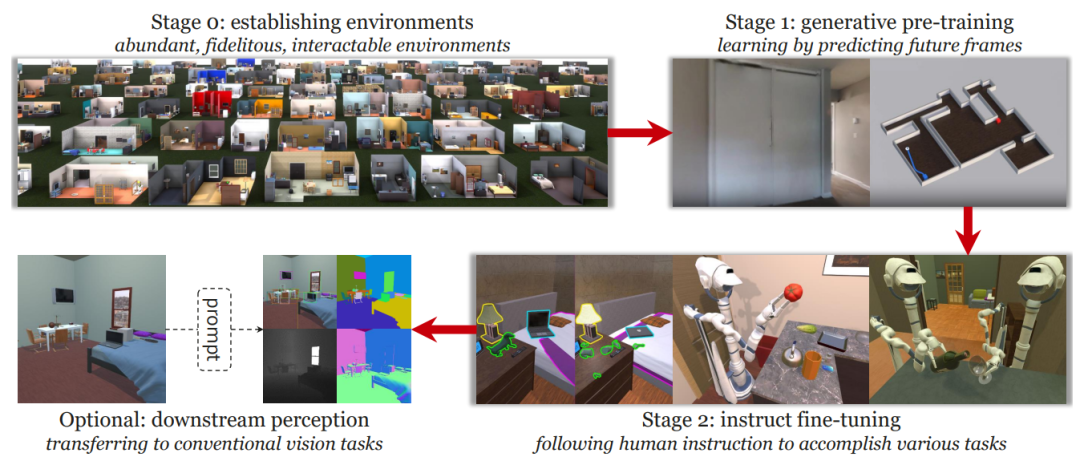

An Imaginary Pipeline

上图显示了我们的想法。该管道包括三个阶段:第0阶段用于建立环境,第1阶段用于预训练,第2阶段用于微调。必要时,可以提示微调后的模型执行传统的视觉识别任务。

Comments on Research Directions

最后,对未来的研究方向进行了展望。随着主要目标从代理任务的性能转移到从环境中学习,许多流行的研究方向可能不得不调整其目标。这里有一个免责声明:以下所有声明都是我们的个人意见,可能是错误的。

论营造环境

一个明确的目标是继续增加虚拟环境的规模、多样性和保真度。有多种技术可以提供帮助。例如,新的3D表示形式(例如,neural rendering field, NeRF)在实现重建质量和开销之间的折衷方面可能更有效。另一个重要的方向是丰富的环境。定义新的、复杂的任务并将它们统一为一个提示系统是一项不平凡的任务。此外,人工智能算法可以从更好地模拟其他代理的行为中受益匪浅,因为它可以在很大程度上提高环境的丰富性,从而提高训练算法的稳健性。

论生成性预训练

主要有两个因素影响预训练阶段,即神经架构设计和代理任务设计。后者显然更为重要,前者应建立在后者的基础上。应修改现有的预训练任务,包括对比学习和掩蔽图像建模,以便在虚拟环境中进行有效探索。我们希望新设计的代理专注于数据压缩,因为视觉数据中的冗余比语言数据中的要重得多。新的预训练代理定义了神经架构的要求,例如,为了实现数据压缩和视觉识别之间的折衷,设计的架构应该具备根据请求提取不同级别(粒度)视觉特征的能力。此外,跨模态(例如,文本到图像)生成将成为衡量预训练性能的直接指标。当统一的标记化方法可用时,可以将其公式化为重建损失的多模式版本。

论指导微调

我们还没有进入新范式中定义任务的范围。由于现实世界中的任务可能非常复杂,我们推测可以首先定义和训练一些基本任务,以便将复杂的任务分解为它们。为此,应该设计一个统一的提示系统,并收集丰富的人工指令。作为一个合理的推测,指令数据的数量可能比为训练GPT和其他聊天机器人而收集的数据大几个数量级。这对CV来说是一个全新的故事。未来的道路充满了未知的困难和不确定性。目前我们看不到太多,但未来会出现清晰的道路。

转载请联系本公众号获得授权

往期回顾

01|RestoreDet:低分辨率图像中目标检测 |

|---|

02|ECCV | 数据高效的Transformer目标检测器 |

03|改进的YOLO:AF-FPN替换金字塔模块提升目标检测精度 |

04|走向CV的通用人工智能:从GPT和大型语言模型中汲取的经验教训 (上) |