每日学术速递8.26

1.Enhancing NeRF akin to Enhancing LLMs: Generalizable NeRF Transformer with Mixture-of-View-Experts(ICCV 2023)

标题:增强 NeRF 类似于增强 LLM:具有混合视图专家的可泛化 NeRF Transformer

作者:Wenyan Cong, Hanxue Liang, Peihao Wang, Zhiwen Fan, Tianlong Chen, Mukund Varma, Yi Wang, Zhangyang Wang

文章链接:https://arxiv.org/abs/2308.11793

项目代码:https://github.com/VITA-Group/GNT-MOVE

摘要:

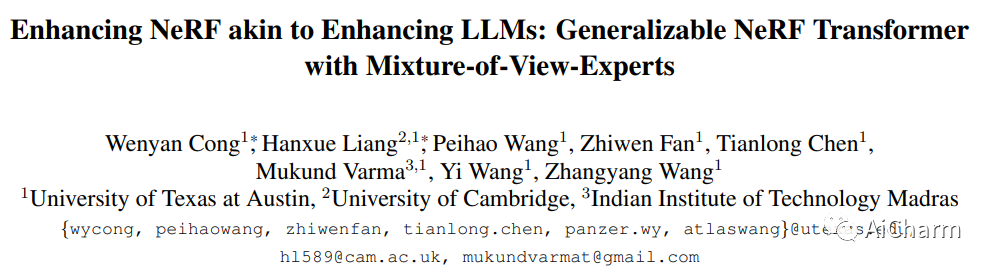

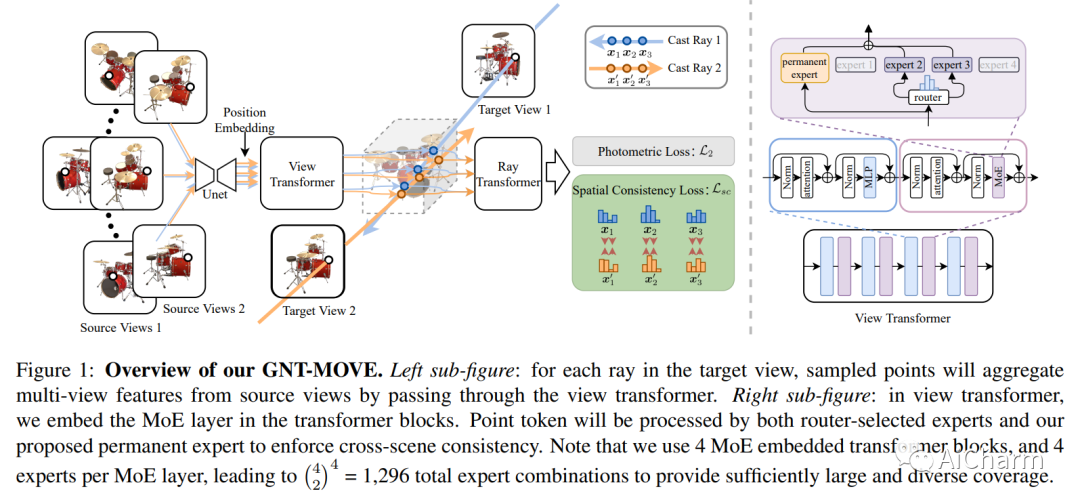

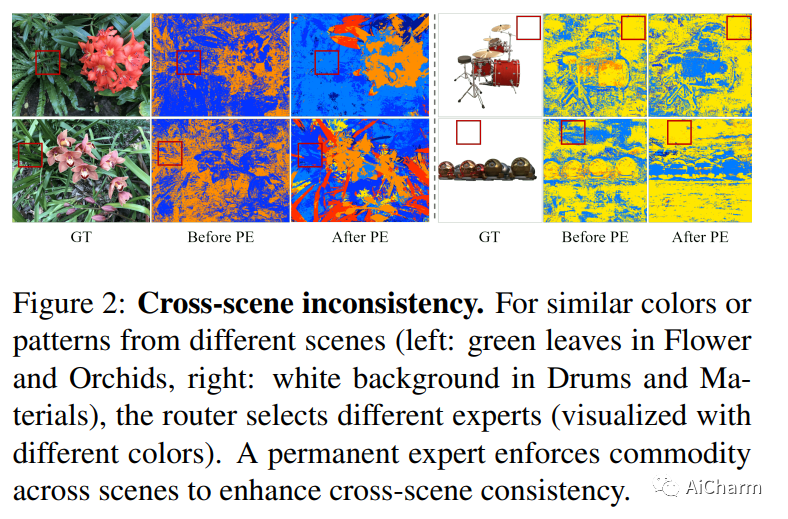

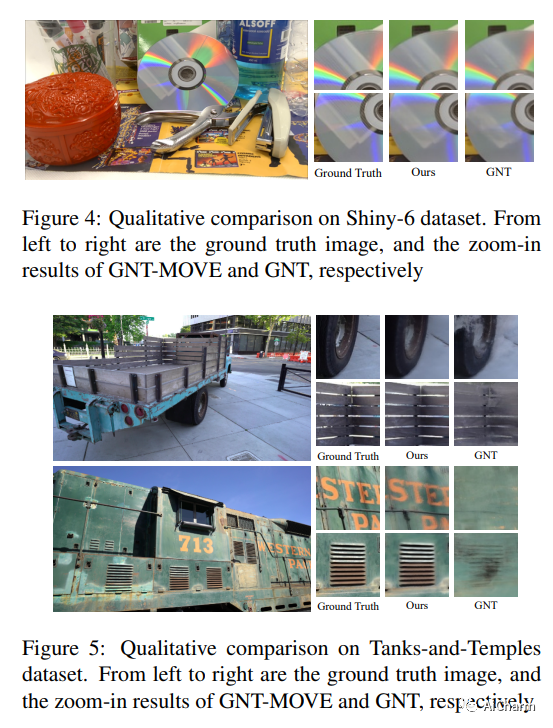

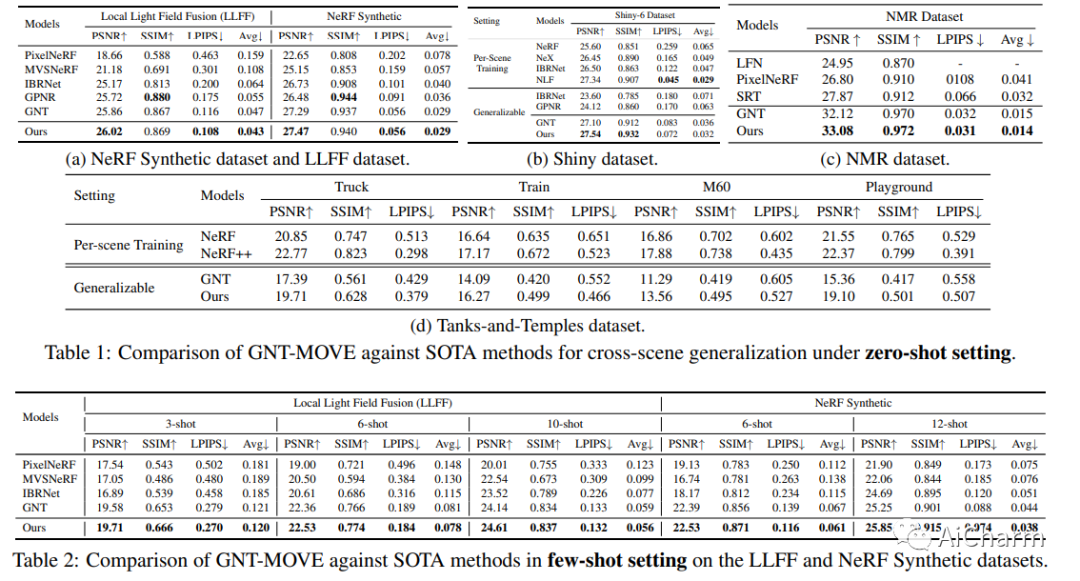

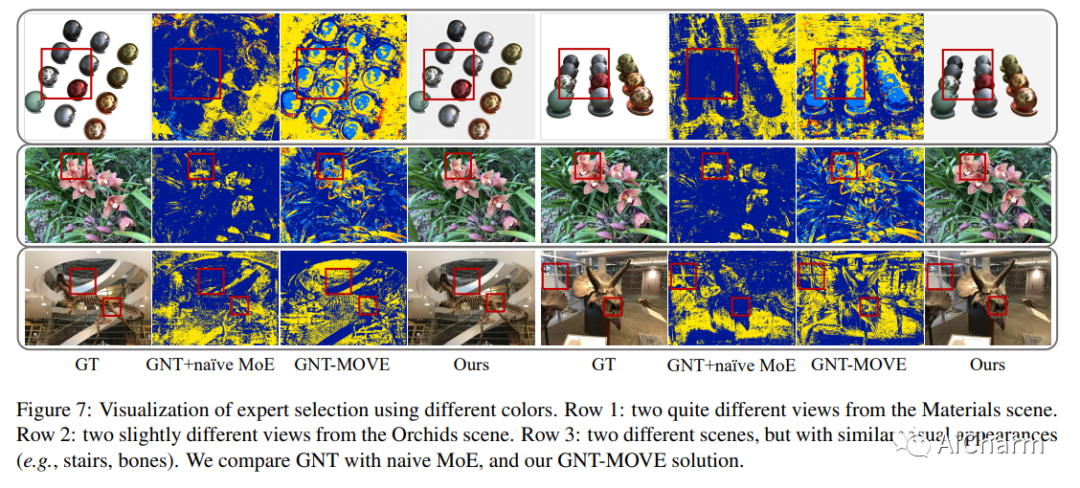

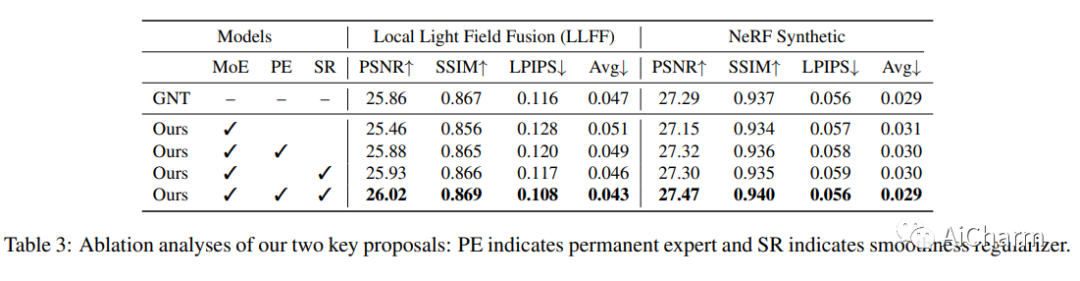

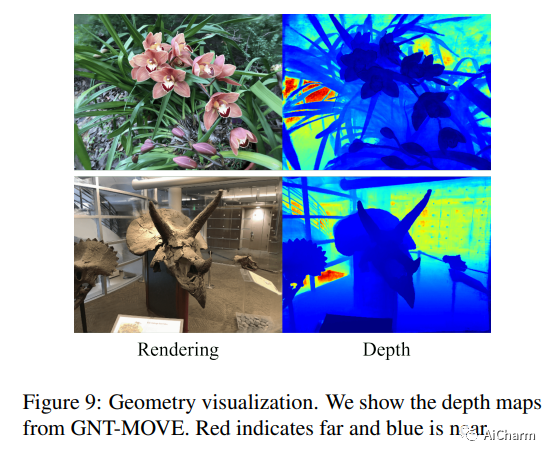

跨场景可推广的 NeRF 模型可以直接合成未见过的场景的新颖视图,已成为 NeRF 领域的新亮点。一些现有的尝试依赖于日益端到端的“神经化”架构,即用高性能神经网络(例如变压器)替换场景表示和/或渲染模块,并将新颖的视图合成转变为前馈推理管道。虽然这些前馈“神经化”架构仍然不能很好地适应不同的场景,但我们建议将它们与来自大型语言模型(LLM)的强大的专家混合(MoE)思想联系起来,该思想已经表现出了卓越的泛化能力通过在更大的整体模型容量和灵活的每个实例专业化之间进行平衡。从最近的通用 NeRF 架构(称为 GNT)开始,我们首先证明 MoE 可以巧妙地插入以增强模型。我们进一步定制了一个共享的永久专家和一个几何感知的一致性损失,以分别增强跨场景一致性和空间平滑度,这对于可概括的视图合成至关重要。我们提出的模型被称为 GNT with Mixture-of-View-Experts (GNT-MOVE),它在转移到未见过的场景时通过实验显示了最先进的结果,表明在零样本和少拍设置。

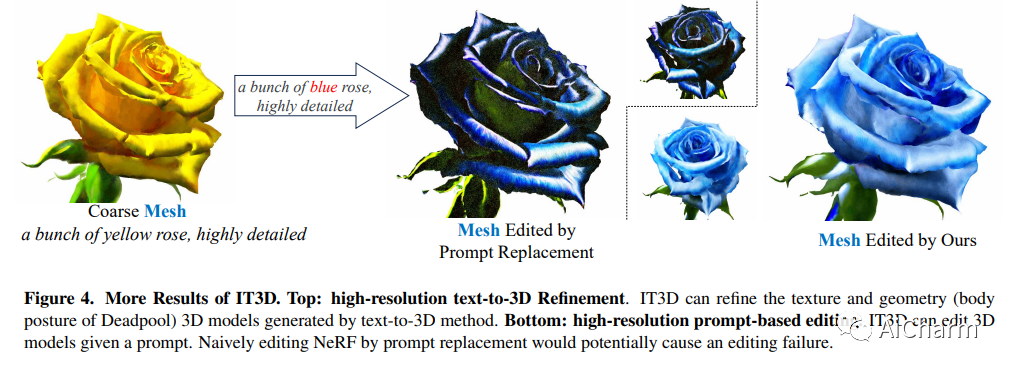

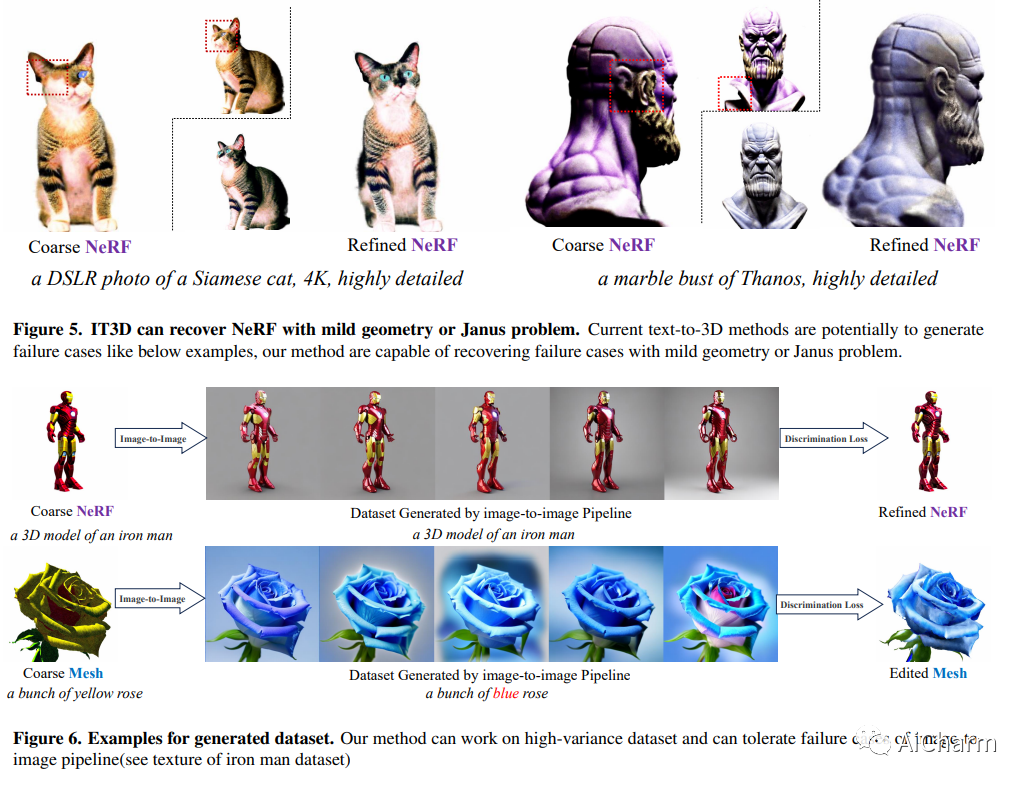

2.IT3D: Improved Text-to-3D Generation with Explicit View Synthesis

标题:IT3D:通过显式视图合成改进文本到 3D 的生成

作者:Yiwen Chen, Chi Zhang, Xiaofeng Yang, Zhongang Cai, Gang Yu, Lei Yang, Guosheng Lin

文章链接:https://arxiv.org/abs/2308.11473v1

项目代码:https://github.com/buaacyw/IT3D-text-to-3D

摘要:

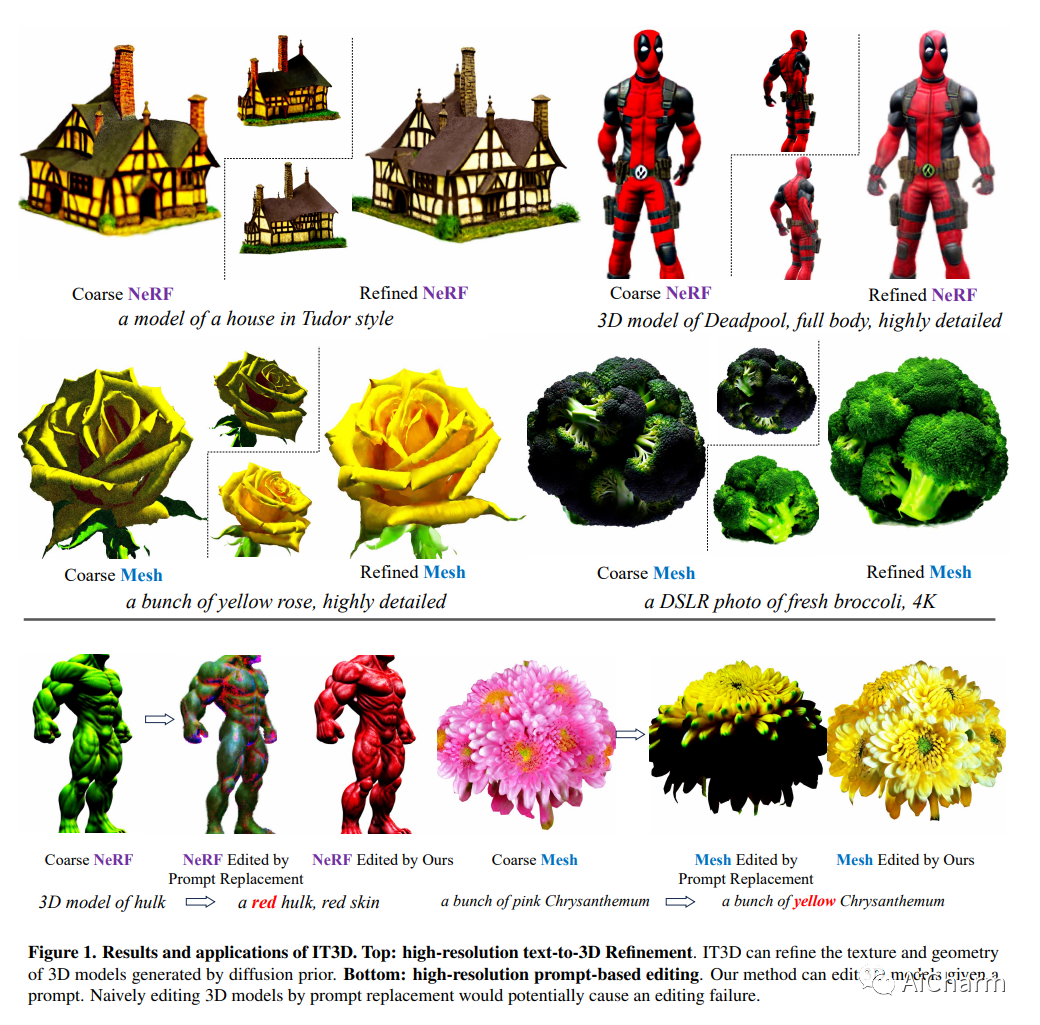

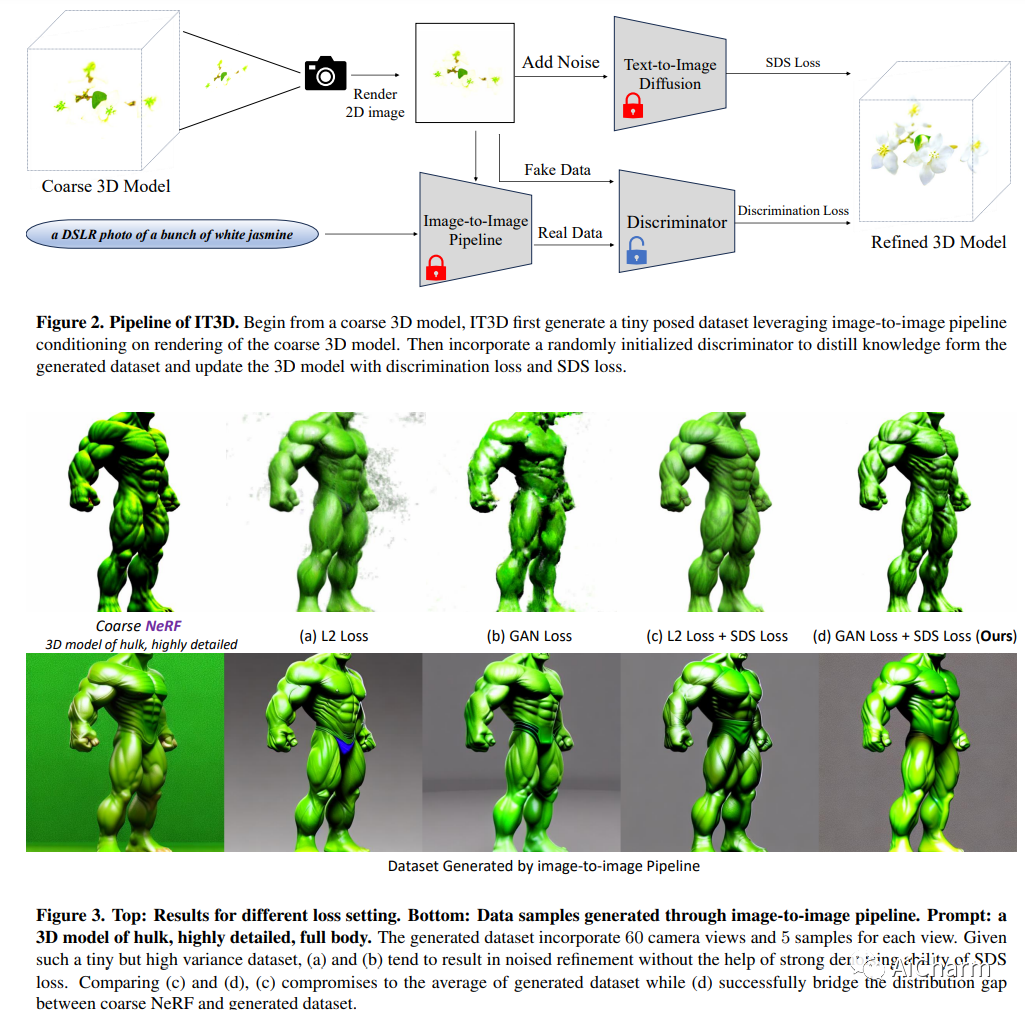

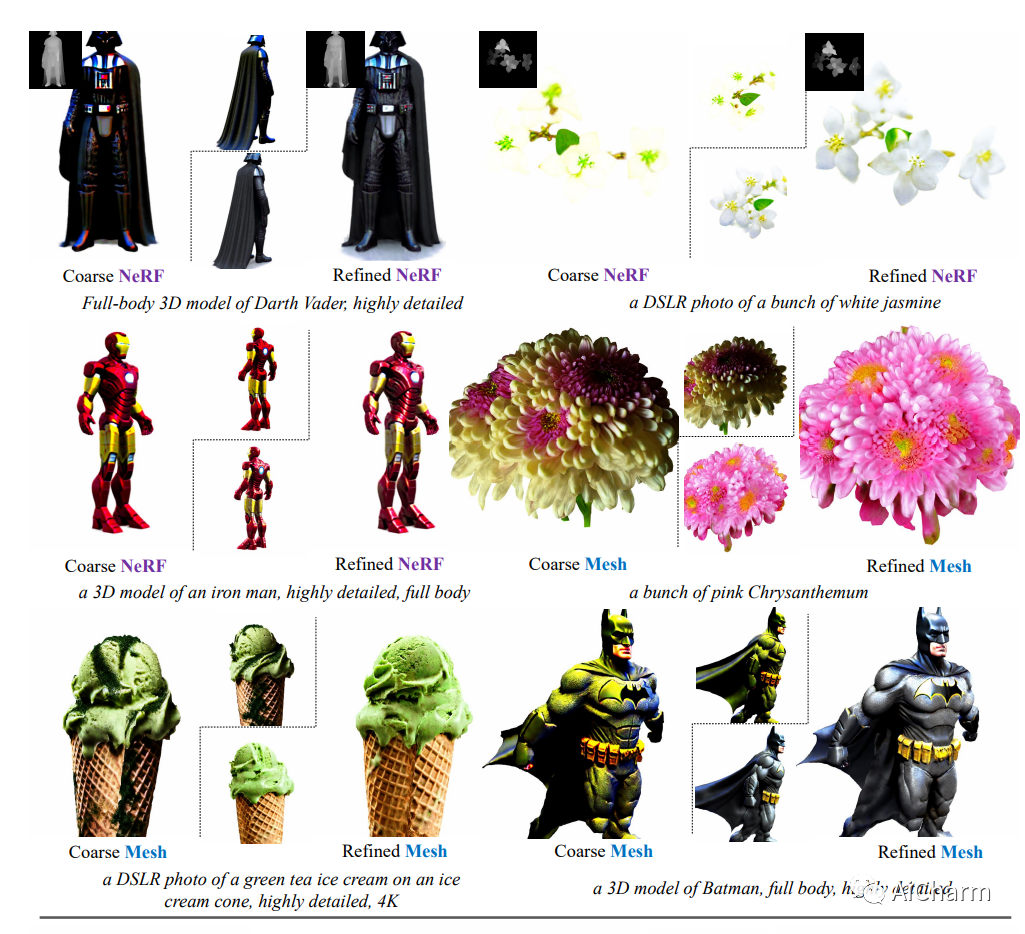

视从强大的大型文本到图像扩散模型 (LDM) 中提取知识,推动了文本到 3D 技术的最新进展。尽管如此,现有的文本转 3D 方法经常面临诸如过饱和、细节不足和输出不切实际等挑战。这项研究提出了一种新颖的策略,利用显式合成的多视图图像来解决这些问题。我们的方法涉及利用由 LDM 支持的图像到图像管道,根据粗略 3D 模型的渲染生成高质量的图像。尽管生成的图像在很大程度上缓解了上述问题,但由于大型扩散模型固有的生成性质,诸如视图不一致和显着内容差异等挑战仍然存在,这给有效利用这些图像带来了巨大的困难。为了克服这一障碍,我们主张将鉴别器与新颖的 Diffusion-GAN 双重训练策略相结合,以指导 3D 模型的训练。对于合并的鉴别器,合成的多视图图像被视为真实数据,而优化的 3D 模型的渲染则被视为假数据。我们进行了一系列全面的实验,证明我们的方法相对于基线方法的有效性。

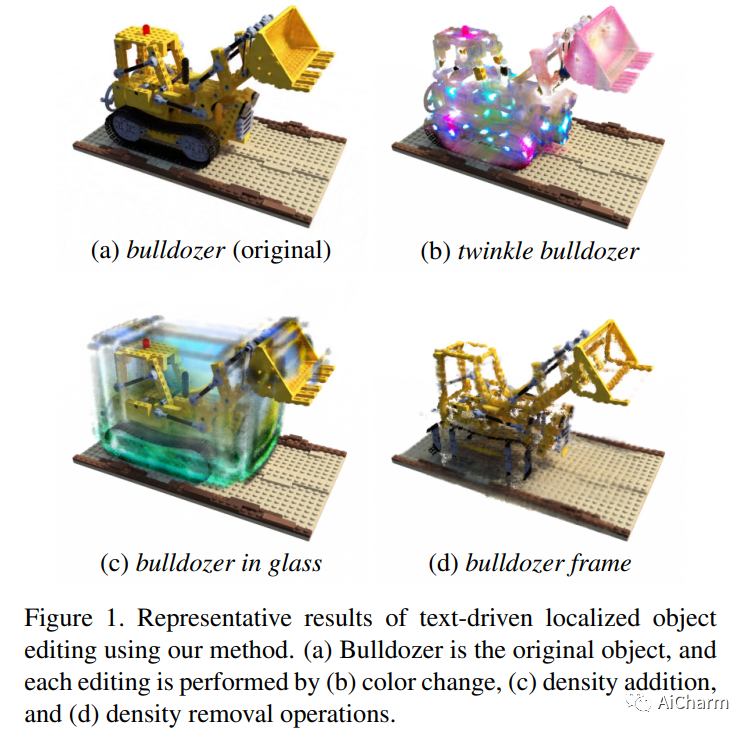

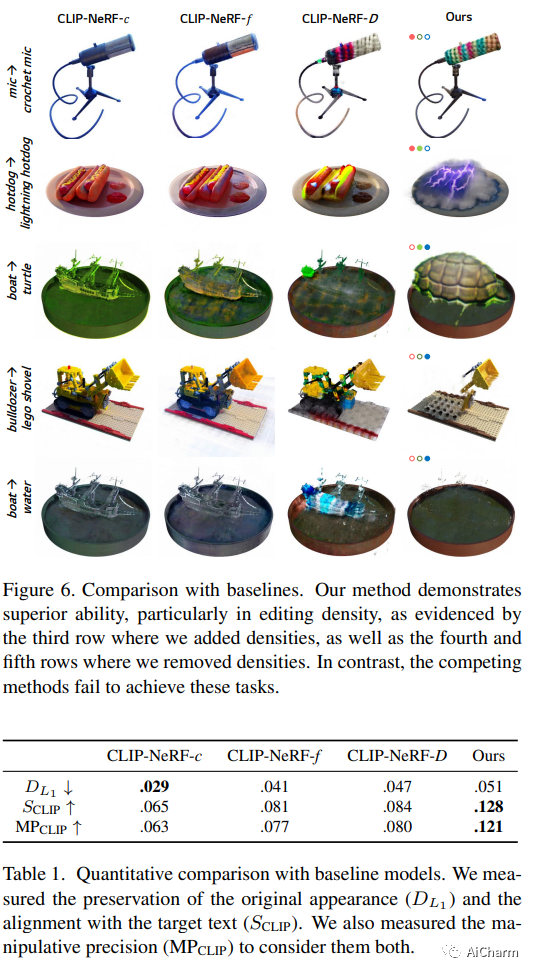

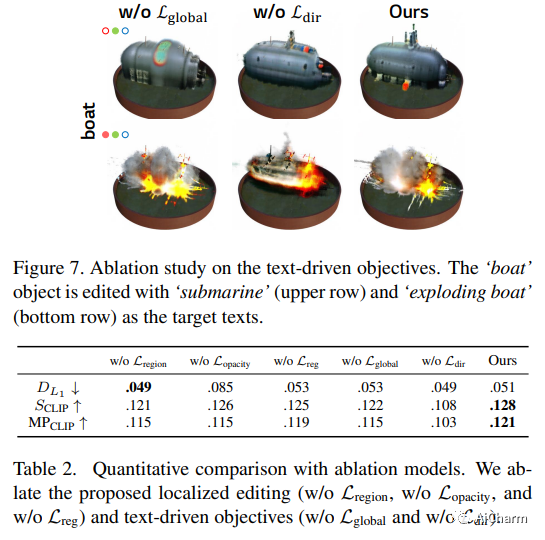

3.Blending-NeRF: Text-Driven Localized Editing in Neural Radiance Fields(ICCV 2023)

标题:Blending-NeRF:神经辐射场中文本驱动的本地化编辑

作者:Hyeonseop Song, Seokhun Choi, Hoseok Do, Chul Lee, Taehyeong Kim

文章链接:https://arxiv.org/abs/2308.11974

摘要:

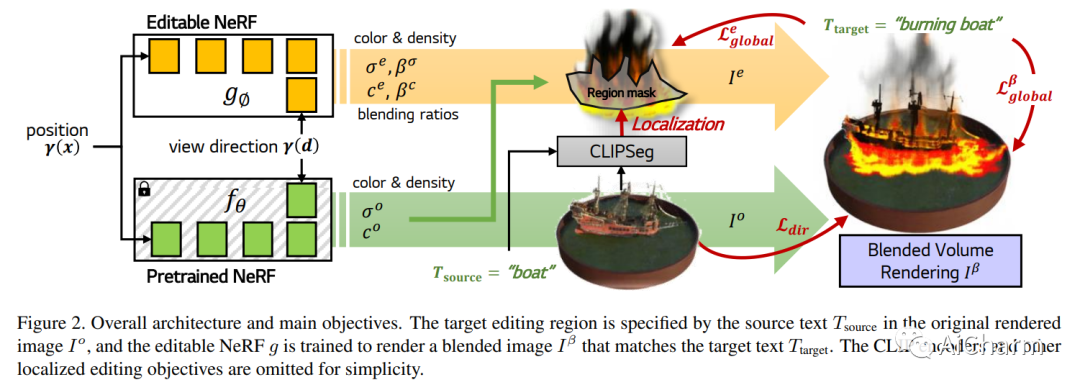

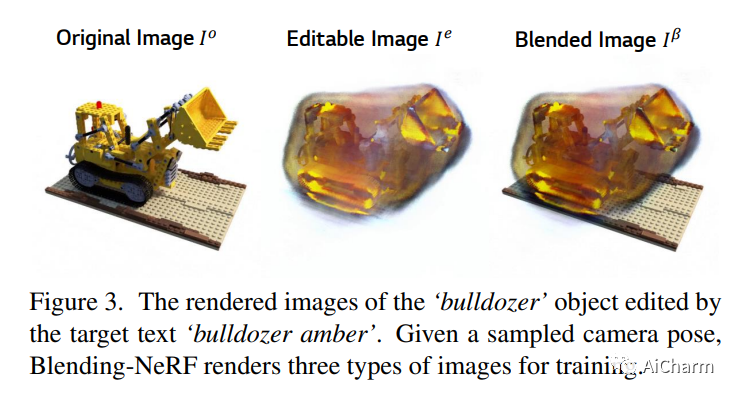

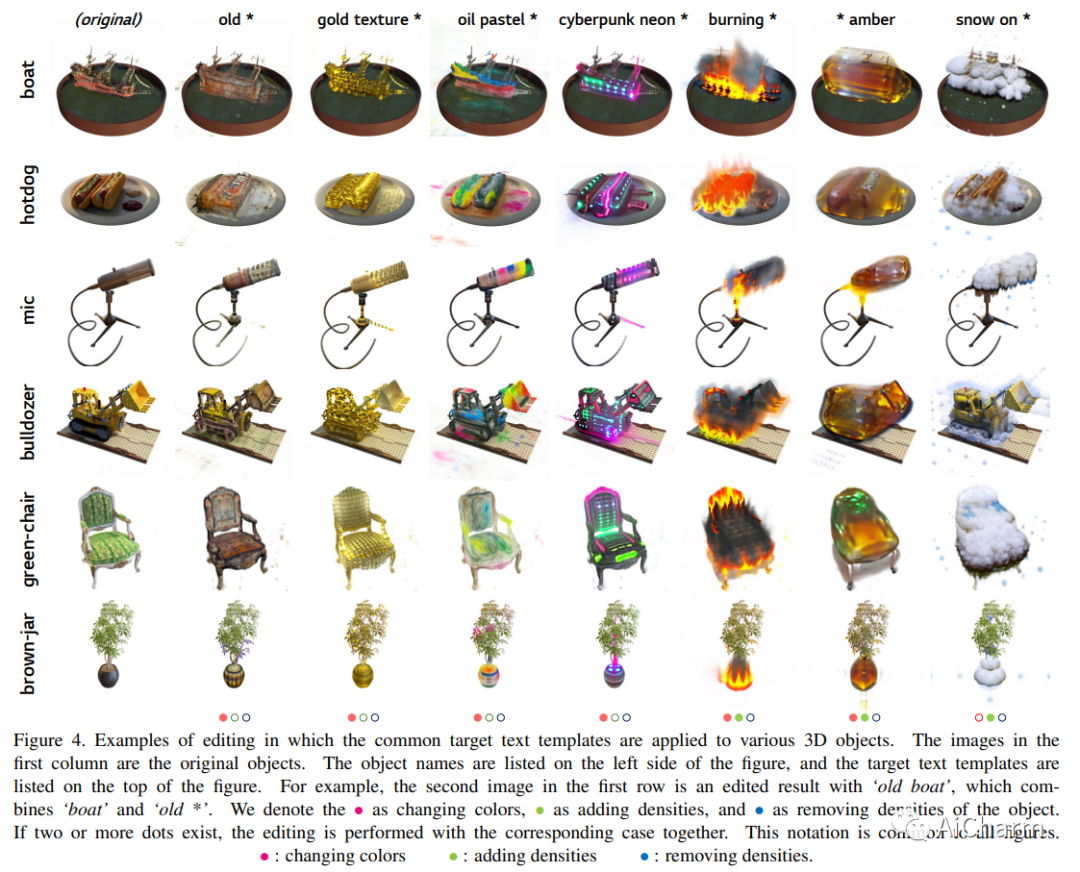

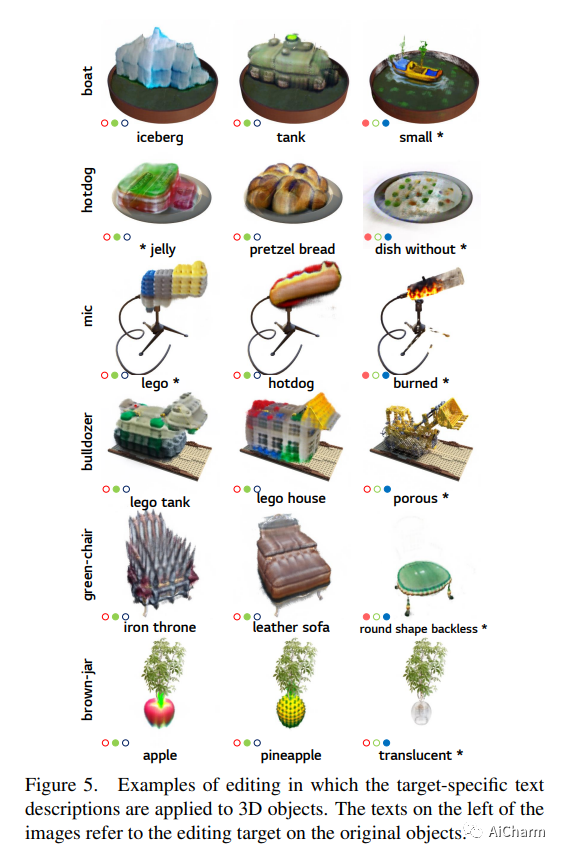

文本驱动的 3D 对象本地化编辑特别困难,因为在不扭曲对象形式的情况下将原始 3D 对象与预期的新对象和样式效果进行本地混合并不是一个简单的过程。为了解决这个问题,我们提出了一种新的基于 NeRF 的模型 Blending-NeRF,它由两个 NeRF 网络组成:预训练的 NeRF 和可编辑的 NeRF。此外,我们引入了新的混合操作,使 Blending-NeRF 能够正确编辑由文本本地化的目标区域。通过使用预训练的视觉语言对齐模型 CLIP,我们指导 Blending-NeRF 添加具有不同颜色和密度的新对象、修改纹理并删除原始对象的部分内容。我们广泛的实验表明,Blending-NeRF 可根据各种文本提示生成自然且本地编辑的 3D 对象。

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2023-08-25,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读