更新深度学习装备:双(1080Ti)显卡装机实录

前言

之前一直在装有一张1080Ti的服务器上跑代码,但是当数据量超过10W(图像数据集)的时候,训练时就稍微有点吃力了。速度慢是一方面,关键显存存在瓶颈,导致每次训练的batch-size不敢调的过高(batch-size与训练结果存在一定的关系),对训练结果的影响还是比较大的。

在深度学习的时代,谁掌握算力谁便领先一步,因此有必要提升自己的计算能力。

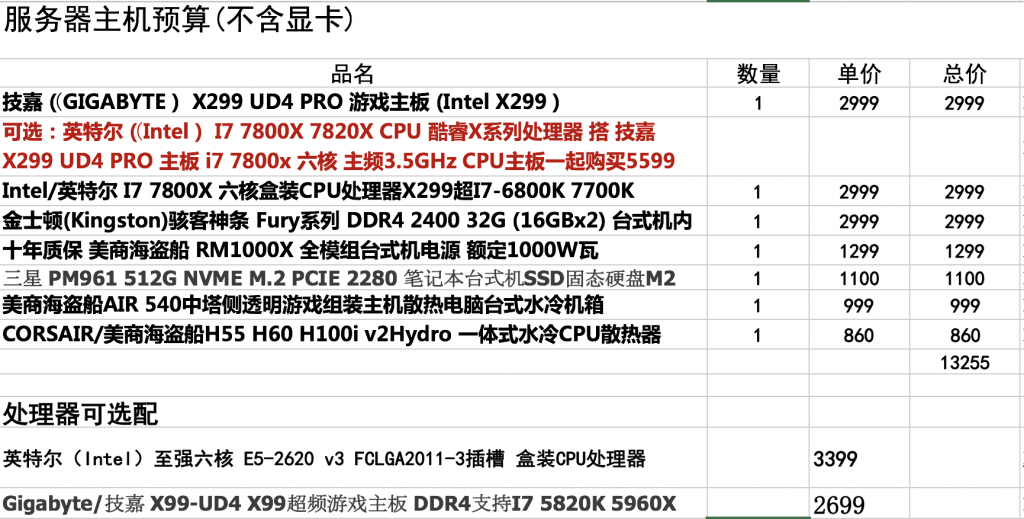

这是我目前使用的服务器的配置清单,主板理论可以插4张GPU,但是由于CPU的原因,插上两张显卡时功效最大。

对配置有疑惑的童鞋可以查看这篇:给你一份配置清单:机器学习、深度学习电脑显卡配置指南。

正文

首先,这是之前的主机,CPU为7800X,主板为X299,CPU水冷其余风冷,插着一张微星1080TI显卡。

欲加上的显卡为索泰1080TI OC 至尊系列,与之前的微信显卡组成双显卡阵列,如果你要问我为什么买这张显卡:

- 学校的供货渠道目前只有两种牌子(七彩虹和索泰),但是七彩虹的那款尺寸有点不合适,故不选择

- 虽然现在都换成了RTX 2080,但是由于2080还不是很稳定,1080ti与最新系列差距并不是很大,所以还是选择1080ti

- 之前那一张是1080Ti,当然选择搭配的最好也是1080Ti,可以分布式训练(显卡牌子型号可以不同)

来看看这款索泰的配置吧:

可以看到,之前这张显卡插得位置有点不好,太靠中间,因此需要将这一张先拔下来,换个位置,两张就都可以插上了(公版散热的显卡比非公版散热卡普遍会瘦一圈,因此多卡最好都是公版散热的同一类,但如果达不到要求也可以妥协)。

看看这张索泰的显卡(正面)。

以及背面(装了两个小风扇,但是最后还是拆了,因为会吹风到另一张显卡上…)

这样调换位置后,两张显卡就可以完美地插上了,两张都是8pin+6pin,使用的电源是海盗船RM1000X,理论上是足够了,具体待测。

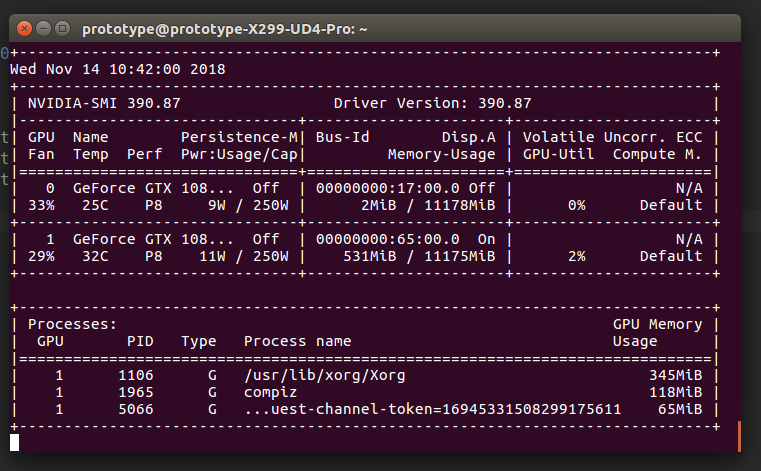

因为在使用之前那张显卡时已经装上了Linux的Nvidia驱动,插两张卡没必要使用之前的驱动即可,显示器还是插之前的那张卡就好。

一次性点亮~

可以看到Linux系统中已经检测到了两张显卡。

总结

装上新卡之后简单测试了一下,两张卡是可以同时进行同一个任务的,速度也会有提升,但具体的需要慢慢来体会了。

其实,有几点需要注意:

- 我使用的CPU是7800X,PCIE通道数为28,理论上两张显卡的分配数是8-PCIE+16-PCIE,但是实际上8+8速度也是可以的,速度个人感觉并没有差太多,需要之后详细评测一下

- 因为一张公版一张非公,散热性能相比两张公版不知道会如何,需要测试

- 两张显卡功率各250W,而CPU最高应该200W左右,额定1000W的电源按理说应该是够用的,到底是不是这样,也需要进行测试

总之,双卡装起来还是比较容易的,只要提前对机箱的尺寸和布局有了解,选择好合适的显卡就可以进行安装了,另外,显卡还是比较耐操的,不要因为一些其他原因点不亮而担心显卡会烧毁。

相关话题:

2080 Ti TensorFlow GPU基准测试 – 2080 Ti vs V100 vs 1080 Ti vs Titan V