神经网络架构:最新进展和未来挑战

神经网络架构:最新进展和未来挑战

文章目录

- 1. 神经网络架构的演化历程

- 1.1 感知机(Perceptron)

- 1.2 多层感知机(Multi-layer Perceptron,MLP)

- 1.3 卷积神经网络(Convolutional Neural Network,CNN)

- 1.4 循环神经网络(Recurrent Neural Network,RNN)

- 1.5 长短时记忆网络(Long Short-Term Memory,LSTM)

- 1.6 注意力机制和Transformer

- 2. 最新进展和应用领域

- 2.1 图神经网络(Graph Neural Networks,GNN)

- 2.2 强化学习与深度强化学习

- 2.3 自动生成模型(AutoML)

- 3. 未来挑战与发展方向

- 3.1 模型效率与推理速度

- 3.2 泛化能力和数据效率

- 3.3 可解释性和可靠性

- 4. 示例代码:基于PyTorch的卷积神经网络

- 5. 结论

🎉欢迎来到AIGC人工智能专栏~神经网络架构:最新进展和未来挑战

- ☆* o(≧▽≦)o *☆嗨~我是IT·陈寒🍹

- ✨博客主页:IT·陈寒的博客

- 🎈该系列文章专栏:AIGC人工智能

- 📜其他专栏:Java学习路线 Java面试技巧 Java实战项目 AIGC人工智能 数据结构学习

- 🍹文章作者技术和水平有限,如果文中出现错误,希望大家能指正🙏

- 📜 欢迎大家关注! ❤️

神经网络作为深度学习的核心组件,一直以来都在不断演化和发展。从最早的感知机到如今的复杂卷积神经网络和Transformer模型,神经网络架构的进展不仅在计算机视觉、自然语言处理等领域取得了显著成果,也在推动人工智能技术向前迈进。本文将探讨神经网络架构的最新进展、应用领域以及未来面临的挑战。

1. 神经网络架构的演化历程

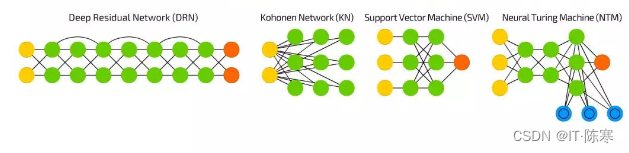

神经网络的发展经历了多个阶段,每个阶段都在特定的问题上取得了突破性进展。以下是一些重要的神经网络架构及其代表性成果:

1.1 感知机(Perceptron)

感知机是神经网络的鼻祖,由Frank Rosenblatt于1957年提出。它是一个单层的前馈神经网络,被用来解决二分类问题。然而,感知机无法解决非线性问题,限制了其应用范围。

1.2 多层感知机(Multi-layer Perceptron,MLP)

多层感知机通过引入隐藏层解决了非线性问题,为神经网络的发展开辟了新的方向。然而,早期的MLP存在梯度消失和过拟合等问题,限制了其在深度学习中的应用。

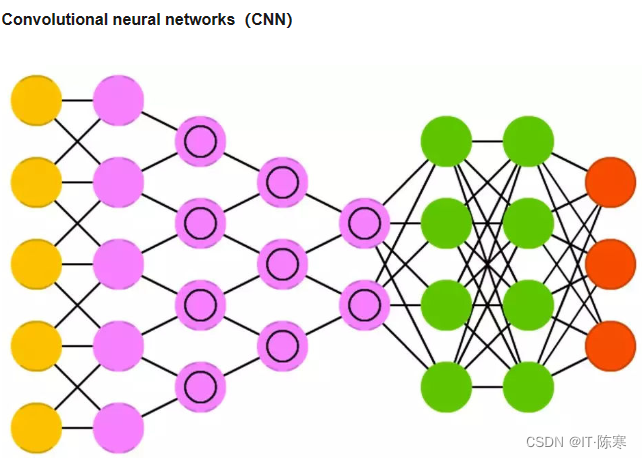

1.3 卷积神经网络(Convolutional Neural Network,CNN)

卷积神经网络是专门用于处理图像数据的一类神经网络架构。由于其卓越的特征提取能力和参数共享机制,CNN在计算机视觉领域取得了巨大成功,如AlexNet、VGG、ResNet等模型。

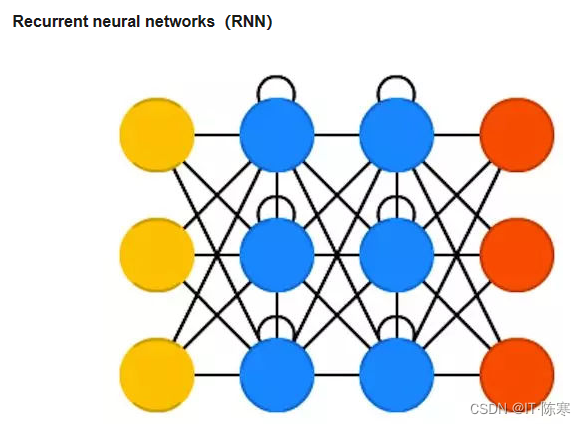

1.4 循环神经网络(Recurrent Neural Network,RNN)

循环神经网络在处理序列数据方面表现出色,如文本生成、语音识别等。然而,传统RNN存在梯度消失和信息衰减的问题,限制了其在长序列上的表现。

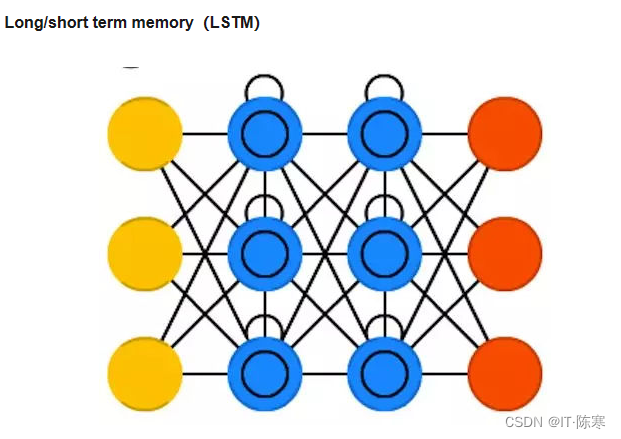

1.5 长短时记忆网络(Long Short-Term Memory,LSTM)

LSTM是一种特殊的RNN,通过引入记忆单元和门控机制,有效解决了传统RNN的短期记忆问题,适用于处理长序列数据。

1.6 注意力机制和Transformer

注意力机制在自然语言处理领域引起了革命性的变革,Transformer模型以其出色的表现引领了自然语言处理的发展潮流,如BERT、GPT等。

2. 最新进展和应用领域

近年来,神经网络架构在各个领域都取得了突破性进展,以下是一些最新的进展和应用:

2.1 图神经网络(Graph Neural Networks,GNN)

图神经网络用于处理图数据,如社交网络、分子结构等。GNN结合了节点和边的信息,具有出色的图数据表征能力,被广泛应用于社交推荐、分子设计等领域。

2.2 强化学习与深度强化学习

强化学习结合了深度学习和决策优化,在游戏、机器人控制等领域取得了重大突破。AlphaGo和OpenAI的Dota 2 AI就是典型的应用。

2.3 自动生成模型(AutoML)

自动生成模型通过自动搜索和优化网络架构,加速了模型的设计和调优过程。AutoML的典型应用包括AutoML-Zero和NASNet。

3. 未来挑战与发展方向

尽管神经网络架构取得了许多令人瞩目的成果,但仍然面临一些挑战和问题:

3.1 模型效率与推理速度

深度学习模型通常具有大量的参数,导致模型庞大且需要高计算资源。未来的发展需要关注模型轻量化和高效推理的技术,以适应移动设备和嵌入式系统。

3.2 泛化能力和数据效率

神经网络在小样本学习和领域迁移方面仍然存在挑战,如何提高模型的泛化能力和数据效率是一个重要问题。

3.3 可解释性和可靠性

深度学习模型的黑盒性质限制了其在某些应用领域的应用,如医疗和金融。未来需要研究如何提高模型的可解释性和可靠性,以满足实际需求。

4. 示例代码:基于PyTorch的卷积神经网络

下面是一个基于PyTorch的简单卷积神经网络示例,用于图像分类任务:

import torch

import torch.nn as nn

class CNN(nn.Module):

def __init__(self):

super(CNN, self).__init__()

self.conv1 = nn.Conv2d(in_channels=3, out_channels=16, kernel_size=3, stride=1, padding=1)

self.relu = nn.ReLU()

self.pool = nn.MaxPool2d(kernel_size=2, stride=2)

self.fc1 = nn.Linear(16 * 16 * 16, 10) # 假设输入图像尺寸为32x32

def forward(self, x):

x = self.conv1(x)

x = self.relu(x)

x = self.pool(x)

x = x.view(-1, 16 * 16 * 16)

x = self.fc1(x)

return x

# 实例化模型

model = CNN()

# 定义损失函数和优化器

criterion = nn.CrossEntropyLoss()

optimizer = torch.optim.Adam(model.parameters(), lr=0.001)

# 训练模型

for epoch in range(10):

for inputs, labels in train_loader:

optimizer.zero_grad()

outputs = model(inputs)

loss = criterion(outputs, labels)

loss.backward()

optimizer.step()5. 结论

神经网络架构作为深度学习的核心,不断在各个领域取得新的突破。从最早的感知机到如今的Transformer模型,每一个新的架构都为人工智能技术的发展带来了新的可能性。然而,未来仍然需要解决模型效率、泛化能力、可解释性等方面的挑战,以实现更广泛的应用和更深远的影响。深入研究神经网络架构,探索其更多潜力,将有助于推动人工智能技术向前迈进。

🧸结尾