为AI配备目标;强化学习是最低的智能行为,昆虫和哺乳动物在第几层?

为AI配备目标;强化学习是最低的智能行为,昆虫和哺乳动物在第几层?

摘要

理论生物学的最新进展表明,基础认知和感知行为是体外细胞培养和神经元网络的自然属性,respectively.这种神经元网络在大脑中自发地学习结构化行为在没有奖励或加强情况下。在这篇文章中,我们通过自由能原理的透镜来描述这种self-organisation,即不证自明的。我们要做到这一点,首先要基于主动推理的设置,definitions of reactive and sentient behaviour,模拟他们的行动的consequences。然后我们引入了一种对有意行为的正式解释,它将代理描述为由潜在状态空间中的首选端点或目标驱动。然后,我们研究这些形式的(反应性的、有感觉的和有意的(reactive, sentient, and intentional)行为模拟。首先,我们模拟上述体外实验,其中神经元培养通过实现嵌套的、自由能的最小化过程,自发地学习玩乒乓。然后模拟被用来解构随之而来的预测行为——区分仅仅是反应性的、有感觉的和有意的行为,后者以归纳计划的形式出现。这使用简单的机器学习基准进一步研究区别(导航一个网格世界和汉诺塔问题),这显示了如何快速有效地适应性行为是在主动推理的归纳形式下出现的。

关键词:主动推理;主动学习;逆向归纳;作为推论的计划;自由能原理。

1 简介

2022 年,发表了一篇论文,声称证明了在培养皿中生长的神经元培养物(体外神经元网络)中的感知行为[1]。

所讨论的行为是球拍击球时自发出现的受控运动,从而打乒乓球。这项研究有几个灵感来源,涉及基础认知的概念;参见,例如, [2‑4] (以及相关工作,例如[5])。特别是,适应性和预测行为会自发出现的假设是基于早期的研究,该研究表明体外神经元培养可以被描述为最小化变分自由能[6] ,从而表现出主动推理和学习。自由能原理(FEP)在神经元培养中的应用随后得到了经验验证[7]:从某种意义上说,神经元活动和突触功效的变化(支持学习)可以作为变分自由能最小化过程进行定量预测。那么,这些发现是否引人注目,或者是可以预见的?

从某种意义上说,这些结果是完全可以预见的。事实上,它们是可以从 FEP 中预测到的,FEP 指出,任何两个以某种稀疏方式耦合的网络都会表现出广义的同步性[8, 9]。更正式地说,FEP 指出,如果支持耦合随机动力系统的概率密度包含马尔可夫毯子(在给定毯子(感觉和活动)状态的情况下,该毯子将内部状态与外部状态屏蔽开来),那么内部状态看起来就像是跟踪外部状态的统计数据,或者更准确地说,就好像它们对覆盖范围之外的变分密度(或最佳猜测)外部状态的参数进行编码。根据经验,当神经元培养物学会打乒乓球时,就观察到了这种同步性。然而,FEP 更进一步指出,任一网络的内部状态和活动状态(统称为自治状态)都可以描述为最小化变分自由能泛函。该函数与统计和机器学习中用于优化生成模型的函数完全相同[10]。根据这一解读,人们可以将网络、粒子或人的自治状态解释为最小化变分自由能或意外或惊奇 surprise(又名,自信息),或者等效地,最大化贝叶斯模型证据(又名,感觉状态边际可能性)。这导致了一种隐含的目的论,从某种意义上说,人们可以用不证自明的方式来描述自组织[11] ,它需要主动推理和学习、计划、目的、意图,也许还有感知。潜在的自由能最小化过程及其目的论解释是本文的重点。

由于不同的原因,一些人认为[1]中报告的结果并不引人注目:学习玩像 Pong 这样的(Atari)游戏是多年前通过机器学习系统使用神经网络和(深度)强化学习完成的事情[ 12、13 ]。那么,神经元网络复制相同类型的行为有什么值得注意的地方呢?这是值得注意的,因为人们无法使用强化学习(RL)范式来解释体外观察到的不证自明行为的出现。这是因为人们无法奖励神经元网络,因为没有人知道任何给定的体外神经元网络会发现什么奖励。然而,FEP 理论家确切地知道不证自明的网络会厌恶什么;即,意外和不可预测。这是向细胞培养物的感觉电极传递不可预测的噪声的基本原理(或以不可预测的方式重新开始游戏),每当神经网络未能击球时[1]。

一些人发现[1]中报告的结果很显着,但不是很好:他们不同意这种行为可以被描述为“有感知”的说法[14]。在这里,我们希望从贝叶斯信念更新的角度理解感知行为的概念;其中“感知行为”表示对感官扰动产生适当反应的能力(而不是仅仅反应行为)。我们追寻上述细胞培养实验建立的叙述,以说明为什么打乒乓球的行为被认为是有感知的,而不是反应性的。简而言之,我们根据生成模型的预测来考虑行动之间的明确界限,该模型会产生或不会产生行动的后果。

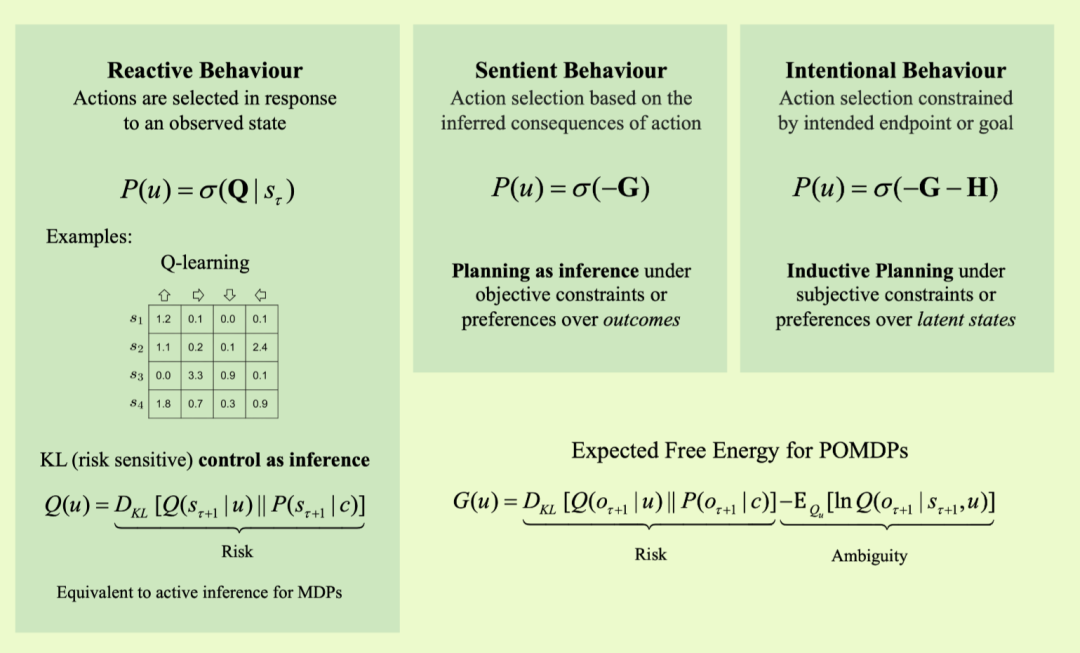

具体来说,本文区分了三种行为:反应性行为、感知性行为和意向性行为 reactive, sentient, and intentional。前两者的公式已在文献中分别在无模型强化学习(RL)和主动推理的框架下进行了广泛研究。在无模型强化学习中,系统使用查找表(Q 学习)或神经网络(深度 Q 学习)来选择操作。在标准主动推理中,行动选择取决于策略的预期自由能(方程 2),其中预期是对未来成为随机变量的观察结果的预期。这意味着期望结果(涉及预期成本和风险)是限制隐式计划作为推论的先验信念[15‑17]。因此,表现出这种行为的事物可以被描述为基于这些行为的后果的生成模型来规划它们的行为[15,16,18 ] 。正是在这种意义上,细胞培养物的行为被认为是有感知的。

这种形式的感知行为 用贝叶斯力学[19‑21]描述, 可以通过预期的端点或目标来增强。这导致了一种新颖的感知行为,它不仅可以预测其行为的后果,而且还能够选择它们以达到未来可能需要许多步骤的目标状态。这种行为,我们称之为有意行为,通常需要某种形式的向后归纳[22, 23] ,类似于动态规划[24‑27]中的那种:即从预期的目标状态开始,向后进行,归纳当前的事态,以便计划向目标状态迈进。向后归纳被应用于部分可观察的环境,并在[27]中的主动推理的背景下进行了探索。在这项工作中,动态规划被证明在主动推理方面比传统规划方法更有效。

这项工作的重点是正式定义一个有意行为的框架,其中代理最小化预期自由能的约束形式,并在计算机中演示该框架。这些约束是在代表智能体预期目标的潜在状态子集上定义的,并通过后向归纳的形式传播到智能体。因此,不允许智能体朝着预期目标之一取得任何“进展”的状态会受到惩罚,导致这种不利状态的行为也会受到惩罚。这导致了感知行为和意向行为之间的区别,因为意向行为配备了归纳约束。

在这种处理中,归纳inductive一词有多种含义。首先,区分归纳规划和应用程序中通常出现的溯因abductive推理贝叶斯力学;即,区分单纯的最佳解释推理(溯因推理)和真正的目标导向推理(归纳规划) [28, 29]。其次,它与动态规划中的向后归纳相结合,即从预期的终点开始,及时向后推算到当前,以决定下一步做什么[ 24,25,27,30 ] 。在这种行为自然化的情况下,恒温器不会表现出有感知的行为,但昆虫可能会表现出(即恒温器仅表现出反应性行为)。同样,昆虫不会表现出有意的行为,但哺乳动物可能会表现出(即昆虫仅表现出有感知的行为)。下面的数值分析表明,体外神经元培养物可能表现出有感知的行为,但不是有意的行为。至关重要的是,我们表明强化学习无法解释有感知的行为和有意的行为。在这项工作的实验部分中,我们研究并比较了有或没有预期目标状态的主动推理代理的性能。

为了便于参考,我们将没有目标状态的主动推理智能体称为溯因智能体,将具有预期目标的智能体称为归纳智能体。

本文包括四个部分。第一个简短地演练了主动推理和学习 作为一组嵌套的自由能最小化过程应用于与某个世界或环境交换的通用生成模型。该模型是部分观察到的马尔可夫决策过程,与机器学习中的规范神经网络相协调,并且易于描述体外神经网络的不证自明[6, 7]。本节特别关注归纳规划及其与预期自由能的关系。随后的部分使用数值研究来提出一系列要点。第二部分再现了体外神经元网络打乒乓球的经验行为。至关重要的是,这种行为纯粹是从朴素的神经元网络开始的自由能最小化过程中出现的。本节说明了当游戏变得更加困难时(模拟的)abductive主体的失败。这种失败被用来说明归纳计划的作用,它可以恢复性能并保证与感觉中枢的流畅接触。最后两节分别说明了使用迷宫导航和汉诺塔问题的归纳规划。这些数值研究说明了如何将归纳约束简单应用于主动推理,从而有效地解决在离散状态空间中难以处理的任务。这种效率取决于这样一个事实:由于归纳规划提供的约束,只需规划未来的几个步骤就可以实现远端目标。归纳规划通过识别blind alleys或死胡同有效地减轻了深度树搜索的压力。

1.1 定义术语

在介绍归纳规划算法之前,我们通过澄清一些关键术语的使用来构建我们的处理方法。这个框架很重要,因为当前工作的目标不仅仅是描述有效推理的有用启发式(即归纳规划),而是提供一种新的决策形式如何实现更复杂的agent形式的说明,可以折叠成通用贝叶斯(主动)推理方案

图1描述了日益复杂的行为形式 从反应性(仅仅重新响应刺激)、感知(基于感官序列进行计划)、有意(为了实现预期状态而进行计划) 以及可能支持此类行为的相应决策形式。

反应行为 的特征是简单的感觉运动反射弧和设定点或轨迹的单纯实现(例如,稳态和稳态的简单情况)。这种行为形式可以解释为以实现预测感觉的方式行动,而不预期行动的未来感官后果。

感知行为 表征了主动推理的典型案例,其中对感知的影响是由计划结果调节的,其政策分布源自具有反事实深度的模型(即对行动的未来感官后果的信念)根据政)。在这种情况下,我们可以将针对行动或政策的推断形式描述为溯因,即,对生成模型下最能解释当前和未来观察结果的政策进行推断(见下文)。

有意行为 不仅是由最小化当前和未来的感官预测误差的一般要求驱动的,而是为了实现特定的未来终点或目标状态。这种形式的行为可以通过后向归纳或归纳规划来促进,如下所定义,它为(纯粹)感知行为的贝叶斯(溯因)推理特征提供了一种特定形式的约束。特别是,它不仅意味着对行为的感官后果的信念,而且还意味着对感官输入的推断或潜在原因的信念。

请注意,这里故意定义了“感知行为”和“意向行为”等词语,以便它们可以在生成模型的框架内进行操作,其中“状态”、“信念”和“信心”等术语具有精确的含义 terms like ‘state’, ‘belief’, and ‘confidence’ have precise 。如果狭隘的话,是用数学排序的信念结构来解释的[31]。 (命题或主观)信念或感知的现象学是否可以产生相同的自然化仍有待观察:有关这个方向的治疗,请参阅[32‑34] 。进一步注意,感知行为和意向行为之间的关键区别分别取决于(可观察的)结果和(不可观察的)潜在空间中的行为后果。

2 主动推理

。。。