CVPR2023 | PVDM:在投影潜在空间中的视频概率扩散模型

CVPR2023 | PVDM:在投影潜在空间中的视频概率扩散模型

题目: Video Probabilistic Diffusion Models in Projected Latent Space 作者: Sihyun Yu, Kihyuk Sohn, Subin Kim, Jinwoo Shin 论文地址: https://ieeexplore.ieee.org/abstract/document/10203977 来源:CVPR 2023 内容整理:周楚骎 尽管深度生成模型取得了显著进展,但由于其高维性和复杂的时间动态以及较大的空间变化,合成高分辨率和时间上连贯的视频仍然是一个挑战。最近关于扩散模型的工作已经显示出它们解决这一挑战的潜力,但它们仍存在严重的计算和内存效率低下的问题,限制了其可扩展性。为了解决这个问题,本文提出了一种新的视频生成模型,即投影潜在视频扩散模型(PVDM),这是一种概率扩散模型,它可以在低维潜在空间中学习视频分布,从而可以在有限的资源下用高分辨率视频进行高效训练。具体来说,PVDM由两个组件组成:(a)一个自动编码器,它将给定的视频投影为2D形状的潜在向量,该向量分解视频像素的复杂立方结构,以及(b)扩散模型架构,专门用于本文设计的新的分解潜在空间和训练/采样程序,以使用单个模型合成任意长度的视频。

简介

深度生成模型的最新进展表明,它们有望在各个领域合成高质量、逼真的样本,例如图像、音频、3D 场景 、自然语言等。作为下一步,一些作品已经积极关注更具挑战性的视频合成任务。与其他领域的成功相比,由于视频的高维性和复杂性,在高分辨率帧中包含复杂的时空动态,因此生成质量与真实世界的视频相去甚远。

受扩散模型在处理复杂和大规模图像数据集方面的成功的启发,最近的方法试图为视频设计扩散模型。与图像域类似,这些方法显示出巨大的潜力,可以更好地模拟视频分布,并具有可扩展性(在空间分辨率和时间持续时间方面),甚至实现逼真的生成结果。然而,它们存在严重的计算和内存效率低下的问题,因为扩散模型需要在输入空间中进行大量迭代过程才能合成样本。

同时,最近在图像生成方面的工作提出了潜在扩散模型,以规避扩散模型的计算和记忆效率低下。潜在扩散模型不是在原始像素中训练模型,而是首先训练自动编码器来学习低维潜在空间,简洁地参数化图像,然后对这种潜在分布进行建模。有趣的是,该方法在合成样本的效率方面得到了显著提高,甚至达到了最先进的生成结果。然而,尽管它们具有吸引人的潜力,但开发一种用于视频的潜在扩散模型形式仍被忽视。

基于以上动机,本文提出了一种新的视频潜在扩散模型,即投影潜在视频扩散模型(PVDM)。具体来说,它是一个两阶段框架:

- 自动编码器:本文引入了一个自动编码器,通过分解视频的复杂三次数组结构,用三个类似 2D 图像的潜在向量来表示视频。具体来说,本文提出了视频在每个时空方向的 3D → 2D 投影,以将 3D 视频像素编码为三个简洁的 2D 潜在向量。本文设计了一个跨时间方向的潜在向量来参数化视频的常见内容(例如,背景),后两个向量来编码视频的运动。这些 2D 潜在向量有利于实现高质量和简洁的视频编码,并且由于其类似图像的结构而能够实现高计算效率的扩散模型架构设计。

- 扩散模型:基于本文视频自动编码器生成的类似图像的 2D 潜在空间,本文设计了一种新的扩散模型架构来模拟视频分布。由于本文将视频参数化为类似图像的潜在表示,因此避免了通常用于处理视频的计算量大的 3D 卷积神经网络架构。相反,本文的架构基于2D卷积网络扩散模型架构,该架构在处理图像方面显示出其优势。此外,本文还提出了无条件和帧条件生成建模的联合训练,以生成任意长度的长视频。

方法

考虑一个大小为 N的数据集

,其中每个

都是从未知数据分布

中采样的。每个

都是一个由

分辨率的 S 帧组成视频片段。在视频生成建模中,目标是从

中学习与

匹配的模型分布

,然后利用

实现无条件视频生成。为了实现这个目标,本文构建了一种基于扩散模型的方法,这是一种生成模型,通过学习马尔可夫扩散过程从

开始到高斯先验分布

。

自编码器

从为了将视频片段

表示为低维潜在向量

,本文训练一个自动编码器,该自动编码器由编码器

组成,和解码器

。本文受VQGAN的激励,通过潜在空间对图像进行感知压缩。

图 1 autoencoder

给定视频片段

,首先通过编码器得到3D潜在编码

,这个

,其中的

为潜在空间的维度,然后将3D潜在编码

通过合并和映射等操作,得到想要的2D潜在编码

,其中

。具体来说,将

在三个方向上进行合并操作,并输入以Transformer构建的网络中,映射为三个2D的潜在编码。因注意到

用于捕获

中跨时间的常见内容(例如,背景),后两个潜在向量

通过学习视频两个空间轴上的潜在表示来编码

中的运动。使用

,从视频片段

得到2D类似图像的潜在向量

后,本文构造了解码器

,该解码器首先从

计算3D的潜在编码

,再从

重建

。

本文使用视频Transformer(即TimeSformer)作为视频自编码器,并用Transformer设计了一个四层的3D-to-2D映射器。而用于自动编码器的训练目标,由编码器

和解码器

组成。本文使用VQGAN和TATS中使用的类似目标函数

,但不使用向量量化正则化:

潜在扩散模型

本文将视频片段

编码为三个 2D 潜在向量

;接下来需要对分布

进行建模以学习

。为了训练

的去噪自动编码器,本文设计了基于利用流行的2D卷积U-Net架构,即DDPM,来训练扩散模型以生成图像而不是3D卷积网络的神经网络架构,如Google的Video diffusion models。具体来说,本文使用单个 U-Net(即共享参数)来对每个

进行降噪。为了处理

之间的依赖关系来模拟联合分布

,本文添加了注意力层,该注意力层对来自共享 U-Net 的

的中间特征进行操作。本文注意到,这种 2D 卷积架构设计比用于视频的朴素 3D 卷积 U-Net 的计算效率更高,因为使用较少的潜在代码对视频进行编码,因此具有类似图像的结构和潜在向量的维度降低。

图 2 diffusion

生成更长的视频

请注意,视频是顺序数据;与上文的设置不同,假设所有视频

具有相同的帧数

,真实世界视频的长度各不相同,生成视频模型应该能够生成任意长度的视频。但是,模型只了解固定长度视频片段

的分布;为了实现长视频生成,可以考虑学习

的两个连续视频片段

的条件分布

,并依次生成给定当前剪辑的未来剪辑。一个简单的解决方案是使用两个独立的模型来学习无条件分布

和条件分布

。本文选择训练一个单一的扩散模型来联合学习无条件分布

和条件分布

,而不是使用额外的模型。这可以通过训练条件扩散模型

来实现,并引入一个零帧(即

)来联合学习

。更具体地说,本文考虑在潜在空间中训练去噪自动编码器

,其中

表征噪声强度,其目标如下:

其中

,而

是一个超参数,用于平衡无条件分布和条件分布之间的学习。

实验

本文在两个具有代表性的数据集下验证了PVDM框架的优越性:UCF-101和SkyTimelapse。按照最近视频生成方法中使用的实验设置,本文将这些数据集预处理为长度为16或128帧的视频片段,其中每帧的大小调整为256×256分辨率。对于定量比较的评估指标,本文使用了Inception Score(IS)和Fréchet video distance(FVD)。本文使用16帧的剪辑长度来评估IS,遵循先前在无条件视频生成中的实验设置。为了让 FVD 评估 UCF101 和 SkyTimelapse,本文使用了 StyleGAN-V 提出的固定协议,该协议消除了数据集中长视频存在的潜在偏差。本文考虑了 FVD 的两种不同的剪辑长度(16 帧和 128帧),其中本文将 FVD

和 FVD

分别表示为在长度为 16 和 128 的视频剪辑上测量的 FVD 分数。本文使用 2,048 个真实/虚假视频剪辑来评估 FVD

和 FVD

,并生成 10,000 个视频片段用于评估 IS。

定性结果

下图说明了 UCF-101 和 SkyTimelapse 上 PVDM 的视频合成结果:本文的方法显示了两种情况下的真实视频生成结果,即包括小物体的运动(图 a)或帧的大过渡(图 b)。此外,本文的方法还能够在复杂的UCF-101数据集中以合理的质量合成视频,如图a所示,而其他基线在这种具有挑战性的数据集数据集上经常失败。

图 3 定性结果

定量结果

图4 中的表 1 和表 2 总结了本文的方法与先前视频生成方法之间的定量比较:PVDM 始终优于使用不同指标测量的其他方法。特别是,与VDM相比,VDM在视频像素上训练扩散模型,即使VDM使用的数据(使用训练+测试拆分)比本问的设置(仅使用训练拆分)更多,本文的方法也显示出更好的IS。有趣的是,本文的方法显示出一个值得注意的对 UCF 的改进,UCF 是一个复杂的多类数据集,它显示了本文的方法对复杂视频分布进行建模的潜力。本文的方法在128帧视频中也取得了最先进的结果,这证明了本文的方法在生成更长视频方面的有效性。

图 4 定量结果

重建质量

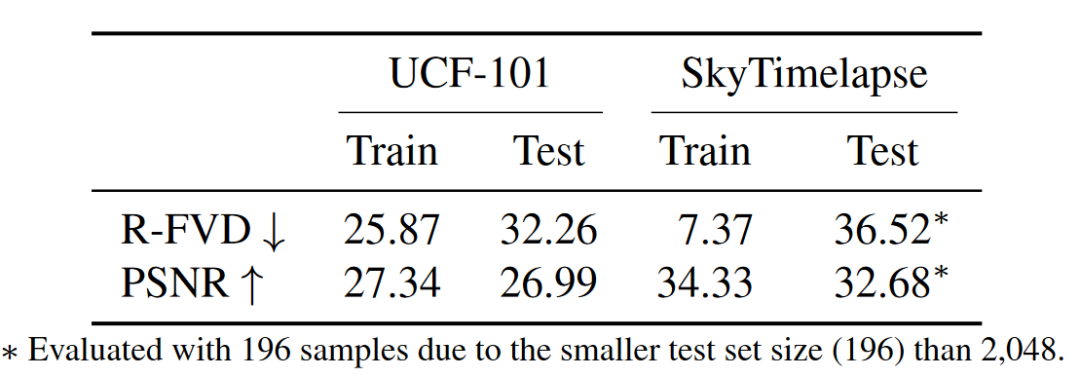

本文考虑以下指标来衡量自动编码器指标:用于重建质量的峰值信噪比 (PSNR) 和用于感知相似性的 R-FVD。在这里,R-FVD 表示重建和真实视频之间的 FVD。本文的方法包括显示类似于地面实况视频的准确重建。特别是,本文的方法显示了足够小的R-FVD,这验证了本文的潜在空间在压缩视频方面的有效性,同时保持了感知相似性。

图 5 encoder性能

总结

本文提出了PVDM,一种用于视频生成的潜在扩散模型。本文的核心思想是基于提出一个类似图像的2D潜在空间,该空间可以有效地参数化给定的视频,以便通过潜在空间中的扩散模型有效地学习给定的视频数据分布。