每日论文速递 | NAACL'24:自生成翻译记忆缓解翻译持续学习遗忘问题

每日论文速递 | NAACL'24:自生成翻译记忆缓解翻译持续学习遗忘问题

深度学习自然语言处理 分享 整理:pp

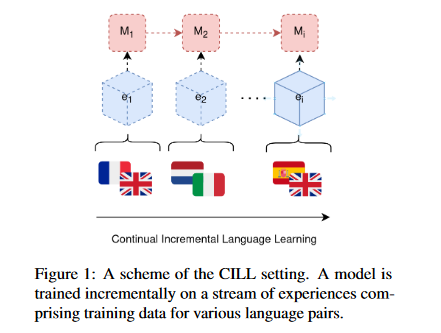

摘要:现代神经机器翻译系统在几种不同的语言中表现出强劲的性能,并在不断改进。然而,它们的持续学习能力仍然受到灾难性遗忘问题的严重限制。在这项工作中,我们利用encoder-decoder transformer的一个关键特性,即它们的生成能力,提出了一种持续学习神经机器翻译系统的新方法。我们展示了如何利用重放记忆,将模型本身作为并行句子的生成器,从而有效地学习由不同语言组成的经验流。我们通过实证证明,我们的方法可以抵消灾难性遗忘,而无需明确记忆训练数据。代码将在发表后公开。

https://arxiv.org/abs/2403.13130

Q1: 这篇论文试图解决什么问题?

A:这篇论文试图解决的问题是神经机器翻译(Neural Machine Translation, NMT)系统在持续学习(Continual Learning, CL)过程中遇到的灾难性遗忘(Catastrophic Forgetting, CF)问题。现代NMT系统虽然在多种语言对上展现出强大的性能,但它们在连续学习新语言对时,往往会忘记之前学到的知识。这个问题限制了NMT系统在实际应用中的适应性和灵活性,尤其是在需要不断适应新任务或新数据的场景中。

为了解决这个问题,论文提出了一种新颖的方法,名为Self-Generated Replay Memories(SG-Rep),该方法利用编码器-解码器Transformers的生成能力,通过使用模型自身生成的并行句子来填充重放记忆(replay memory),以此来持续学习多种语言对的翻译任务,同时减轻灾难性遗忘的负面影响。论文通过实验验证了该方法的有效性,并展示了其在不同翻译方向上的性能,证明了SG-Rep能够在不需要显式记忆训练数据的情况下,对抗灾难性遗忘。

Q2: 有哪些相关研究?

A:这篇论文提到了以下几个与持续学习(Continual Learning)和神经机器翻译(Neural Machine Translation, NMT)相关的研究领域和具体工作:

- 持续学习或终身学习(Lifelong Learning, LL):这个领域的研究致力于开发能够在长时间内逐渐获取、提炼和转移知识的计算系统。这些系统尝试模仿生物学系统的学习能力。

- 灾难性遗忘(Catastrophic Forgetting, CF):这是一个在神经网络中普遍存在的问题,指网络在更新参数以学习新任务时,之前任务的性能会恶化,导致已获得知识的丢失。

- 架构方法(Architecture-based Methods):这类方法通过为特定任务添加新参数或在固定网络大小下为每个任务分配不同容量的方式来改变网络架构。例如,Progressive Networks、Net2Net和PathNet。

- 正则化方法(Regularization-based Methods):基于神经科学理论,通过向神经网络的损失函数中添加正则化项来实现权重更新的约束,以此保护已获得的知识。例如,Elastic Weight Consolidation (EWC) 和 Memory Aware Synapses (MAS)。

- 数据方法(Data-based Methods):这类方法通过保留先前任务的一小部分训练样本来限制权重更新,这些样本可以是真实的或伪样本。例如,使用混合数据进行域适应、GEM和A-GEM。

- 增量式语言学习(Incremental Language Learning):最近才开始转向不同的持续学习设置,如增量式语言学习。

- 多任务学习(Multitask Learning):同时训练模型处理多个任务,通常作为持续学习的一个上界性能基准。

- 知识蒸馏(Knowledge Distillation):虽然不是直接解决持续学习问题的,但与SG-Rep方法有关联,因为它们都涉及到生成样本的使用。

这些相关研究构成了SG-Rep方法的理论基础和对比背景。论文中还提到了一些具体的工作,例如使用EWC作为正则化策略的方法、基于记忆的GEM方法、LAMOL语言模型等,这些都是在解决持续学习问题方面的具体尝试。

Q3: 论文如何解决这个问题?

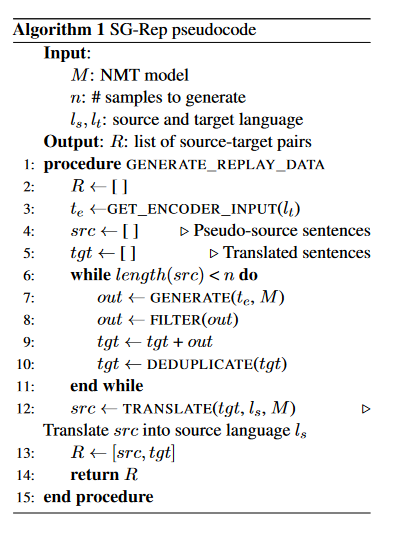

A: 论文提出了一种名为Self-Generated Replay Memories (SG-Rep) 的方法来解决神经机器翻译系统在持续学习过程中遇到的灾难性遗忘问题。SG-Rep方法的核心思想是利用Transformer模型的生成能力,通过以下步骤来实现:

- 生成样本(Generation of Samples):在每个学习经验(learning experience)结束时,使用当前经验中学习到的模型作为生成器,生成一批伪并行句子(pseudo-sentences)。这些句子是模型自己生成的,而不是直接从训练数据中提取的。

- 过滤(Filtering):对生成的伪句子进行过滤,移除重复的句子,并使用拼写检查器(如PyEnchant)来过滤掉形态不正确的句子,以保证生成样本的质量。

- 翻译(Translation):将过滤后的伪目标语言句子翻译回源语言,形成一对源目标语言句子对,这些句子对将作为重放记忆(replay memory)的一部分。

- 重放记忆(Replay Memory):使用水库采样(reservoir sampling)方法将生成的伪样本填充到固定大小的重放记忆中。这个重放记忆将在未来的学习任务中用于缓解灾难性遗忘。

- 持续学习(Continual Learning):在每个新的学习经验开始时,模型将使用新的训练数据和重放记忆中的样本进行训练,以此来保持对之前学习过的语言对的翻译性能,同时适应新的数据。

通过这种方法,SG-Rep能够在不需要显式记忆训练数据的情况下,有效地对抗灾难性遗忘,并且能够持续学习新的翻译任务。论文通过实验验证了SG-Rep方法在不同翻译方向上的性能,并与多种持续学习基线方法进行了比较,证明了其有效性。

Q4: 论文做了哪些实验?

A:论文中进行了一系列实验来评估和验证SG-Rep方法在解决神经机器翻译系统中灾难性遗忘问题上的有效性。以下是实验的主要组成部分:

- 多语言翻译模型:选择单个Transformer模型作为多语言翻译系统的架构,并对其进行了适当的调整以适应实验需求。

- 数据集和学习经验:使用IWSLT17和UNPC数据集进行实验,这些数据集包含了多种语言对。将训练数据组织成一系列学习经验(learning experiences),每个经验包含一种或两种语言对。

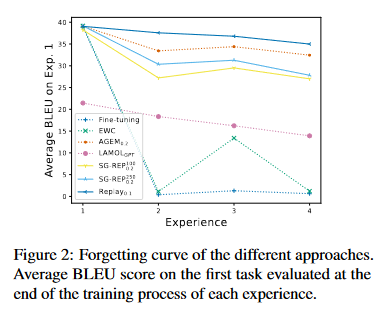

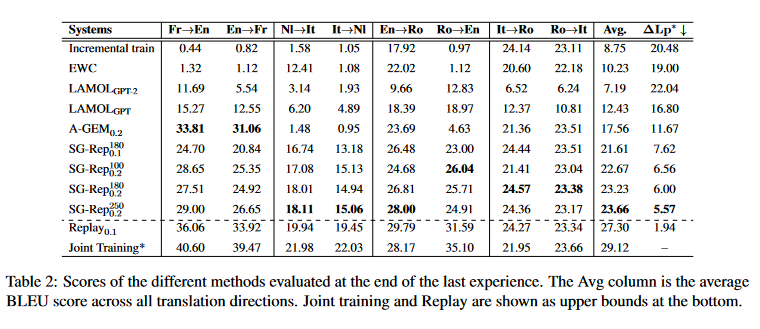

- 系统比较:与多种基线系统进行比较,包括增量训练(Incremental Training)、多任务联合训练(Multitask Joint Training)、重放记忆(Replay)、弹性权重巩固(EWC)、A-GEM、LAMOL等。

- 训练细节:详细描述了模型的训练过程,包括优化器、学习率调度、早停机制、批处理大小等。

- 实验结果:对不同系统在最后学习经验结束后的翻译输出进行了BLEU分数评估,并计算了与联合训练上界性能的差异(ΔLp∗)。此外,还分析了不同系统在不同任务顺序下的性能表现。

- 子词标记重叠分析:研究了在不同学习经验中子词标记重叠程度对性能的影响。

- 不同超参数的影响:探讨了不同重放记忆大小和生成样本数量对SG-Rep方法性能的影响。

- 伪样本分析:对生成的伪样本进行了分析,包括重复计数、长度统计和自我BLEU分数,以评估样本的多样性。

- 数据泄露分析:评估了在模型生成过程中训练数据泄露的情况。

这些实验全面地评估了SG-Rep方法在不同设置和条件下的性能,并与现有的持续学习方法进行了比较,从而证明了SG-Rep方法在减轻灾难性遗忘方面的有效性。

Q5: 有什么可以进一步探索的点?

A:尽管论文提出的SG-Rep方法在持续学习中减轻灾难性遗忘方面取得了积极的结果,但仍有一些方向可以进行进一步的探索:

- 模型架构的改进:探索不同的模型架构和预训练策略,以提高SG-Rep方法在更复杂或资源较少的语言对上的性能。

- 更大规模的数据集:在更大的多语言数据集上测试SG-Rep方法,以评估其在更广泛的语言和领域上的泛化能力。

- 超参数优化:通过自动化超参数优化技术,如贝叶斯优化或网格搜索,来寻找最佳的重放记忆大小和生成样本数量。

- 多样性和质量的平衡:研究如何改进生成样本的多样性和质量,可能通过改进生成策略或引入额外的评估指标。

- 遗忘机制的理解:深入分析和理解在持续学习过程中发生的具体遗忘机制,以便更精确地设计对策。

- 跨领域适应性:测试SG-Rep方法在跨领域适应性任务中的性能,例如从新闻领域到医疗领域的翻译。

- 长期持续学习:评估SG-Rep在长期持续学习场景中的性能,其中模型需要在很长的时间跨度内学习大量不同的任务。

- 实际部署和应用:研究SG-Rep方法在实际NMT系统部署中的可行性和效果,包括计算效率和内存使用。

- 与其他技术的结合:将SG-Rep与其他持续学习技术(如正则化方法、动态架构方法等)结合,探索混合方法在减轻灾难性遗忘方面的潜力。

- 理论分析:进行理论分析,以更好地理解SG-Rep方法如何影响模型的学习过程和知识保留。

这些方向可以为未来的研究提供新的思路,进一步推动持续学习在神经机器翻译等领域的发展。

Q6: 总结一下论文的主要内容?

A:这篇论文的主要内容可以总结如下:

- 标题: Self-generated Replay Memories for Continual Neural Machine Translation

- 背景: 现代神经机器翻译(NMT)系统虽然在多种语言翻译任务上表现出色,但在持续学习(CL)新任务时容易遭受灾难性遗忘(CF),即模型在学习新语言对时会忘记之前学习的语言对。

- 目标: 提出一种新的持续学习NMT方法,通过自生成的重放记忆(SG-Rep)来减轻灾难性遗忘,使模型能够有效地学习一系列不同语言的经验流,而不需要显式记忆训练数据。

- 方法:

- 利用Transformer模型的生成能力,生成伪并行句子。

- 通过过滤和翻译生成的伪句子来构建重放记忆。

- 在未来的任务中使用重放记忆辅助训练,以保持对过去任务的性能。

- 实验:

- 使用IWSLT17和UNPC数据集进行实验。

- 与多种基线系统进行比较,包括增量训练、多任务联合训练、重放记忆、EWC、A-GEM、LAMOL等。

- 评估了不同重放记忆大小和生成样本数量对性能的影响。

- 分析了子词标记重叠、伪样本多样性和数据泄露。

- 结果:

- SG-Rep在多个翻译方向上表现出色,接近或超过多任务联合训练的上界性能。

- SG-Rep在不需要显式记忆训练数据的情况下,有效对抗了灾难性遗忘。

- 实验结果证明了SG-Rep方法在减轻灾难性遗忘方面的有效性。

- 结论:

- SG-Rep是一种简单而有效的持续学习方法,适用于NMT系统。

- 该方法在减轻灾难性遗忘方面优于多个强基线系统。

- 论文还讨论了方法的局限性和未来可能的研究方向。

这篇论文为解决NMT系统中的持续学习问题提供了一个有前景的解决方案,并通过一系列实验验证了其有效性。

以上内容均由KimiChat生成,深入了解论文内容仍需精读论文