每日学术速递4.14(全新改版)

标题: MoReVQA:探索视频问答的模块化推理模型

作者:Juhong Min, Shyamal Buch, Arsha Nagrani, Minsu Cho, Cordelia Schmid

文章链接:https://arxiv.org/pdf/2404.06511.pdf

项目代码:http://juhongm999.github.io/morevqa

摘要:

本文通过分解的多阶段、模块化推理框架来解决视频问答 (videoQA) 的任务。以前的模块化方法已经显示出前景,单一的规划阶段不以视觉内容为基础。然而,通过一个简单而有效的基线,我们发现这样的系统在实践中会导致具有挑战性的视频QA设置的脆弱行为。因此,与传统的单阶段规划方法不同,我们提出了一个多阶段系统,该系统由事件解析器、接地阶段和最终推理阶段以及外部存储器组成。所有阶段都是免训练的,并使用大型模型的少量提示来执行,在每个阶段创建可解释的中间输出。通过分解底层规划和任务复杂性,我们的方法 MoReVQA 改进了之前在标准视频 QA 基准测试(NExT-QA、iVQA、EgoSchema、ActivityNet-QA)上的工作,并获得了最先进的结果,并扩展了相关任务(接地视频 QA、段落字幕)。

论文的主要内容:

这篇论文的主要内容可以总结如下:

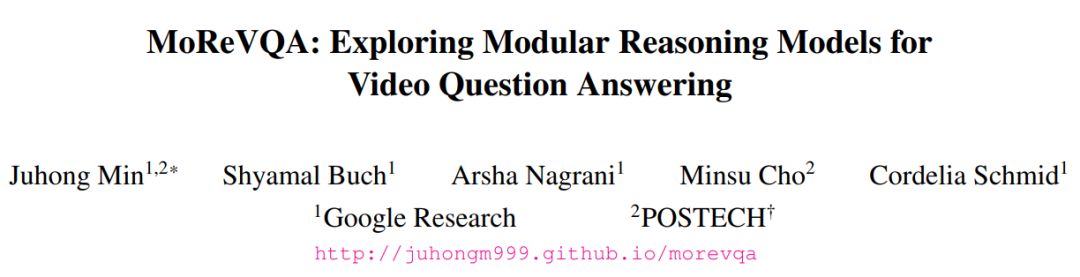

- 问题定义:论文针对视频问答(videoQA)任务,提出了一个多阶段、模块化推理框架,旨在解决传统单阶段规划方法在处理复杂视频内容时的脆弱性和缺乏可解释性问题。

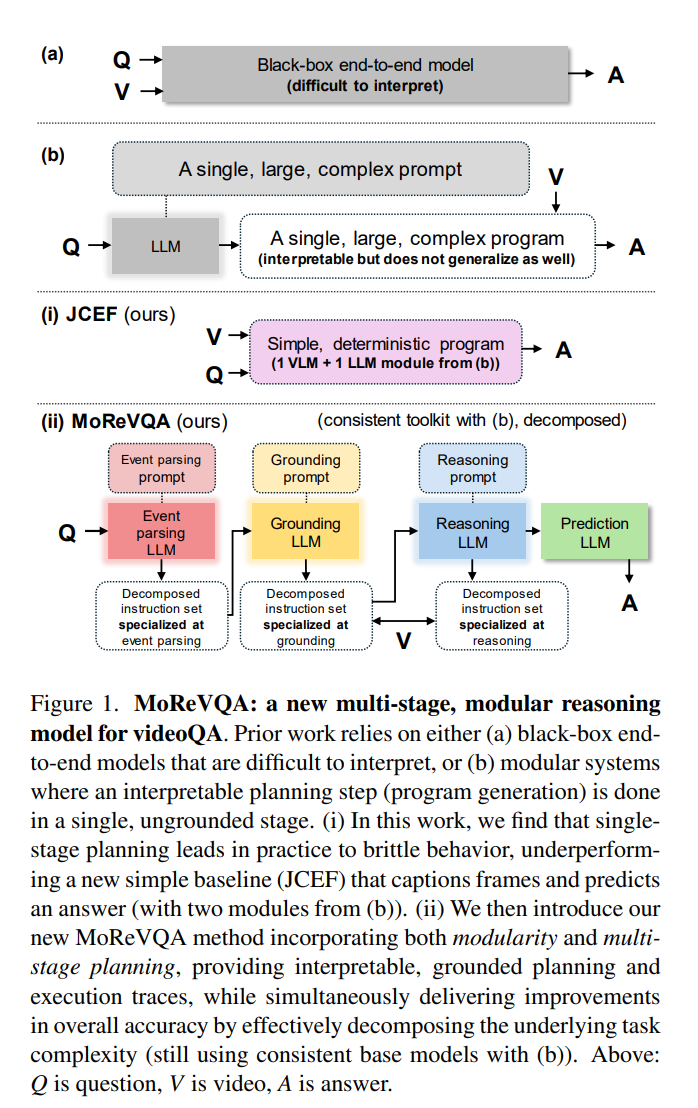

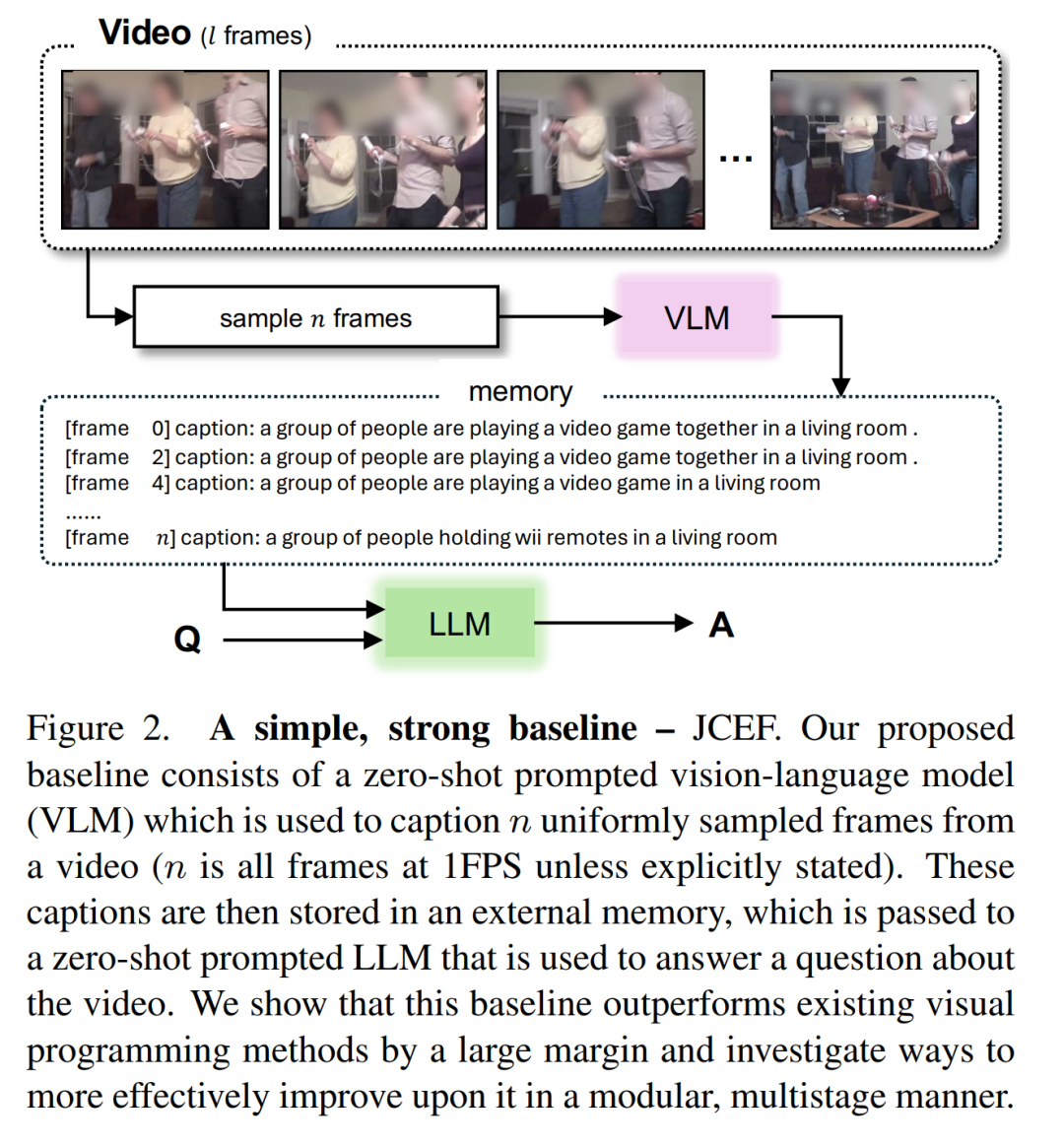

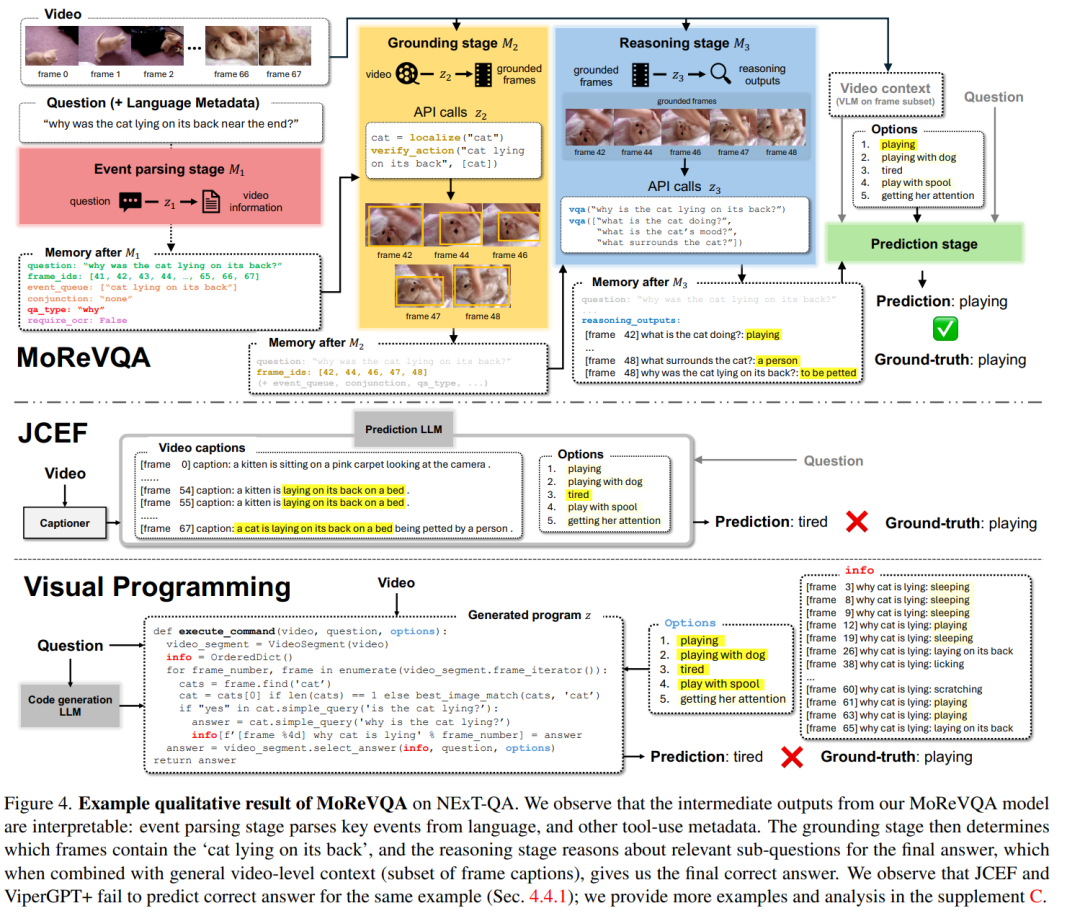

- 方法提出:提出了一种名为MoReVQA(Modular Reasoning for Video Question Answering)的新方法,该方法通过事件解析、定位和推理三个阶段来处理视频问答任务。每个阶段都利用大型预训练模型(如LLM和VLM)生成可解释的中间输出。

- 技术细节:详细描述了MoReVQA的每个阶段如何工作,包括事件解析阶段对问题的分析、定位阶段对视频关键区域的识别,以及推理阶段如何结合前两个阶段的输出来生成答案。

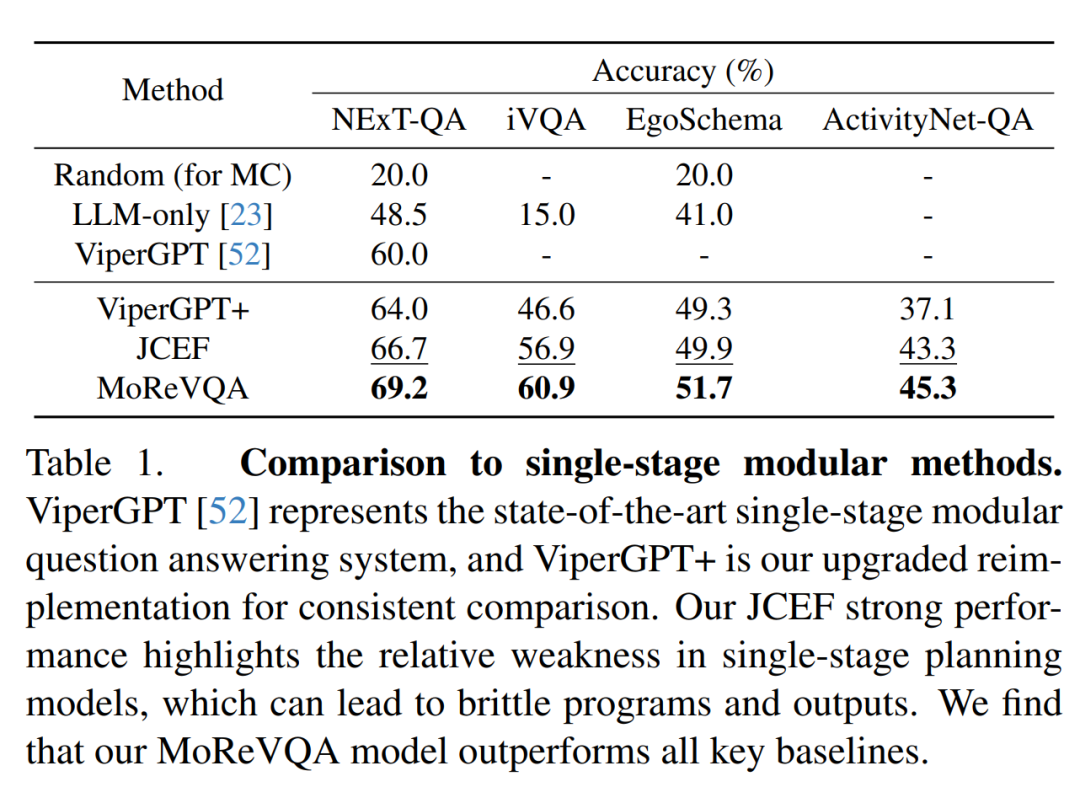

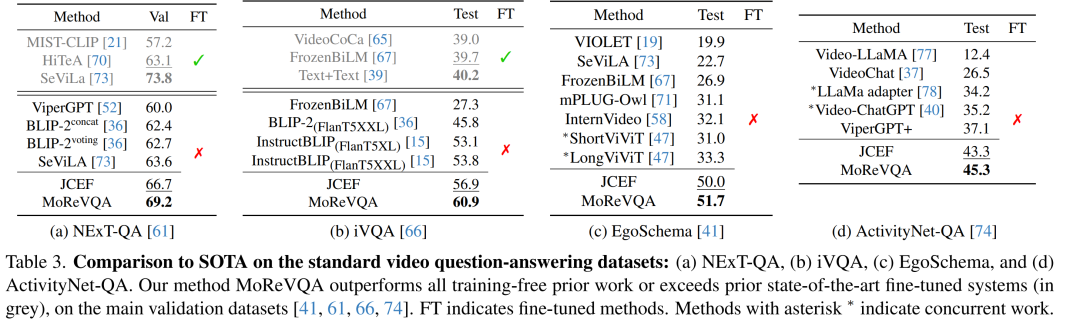

- 实验验证:在多个标准视频问答数据集上(如NExT-QA、iVQA、EgoSchema和ActivityNet-QA)进行了实验,与现有的单阶段模块化方法和其他基线模型进行了比较,证明了MoReVQA在准确率和可解释性方面的优势。

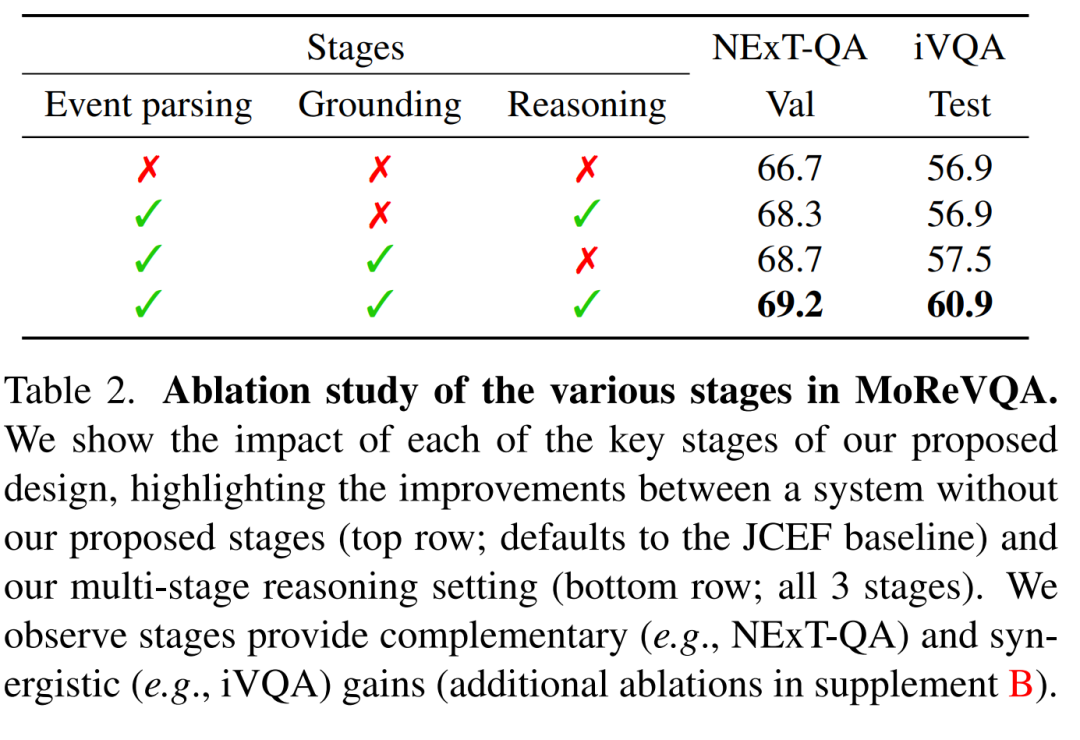

- 结果分析:通过消融实验展示了MoReVQA中每个阶段的重要性,并分析了模型在不同数据集上的性能,包括对模型鲁棒性的评估。

- 扩展应用:探讨了MoReVQA在相关任务上的扩展性,如基于段落的视频字幕生成和定位视频问答任务。

- 未来工作:讨论了MoReVQA的潜在改进空间,包括模型泛化能力、多模态融合、实时处理、交互式问答、外部知识集成、模型鲁棒性和社会影响等方面的进一步研究。

总的来说,这篇论文通过引入一个新的多阶段模块化方法,显著提高了视频问答任务的性能,并增强了模型的可解释性和灵活性。

这篇论文试图解决什么问题?

这篇论文试图解决视频问答(videoQA)任务中的一些挑战性问题。具体来说,它关注的是如何通过一个分解的多阶段、模块化推理框架来提高视频问答系统的性能。以下是论文试图解决的主要问题和挑战:

- 传统单阶段规划方法的局限性:以往的模块化方法在视频问答任务中表现出了潜力,但它们通常依赖于一个单一的规划阶段,这个阶段没有基于视觉内容的支撑,可能导致系统在处理具有挑战性的视频问答设置时表现出脆弱性。

- 提高视频问答的准确性:通过提出一个新的多阶段模块化方法(MoReVQA),论文旨在通过有效地分解任务复杂性来提高标准视频问答基准测试(如NExT-QA、iVQA、EgoSchema、ActivityNet-QA)上的性能。

- 增强模型的可解释性:MoReVQA方法在每个阶段都生成可解释的中间输出,这有助于理解模型的决策过程,并提供更多的透明度。

- 处理视频内容的复杂性:视频内容通常包含多个时间尺度上的事件,这对于现有的端到端视觉语言模型(VLMs)来说是一个挑战,因为它们通常只看到视频的少数几帧。

- 模块化和组合泛化:MoReVQA利用大型语言模型(LLMs)的推理和规划能力,通过模块化方法来提高组合泛化能力,即模型能够灵活地适应和处理新的、未见过的情境。

总的来说,这篇论文的目标是通过一个新的多阶段模块化推理方法来提高视频问答任务的性能和可解释性,同时解决传统单阶段方法的脆弱性和缺乏组合泛化能力的问题。

论文如何解决这个问题?

论文提出了一种名为MoReVQA(Modular Reasoning for Video Question Answering)的新方法来解决视频问答任务中的挑战。MoReVQA采用分解的多阶段、模块化推理框架,具体解决方案包括以下几个关键步骤:

- 事件解析(Event Parsing):首先,MoReVQA通过一个事件解析器来理解问题中的关键事件和属性。这个阶段使用大型语言模型(LLM)来分析输入问题,识别出与视频内容相关的重要信息,如时间提示、事件类型(如位置、描述、解释)等。

- 定位(Grounding):接着,模型进入定位阶段,这一阶段的目标是识别视频中与事件解析阶段识别出的事件相对应的具体时间区域。这样可以避免处理视频中的每一帧,而是只关注那些对回答问题最重要的部分。

- 推理(Reasoning):最后,模型利用事件解析和定位阶段的输出,结合外部记忆(存储前两个阶段的信息),进行最终的推理,得出问题的答案。这个阶段通过生成一系列API调用来执行,这些调用涉及对视频内容的进一步分析和问题的理解。

MoReVQA的关键特点包括:

- 模块化:通过将问题分解为多个子任务,每个子任务由专门的模块处理,提高了系统的灵活性和可解释性。

- 多阶段规划:通过分阶段处理问题,而不是在一个单一的、复杂的阶段中解决所有问题,使得模型能够更有效地处理视频问答任务。

- 无需训练:所有阶段都采用预训练的模型,通过少量样本提示(few-shot prompting)来执行,这减少了对大量标注数据的需求。

- 外部记忆:使用外部记忆来存储跨阶段的信息,使得模型能够在处理问题时迭代地改进其理解。

通过这种方法,MoReVQA在多个标准视频问答基准测试中取得了最先进的结果,并且在需要时可以扩展到相关任务,如基于段落的视频字幕生成。此外,由于模型在每个阶段生成可解释的中间输出,因此提供了对模型决策过程的深入理解。

2.Reconstructing Hand-Held Objects in 3D

标题: 在 3D 中重建手持对象

作者:Jane Wu, Georgios Pavlakos, Georgia Gkioxari, Jitendra Malik

文章链接:https://arxiv.org/abs/2404.06507

项目代码:https://github.com/THUDM/ImageReward

摘要:

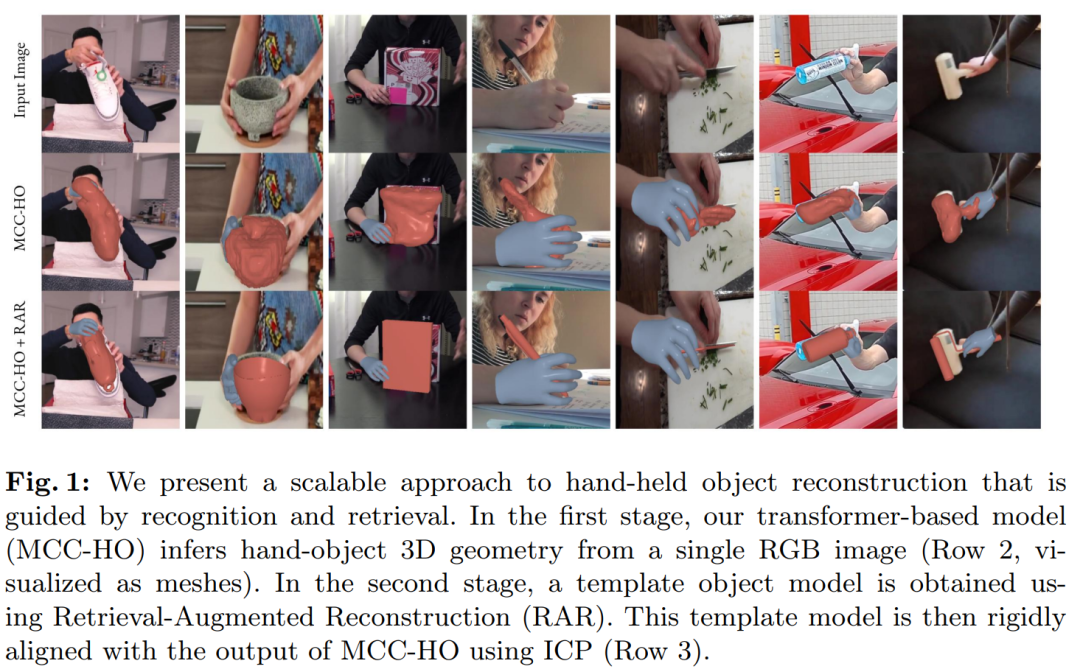

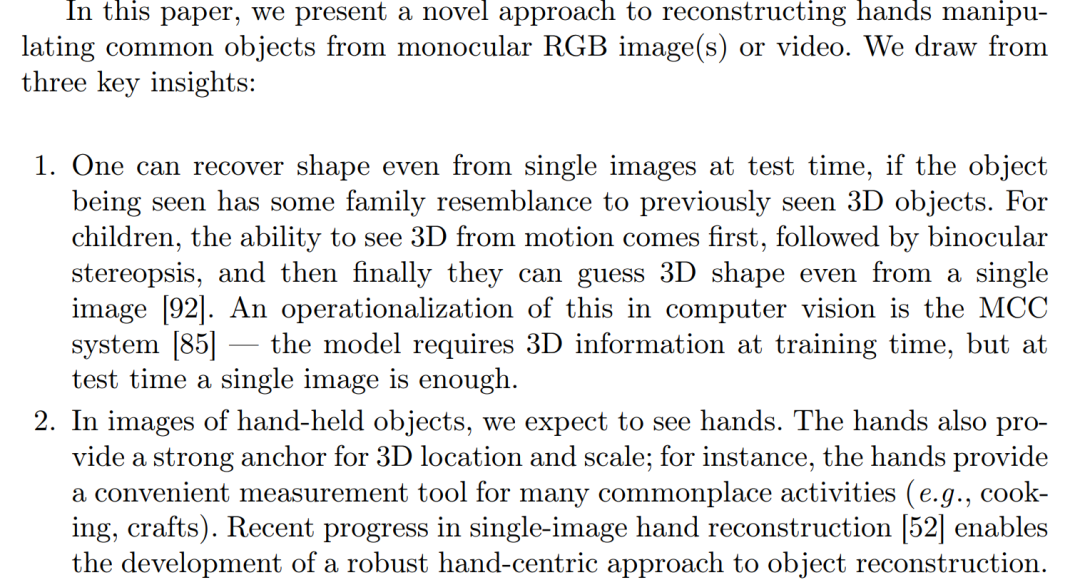

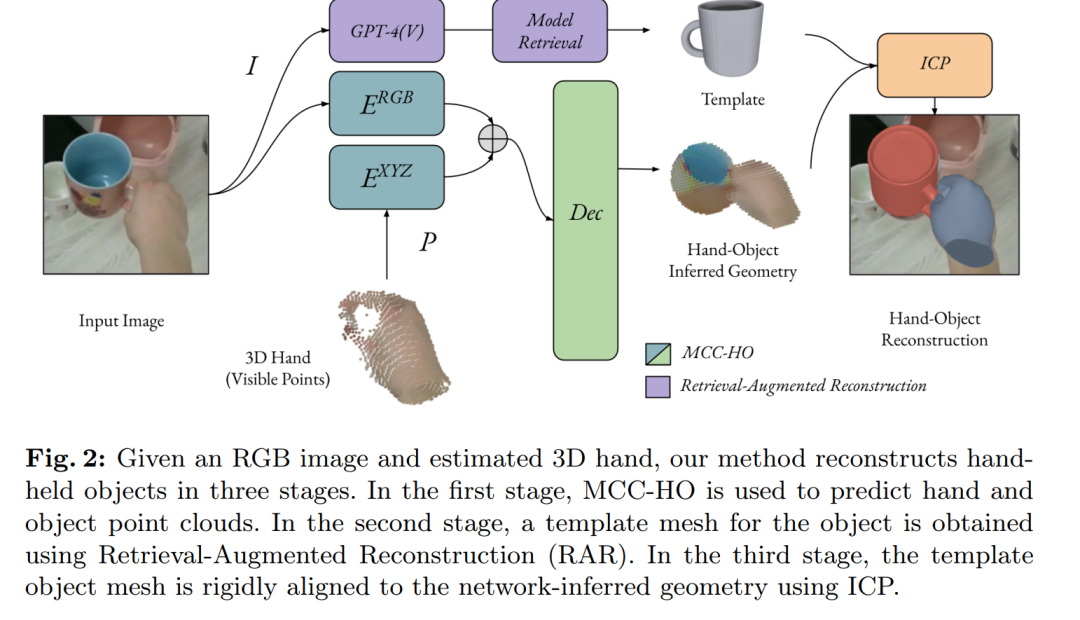

用手操作的物体(即操纵物)在野外RGB图像或视频中重建特别具有挑战性。手不仅遮挡了大部分物体,而且物体通常只在少量图像像素中可见。同时,在这种设置中出现了两个强大的锚点:(1)估计的3D指针有助于消除物体的位置和比例的歧义,以及(2)相对于所有可能的物体,操纵集都很小。考虑到这些见解,我们提出了一种可扩展的手持对象重建范式,该范式建立在大型语言/视觉模型和 3D 对象数据集的最新突破之上。我们的模型 MCC-Hand-Object (MCC-HO) 在给定单个 RGB 图像和推断的 3D 手作为输入的情况下共同重建了手和物体的几何形状。随后,我们使用 GPT-4(V) 检索与图像中对象匹配的 3D 对象模型,并将模型与网络推断的几何体刚对齐;我们称这种对齐为检索增强重建(RAR)。实验表明,MCC-HO在实验室和互联网数据集上实现了最先进的性能,我们展示了如何使用RAR自动获取手与物体交互的野外图像的3D标签。

论文的主要内容:

这篇论文的主要内容可以总结如下:

- 问题定义:

- 论文关注于从野外RGB图像或视频中重建手持物体的3D几何结构,这是一个具有挑战性的问题,因为手部的遮挡和物体的有限可见性增加了重建的难度。

- 方法提出:

- 论文提出了一个三阶段的方法来解决这个问题,包括手-物体几何推断、检索增强重建(RAR),以及刚性对齐。

- 模型设计:

- 介绍了MCC-Hand-Object (MCC-HO)模型,这是一个基于Transformer的模型,能够从单个RGB图像和估计的3D手部输入中联合推断手和物体的几何结构。

- 技术亮点:

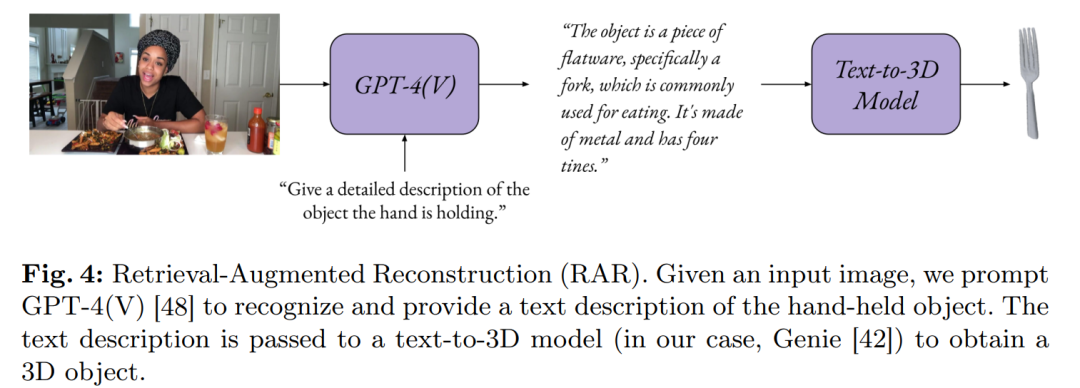

- 利用GPT-4(V)进行文本描述生成,然后通过Genie模型将文本转换为3D对象模型,实现了自动化的3D对象检索和对齐。

- 实验验证:

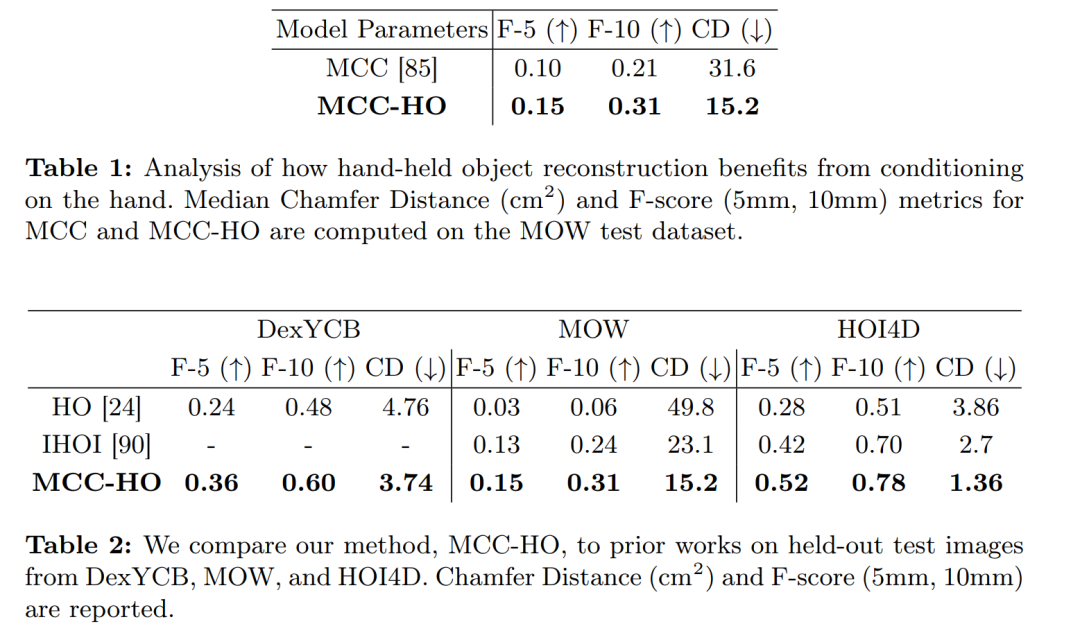

- 在多个数据集上进行实验,包括HOI4D、DexYCB、MOW/RHOV和100DOH,验证了所提方法的有效性,并与现有方法进行了比较。

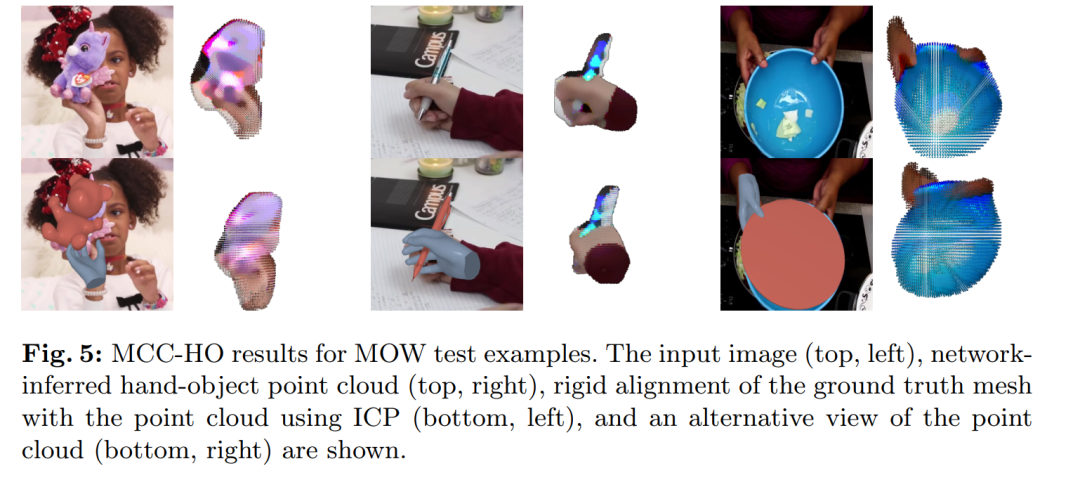

- 结果展示:

- 论文通过定量和定性的实验结果展示了MCC-HO模型的优越性能,以及RAR技术在自动获取3D标签方面的潜力。

- 未来方向:

- 论文讨论了方法的局限性,并提出了未来可能的研究方向,如实时性能优化、更广泛的物体类别、多模态数据融合等。

总体而言,这篇论文为手持物体的3D重建问题提供了一个创新的解决方案,并通过一系列实验展示了该方法的有效性和应用前景。

这篇论文试图解决什么问题?

这篇论文试图解决的问题是如何从野外(in-the-wild)RGB图像或视频中重建手持物体(manipulanda)的3D几何结构。具体来说,论文面临的挑战包括:

- 手持物体在图像中经常被手部遮挡,导致物体的可见部分非常有限。

- 现有的3D重建方法(如结构光、运动恢复结构(SfM)和神经辐射场(NeRF))在处理大部分被遮挡的物体时表现不佳。

- 手动检索3D模型的方法虽然可以提高重建质量,但缺乏可扩展性,因为需要大量的人工搜索和验证工作。

为了解决这些问题,论文提出了一个可扩展的手持物体重建范式,该范式利用了以下两个关键点:

- 估计的3D手部信息可以帮助消除物体位置和尺度的歧义。

- 与所有可能的物体相比,手持物体的类别相对较少。

基于这些见解,论文提出了一个名为MCC-Hand-Object(MCC-HO)的模型,该模型结合了大型语言/视觉模型和3D对象数据集的最新进展,可以从单个RGB图像和推断出的3D手部输入中联合重建手部和物体的几何结构。此外,论文还提出了一种名为检索增强重建(Retrieval-Augmented Reconstruction, RAR)的方法,该方法使用GPT-4(V)来检索与图像中的物体匹配的3D对象模型,并通过刚性对齐技术将其与网络推断的几何结构对齐。通过这种方法,论文旨在实现手持物体的高效、准确重建。

论文如何解决这个问题?

论文提出了一个三阶段的方法来解决手持物体的3D重建问题,具体如下:

- 手-物体几何推断(Hand-Object Geometry Inference):

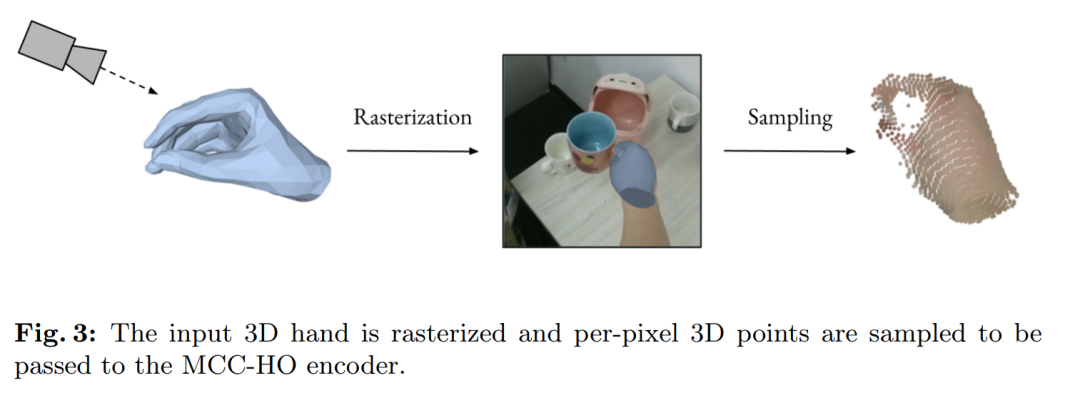

- 论文提出了一个基于Transformer的模型,名为MCC-Hand-Object (MCC-HO),它能够从单个RGB图像和估计的3D手部输入中联合推断出手部和物体的几何结构。这个模型是MCC模型的改进版,适应于手持物体重建任务。

- MCC-HO使用编码器-解码器架构,编码器处理输入的RGB图像和3D手部信息,解码器则输出一个神经隐式函数,表示手部和物体的占用概率、RGB颜色和分割标签。

- 检索增强重建(Retrieval-Augmented Reconstruction, RAR):

- 为了进一步提高网络推断的物体几何质量,论文使用GPT-4(V)自动检测并检索与图像中手持物体对应的3D物体模型。这一技术被称为检索增强重建(RAR),类似于自然语言处理中的检索增强生成。

- 通过将输入图像提示给GPT-4(V),模型提供了一个详细的文本描述,然后这个文本描述被传递给一个文本到3D的生成模型(如Genie),以获取真实的3D物体几何和外观。

- 刚性对齐(Rigid Alignment):

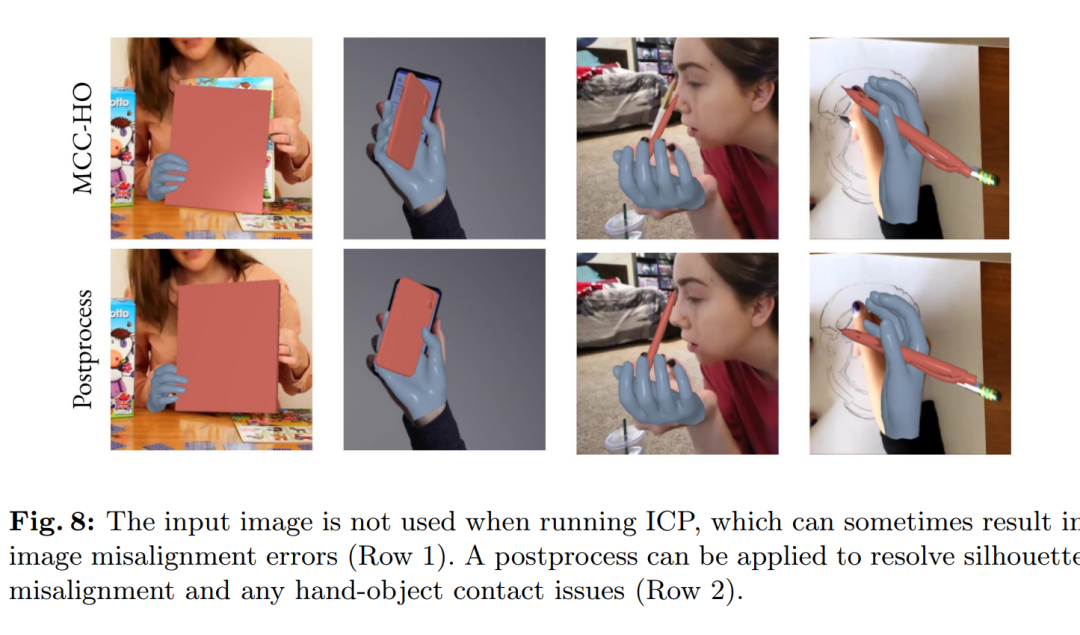

- 获取到的3D物体模型通过迭代最近点(ICP)算法或其他点云拟合技术与网络推断的几何结构进行刚性对齐。

- 这一步骤确保了检索到的3D模型与从图像中推断出的几何结构紧密匹配,从而得到准确的手持物体3D重建。

通过这三个阶段,论文的方法结合了无模型和基于模型的方法的优势,实现了从单目RGB图像或视频中高效、准确地重建手持物体的3D结构。此外,该方法能够自动地扩展到未标记的数据集上,为创建大型手-物体交互的3D数据集提供了可能性。

3.Flying With Photons: Rendering Novel Views of Propagating Light

标题:与光子一起飞行:渲染传播光的新视图

作者:Anagh Malik, Noah Juravsky, Ryan Po, Gordon Wetzstein, Kiriakos N. Kutulakos, David B. Lindell

文章链接:https://arxiv.org/abs/2404.06493

项目代码:https://anaghmalik.com/FlyingWithPhotons/

摘要:

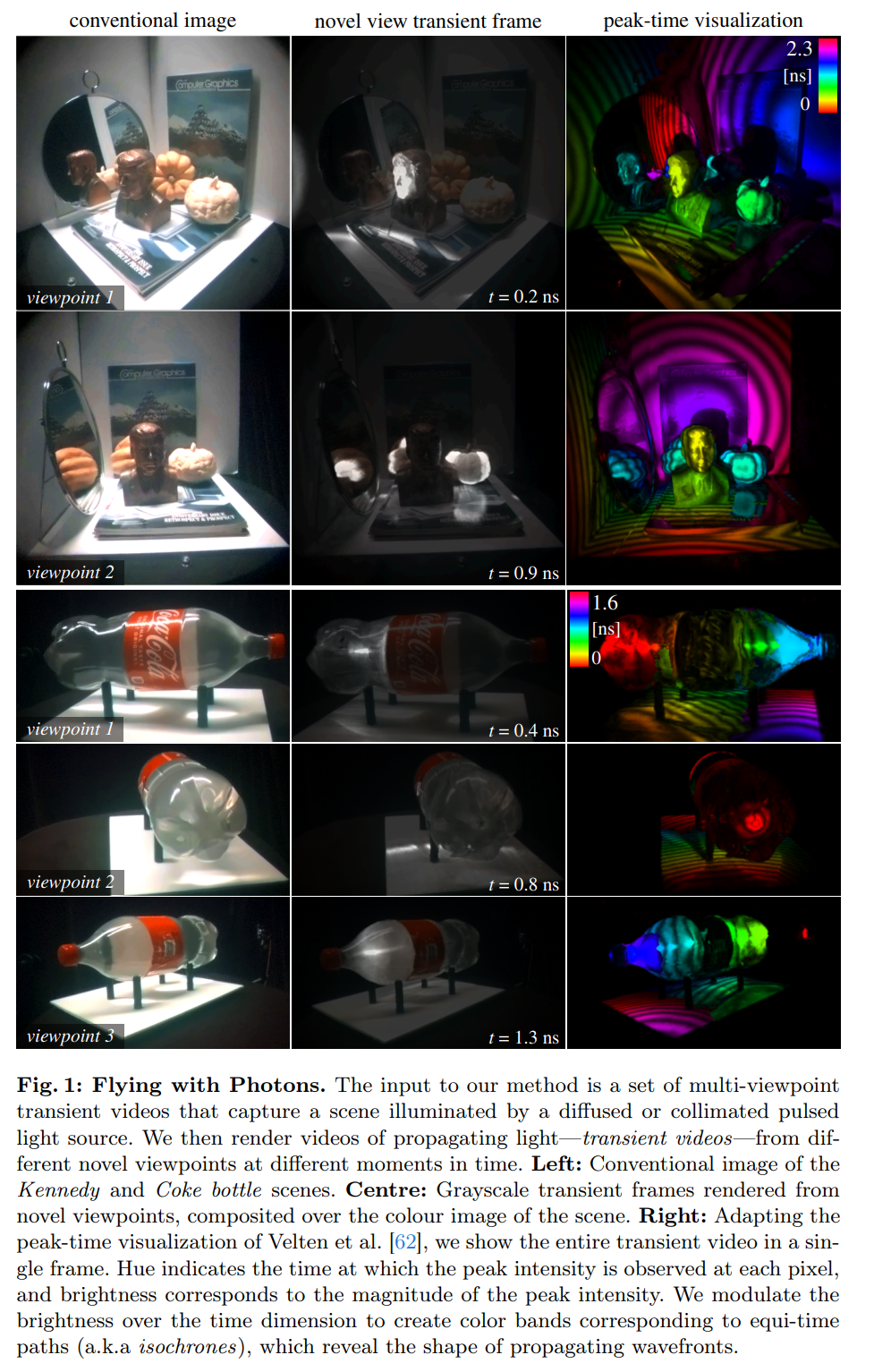

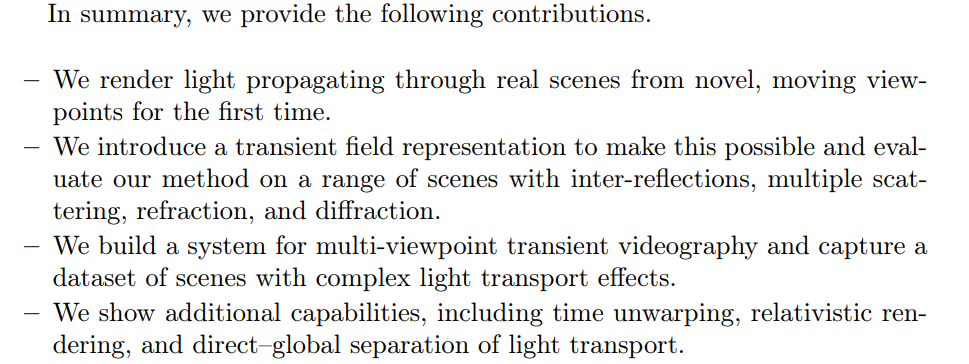

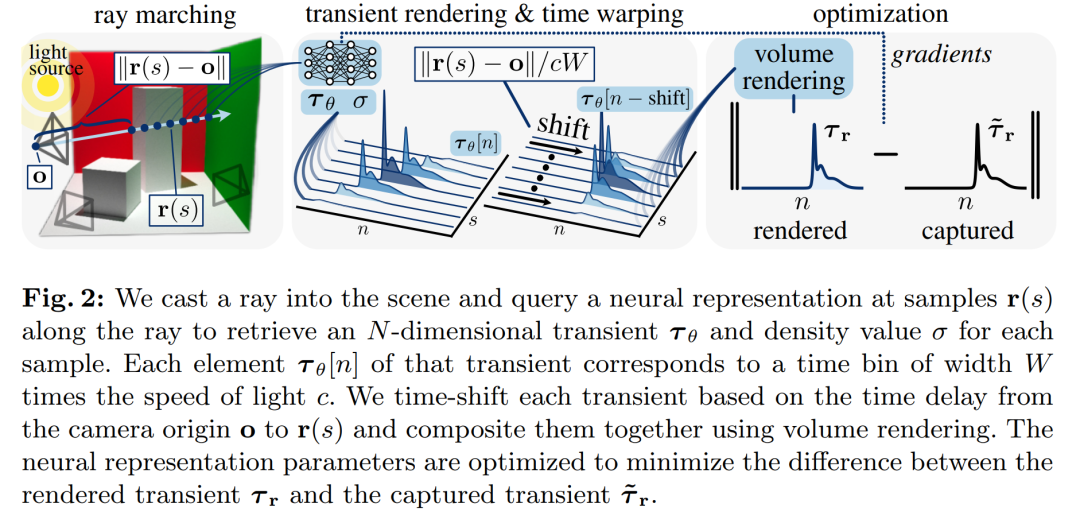

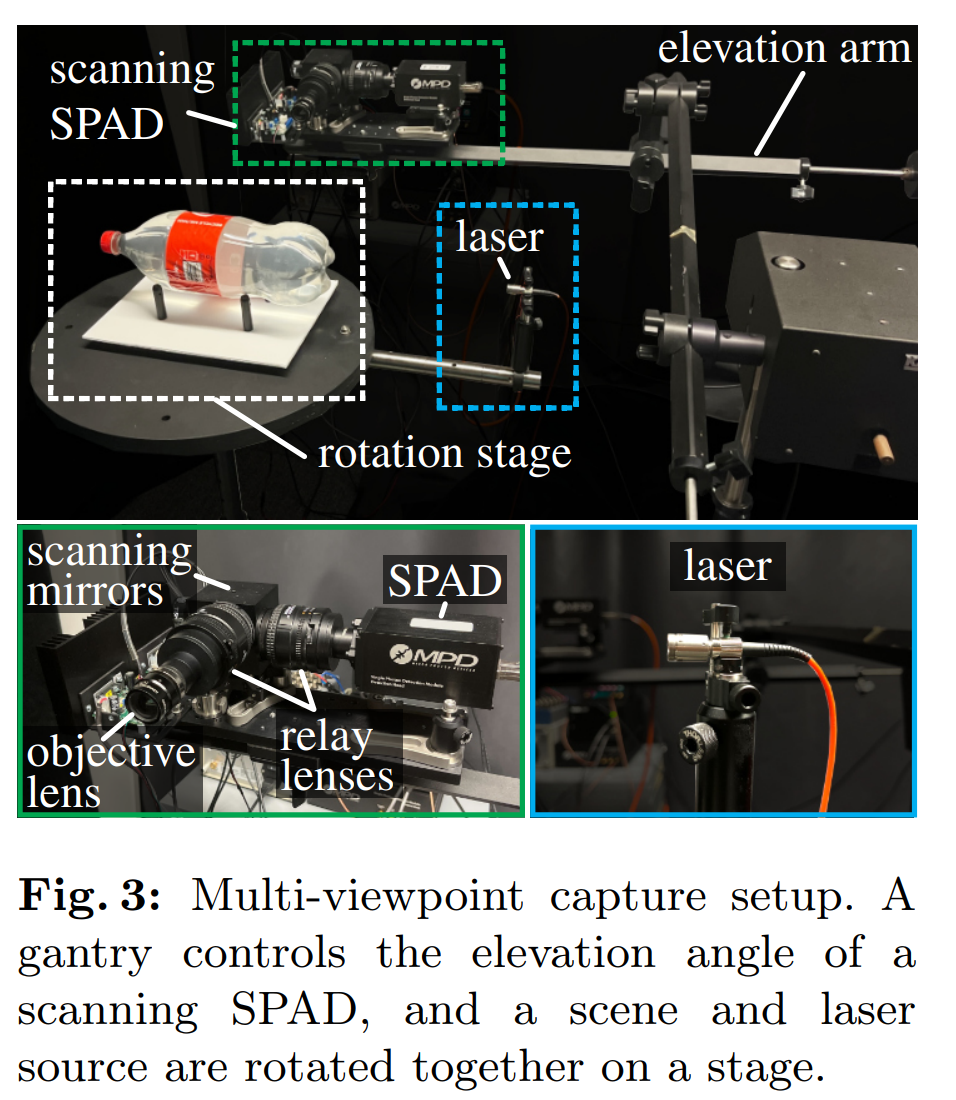

我们提出了一种成像和神经渲染技术,该技术旨在从新颖的移动摄像机视角合成光在场景中传播的视频。我们的方法依赖于一种新的超快成像设置,以皮秒级的时间分辨率捕获同类首创的多视点视频数据集。结合该数据集,我们引入了一个基于瞬态场的高效神经体积渲染框架。该场被定义为从 3D 点和 2D 方向到高维离散时间信号的映射,该信号表示超快时间尺度下的时变辐射。使用瞬态场进行渲染时,自然会考虑由于光速有限而产生的影响,包括由光传播延迟到相机引起的与视点相关的外观变化。我们渲染了一系列复杂的效果,包括散射、镜面反射、折射和衍射。此外,我们还演示了使用时间扭曲程序、相对论效应的渲染以及光传输的直接和全局分量的视频合成来消除视点相关的传播延迟。

论文的主要内容:

这篇论文的主要内容可以总结如下:

- 问题定义:论文旨在解决从新颖、移动的相机视角合成光通过场景传播的视频的问题。这是由于现有的新视角合成技术与超快成像设备的单视角捕获设置不兼容。

- 技术方法:

- 提出了一种基于超快成像设置的多视角视频数据采集技术,该数据集具有皮秒级时间分辨率。

- 引入了一个神经体积渲染框架,称为瞬态场,用于表示和渲染超快速时间尺度上的时变辐射度。

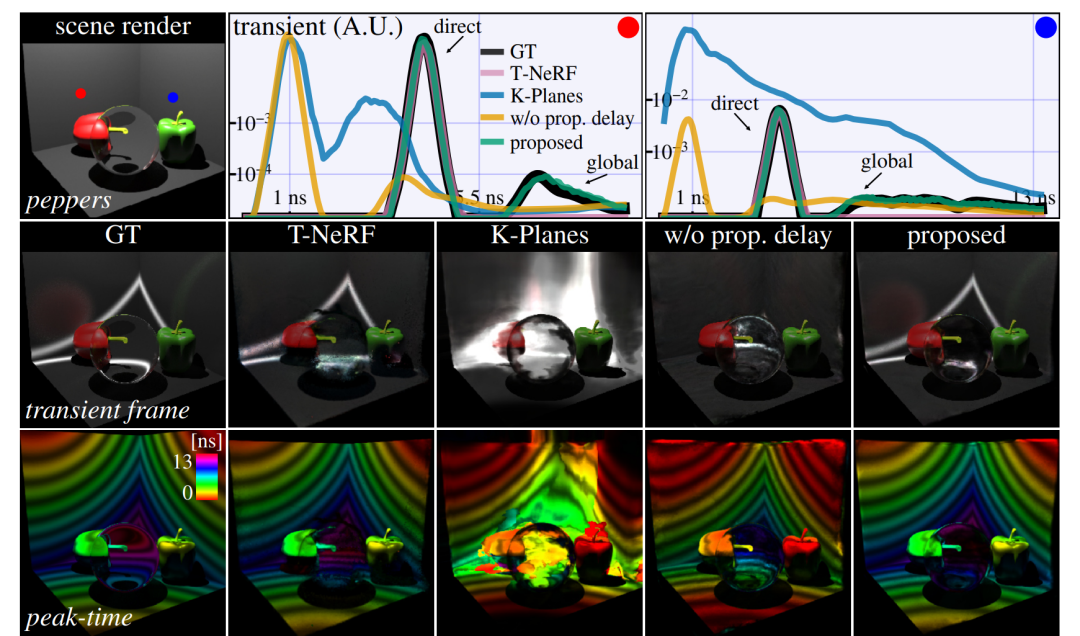

- 通过考虑光速有限的影响,渲染了包括散射、镜面反射、折射和衍射在内的复杂光传输效应。

- 展示了使用时间扭曲技术来改变视角依赖的光传输外观,以及渲染相对论效应。

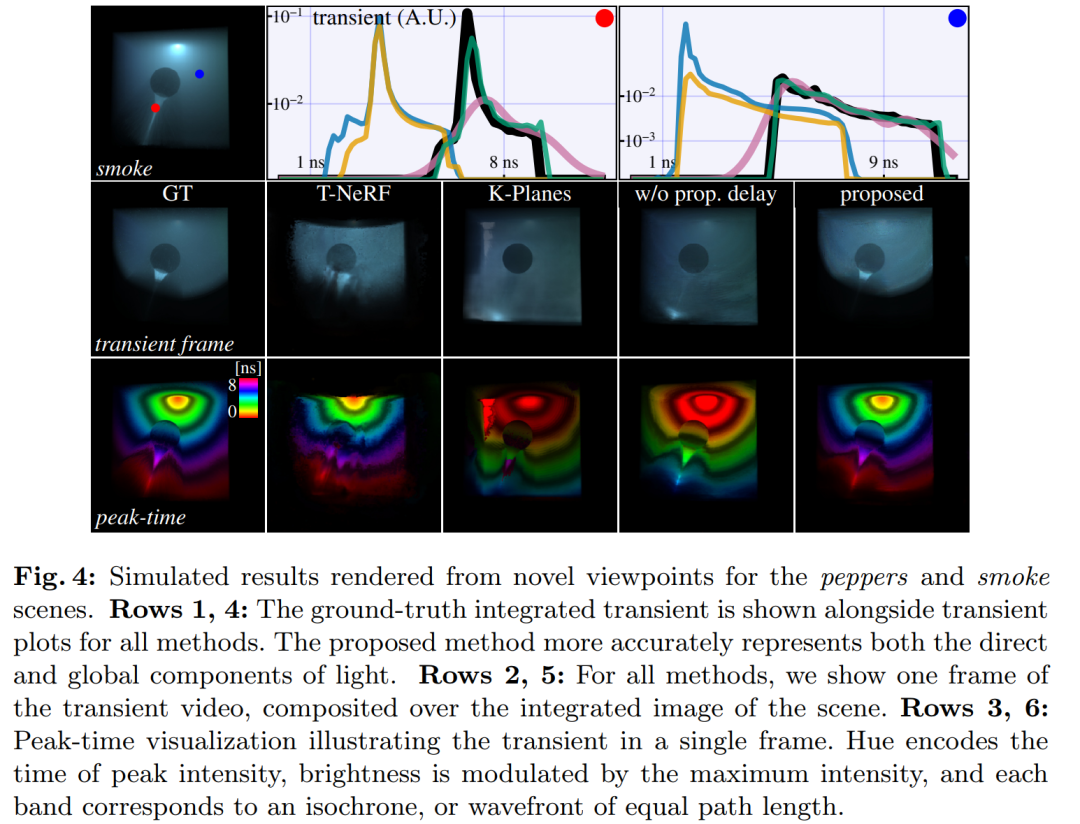

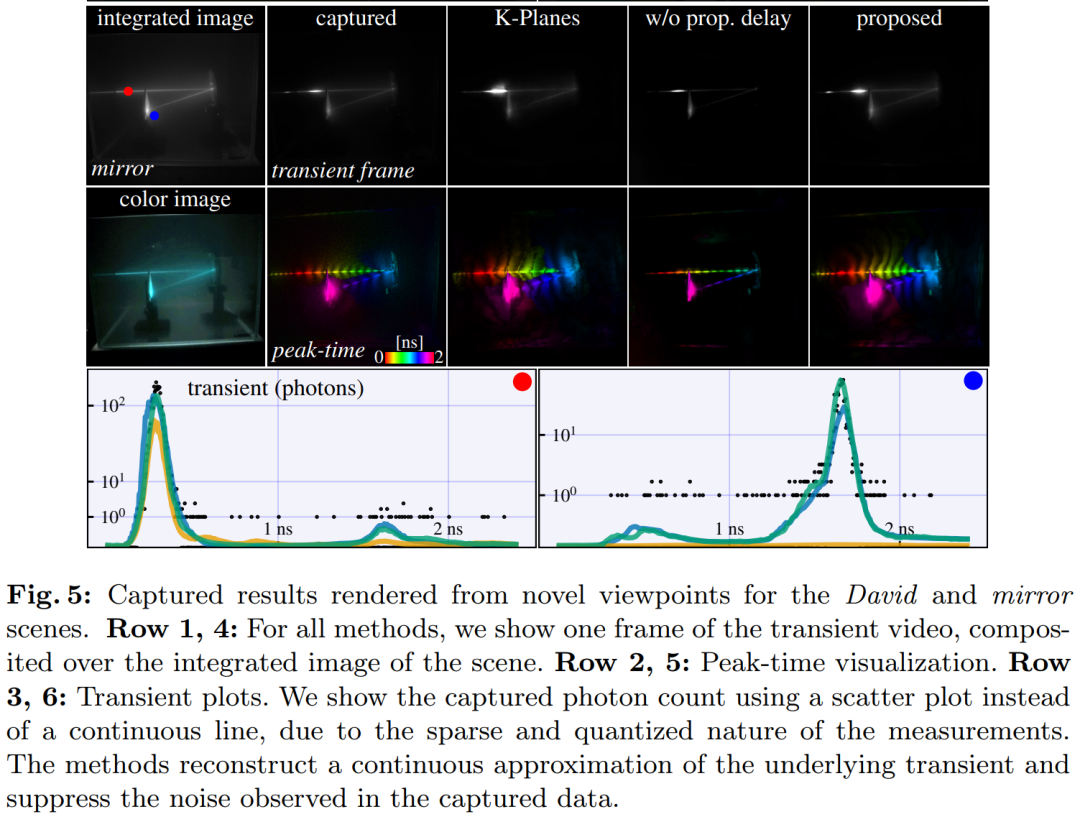

- 实验验证:

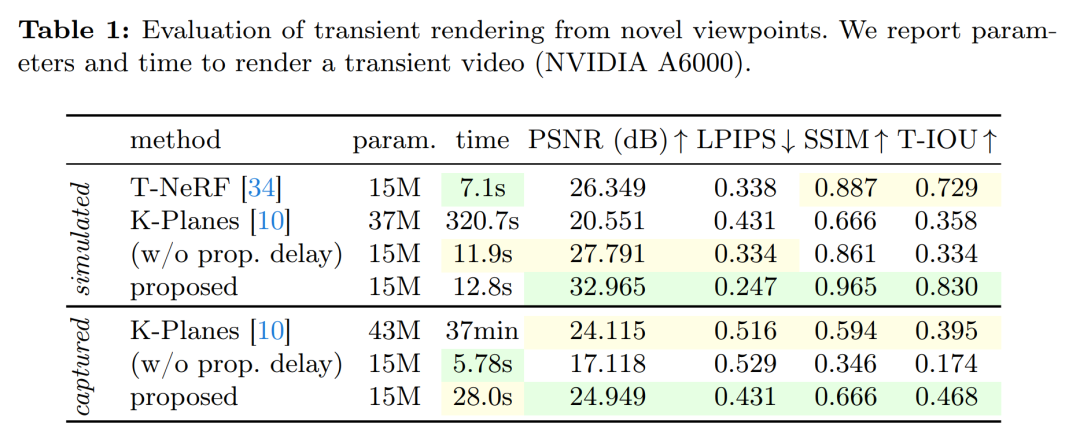

- 在模拟数据集和真实数据集上进行了一系列实验,以验证提出方法的有效性。

- 与现有技术(如Transient NeRF和K-Planes)进行了比较,显示出在图像质量和计算效率方面的优势。

- 展示了从新颖视角渲染瞬态视频的能力,并评估了时间扭曲和相对论效应的可视化。

- 未来工作:

- 论文提出了未来可能的研究方向,包括处理动态场景、实时渲染、更广泛的光传输效应、数据集扩展、与物理模型集成、新评估基准、多模态数据融合、硬件改进和新应用探索。

总的来说,这篇论文提出了一种创新的方法,用于从多个移动视角渲染光的传播,并通过一系列实验展示了该方法的有效性和潜在应用。

这篇论文试图解决什么问题?

这篇论文提出了一种新的成像和神经渲染技术,旨在合成从新颖的、移动的相机视角观察光通过场景传播的视频。具体来说,它试图解决以下问题:

- 多视角瞬态视频合成:现有的新视角合成技术主要基于从多个视角捕获的场景图像,但这些技术与现有的瞬态摄影设备不兼容,后者主要用于单视角捕获。论文提出的方法旨在从动态的新颖视角合成瞬态视频,以便于灵活地可视化光传输并促进基于光传播3D表示的新应用。

- 有限光速的渲染:现有用于多视角瞬态渲染的技术没有考虑到光速有限的影响,这在短时标下会导致显著的视觉效果变化。论文提出的方法特别处理了由于光速有限导致的渲染问题,包括由于光传播延迟到相机而引起的视角依赖性外观变化。

- 复杂光传输效应的渲染:论文的方法能够渲染包括散射、镜面反射、折射和衍射在内的一系列复杂的光传输效应。

- 实时和动态场景的渲染:尽管目前的方法是针对静态场景的,但它为将来可能发展出的能够捕捉动态场景的多视角瞬态摄影技术提供了基础。

- 数据集和表示方法的缺乏:为了实现上述目标,需要一个新的数据集和表示方法来捕获和渲染多视角瞬态效应。论文通过引入一种基于瞬态场的体积渲染框架来解决这个问题,该框架定义了一个从3D点和2D方向映射到高维离散时间信号的映射,代表了超快速时间尺度上变化的辐射度。

总的来说,这篇论文的目标是通过结合新的超快成像设置和高效的神经体积渲染框架,来渲染真实场景中传播的光,从新颖的、移动的视角进行观察。

论文如何解决这个问题?

论文通过以下主要技术方案来解决提出的问题:

- 超快成像设置:论文首先介绍了一种新的超快成像设置,能够以皮秒级时间分辨率捕获多视角视频数据集。这个数据集是首次捕获的,并且包含了光在超快速时间尺度上的变化信息。

- 神经体积渲染框架:结合上述数据集,论文提出了一个基于瞬态场的高效神经体积渲染框架。瞬态场是一个从3D点和2D方向映射到一个高维离散时间信号的函数,它代表了在超快速时间尺度上变化的辐射度。

- 渲染技术:论文的渲染技术自然地考虑了由于光速有限而产生的效应,包括由于光传播延迟到相机而引起的视角依赖性外观变化。通过这种方式,可以渲染出包括散射、镜面反射、折射和衍射在内的一系列复杂的光传输效应。

- 时间扭曲技术:为了进一步改善渲染效果,论文提出了一种时间扭曲技术,通过添加或移除渲染瞬态中的时间延迟来可视化光传输。这包括深度基础的时间扭曲,可以去除从场景点到相机的传播延迟,从而在不同的空间时间坐标框架中渲染每条相机射线。

- 相对论效应渲染:论文还展示了如何渲染由于相机以接近光速移动而产生的相对论效应,包括时间膨胀、由于洛伦兹收缩导致的相机焦距变形、光畸变以及搜寻灯效应。

- 数据集和系统构建:为了支持上述方法,论文构建了一个多视角瞬态视频数据集,并开发了一个硬件原型系统,用于捕获场景的瞬态视频。

- 优化和实现细节:论文详细描述了神经表示的优化过程、渲染细节、动态视点渲染、以及如何从新的视角合成瞬态视频。

通过这些技术组合,论文成功地从新颖的、移动的视角渲染了传播中的光,并通过实验验证了方法的有效性。此外,论文还展示了该方法的一些额外应用,如时间扭曲、相对论渲染和直接-全局光传输成分的分离。