每日学术速递4.17(全新改版)

1.3DMambaComplete: Exploring Structured State Space Model for Point Cloud Completion

标题:3DMambaComplete:探索用于点云完成的结构化状态空间模型

作者:Yixuan Li, Weidong Yang, Ben Fei

文章链接:https://arxiv.org/abs/2404.07106

摘要:

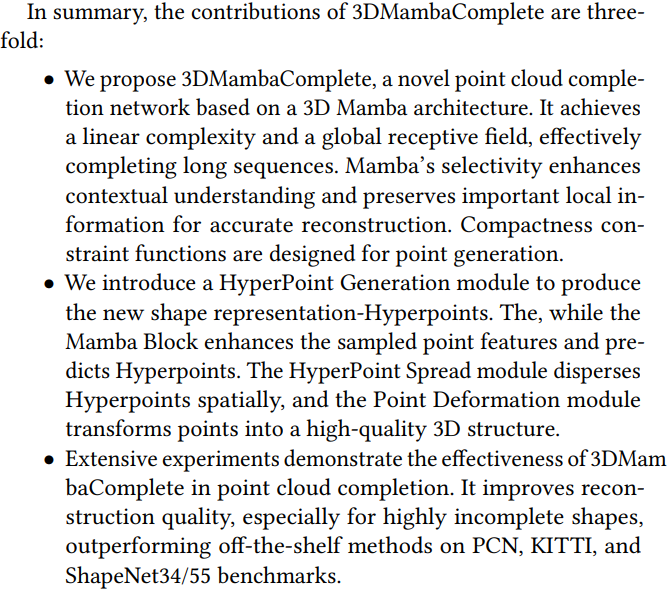

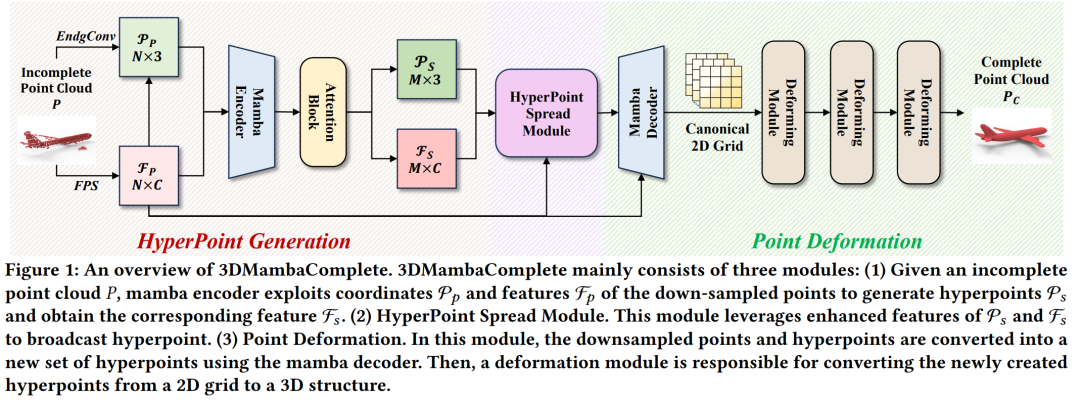

点云完成旨在从最初不完整和低质量的输入中生成完整且高保真度的点云。一种流行的策略是利用基于 Transformer 的模型来编码全局特征并促进重建过程。然而,采用池化操作来获取全局要素表示通常会导致点云内局部细节的丢失。此外,Transformers 固有的注意力机制引入了额外的计算复杂性,使得有效处理长序列变得具有挑战性。为了解决这些问题,我们提出了3DMambaComplete,这是一个建立在新颖的Mamba框架上的点云完成网络。它由三个模块组成:HyperPoint Generation 使用 Manna 的选择机制对点云特征进行编码,并预测一组 Hyperpoints。将估计特定偏移量,并且向下采样的点将成为 HyperPoints。HyperPoint Spread 模块将这些 HyperPoint 分散在不同的空间位置,以避免集中。最后,一种变形方法将超点的二维网格表示转换为细粒度的三维结构,用于点云重建。在各种既定基准上进行的大量实验表明,3DMambaComplete 超越了最先进的点云完成方法,这得到了定性和定量分析的证实。

这篇论文试图解决什么问题?

这篇论文试图解决的问题是点云补全(Point Cloud Completion),即从初始不完整和低质量的输入点云生成一个完整且高保真的点云。具体来说,论文中提到的方法面临的挑战包括:

- 在编码过程中使用池化操作以获取全局特征表示,这常常导致点云内部局部细节的丢失。

- 变压器(Transformer)模型中固有的注意力机制引入了额外的计算复杂性,这使得处理长序列变得具有挑战性。

为了解决这些问题,论文提出了一个基于新颖的Mamba框架的点云补全网络——3DMambaComplete。该网络通过引入结构化状态空间模型(Structured State Space Model)来改善全局感受野和线性复杂度,同时通过Mamba的选择机制增强上下文理解并保留重要局部信息,以实现更准确的重建。

论文如何解决这个问题?

论文提出了一个名为3DMambaComplete的点云补全网络,以解决上述提到的问题。这个网络基于新颖的Mamba框架,并包含以下关键模块和方法来解决问题:

- HyperPoint Generation(超点生成):

- 使用Mamba的选择机制来编码点云特征,并预测一组称为Hyperpoints的超点。

- 通过特定的偏移量估计,将下采样的点转换为Hyperpoints。

- HyperPoint Spread Module(超点分散模块):

- 为了避免Hyperpoints在空间中的集中,将这些超点分散到不同的空间位置。

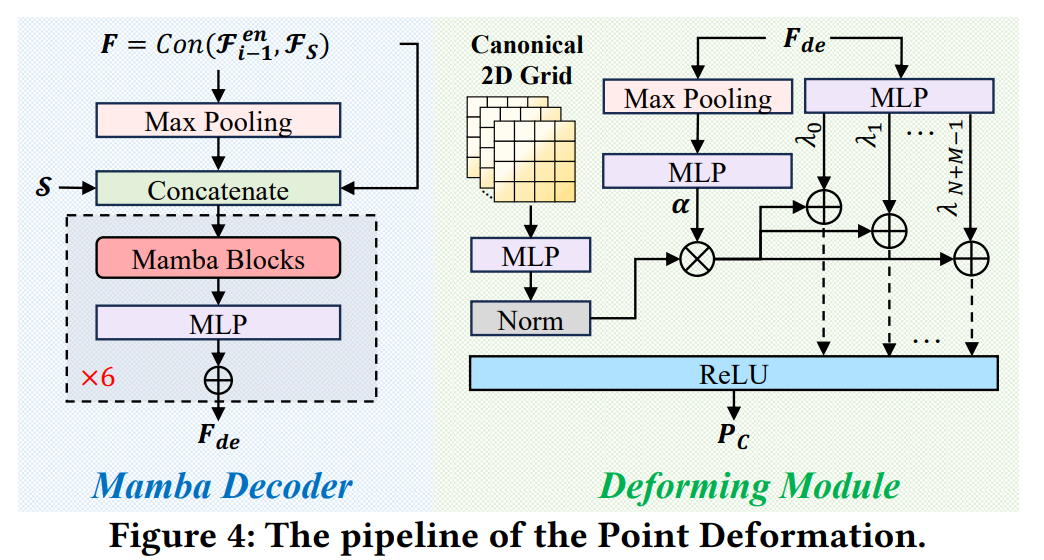

- Point Deformation Module(点变形模块):

- 将2D网格上的Hyperpoints通过特定的变形方法转换为细粒度的3D结构,以便进行点云重建。

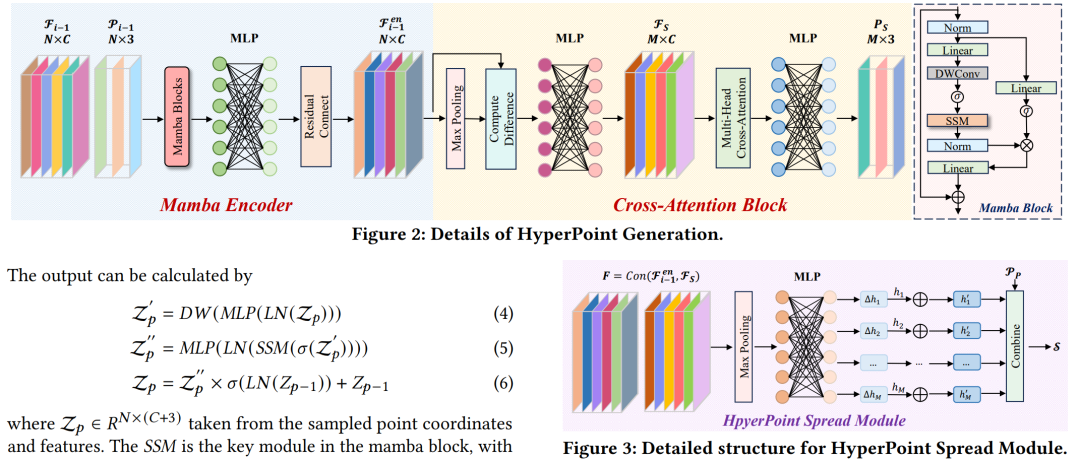

- Mamba Encoder(Mamba编码器):

- 利用Mamba编码器处理下采样点的坐标和特征,以生成Hyperpoints并获取相应的特征。

- Cross-Attention Block(交叉注意力模块):

- 预测超点的坐标和特征,并通过多头交叉注意力机制处理多个输入序列,以更好地处理特征间的关系。

- Deforming Module(变形模块):

- 控制每个超点位置的变形,将全局特征向量从2D网格变形为3D结构。

- Loss Function(损失函数):

- 使用Chamfer Distance(CD)来最小化预测点和真实点之间的距离。

- 构建一个最小生成树并使用约束损失函数来确保空间中补充的点是紧凑的。

通过这些模块和方法,3DMambaComplete能够有效地完成点云补全任务,同时保持局部细节并处理长序列数据。论文通过在多个基准测试上的广泛实验来证明其有效性,并通过定性和定量分析展示了其超越现有最先进方法的性能。

论文的主要内容:

这篇论文的主要内容可以总结如下:

- 问题定义:论文针对点云补全任务,旨在从不完整和低质量的输入点云生成完整且高保真的点云。点云补全在计算机图形学、机器人学和自动驾驶等领域具有重要应用。

- 现有挑战:传统的点云处理方法存在局部细节丢失和计算复杂性高的问题,特别是在处理长序列数据时。Transformer模型虽然在全局特征编码方面表现出色,但其注意力机制的二次复杂度限制了其在点云补全任务中的应用。

- 方法提出:论文提出了3DMambaComplete,一个基于Mamba框架的点云补全网络。该网络包含三个主要模块:HyperPoint Generation、HyperPoint Spread Module和Point Deformation Module,以及一个用于优化的损失函数。

- 关键技术:

- HyperPoint Generation:通过Mamba的选择机制生成Hyperpoints,这些超点能够捕捉点云的关键局部特征。

- HyperPoint Spread Module:分散Hyperpoints以避免在空间中的集中,提高补全质量。

- Point Deformation Module:将2D网格上的Hyperpoints转换为3D结构,以精细地重建点云。

- Mamba Encoder:利用Mamba编码器处理下采样点的特征,增强上下文理解。

- Cross-Attention Block:通过交叉注意力机制预测超点的坐标和特征,处理多个输入序列间的关系。

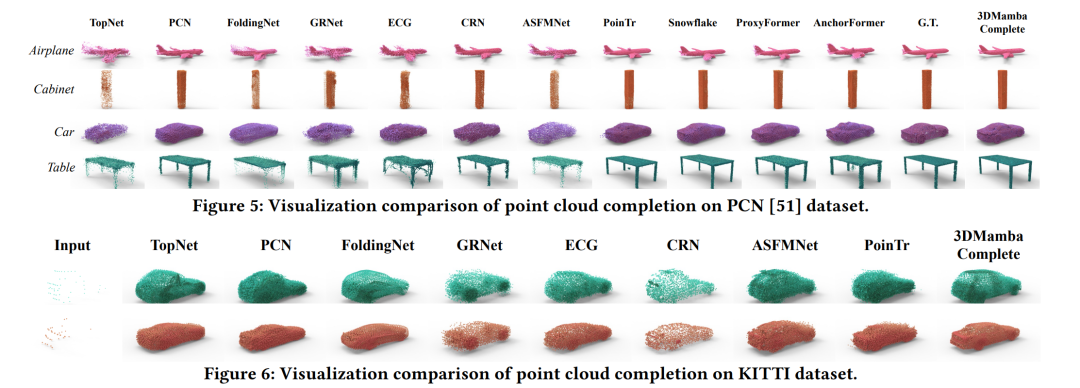

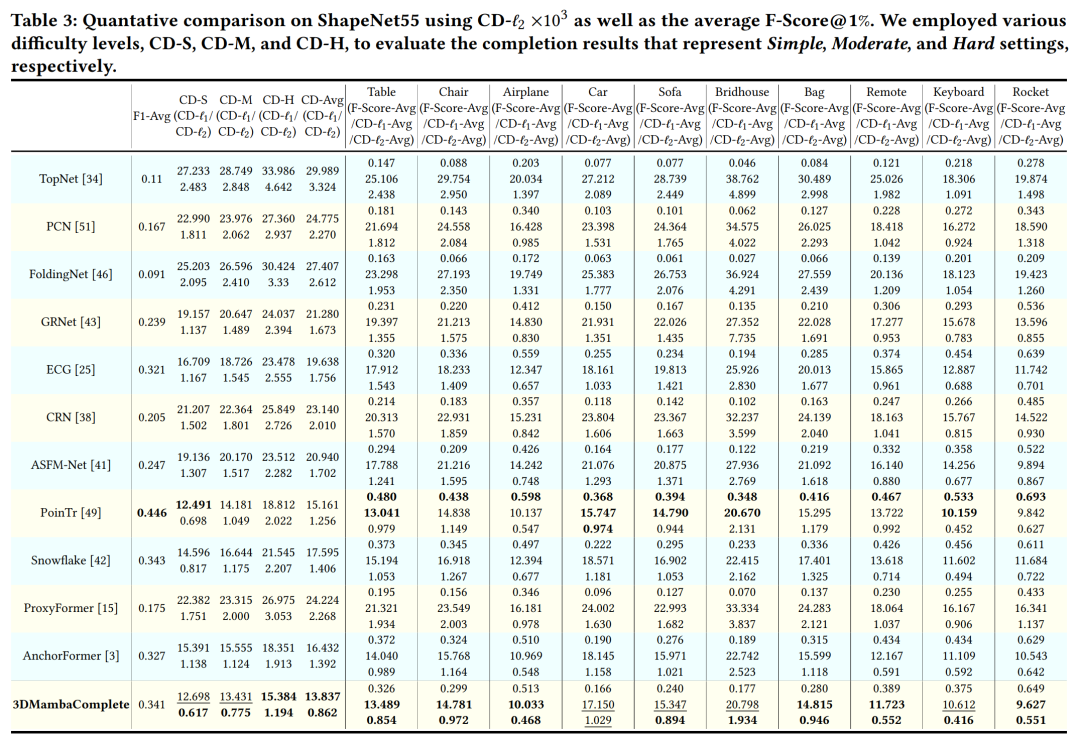

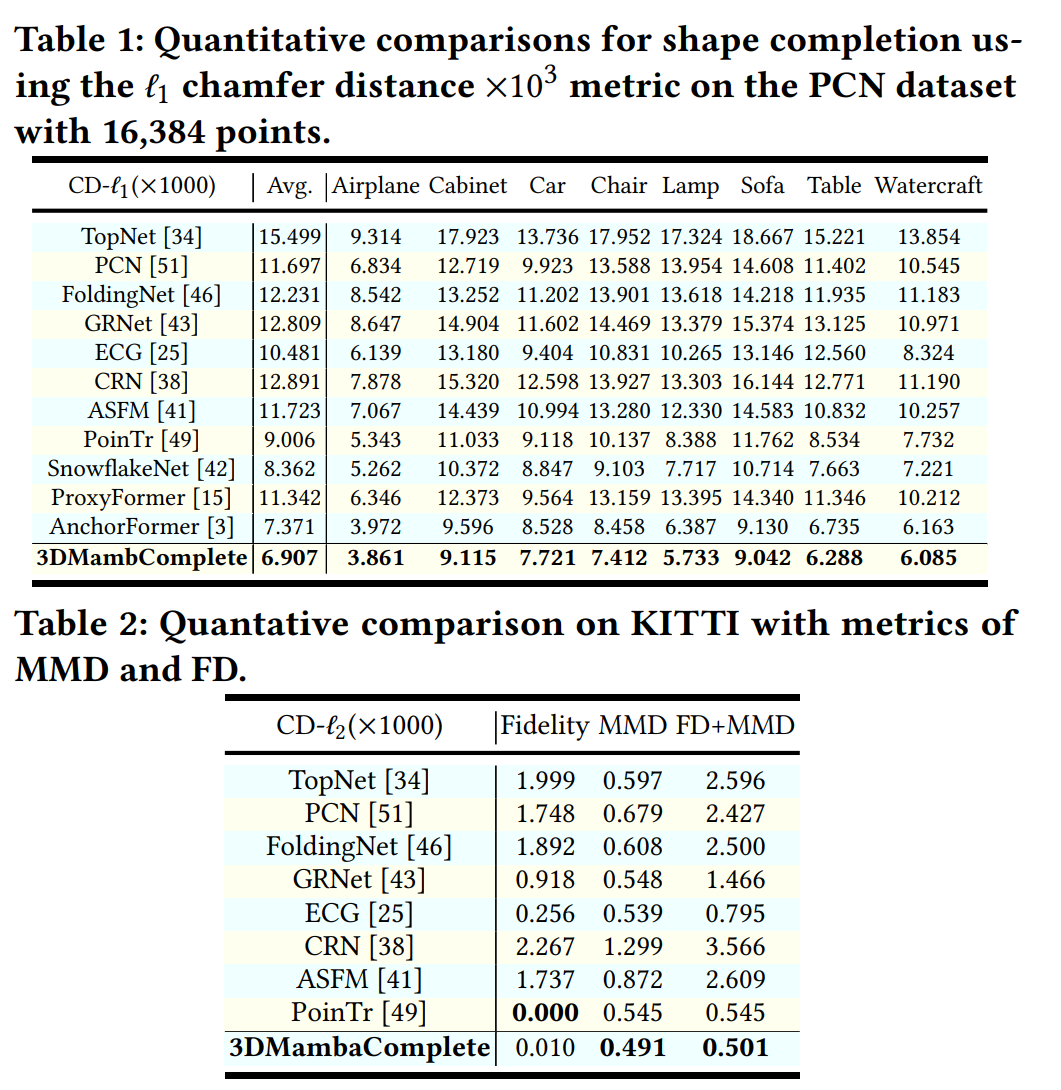

- 实验验证:

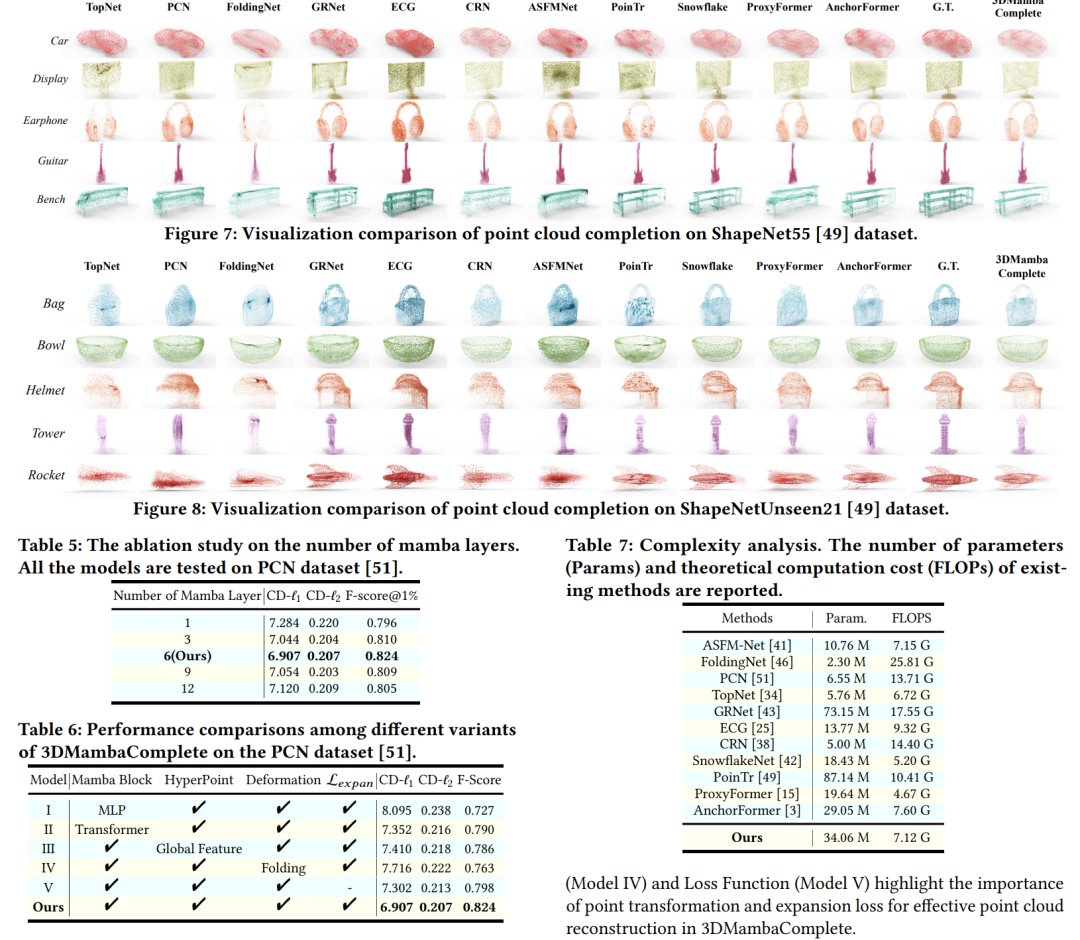

- 论文在多个标准数据集上对3DMambaComplete进行了广泛的实验,包括定量和定性分析。

- 与现有的点云补全方法相比,3DMambaComplete在多个评价指标上取得了更好的性能。

- 消融研究:通过消融研究,论文展示了Mamba层数量、不同模块设计以及模型复杂度对性能的影响。

- 结论:3DMambaComplete通过结合结构化状态空间模型和点云特征,有效地解决了点云补全中的关键挑战,实现了高质量的点云重建。论文的实验结果证明了该方法在点云补全任务上的有效性和优越性。

2.MoCap-to-Visual Domain Adaptation for Efficient Human Mesh Estimation from 2D Keypoints

标题:从二维关键点高效估算人体网格的 MoCap 到视觉域自适应技术

作者:Bedirhan Uguz, Ozhan Suat, Batuhan Karagoz, Emre Akbas

文章链接:https://arxiv.org/abs/2404.07094

项目代码:https://key2mesh.github.io/

摘要:

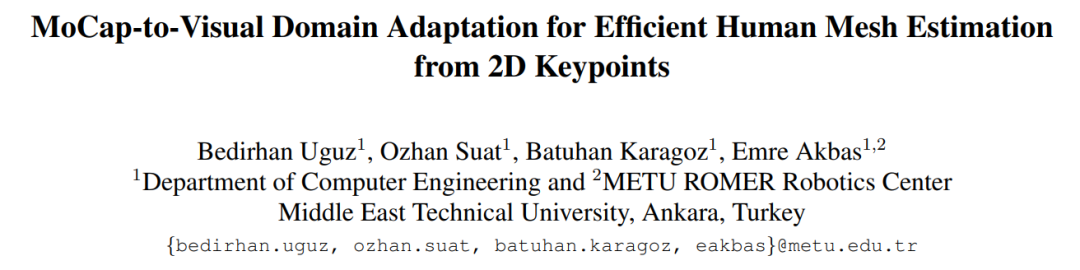

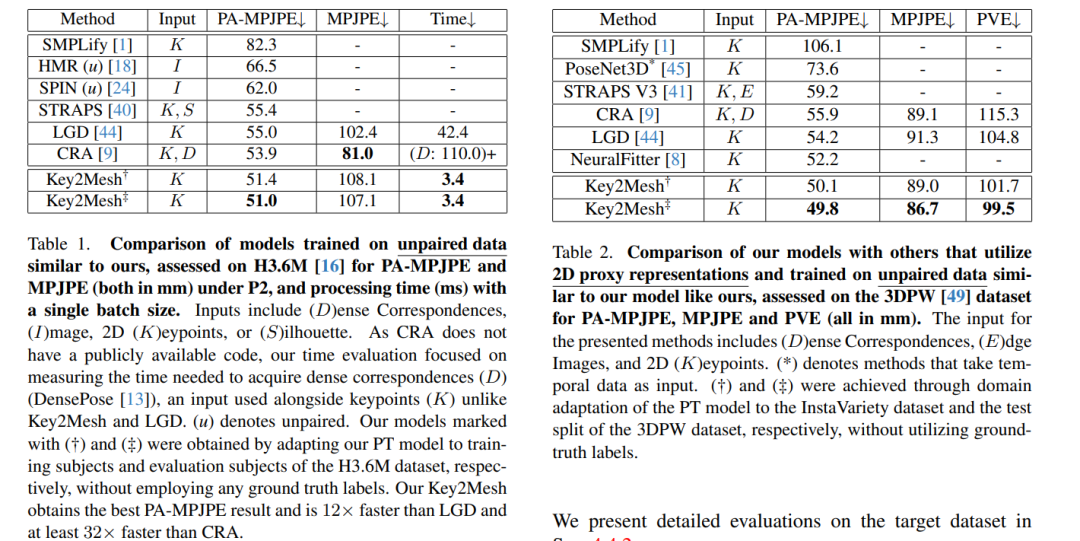

本文介绍了Key2Mesh,这是一个将一组2D人体姿势关键点作为输入并估计相应身体网格的模型。由于此过程不涉及任何视觉(即RGB图像)数据,因此可以在大规模动作捕捉(MoCap)数据集上训练模型,从而克服带有3D标签的图像数据集的稀缺性。为了在RGB图像上启用模型的应用,我们首先运行一个现成的2D姿态估计器来获取2D关键点,然后将这些2D关键点提供给Key2Mesh。为了提高模型在RGB图像上的性能,我们应用了一种对抗性域适应(DA)方法来弥合动作捕捉和视觉域之间的差距。至关重要的是,我们的 DA 方法不需要视觉数据的 3D 标签,这使得无需昂贵的标签即可适应目标集。我们评估了Key2Mesh在没有RGB和网格标签对的情况下从2D关键点估计3D人体网格的任务。我们在广泛使用的 H3.6M 和 3DPW 数据集上的结果表明,Key2Mesh 在 PA-MPJPE 这两个数据集中的表现优于其他模型,在 3DPW 数据集的 MPJPE 和 PVE 中表现优于其他模型,从而设定了新的最先进的水平。由于我们模型的简单架构,它的运行速度至少比之前最先进的模型 LGD 快 12 倍。

这篇论文试图解决什么问题?

这篇论文提出了一个名为Key2Mesh的模型,旨在解决从2D人体姿态关键点估计相应的3D人体网格的问题。具体来说,它关注以下几个关键问题:

- 数据稀缺问题:高质量的3D标注数据集稀缺,获取这类数据成本高昂且具有挑战性,尤其是在野外环境中。

- 数据不匹配问题:现有的基于图像的3D人体姿态和形状估计方法通常依赖于成对的RGB图像和3D标注数据,但这类成对数据难以获取。

- 隐私问题:在某些敏感领域(如医疗领域),收集全图像数据可能会引发隐私问题。

为了解决这些问题,Key2Mesh采用了以下方法:

- 利用大规模的运动捕捉(MoCap)数据集进行训练,这些数据集提供了丰富的3D细节,但不含RGB图像数据。

- 通过对抗性域适应(DA)方法,将在MoCap数据集上训练好的模型适配到视觉领域,而不需要额外的3D标签数据。

- 在推理阶段,首先使用现成的2D姿态估计器从输入图像中提取2D关键点,然后将这些关键点输入到Key2Mesh模型中以估计人体网格。

这种方法允许模型在没有成对3D标签的情况下,从2D关键点估计3D人体姿态和形状,同时解决了数据稀缺和隐私问题。此外,Key2Mesh的简单架构使其运行速度比现有的最先进模型快得多,适用于需要快速处理的应用场景。

论文如何解决这个问题?

论文提出了一个名为Key2Mesh的模型,通过以下步骤解决从2D关键点估计3D人体网格的问题:

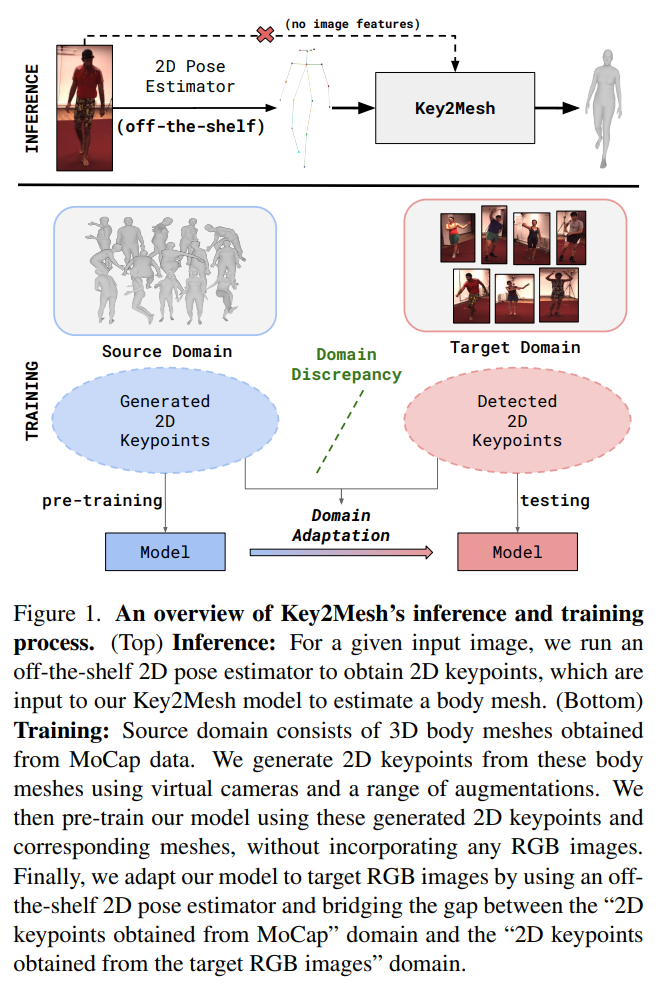

- 利用MoCap数据进行预训练:

- 使用大规模的未配对的运动捕捉(MoCap)数据集,这些数据集提供了丰富的3D人体姿态和形状信息。

- 从MoCap数据中提取2D关键点,并将其作为输入训练Key2Mesh模型,同时使用对应的3D人体网格作为输出。

- 对抗性域适应(DA)方法:

- 为了使模型适应于没有3D标签的RGB图像,论文提出了一种对抗性域适应方法,该方法不需要目标域的3D标签数据。

- 使用现成的2D姿态估计器(如OpenPose)从RGB图像中提取2D关键点,然后将这些关键点输入到预训练的Key2Mesh模型中。

- 通过域批评者(Domain Critic)和对抗性训练,调整模型以适应目标域的特征分布,从而提高在RGB图像上的估计性能。

- 简化的模型架构:

- Key2Mesh模型采用了简单的架构,包括特征提取器和SMPL头(head),并通过单个前向传递实现估计,无需循环或迭代操作。

- 这种设计使得模型在速度上具有显著优势,能够快速处理输入的2D关键点并输出3D人体网格。

- 评估和验证:

- 在H3.6M和3DPW等公开的3D人体姿态和形状估计数据集上评估Key2Mesh模型,使用PA-MPJPE、MPJPE和PVE等指标来衡量模型性能。

- 通过与现有技术的比较,证明了Key2Mesh在准确性和速度方面的优势。

通过这些步骤,Key2Mesh模型能够有效地从2D关键点估计出3D人体网格,同时避免了对成对RGB图像和3D标签数据的依赖,解决了数据稀缺和隐私问题,并提高了模型的运行效率。

论文的主要内容:

这篇论文主要内容的总结如下:

- 问题定义:论文旨在解决从2D关键点估计3D人体网格的问题,特别是在缺乏成对RGB图像和3D标签数据的情况下。

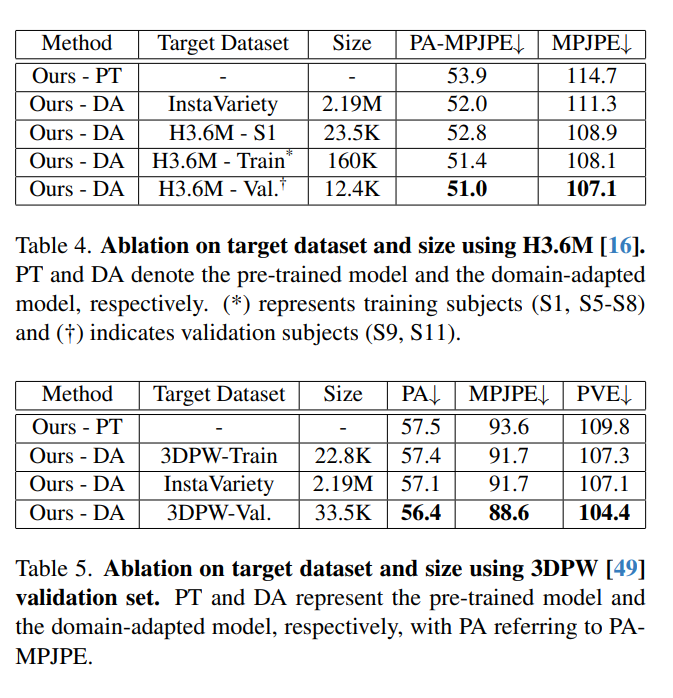

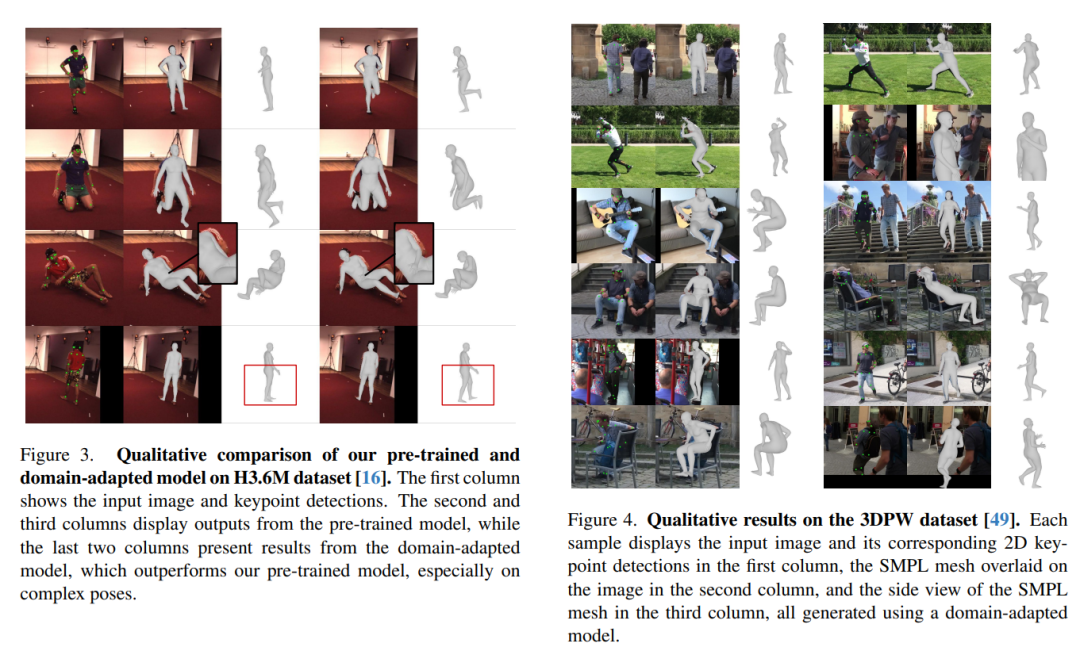

- 方法介绍:提出了Key2Mesh模型,它首先在大规模未配对的MoCap数据集上进行预训练,然后通过对抗性域适应方法适应到RGB图像,无需目标域的3D标签。

- 模型架构:Key2Mesh由特征提取器、SMPL头和域批评者组成,采用简单的前向传递架构,强调了速度和效率。

- 实验评估:在H3.6M和3DPW数据集上对Key2Mesh进行了定量和定性评估,展示了其在准确性和速度方面的优势。

- 消融研究:通过消融实验分析了不同损失项对模型性能的影响,以及目标数据集和大小对域适应效果的影响。

- 相关研究:讨论了与Key2Mesh相关的研究工作,包括3D人体姿态和形状估计、使用2D标签的辅助方法、未配对3D数据的使用、域适应技术等。

- 未来方向:论文指出了未来可能的研究方向,包括多模态数据融合、更复杂的域适应技术、模型泛化能力、实时应用优化等。

3.Implicit Multi-Spectral Transformer: An Lightweight and Effective Visible to Infrared Image Translation Model

标题:隐式多光谱变压器:一种轻量级、高效的可见光到红外图像转换模型

作者:Yijia Chen, Pinghua Chen, Xiangxin Zhou, Yingtie Lei, Ziyang Zhou, Mingxian Li

文章链接:https://arxiv.org/abs/2404.07094

摘要:

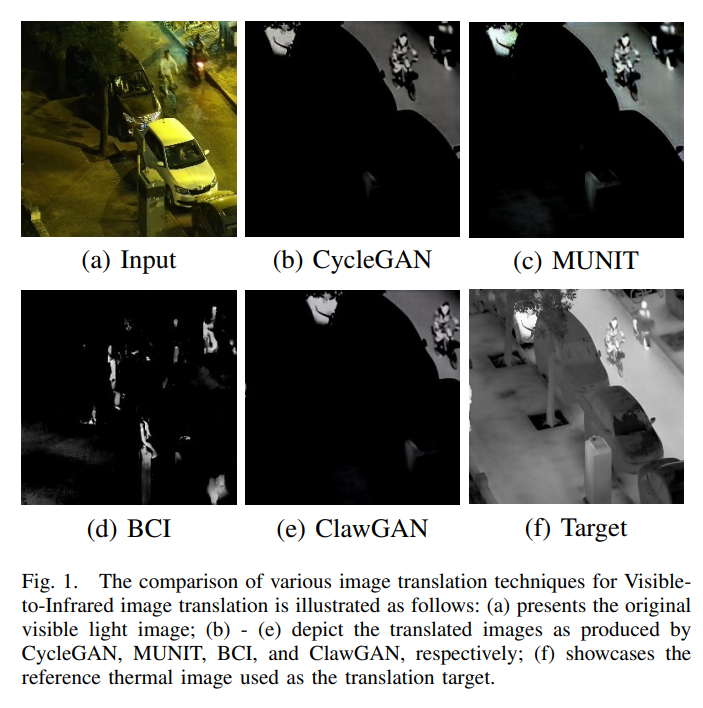

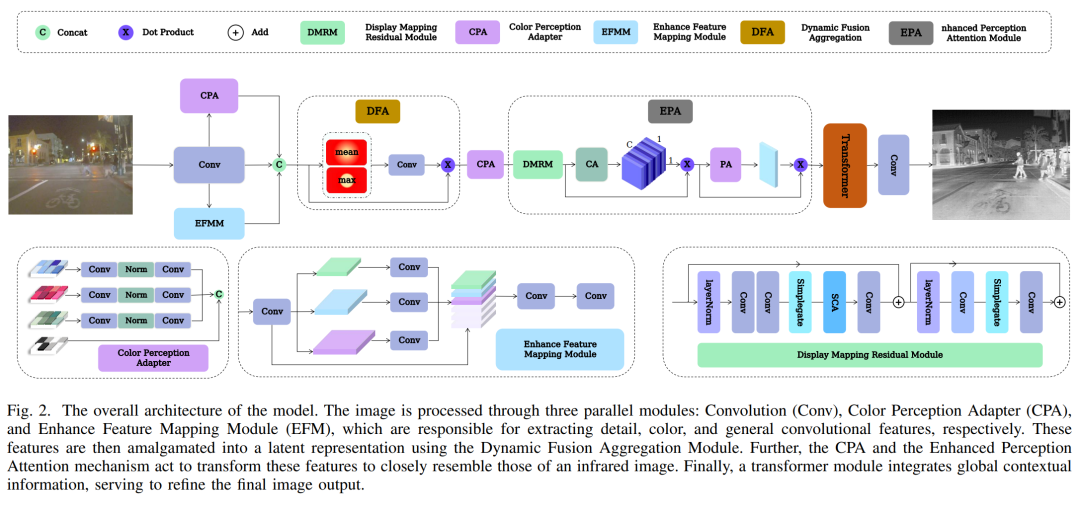

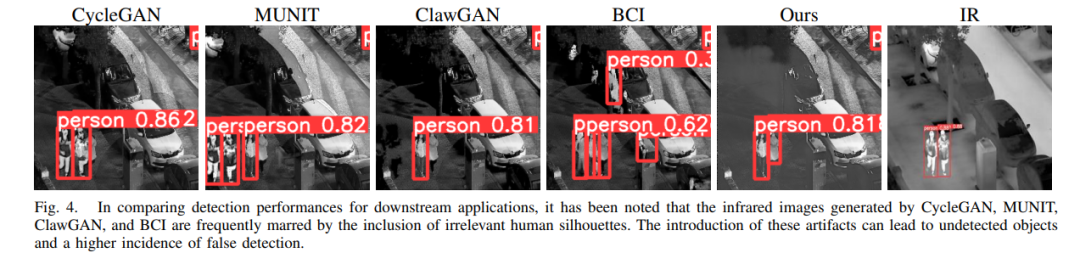

在计算机视觉领域,可见光图像在弱光条件下通常表现出低对比度,这带来了重大挑战。虽然红外图像提供了一种潜在的解决方案,但其利用成本高昂且存在实际局限性。深度学习的最新进展,特别是生成对抗网络 (GAN) 的部署,促进了可见光图像到红外图像的转换。然而,这些方法经常经历不稳定的训练阶段,并可能产生次优输出。为了解决这些问题,我们提出了一种基于Transformer的端到端模型,该模型可以有效地将可见光图像转换为高保真红外图像。最初,纹理映射模块和颜色感知适配器协作从可见光图像中提取纹理和颜色特征。动态融合聚合模块随后集成了这些功能。最后,通过颜色感知适配器和增强感知注意力机制的协同作用,对红外图像的转换进行了细化。全面的基准实验证实,我们的模型优于现有方法,产生的红外图像在定性和定量上都具有明显优越的质量。此外,与其他方法相比,所提出的模型能够更有效地实现红外图像的下游应用。

这篇论文试图解决什么问题?

这篇论文旨在解决在低光照条件下可见光图像对比度低的问题,通过提出一种有效的从可见光图像到红外图像的转换模型。具体来说,它试图解决以下几个问题:

- 可见光图像在低光照条件下对比度低,导致图像质量下降,影响诸如行人检测、自动驾驶、机器人导航等领域的性能。

- 红外图像虽然能够提供更好的对比度和可检测性,但其获取成本高,且存在实际应用中的局限性。

- 现有的基于生成对抗网络(GANs)的方法在进行可见光到红外图像转换时,可能会产生不稳定的训练阶段和次优的输出,如图像中的虚假情况和不规则视觉伪影。

为了解决这些问题,论文提出了一个名为IRFormer的端到端的基于Transformer的模型,该模型能够有效地将可见光图像转换成高质量的红外图像,同时保持较低的计算开销。

论文如何解决这个问题?

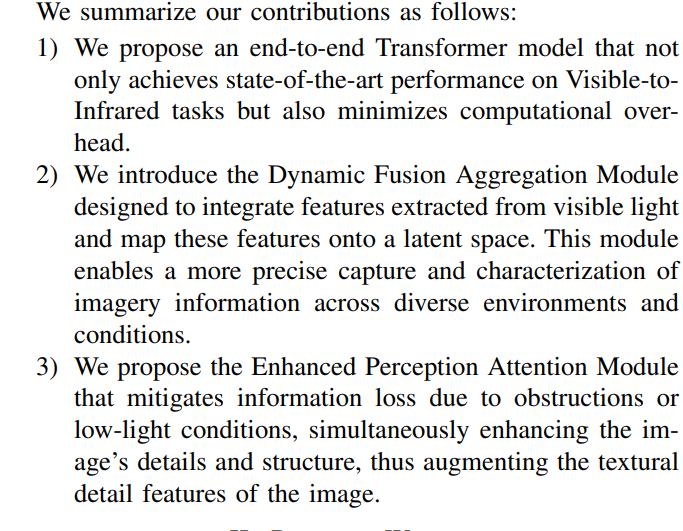

论文提出了一个名为IRFormer的端到端的基于Transformer的模型,以解决可见光图像到红外图像的转换问题。IRFormer模型的解决方案包括以下几个关键组件和步骤:

- 纹理映射模块(Texture Mapping Module) 和 颜色感知适配器(Color Perception Adapter, CPA):这两个模块合作从可见光图像中提取纹理和颜色特征。CPA用于从可见光图像中提取红外颜色特征,这些特征虽然存在但对人眼不可见。

- 动态融合聚合模块(Dynamic Fusion Aggregation Module, DFA):该模块负责将从可见光图像中提取的特征进行整合,并将其映射到一个潜在空间中,以便在可见光和红外图像之间进行有效的转换。

- 增强感知注意力模块(Enhanced Perception Attention Module, EPA):该模块通过双注意力系统(通道注意力和像素注意力)来细化和增强潜在空间的特征集,特别是在低光照或遮挡条件下,以弥补信息损失并增强图像的细节和结构。

- Transformer架构:模型利用Transformer架构来增强前述模块提取的信息的整合,特别是在重建红外图像的过程中,利用Transformer捕捉特征之间的长距离依赖关系。

- 目标函数:为了更好地保留结构信息并增强图像对比度,模型采用了结合平滑L1损失函数和结构相似性指数测量(LSSIM)的双重损失函数策略。

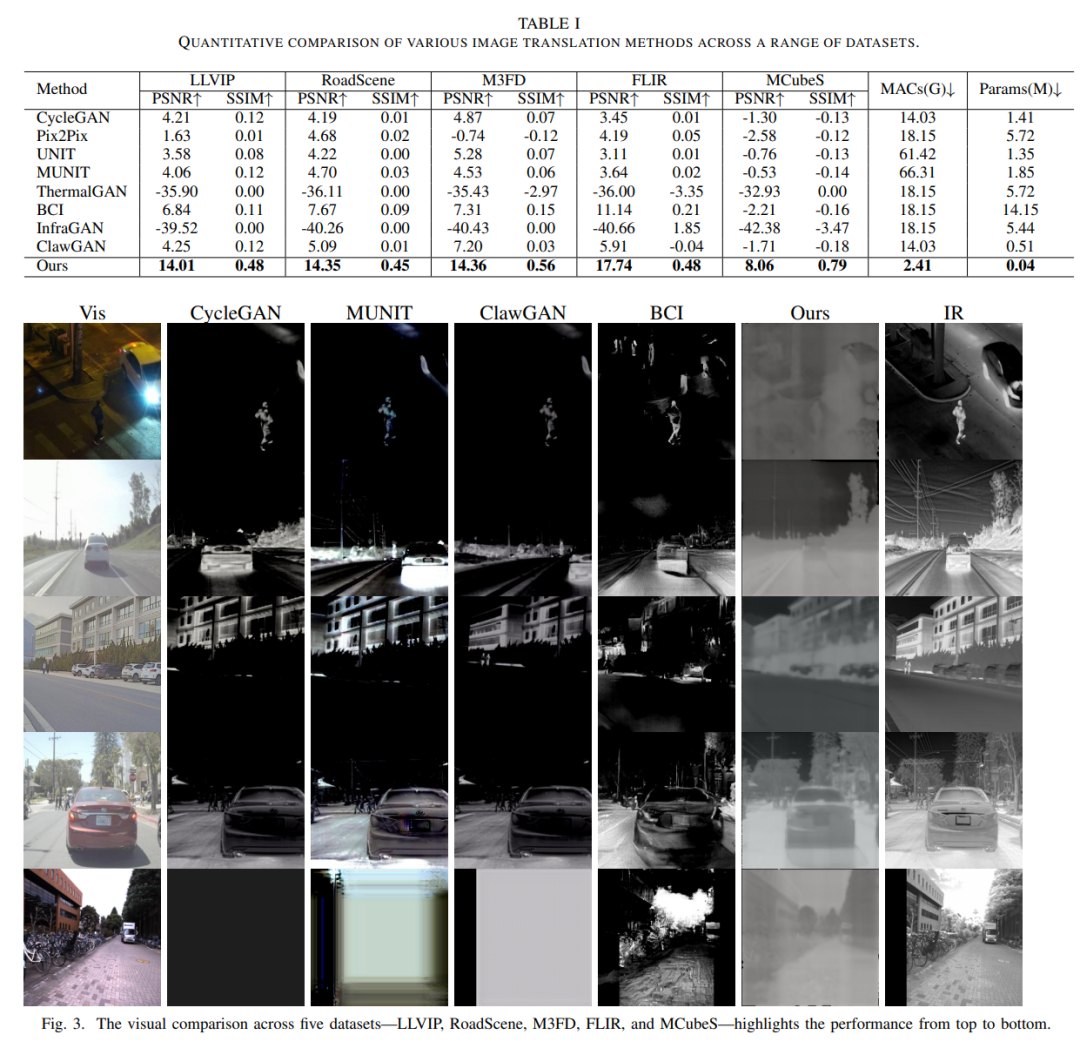

通过这些组件和策略的协同工作,IRFormer模型能够有效地将可见光图像转换成高质量的红外图像,同时保持较低的计算开销。论文通过广泛的基准测试实验来证明模型的性能,包括与其他现有方法的比较,以及在下游应用中的性能评估,如行人检测任务。

论文的主要内容:

这篇论文的主要内容可以总结如下:

- 问题定义:论文针对在低光照条件下可见光图像对比度低的问题,提出了一种有效的从可见光图像到红外图像的转换模型,旨在改善图像质量,特别是在关键的应用领域,如行人检测和自动驾驶。

- 相关工作:论文回顾了图像到图像翻译领域的相关研究,包括Pix2Pix、CycleGAN、UNIT、MUNIT、ThermalGAN、InfraGAN、BCI和ClawGAN等方法,并指出了现有方法的局限性。

- 方法提出:提出了一个名为IRFormer的端到端的基于Transformer的模型,该模型包含纹理映射模块、颜色感知适配器、动态融合聚合模块和增强感知注意力模块,用于高效地转换可见光图像到高保真的红外图像。

- 实验验证:通过在多个数据集上的实验,包括LLVIP、RoadScene、M3FD、FLIR和MCubeS,使用PSNR和SSIM等评估指标,验证了IRFormer模型在生成高质量红外图像方面的优越性。同时,还进行了下游应用评估,如行人检测任务,进一步证明了模型的有效性。

- 消融研究:通过消融实验评估了模型中各个模块的贡献,展示了动态融合聚合模块和增强感知注意力模块对模型性能的重要性。

- 结论与未来工作:论文总结了IRFormer模型在可见光到红外图像转换任务中的有效性,并提出了未来可能的研究方向,如对比度增强、实时性能优化、多模态数据融合等。

总体而言,这篇论文通过提出一种新的模型架构和方法,有效地解决了在特定条件下图像转换的问题,并为未来的研究提供了新的方向和思路。