【他山之石】CVPR 2024 | PeLK:101 x 101 的超大卷积网络,同参数量下反超 ViT!!!

【他山之石】CVPR 2024 | PeLK:101 x 101 的超大卷积网络,同参数量下反超 ViT!!!

“他山之石,可以攻玉”,站在巨人的肩膀才能看得更高,走得更远。在科研的道路上,更需借助东风才能更快前行。为此,我们特别搜集整理了一些实用的代码链接,数据集,软件,编程技巧等,开辟“他山之石”专栏,助你乘风破浪,一路奋勇向前,敬请关注!

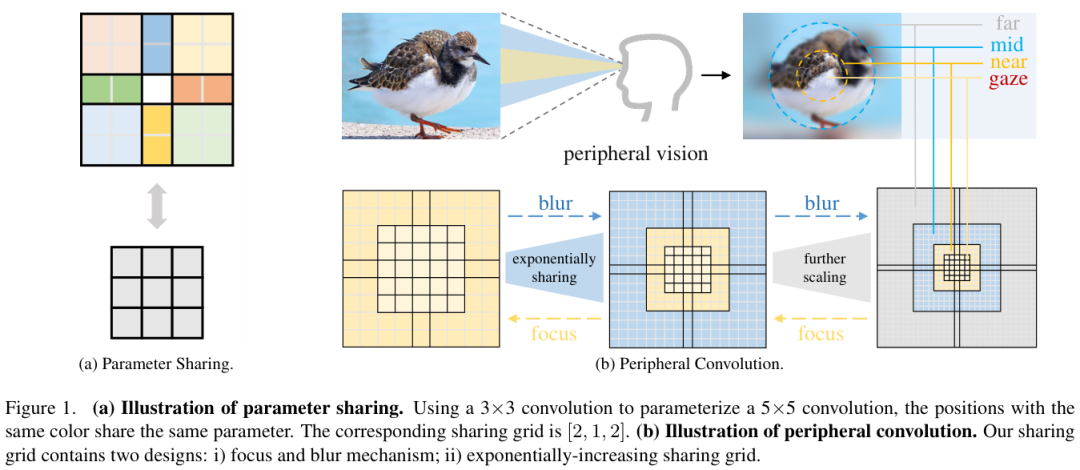

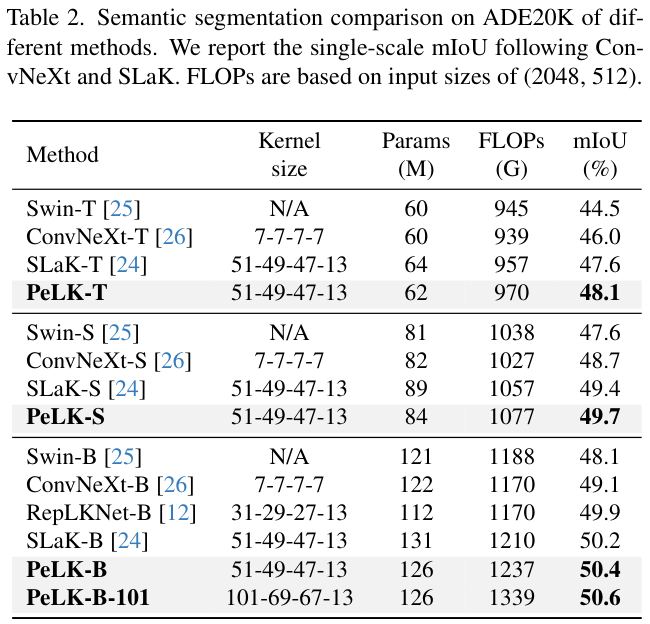

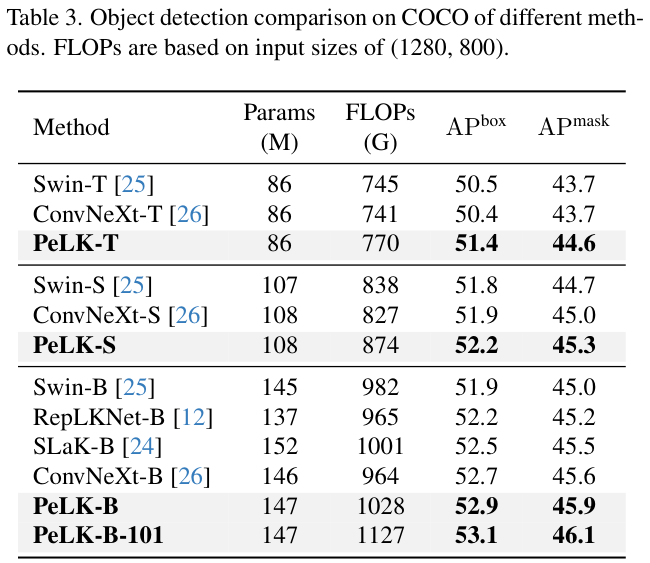

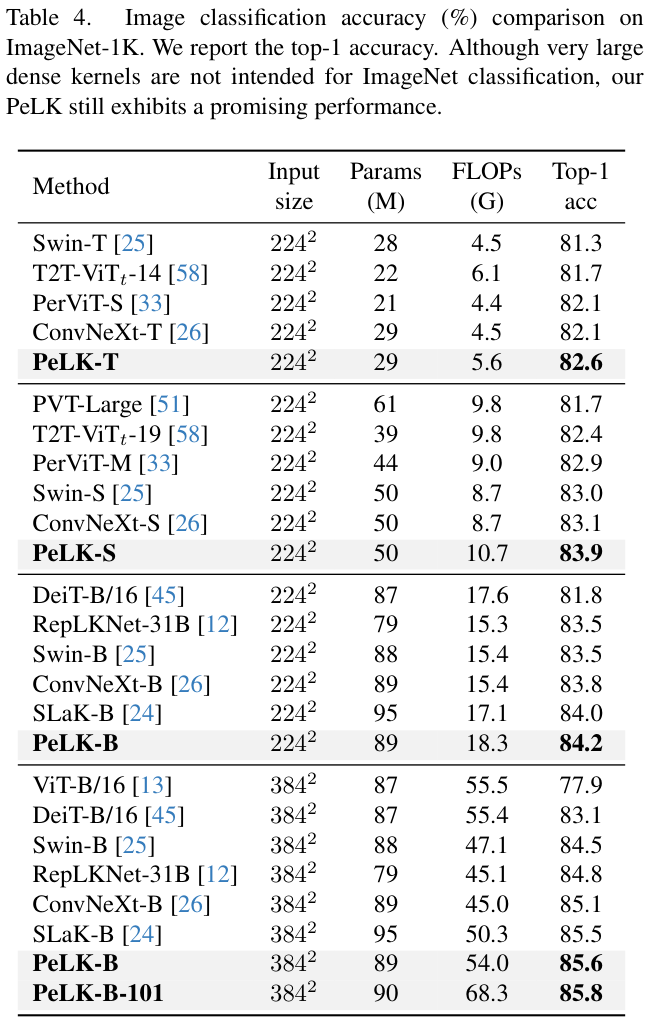

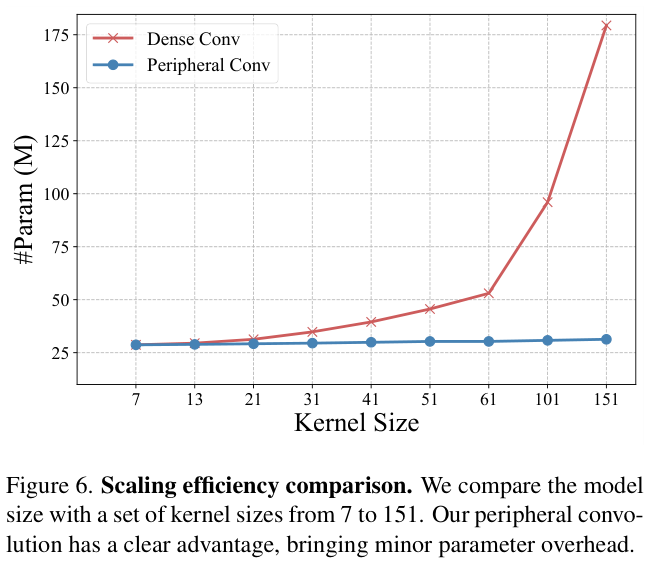

前言最近,有一些大型内核卷积网络的研究,但考虑到卷积的平方复杂度,扩大内核会带来大量的参数,继而引发严重的优化问题。受人类视觉的启发,论文提出了外围卷积,通过参数共享将卷积的复杂性从 降低到 ,有效减少 90% 以上的参数数量并设法将内核尺寸扩大到极限。在此基础上,论文提出了参数高效的大型内核网络(PeLK),将CNN的内核大小扩展到前所未有的,性能的也在持续提升。

论文: PeLK: Parameter-efficient Large Kernel ConvNets with Peripheral Convolution

- 论文地址:https://arxiv.org/abs/2403.07589

Introduction

的强大性能归因于其巨大的感受野,在自注意力机制的帮助下可以从大的空间范围捕获上下文信息并建模远程依赖关系。受此启发,的最新进展表明,当配备大内核(例如

RepLKNet将大内核重参数化为并行的 内核,从而弥补优化问题。SLaK妥协地使用条带卷积将复杂度降低为线性,并扩展到 (即 和 )。- 聚焦和模糊机制。在卷积核的中心区域保留细粒度的独立参数,在外围区域则使用大范围的共享参数。

- 呈指数级增加的共享粒度。共享网格以指数级增长的方式增长,这比固定粒度更有效。

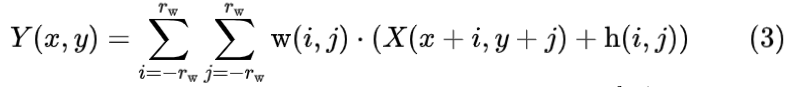

- 内核级位置嵌入。引入内核级位置嵌入,以优雅且廉价的方式解决因大范围的外围共享而导致的细节模糊问题。

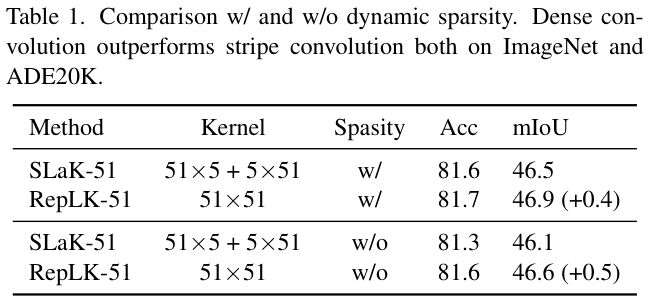

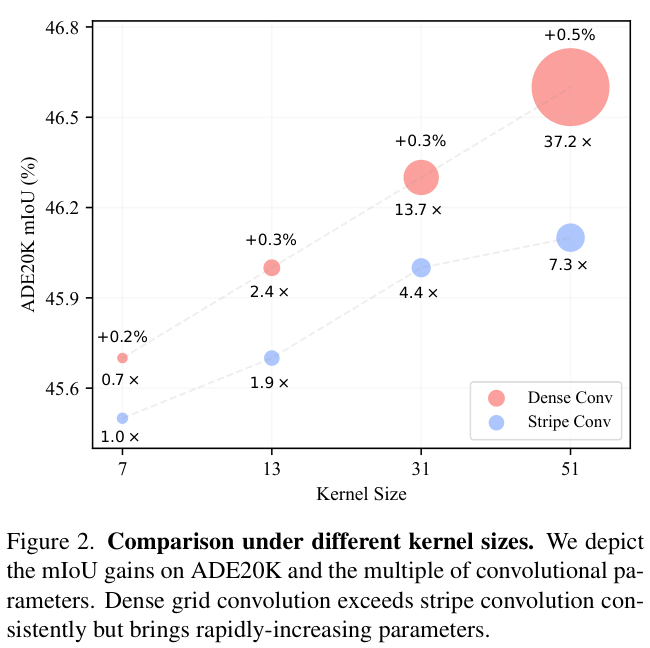

Dense Outperforms Stripe Consistently

论文通过和研究密集网格卷积是否比条纹卷积更好,先在训练得到预训练模型,然后将预训练模型作为

Parameter-efficient Large Kernel Network

Peripheral Convolution

类似于人类的周边视觉,共享网格主要由两个核心设计组成:

- 聚焦和模糊机制。如图 1b 所示,将细粒度参数保留在卷积核的中心区域,其对应共享网格设置为 1 (即不共享)。对于外围区域,利用大范围参数共享来探索外围视觉的空间冗余。

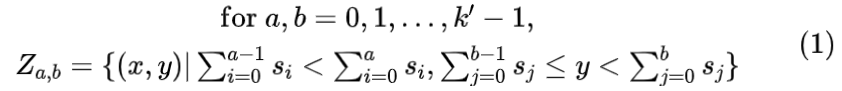

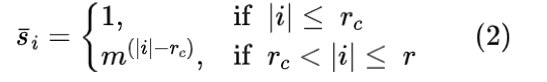

- 呈指数级增加的共享粒度。受人类视觉的启发,论文设计了以指数级的方式增长的共享网格。这种设计可以优雅地将卷积的参数复杂度从 降低到 ,从而可以进一步扩大密集卷积的内核大小。具体来说,共享网格 的构造如下:

其中

是中心细粒度区域的半径,

是指数增长的基数,默认设置为 2。

Kernel-wise Positional Embedding

内核

的半径

Partial Peripheral Convolution

大型内核卷积网络已被证明具有高度通道冗余性,非常适合进行稀疏化。外围卷积使得论文能够设计具有更强空间感知能力的大型密集卷积,因此可以进一步优化大卷积的通道冗余。

最后,将两个分支的输出连接起来以恢复原始形状:

Architecture Specification

- 采用了 4 阶段的框架。

- stem 包含一个 内核和 4 步幅的卷积层。

- 对于

tiny和small/base大小的模型,各阶段的块数量是分别为 和 。 - 不同阶段的内核大小默认为 。对于

PeLK-101,内核大小放大至 。 - 默认情况下,保持中心 区域作为细粒度。对于

PeLK-101,中心区域则放大到 。 - 遵循

SLaK的设计,使用动态稀疏性来增强模型容量,所有超参数设置相同( 网络宽度,40% 稀疏度)。

Experiments

对于目标检测/分割,在上使用

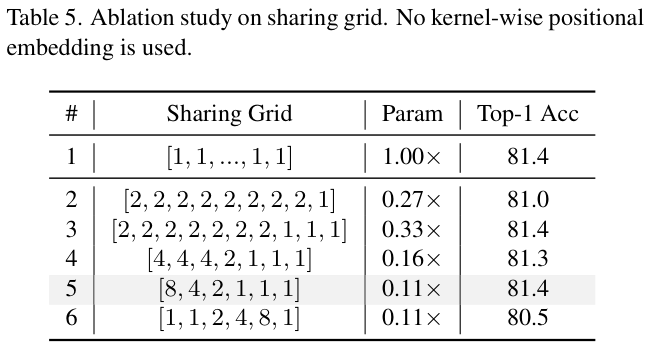

表 5 展示不同共享粒度的性能对比。由于网格是轴对称的,表格中仅表示半个网格。

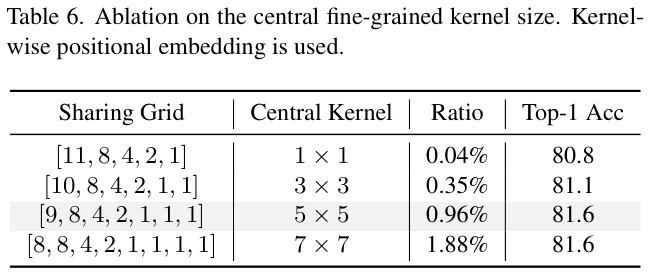

表 6 展示了不同中心细粒度内核大小的性能对比。

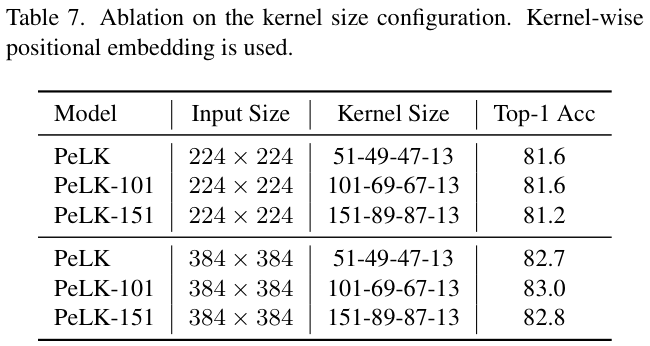

表 7 展示了不同内核大小配置的性能对比。

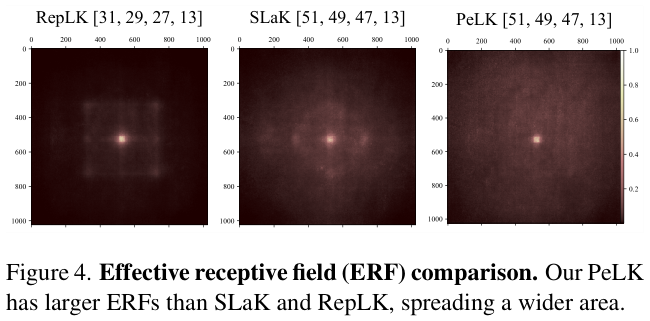

图 4 展示不同模型最后一层对输入图片的感受野对比。

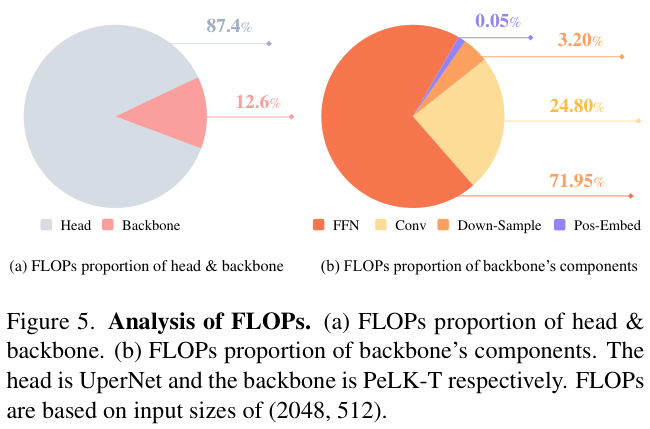

图 5 中对语义分割中使用的架构的

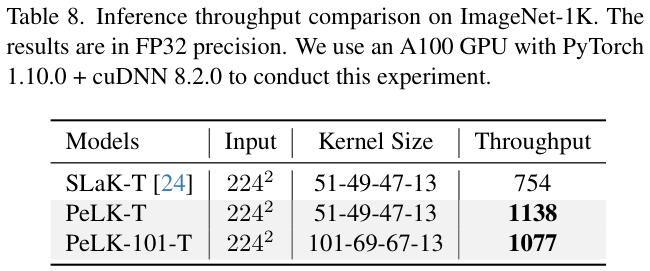

表 8 中比较了推理吞吐量。

图 6 展示了内核缩放对模型参数量的影响。