详细说明了 YOLOv1 到 YOLOv10 背后的基础原理和架构 ,以及探讨实际项目应用!

详细说明了 YOLOv1 到 YOLOv10 背后的基础原理和架构 ,以及探讨实际项目应用!

本研究调查了从 YOLOv1 到最先进的 YOLOv10 等各种YOLO变体在农业进步背景下的变革潜力。 主要目标是阐明这些尖端目标检测模型如何为农业的各个方面注入新活力并优化,从作物监测到牲畜管理。 它旨在实现关键目标,包括识别农业中的当代挑战,对YOLO的逐步进步进行详细评估,并探索其在农业中的具体应用。这是首批包括最新的YOLOv10的调查之一,为人工智能和自动化时代的精准农业和可持续农业实践提供了新的视角。 此外,调查对YOLO的性能进行了批判性分析,综合了现有研究,并预测了未来趋势。 通过审视YOLO变体中蕴含的独特能力及其在现实世界中的应用,本调查为理解YOLO变体与农业之间关系的演变提供了宝贵的见解。 这些发现有助于深入理解精准农业和可持续农业实践的潜力,标志着在农业领域整合先进的目标检测技术的重要一步。

1 Introduction

近年来,计算机视觉与农业的交叉领域取得了显著进展,开启了一个精准农业和农业管理变革的时代。[1]在推动这一范式转变的关键技术中,You Only Look Once(YOLO)算法的演变尤为突出,这是一系列表现出卓越效率和准确性的目标检测器。本文旨在深入探讨主流的YOLO变体,从YOLOv1开始,直至最新的YOLOv10。特别是,此次探索试图揭示YOLO变体在改变农业实践和促进可持续发展方面的潜力。由Joseph Redmon于2015年引入的YOLO目标检测器家族,在目标检测架构目录中标志着一个分水岭时刻。YOLO的独特之处在于它能够通过将输入图像划分为网格矩阵,同时预测边界框和类别概率来进行实时目标检测。[2]这种从传统两阶段方法向单阶段方法的转变显著提高了速度,同时保持了有竞争力的准确性,为后续YOLO迭代奠定了基础。随着YOLO改革的进行,每个变体在引入新颖技术以改善边缘性能的同时,也解决了原有的局限性。从YOLOv1到YOLOv10的转变见证了在架构设计、训练策略和优化技术等多个领域的进步。后来的YOLO变体旨在解决诸如小目标目标、遮挡以及提高不同数据集上的性能等挑战。为了充分理解YOLO变体在农业等复杂子领域中的潜在适用性,理解这些复杂性至关重要。

农业作为一个多方面的领域,需要强大的、高效的工具来进行作物、牲畜和环境的监测和管理。将YOLO变体集成到农业应用中,有望变革诸如作物监测[4]、疾病检测[5]、产量估算[6]和牲畜管理等工作。YOLO提供的实时能力,结合其准确性和适应性,使得YOLO变体成为解决现代农业发展挑战的吸引人解决方案。鉴于农业部门的需求不断增长,计算机视觉因其以下几个原因成为一股变革性力量:

- 规模与精度: 计算机视觉使能的自动化加速了大规模、精确的操作。计算机视觉算法可以促进视觉数据的快速、准确分析,实现对广阔农业景观的以前所未有的速度和精度进行监测。

- 效率与资源优化: 计算机视觉的整合可以提高自动化过程的效率。先进的图像识别和设备端分析可以使资源(如水、肥料和土地)的分配更加合理。这不仅最大化了产量,也促进了可持续的农业实践。

- 实时响应: 计算机视觉有助于实时监测和分析。由计算机视觉驱动的自动化系统可以迅速检测并响应出现的挑战,如疾病爆发或害虫入侵,确保快速、有针对性的干预以减轻潜在损失并保持作物健康。

- 数据驱动的决策制定: 计算机视觉通过提供丰富的实时视觉数据增强了自动化。这种数据驱动的方法可以使农民和利益相关者做出明智的决策,改善农场管理和战略规划。

在本篇综述的后续部分,作者将探讨每个YOLO变体的关键进展,阐明每个变体引入的增强功能。随后,作者将考察YOLO变体在农业中特定的应用和潜在影响,调查这些变体如何为可持续农业实践和农业发展做出贡献。在深入本篇综述的过程中,作者清楚地看到,将代表着尖端计算机视觉技术的YOLO变体与农业景观相结合,有望推动精准农业和资源优化的新时代。

Survey Objective

这篇综述旨在探讨YOLO变体从YOLOv1到最先进的YOLOv10在农业进步领域的变革潜力。总体目标是阐明YOLO家族中的这些最先进架构如何 Reshape 和优化农业的各个方面,从作物监测到牲畜管理。主要关注点是利用YOLO变体的独特能力来适应农业部门面临的动态挑战。具体而言,本综述旨在实现以下目标:

评估YOLO的演变: 作者追踪每个YOLO变体的基本进步,检查架构增强、算法改进和方法创新。通过全面理解YOLO变体的逐步演变,作者可以确认使YOLO适用于各种农业场景的技术进步。

探索YOLO在农业中的应用: 作者接着探讨YOLO变体在农业子领域中的具体应用。这包括调查YOLO已显示出高效率的的实际应用案例,例如作物监测、牲畜追踪和农业景观中异常的检测。通过识别这些应用,作者可以衡量YOLO在应对现代农业的多方面挑战中的多样性。

对YOLO性能的批判性分析: 本文提供了在农业背景下YOLO变体性能的批判性回顾。这包括评估诸如检测准确性、处理速度和对多样化农业环境适应性的指标。通过细致的分析,作者可以确定YOLO在满足农业特定需求方面的优势和局限性。

现有研究的综合: 本调查旨在综合和分析已探讨YOLO变体与农业领域交叉的现有研究。通过整合这些工作的发现,作者可以揭示关键见解并辨别共同趋势,为全面理解当前形势奠定基础。

预测未来趋势: 作者预期未来对于衡量YOLO变体在农业中的影响至关重要的趋势。这一目标涉及从当前研究和技术轨迹外推,预测YOLO在农业领域可能的技术进步、挑战和新兴应用。

简而言之,这篇综述旨在展现YOLO变体与农业之间关系的全面发展,揭示那些承诺引领精准农业和可持续农业实践新时代的创新层面。

Organization of Paper

这篇综述首先描述了农业挑战,接着介绍了卷积神经网络(CNNs),为读者提供了理解YOLO框架原则的基础知识。随后,本文提供了目标检测技术的概述,为后续的讨论建立必要的背景语境。

此外,综述对YOLO架构的发展轨迹进行了全面审查,系统地研究了每个变体引入的修改和增强。

在这次审查之后,本文详细审查了YOLO变体在农业子领域的应用,包括作物疾病、害虫侵扰、资源优化和精准农业。在结论部分,本文详细总结了调查结果,最终对YOLO变体作为农业领域变革性解决方案的全面评估。

2 Convolutional Neural Networks (CNN)

深度学习(DL)在诸如决策树(DT)、支持向量机(SVM)、KMeans、多层感知器(MLP)和人工神经网络(ANN)等各种机器学习(ML)技术流行之际,已成为一个跨多个领域的技术创新。DL是ML的一个子集,也是人工智能(AI)的一个组成部分,在众多领域都取得了显著的成功。其应用包括生物数据处理[7],语音识别[8],字符识别[9],微博[10],文本分类[11],非结构化文本数据挖掘与故障分类[12],基因表达[13],螺栓检测[14, 15],托盘损坏检测[16],自动滑坡检测[17],视频处理,包括字幕生成[18],入侵检测[19]和股市预测[20]。然而,这些例子仅触及了深度学习巨大潜力的皮毛。

在本篇综述的背景下,计算机视觉涉及训练机器在高 Level 上理解和解释视觉内容。这一领域包括诸如目标检测[21],图像恢复,场景或目标识别,姿态和运动估计,目标分割和视频跟踪等子领域[22]。与需要通过定义特征描述符进行手动特征提取的传统图像处理不同,深度学习架构作为自动特征提取器。这使得深度学习成为一个有利可图的替代方案,使研究行人能够克服传统图像处理的限制,更多地关注提高特定应用性能。

深度学习模型包括各种技术,例如用于处理序列数据的循环神经网络(RNNs)及其架构变体,如用于记忆和上下文保留的长短期记忆(LSTM)和门控循环单元(GRU)[23]。卷积神经网络(CNNs)专攻涉及图像数据的视觉感知任务,而其他DL算法如ANNs在面临如图像这样高维输入数据时,在扩展效率上存在问题。

从抽象层面看,卷积神经网络(CNNs)的架构足迹包括一系列卷积、池化和激活函数,它们通过分阶段的过程转换输入以达到适当的输出。

CNN的卷积块中的一个基本组成部分是定义核/滤波器的数量及其相应维度。这对于特征提取至关重要,为后续层提供低级空间信息以建立语义关系[24]。

与ANNs类似,权重()和空间输入()通过点积相乘。引入偏置项()后,应用非线性激活函数()。

方程(1)和(2)分别表示输入的卷积操作。在这些方程中,代表第层的第个神经元的输出。对于文本输入,滤波器大小表示为,而对于视觉输入,和分别表示滤波器的宽度和高度。

卷积后的输出被施加池化以通过聚合提取显著特征,即沿着空间维度进行下采样。

多方面的聚合,即池化框架,是可用的[25],例如平均池化、和池化和最大池化。例如,后者(即最大池化函数)的数学组成用方程3表示。

修正线性单元(ReLU)是在卷积块中广泛使用的激活函数,因为本质上它是一个'max-operation',使其在数学计算上比通过(4)表示的与(5)和(6)分别表示的sigmoid和TanH要轻量级。

抽象CNN的视觉表现如图1所示。CNN的关键组件可以标记为一系列可以优化的滤波器的卷积块,其后是若干个全连接层直至输出[26]。

3 Object Detection

有效目标检测器的发展为研究行人和实践者提出了几项挑战。一个主要的关注点是处理图像分辨率和宽高比的变化,当目标物体在空间尺寸上表现出显著差异时,这一挑战变得更加艰巨。特别是在某些类别难以获得足够图像的场景中,类别不平衡可能会负面影响目标检测器的性能,导致有偏见的预测[27]。

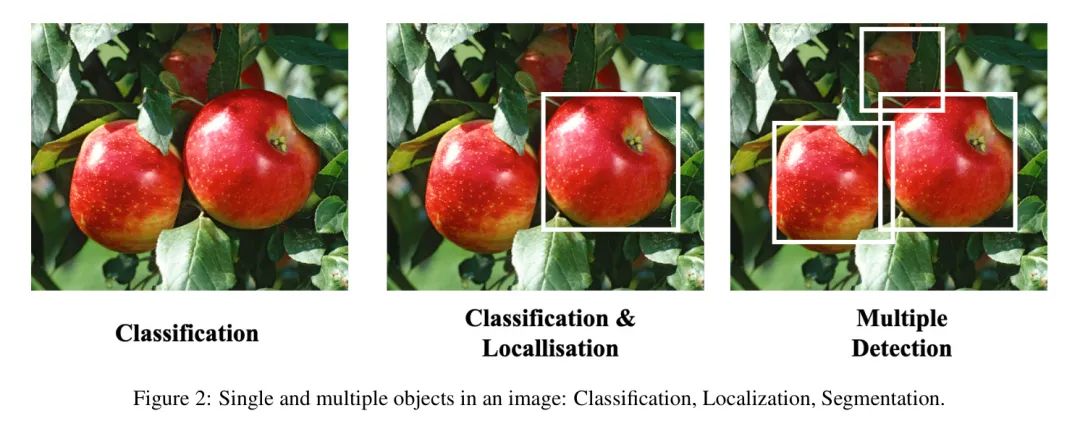

另一个重大挑战在于目标检测架构的计算复杂性,这需要大量的计算资源,包括电力、内存和时间[28, 29]。图2展示了在图像中对单个和多个物体进行检测,描绘了具有深层内部网络的检测器,这些检测器在处理复杂图像数据集和提取关键特征时需要大量的计算资源。目标检测方法可以分为两阶段目标检测器和单阶段检测器。前者在图像中提出候选区域,然后在提出的区域内进行分类和定位。两阶段检测器的例子包括RCNN(基于区域的卷积神经网络)[30],Fast R-CNN[31],Faster R-CNN[32]和FPN(特征金字塔网络)[33]。

RCNN[30]在2014年被提出,使用了选择性搜索来提出候选区域。然后它使用CNN网络进行特征提取,接着使用SVM分类器进行分类和定位。尽管准确,但由于其两阶段过程,RCNN在计算上效率低下。Fast R-CNN[31]通过引入ROI池化来解决效率问题。这种方法使用ROI池化从原始特征图中为每个区域提取固定大小的特征图,从而实现了显著的速度提升。Faster R-CNN[32]通过引入区域 Proposal 网络(RPN)改进了Fast R-CNN,RPN直接从卷积特征图生成区域 Proposal ,省去了单独的 Proposal 阶段。将RPN集成到Fast R-CNN提高了速度和准确性。FPN(特征金字塔网络)[33]通过解决多尺度检测目标的挑战,增强了两阶段检测器。FPN通过合并来自网络不同阶段的具有不同分辨率特征图的特征金字塔,使模型能够有效地检测不同尺度的目标。

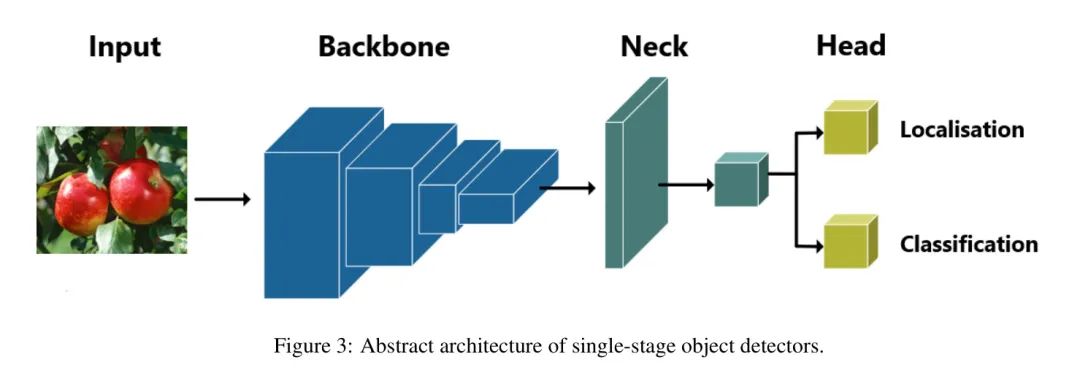

尽管两阶段检测器表现出令人印象深刻的准确性,但它们的高计算需求限制了其应用。单阶段检测器旨在一次性检测物体,消除了对单独区域 Proposal 步骤的需求,如图3所示。值得注意的单阶段检测器包括SSD(单次多框检测器),YOLO变体(You Only Look Once),RefineDet++,DSSD(反卷积单次检测器)和RetinaNet。SSD[34]利用了不同尺度上的多个卷积特征图来预测边界框和类别概率得分。它有效地在一次前向传递中检测各种大小和形状的物体。RefineDet++[35]通过多阶段迭代改进目标 Proposal ,增强了原始RefineDet架构。改进的特征融合机制和细化目标边界提高了准确性。DSSD(反卷积单次检测器)通过反卷积层保留在特征池化过程中丢失的空间信息。这有助于保持空间分辨率,使DSSD能够捕捉到细粒度细节。RetinaNet[36]通过使用Focal Loss解决类别不平衡问题,为难以分类的样本分配更高的权重,提高了架构处理类别不平衡和提高检测性能的能力。

与两阶段检测器相比,单阶段检测器具有更快的推理速度和更轻的足迹,使其适用于资源受限的环境。YOLO已经成为单阶段检测器中的一个强大竞争者,由于其简单的架构,它展示了令人印象深刻的准确性和实时推理能力。它已经在各种实际应用中证明是有效的,展示了其用于生产目的的潜力。

4 YOLO Architecture Background

本节深入探讨了YOLO背后的基础原理和架构,详细说明了每个迭代版本所特有的进展。YOLO算法由Joesph Redmon等人于2015年提出[37],代表“你只需看一次”。这个名字反映了它独特的方法,只需一次检查整张图像来识别物体及其位置。与采用两阶段检测过程的传统方法相比,YOLO将目标检测视为一个回归问题[37]。在YOLO范例中,使用单个卷积神经网络来预测整张图像的边界框和类别概率。这种简化的方法与具有更复杂流程的传统方法不同。

YOLOv1

YOLOv1的核心概念是将一个大小为“s x s”的网格单元叠加在图像上。每当一个物体的中心落在网格单元内,这个特定的单元就负责识别该物体,使得在其他实例多次出现的情况下,其他单元可以忽略其存在。在目标检测方面,每个网格单元预期会有“B”个边界框,包括尺寸和置信度分数。置信度分数表示物体位于指定边界框内的概率。在数学上,置信度分数表示为公式(7):

在此上下文中,表示物体存在的可能性(范围在0到1之间),而表示预测边界框与 GT 之间的交并比。

主要目标是使用边界框准确地识别和定位物体。YOLO通过非最大值抑制(NMS)机制解决预测边界框重叠的挑战,消除那些交并比低于特定阈值的边界框。原始的YOLO架构基于Darknet,推出了两个子变体:一个有24个卷积层,另一个名为'Fast YOLO'的有9层。对于包含物体的边界框和指示物体不存在边界框,分配了不同的惩罚。整体损失函数包括坐标、宽度、高度、置信度分数和类别概率的考虑。

在性能方面,较简单的YOLO版本在每秒45帧(FPS)时达到了63.4%的平均平均精度(mAP),而Fast YOLO变体在每秒155 FPS时达到了52.7%。尽管它们超过了某些实时检测器,但在当时还是未能达到最先进(SOTA)的基准。尽管如此,召回率较低和定位错误等局限性促使在后续YOLO变体中进一步改进。

YOLOv2

在YOLOv1成就的基础上,YOLOv2在设计上带来了显著的增强。这个版本融合了Network-In-Network和VGG的思想,选择了Darknet-19框架,包含19个卷积层和5个专门用于最大池化的层,具体见表1。YOLOv2采用池化层和1x1卷积层的结合,在网络架构内实现下采样。

在目标检测中,一个基本的挑战是标记数据的有限性,常常将方法限制在预定的类别中。YOLOv2通过合并ImageNet和COCO数据集来解决这个问题,将其检测能力扩展到超过9418个目标实例[38]。为了提高可扩展性,YOLOv2采用了Word-Tree,这是一种分层的分类和检测方法,能够有效地处理扩展后的类别数组。

尽管最初在小目标检测上存在困难,但YOLOv2在其前身的基础上取得了重大改进。它引入了多种数据增强技术和优化策略,取得了显著的进步:

- YOLOv2预测一系列尺寸的目标大小,从320x320到608x608,通过丢弃YOLOv1中的全连接层。

- 通过使用更高分辨率的分类器,mAP平均提高了4%。与V1不同,YOLOv2在检测之前先在448x448图像上进行分类训练,提高了边界框预测的准确性。

- 集成批量归一化(Batch Normalization)处理训练期间输入分布的不一致性,大约提高了2%的mAP。

- 通过相对于网格单元位置预测位置坐标,实现了更精确的边界框坐标预测,使得具有更均匀的边界框长宽比和尺寸时,mAP提高了5%。

- YOLOv2使用卷积层进行特征提取,并使用 Anchor 框预测边界框,使召回率提高了7%。

- 采用基于K-means的聚类算法,无需手动选择 Anchor 框,从而提高了准确性。

- 为了解决小目标检测的挑战,融入了来自ResNet启发的跳跃连接,使mAP提高了1%。例如,一个26x26x512的特征图转换为13x13x2048的特征图,与模型的输出连接,使得在各种尺寸下都能更鲁棒地识别目标。

Yolov3

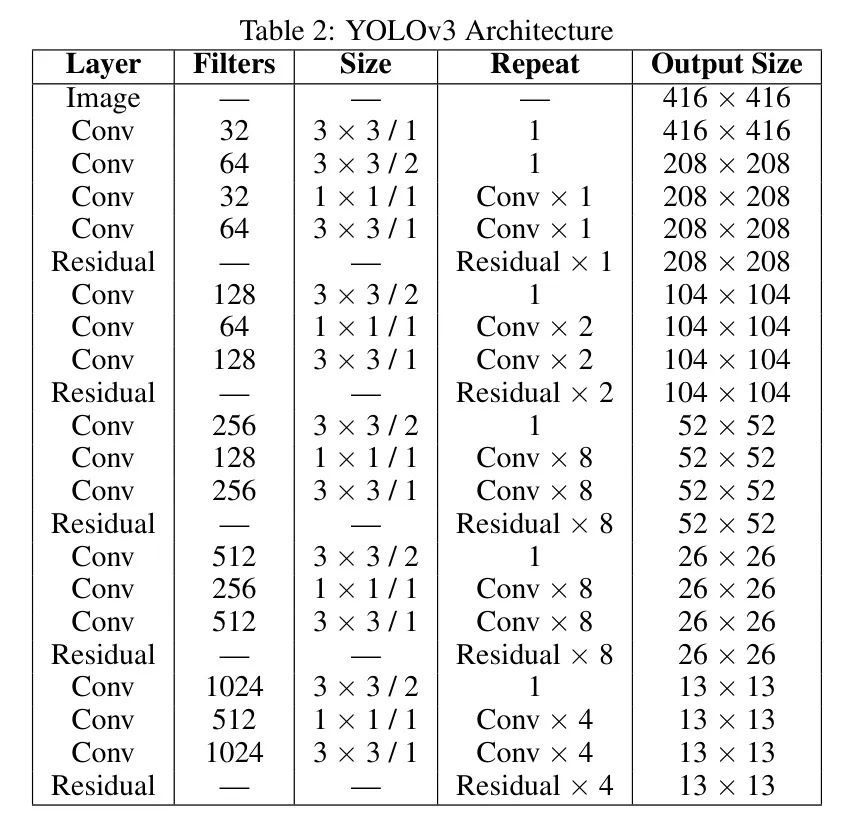

2018年,约瑟夫·雷德蒙等人引入的YOLOv3[39]代表了显著的发展,其扩展架构在表2中有所概述。这一迭代版本在保持实时处理能力的同时,融入了当代技术的进步。与YOLOv2类似,YOLOv3为每个边界框预测四个坐标,但为每个框引入了一个目标性得分,该得分通过逻辑回归确定。这个得分取值为1或0,表示 Anchor 框与 GT 值(1)或其他 Anchor 框(0)的交叠最高。与Faster R-CNN[40]不同,YOLOv3将单个 Anchor 框与每个 GT 目标相关联,而不是使用SoftMax进行分类,YOLOv3采用二元交叉熵,使得可以将多个标签分配给单个框。该架构集成了一个广泛特征提取器,包含53个卷积层并融入残差连接。

重要的改进涉及在主干网络中修改空间金字塔池化(SPP)块以适应更广阔的感受野。YOLOv3将特征图组织成三种尺度:(416×416)、(13×13)、(26×26)和(52×52)以供输入,并在每个位置上为每个尺度配备三个先验框(如图4所示)。总的来说,这些增强使得AP50指标提高了2.7%。通过三种尺度特征图上的K-means算法确定八个先验框。较大尺度的特征图融入较小的先验框。YOLOv3的基础架构被称为Darknet-53,它用步进卷积取代了所有的最大池化层并整合了残差连接。包含53个卷积层的这个主干架构(如表2所详述)成为了目标检测的主要基准,从PASCAL VOC[41]转向了Microsoft COCO[42]。因此,所有后续的YOLO模型都使用MS COCO数据集进行评估。YOLOv3取得了显著成果:平均精度(AP)为36.2%,AP-50为60.6%,处理速度达到每秒20帧(FPS),超过了之前最先进模型的处理速度。

YOLOv4

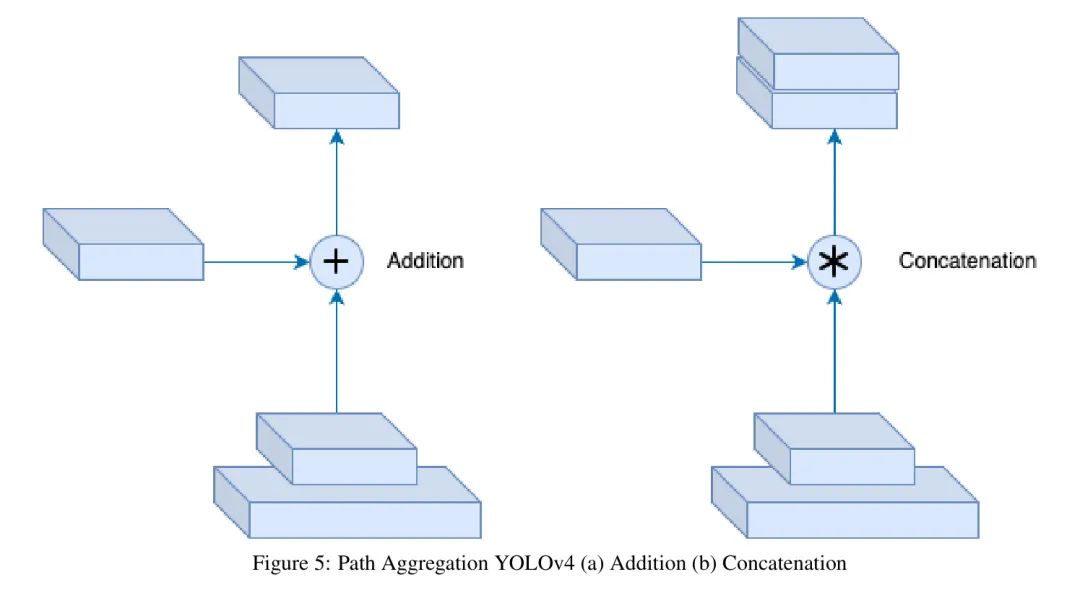

2020年4月,由Alexey Bochkovskiy领导的团队推出了YOLOv4[43],该模型与其前身相比有了深刻的变革,采用了革命性的架构变化,旨在提高性能的同时保持实时处理能力。YOLOv4的关键进展包括整合了CSP Darknet53、SPP结构[44]、PANet架构[45](如图5所示)、CBN整合[46]以及SAM融合[47],从而形成了一个高效且鲁棒的目标检测模型。YOLOv4旨在简化目标检测器的训练,使其易于不同技术水平的个人使用。该研究还验证了诸如bag-of-freebies和bag-of-specials等最先进方法的有效性,以提高训练流程的效率。

与YOLOv3不同,在YOLOv3中,一个单一的 Anchor 点检测一个 GT 值,而YOLOv4为单一 GT 值检测使用多个 Anchor 点。这种方法提高了正样本的选择比例,减少了正负样本之间的不平衡,并提高了边界检测的准确性。

YOLOv4采用了完全交并比(CIoU)损失,如方程(8)所示,通过整合IoU、最大IoU和正则化等因素来提高定位精度。利用这种损失函数增强了YOLOv4在图像中准确定位和描绘物体的能力,从而提高了整体的目标检测性能。

在这里,表示CIoU损失,代表预测的边界框,表示 GT 边界框,IoU计算预测框和真实框之间的交并比,作为最大可能IoU的一个参数,作为一个平衡因子,用于处理小边界框。

YOLOv5

2020年,Glenn Jocher推出了YOLOv5,紧随YOLOv4[46]的发布之后。由Ultralytics管理的YOLOv5在几个关键方面与YOLOv4采取了不同的路径。值得注意的是,YOLOv5选择了PyTorch而不是Darknet进行开发,由于PyTorch的用户友好特性,扩大了其用户基础。YOLOv5融合了多种增强功能,以改善其在目标检测方面的性能。在其核心,YOLOv5采用了来自ResNet架构的CSP(跨阶段部分)网络,包含跨阶段的局部连接以提升网络效率。CSPNet通过多个SPP(空间金字塔池化)块在不同尺度上进行特征提取。

该架构的 Neck 包括一个PAN(路径聚合网络)模块和随后的上采样层,以提升特征图的分辨率[48]。YOLOv5的 Head 利用卷积层预测边界框和类别标签。YOLOv5采用基于 Anchor 点的预测方法,将每个边界框与特定形状和大小的预定 Anchor 框相关联。YOLOv5中的损失函数结合了二元交叉熵和完整交并比(CIoU)用于类别、目标性和定位损失,表示为(9):

其中、和分别表示类别预测的二元交叉熵损失、目标性预测的二元交叉熵损失和定位的CIoU损失。值作为每个损失组件的加权因子。

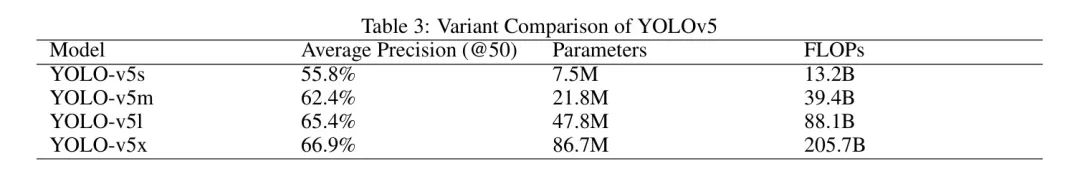

YOLOv5的主要目标是提升效率和准确性,超越其前身。它在特征提取、特征聚合和基于 Anchor 点的预测方面带来了进步。此外,它确保了从PyTorch到ONNX和CoreML框架的无缝过渡,提高了与iOS设备的兼容性。在MS COCO数据集的test-dev 2017划分上的评估中,YOLOv5x在640像素的图像大小下获得了50.7%的平均精度(AP)得分,在NVIDIA V100上以每秒200帧(FPS)的高速度处理。使用更大的1536像素输入大小,YOLOv5获得了更高的55.8%的AP得分,如表3所示。

YOLOv6

由美团视觉AI部门于2022年9月发布,YOLOv6是一个专为工业应用设计的单阶段目标检测框架。这个版本带来了显著的改进和架构上的精炼,特别是引入了CSPDarknet作为新的基础架构,超过了其前身YOLo-v4和YOLo-v5在效率和速度上的基准。YOLO-v6的一个关键增强是集成了特征金字塔网络(FPN),扩展了特征尺度的范围,从而显著提高了检测精度。这强调了提升整体性能的承诺[49]。

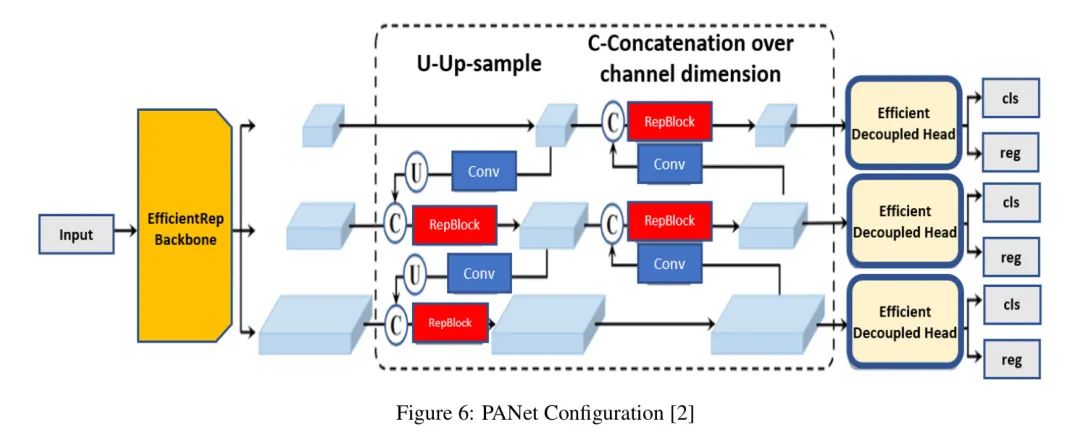

YOLO-v6精心设计以达到最优的实时目标检测性能,在中央处理单元(CPUs)和图形处理单元(GPUs)上均展示了令人印象深刻的帧率。YOLOv6架构中的一个关键演变是将分类和边界框回归头分离,如图6所示。这种策略性的架构修订在网络中引入了额外的层,有效地将这些关键功能从最终的 Head 分离出来[50]。实证证据支持这种改进对提升整个模型性能的影响,加强了其能力[51]。

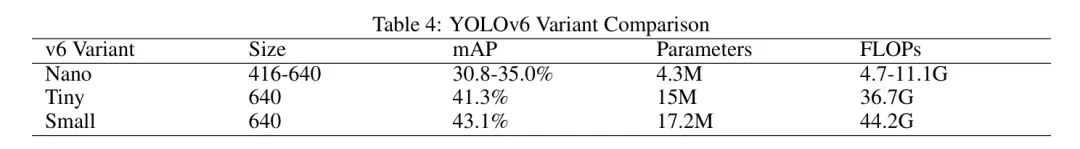

总的来说,YOLOv6在YOLO架构的发展中标志着实质性的进步,融合了范围广泛的增强功能,覆盖了速度、准确性和操作效率。对MS COCO的全面评估表明,YOLOv6在速度和准确性上都取得了显著的成果。相比之下,YOLOv6small在架构复杂性上领先,实现了更高水平的准确性。这种配置特别适合于需要在视觉范围内检测更小物体的场景。这些变体的选择取决于特定的用例和可用的计算资源。YOLOv6nano是低功耗设备上实时检测的理想选择,而在需要更高准确性和检测更小物体的情况下,可能会倾向于选择YOLOv6tiny或YOLOv6small。这个决定应该根据可用的资源和所需的准确性阈值来定制。

YOLOv7

在2022年7月推出的YOLOv7 [52] 与其前身相比有了显著的飞跃,展示了从5 FPS到160 FPS的准确性和速度提升。这些进步主要集中在于通过整合扩展的效率层聚合网络(E-ELAN)[53] 和实施可伸缩的基于拼接的架构来提高效率和可扩展性。E-ELAN在管理梯度路径方面发挥着关键作用,从而增强模型的学习和收敛。这种技术是通用的,适用于具有堆叠计算块的模型,熟练地混合和合并来自不同组别的特征,同时保持梯度路径的完整性。模型缩放是YOLOv7另一个关键方面,它使得可以创建不同大小的模型。所设计的缩放策略均匀地调整块的深度和宽度,在保持最优模型结构的同时减少硬件资源消耗。"自由礼包"(bag-of-freebies)的融合技术进一步增强了YOLOv7的性能。其中一种技术反映了在YOLOv6中使用的重新参数化卷积概念。然而,由于在RepConv [54]中的恒等连接和DenseNet [55]中的拼接存在问题,YOLOv7采用了RepConvN方法。

表4:YOLOv6变体比较

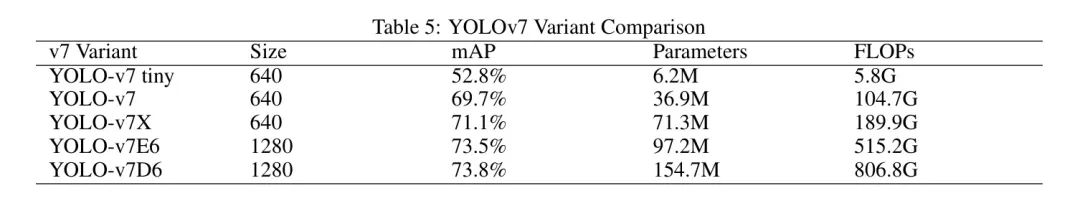

此外,YOLOv7对辅助头使用粗标签分配,而将细标签分配留给主导头。虽然辅助头参与了训练过程,但主导头产生最终的输出,如图6所示。此外,在推理过程中使用了批量归一化,将批量归一化的均值和方差合并到卷积层的偏置和权重中,最终提高了模型性能[56]。在MS COCO数据集的test-dev 2017上进行了严格的评估,YOLOv7E6展示了出色的性能,实现了55.9%的平均精度(AP)和73.5%的IoU阈值为0.5时的AP(AP50),如表5所示。

YOLOv8

2023年1月,Ultralytics推出了YOLOv8,在计算机视觉领域[57]中取得了显著的进展。该模型的精确度通过在COCO和Roboflow 100数据集[57]上的评估得到了广泛验证。YOLOv8以用户友好为特色,包括易于使用的命令行界面和结构化的Python包。热情的YOLO社区进一步提高了用户对模型的可达性。根据其方法论细节[58],YOLOv8的创新之处在于它摒弃了传统的基于 Anchor 框的方法。YOLOv8不是依赖于预定的 Anchor 框,而是采用 Anchor-Free 框方法,通过预测物体的中心点。这种调整解决了 Anchor 框可能无法准确表示自定义数据集分布的问题。这种方法的优势包括减少了框预测的数量以及加快了非最大抑制的后处理步骤。值得注意的是,YOLOv8的训练例程,包括在线图像增强技术,如马赛克增强,提高了模型在不同条件和新型空间排列下检测物体的能力。

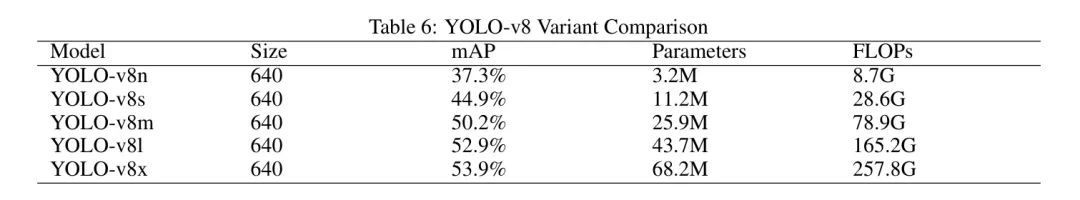

在其前身YOLOv5(同样由同一批作者开发)的结构演进中,YOLOv8在其各个组成部分中引入了变化。例如,在 Neck 段,YOLOv8直接连接特征,而不强制统一通道尺寸。这种策略有助于减少参数数量和总体张量大小。在MS COCO数据集的test-dev 2017子集上评估时,YOLOv8x在640像素的图像大小下,平均精度(AP)达到了53.9%,超过了相同输入尺寸下YOLOv5的50.7%的AP。此外,YOLOv8x在使用NVIDIA A100和TensorRT时,展现出了卓越的处理速度,达到了每秒280帧(FPS)。值得注意的是,YOLOv8有五种不同的变体,每种变体都针对特定的准确性和计算需求进行了定制,具体细节见表6。

YOLOv9

YOLOv9,在2024年2月发布[59],成为主流YOLO变体的最新成员。YOLOv9拥有两项关键创新:可编程梯度信息(PGI)框架和通用高效层聚合网络(GELAN)。PGI框架旨在解决深度神经网络固有的信息瓶颈问题,同时使深度监督机制与轻量级架构兼容。通过实施PGI,轻量级和深度架构都可以在准确性上获得实质性提升,因为PGI在训练期间要求可靠的梯度信息,从而增强了架构的学习能力和准确预测的能力。

表5:YOLOv7变体比较配置,使其适合在不同的推理设备上部署,包括资源受限的边缘设备。结合上述两个框架(PGI和GELAN),YOLOv9在轻量级目标检测方面取得了重大进步。尽管YOLOv9问世不久,但在目标检测任务中已经显示出显著的竞争力,在参数减少和计算效率方面优于YOLOv8,同时在MS COCO数据集上的平均精度(AP)提高了0.6%。

GELAN架构是有意设计的,旨在通过高效率和轻量级足迹来提升目标检测任务的性能。GELAN在各种计算块和深度方面表现出高性能

YOLOv10

在YOLO系列的创新势头的基础上,同一年又出现了另一个开创性发展,即2024年发布的YOLOv10。这个版本进一步推动了实时目标检测的边界,这对于需要快速准确响应的应用至关重要,如农业监测和自动驾驶导航。

YOLOv10通过在后期处理中完全取消对非最大值抑制(NMS)的依赖而与众不同,这是提高推理速度的一个重大进步。这个模型采用了一种新颖的无需NMS的训练方法,使用双重标签分配,确保模型在保持计算效率的同时捕获必要的检测特征,从而和谐地整合准确性和速度。此外,YOLOv10在架构上的增强包括实施轻量级分类头、空间通道解耦降采样和排名引导的块设计,这些都有助于大幅降低计算需求和参数数量。这些创新不仅提高了模型的效率,还使其在各种设备上的可扩展性得到增强,从高性能服务器到资源有限的边缘设备。

广泛测试表明,YOLOv10在性能效率权衡上树立了新的基准。与YOLOv9相比,它在延迟和模型尺寸减小方面取得了显著改进,同时仍提供竞争性或更优的检测精度。这在应用于COCO数据集时尤为明显,YOLOv10在检测指标上显示出显著进步,巩固了其在实时目标检测技术领域的领导者地位[60]。

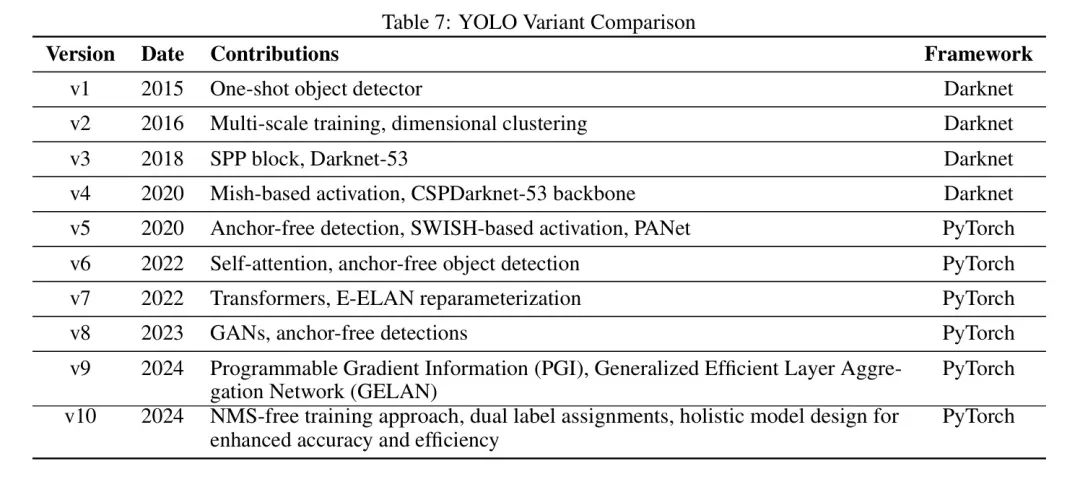

表7提供了截至当前日期主要YOLO变体的比较概述。该表展示了YOLO系列目标检测器的迭代演变,每次迭代都推动了计算机视觉的前沿技术。

5 Agricultural Applications of YOLO

在本节中,作者全面回顾了当前文献中关于不同YOLO变体在农业应用中的利用情况。讨论专门包括如下应用:杂草检测、作物分类、疾病检测、动物追踪和精准农业。

使用YOLO进行杂草检测

杂草检测是现代农业的关键方面,因为它直接影响作物产量和资源优化。传统的杂草管理方法可能劳动强度大且耗时。将YOLO变体集成到杂草检测中,提供了一个有前景的解决方案,它通过实时高效地识别农业景观中的杂草来推进这一过程。

本小节探讨了YOLO在杂草检测中的应用,重点关注其变革杂草管理实践的潜力。作者深入探讨了传统农业中杂草检测的挑战,并检查了YOLO变体是如何解决这些挑战的。此外,作者还探讨了YOLO在实际场景中准确识别和定位杂草的效力,从而推动了精准农业的进步。

[61] 开发并实施了一个针对葱类作物的实时杂草检测系统。利用YOLOv3深度学习算法,这个被称为YOLO-WEED的系统在由无人机(UAVs)捕获的视频帧中显示出显著的效率和精确度[61]。这使得YOLO-WEED成为精准农业活动,如针对性喷洒和杂草管理的宝贵资产。系统的性能评估基于平均精度均值和F1分数指标,取得了令人印象深刻的结果,平均精度均值为93.81%,F1分数为0.94。YOLO-WEED系统的显著优势和准确性使它成为实时自动化空中喷洒系统无缝集成的有希望的候选者,特别是针对葱类田地[61]。然而,重要的是要承认某些局限性。系统的有效性取决于无人机视频帧的分辨率。特别是,系统中使用的YOLOv3算法在检测较小物体时遇到挑战,这导致在葱类田地中识别微小杂草存在困难[61]。此外,YOLO-WEED系统需要机上计算机的存在,这为无人机喷洒系统增加了额外的重量因素。尽管如此考虑,系统的整体性能凸显了其在推进精准农业实践方面的潜力,特别是在葱类种植中杂草检测和控制方面。

应博宇等研究行人使用改进的YOLOv4模型对胡萝卜田中的杂草进行了一项细致的研究[62]。研究行人在中国中部河南省的胡萝卜田收集了测试图像,旨在检测四种常见田间杂草:马唐、车前草、稗草和东风菜。他们开发了一个轻量级的杂草检测模型YOLOv4-weeds,用MobileNetV3-Small替换了YOLOv4的主干网络。这项修改减少了图像处理的内存需求,并提高了复杂环境中小型杂草检测的效率和准确性。作者与其他检测模型进行了比较实验,并证明YOLOv4-weeds模型在这些模型中表现最佳,尤其是在复杂田间场景中检测不同杂草。研究成果为农业环境中的杂草检测、机器人除草和选择性喷洒提供了有价值的见解和参考。然而,研究存在潜在局限性,例如杂草种类的多样性、对其他作物的泛化能力、对环境变异的鲁棒性、实际部署和验证以及对计算资源的考虑。这些发现对农业部门有重大影响,因为杂草管理对作物产量和质量至关重要。该研究为在复杂农业环境中改进杂草检测提供了一个框架,可能导致高效且成本有效的杂草管理实践。然而,需要进一步研究来解决研究的局限性,并增强这些发现对其他作物和环境设置的泛化能力。

戴尔曼等人进行了一项研究,重点关注利用基于相机的监测系统[63]沿国家道路识别和追踪入侵性外来植物物种(IAPS),如图7所示。所采用的深度学习算法成功地在收集的图像中检测和分类了IAPS,证明了在110公里/小时的驾驶速度下实时绘制入侵性外来植物物种地图的潜力。尽管取得了显著成就,但研究承认存在某些局限性,例如在检测特定植物物种如羽扇豆和多叶款冬时遇到的挑战,并强调未来研究需要解决这些问题。该研究为路边环境的有效保护提供了有价值的见解。

陈等人专注于为芝麻田开发一种YOLO-芝麻模型[64]进行杂草检测。该模型融合了改进的注意力机制和特征融合,在帧率(FPS)和平均精度(mAP)方面表现出高性能。尽管展示了有希望的结果,但研究强调了数据集中的区域特异性,并强调需要进一步工作以提高模型在嵌入式设备上的适用性。这项工作有助于推进芝麻种植中杂草检测方法的发展。

王等人在中国河北省张家口市进行了田间试验,以测试他们的方法在实际应用中的效果[65]。该研究的技术在图像预处理和部署改进的YOLOv5卷积神经网络(CNN)方面,在实际场景中表现出令人满意的性能。尽管取得了显著成就,但研究认识到与环境影响相关的局限性,并强调解决这些挑战的重要性以扩大适用范围。

该研究有助于推进杂草检测方法的发展,并可能对早期识别入侵性杂草产生影响。

科斯特洛等人研究了在受控环境中使用RGB和HSI数据对银胶菊杂草进行田地绘图[66]。采用包括基于决策树的协议在内的深度学习算法,研究在检测和分类银胶菊杂草生长阶段方面取得了高准确性。然而,研究承认了局限性,如受控环境,并强调需要进一步探索AI算法和技术改进以增强检测成功率。这项研究为AI和成像技术在银胶菊杂草检测中的应用提供了宝贵的见解,可能对杂草管理和农业产生影响。

当等人引入了YOLOWeeds基准数据集,用于检测棉花生产系统中的各种杂草类型[67]。评估了六种不同的YOLO目标检测模型,研究提供了一个详细的实验设置,强调棉花生产中杂草管理的挑战。结果显示了YOLOv4和YOLOv5在实时杂草检测方面的潜力,促使进一步探索基于机器视觉的除草系统。这项工作有助于推进自动化杂草识别的发展,并可能应用于农业中可持续的杂草管理。

佩雷斯-波拉斯等人进行了一项研究,利用YOLO架构在小麦田中检测罂粟(Papaver rhoeas)[68]。评估了不同的YOLO模型,研究优化了超参数并评估了计算效率。尽管实现了大约75%的准确率,但研究承认需要进行现场验证并与农业实践相结合。这项研究为农业田地中早期杂草检测提供了宝贵的见解,特别是在小麦田中检测罂粟的情况。

Sportelli等人评估了YOLO目标检测器在多种草坪场景中检测杂草的性能[69]。利用具有特定特征的三种数据集,该研究强调了在草坪中准确检测杂草所面临的挑战。尽管取得了高性能,但研究承认模型性能存在局限性,并强调需要进一步研究以解决这些挑战。这项工作有助于全面理解在杂草检测中模型性能与计算效率之间的权衡。Jin等人提出了一种使用YOLO-v3在蔬菜田地中识别杂草的新方法[70]。采用基于卷积神经网络(CNN)的两阶段方法,该方法通过专注于蔬菜作物的检测来准确检测杂草。尽管结果很有希望,但研究指出了主要局限性,即缺乏用于智能除草机器人商业开发的鲁棒感知技术。这项研究为在不同作物中检测杂草提供了可行的途径,并强调了对感知技术的进步的需求,以实现更广泛的应用。表8汇总了在农业领域使用不同YOLO架构进行杂草检测的研究。

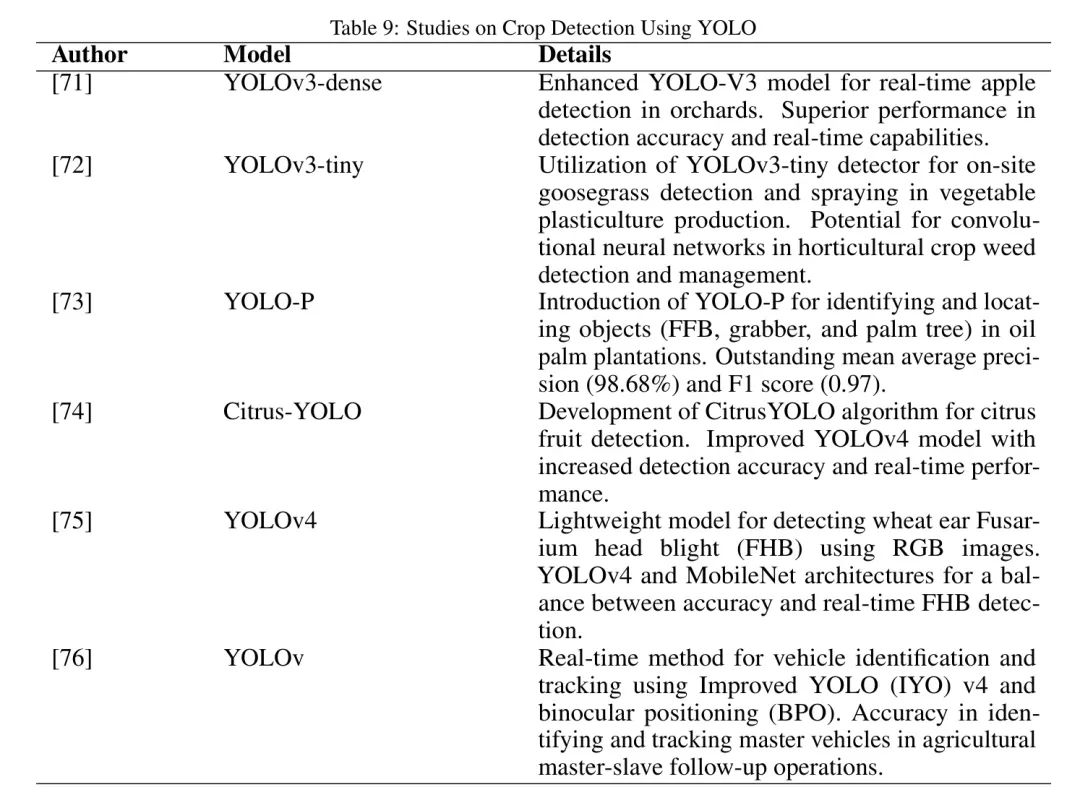

Crop Detection via YOLO

在精准农业领域,作物检测在优化农业实践和资源利用方面发挥着关键作用。在大规模田地中对作物进行准确识别和划界有助于改进监测、产量估算和资源管理。各种研究探讨了YOLO变体在解决作物检测挑战中的应用,展示了实时、高效和精确识别不同作物类型的潜力。田等引入了一种改进的YOLO-V3模型,专为果园实时苹果检测而设计[71]。研究行人在不同的天气和光照条件下使用3000 x 4000像素分辨率的相机收集图像数据。应用了数据增强技术来增强数据集的多样性。为了优化YOLO-V3网络中低分辨率的特征层,作者融入了DenseNet方法,旨在提升特征传播、鼓励复用,并增强整体网络性能。所提出的YOLOV3-dense模型与原始YOLO-V3和带有VGG16网的Faster R-CNN模型相比,尤其在检测准确性和实时能力方面表现出色。值得注意的是,该研究仅关注苹果检测,未探索其他水果或作物。未来的调查可以探索所提模型对不同农业环境的适应性。此外,该研究忽视了恶劣天气条件,如雨或雾,对模型性能的潜在影响。后续的研究努力可以深入研究模型在不同天气情景下的鲁棒性。最后,该研究在大规模数据集上的评估不足。因此,未来的研究可以考虑在更广泛的数据集上验证模型,以进一步建立和验证其性能。

Sharpe及其研究团队开发了一种用于佛罗里达州蔬菜塑料栽培生产中有效控制马唐的精准施药器[72]。该研究评估了YOLOv3-tiny检测器在现场马唐检测和喷洒中的应用。图像处理包括各种植物,如草莓和番茄植株,以及其他杂草种类,以训练和测试神经网络。尽管展示了卷积神经网络在园艺作物杂草检测和管理中的潜力,但研究指出了特定的局限性和改进领域。首先,关注草莓和番茄生产中的马唐检测需要进一步研究,以将网络的适用性扩展到多种作物和杂草种类。该研究强调了LB标注方法在生产和精准喷洒方面的优势,但建议增加其他类别或分组可能提高整体网络准确性。最后,对于番茄,该研究承认分段图像方法在检测准确性方面的局限性,敦促进一步研究以提高这一特定作物的检测准确性。

Junos等人引入了YOLO-P,这是一种能够识别和定位油棕种植园中的物体(新鲜果串、抓取器和棕榈树)的目标检测模型[73]。通过多项实验,该模型显示了卓越的平均精度均值和F1得分,分别为98.68%和0.97。该模型的特点是训练过程更快,设计轻巧(76 MB),在识别不同成熟度的鲜果串方面表现出准确性,为自动化作物收获系统的潜在应用提供了可能。综合实验结果表明,YOLO-P可以准确、稳健地检测棕榈油种植园中的物体,从而有助于提高农业行业的生产力和优化运营成本。

Chen等人通过开发CitrusYOLO算法,在柑橘果实检测方面取得了重大进展[74]。对YOLOv4模型的改进包括增加了152*152特征检测层、多尺度融合的密集连接,以及整合了深度可分离卷积和注意力机制模块。这些改进提高了检测的准确性和实时性能。CitrusYOLO表现出卓越的性能,在准确性和时间效率方面超过了标准的深度学习方法。尽管取得了这些进步,研究还是认识到某些局限性和改进空间。数据集专注于两种金桔和南丰蜜桔以及四种丰产柑、柑橘、马水橘和贡柑,表明在扩大柑橘品种和生长阶段的覆盖范围时,性能有提升的潜力。在多变的光照条件下算法的性能以及在其他环境和不同物体中的应用仍然未知。虽然实验证明了有效性,但在果园产量估计和果实收获机器人等实际应用中还需要进一步验证。

Hong等人开发了一种轻量级模型,用于利用RGB图像检测小麦穗赤霉病(FHB)[75]。利用YOLOv4和MobileNet架构,所提出的模型在准确性和实时FHB检测之间取得了平衡。在检测小麦穗FHB方面,该模型的准确率为93.69%,优于MobileNetv2-YOLOv4模型,其减小的大小便于在无人航空器(UAV)上部署。尽管在实时FHB检测方面显示出巨大潜力,但研究还是认识到某些局限性和改进空间。研究专注于小麦穗赤霉病检测,而忽略了影响小麦作物的其他疾病,这表明未来研究可以考虑扩展模型的疾病检测能力。对于小型物体的错误检测以及在复杂背景下的检测性能挑战突出了需要改进模型性能的需求。此外,研究强调减少参数,这需要探索模型在不同边缘平台上的泛化能力。

王等人提出了一种使用改进的YOLOv4和双目定位(BPO)[76]的车辆实时识别与跟踪方法。针对农业主从跟随操作中的跟踪问题,该研究的实验展示了该方法在实时识别和跟踪主车辆方面的准确性。在纵向、横向和航向角偏差方面较低的均方根误差表明,该方法在满足主车辆定位要求方面的有效性。研究还为训练和测试识别模型创建了一个数据集,暗示未来将构建和测试奴隶自动跟随系统。尽管研究没有明确提及局限性,但未来探索的潜在领域包括在多样化的农业环境中验证该方法,并考虑在不同天气和光照条件下其性能的表现。《表9》汇总了在农业领域内利用不同YOLO架构进行作物检测的研究努力。

Animal Tracking with YOLO

近年来,You Only Look Once(YOLO)目标检测模型的应用彻底改变了生态研究中的动物追踪。YOLO的实时和高精度能力使其成为监测野生动物的有力工具,能够自动识别和跟踪各种环境中的动物。本小节深入探讨了基于YOLO系统的创新性动物追踪使用,探索它们在理解动物行为、迁徙模式和生态动态方面的贡献。

王等人进行了一项研究,利用视觉图像处理和YOLO v3深度学习算法监测和分析自繁育笼中蛋鸡的行为[77]。他们的方法识别了六种行为,达到了高精确度,并提供了关于蛋鸡福利状态的见解。尽管取得了成功,但研究的局限性在于分析了单一笼中有限数量的Hy-Line Gray蛋鸡样本,需要在更多品种、更大种群以及与现有行为识别方法比较中进行进一步调查[77]。于等人利用改进的YOLO模型和边缘计算来自动检测奶牛的喂养行为[79]。所提出的DRN-YOLO算法在精确度、召回率、平均平均精度(mAP)和F1分数方面都有所提高,并指出了可能的改进领域,例如进一步细分牛的觅食行为,并在不同的农场环境和牛种群中测试泛化能力[79]。

Elmessery等人进行了一项全面的研究,开发和验证了一个基于YOLOv8的模型,用于在集约化养鸡场自动检测肉鸡的病理现象[80]。尽管训练和检测成功,但局限性包括由于疾病相关限制导致的患病肉鸡数据集受限,以及光照强度对图像质量可能产生的影响[80]。

Barreiros等人提出了一种利用YOLOv2和卡尔曼滤波的追踪算法,以准确追踪受控实验设置中斑马鱼群体的移动[81]。他们成功实施了一个可以检测和追踪群体中单条鱼的系统,限定鱼头的检测区域,并使用卡尔曼滤波在每帧中估计鱼头的最佳状态。

Rancic等人开发并测试了一个用于检测动物的 Pipeline ,特别是鹿,使用YOLOv3、YOLOv4、YOLOv4-tiny和应用于无人机图像的SSD[82]。尽管研究取得了高性能预测,但局限性包括通过预训练模型解决的数据有限的挑战,指出需要进一步研究以增强系统的鲁棒性和泛化能力[82]。

郑等人提出了一个名为YOLO-BYTE的算法,用于使用单个相机追踪多头奶牛[83]。尽管在奶牛目标检测中实现了高精度,但承认了潜在环境对准确度的影响,强调需要在不同数据集和场景中进一步检验算法[83]。

Wangli等人提出了一种新的猪检测和计数模型,名为YOLOv5-SA-FC,它将shuffle attention和Focal-CIoU损失整合到YOLOv5框架的主干中[84]。通过利用shuffle attention模块,模型动态关注与猪检测和计数相关的特征,同时减少非必要特征的权重。此外,Focal-CIoU损失机制优先考虑与目标框重叠度更高的预测框,提高了检测性能。同样,Jonggwan等人开发了一种名为EmbeddedPigCount的技术,利用TinyYOLOv4准确计数大规模养猪场上的猪[85]。他们在韩国一家商业养猪场收集了图像数据,其中监控摄像头捕捉了走廊中移动的猪和人类的图像。研究行人在图像中手动标注边界框,并使用总共2675张图像来训练检测模块。即使猪来回穿过计数区域,研究也实现了99.44%的计数准确度。

Disease Detection in Agriculture Using YOLO

农业部门在保持作物健康和确保产量最大化方面面临着不断的挑战。及时识别和解决植物疾病是可持续农业实践的重要部分。随着计算机视觉和深度学习,尤其是“你只看一次”(YOLO)算法的发展,人们越来越有兴趣利用这些技术在作物中实现自动疾病检测。

本小节探讨了几个采用基于YOLO模型的研究,用于在农业环境中检测和监测疾病。这些研究展示了YOLO在为疾病识别提供准确、高效解决方案方面的潜力,为现代农业中智能和技术驱动方法的发展做出贡献。

刘和王进行了一项研究,专注于在自然环境中对番茄疾病和虫害的检测,并创建了一个专门的数据库[86]。通过使用YOLO v3模型,他们在短短20.39毫秒内实现了令人称赞的92.39%的检测准确率。改进的YOLO v3在准确性和速度上都超过了其他方法,包括SSD、Faster R-CNN和原始的YOLO v3。尽管该算法在实时检测中显示出有效性,但在实际应用中,仍有机会提高准确性和速度,特别是在与基于深度学习的分类方法所达到的高精度相比较时。

Morbekar及其同事开发了一个利用YOLO目标检测方法的实时作物疾病检测模型[87],用于检测和分类,如图8所示。该模型在PlantVillage数据集上测试时表现出色,准确率达到98.5%。然而,该研究的局限性包括数据集主要关注印度的主要作物,可能限制其在其他作物和地区的适用性。此外,系统的范围仅限于检测叶片上的疾病,忽视了作物其他重要部分,如茎或果实。

Nihar和Raghavendra提出了一种用于实时水稻作物疾病检测的创新方法,开发了一种基于tiny_yolov3算法的先进的深度学习模型[88]。该模型实现了令人印象深刻的98.92%的准确率,使农民能够早期识别潜在问题,主动保护作物。作者建议该模型适用于害虫检测,增强了其在多种应用中的多样性。

Agbulos等人采用YOLO算法识别水稻叶片疾病,总体准确率达到73.33%[89]。尽管在识别叶瘟和褐色斑点疾病方面取得了成功,但研究专注于静态的水稻叶片图像以及硬件设置的限制(包括Raspberry Pi 3和相机模块)在现实场景中可能带来挑战。未来的改进可能包括升级硬件组件以提高图像质量,并探索水稻植物更广泛的疾病谱。

利皮和同事们开发了一个基于YOLO的卷积神经网络(CNN)的害虫检测系统,用于识别榛子果园中的真正害虫[90]。该系统平均精度大约为94.5%,展示了实时处理能力。然而,当将系统应用于大型果园时,可扩展性问题随之产生,与系统深度传感器分辨率相关的潜在挑战可能会影响其性能。

雷迪和迪克沙训练了一个YOLOv4模型,用于检测和识别桑树作物的叶部疾病,实现了高速度和准确度[91]。该模型在检测后推荐相应杀虫剂的能力对有效疾病管理具有前景。尽管该研究在关注桑树作物方面取得了成功,但鼓励进一步探索识别各种疾病,并考虑实时视频分类。

马修和马赫什探讨了在苹果树中早期疾病检测的重要性,采用YOLO V3网络进行疾病检测[92]。该研究突出了YOLO V3的优势,如更快的检测结果和提高了准确度,但也承认了挑战,包括环境干扰和需要对植物健康进行持续监测。

维尔马等人提出了一种使用YOLO算法在大豆作物中检测害虫的框架[93]。虽然实现了高平均精度,但该研究承认了限制,包括数据集大小的限制和偶尔的误分类。还指出了基于害虫检测结果进行杀虫剂应用的潜在伦理和环境含义,需要进一步考虑。

库努等人开发了一个基于YOLO v5的系统,用于自动种子分选和分类,实现了99%的高精度和召回率[94]。尽管在分类珍珠粟和玉米种子方面有影响,但该研究识别了在混合种植场景中种子分类的进一步研究需求,以及基于作物类型和质量对种子进行更广泛分类的需要。马修和马赫什使用YOLO v5识别甜椒植物的疾病,展示了高准确性和减少的模型大小[95]。该研究暗示了将疾病检测扩展到影响甜椒植物的多种疾病的潜力,通过及时疾病识别有望提高农场产量。

苏布等人引入了一种使用YOLOv7方法检测茶叶病害的人工智能解决方案,强调需要探索人工智能在孟加拉国茶叶种植中的好处[96]。承认限制,如有限标记数据和缺乏建立的评估指标,该研究主张进一步研究以增强YOLOv7模型在茶叶病害检测中的有效性。

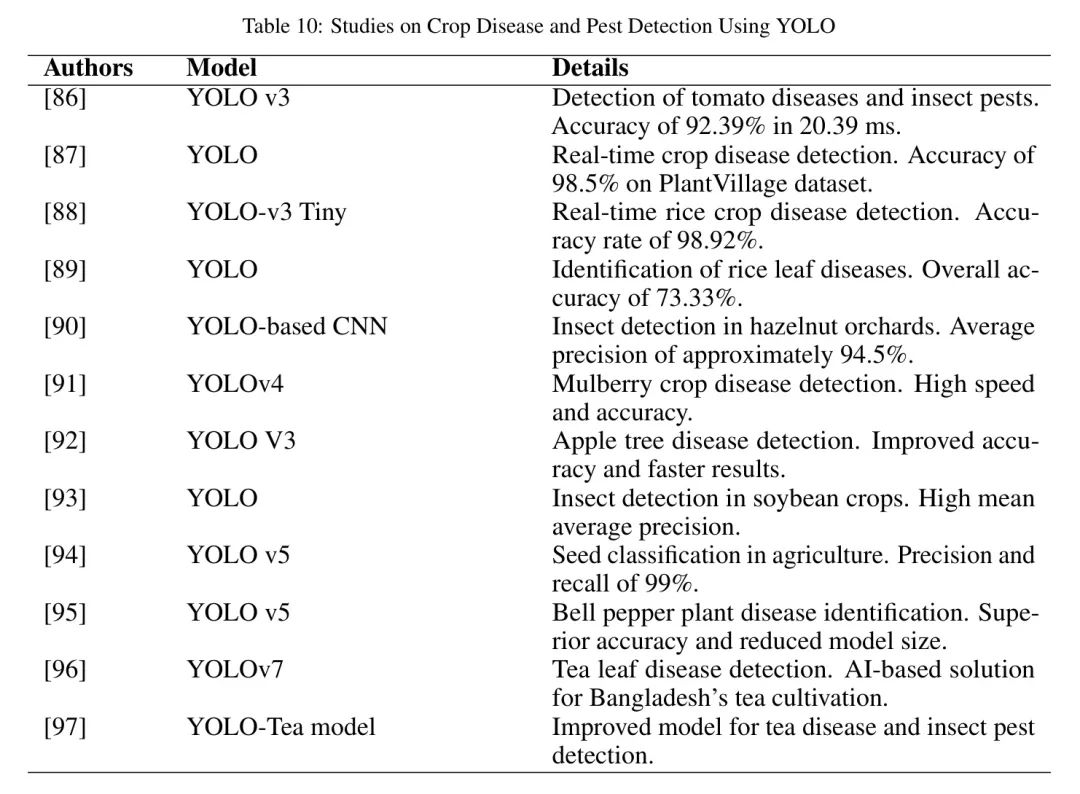

薛等人提出了YOLO-Tea模型,通过改进特征提取和注意力机制,解决了茶叶疾病和虫害的小目标挑战问题[97]。尽管通过消融实验和比较展示了其潜力,但研究强调了在真实世界茶叶疾病监测应用中需要持续探索和评估。表10概述了在农业领域中使用各种YOLO架构来检测作物疾病和害虫的研究。

Precision Framing Using YOLO

精准农业在多种农业应用中都是一个关键方面,它涉及准确地在图像或视频帧中描绘和识别特定目标。将You Only Look Once(YOLO)算法应用于精准农业已经显示出在快速高效地检测和分类物体方面的卓越能力。本小节探讨了几项利用YOLO在多样化农业背景下进行精准农业的研究,展示了其在疾病和害虫检测、种子分类等任务中的有效性。这些应用不仅提高了目标识别的准确性,而且有助于优化农业流程,提高作物管理的整体水平。

表10:利用YOLO、Faster R-CNN、YOLO v3和SSD进行作物疾病和害虫检测的研究。研究者在配备了两个TITAN RTX GPU的工作站上,采用PyTorch深度学习框架对模型进行训练和评估。通过将GF-1数据融合到2米多光谱数据中,并结合GF-2,研究增加了样本多样性,并评估了在具有相似AG风格的不同数据源之间方法的可迁移性。结果显示,YOLO v3模型在AG检测的准确性和效率方面超过了其他模型。尽管研究为AG检测方法和基于CNN的遥感目标检测提供了有价值的见解,但作者认为未来调查需要利用卫星图像中的多光谱和 hyperspectral 数据以改进目标检测。研究专注于AG检测,促使未来研究进一步探索其他地理空间目标。

李等人使用卷积神经网络(CNN)在高分辨率卫星图像中识别农业温室(AG)[98]。该研究比较了三种主流基于CNN的目标检测模型的性能:汗等人开发了一个深度学习系统,用于区分草莓和豌豆田中的作物和杂草,旨在集成到精准农业喷雾器中,进行实时杂草管理[99]。配备相机的无人机捕获田地图像,深度学习技术被优化以高精度识别小片杂草,特别是在早期生长阶段。该系统的总体平均准确率为94.73%,优于现有的机器学习和基于深度学习的方法。尽管该方法具有很强的鲁棒性,但研究指出数据集大小、泛化能力以及实时集成到精准喷雾系统中的局限性,呼吁进行额外的研究和开发。

Mamdouh和Khattab介绍了一个基于YOLO的深度学习框架,用于检测和计算果园中的橄榄果蝇[100]。该框架显示出卓越的精确度(0.84)、召回率(0.97)、F1分数(0.9)和平均精度均值(mAP)为96.68%,超过了现有的害虫检测系统。作者强调了该框架与传统手工方法相比的潜在优势,并通过广泛的模拟实验强调了其有效性。认识到框架的局限性,包括缺乏大规模数据集,作者提出了未来的改进措施,如现实图像评估、数据集丰富和转化为多类别分类器。

Comparative Analysis

作者的方法系统地比较了农业环境中不同YOLO应用,整合了任务复杂性、实验条件控制、硬件依赖性以及结果和错误测量方法的关键分析等关键方面。这种全面的方法不仅评估了性能,还阐明了在现实世界农业场景中部署这些模型的实际影响。

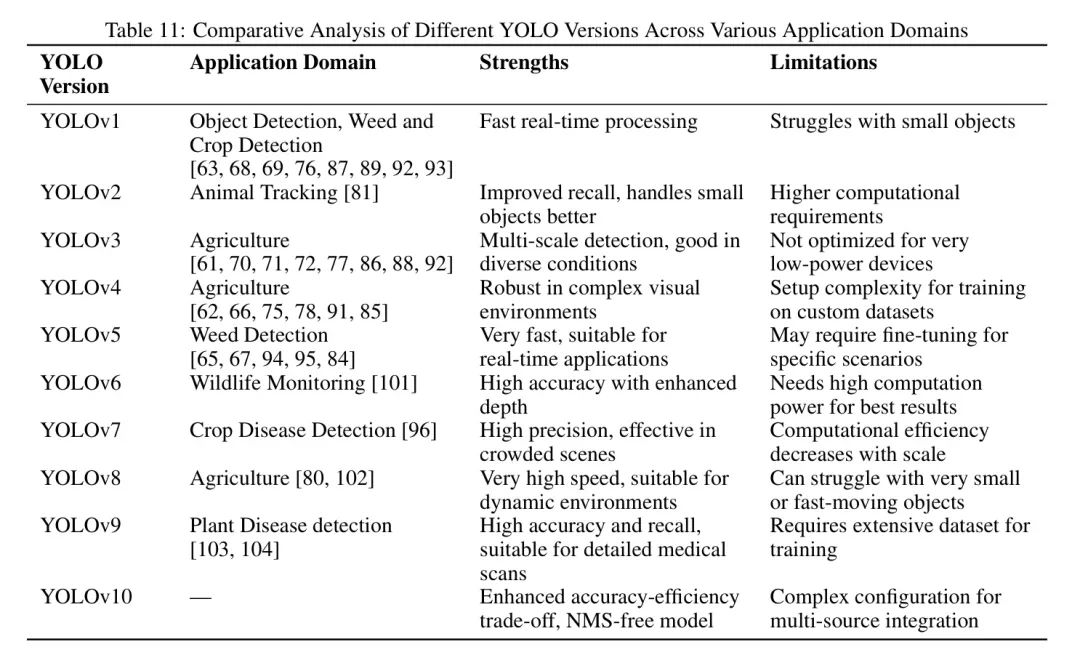

在比较不同YOLO版本在农业等不同应用领域的分析中,每个YOLO架构版本都显示出其独特的优势,并遇到特定的局限性,这些局限性影响其在某些任务中的适用性(见表11)。例如,YOLOv1主要针对如VOC 2007或芝麻田图像数据集这样的标准数据集,进行简单的目标识别任务,如杂草检测。相比之下,后来的版本如YOLOv4和YOLOv5已被用于更复杂的农业数据集,这些数据集具有不同的背景、多个目标类别,并需要实时检测能力。这些任务不仅根据准确性进行评估,还根据模型处理自然场景复杂性的能力进行评估,包括可变光照条件、遮挡和重叠目标。

作者的分析强调了控制实验条件以验证目标检测模型鲁棒性的重要性。例如,YOLOv3在基于无人机的杂草检测中的应用,不仅仅是算法性能的问题,还包括飞行稳定性、相机质量和环境干扰等因素——所有这些都会显著影响结果。同样,YOLOv6在野生动物监测中的应用面临如动物速度变化和伪装背景等挑战,这些挑战在条件不太受控但高度可变的情况下推动了检测能力的极限。硬件的选择显著影响了YOLO模型的部署。作者的评估范围从用于训练的高端GPU到如NVIDIA Jetson这样的嵌入式系统,用于现场部署,关键评估性能指标,如帧率、处理速度和功耗,以确定在农业设置中的可行性,在这些环境中,有限的电力和移动性常常决定了硬件的选择。

作者的方法包括对错误测量技术的关键性回顾,这在作者比较分析表的“性能指标”一列中有详细描述(见表11)。作者关注如精确度、召回率、mAP和F1分数等关键指标,这些对于评估模型在不同场景下的性能至关重要。此外,作者将错误分为定位、分类和假阳性/假阴性等类型。这种分类不仅为模型性能提供了细致入微的观点,还增强了作者理解在实地条件下部署这些模型实际影响的理解。例如,在YOLOv4在作物病害检测中的应用中,理解假阴性的影响至关重要,因为遗漏一个患病植物可能导致作物内更广泛的传播。

通过这种全面的方法收集的数据使作者能够综合不同YOLO应用和版本的研究发现,突出如速度和准确性的改进与计算需求复杂性之间的权衡。这种综合不仅回答了当前的研究问题,还确定了未来研究的空白,建议可能的模型训练或部署改进,以更好地满足精准农业的具体需求。YOLO架构的演变标志着技术增强的重要轨迹,这些技术被系统地改进以应对农业应用的多样性和挑战性需求。从YOLOv1到YOLOv10的每个版本都经过调整以克服特定的局限性,导致了更复杂的系统,能够进行复杂的环境交互。这些迭代式进步强调了选择适合特定农业任务量身定制的YOLO变体的的重要性,平衡计算需求与精确度要求,如害虫识别和作物病害监测等任务。通过将模型能力与特定任务需求对齐,研究行人和从业者可以有效地利用YOLO技术推动精准农业和可持续农业实践的未来的发展。

这次比较分析突出了基于特定应用需求的模型选择以及涉及的技术权衡的关键角色,为未来研究和技术在驱动农业中的应用提供了一个框架。

Conclusion

总之,YOLO变体与农业的交汇展示了对精准农业、杂草管理和作物监测的变革潜力。在各种研究中不断取得的进展和展现出的积极成果,强调了YOLO架构在塑造智能高效农业未来中的关键作用。

对农业应用中YOLO变体的全面回顾,凸显了这些模型在革新精准农业方面的变革潜力。从作物检测和病害识别到杂草管理,YOLO变体已经展示了卓越的能力,为农业中长期存在的挑战提供了实时有效的解决方案。

对各种研究的讨论和分析强调了YOLO架构在多样化农业场景中的多样性和适应性。尽管已经取得了明显的成功,但挑战依然存在,需要持续的研究努力。训练数据集的特定性、硬件限制和环境可变性提出了需要创新解决方案的障碍。

未来的研究应优先考虑开发更具包容性的数据集、针对边缘设备的优化技术以及适应动态农业环境的模型。

展望未来,多模态融合、可解释性和实时自适应系统为进一步提升YOLO模型在农业中的实用性提供了令人兴奋的机会。不同数据模态的融合,结合实时学习机制,可以开启一个智能的、情境感知的精准农业新时代。

此外,重视人机协作的做法承认了农民在决策过程中的不可或缺的作用,促进了AI技术与传统农业实践的和谐融合。

总之,YOLO变体在农业中的演变标志着向可持续、高效和技术驱动的农业实践范式的转变。随着研究行人、实践者和利益相关者的合作,基于YOLO的应用继续进步的未来充满希望,为全球努力解决食品安全和支持环保型农业做出贡献。