人工智能将如何重塑数据中心内外部网络架构?

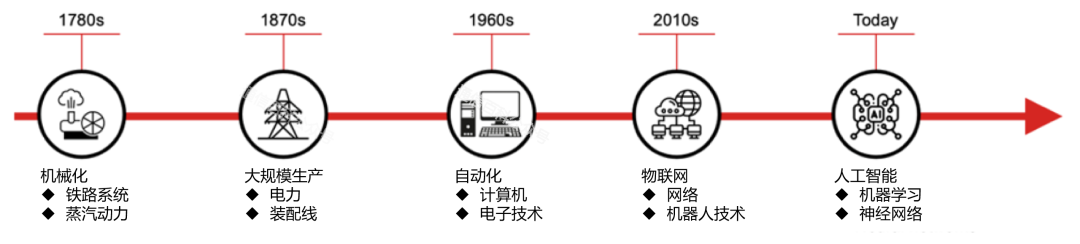

尽管存在市场炒作周期,人工智能已进入实质性技术拐点,其引发的范式变革正在突破传统效率边界。类比蒸汽机开启工业革命、电力重塑生产模式、互联网重构信息生态,AI 作为新一代通用目的技术(General-Purpose Technology)正在催生独特的网络架构挑战与创新机遇。

人工智能 (AI),一个新的技术拐点

AI基础设施面临三维扩展困境:在存储、计算、网络资源的规模化扩展过程中,需同步应对指数级增长的能源消耗(年复合增长率>65%)与可持续发展需求。为深入解析这一命题,我们首先剖析数据中心内部网络架构变革,继而延展至跨数据中心互联的技术演进路径。

数据中心内部AI网络重构

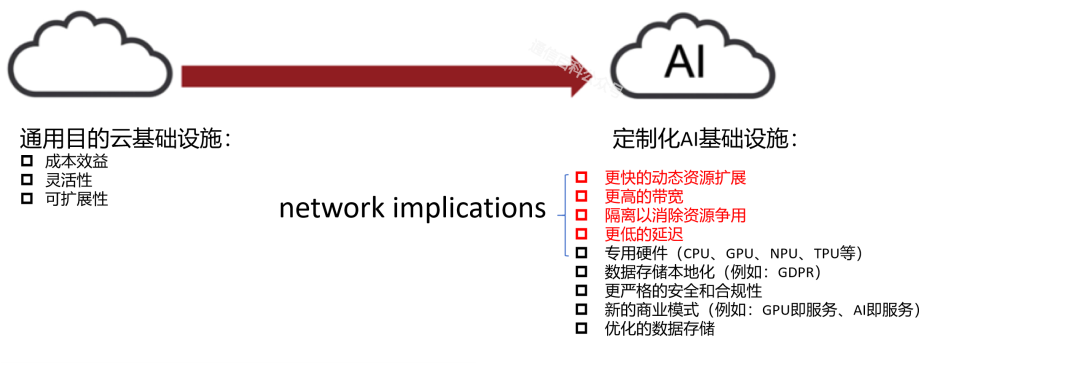

传统云服务架构虽支撑了初期AI发展,但面对大型语言模型(LLM)训练、生成式AI(GenAI)等新型负载,其网络性能瓶颈日益凸显。以ChatGPT为代表的GenAI应用揭示出传统架构的局限性——尽管成本效益与弹性扩展仍是核心诉求,但AI工作负载对网络提出了颠覆性要求,如下图所示。

传统云和 AI 基础设施要求的比较

深度学习驱动的LLM训练场景中,数据中心内部网络需满足:

- 超高频宽需求:单节点400Gb/s至1.6Tb/s传输带宽

- 亚微秒级时延:GPU集群间通信延迟要求<1μs

- 无损传输特性:零丢包率与精准拥塞控制机制

AI 由数据中心内部和之间的高性能网络提供支持

产业界通过双重路径应对挑战:

- 物理层突破:硅光集成收发器(1.6Tb/s PAM4)、光电路交换矩阵(OCS)、共封装光学(CPO)等技术演进

- 协议层革新:Ultra以太网联盟(UEC)增强RoCEv2协议,UALink产业联盟制定加速器互连标准

AI园区网络

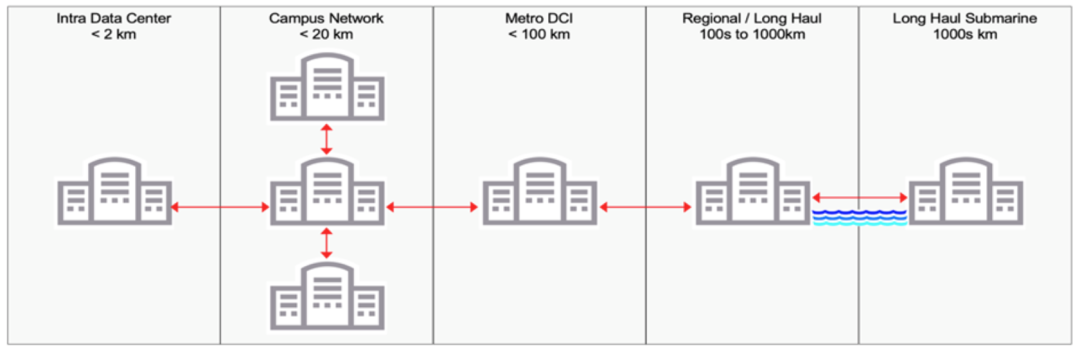

单个现代 GPU 是 AI 计算集群的基本元素,其功耗可能高达 1,000 瓦,因此,当数万到数十万(甚至更多)互连用于 LLM 训练等目的时,相关能耗将成为数据中心运营商面临的巨大挑战。新的 AI 基础设施将迅速消耗现有数据中心内的能源和空间。这将导致在数据中心相距不到 10 km 的“园区”中建造新的数据中心,以最大限度地减少延迟,从而提高 AI 应用程序的性能。

而校园则需要位于可靠、可持续且具有成本效益的可用能源附近。园区数据中心将使用针对特定成本、功率、带宽、延迟和距离优化的光学器件相互连接,并与远程数据中心相连。

- 能耗挑战:单颗AI加速芯片功耗突破1200W,十万级集群PUE优化至1.1以下;

- 拓扑创新:采用3D-Torus与Hypercube拓扑结构,光互连距离<300米;

- 能效优化:液冷系统搭配48V直流供电,能源利用率提升35%。

由于 AI 基础设施托管在新的和现有的数据中心中,因此需要将它们互连,就像它们今天对于传统云服务的互连一样。这将使用类似的光传输解决方案来实现,尽管速率更高,包括 1.6Tb/s。根据 Omdia 预测2023-2030年AI相关流量年复合增长率达126%

年份 | 月均AI流量(EB) | 年增长率 |

|---|---|---|

2023 | 45 | - |

2025 | 230 | 156% |

2030 | 1,850 | 132% |

边缘推理网络

- 模型优化:知识蒸馏技术压缩LLM体积达90%

- 时延控制:边缘节点端到端时延<10ms

- 合规架构:同态加密与联邦学习实现隐私保护

AI基础设施面临严峻能效挑战:

- 计算维度:每PFLOPS能耗从20kW向5kW突破

- 传输维度:光模块能效比从15pJ/bit向1pJ/bit演进

- 架构创新:第三代相干算法使频谱效率提升40%,每比特功耗下降35%

技术代际 | 频谱效率(b/s/Hz) | 能效比(pJ/bit) |

|---|---|---|

5nm | 8.4 | 0.18 |

3nm | 11.2 | 0.12 |

硅光集成 | 15.6 | 0.08 |

构建AI原生网络生态

AI价值实现依赖于数据流动效率,这要求:

- 协议革新:QUIC协议替代TCP/IP降低30%时延;

- 安全架构:拟态防御体系融合量子密钥分发(QKD);

- 智能管控:基于数字孪生的网络自优化系统。

尽管 AI 基础设施计算和存储消耗的电能远高于将它们互连的网络,但网络带宽的增长无法与相关的功耗线性扩展——这既不可持续也不具有成本效益。这意味着网络技术还必须始终减少每比特的电力(和空间),以便在对实现 AI 功能至关重要的行业中“尽其所能”。

撇开炒作不谈,人工智能将为不同行业提供前所未有的好处,对我们的商业和个人生活产生积极影响。然而,AI 的快速和广泛采用带来了一系列与其基础设施(包括计算、存储和网络构建块)相关的新挑战。成功应对这些挑战需要广泛的跨行业创新和协作,因为只有当数据能够安全、可持续且经济高效地从托管 AI LLM 培训的核心数据中心内部移动到托管 AI 推理的边缘数据中心时,AI 才能成功扩展。