全面超越 Ollama,实测拉垮

大家好,我是 Ai 学习的老章

项目地址:https://github.com/Michael-A-Kuykendall/shimmy

看到一个新的大模型推理工具——Shimmy,号称全面超越 Ollama

省流:实际体验,没啥优势

Shimmy

🔒 本地 AI,零锁定 🚀

Shimmy 是一个 5.1MB 的单文件可执行程序 ,为 GGUF 模型提供 100% 兼容 OpenAI 的端点 。

将现有 AI 工具指向 Shimmy,它们即可立即运行——本地、私密且完全免费。

⚡ 零配置开箱即用

- 自动发现 Hugging Face 缓存、Ollama 及本地目录中的模型

- 自动分配端口 ,避免冲突

- 自动检测 LoRA 适配器 ,支持专用模型

- 开箱即用 ——无需配置文件,无需设置向导

🎯 本地开发完美之选

- 隐私 :代码始终保留在本地

- 成本 :无需 API 密钥,无需按 Token 计费

- 速度 :本地推理,亚秒级响应

- 稳定 :无速率限制,零宕机

性能速览

Shimmy 的基准测试聚焦于真实场景性能而非理论峰值。用户关心的是加载模型、在内存受限情况下的文本生成以及跨配置的稳定吞吐量。

Model | 大小 | 加载时间 | 首个 token | token/秒 | 内存 |

|---|---|---|---|---|---|

phi3-mini | 2.4GB | 1.2 秒 | 220 毫秒 | 24.3 | 3.1GB |

llama-7b | 4.1GB | 2.8 秒 | 410 毫秒 | 15.7 | 5.9GB |

mistral-7b | 4.1GB | 2.6 秒 | 380 毫秒 | 18.2 | 5.7GB |

⚡ 性能对比

工具 | 二进制大小 | 启动时间 | 内存用量 | OpenAI API |

|---|---|---|---|---|

Shimmy | 5.1MB | <100 毫秒 | 50MB | 100% |

Ollama | 680MB | 5–10 秒 | 200MB+ | 部分 |

llama.cpp | 89MB | 1-2 秒 | 100MB | 无 |

用法

API

GET /health- 健康检查POST /v1/chat/completions- 兼容 OpenAI 的聊天GET /v1/models- 列出可用模型POST /api/generate- Shimmy 原生 APIGET /ws/generate- WebSocket 流式传输

CLI

shimmy serve # Start server (auto port allocation)

shimmy serve --bind 127.0.0.1:8080 # Manual port binding

shimmy list # Show available models

shimmy discover # Refresh model discovery

shimmy generate --name X --prompt "Hi" # Test generation

shimmy probe model-name # Verify model loads

安装

🪟 Windows

# RECOMMENDED: Use pre-built binary (no build dependencies required)

curl -L https://github.com/Michael-A-Kuykendall/shimmy/releases/latest/download/shimmy.exe -o shimmy.exe

# OR: Install from source (requires LLVM/Clang)

# First install build dependencies:

winget install LLVM.LLVM

# Then install shimmy:

cargo install shimmy --features huggingface

🍎 macOS

# Install dependencies

brew install cmake rust

# Install shimmy

cargo install shimmy

实际体验

安装显然不如 Ollama 省事儿,pip、node、docker 版本也都没有

app更是没有

Ollama 发布新app,文档聊天,多模态支持,可在 macOS 和 Windows 上使用

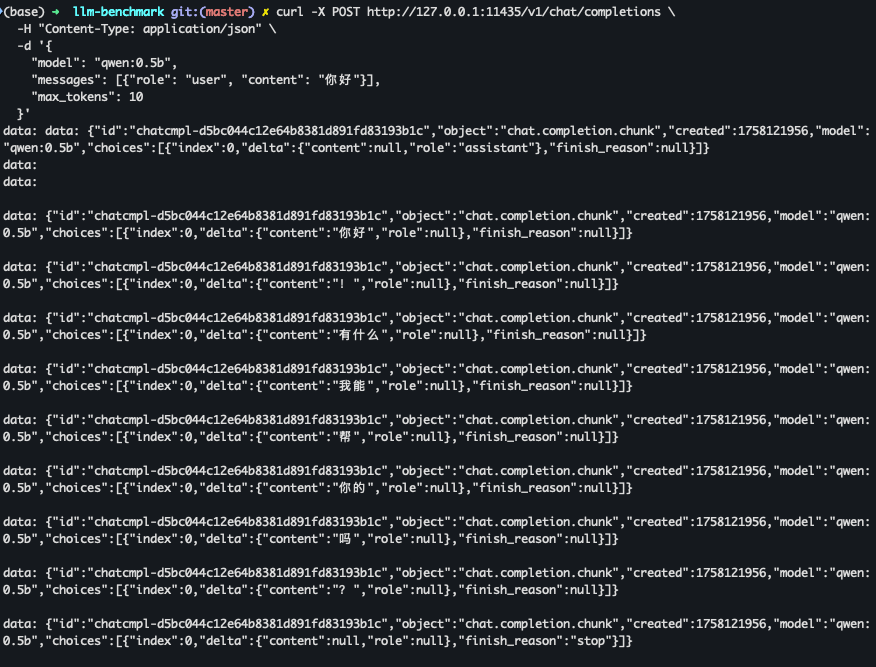

实际拿它与 Ollama 对比,拉起 Qwen:0.5B,发起请求后

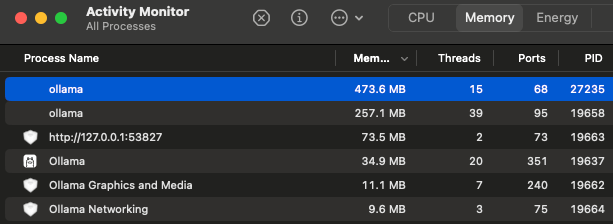

Ollama 内存占用 473+,因为它有单独的 app,所以会有额外内存占用。

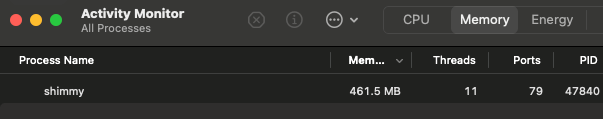

Shimmy 占用 461+

使用上更是毫无方便之处,必须搭配其他工具进行简单测试

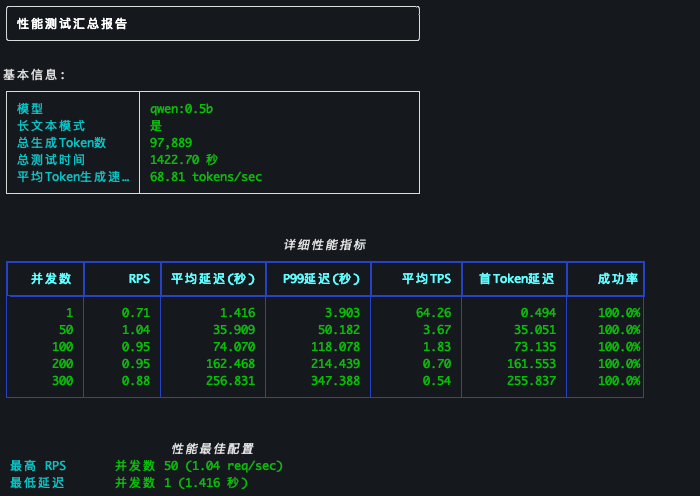

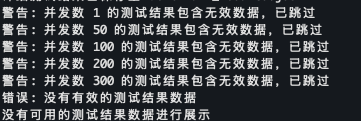

我唯一感兴趣的是它会不会对并发更加友好

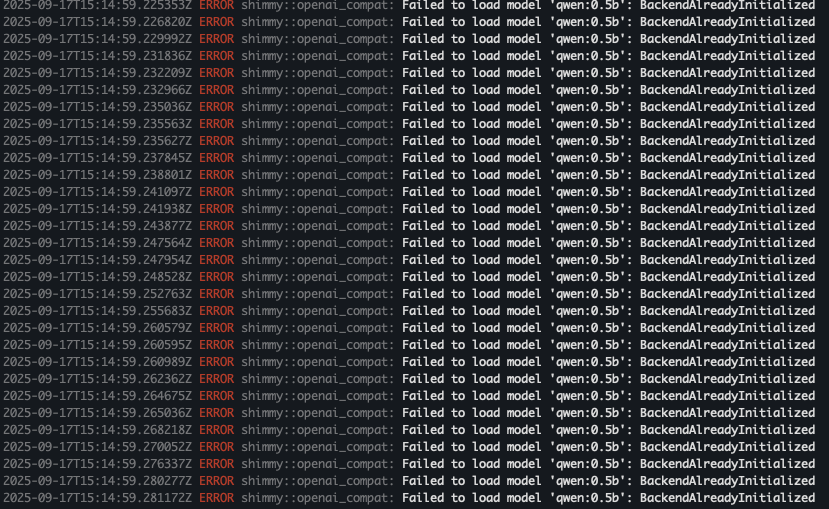

结果更是惨不忍睹

Ollama 之前我写过文章介绍,并发是无解的 不要再用Ollama,不要再用llama.cpp

好歹它至少还能跑,但是 Shimmy 单请求还正常

发起并发请求之后,就大量 ERROR 了

最终测试失败告终

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2025-09-18,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读

目录